c++下调用tensorflow预训练好的模型(pb模型文件导出,c++调用tf模型)

c++下调用tensorflow预训练好的模型(pb模型文件导出,tf的API接口编译,c++中的实践)

- PB模型文件

-

- PB模型文件导出

- 查找输入输出节点名称

- c++接口调用python脚本

-

- 配置环境

- 调用脚本

- Cmake编译tensorflow c++ API

-

- c++ tf的API联合opencv进行图片的模型预测

本人新手小白,由于项目需求,要通过c#winform平台调用python预先训练好的模型,整体流程差不多是通过

c#调用c++的写好的dll,在dll里进行c++调用tf模型的操作。 网上搜到大部分的都是linux上的bazel教程,在windows上还是有些区别的,所以想自己记录一下实现过程。有任何错误可以交流哈hhh

通过查看众多网上的方法,现阶段大概实现了两个方法:

1.c++调用写好的python脚本(调用tf的pb模型,并对结果做一些处理措施)

2.cmake编译tf源码,c++调用tf模型并实现离线预测(bazel 的编译方法也试过,会提一下so文件的)

现在我已完成了第一种的整体流程实现,但是在迁移过程中发现,项目客户仍需要安装python,所以我决定开始尝试第二种方法 第二种方法也ok了。

安装环境以及软件配置:windows

python 3.6.8

vs 2015

tensorflow 1.8.0

Cmake3.15.0 (cmake-gui)

PB模型文件

使用tensorflow训练模型时,为了防止训练途中出现意外情况而导致的训练作废,一般都会通过saver.save(session,"save_dir")将阶段性训练结果保存下来。

这样会生成4个文件

- checkpoint

- .data-00000-of-00001

- .index

- .meta

这个四个文件分别存储了网络模型的网络结构,网络节点名称和节点内的权重参数等,四个文件加起来体积过大,而且如果用c++调用的话肯定是单个模型文件更为方便。pb模型文件常用于网络的离线预测,它的网络结构比meta简单的多了。

PB模型文件导出

网上比较经典的办法是通过tensorflow源码中的freeze_graph.py文件来导出pb模型,我是将pb模型导出的代码写在了,原有的测试调用模型的代码的下面。

压缩过后的模型从200多MB缩小到了56MB。

# 导出成pb模型 *********************************************************

try:

out_pb_path = os.path.join(self.cfgs['save_dir'], 'models/origin.pb') #输出pb模型存储路径

graph = tf.get_default_graph() # 获得默认的图

input_graph_def = graph.as_graph_def() # 返回一个序列化的图代表当前的图

# for op in graph.get_operations():

# print(op.name, op.values())#用来查看原图所有节点名称

output_graph_def = graph_util.convert_variables_to_constants( # 模型持久化,将变量值固定

sess=session,

input_graph_def=input_graph_def,

#output_node_names=['Conv2D', 'side_3/conv2d_transpose', 'side_4/conv2d_transpose', 'side_5/conv2d_transpose'])

# 我的模型为一个融合输出层,和3个侧输出层,分别对应以上节点名称

with tf.gfile.GFile(out_pb_path, "wb") as f: # 保存模型

f.write(output_graph_def.SerializeToString()) # 序列化输出

print("%d ops in the final graph." % len(output_graph_def.node)) # 得到当前图有几个操作节点

except Exception as err:

self.io.print_error('Error transforming, {}'.format(err))

self.init = False

查找输入输出节点名称

这个导出最关键的是找到输入输出的节点名称,大佬们可能在之前网络模型训练过程中,心中有数,作为萌新,找节点还是比较费劲的事,技术性(写代码输出节点?)的方法我不会,所以介绍一下我的方法。

这里推荐一个软件 Netron,目前它支持主流各种框架的模型结构可视化工作。

给一下GitHub链接:https://github.com/lutzroeder/Netron

我当时是用这个软件配合将原图的所有节点名称输出,找和side3这种层次名相关的节点名称,配合原有网络结构的输出层名称(譬如反卷积层输出的那就肯定带deconv这种)试出来的。

那是两天眼快瞎了的日子。。。。因为meta的模型文件实在太乱了。

调用pb模型文件的代码放在下面c++调用python脚本中一起。

c++接口调用python脚本

这个博客中介绍的挺详细的C++调用python

配置环境

c++调用python需要在项目配置中加入python的头文件

右键项目>属性>配置属性>VC++目录,需要配置的是库目录和包含目录

包含目录:D:\soft\Python\Python36\include 包含的是python.h的头文件

库目录:D:\soft\Python\Python36\libs 用来连接lib文件的路径

还需要在右键项目 > 属性 > 配置属性 > 链接器 > 输入>附加依赖项里加

python36.lib;python3.lib;_tkinter.lib;

用Debug调试的话可能会有以下的问题

LINK : fatal error LNK1104: 无法打开文件“python36_d.lib”

解决办法:

- 换成Release-x64

- 把python36.lib重命名成python36_d.lib

.h文件

#pragma once

#include<iostream>

#include <Python.h>

#include<windows.h>

using namespace std;

extern "C" __declspec(dllexport) void testImage(char *);

extern "C" __declspec(dllexport) void test(char *);

这个是我用于生成dll项目的头文件,所以我把功能都封装成函数了。

调用脚本

Cmake编译tensorflow c++ API

我参考的是这个博客

windows10+vs2015下编译GPU版本tensorflow得到lib和dll(附带C++ inference示例)

这个博客里包括了如何配置c++工程,步骤挺全了。

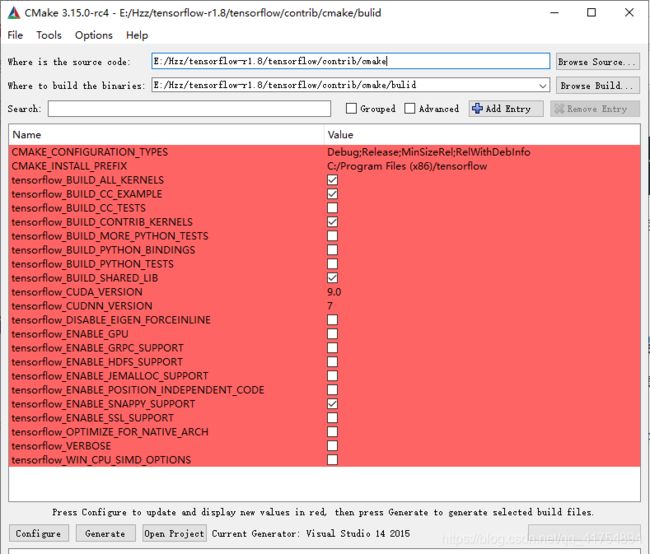

下面是我的cmake配置文件截图。

c++ tf的API联合opencv进行图片的模型预测

其中需要注意的是Mat的imread读进来的图片是BGR格式的图片,所以在使用它的RGB三通道的时候要进行一下转换。

Tensorflow C++的Tensor和OpenCV的Mat相互转换这个博客中写道的Tensor和Mat相互转换的函数

这里放一下源代码

// 设置输入图像

char* img_path = path1;

//模型地址

string model_path = "D://test.pb";

Mat src = imread(img_path);//CV_8UC3 BGR

int height = 512;

int width = 512;

#pragma region 模型预测部分

tensorflow::Tensor input_tensor(DT_FLOAT, TensorShape({ 1, height, width, 3 })); //输入张量

cvMat2tfTensor(src, input_tensor); //将输入Mat转换为tensor

//建立会话

//初始化tensorflow session

Session* session;

Status status = NewSession(SessionOptions(), &session);

if (!status.ok()) {

std::cerr << status.ToString() << endl;

return;

}

else {

cout << "Session created successfully" << endl;

}

// 读取二进制的模型文件到graph中

GraphDef graph_def;

status = ReadBinaryProto(Env::Default(), model_path, &graph_def);

if (!status.ok()) {

std::cerr << status.ToString() << endl;

return;

}

else {

cout << "Load graph protobuf successfully" << endl;

}

// 将graph加载到session

status = session->Create(graph_def);

if (!status.ok()) {

std::cerr << status.ToString() << endl;

return;

}

else {

cout << "Add graph to session successfully" << endl;

}

//输出

// 输入节点Placeholder

std::vector<std::pair<std::string, tensorflow::Tensor>> inputs = { { "Placeholder",input_tensor } };

// 输出outputs

std::vector<tensorflow::Tensor> outputs;

// 运行会话,计算输出,即我在模型中定义的输出数据名称,最终结果保存在outputs中

status = session->Run(inputs, { "Conv2D","side_3/conv2d_transpose","side_4/conv2d_transpose","side_5/conv2d_transpose" }, {}, &outputs);

if (!status.ok()) {

std::cerr << status.ToString() << endl;

return;

}

else {

cout << "Run session successfully" << endl;

}

// 输出结果的可视化

tensorflow::Tensor _fuse = outputs[0];

tensorflow::Tensor _side3 = outputs[1];

tensorflow::Tensor _side4 = outputs[2];

tensorflow::Tensor _side5 = outputs[3];

auto out_shape = _fuse.shape(); // 这里的输出结果为1x512x512x1

cout << out_shape << endl;

//将输出tensor转换为Mat

Mat fuse, side3, side4, side5;

//融合层

tfTensor2cvMat(_fuse, fuse);

imwrite("D://fuse.jpg", fuse);

//side3

tfTensor2cvMat(_side3, side3);

imwrite("D://side3.jpg", side3);

//side4

tfTensor2cvMat(_side4, side4);

imwrite("d://side4.jpg", side4);

//side5

tfTensor2cvMat(_side5, side5);

imwrite("D://side5.jpg", side5);

#pragma endregion

//边缘图

edge = imread("D://fuse.jpg");

整体流程已经跑通并且用c#平台调用,就是还有点小问题,相同的模型在c++调用下的效果比在python 下的差那么一点,就很奇怪。如果有大佬知道为什么欢迎给我留言!谢谢!

我太傻,我有罪,在图片转换格式的时候一定要注意原来网络中输入输出的tensor的属性,没对齐就会出现效果差异,后续将继续更新安卓端的相同功能,有兴趣的欢迎留言~!