Linux(一)

Linux day01

- 第一章 Linux入门

-

- 1.1 概述

- 1.2 Linux和Windows区别

- 1.3 Centos下载地址

- 第二章 VM与Linux的安装

-

- 2.1 VMWare安装

- 2.2 CentOS安装

- 2.3 VMTools安装

- 第三章 Linux文件与目录结构

-

- 3.1 Linux文件

- 3.2 Linux目录结构

- 第四章 VI/VIM编辑器

-

- 4.1 是什么

- 4.2 测试数据准备

- 4.3 一般模式

- 4.4 编辑模式

- 4.5 指令模式

- 4.6 模式间转换

- 第五章 网络配置和系统管理操作

-

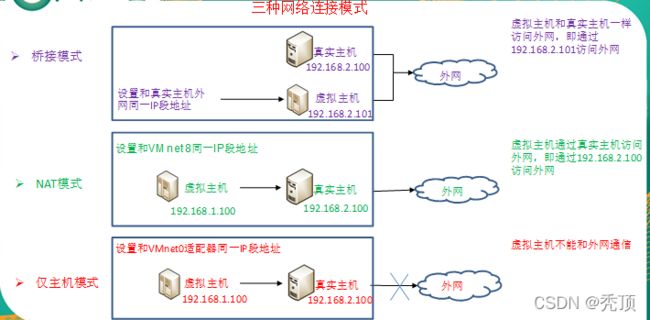

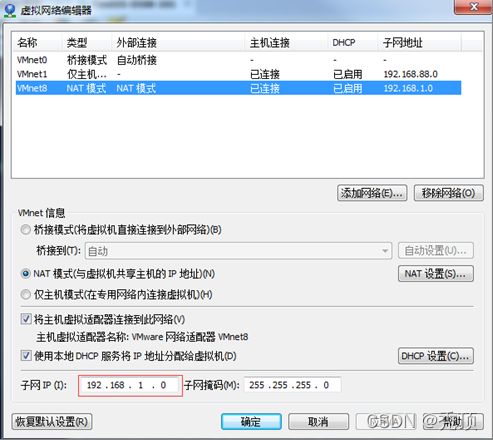

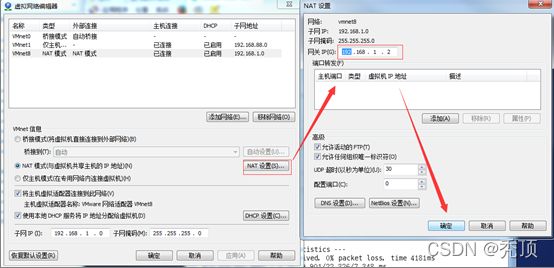

- 5.1 查看网络IP和网关

- 5.2 配置网络ip地址

-

- 5.2.1 ifconfig 配置网络接口

- 5.2.2 ping 测试主机之间网络连通性

- 5.2.3 修改IP地址

- 5.3 配置主机名

-

- 5.3.1 hostname 显示和设置系统的主机名称

- 5.3.2 修改主机名称

- 5.4 关闭防火墙

-

- 5.4.1 service 后台服务管理

- 5.4.2 chkconfig 设置后台服务的自启配置

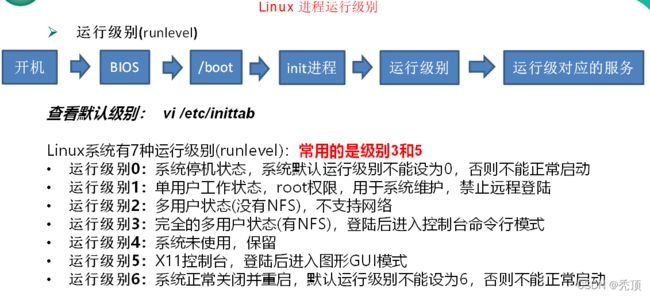

- 5.4.3 进程运行级别

- 5.4.4 关闭防火墙

- 5.5 关机重启命令

- 5.6 找回root密码

- 第六章 远程登录

-

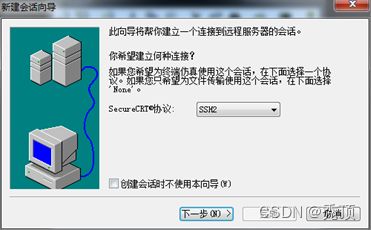

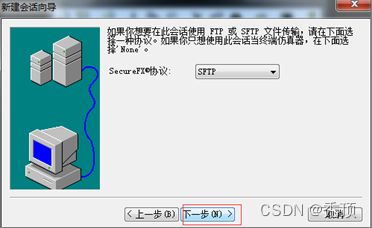

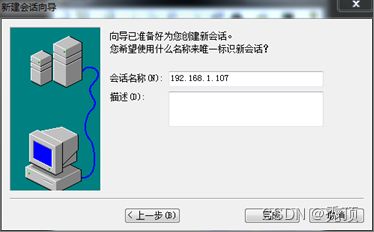

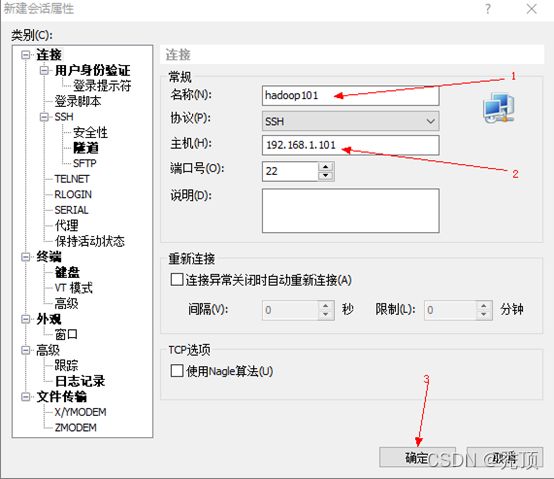

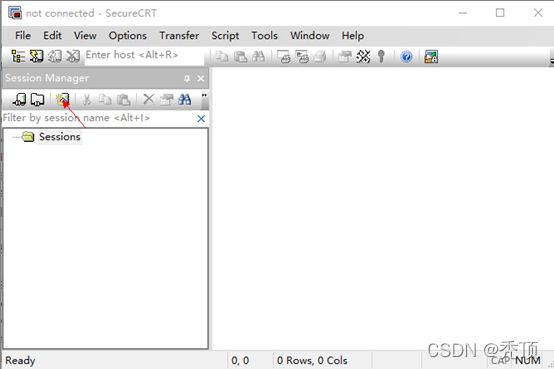

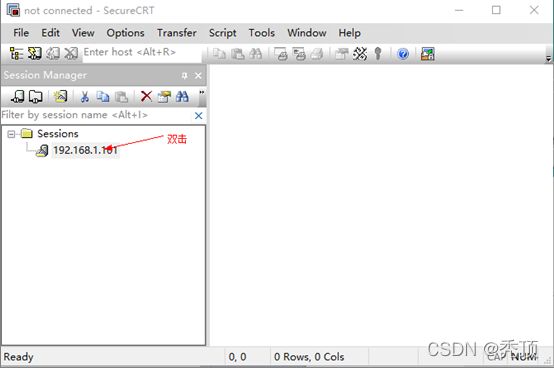

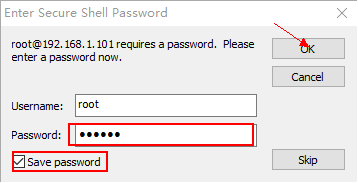

- 6.1 安装SecureCRT(英文版)

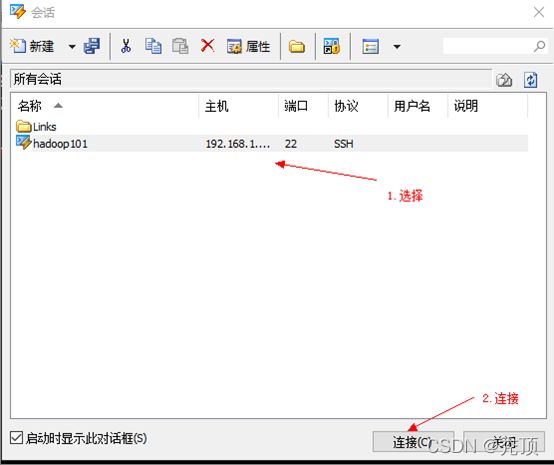

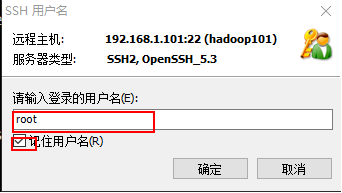

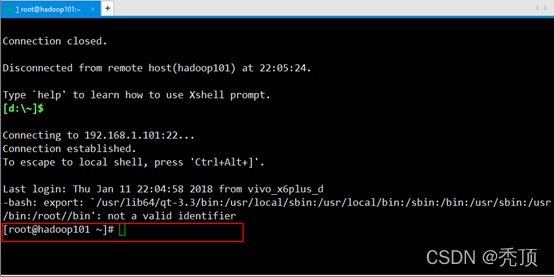

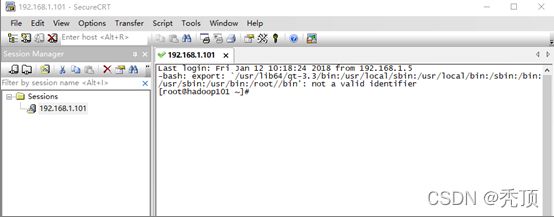

- 6.2 中文版SecureCRT的使用

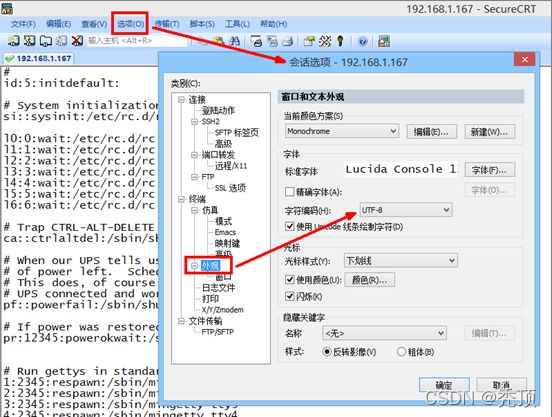

- 6.3 SecureCRT中文乱码解决方法

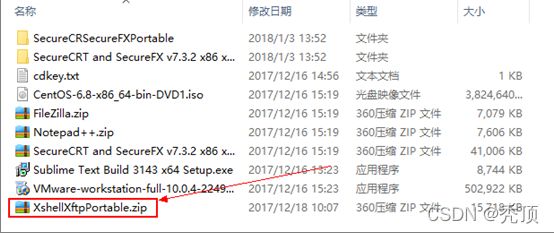

- 6.4 安装Xshell

- 第七章 常用基本命令

-

- 7.1 帮助命令

-

- 7.1.1 man 获得帮助信息

- 7.1.2 help 获得shell内置命令的帮助信息

- 7.1.3 常用快捷键

- 7.2 文件目录类

-

- 7.2.1 pwd 显示当前工作目录的绝对路径

- 7.2.2 ls 列出目录的内容

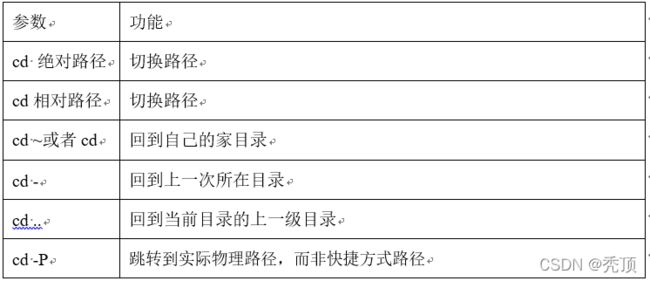

- 7.2.3 cd 切换目录

- 7.2.4 mkdir 创建一个新的目录

- 7.2.5 rmdir 删除一个空的目录

- 7.2.6 touch 创建空文件

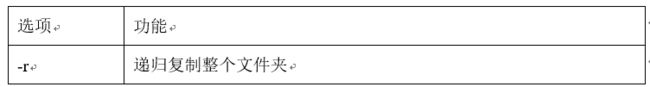

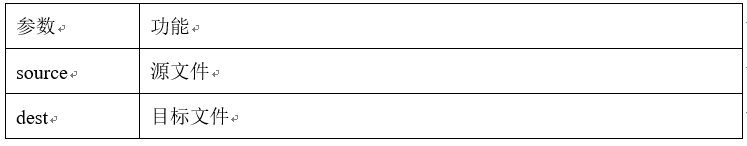

- 7.2.7 cp 复制文件或目录

- 7.2.8 rm 移除文件或目录

- 7.2.9 mv 移动文件与目录或重命名

- 7.2.10 cat 查看文件内容

- 7.2.11 more 文件内容分屏查看器

- 7.2.12 less 分屏显示文件内容

- 7.2.13 echo

- 7.2.14 head 显示文件头部内容

- 7.2.15 tail 输出文件尾部内容

- 7.2.16 > 输出重定向和 >> 追加

- 7.2.17 ln 软链接

- 7.2.18 history 查看已经执行过历史命令

- 7.3 时间日期类

-

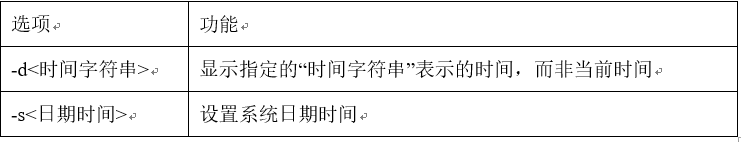

- 7.3.1 date 显示当前时间

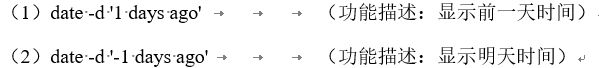

- 7.3.2 date 显示非当前时间

- 7.3.3 date 设置系统时间

- 7.3.4 cal 查看日历

- 7.4 用户管理命令

-

- 7.4.1 useradd 添加新用户

- 7.4.2 passwd 设置用户密码

- 7.4.3 id 查看用户是否存在

- 7.4.4 cat /etc/passwd 查看创建了哪些用户

- 7.4.5 su 切换用户

- 7.4.5 userdel 删除用户

- 7.4.6 who 查看登录用户信息

- 7.4.7 sudo 设置普通用户具有root权限

- 7.4.9 usermod 修改用户

- 7.5 用户组管理命令

-

- 7.5.1 groupadd 新增组

- 7.5.2 groupdel 删除组

- 7.5.4 cat /etc/group 查看创建了哪些组

- 7.6 文件权限类

-

- 7.6.1 文件属性

- 7.6.2 chmod 改变权限

- 7.6.3 chown 改变所有者

- 7.6.4 chgrp 改变所属组

- 7.7 搜索查找类

-

- 7.7.1 find 查找文件或者目录

- 7.7.2 locate快速定位文件路径

- 7.7.3 grep 过滤查找及“|”管道符

- 7.8 压缩和解压类

-

- 7.8.1 gzip/gunzip 压缩

- 7.8.2 zip/unzip 压缩

- 7.8.3 tar 打包

第一章 Linux入门

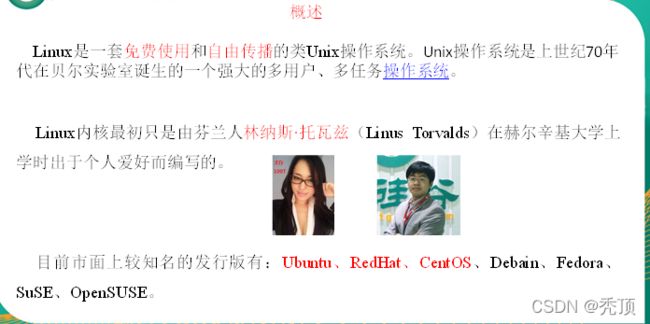

1.1 概述

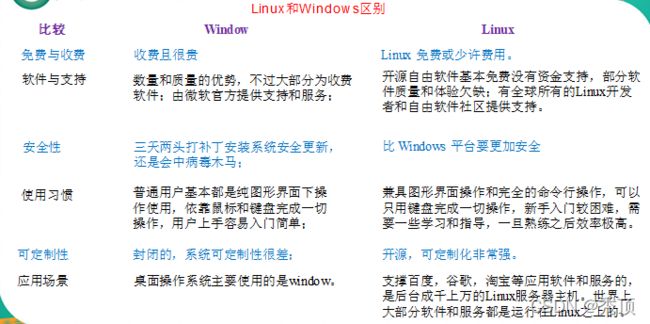

1.2 Linux和Windows区别

1.3 Centos下载地址

第二章 VM与Linux的安装

2.1 VMWare安装

具体安装步骤见安装步骤说明

2.2 CentOS安装

2.3 VMTools安装

具体步骤见安装步骤说明

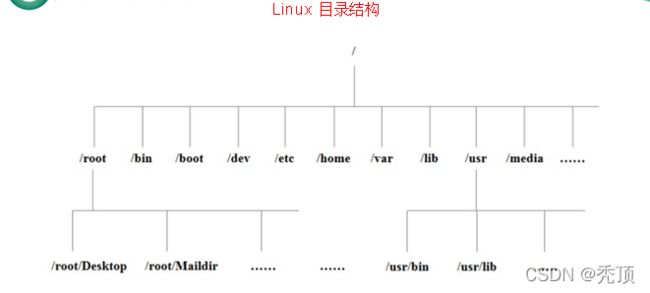

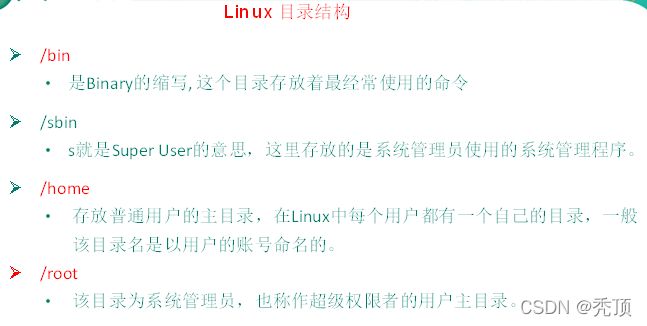

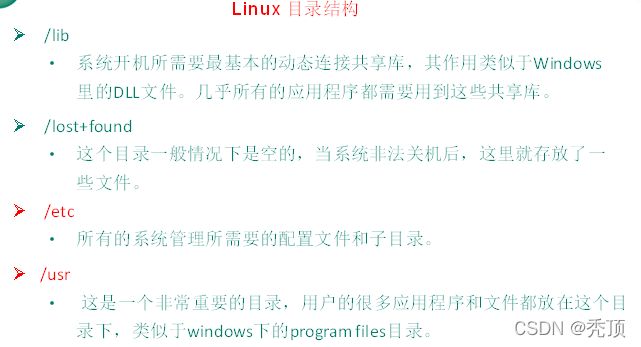

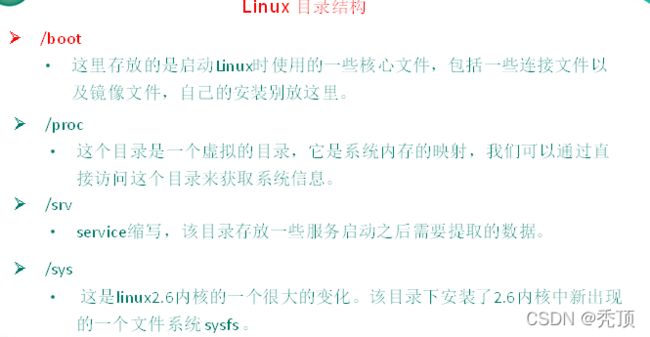

第三章 Linux文件与目录结构

3.1 Linux文件

Linux系统中一切皆文件。

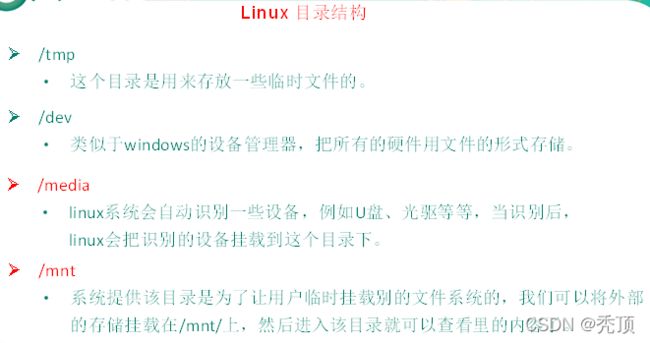

3.2 Linux目录结构

第四章 VI/VIM编辑器

4.1 是什么

VI是Unix操作系统和类Unix操作系统中最通用的文本编辑器。

VIM编辑器是从VI发展出来的一个性能更强大的文本编辑器。可以主动的以字体颜色辨别语法的正确性,方便程序设计。VIM与VI编辑器完全兼容。

4.2 测试数据准备

1)拷贝/etc/smartd.conf数据到/root目录下

[root@hadoop100 桌面]# cp /etc/smartd.conf /root

[root@hadoop100 桌面]# cd /root/

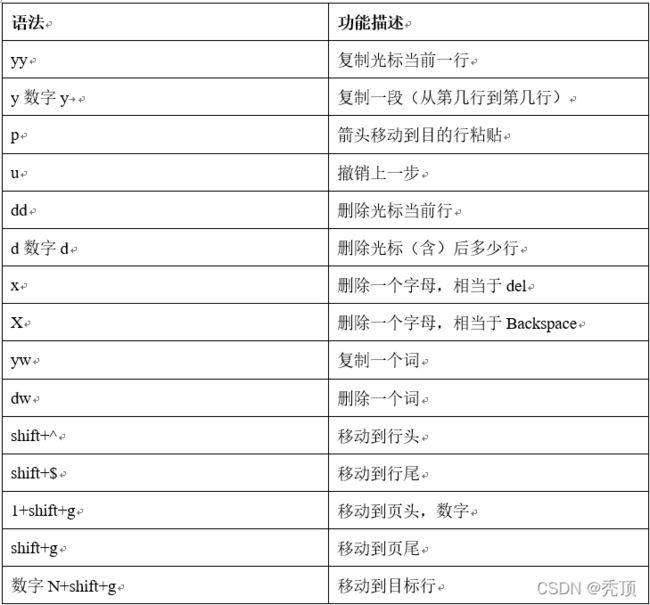

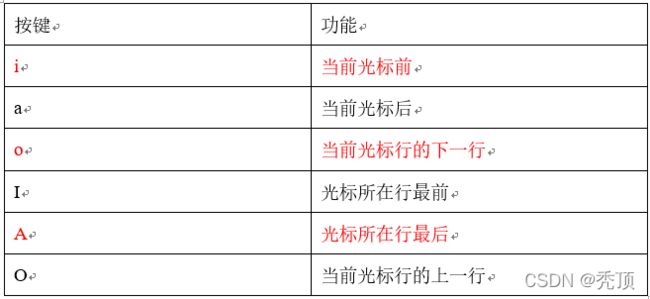

4.3 一般模式

以vi/vim打开一个文档就直接进入一般模式了(这是默认的模式)。在这个模式中, 可以用『上下左右』按键来移动光标,可以用『删除字符』、『删除整行』、『复制、粘贴』按键来处理文件内容。

常用语法

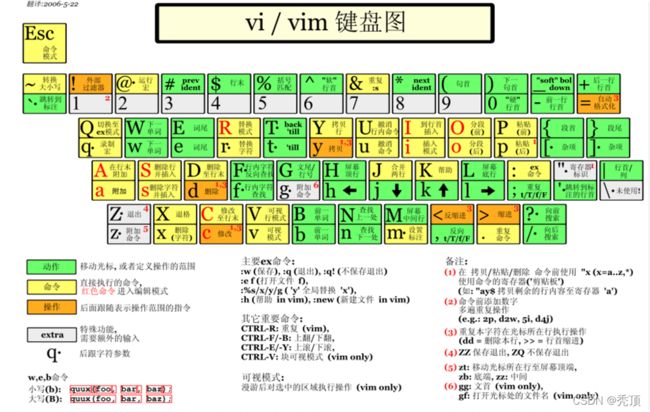

4.4 编辑模式

在一般模式中可以进行删除、复制、粘贴等的动作,但是却无法编辑文件内容!要等到你按下『i, I, o, O, a, A』等任何一个字母之后才会进入编辑模式。

通常在Linux中,按下这些按键时,在界面的左下方会出现『–插入–』的字样,此时才可以进行编辑。而如果要回到一般模式时,则必须要按下『Esc』这个按键即可退出编辑模式。

常用语法

1)进入编辑模式

2)退出编辑模式

按『Esc』键

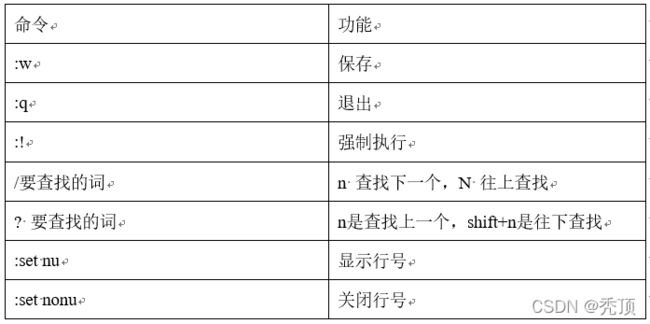

4.5 指令模式

在一般模式当中,输入『 : / ?』3个中的任何一个按钮,就可以将光标移动到最底下那一行。

在这个模式当中, 可以提供你『搜寻资料』的动作,而读取、存盘、大量取代字符、离开 vi 、显示行号等动作是在此模式中达成的!

1)基本语法

2)案例实操

(1)强制保存退出:wq!

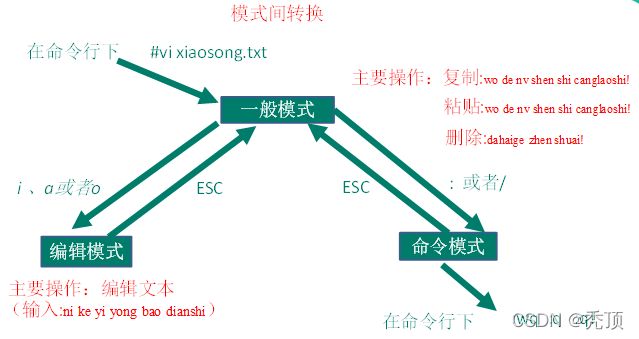

4.6 模式间转换

第五章 网络配置和系统管理操作

5.1 查看网络IP和网关

5.2 配置网络ip地址

5.2.1 ifconfig 配置网络接口

ifconfig :network interfaces configuring网络接口配置

1)基本语法:

ifconfig (功能描述:显示所有网络接口的配置信息)

2)案例实操:

(1)查看当前网络ip

[root@hadoop100 桌面]# ifconfig

5.2.2 ping 测试主机之间网络连通性

1)基本语法:

ping 目的主机 (功能描述:测试当前服务器是否可以连接目的主机)

2)案例实操:

(1)测试当前服务器是否可以连接百度

[root@hadoop100 桌面]# ping www.baidu.com

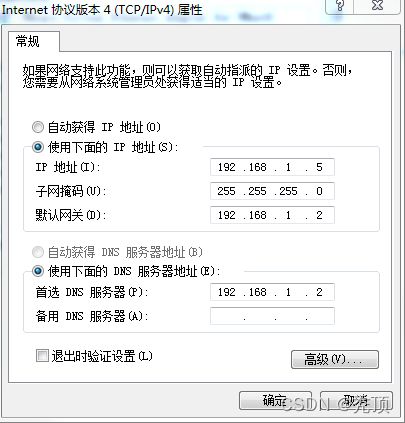

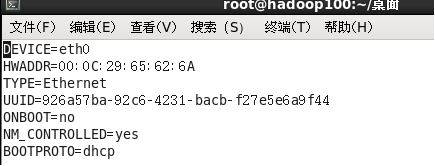

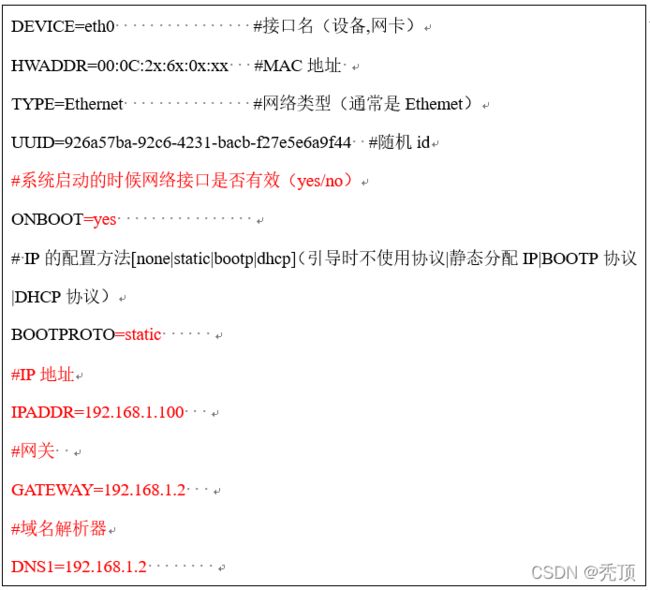

5.2.3 修改IP地址

1)修改IP地址

[root@hadoop100 桌面]#vim /etc/sysconfig/network-scripts/ifcfg-eth0

以下标红的项必须修改,有值的按照下面的值修改,没有该项的要增加。

修改后

:wq 保存退出

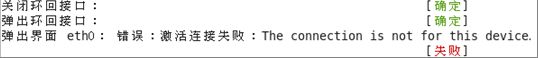

2)执行service network restart

3)如果报错,reboot,重启虚拟机

5.3 配置主机名

5.3.1 hostname 显示和设置系统的主机名称

1)基本语法:

hostname (功能描述:查看当前服务器的主机名称)

2)案例实操:

(1)查看当前服务器主机名称

[root@hadoop100 桌面]# hostname

5.3.2 修改主机名称

1)修改linux的主机映射文件(hosts文件)

(1)进入Linux系统查看本机的主机名。通过hostname命令查看

[root@hadoop100 桌面]# hostname

hadoop100

(2)如果感觉此主机名不合适,我们可以进行修改。通过编辑/etc/sysconfig/network文件

[root@hadoop100 桌面]# vi /etc/sysconfig/network

文件中内容

NETWORKING=yes

NETWORKING_IPV6=no

HOSTNAME= hadoop100

注意:主机名称不要有“_”下划线

(3)打开此文件后,可以看到主机名。修改此主机名为我们想要修改的主机名hadoop100。

(4)保存退出。

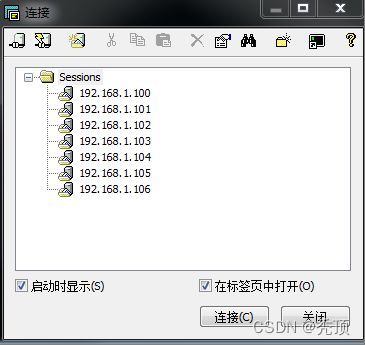

(5)打开/etc/hosts

[root@hadoop100 桌面]# vim /etc/hosts

添加如下内容

192.168.1.100 hadoop100

192.168.1.101 hadoop101

192.168.1.102 hadoop102

192.168.1.103 hadoop103

192.168.1.104 hadoop104

192.168.1.105 hadoop105

192.168.1.106 hadoop106

192.168.1.107 hadoop107

192.168.1.108 hadoop108

(6)并重启设备,重启后,查看主机名,已经修改成功

2)修改window7的主机映射文件(hosts文件)

(1)进入C:\Windows\System32\drivers\etc路径

(2)打开hosts文件并添加如下内容

192.168.1.100 hadoop100

192.168.1.101 hadoop101

192.168.1.102 hadoop102

192.168.1.103 hadoop103

192.168.1.104 hadoop104

192.168.1.105 hadoop105

192.168.1.106 hadoop106

192.168.1.107 hadoop107

192.168.1.108 hadoop108

3)修改window10的主机映射文件(hosts文件)

(1)进入C:\Windows\System32\drivers\etc路径

(2)拷贝hosts文件到桌面

(3)打开桌面hosts文件并添加如下内容

192.168.1.100 hadoop100

192.168.1.101 hadoop101

192.168.1.102 hadoop102

192.168.1.103 hadoop103

192.168.1.104 hadoop104

192.168.1.105 hadoop105

192.168.1.106 hadoop106

192.168.1.107 hadoop107

192.168.1.108 hadoop108

(4)将桌面hosts文件覆盖C:\Windows\System32\drivers\etc路径hosts文件

5.4 关闭防火墙

5.4.1 service 后台服务管理

1)基本语法:

service 服务名 start (功能描述:开启服务)

service 服务名 stop (功能描述:关闭服务)

service 服务名 restart (功能描述:重新启动服务)

service 服务名 status (功能描述:查看服务状态)

2)经验技巧

查看服务的方法:/etc/init.d/服务名

[root@hadoop100 init.d]# pwd

/etc/init.d

[root@hadoop100 init.d]# ls -al

3)案例实操

(1)查看网络服务的状态

[root@hadoop100 桌面]#service network status

(2)停止网络服务

[root@hadoop100 桌面]#service network stop

(3)启动网络服务

[root@hadoop100 桌面]#service network start

(4)重启网络服务

[root@hadoop100 桌面]#service network restart

(5)查看系统中所有的后台服务

[root@hadoop100 桌面]#service --status-all

5.4.2 chkconfig 设置后台服务的自启配置

1)基本语法:

chkconfig (功能描述:查看所有服务器自启配置)

chkconfig 服务名 off (功能描述:关掉指定服务的自动启动)

chkconfig 服务名 on (功能描述:开启指定服务的自动启动)

chkconfig 服务名 --list (功能描述:查看服务开机启动状态)

2)案例实操

(1)关闭iptables服务的自动启动

[root@hadoop100 桌面]#chkconfig iptables off

(2)开启iptables服务的自动启动

[root@hadoop100 桌面]#chkconfig iptables on

5.4.3 进程运行级别

5.4.4 关闭防火墙

1)临时关闭防火墙:

(1)查看防火墙状态

[root@hadoop100桌面]# service iptables status

(2)临时关闭防火墙

[root@hadoop100桌面]# service iptables stop

2)开机启动时关闭防火墙

(1)查看防火墙开机启动状态

[root@hadoop100桌面]#chkconfig iptables --list

(2)设置开机时关闭防火墙

[root@hadoop100桌面]#chkconfig iptables off

5.5 关机重启命令

在linux领域内大多用在服务器上,很少遇到关机的操作。毕竟服务器上跑一个服务是永无止境的,除非特殊情况下,不得已才会关机。

正确的关机流程为:sync > shutdown > reboot > halt

1)基本语法:

(1)sync (功能描述:将数据由内存同步到硬盘中)

(2)halt (功能描述:关闭系统,等同于shutdown -h now 和 poweroff)

(3)reboot (功能描述:就是重启,等同于 shutdown -r now)

(4)shutdown [选项] 时间

2)经验技巧:

Linux系统中为了提高磁盘的读写效率,对磁盘采取了 “预读迟写”操作方式。当用户保存文件时,Linux核心并不一定立即将保存数据写入物理磁盘中,而是将数据保存在缓冲区中,等缓冲区满时再写入磁盘,这种方式可以极大的提高磁盘写入数据的效率。但是,也带来了安全隐患,如果数据还未写入磁盘时,系统掉电或者其他严重问题出现,则将导致数据丢失。使用sync指令可以立即将缓冲区的数据写入磁盘。

3)案例实操:

(1)将数据由内存同步到硬盘中

[root@hadoop100桌面]#sync

(2)重启

[root@hadoop100桌面]# reboot

(3)关机

[root@hadoop100桌面]#halt

(4)计算机将在1分钟后关机,并且会显示在登录用户的当前屏幕中

[root@hadoop100桌面]#shutdown -h 1 ‘This server will shutdown after 1 mins’

(5)立马关机(等同于 halt)

[root@hadoop100桌面]# shutdown -h now

(6)系统立马重启(等同于 reboot)

[root@hadoop100桌面]# shutdown -r now

5.6 找回root密码

详见具体操作步骤

第六章 远程登录

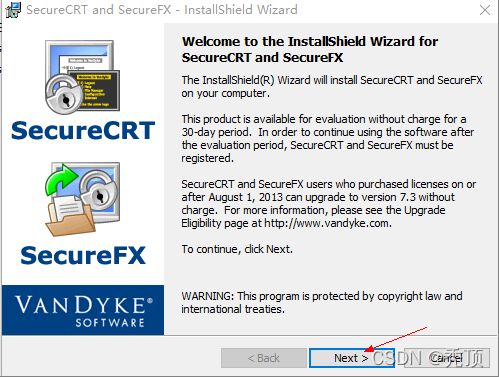

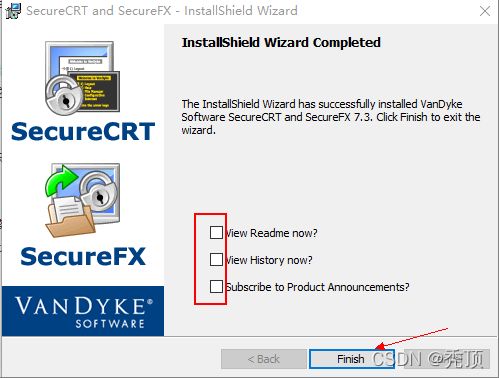

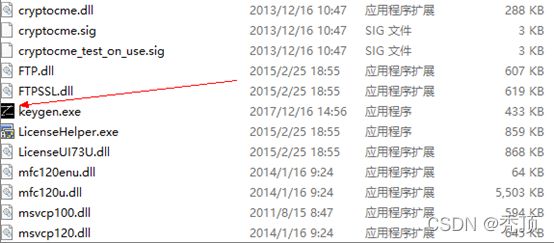

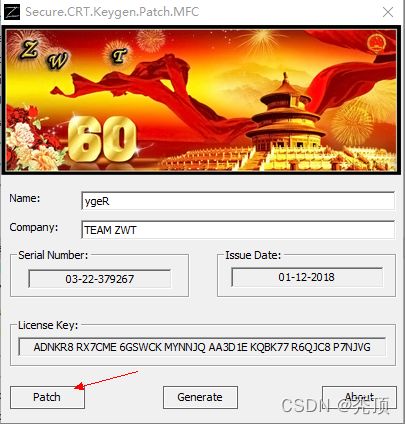

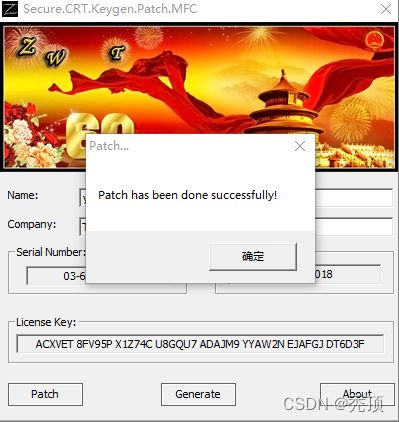

6.1 安装SecureCRT(英文版)

Linux远程登录及相关工具介绍

Linux一般作为服务器使用,而服务器一般放在机房,你不可能在机房操作你的Linux服务器。这时我们就需要远程登录到Linux服务器来管理维护系统。

Linux系统中是通过SSH服务实现的远程登录功能,默认ssh服务端口号为 22。Window系统上Linux远程登录客户端有SecureCRT,Putty,SSH Secure Shell,XShell等。

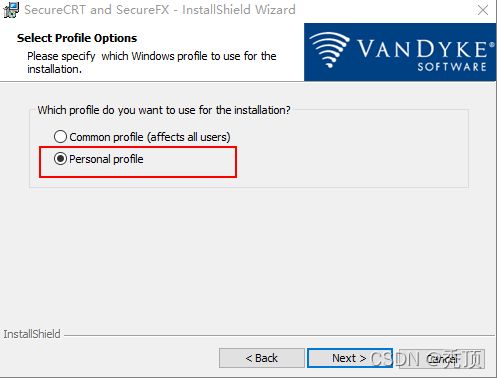

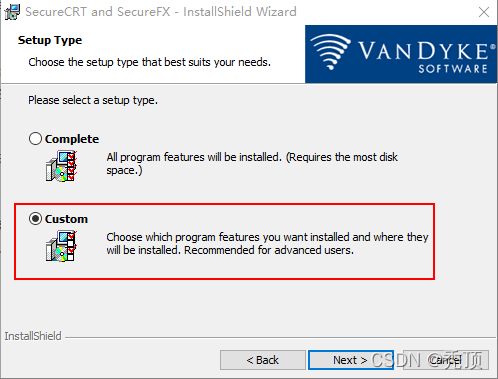

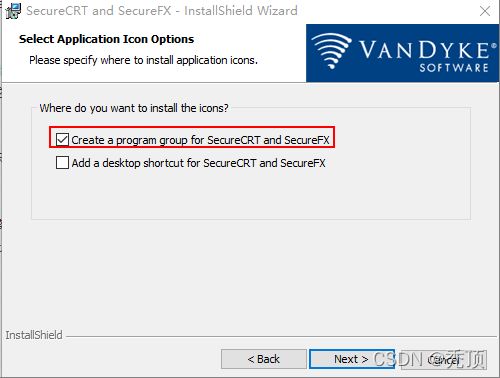

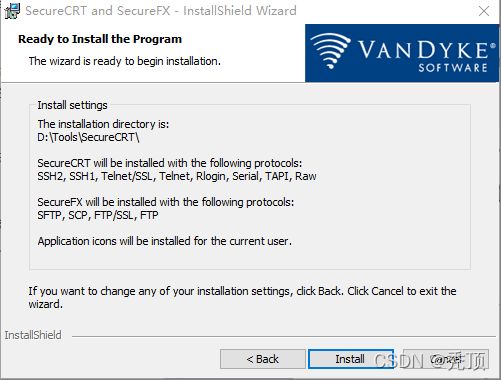

1)安装步骤

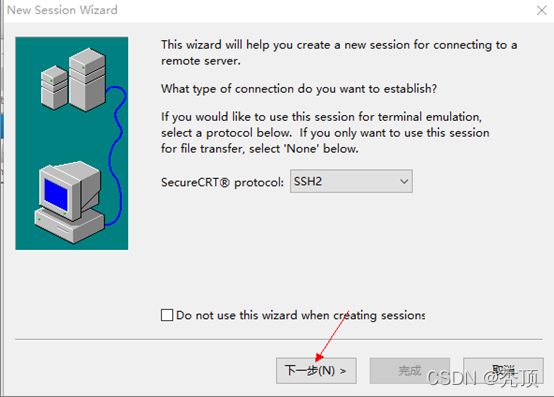

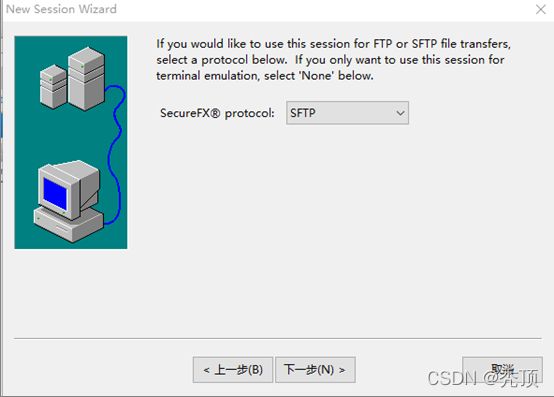

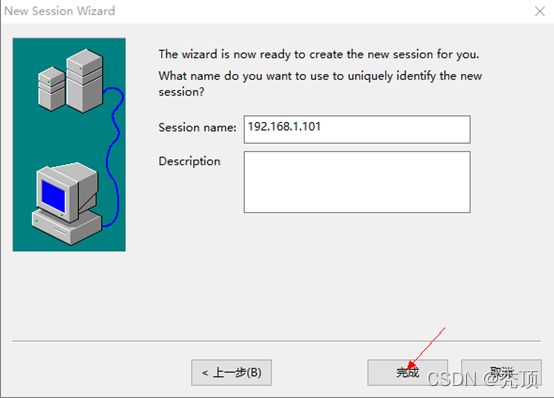

6.2 中文版SecureCRT的使用

6.3 SecureCRT中文乱码解决方法

1)重新查看会话,是否中文显示正常

2)依然无法正常显示中文,可能是由于Linux系统中默认的字符编码非UTF8所致

用root用户登录。输入cat /etc/sysconfig/i18n

如果安装系统为中文系统,则修改【LANG=“zh_CN.UTF-8”】

如果安装系统为英文系统,则修改【LANG=“en_US.UTF-8”】

保存文件。 断开SSH,重新登录。就正常了

下面是修改后的查看

[root@hadoop101 ~]# cat /etc/sysconfig/i18n

LANG=“zh_CN.UTF-8”

3)调整设置CRT解决

6.4 安装Xshell

第七章 常用基本命令

7.1 帮助命令

7.1.1 man 获得帮助信息

1)基本语法:

man [命令或配置文件] (功能描述:获得帮助信息)

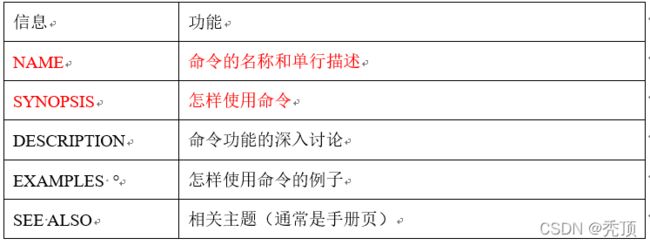

2)显示说明

3)案例实操

(1)查看ls命令的帮助信息

[root@hadoop101 ~]# man ls

7.1.2 help 获得shell内置命令的帮助信息

1)基本语法:

help 命令 (功能描述:获得shell内置命令的帮助信息)

2)案例实操:

(1)查看cd命令的帮助信息

[root@hadoop101 ~]# help cd

7.1.3 常用快捷键

7.2 文件目录类

7.2.1 pwd 显示当前工作目录的绝对路径

pwd:print working directory 打印工作目录

1)基本语法:

pwd (功能描述:显示当前工作目录的绝对路径)

2)案例实操

(1)显示当前工作目录的绝对路径

[root@hadoop101 ~]# pwd

/root

7.2.2 ls 列出目录的内容

ls:list 列出目录内容

1)基本语法:

ls [选项] [目录或是文件]

2)选项说明:

3)显示说明:

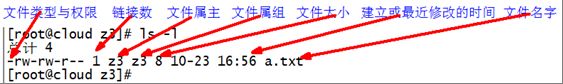

每行列出的信息依次是: 文件类型与权限 链接数 文件属主 文件属组 文件大小用byte来表示 建立或最近修改的时间 名字

4)案例实操

(1)查看当前目录的所有内容信息

[root@hadoop101 ~]$ ls -al

总用量 44

drwxr-xr-x. 2 root root 4096 3月 6 21:16 公共的

drwxr-xr-x. 2 root root 4096 3月 6 21:16 模板

drwxr-xr-x. 2 root root 4096 3月 6 21:16 视频

7.2.3 cd 切换目录

cd:Change Directory切换路径

1)基本语法:

cd [参数]

2)参数说明

3)案例实操

(1)使用绝对路径切换到root目录

[root@hadoop101 ~]# cd /root/

(2)使用相对路径切换到“公共的”目录

[root@hadoop101 ~]# cd 公共的/

(3)表示回到自己的家目录,亦即是 /root 这个目录

[root@hadoop101 公共的]# cd ~

(4)cd- 回到上一次所在目录

[root@hadoop101 ~]# cd -

(5)表示回到当前目录的上一级目录,亦即是 “/root/公共的”的上一级目录的意思;

[root@hadoop101 公共的]# cd ..

7.2.4 mkdir 创建一个新的目录

mkdir:Make directory 建立目录

1)基本语法:

mkdir [选项] 要创建的目录

2)选项说明:

3)案例实操

(1)创建一个目录

[root@hadoop101 ~]# mkdir xiyou

[root@hadoop101 ~]# mkdir xiyou/mingjie

(2)创建一个多级目录

[root@hadoop101 ~]# mkdir -p xiyou/dssz/meihouwang

7.2.5 rmdir 删除一个空的目录

rmdir:Remove directory 移动目录

1)基本语法:

rmdir 要删除的空目录

2)案例实操

(1)删除一个空的文件夹

[root@hadoop101 ~]# rmdir xiyou/dssz/meihouwang

7.2.6 touch 创建空文件

1)基本语法:

touch 文件名称

2)案例实操

[root@hadoop101 ~]# touch xiyou/dssz/sunwukong.txt

7.2.7 cp 复制文件或目录

1)基本语法:

cp [选项] source dest (功能描述:复制source文件到dest)

2)选项说明

3)参数说明

4)经验技巧

强制覆盖不提示的方法:\cp

5)案例实操

(1)复制文件

[root@hadoop101 ~]# cp xiyou/dssz/suwukong.txt xiyou/mingjie/

(2)递归复制整个文件夹

[root@hadoop101 ~]# cp -r xiyou/dssz/ ./

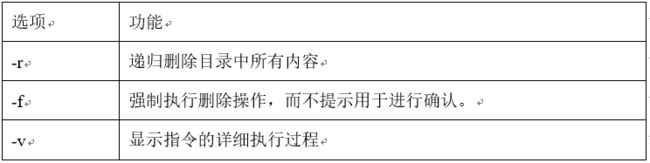

7.2.8 rm 移除文件或目录

1)基本语法

rm [选项] deleteFile (功能描述:递归删除目录中所有内容)

2)选项说明

3)案例实操

(1)删除目录中的内容

[root@hadoop101 ~]# rm xiyou/mingjie/sunwukong.txt

(2)递归删除目录中所有内容

[root@hadoop101 ~]# rm -rf dssz/

7.2.9 mv 移动文件与目录或重命名

1)基本语法:

(1)mv oldNameFile newNameFile (功能描述:重命名)

(2)mv /temp/movefile /targetFolder (功能描述:移动文件)

2)案例实操:

(1)重命名

[root@hadoop101 ~]# mv xiyou/dssz/suwukong.txt xiyou/dssz/houge.txt

(2)移动文件

[root@hadoop101 ~]# mv xiyou/dssz/houge.txt ./

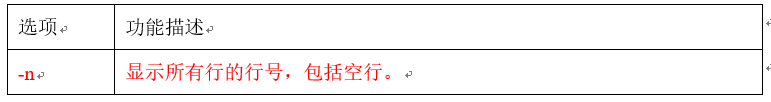

7.2.10 cat 查看文件内容

查看文件内容,从第一行开始显示。

1)基本语法

cat [选项] 要查看的文件

2)选项说明

3)经验技巧:

一般查看比较小的文件,一屏幕能显示全的。

4)案例实操

(1)查看文件内容并显示行号

[root@hadoop101 ~]$ cat -n houge.txt

7.2.11 more 文件内容分屏查看器

more指令是一个基于VI编辑器的文本过滤器,它以全屏幕的方式按页显示文本文件的内容。more指令中内置了若干快捷键,详见操作说明。

1)基本语法:

more 要查看的文件

2)操作说明

3)案例实操

(1)采用more查看文件

[root@hadoop101 ~]# more smartd.conf

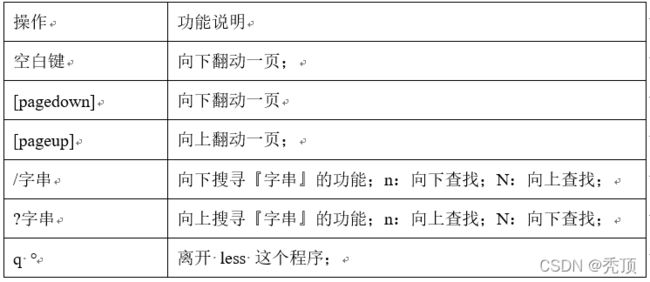

7.2.12 less 分屏显示文件内容

less指令用来分屏查看文件内容,它的功能与more指令类似,但是比more指令更加强大,支持各种显示终端。less指令在显示文件内容时,并不是一次将整个文件加载之后才显示,而是根据显示需要加载内容,对于显示大型文件具有较高的效率。

1)基本语法:

less 要查看的文件

2)操作说明

3)经验技巧

用SecureCRT时[pagedown]和[pageup]可能会出现无法识别的问题。

4)案例实操

(1)采用less查看文件

[root@hadoop101 ~]# less smartd.conf

7.2.13 echo

1)echo输出内容到控制台

(1)基本语法:

echo [选项] [输出内容]

(2)选项说明

-e: 支持反斜线控制的字符转换

(3)案例实操

[root@hadoop101 ~]$ echo "hello\tworld"

hello\tworld

[root@hadoop101 ~]$ echo -e "hello\tworld"

hello world

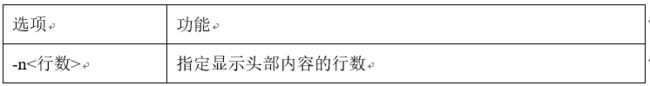

7.2.14 head 显示文件头部内容

head用于显示文件的开头部分内容,默认情况下head指令显示文件的前10行内容。

1)基本语法

head 文件 (功能描述:查看文件头10行内容)

head -n 5 文件 (功能描述:查看文件头5行内容,5可以是任意行数)

2)选项说明

3)案例实操

(1)查看文件的头2行

[root@hadoop101 ~]# head -n 2 smartd.conf

7.2.15 tail 输出文件尾部内容

tail用于输出文件中尾部的内容,默认情况下tail指令显示文件的前10行内容。

1)基本语法

(1)tail 文件 (功能描述:查看文件头10行内容)

(2)tail -n 5 文件 (功能描述:查看文件头5行内容,5可以是任意行数)

(3)tail -f 文件 (功能描述:实时追踪该文档的所有更新)

2)选项说明

3)案例实操

(1)查看文件头1行内容

[root@hadoop101 ~]# tail -n 1 smartd.conf

(2)实时追踪该档的所有更新

[root@hadoop101 ~]# tail -f houge.txt

7.2.16 > 输出重定向和 >> 追加

1)基本语法:

(1)ls -l >文件 (功能描述:列表的内容写入文件a.txt中(覆盖写))

(2)ls -al >>文件 (功能描述:列表的内容追加到文件aa.txt的末尾)

(3)cat 文件1 > 文件2 (功能描述:将文件1的内容覆盖到文件2)

(4)echo “内容” >> 文件

2)案例实操

(1)将ls查看信息写入到文件中

[root@hadoop101 ~]# ls -l>houge.txt

(2)将ls查看信息追加到文件中

[root@hadoop101 ~]# ls -l>>houge.txt

(3)采用echo将hello单词追加到文件中

[root@hadoop101 ~]# echo hello>>houge.txt

7.2.17 ln 软链接

软链接也成为符号链接,类似于windows里的快捷方式,有自己的数据块,主要存放了链接其他文件的路径。

1)基本语法:

ln -s [原文件或目录] [软链接名] (功能描述:给原文件创建一个软链接)

2)经验技巧

删除软链接: rm -rf 软链接名,而不是rm -rf 软链接名/

查询:通过ll就可以查看,列表属性第1位是l,尾部会有位置指向。

3)案例实操:

(1)创建软连接

[root@hadoop101 ~]# mv houge.txt xiyou/dssz/

[root@hadoop101 ~]# ln -s xiyou/dssz/houge.txt ./houzi

[root@hadoop101 ~]# ll

lrwxrwxrwx. 1 root root 20 6月 17 12:56 houzi -> xiyou/dssz/houge.txt

(2)删除软连接

[root@hadoop101 ~]# rm -rf houzi

(3)进入软连接实际物理路径

[root@hadoop101 ~]# ln -s xiyou/dssz/ ./dssz

[root@hadoop101 ~]# cd -P dssz/

7.2.18 history 查看已经执行过历史命令

1)基本语法:

history (功能描述:查看已经执行过历史命令)

2)案例实操

(1)查看已经执行过的历史命令

[root@hadoop101 ~]# history

7.3 时间日期类

1)基本语法

date [OPTION]… [+FORMAT]

2)选项说明

3)参数说明

7.3.1 date 显示当前时间

[root@hadoop101 ~]# date

2017年 06月 19日 星期一 20:53:30 CST

(2)显示当前时间年月日

[root@hadoop101 ~]# date +%Y%m%d

20170619

(3)显示当前时间年月日时分秒

[root@hadoop101 ~]# date "+%Y-%m-%d %H:%M:%S"

2017-06-19 20:54:58

7.3.2 date 显示非当前时间

[root@hadoop101 ~]# date -d '1 days ago'

2017年 06月 18日 星期日 21:07:22 CST

(2)显示明天时间

[root@hadoop101 ~]#date -d '-1 days ago'

2017年 06月 20日 星期日 21:07:22 CST

7.3.3 date 设置系统时间

1)基本语法:

date -s 字符串时间

2)案例实操

(1)设置系统当前时间

[root@hadoop101 ~]# date -s “2017-06-19 20:52:18”

7.3.4 cal 查看日历

[root@hadoop101 ~]# cal

(2)查看2017年的日历

[root@hadoop101 ~]# cal 2017

7.4 用户管理命令

7.4.1 useradd 添加新用户

1)基本语法:

useradd 用户名 (功能描述:添加新用户)

useradd -g 组名 用户名 (功能描述:添加新用户到某个组)

2)案例实操:

(1)添加一个用户

[root@hadoop101 ~]# useradd tangseng

[root@hadoop101 ~]#ll /home/

7.4.2 passwd 设置用户密码

1)基本语法:

passwd 用户名 (功能描述:设置用户密码)

2)案例实操

(1)设置用户的密码

[root@hadoop101 ~]# passwd tangseng

7.4.3 id 查看用户是否存在

1)基本语法:

id 用户名

2)案例实操:

(1)查看用户是否存在

[root@hadoop101 ~]#id tangseng

7.4.4 cat /etc/passwd 查看创建了哪些用户

1)基本语法:

[root@hadoop101 ~]# cat /etc/passwd

7.4.5 su 切换用户

su: swith user 切换用户

1)基本语法:

su 用户名称 (功能描述:切换用户,只能获得用户的执行权限,不能获得环境变量)

su - 用户名称 (功能描述:切换到用户并获得该用户的环境变量及执行权限)

2)案例实操

(1)切换用户

[root@hadoop101 ~]#su tangseng

[root@hadoop101 ~]#echo $PATH

/usr/lib64/qt-3.3/bin:/usr/local/sbin:/usr/local/bin:/sbin:/bin:/usr/sbin:/usr/bin:/root/bin

[root@hadoop101 ~]#exit

[root@hadoop101 ~]#su - tangseng

[root@hadoop101 ~]#echo $PATH

/usr/lib64/qt-3.3/bin:/usr/local/bin:/bin:/usr/bin:/usr/local/sbin:/usr/sbin:/sbin:/home/tangseng/bin

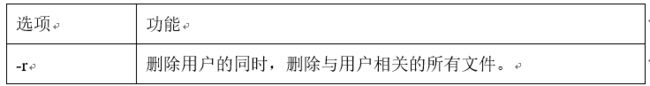

7.4.5 userdel 删除用户

1)基本语法:

(1)userdel 用户名 (功能描述:删除用户但保存用户主目录)

(2)userdel -r 用户名 (功能描述:用户和用户主目录,都删除)

2)选项说明

3)案例实操:

(1)删除用户但保存用户主目录

[root@hadoop101 ~]#userdel tangseng

[root@hadoop101 ~]#ll /home/

(2)删除用户和用户主目录,都删除

[root@hadoop101 ~]#useradd zhubajie

[root@hadoop101 ~]#ll /home/

[root@hadoop101 ~]#userdel -r zhubajie

[root@hadoop101 ~]#ll /home/

7.4.6 who 查看登录用户信息

1)基本语法

(1)whoami (功能描述:显示自身用户名称)

(2)who am i (功能描述:显示登录用户的用户名)

2)案例实操

(1)显示自身用户名称

[root@hadoop101 opt]# whoami

(2)显示登录用户的用户名

[root@hadoop101 opt]# who am i

7.4.7 sudo 设置普通用户具有root权限

1)添加atguigu用户,并对其设置密码。

[root@hadoop101 ~]#useradd atguigu

[root@hadoop101 ~]#passwd atguigu

2)修改配置文件

[root@hadoop101 ~]#vi /etc/sudoers

修改 /etc/sudoers 文件,找到下面一行(91行),在root下面添加一行,如下所示:

或者配置成采用sudo命令时,不需要输入密码

修改完毕,现在可以用atguigu帐号登录,然后用命令 sudo ,即可获得root权限进行操作。

3)案例实操

(1)用普通用户在/opt目录下创建一个文件夹

[atguigu@hadoop101 opt]$ sudo mkdir module

[root@hadoop101 opt]# chown atguigu:atguigu module/

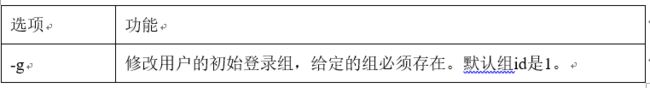

7.4.9 usermod 修改用户

1)基本语法:

usermod -g 用户组 用户名

2)选项说明

3)案例实操:

(1)将用户加入到用户组

[root@hadoop101 opt]#usermod -g root zhubajie

7.5 用户组管理命令

每个用户都有一个用户组,系统可以对一个用户组中的所有用户进行集中管理。不同Linux 系统对用户组的规定有所不同,

如Linux下的用户属于与它同名的用户组,这个用户组在创建用户时同时创建。

用户组的管理涉及用户组的添加、删除和修改。组的增加、删除和修改实际上就是对/etc/group文件的更新。

7.5.1 groupadd 新增组

1)基本语法

groupadd 组名

2)案例实操:

(1)添加一个xitianqujing组

[root@hadoop101 opt]#groupadd xitianqujing

7.5.2 groupdel 删除组

1)基本语法:

groupdel 组名

2)案例实操

(1)删除xitianqujing组

[root@hadoop101 opt]# groupdel xitianqujing

7.5.3 groupmod 修改组

1)基本语法:

groupmod -n 新组名 老组名

2)选项说明

3)案例实操

(1)修改atguigu组名称为atguigu1

[root@hadoop101 ~]#groupadd xitianqujing

[root@hadoop101 ~]# groupmod -n xitian xitianqujing

7.5.4 cat /etc/group 查看创建了哪些组

1)基本操作

[root@hadoop101 atguigu]# cat /etc/group

7.6 文件权限类

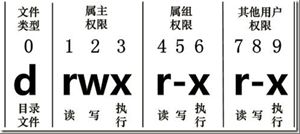

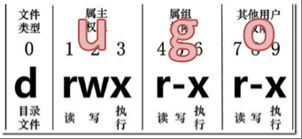

7.6.1 文件属性

Linux系统是一种典型的多用户系统,不同的用户处于不同的地位,拥有不同的权限。为了保护系统的安全性,Linux系统对不同的用户访问同一文件(包括目录文件)的权限做了不同的规定。在Linux中我们可以使用ll或者ls -l命令来显示一个文件的属性以及文件所属的用户和组。

1)从左到右的10个字符表示:

如果没有权限,就会出现减号[ - ]而已。从左至右用0-9这些数字来表示:

(1)0首位表示类型

在Linux中第一个字符代表这个文件是目录、文件或链接文件等等

- 代表文件

d 代表目录

l 链接文档(link file);

(2)第1-3位确定属主(该文件的所有者)拥有该文件的权限。—User

(3)第4-6位确定属组(所有者的同组用户)拥有该文件的权限,—Group

(4)第7-9位确定其他用户拥有该文件的权限 —Other

2)rxw作用文件和目录的不同解释

(1)作用到文件:

[ r ]代表可读(read): 可以读取,查看

[ w ]代表可写(write): 可以修改,但是不代表可以删除该文件,删除一个文件的前提条件是对该文件所在的目录有写权限,才能删除该文件.

[ x ]代表可执行(execute):可以被系统执行

(2)作用到目录:

[ r ]代表可读(read): 可以读取,ls查看目录内容

[ w ]代表可写(write): 可以修改,目录内创建+删除+重命名目录

[ x ]代表可执行(execute):可以进入该目录

3)案例实操

[root@hadoop101 ~]# ll

总用量 104

-rw-------. 1 root root 1248 1月 8 17:36 anaconda-ks.cfg

drwxr-xr-x. 2 root root 4096 1月 12 14:02 dssz

lrwxrwxrwx. 1 root root 20 1月 12 14:32 houzi -> xiyou/dssz/houge.txt

(1)如果查看到是文件:链接数指的是硬链接个数。创建硬链接方法

ln [原文件] [目标文件]

[root@hadoop101 ~]# ln xiyou/dssz/houge.txt ./hg.txt

(2)如果查看的是文件夹:链接数指的是子文件夹个数。

[root@hadoop101 ~]# ls -al xiyou/

总用量 16

drwxr-xr-x. 4 root root 4096 1月 12 14:00 .

dr-xr-x---. 29 root root 4096 1月 12 14:32 ..

drwxr-xr-x. 2 root root 4096 1月 12 14:30 dssz

drwxr-xr-x. 2 root root 4096 1月 12 14:04 mingjie

7.6.2 chmod 改变权限

1)基本语法:

第一种方式变更权限

chmod [{ugoa}{±=}{rwx}] 文件或目录

第二种方式变更权限

chmod [mode=421 ] [文件或目录]

2)经验技巧

u:所有者 g:所有组 o:其他人 a:所有人(u、g、o的总和)

r=4 w=2 x=1 rwx=4+2+1=7

3)案例实操

(1)修改文件使其所属主用户具有执行权限

[root@hadoop101 ~]# cp xiyou/dssz/houge.txt ./

[root@hadoop101 ~]# chmod u+x houge.txt

(2)修改文件使其所属组用户具有执行权限

[root@hadoop101 ~]# chmod g+x houge.txt

(3)修改文件所属主用户执行权限,并使其他用户具有执行权限

[root@hadoop101 ~]# chmod u-x,o+x houge.txt

(4)采用数字的方式,设置文件所有者、所属组、其他用户都具有可读可写可执行权限。

[root@hadoop101 ~]# chmod 777 houge.txt

(5)修改整个文件夹里面的所有文件的所有者、所属组、其他用户都具有可读可写可执行权限。

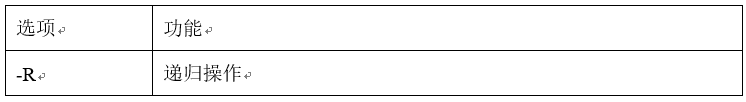

[root@hadoop101 ~]# chmod -R 777 xiyou/

7.6.3 chown 改变所有者

1)基本语法:

chown [选项] [最终用户] [文件或目录] (功能描述:改变文件或者目录的所有者)

2)选项说明

3)案例实操

(1)修改文件所有者

[root@hadoop101 ~]# chown atguigu houge.txt

[root@hadoop101 ~]# ls -al

-rwxrwxrwx. 1 atguigu root 551 5月 23 13:02 houge.txt

(2)递归改变文件所有者和所有组

[root@hadoop101 xiyou]# ll

drwxrwxrwx. 2 root root 4096 9月 3 21:20 xiyou

[root@hadoop101 xiyou]# chown -R atguigu:atguigu xiyou/

[root@hadoop101 xiyou]# ll

drwxrwxrwx. 2 atguigu atguigu 4096 9月 3 21:20 xiyou

7.6.4 chgrp 改变所属组

1)基本语法:

chgrp [最终用户组] [文件或目录] (功能描述:改变文件或者目录的所属组)

2)案例实操

(1)修改文件的所属组

[root@hadoop101 ~]# chgrp root houge.txt

[root@hadoop101 ~]# ls -al

-rwxrwxrwx. 1 atguigu root 551 5月 23 13:02 houge.txt

7.7 搜索查找类

7.7.1 find 查找文件或者目录

find指令将从指定目录向下递归地遍历其各个子目录,将满足条件的文件显示在终端。

1)基本语法:

find [搜索范围] [选项]

2)选项说明

3)案例实操

(1)按文件名:根据名称查找/目录下的filename.txt文件。

[root@hadoop101 ~]# find xiyou/ -name *.txt

(2)按拥有者:查找/opt目录下,用户名称为-user的文件

[root@hadoop101 ~]# find xiyou/ -user atguigu

(3)按文件大小:在/home目录下查找大于200m的文件(+n 大于 -n小于 n等于)

[root@hadoop101 ~]find /home -size +204800

7.7.2 locate快速定位文件路径

locate指令利用事先建立的系统中所有文件名称及路径的locate数据库实现快速定位给定的文件。Locate指令无需遍历整个文件系统,查询速度较快。为了保证查询结果的准确度,管理员必须定期更新locate时刻。

1)基本语法

locate 搜索文件

2)经验技巧

由于locate指令基于数据库进行查询,所以第一次运行前,必须使用updatedb指令创建locate数据库。

3)案例实操

(1)查询文件夹

[root@hadoop101 ~]# updated

[root@hadoop101 ~]#locate tmp

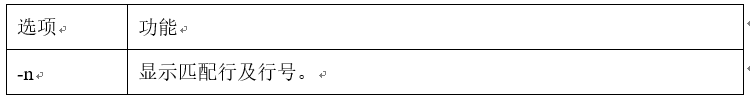

7.7.3 grep 过滤查找及“|”管道符

0)管道符,“|”,表示将前一个命令的处理结果输出传递给后面的命令处理

1)基本语法

grep 选项 查找内容 源文件

2)选项说明

3)案例实操

(1)查找某文件在第几行

[root@hadoop101 ~]# ls | grep -n test

7.8 压缩和解压类

7.8.1 gzip/gunzip 压缩

1)基本语法:

gzip 文件 (功能描述:压缩文件,只能将文件压缩为*.gz文件)

gunzip 文件.gz (功能描述:解压缩文件命令)

2)经验技巧:

(1)只能压缩文件不能压缩目录

(2)不保留原来的文件

3)案例实操

(1)gzip压缩

[root@hadoop101 ~]# ls

test.java

[root@hadoop101 ~]# gzip houge.txt

[root@hadoop101 ~]# ls

houge.txt.gz

(2)gunzip解压缩文件

[root@hadoop101 ~]# gunzip houge.txt.gz

[root@hadoop101 ~]# ls

houge.txt

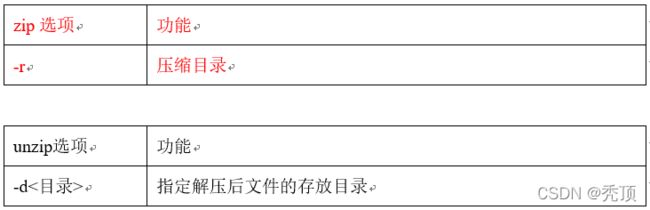

7.8.2 zip/unzip 压缩

1)基本语法:

zip [选项] XXX.zip 将要压缩的内容 (功能描述:压缩文件和目录的命令)

unzip [选项] XXX.zip (功能描述:解压缩文件)

2)选项说明

3)经验技巧

zip 压缩命令在window/linux都通用,可以压缩目录且保留源文件。

4)案例实操:

(1)压缩 1.txt 和2.txt,压缩后的名称为mypackage.zip

[root@hadoop101 opt]# touch bailongma.txt

[root@hadoop101 ~]# zip houma.zip houge.txt bailongma.txt

adding: houge.txt (stored 0%)

adding: bailongma.txt (stored 0%)

[root@hadoop101 opt]# ls

houge.txt bailongma.txt houma.zip

(2)解压 mypackage.zip

[root@hadoop101 ~]# unzip houma.zip

Archive: houma.zip

extracting: houge.txt

extracting: bailongma.txt

[root@hadoop101 ~]# ls

houge.txt bailongma.txt houma.zip

(3)解压mypackage.zip到指定目录-d

[root@hadoop101 ~]# unzip houma.zip -d /opt

[root@hadoop101 ~]# ls /opt/

7.8.3 tar 打包

1)基本语法:

tar [选项] XXX.tar.gz 将要打包进去的内容 (功能描述:打包目录,压缩后的文件格式.tar.gz)

2)选项说明

3)案例实操

(1)压缩多个文件

[root@hadoop101 opt]# tar -zcvf houma.tar.gz houge.txt bailongma.txt

houge.txt

bailongma.txt

[root@hadoop101 opt]# ls

houma.tar.gz houge.txt bailongma.txt

(2)压缩目录

[root@hadoop101 ~]# tar -zcvf xiyou.tar.gz xiyou/

xiyou/

xiyou/mingjie/

xiyou/dssz/

xiyou/dssz/houge.txt

(3)解压到当前目录

[root@hadoop101 ~]# tar -zxvf houma.tar.gz

(4)解压到指定目录

[root@hadoop101 ~]# tar -zxvf xiyou.tar.gz -C /opt

[root@hadoop101 ~]# ll /opt/