领域自适应的语义集中:Semantic Concentration for Domain Adaptation

Accepted by International Conference on Computer Vision(ICCV 2021),发文高校和企业为北京理工大学、阿里巴巴集团、爱丁堡大学、嬴彻科技。

目录

-

- 1.摘要

- 2.思想

- 3.创新与贡献

- 4.SCDA模型

-

- 4.1 SCDA对抗过程

- 4.2 模型图

- 4.3 放大不相关区域

- 4.4 抑制不相关语义信息

- 4.5 总的损失函数

- 5.实验

-

- 5.1 DomainNet(6个域共345个类)

- 5.2 Office-Home(4个域共65个类)

- 5.3 Office-31(3个域共31个类)

- 6.总结

1.摘要

领域自适应(DA)通过从标签丰富的源域到相关但未标记的目标域的知识转移,为标签标注和数据集偏差问题铺平了道路。

目前DA方法的主流是对齐两个域的特征分布。然而,它们中的大多数关注于整个图像特征,其中不可避免地嵌入了不相关的语义信息,例如混乱的背景。在这种情况下强制执行特征对齐将对对象的正确匹配产生负面影响,从而由于不相关语义的混淆而导致语义上的负迁移。

为了缓解域偏移问题,DA 的常见做法是通过学习域不变的特征表示来减少跨域分布差异。一般来说,这些 DA 方法可以大致分为基于差异的方法,通过最小化设计良好的统计度量来对齐域分布,以及基于对抗的方法,其中域鉴别器旨在区分源样本和目标样本,而特征提取器试图混淆鉴别器。

2.思想

SCDA 的动机来源于模型做出的类预测取决于它所关注的内容,并且每个类预测的集中区域可以通过特征图和相应的分类权重来定位。因此,我们希望找到错误预测的集中区域,并在将图像编码为特征时抑制这些区域的特征。为此,我们建议以对抗的方式逐类对齐成对预测分布。

为了解决不相关语义的混淆而导致语义上的负迁移,我们提出了域适应的语义集中(SCDA),它鼓励模型通过预测分布的成对对抗对齐来专注于最主要的特征。

具体来说,我们训练分类器以按类别最大化每个样本对的预测分布散度,这使模型能够找到同一类样本中差异较大的区域。同时,特征提取器试图最小化这种差异,从而抑制同一类样本中不同区域的特征,突出主要部分的特征。作为一种通用方法,SCDA 可以很容易地集成到各种 DA 方法中作为正则化器,以进一步提高它们的性能。

3.创新与贡献

1.本文提出了一种新的 DA 对抗方法,即预测分布差异的成对对抗对齐。我们的方法可以在编码特征时抑制不相关的语义信息并突出类对象,从而实现语义集中。

2.作为一种简单而通用的方法,SCDA 可以很容易地作为正则化器集成到各种 DA 方法中,并大大提高它们的适应性能。

3.广泛的实验结果和分析表明,SCDA 在适应过程中极大地抑制了不相关的语义,在多个跨域基准测试中产生了最先进的结果。

4.SCDA模型

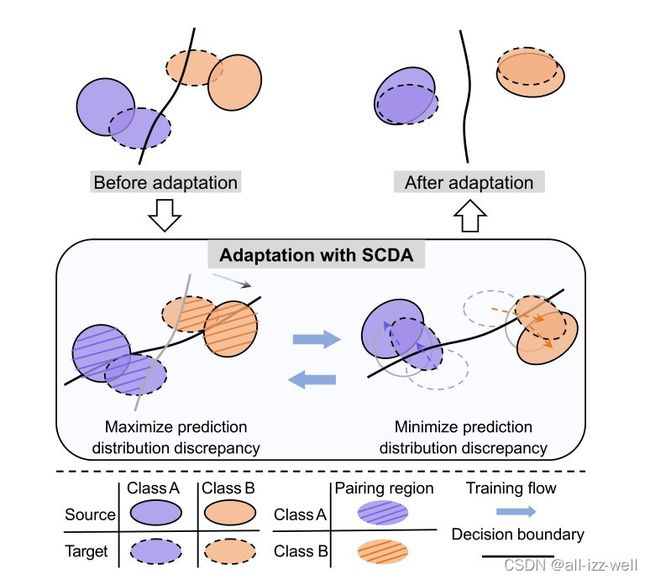

4.1 SCDA对抗过程

SCDA 在宏观层面的对抗过程:训练分类器以最大化配对区域中样本的预测分布差异,从而导致决策边界通过配对区域的高密度区域;特征提取器试图最小化这种差异,这会将特征推离决策边界。

最后通过分类器和特征提取器之间的对抗博弈获得对齐良好的特征。

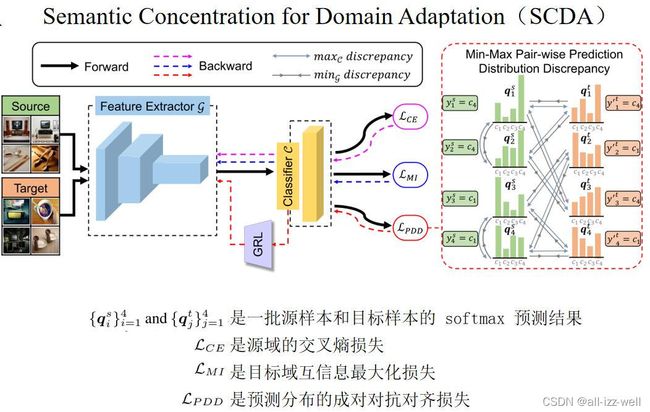

4.2 模型图

源域数据和目标域数据进入特征提取器,提取到的特征经分类器判断类别,其中得到三个损失。同时网络通过反向传播和梯度反转层更新参数。c1,c2,c3,c4可以理解为一个样本中判断不同类别的分数,例如识别自行车时,图片中有柱子、自行车、人、头盔等。

4.3 放大不相关区域

来自两个域的相同标签的样本构成了相应类的配对区域。

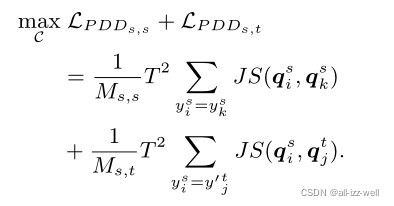

两个样本的标签(目标域使用伪标签)相同,则将它们视为一对。对于每个类,存在两种样本对,即域内样本对(源域内)和域间样本对(源域和目标域间)。训练分类器以最大化每个样本对的预测分布差异,总损失包括域内和域间部分。

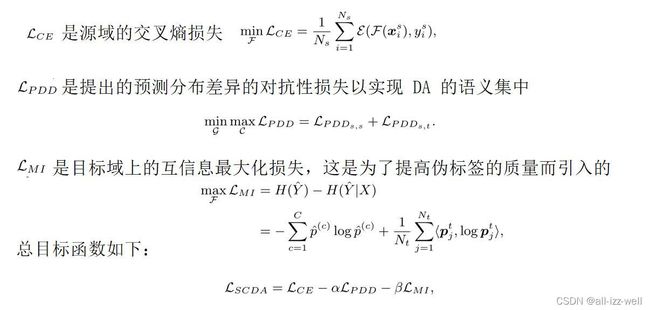

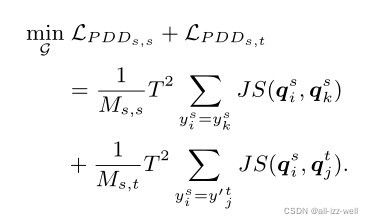

当特征提取器固定时,分类结果仅取决于分类器的分类权重。由于样本对属于同一类并且该类的预测分数都很高,为了最大化样本对的预测分布差异,其他错误类的分类权重增加,通过这样做,我们放大了不相关区域。目标函数为

4.4 抑制不相关语义信息

放大不相关区域使模型集中用于预测不相关类的区域。现在,我们希望抑制这些区域的特征,以便在 DA 中进行更纯粹的知识转移。为此,我们训练特征提取器以最小化样本对的预测分布差异,其损失表示为

由于在之前的分类器训练中错误类的分类权重增加,为了减少预测分布差异,特征提取器必须抑制这些不相关语义的特征,并强调样本对中相似部分的特征。在对抗方式下,对于域内样本对,实现对每个类的最主要特征的提取以指导对目标域的知识迁移。

4.5 总的损失函数

5.实验

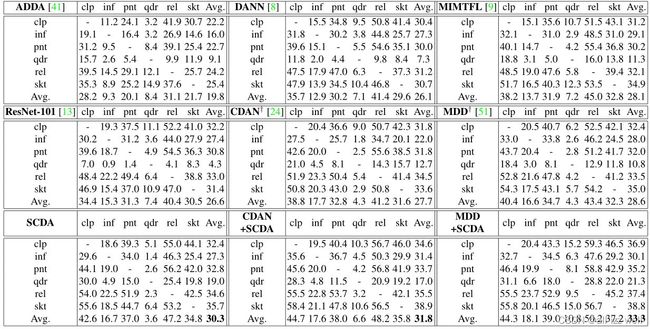

5.1 DomainNet(6个域共345个类)

CDAN 和 MDD与SCDA应用结合准确度分别提高4.1% 和 4.7%

抑制了可能混淆CDAN 和 MDD 对齐过程的不相关语义特征

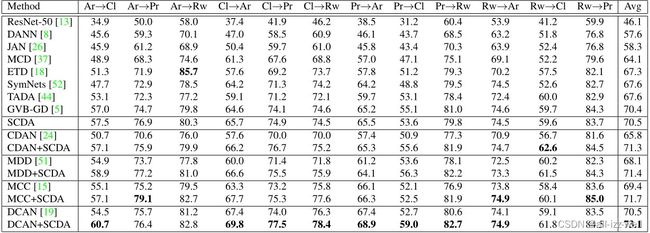

5.2 Office-Home(4个域共65个类)

与CDAN结合提升了 5.5% Cl → Ar 、 Cl → Pr 、 Cl → Rw任务大幅改进。

原因是 Cl 中图像相当复杂通过抑制不相关语义特征带来的改进更明显。

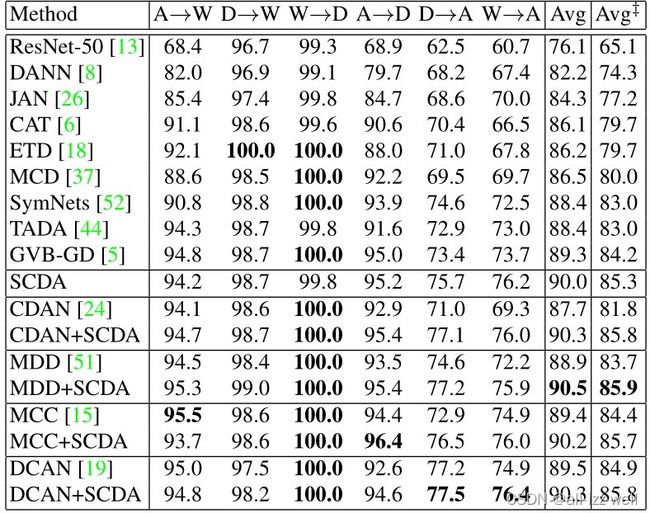

5.3 Office-31(3个域共31个类)

SCDA 应用于 MDD 时,达到了 90.5% 的最高精度。

尤其是如下三个困难任务:A → D 、 D → A 和 W → A 准确率提升大

6.总结

1.在本文中,作者提出了域自适应语义集中(SCDA)

2.通过源域内和跨域的预测空间上的成对对抗对齐来突出主要部分的特征并抑制不相关语义的特征。

3.SCDA 可以很容易地集成为正则化器,以带来进一步的改进。大量的实验结果验证了 SCDA 的有效性。