西瓜书第一、二章学习笔记

第一章 绪论

1.1 机器学习解决的问题

1.通过计算的手段,利用经验来改善系统自身性能

2. 在有数据的前提下,通过某种学习算法(learning algorithm ),得到模型,进行预测

1.2 基本术语

色泽

根蒂 敲声 好瓜是否 …… 青绿 蜷缩 浊响 是 乌黑 稍蜷 沉闷 否 浅白 硬挺 清脆 是 …… …… …… ……

1.数据集:这些记录的集合称为数据集

2.样本/示例:数据集中每条记录是关于一个事件或对象的描述

3.属性:反映事件或对象在某方面的表现或性质的事项,如:色泽

4.属性值:反映属性的值 ,如:青绿

5.属性空间/样本空间:属性张成的空间,即:将“色泽” “根蒂” “敲声”作为三个坐标轴,则它们张成一个用于描述西瓜的三维空间。每个西瓜都可以在这个空间找到自己的坐标位置。

6.特征向量:对一个事物,通过描述其不同特征属性,得到的一行或者一列值,这样就组成了一个特征值形成的向量。就被成为特征向量。

7.维数:d维样本空间中包含了m个示例的数据集D,每个示例中是d维的样本空间,d称为维数。

8.分类: 预测离散值 分为二分法和多分法

二分法:y正负 如瓜农分辨西瓜是否为好瓜

多分法:y>2时,如市场上有多种西瓜,看需求买哪一种

9.回归: 预测连续值

10.聚类: 将训练集中的内容分为一些簇,训练样本不拥有标记信息

11.有监督学习:样本有标记(如是否为好瓜) 种类有分类和回归

12.无监督学习: 如聚类

聚类:机器自己分类 每一组称为簇cluster

13.泛化: 特殊到一般,使得模型可以适用于新样本的能力

14.特化:一般到特殊

1.3假设空间

一、科学推理的两大基本手段:归纳(induction)和演绎(deduction)

1.归纳:从特殊到一般的Generalization泛化过程 即:从具体的事实结出一般性的规律

归纳学习(Inductive Learning): 广义理解是”从样例中学习“。狭义理解是从训练数据中学得概念(Concept),概念学习研究较少因为涉及语义(Semantic),概念学习中最基本的是布尔概念学习(指是/不是为目标概念的*学习,比如我们上图中的好瓜和坏瓜)

2.演绎:从一般到特殊的Specialization特化过程 即:从基础原理推演出具体状况

二、假设空间

1.假设空间:学习的过程可以看做一个在所有假设(Hypothesis)组成的空间(即”假设空间“)中进行搜索的过程,搜索目标是找到与训练集匹配(Fit)的假设,即能够将训练集中的瓜全部判断正确的假设。

2.版本空间: 与训练集一致的“假设空间”,即存在着一个与训练集一致的“假设集合”,故称之为版本空间。

1.4 归纳偏好

1.目标:当同一个数据训练出不同的模型,利用归纳偏好进行模型选择

2.原则:奥卡姆剃刀:若有多个观察目标与假设一致,则选最简单的那个 (曲线更平滑则更简单)

3.NFL : “没有免费的午餐”(NFL)定理,在所有问题出现的机会相同、或所有问题同等重要的前提下,每个学习算法(无论算法多么聪明或多么笨拙)的期望性能相同。

但实际情况中,我们只关心自己正在试图解决的问题。学习算法自身的归纳偏好与问题是否匹配,往往起到决定性作用。

1.5 发展历程

1.6 应用现状

第二章 模型评估与选择

2.1 经验误差与过拟合

1.错误率(error rate):分类错误的样本数占样本总数的比例 E=a/m

2.精度(accuracy):分类正确的样本数占样本总数的比例 1-E

3.误差(error):学习器的实际预测输出与样本的真实输出之间的差异

误差又分为训练误差和泛化误差

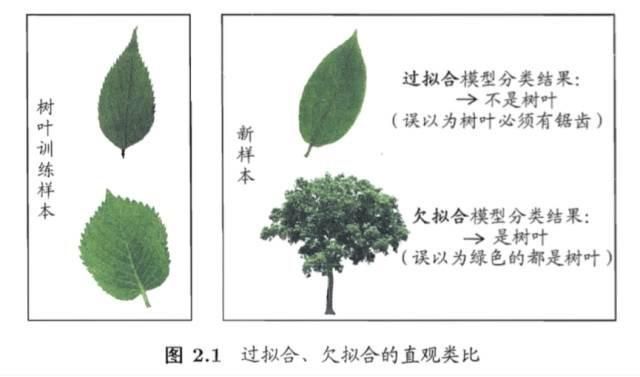

4.过拟合和欠拟合:在训练集表现的很好,但是泛化误差却很大的情况叫做过拟合。在训练集上表现的都很差的是欠拟合,比较容易克服

二者对比如下图

2.2 评估方法

1.留出法:直接将数据集D划分为两个互斥的集合,其中一个作为训练集S,一个作为测试集T S∪T=D S ∩ T=空集 一般将数据集2/3到4/5的样本划给训练集,但由于训练集划分部分给了测试集,导致训练集的缩小使得降低了评估结果的保真性,因此一般将数据集2/3到4/5的样本划给训练集,剩余样本用于训练

2.交叉验证法: 将数据集D以分层抽样的方式分成k份,每份轮流做测试集,其他的为训练集,进行k次训练和测试,最终返回的是k个测试结果的平均值 缺点:样本过大,计算成本高

3.自助法: 在包含m个样本的数据集D中进行m次自助有放回的采样,最终得到包含m个样本数据集D’,用作训练集。优点:在数据集较小、难以有效划分训练/测试集时很有用

2.3 性能度量

1.任务描述:对学习器的泛化性能进行评估,不仅需要有效可行的实验估计方法,还需要有衡量模型泛化能力的评价标准

2.均分误差公式:略

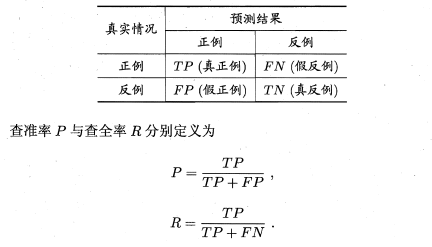

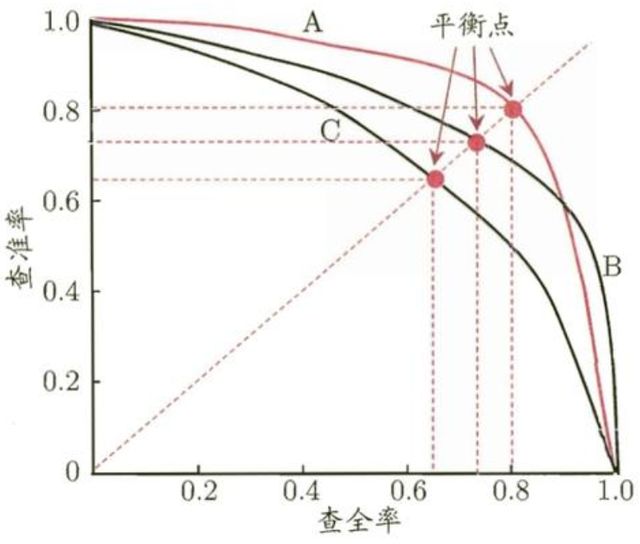

2.查准率与查全率:在二分类问题,将样例根据其真实类别与学习机预测类别的组合划分为真正例(TP) 假反例(FN) 假正例(FP) 真反例(TN) 顾名思义,查准率就是机器预测正确真正例数量占预测结果正例总数的比例;查全率则为真正例占真实情况正例总数的比例;

一般而言,查准率高则查全率低