FAIR Transformer新作Multiscale Vision Transformers

论文地址:

Multiscale Vision Transformersarxiv.org

代码地址:

GitHub - facebookresearch/SlowFast: PySlowFast: video understanding codebase from FAIR for reproducing state-of-the-art video models.github.com

速览:

该文章首先给出了一个初步的结论,即在视觉任务中浅层主要作用高分辨率,提取low-level的特征, 而深层主要作用在空间分辨率没有那么高的但是更复杂的语义上,因此需要更多的通道去提取信息。这已经是CNN中的基本共识了(虽然解释上尚有怀疑的地方,但是模型结构设计大抵如此)。

那么文章就将transformer的设计也按照这个思路进行下去,如下图所示,除了任务token之外,图像特征token的分辨率是逐渐降低,但是channel是逐渐增多的。

这种思想设计的vision transformer在结果上是取得了不错的效果的。从最终能达到的绝对精度上看,优势并不明显,但是在获取相同准确率的情况下,其前向推理的FLOPS是明显优于ViViT等方法的,如曲线所示。

同时作为一个视频相关的任务,能否很好的利用时序信息是很重要的,文章发现MViT方法在时序信息打乱的情况下, 性能是显著下降的,而其他的transformer方法则没有明显下降,证明了该方法中时序信息的重要性,也就证明了该方法能够很好的利用时序信息。

方法:

实现空间分辨率收缩,同时channel增加的核心模块是Multi Head Pooling Attention(MHPA)。具体如下图所示。

从图中和可以发现与传统的MHA主要的不同点,在于QKV均是经过pooling操作的,同时为了维度统一,原始的输入也是需要经过pooling到Q的pooling维度,然后作为残差的方式与MatMul的结果相连。这一步主要是实现空间分辨率(视频序列包括时间)的降低,同时在接下来的MLP中通道的维度则进行扩增。具体变化情况如下表:

文章思路不难,几张图几个表格便将所做的内容清晰的展现出来,又是一篇将CNN思想引入到transformer结构中文章。

与Swin-transformer相:

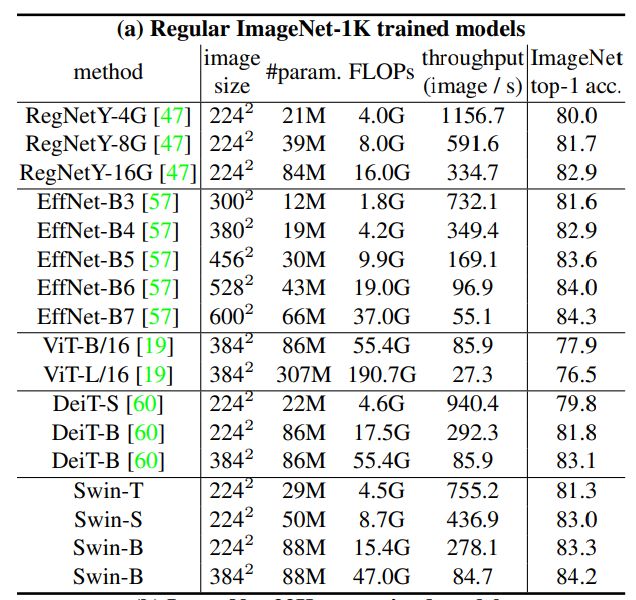

可以看到swin-transformer主要是通过local attention,,然后经过shiftwin向全局扩展,然后再用金字塔的方法逐渐扩展到全局的方式。而本文始终是全局attention,但是不同点在于改变的是图像的分辨率,通过分辨率的降低达到计算量的目的,从理论的美妙程度我是更倾向于这篇文章的,从结果上看也是优于Swi-transformer的,如下表对比,但是文章的代码链接虽然给出来,实际额代码目前尚未更新,期待代码放出来之后的复现效果。

===============文章结束,广告线===============

荣耀招聘计算机视觉算法工程师,主要为:

超分、去噪、deblur、demosaic等基础图像质量方向(我的主要落地方向)。

分割检测识别等方向(组内其他同事的落地方向)。

high level引导low level(我的半落地半研究方向)。

transformer、自监督、GAN(我的研究方向,主要也是结合low level去应用)。

基于event camera的光流和deblur、slomo(算法是目前我相对比较擅长的方向)。

模型压缩量化(人才空缺中~)。

也招聘实习生哦~

有兴趣的可以加我微信(thubofu),或者私聊我。

===========================================

同时我也建了一个微信群,希望能够一起分享CV方向的新文章以及学习资源,欢迎加入!

===============show 猫时刻===============