神经网络与深度学习-2- 机器学习简单示例-PyTorch

前言:

通过简单的模型,线性回归(Linear Regression)来具体了解机器学习的一般过程,以及不同的学习准则

经验风险最小化,结构风险最小,最大似然估计(最大后验估计)

参考文档:

【技术干货】PyTorch深度学习合集【全20集】深度学习入门|PyTorch入门|深度学习中的数学入门_哔哩哔哩_bilibili

《神经网络与深度学习》

目录:

1: 线性回归

2: 结构风险

3:MLE

4: MAE

5: GPU与pythorch

一 线性回归

1.1 模型:

![]()

有时候会了简单起见写成,其中的w,x分别称为 增广权重向量,增广特征向量

![]()

1.2 参数学习

由于线性回归的标签y 和 模型的输出都为连续实数值,因此常用 平方损失函数 作为损失函数

写成矩阵的形式:

风险函数是关于W的凸函数,其对w的偏导数为

![]()

则最优参数![]() 为

为

![]()

这种求解方法称为最小二乘法(Least Square Method,LSM)

但是![]() 不一定是可逆的,当不可逆通常有两种方法:

不一定是可逆的,当不可逆通常有两种方法:

1: 降维: 使用PCA来预处理数据,然后再使用LSM

2 梯度下降法:

初始化![]()

![]()

二 结构风险最

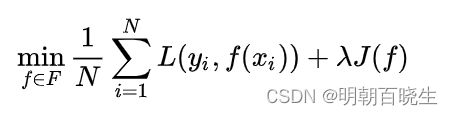

结构风险最小化(SRM):为了防止过拟合,等价于正则化。(regularizetion)

又分为L1,L2 正规化,这里举例L2正规化

例如:

最小二乘法要求各个特征之间要相互独立,但是数据集一些小的扰动会导致![]()

不可逆,为解决上面问题,1970年 Hoerl et al,提出了岭回归(Ridge Regression)

![]()

![]() ,

,

岭回归的解w可以看作结构风险最小化准则的最小二乘法估计

三 最大似然估计(Maximum likehood Estimation,MLE)

假设标签y为一个随机变量,由函数f加上一个随机噪声![]() 组成

组成

![]()

噪声服从![]() 高斯分布,则

高斯分布,则

参数w在训练集D 上的似然函数(Likelihood)为

为了方便计算,对对数似然函数(Log Likelihood):

最大似然估计(Maximum Likelihood Estimation,MLE)是指找到一组

参数w 使得似然函数p最大,则对w 求导数

![]()

补充一下数理统计里面的似然MLE

1 如果总体X属于离散型

分布律

,

属于待估参数

设

是来自总体的样本,则其联合分布律为

这个概率随着

取值而变化,是它的函数

称为样本的似然函数

由费希尔(R.A.Fisher)引入的最大似然估计法:

就是固定样本观测值,在

取值的可能范围内,挑选使得

达到最大值的

使得

这样得到的

2 若X属于连续型

求解方法:

很多时候

关于

可微,这时最大似然估计

也可以从方程:

离散型例子

例1: 设

是来自X的样本,试求参数P的最大似然估计量

解:

是对应样本值,则X的分布律为

其对数似然函数为:

对p求偏导数为:

连续型例子

设

,参数

来自于X的样本值,求

的最大似然估计

解:

X的概率密度为

似然函数LLR为

对数似然函数为:

对 u,

分别求偏导数

四 最大后验估计MAP(Maximum A Posteriori Estimation)

MLE 认为w是随机的,但是P(w)为均匀分布![]() 为固定值

为固定值

![]()

MAP w 为随机向量,其先验概率密度函数为 P(w),其目标为

![]()

4.1 例

假设参数w为一个随机向量,并且服从一个先验分布![]() ,一般设其为高斯分布

,一般设其为高斯分布

![]() ,

,![]() 为每一维上面的方差

为每一维上面的方差

![]()

则:

![]()

就是结构化风险

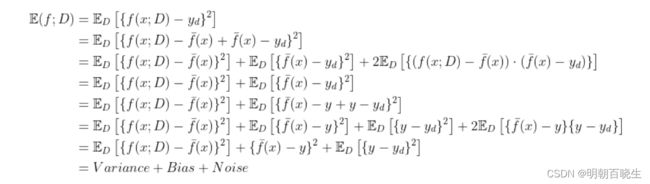

四 偏差-方差分解

为了避免过拟合,我们经常会在模型的拟合能力和复杂度之间进行权衡。拟合能力强的模型一般复杂度会比较高,容易导致过拟合。相反,如果限制模型的复杂度,降低其拟合能力,又可能会导致欠拟合。因此,如何在模型能力和复杂度之间取得一个较好的平衡对一个机器学习算法来讲十分重要。偏差-方差分解(Bias-Variance Decomposition)为我们提供一个很好的分析和指导工具。

Varinance: 样本的拟合能力

Bias: 样本的拟合能力

Noise: 训练集中的噪声导致的

x: 测试样本

D: 训练集

![]() : 通过训练集训练出映射函数f, 测试样本x在f上面的输出

: 通过训练集训练出映射函数f, 测试样本x在f上面的输出

![]() : 模型的期望预测.理解为不同的训练集训练出不同参数的模型(跟训练方法有关系)

: 模型的期望预测.理解为不同的训练集训练出不同参数的模型(跟训练方法有关系)

![]() 在训练集上的标签值

在训练集上的标签值

![]() 在训练集上的真实值

在训练集上的真实值

用途:

欠拟合

模型在训练集上的错误率高,偏差大

增加数据维度,提高模型复杂度,减小正规化系数,增加训练轮数

过拟合:

方差高,减少模型的复杂度,加大正规化系数,集成学习。

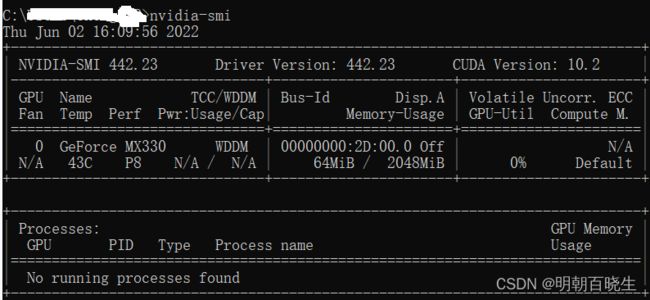

五 GPU

Pytorch 目前只支持英伟达的显卡,可以稳定的运行在3080以下。

PC 是否带N卡,查看方式有两种:

5.1 属性查看

主流的显卡有两种:

AMD: 苹果用的A卡

NVIDIA : 英伟达的N卡

5.3 NV主要型号

![]()

5.4 显存要求

企业级应用

非企业级应用