ECCV 2022 京东探索研究院 25 篇入选论文合集解读,含目标检测、动作检测、异常检测、风格迁移等多个方向...

关注公众号,发现CV技术之美

欧洲计算机视觉国际会议European Conference on Computer Vision(ECCV) 是计算机视觉三大会议之一,每两年举行一次。今年将在10月23日-27日于以色列特拉维夫(Tel-Aviv)举行,并采取线下和线上混合形式召开。根据最新公开的论文录用列表,本届 ECCV 2022论文有效投稿数5803篇,其中1650篇论文中选,录取率仅为28%。今年,探索研究院共有25篇论文入选,以下是论文亮点解读。

01

Meta-Learning with Less Forgetting on Large-Scale Non-Stationary Task Distributions

大规模非平稳任务分布上的少遗忘元学习

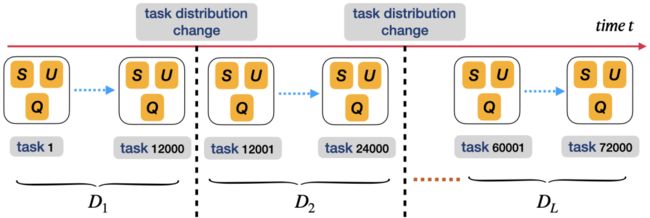

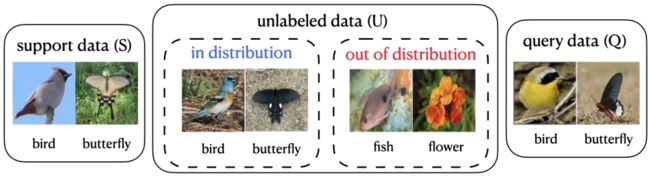

当标记数据稀缺但相关的未标记数据可用时,机器智能的范式从纯粹的监督学习转变为更实际的场景。因为目前大多数现有算法均局限于假设底层任务分布是固定的,所以本文考虑了一个更现实和更具挑战性的环境,即任务分布随着时间的推移而演变。我们将此问题命名为 Semi-supervised meta-learning with Evolving Task diStributions,缩写为SETS。在这个更现实的设置中出现了两个关键挑战:(i)如何在存在大量未标记的分布外(OOD)数据的情况下使用未标记的数据;(ii) 如何防止由于任务分布转移而导致对先前学习的任务分布的灾难性遗忘。

我们提出了一个 OOD Robust and knowleDge presErved semi-supeRvised meta-learning 的算法(缩写为ORDER) ,来解决这两个主要挑战。具体来说,为了利用 OOD 数据,我们的 ORDER 引入了一种新颖的互信息的正则化,以达到以下两个目的,(i) 增强类原型和分布中未标记数据之间的相关性,(ii) 减少类原型和 OOD 未标记数据之间的依赖性。此外,为了解决灾难性的遗忘问题,ORDER 采用最佳传输的正则化来记住先前在特征空间中学习到的知识,其中包括标记数据和未标记数据。此外, 我们提出了一个非常具有挑战性的基准:在由(至少)72000个任务组成的大规模非平稳半监督任务分布上设置。通过广泛的实验,我们证明了所提出的 ORDER 减轻了对不断变化的任务分布的遗忘,并且比相关的基准模型对 OOD 数据更稳健。

02

Hierarchical Semi-Supervised Contrastive Learning for Contamination-Resistant Anomaly Detection

用于抗污染异常检测的分层半监督对比式学习

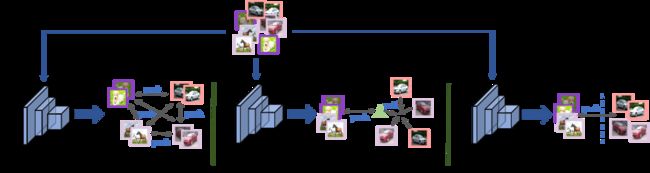

良好的表示学习策略对于识别异常样本至关重要。受视觉对比表示学习的成功启发,近年来对比学习在异常检测方面取得较大进展。然而,当训练数据中混杂少量未标记的异常样本时,基于常用的对比学习方法会导致检测性能的大幅下降。主要原因在于:

(1)目前基于对比学习的方法通常只考虑样本之间实例级别的关系,而忽略了其他潜在多元关系,例如样本与原型的关系,以及正常和异常类别之间的关系,如图1所示。进而导致了现有方法在具有异常样本污染的大量无标记数据上训练时,难以识别异常样本。

(2)此外,当混杂有无标记的异常训练数据时,通常需要多阶段微调或自适应步骤才能获得更好的样本表示。这些多阶段训练方式通常会导致效率低下,并严重依赖额外的训练技巧,例如早停(early-stop)策略等,增加了在实践应用中的复杂性。

03

Learning Graph Neural Networks for Image Style Transfer

基于图神经网络的图像风格迁移

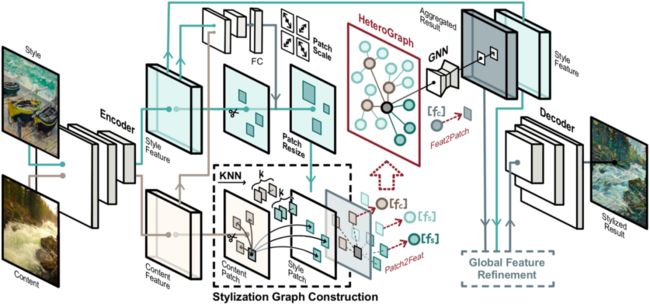

图像风格迁移这一任务的目标是将用户上传的照片渲染为具有艺术风格的画作。现有的图像风格迁移算法主要包括两大类:参数化图像风格迁移算法以及非参数化图像风格迁移算法。然而,参数化风格迁移算法常常会因为只考虑了全局风格信息而导致局部区域的风格扭曲,而非参数化风格迁移方法又会由于局部图像块误匹配进而产生不连续、不正常的人为篡改痕迹。为了解决现有参数化和非参数化风格迁移算法的问题,我们提出了一个新的基于图神经网络的半参数化风格迁移框架。通过利用图神经网络来建立细粒度的、多对一的更为精确的内容风格图像块配准,我们的方法同时解决了以往参数化和非参数化风格迁移算法的不足。

04

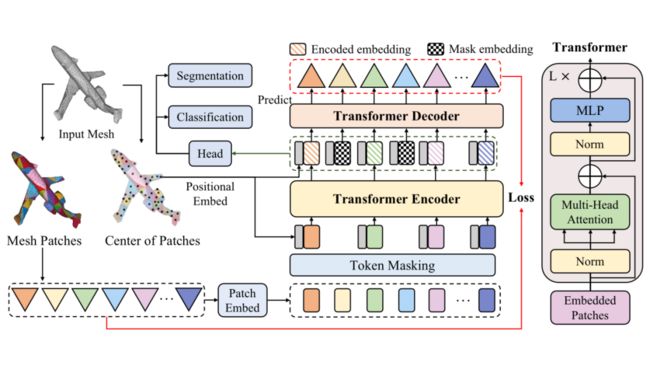

MeshMAE:Masked Autoencoders for 3D Mesh Data Analysis

用于三维网格数据分析的掩蔽自动编码器

基于mask auto-encoding的预训练策略使得Transformers在自然语言处理和计算机视觉等多种任务上取得最先进的效果。基于此,本文探索将这一策略引入到3D mesh的分析任务中。由于将Transformer网络应用于新的数据类型通常并不容易,本文提出基于Vision Transformer的3D mesh处理网络,即Mesh Transformer。具体来说,我们将3D mesh的面片分成若干个互不重叠的块,每个块包含相同数量的面片,并利用每个块的中心点坐标计算位置编码。其次,我们探索了如何进行mask auto-encoding预训练从而有利于下游任务,其中3D mesh的块将被随机遮挡一部分,并将未被遮挡的部分送到Mesh Transformer中;然后,通过重构被遮挡面片的几何信息,该网络能够学习到3D mesh的较好的特征表示。我们的方法可以在3D mesh分类任务上取得最先进的性能。此外,我们还进行了全面的消融实验,以证明我们方法中关键设计的有效性。

05

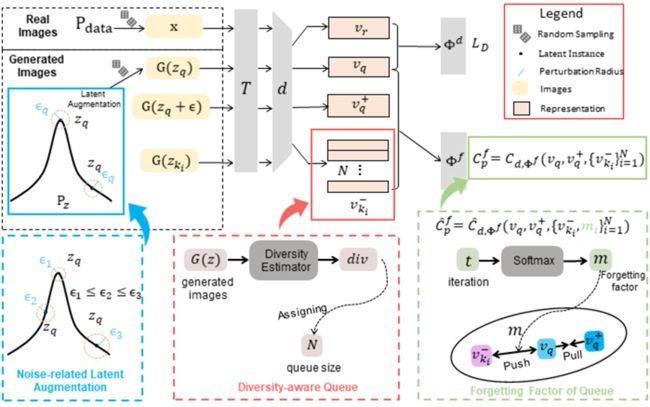

FakeCLR:Exploring Contrastive Learning for Solving Latent Discontinuity in Data-Efficient GANs

探索对比学习以解决数据高效 GAN 中的隐空间不连续

数据高效的生成对抗网络(Data-Efficient GANs, DE-GANs)旨在用有限的数据训练生成模型,这在生成高质量样本和训练稳定性方面等遇到了一些挑战。数据增强策略在很大程度上缓解了训练的不稳定性,如何进一步提高DE-GANs的生成性能成为一个研究热点。近年来,对比学习在提高DE-GANs生成质量方面显示出了巨大的潜力,但相关原理尚未得到很好的探索。在本文中,我们重新审视和比较了DE-GANs中不同的对比学习策略,发现:(i)当前生成性能的瓶颈是隐空间的不连续; (ii)与其他对比学习策略相比,隐空间摄动策略对DE-GANs的训练有较大的改善。基于这些观察,我们提出了FakeCLR,它只在生成样本上进行对比学习。此外,我们还设计了三种适配生成样本对比学习的训练策略:噪声相关的隐空间增强(Noise-related Latent Augmentation),多样性感知队列(Diversity-aware Queue),和遗忘因子(Forgetting Factor of Queue)。我们的实验结果在少样本生成和有限数据生成两个方面展现出最先进的性能。在多个数据集上,FakeCLR获得了比现有的DE-GANs的方法15%以上的提高。

06

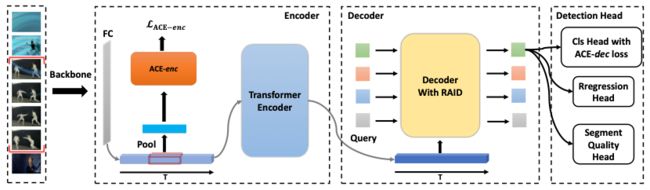

ReAct:Temporal Action Detection with Relational Action Queries

基于关联动作查询的时序动作检测

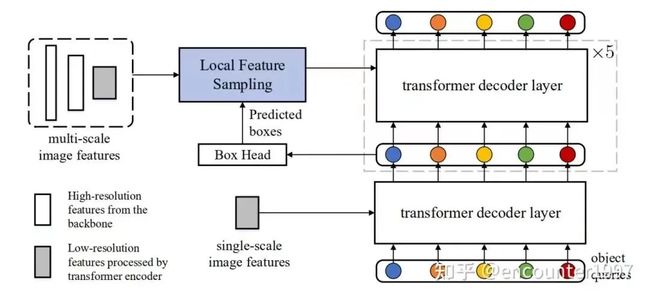

该工作希望通过 encoder-decoder 的框架(如 DETR 类方法),来解决时序动作检测(TAD)问题。但是,直接应用这些方法到 TAD 任务上会面临三个问题:1. decoder 中的 query 关系建模探索不充分; 2. 有限的训练数据导致的分类训练不充分; 3. 预测时分类得分的不可靠。

为了解决这三个问题,我们提出了基于关系的注意力机制,两个增强和稳定分类头训练的损失以及预测片段质量得分方法。ReAct 在 THUMOS14 上取得了先进的性能,同时,和之前方法相比,具有更低的计算量。

07

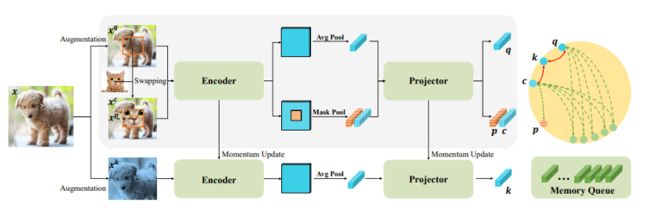

RegionCL:Exploring Contrastive Region Pairs for Self-supervised Representation Learning

探索对比性区域对的自监督表征学习

得益于可以使用不带有标签的数据来帮助网络学到优良的表征能力,自监督学习在进来受到了越来越多的关注。对比学习是其中的主要方法之一,即通过最大化相似区域之间的互信息,来引导网络学到更好的特征。然而,之前的方法往往更加关注从图片整体的角度去构建用于对比学习的样本对,而忽略了对于局部区域样本对信息的挖掘,特别是由于cropping操作产生的被裁减区域的信息。本文通过提出一种联合使用全局样本对的局部样本对构建正负样本的方式,帮助网络进一步学到更具判别力和位置敏感性的特征。

08

Towards Data-Efficient Detection Transformers

迈向数据高效的检测Transformers

对目标检测模型所需要的数据进行标注往往是十分繁重的工作,因为它要求对图像中可能存在的多个物体的位置和类别进行标注。本文旨在减少Detection Transformer类目标检测器对标注数据的依赖程度,提升其数据效率。Detection Transformer于2020年ECCV被提出,作为一种新兴的目标检测方法,Detection Transformers以其简洁而优雅的框架取得了越来越多的关注。Detection Transformer的开山之作是DETR[1],在常用的目标检测数据集COCO[2]上,DETR取得了比Faster RCNN[3]更好的性能,但其收敛速度显著慢于基于CNN的检测器。为此,后续的工作大多致力于提升DETR的收敛性[4,5,6,7]。在COCO数据集上这些后续方法能够在训练代价相当的情况下取得比Faster RCNN更好的性能,表现出了Detection Transformers的优越性。

09

JPerceiver:Joint Perception Network for Depth, Pose and Layout Estimation in Driving Scenes

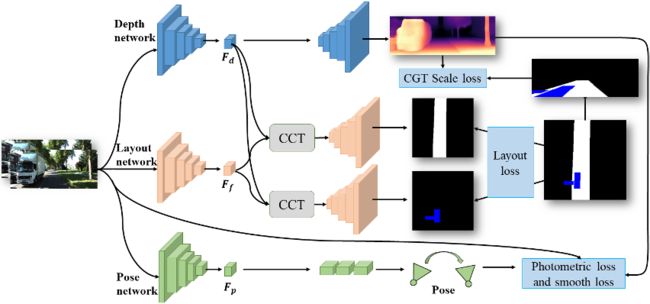

用于驾驶场景中深度、姿势和布局估计的联合感知网络

自动驾驶场景感知是一个非常复杂的系统,其往往被分成多个任务分别研究,例如深度估计、位姿估计、场景分割、3D检测等等。而且最近工业界和学术界的研究者们也发现鸟瞰视角下(BEV)的语义分割对于自动驾驶的后续任务包括车辆轨迹预测、运动规划和导航等任务都非常重要。在实际应用的驱动下,这些感知任务都得到了大量的探索和研究,取得了很不错的性能。但是多个感知任务间相存在的相关性和互补性也需要探索,以高效协同地完成多个感知任务,并进一步提高单个任务的性能。本文探索了自动驾驶场景下深度估计、位姿估计和鸟瞰语义分割的联合感知。我们提出了一个联合感知框架JPerceiver,该框架同时完成了尺度感知的深度估计、位姿估计和多语义类别的BEV布局估计。在KITTI、Argoverse等多个数据集上的实验证明,我们的方法使用更少的计算资源和训练时间,在上述三种感知任务上都取得了更好的性能。

10

BMD: A General Class-balanced Multicentric Dynamic Prototype Strategy for Source-free Domain Adaptation

用于无源领域自适应的一种通用的类平衡、多中心动态原型策略

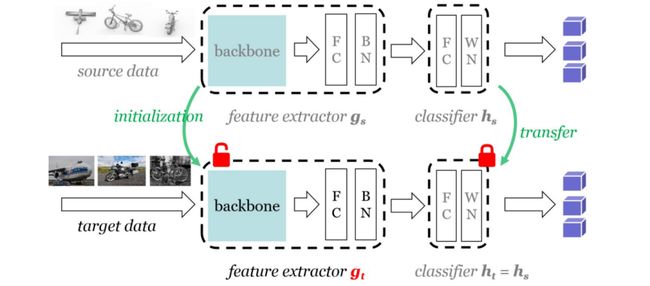

机器学习和深度学习的核心假设是训练数据和测试数据需要满足独立同分布。然而现实应用中,该假设往往难以成立(如图1所示)。因此经常出现在一个带标签数据集 (源域)上训练完成且性能优异的网络模型,部署到相近的无标签数据 (目标域)时出现大幅的性能损失。为解决该问题,目前学界主要提出了两类解决方案,领域自适应(Domain adaptation, DA) 和 领域泛化(Domain generalization, DG)。前者主要关注在访问目标域数据情况下,如何通过利用源域数据的信息,采用无监督学习提升网络模型在目标域的性能;而后者则主要关注在不访问目标域数据情况下,如何直接提升网络的泛化性能。对于领域自适应和领域泛化的相关技术和发展历程,本文并不展开介绍,感兴趣的小伙伴可以参考相关综述论文[2, 3].

SFDA是近年来 DA中较为受关注的一个方向。不同于传统DA方法往往假定源域数据和目标域数据是同时可访问的,然后采用半监督学习的方式,利用统计准则或者对抗学习的方式实现目标域适配。SFDA 假设仅基于源域的预训练模型,而非原始数据实现对目标域的适配。SFDA 目前最具代表性方法是 中科院自动化所 Jian Liang 老师在2020年ICML上所提出的 SHOT [4] 和 2021年 TPAMI上拓展提出的 SHOT++ [5]等工作,在这个系列文章中,Liang 老师率先提出了基于源域假设(Source-Hypothesis)的 SFDA框架 (如图2所示)。结合提出的信息最大化损失(Information-maximization Loss)和 伪标签自监督损失 (Pseudo-labeling loss),通过固定分类器头,优化学习目标域的特征提取器,实现在无源域数据访问情况下的领域适应。目前大多数SFDA的方法均基于SHOT的源域假设框架实现(如ICCV-21 G-SFDA,NeurIPS-21 NRC等).

11

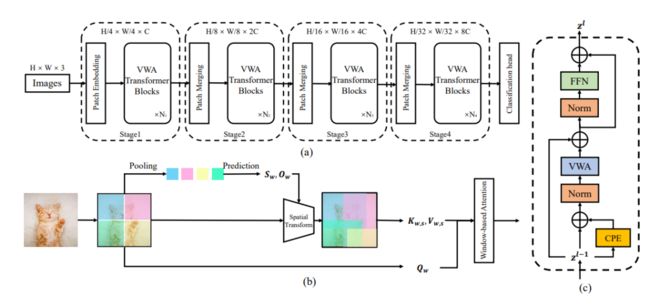

VSA:Learning Varied-Size Window Attention in Vision Transformers

视觉transformer中可学习的可变窗注意力机制。

窗内自注意力机制可以平衡性能、计算复杂性和内存占用,因此已在视觉转换器中得到广泛探索。然而,目前的模型采用人为定义的固定大小窗口设计,这限制了它们建模长期依赖关系和适应不同大小对象的能力。为了解决这个缺点,我们提出了可变大小窗口注意(VSA)来从数据中学习自适应的窗口配置。具体来说,基于每个默认窗口内的token,VSA 采用回归模块来预测目标窗口的大小和位置,即对key和value进行采样的区域。通过对每个注意力头独立采用 VSA,它可以建模长期依赖关系,从不同的窗口捕获丰富的上下文,并促进重叠窗口之间的信息交换。VSA 是一个易于实现的模块,它可以通过微小的修改和可忽略的额外计算成本来替换 state-of-the-art 代表模型中的固定窗口注意力,同时大幅提高它们的性能,例如Swin-T 在 ImageNet 分类上提高了 1.1%准确率。此外,当使用更大的图像进行训练和测试时,性能增益也会进一步增加。更多下游任务的实验结果,包括对象检测、实例分割和语义分割,进一步证明了 VSA 在处理不同大小的物体方面优于普通窗口注意力。

12

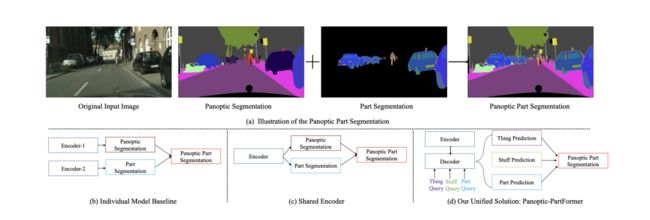

Panoptic-PartFormer: Learning a unified model for Panoptic Part Segmentation

一种全景部分分割的统一模型。

全景部分分割(PPS)旨在将全景分割和部分分割统一为一项统一的任务。之前的工作主要使用了分离的方法来处理物体和背景,并没有进行共享的计算。在这篇工作中,我们旨在将这些任务在架构层面进行统一,设计出第一个端到端的统一模型。受到近期的Vision Transformer的工作的启发,我们将物体和背景以及它们的部分分割建模为物体查询并直接将所有的三种预测统一为掩码预测和分类问题而后进行优化。我们设计了一个解耦的解码器来分别生成部分分割的特征和物体/背景的特征。然后我们提出了一种联合地且迭代地方法来使用查询和对应的特征进行推理。最终的掩码可以通过将查询和对应的特征直接进行内积来获得。广泛的消融实验和分析证明了框架的有效性。我们的Panoptic-PartFormer在Cityspaces PPS和PASCAL Context PPS数据集上取得了至今为止最好的结果,并且有70%的GFlops和50%的参数减少。特别是,我们在ResNet-50骨干网络和Swin Transformer骨干网络在PASCAL Context PPS数据集上分别获得了3.4%和10%的性能提升。据我们所知,我们首先通过一个统一的端到端transformer模型来解决PPS问题。鉴于模型的有效性和概念上的简单性,我们希望我们的Panoptic-PartFormer可以作为一个良好的基准,有助于PPS的未来的研究。

13

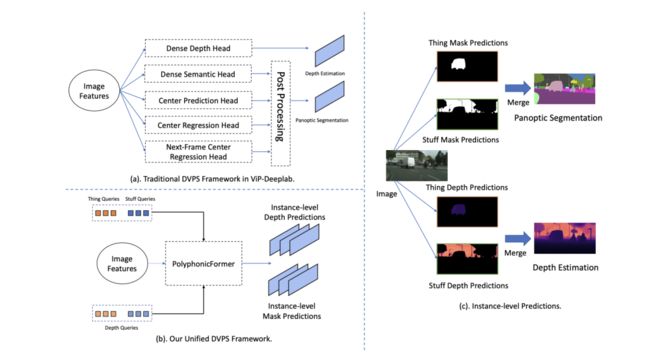

PolyphonicFormer: Unified Query Learning for Depth-aware Video Panoptic Segmentation

基于统一查询学习的深度可知视频全景分割方法

深度可知视频全景分割是一个新的十分有挑战性的任务,旨在同时预测视频中的全景分割和深度图。之前的工作通过在全景分割模型之外加入一个额外的深度估计密集预测输出和实例跟踪输出。然而,深度估计和全景分割之间的关系没有被很好的挖掘——简单的将两者结合会导致互相竞争进而需要小心的平衡。在这个工作中,受到古典音乐中复调的启发,我们提出了PolyphonicFormer,一个vision transformer来将深度可知视频全景分割的所有子任务进行统一并得到了更鲁棒的结果。我们的核心思想是深度估计可以和全景分割通过我们提出的基于物体查询的实例级的深度估计方法来进行协调。然后我们使用查询学习的方法来探究这两个任务之间的关系。通过实验,我们展示出了我们的方法在深度估计和物体查询上的性能提升。因为每个物体查询可以包含这个物体的实例信息,我们很自然的使用物体查询来进行物体跟踪。PolyphonicFormer在SemanticKITTI-DVPS和Cityscapes-DVPS两个数据集中取得了最先进的性能,并且在ICCV-2021 BMTT 竞赛的视频+深度赛道中取得了第一名。

14

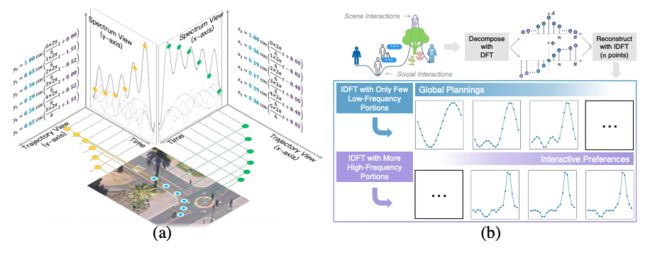

View Vertically: A Hierarchical Network for Trajectory Prediction via Fourier Spectrums

通过频域建模针对轨迹预测的分层网络

理解和预测轨迹对于行为分析、机器人、自动驾驶等领域十分重要。现有方法大多将轨迹预测作为时间序列生成问题来处理。本文从另一维度——垂直视角来研究这一问题,即从频域建模和研究这一问题。在轨迹频谱中不同的频域基带可以分层多尺度地表现代理的运动倾向。低频和高频部分可以分别代表整体趋势和精细变化。相应地,我们提出了一个分层网络,包含两个子网络,从而分层地建模和预测代理的轨迹和轨迹频谱。粗层级上的关键点估计子网络首先预测了代理轨迹在几个关键频域成分上的谱;精细层级上谱插值子网络将这些谱进行插值从而重构最终的预测。在ETF-UCY和Stanford Drone Dataset等数据集上具有相比现有方法更优的性能。

15

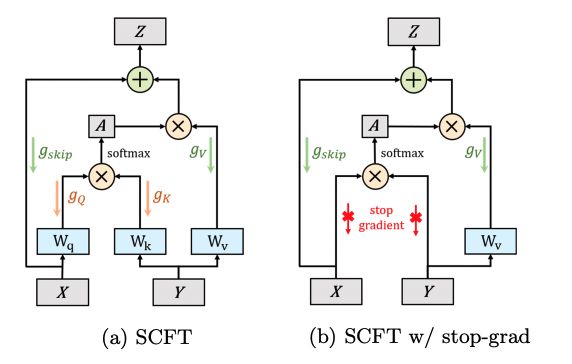

Eliminating Gradient Conflict in Reference-based Line-art Colorization

消除基于风格参考的草图上色任务中的梯度冲突

基于风格参考的草图上色是一个极具挑战性的计算机视觉任务,其难点在于如何在草图和参考之间准确地建模远程依赖,从而捕捉颜色、纹理、明暗等特征。现有方法大多采用注意力机制这一模块对参考图特征与草图特征之间的关系进行建模。本论文通过细致观察注意力机制模块内部的梯度组成,首次指出该模块内的分支之间存在梯度冲突现象。为了克服这一困难,本文大胆地提出只保留主导优化方向的网络分支,截断其它冲突分支上的反向传播的梯度。此外,本论文合理改进了注意力矩阵的归一化方式和特征聚合方法,使得模块性能得到进一步提高。通过模仿Transformer进行堆叠,本论文方法在上色图片真实度和草图结构保真度上得到了明显的提升。

16

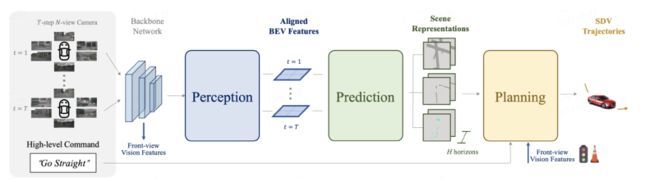

ST-P3: End-to-end Vision-based Autonomous Driving via Spatial-Temporal Feature Learning

通过空间-时间特征学习实现端到端的基于视觉的自主驾驶

许多现有的自动驾驶模式涉及一个多阶段的离散任务管道。为了更好地预测控制信号并提高用户的安全性,一种受益于联合空间-时间特征学习的端到端方法是可取的。虽然在基于LiDAR的输入或隐含设计方面有一些开创性的工作,但在本文中,我们在一个可解释的基于视觉的环境中制定了这个问题。特别是,我们提出了一个空间-时间特征学习方案,旨在为感知、预测和规划任务同时提供一套更具代表性的特征,这被称为ST-P3。具体来说,我们提出了一种以自我为中心的积累技术,以便在鸟瞰变换之前保留三维空间的几何信息,用于感知;设计了一种双路径建模,将过去的运动变化纳入未来预测的考虑范围;引入了一个基于时间的细化单元,用于补偿识别基于视觉的元素,用于规划。据我们所知,我们是第一个系统地研究可解释的基于视觉的端到端自动驾驶系统的每个部分。我们在开环nuScenes数据集和闭环CARLA模拟中对我们的方法与之前的先进技术进行了比较。结果显示了我们方法的有效性。

17

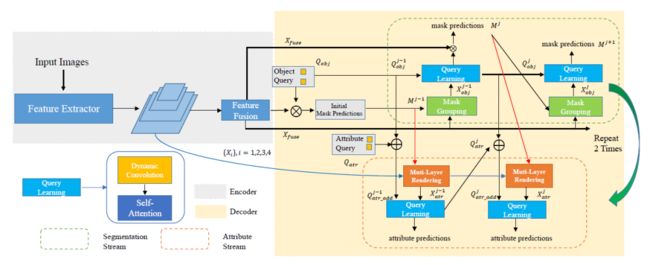

Fashionformer: A simple and unified baseline for fashion segmentation and recognition

一个简单、统一的时装分割和识别基线

人类时尚的理解是一项关键的计算机视觉任务,因为它对现实世界的应用具有全面的信息。本研究的重点是联合人类时尚分割和属性识别。与以往将每项任务单独建模为多头预测问题的工作相反,我们的见解是通过视觉变换器建模将这两项任务用一个统一的模型连接起来,使每项任务都受益。特别是,我们引入了用于分割的对象查询和用于属性预测的属性查询。这两个查询和它们相应的特征都可以通过掩码预测联系起来。然后,我们采用双流查询学习框架来学习解耦的查询表征。我们为属性流设计了一个新颖的多层渲染模块来探索更精细的特征。解码器的设计与DETR具有相同的精神。因此,我们将提出的方法命名为Fahsionformer。在三个人类时尚数据集上进行的广泛实验说明了我们方法的有效性。特别是,在分割和属性识别的联合度量(AP mask IoU+F1)的情况下,我们的方法在相同的主干上比以前的工作取得了相对10%的改进。据我们所知,我们是第一个用于人类时尚分析的统一的端到端视觉转化器框架。我们希望这个简单而有效的方法可以作为时尚分析的一个新的灵活基线。

18

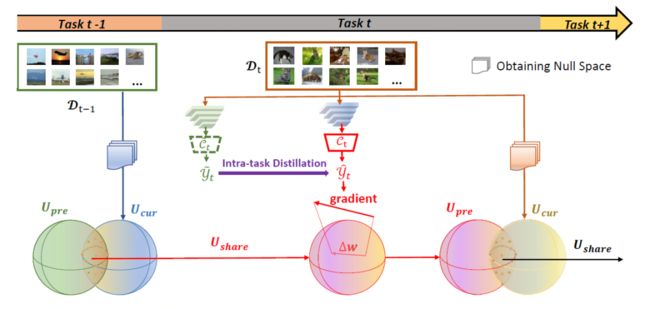

Balancing the Stability-Plasticity through Advanced Null Space in Continual Learning

通过连续学习中的高级Null space来平衡稳定与弹性的关系

持续学习是一种在资源限制下按顺序学习任务的学习模式,其中的关键挑战是稳定性-可塑性困境,即同时拥有防止旧任务灾难性遗忘的稳定性和学习新任务的可塑性是不容易的。在本文中,我们提出了一种新的持续学习方法--高级空洞空间(AdNS),以平衡稳定性和可塑性,而不存储任何以前任务的旧数据。特别是,为了获得更好的稳定性,AdNS利用低秩近似法获得一个新的空空间,并将梯度投射到空空间上,以防止对过去任务的干扰。为了控制无效空间的生成,我们引入了一个非统一的约束强度,以进一步减少遗忘。此外,我们提出了一个简单而有效的方法,即任务内提炼法,以提高当前任务的性能。最后,我们从理论上发现,无效空间在可塑性和稳定性方面分别起着关键作用。实验结果表明,与最先进的持续学习方法相比,所提出的方法可以取得更好的性能。

19

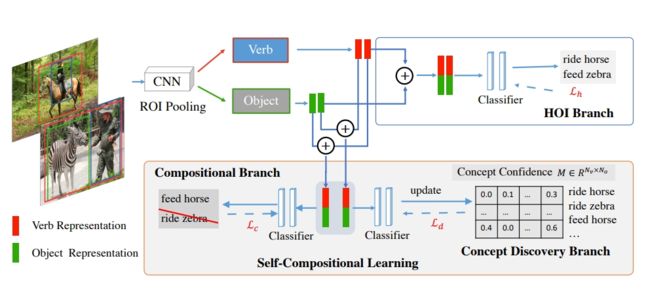

Discovering Human-Object Interaction Concepts via Self-Compositional Learning

通过自我构成学习挖掘人-物互动

对人-物交互(HOI)的全面理解不仅需要检测一小部分预定义的HOI概念(或类别),还需要检测其他合理的HOI概念,而目前的方法通常不能探索大量未知的HOI概念(即未知但合理的动词和对象的组合)。在本文中,1)我们为全面的HOI理解引入了一个新的和具有挑战性的任务,这被称为HOI概念发现;2)我们为HOI概念发现设计了一个自我构成的学习框架(或SCL)。具体来说,我们在训练过程中维护一个在线更新的概念置信度矩阵:1)我们根据概念置信度矩阵为所有复合HOI实例分配伪标签进行自我训练;2)我们使用所有复合HOI实例的预测结果更新概念置信度矩阵。因此,所提出的方法能够对已知和未知的HOI概念进行学习。我们在几个流行的HOI数据集上进行了广泛的实验,以证明所提出的方法在HOI概念发现、物体负担识别和HOI检测方面的有效性。例如,所提出的自我构成学习框架显著提高了以下性能:1)HOI概念发现,在HICO-DET上超过10%,在V-COCO上超过3%;2)物体负担识别,在MS-COCO和HICODET上超过9%的mAP;3)稀有优先和非稀有优先的未知HOI检测,分别相对超过30%和20%。

20

Wave-ViT: Unifying Wavelet and Transformers for Visual Representation Learning

联合小波变换与Transformer的网络特征模型

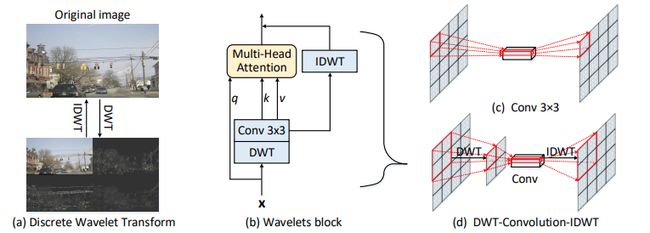

多尺度的视觉Transformer网络结构已成为目前计算机视觉任务的强大网络特征模型。传统Transformer的自注意力操作的计算复杂度随着输入的图片块数目的增长成二次方的规模增长。为此,现有的解决方案通常对键/值采用下采样操作(例如,平均池化)来显著减少计算成本。然而,这种下采样操作是不可逆的,并且不可避免地会导致信息丢失,这对于物体中的高频分量(例如,纹理细节)尤为严重。受启发于小波理论,我们构造了一个新的Transformer网络特征,命名为Wavelet Vision Transformer (Wave-ViT),将小波变换这种可逆下采样操作和自注意力机制联合起来。该方案通过对键/值进行无损下采样来进行自注意学习,从而拥有更好的速度与性能之间的折中。此外,逆小波变换被用来扩大感受野,通过聚合局部上下文信息来增强自注意力输出。我们通过对Wave-ViT在多个视觉任务进行广泛实验(例如图像识别、物体检测和实例分割)来验证其优越性。它的性能在同等量级的FLOP超过了目前主流的Transformer特征网络。代码已开源到https://github.com/YehLi/ ImageNetModel.

图一:(a) 离散小波变换 (DWT) 和逆离散小波变换(IDWT)的示意图,(b)本方案提出的基于小波变换的网络块结构示意图,(c)传统卷积神经网络块中的 3×3 卷积和 (d) 本方案提出的基于小波变换网络块的DWT-Convolution-IDWT 过程。

21

Dynamic Temporal Filtering in Video Models

动态时域滤波视频建模

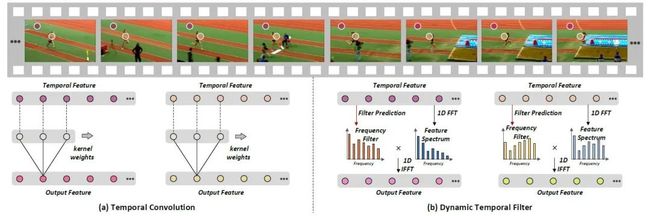

目前对视频进行时域动态建模一般通过时空三维卷积或者分解形式的二维空域卷积加一维时域卷积完成。然而,基于这两种方式对视频进行时域建模,其建模能力会受限于固定的时域窗口大小以及不同空间位置上固定的特征加权权重。这种预设固定大小时域卷积核限制了网络的时域感受野,而在不同空域位置使用同一时域卷积权重更是对这些位置的时域特征同等对待,这使得网络模型针对长时时域建模得到的是次优解。因此,本文从该点出发,设计了一种新颖的时域建模机制,称为动态时域滤波(Dynamic Temporal Filtering (DTF) ),以一种更大的等效时域感受野将空间感知的时域建模转换至频域进行处理。特别地,DTF动态学习特征图谱中每一空间位置时域特征对应的独特的频域滤波器参数,利用时域滤波的等效性,提升模型对长时依赖的动态建模性能。同时,每一空间位置的时域特征通过一维快速傅里叶变换转换为特征频谱。该特征谱经过学习得到的频域滤波器调制以后,通过快速傅里叶反变换恢复至时域。除此以外,为了增强频域滤波器参数的学习,我们提出了一种帧间特征聚合操作,通过相邻帧间的局部区域相关性对特征进行增强。对于CNN和Transformer网络结构,我们可以非常方便地将DTF模块内置于其中,从而构建DTF-Net和DTF-Transformer。在三个公开数据集上通过充分的实验验证了我们方案的有效性。特别值得注意的是,DTF-Transformer在Kinetics-400数据集上达到了83.5%的分类准确率。相关代码已经在https://github.com/FuchenUSTC/DTF公开。

图1:通过 (a)传统时域卷积和 (b)动态时域滤波对同一视频中两个空间位置特征的时域动态建模。

22

SPE-Net: Boosting Point Cloud Analysis via Rotation Robustness Enhancement

针对旋转鲁棒性的点云分析性能提升

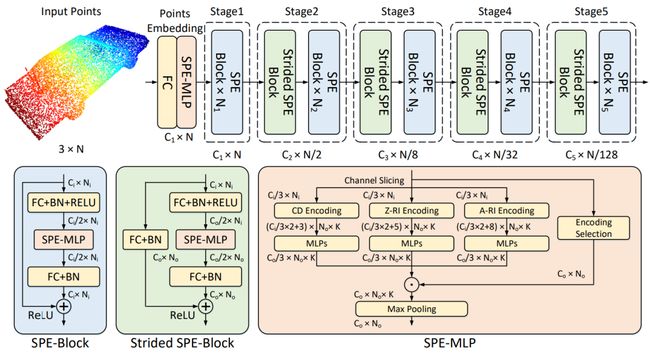

本论文中提出了一种新的用于三维点云应用的深度网络结构SPE-Net。其核心部分是动态位置编码(SPE),使用注意力机制有效地分析输入数据的旋转情况,并根据对不同旋转鲁棒性的需求选择不同的位置编码方式。这种对数据旋转情况的分析帮助网络参数有针对性地学习具有不同旋转鲁棒性的特征,从而有效地降低网络参数的训练自由度。这种机制使得网络对于三维点云的不同旋转有着更强的针对性,从而降低了训练的复杂度。本文通过一系列的实验进一步分析了旋转信息和深度网络准确度的关系,同时发现即使是在没有被人工旋转的三维点云上,提升网络的旋转鲁棒性同样可以提升分类性能。通过SPE-Net和其他网络结构的性能对比,本文验证了对于旋转不变性的一系列假设并同时在旋转与不旋转的三维点云数据上均取得了比同类方法更高的性能。

23

Responsive Listening Head Generation: A Benchmark Dataset and Baseline

响应式聆听者头部生成:基准数据集及方法

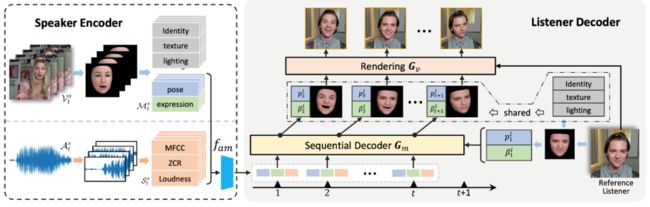

我们提出了一个新的聆听者头部生成的基准,其用于合成面对面谈话中聆听者的响应式的反馈(例如,点头、微笑等)。作为说话人头部生成不可缺少的补充,聆听者头部生成在领域中很少被研究。自动合成能够动态响应说话人的倾听行为,对数字人、虚拟客服和社交机器人等应用至关重要。在这项工作中,我们提出了一个新的数据集 "ViCo",来强调在面对面的对话中生成动态响应的聆听者。在ViCo中共有92个不同的人(67个说话人和76个聆听人),并有483个成对的"诉说-聆听"模式的视频片段,聆听者会根据他们的态度表现出三种倾听风格:积极、中立、消极。与传统的语音到手势生成或说话人头部生成不同,聆听者头部生成将说话人的音频和视觉信号作为输入,并以实时方式输出非语言反馈(如头部动作、面部表情等)。我们的数据集支持广泛的应用,如人与人的互动、视频与视频的翻译、跨模式的理解和生成。为了鼓励进一步的研究,我们还发布了一套响应式聆听人头部生成的基准方法,来对听者不同的聆听态度进行调节。代码和ViCo数据集:https://project.mhzhou.com/vico。

24

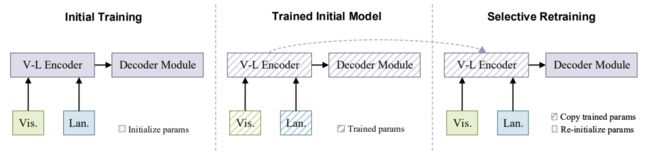

SiRi: A Simple Selective Retraining Mechanism for Transformer-based Visual Grounding

一种用于视觉定位Transformer的简单的选择性重训练机制

在本文中,我们研究了如何在现有视觉语言Transformer上实现更好的视觉定位,并为这一具有挑战性的任务提出了一个简单而强大的选择性再训练(SiRi)机制。特别是,SiRi为视觉定位的研究传达了一个重要的原则,即一个更好的初始化视觉语言编码器将帮助模型收敛到一个更好的局部最小值,相应地提高性能。具体来说,随着训练的进行,我们不断地更新编码器的参数,同时定期重新初始化其余的参数,迫使模型在增强的编码器的基础上得到更好的优化。SiRi在三个流行的基准上的表现明显优于以前的方法。具体来说,我们的方法在RefCOCO+ testA上达到了83.04%的Top1准确率,比最先进的方法(从头开始训练)要好10.21%以上。此外,我们发现SiRi即使在有限的训练数据下也有惊人的表现。我们还将其扩展到其他基于Transformer的视觉定位模型和其他视觉语言任务上以验证其有效性。

25

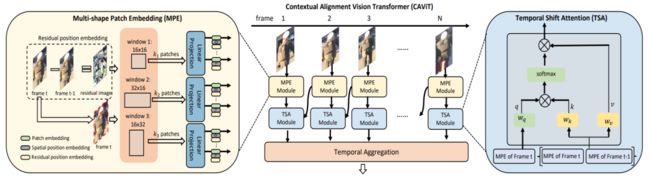

CAViT: Contextual Alignment Vision Transformer for Video-based Object Re- identification

用于视频目标重识别的上下文对齐的Transformer

视频目标重识别旨在通过匹配视频轨迹和裁剪后的视频帧来重新识别不同摄像机下的相同目标。关键点是要从视频序列的时空信息中提取准确的表示。现有的三维解决方案从时空线索中学习表征,但它们被相邻帧的错位所困扰。二维解决方案对错位采取了分而治之的策略,但不能同时建立时空关系模型。为了解决这个难题,我们提出了一个上下文对齐视觉变换器(CA ViT),它包含一个时空转移注意(TSA)模块和一个多形状补丁嵌入(MPE)模块。具体来说,TSA旨在实现上下文空间语义特征的对齐,并联合建立时空关系模型。MPE被设计用来保留空间语义信息,以应对姿势、遮挡和错误检测造成的错位。此外,本文还引入了剩余时间位置嵌入(RPE)来引导关注时间显著性线索时的时间转移注意力。在5个基于视频的行人重识别数据集上的实验结果表明,所提出的CAViT方法优于几种最先进的基于视频的行人重识别方法。同时在VVeRI-901-trial上进行的实验也证明了CAViT在车辆重识别中的有效性。

THE END

ABOUT

京东探索研究院

京东探索研究院(JD Explore Academy)秉承“以技术为本,致力于更高效和可持续的世界”的集团使命,是以京东集团以各事业群与业务单元的技术发展为基础,集合全集团资源和能力,成立的专注前沿科技探索的研发部门,是实现研究和协同创新的生态平台。探索研究院深耕泛人工智能3大领域,包括“量子机器学习”、“可信人工智能”、“超级深度学习”,从基础理论层面实现颠覆式创新,助力数智化产业发展及变革。以原创性科技赋能京东集团零售、物流、健康、科技等全产业链场景,打造源头性科技高地,实现从量变到质变的跨越式发展,引领行业砥砺前行。

京东探索研究院诚招勤于实践、勇于梦想的志同道合之士,包括正式员工或者实习生,方向包括但不限于:算法理论、深度学习、自动机器学习、自然语言处理、计算机视觉、多模态处理、量子机器学习等。

简历投递邮箱:

本文转自京东探索研究院。

欢迎加入「ECCV」交流群备注:ECCV