学习笔记:StyleGAN-NADA: CLIP-Guided Domain Adaptation of Image Generators 图像生成器的CLIP引导领域适应

StyleGAN-NADA: CLIP-Guided Domain Adaptation of Image Generators 图像生成器的CLIP引导领域适应

- 摘要

- 1. 背景

- 2. 相关工作

-

- 2.1 StyleGAN

- 2.2 CLIP

- 2.3 StyleCLIP

- 3. 方法

-

- 3.1 网络架构

- 3.2 基于CLIP的损失

- 3.3 自适应层冻结

- 3.4 潜在映射器

- 4. 实验

-

- 4.1 域外适应

- 4.2 潜在空间探索

- 4.3 对比实验

- 4.4 消融实验

- 5. 总结

论文链接:https://arxiv.org/abs/2108.00946

代码链接:https://github.com/rinongal/StyleGAN-nada

摘要

生成模型能否训练成只在文本提示的引导下生成特定领域的图像,而不需要看到任何图像?换句话说:可以盲目训练一个图像生成器吗?利用大规模对比语言-图像-预训练(CLIP)模型的语义能力,本文提出了一种文本驱动的方法,允许将生成模型迁移到新的领域,而无需从这些域中收集甚至一张图像。通过自然语言提示和几分钟的训练,本文的方法可以在具有不同风格和形状特征的众多领域中调整生成器。值得注意的是,用现有的方法很难或完全不可能实现这些修改。我们在广泛的领域进行了一系列的实验和比较,这些实验证明了该方法的有效性,并表明本文的迁移模型保持了潜在空间属性,这使得生成模型对下游任务具有吸引力。

1. 背景

-

生成对抗网络(GAN)通过语义丰富的潜在空间捕获和建模图像分布的能力已经彻底改变了无数领域。但这些模型的范围通常仅限于可以为其收集大量图像的域,这一要求严重限制了它们的适用性。因为在许多情况下,可能没有足够的数据来训练网络,甚至根本没有任何数据(例如特定艺术家的画作,虚构的场景)。

-

研究表明,视觉–语言模型封装了可以绕过收集数据的通用信息,这些模型可以与生成模型配对,为图像生成和操作提供简单直观的文本驱动界面。然而,这些工作建立在具有固定域的预训练生成模型之上,将用户限制在域内生成和操作上。

2. 相关工作

2.1 StyleGAN

近年来,StyleGAN及其优化模型已经成为最先进的无条件图像生成器,因为它们能够合成前所未有的高分辨率图像。

StyleGAN生成器由两个主要部分组成。首先,映射网络将从高斯分布采样的潜码 z z z转换为学习潜空间 W W W中的向量 w w w。然后将这些潜在向量输入第二个组成部分——合成网络,以控制不同网络层的特征统计信息。通过遍历这个中间潜在空间 W W W,或者在不同的网络层混合不同的 w w w编码,先前的工作证明了对生成图像中语义属性的细粒度控制。然而,这种潜在空间遍历通常仅限于域内修改,也就是说,它被限制为具有与初始训练集匹配的属性的图像集合。相比之下,这里本文的目标是在域之间转移生成器,超越潜在空间编辑,转向语义感知的微调。

2.2 CLIP

Contrastive Language-Image Pretraining(CLIP)是2021年OpenAI推出的一个可以学习联合视觉–语言表示的模型。CLIP在4亿个文本–图像对上进行了训练,使用对比学习目标。在训练时(图左),CLIP联合训练图像编码器和文本编码器来预测一批文本和图像的正确配对。在测试时(图右),学习过的文本编码器通过嵌入目标数据集类的名称或描述来合成零样本线性分类器。目的是将文本和图像各自的输入映射到一个联合的多模态嵌入空间中。

2.3 StyleCLIP

StyleCLIP是先前的工作,它是将StyleGAN的生成能力与CLIP的语义知识相结合,只使用所需更改的文本描述,在预先训练的GAN网络的潜在空间中发现编辑方向。下面是利用CLIP语义能力的三种方法:

(1)文本引导的潜在优化

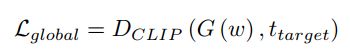

使用标准的反向传播方法来修改给定的潜码,以最小化生成的图像和某些给定目标文本之间的CLIP空间距离:ℒg = ((), ),将此目标文本距离损失定义为全局CLIP损失;

(2)潜在映射器

训练网络将输入的潜码转换为修改生成图像中文本描述属性的编码。此映射器使用相同的全局CLIP损失目标进行训练,它应该生成与图像相对应的编码,以最小化到目标文本的CLIP空间距离。对于一些比较大的形状修改,训练一个潜在映射器可以通过识别潜在空间区域来帮助改善结果,这些区域为目标类产生了更好的候选者;

(3)全局方向

通过确定哪些潜码修改诱导图像空间变化来发现GAN网络的潜在空间中有意义的变化方向,该变化与CLIP空间中两个文本描述符(也就是源和目标)之间的方向共线性。

3. 方法

本文提出了StyleGAN-NADA,一种基于视觉–语言预训练模型(CLIP)引导的图像生成器非对抗领域适应的零样本方法。通过使用CLIP来指导生成器的训练,将生成模型的领域迁移到一个新的领域,只使用文本提示,生成的图像能够产生风格和形状的巨大变化,远远超越原始生成器的领域。

如图所示,只需要输入文本,就可以生成指定艺术风格的绘画图像。

3.1 网络架构

图中是训练阶段的一个大致的网络架构。核心是两个相互交织的生成器—— G G Gfrozen 和 G G Gtrain(它们都使用StyleGAN2架构)。两个生成器共享一个映射网络,所以具有相同的潜在空间,这就使得相同的潜码最初将在两者中生成的图像相同。然后使用在单个源域(例如人脸、狗、教堂、汽车)上预先训练的模型的权重来初始化这两个生成器。我们的目标是更改其中一个配对生成器的域,同时保持另一个生成器固定作为参考。

G G Gfrozen 的权重在整个过程中保持固定,目的是在无限范围的生成实例中提供源域的上下文; G G Gtrain 的权重通过使用一组基于CLIP的损失优化和层冻结方法进行修改。这个过程是根据用户提供的文本方向来迁移 G G Gtrain 的域,同时保持共享的潜在空间。

3.2 基于CLIP的损失

本文依靠预先训练的CLIP模型作为目标域的唯一监督源。为了有效地从CLIP中提取知识,本文利用了三种损失算法:

3.2.1 全局目标损失(Global CLIP loss)

G G G( w w w)是提供潜码时生成器生成的图像, t t ttarget 是目标类的文本描述, D D D是CLIP空间的余弦距离。这个损失的目的是最小化生成的图像和某些给定目标文本之间的CLIP 空间余弦距离,用来负责确定在每次迭代中训练哪个层子集。

3.2.2 局部方向损失(Directional CLIP loss)

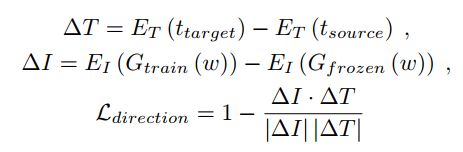

将两个生成器生成的图像嵌入到CLIP空间中,并要求连接它们的矢量 Δ I ΔI ΔI,与源文本和目标文本规定的方向 Δ T ΔT ΔT共线性。

t t ttarget 和 t t tsource 分别是源文本和目标文本, E E EI 和 E E ET 分别是CLIP的图像和文本编码器, G G Gfrozen 和 G G Gtrain 分别是冻结源生成器和改进的可训练生成器。这个损失的目的是保护多样性和图片质量。

3.2.3 嵌入范数损失(Embedding-norm loss)

在某些情况下,使用StyleCLIP中的潜在映射器可以更好地识别与目标域匹配的潜在空间区域。但映射器偶尔会在图像上引起不良的语义伪影,例如张开动物的嘴和放大舌头。我们观察到,这些伪影与生成的图像的CLIP空间嵌入规范的增加相关。因此,我们通过在映射器训练期间引入额外的损失来约束这些规范,从而阻止映射器引入此类伪影:

3.3 自适应层冻结

理想情况下,我们希望将训练限制在那些与给定变化最相关的模型权重上,在StyleGAN的潜在空间中,不同网络层的潜码会影响不同的语义属性,我们可以查找哪些层与给定的变化最相关,避免不相关的更改。因此,本文提出了一个自适应层冻结方案,在每次迭代中,(1)选择 k k k个最相关的层;(2)执行生成器的单一训练迭代,只优化这些层,同时冻结所有其他层。

-

第一阶段(层选择阶段),为了选择这 k k k层,我们随机抽样 N N Nw 个潜码∈ W W W,并通过为每一层复制相同的潜码将其转换为 W W W+(绿松石色),然后执行StyleCLIP潜在优化步骤的 N N Ni 迭代,保持所有网络权重固定。这一阶段使用全局目标损失进行优化,这个损失是由目标域的文本描述驱动。然后我们选择相应 w w w条目变化最明显的 k k k层(用较深的颜色表示,这里是选择红色和橘色);

-

第二阶段(优化阶段),使用局部方向损失来优化选中的这些层,同时冻结其他层。采用这个训练方法优化的参数较少,可以降低模型复杂性和过拟合的风险。

3.4 潜在映射器

作者注意到对于某些形状变化,生成器不会进行完整的转换。 例如,在狗变成猫的情况下,微调过程会产生一个新的生成器,它可以输出猫、狗和介于两者之间的各种图像。 然而,这个转换的生成器现在在其域内同时包括猫和狗。因此,我们使用StyleCLIP的潜在映射器,并添加了嵌入范数损失,以便将所有潜码映射到潜在空间的类似猫的区域。

4. 实验

4.1 域外适应

下面两个图展示了一系列由从人脸、教堂、狗和汽车域迁移到一系列目标域的生成器合成的随机采样图像。在这些实验中,作者使用了完整的模型,没有潜在映射器。对于纯粹基于风格的更改,我们允许跨所有层进行训练;对于微小的形状修改,我们训练大约三分之二的模型层,在稳定性和训练时间之间提供了良好的折衷方案。

狗对其它动物的域适应性

源域文本都是"Dog",目标域文本在每个图像的下方。对于这个实验,我们在每次迭代的可训练层数设置3,并训练一个潜在映射器以减少源域的泄漏。与前一个实验主要集中在风格或小的形状调整相比,这里的模型需要执行比较大的形状修改。例如,许多动物的耳朵是直立的,而源域中大多数狗不是。

4.2 潜在空间探索

4.2.1 GAN反转

对于给定的真实图像,首先预训练的ReStyle编码器将图像转换到StyleGAN2 FFHQ模型的潜在空间中,然后将相同的潜码输入修改过的生成器中,以便将相同的标识映射到一个新的域。图中展示了反转和域外编辑的结果。

从图中可以看出,本文的生成器成功地保留了与潜码相关联的身份,对于那些从真实图像的反转中获得的编码也是如此。因此,本文的模型可以用于真实图像的文本驱动、零样本域外图像到图像的翻译。

4.2.2 潜在遍历编辑

图中展示了使用现有的几种方法在映射到新域的真实图像上执行的编辑。第一行是源域的编辑,下面所有行是编辑域中的编辑操作,每一行的左侧是驱动文本,每一列的下面是编辑方向。

实验使用StyleCLIP编辑表情和发型,使用InterfaceGAN编辑年龄,使用StyleFlow编辑姿势。

4.2.3 图像到图像的翻译

预先训练的pSp编码器可以与本文适应的生成器配对,从而实现更通用的图像到图像的翻译方法。图中展示了使用分割掩码和基于草图的引导,在多个域中条件图像合成的结果。

4.3 对比实验

4.3.1 文本引导编辑

第一个对比实验是将本文的方法与 StyleCLIP 的三种方法比较。第一列显示了源生成器生成的图像,其中包含给定的潜码;中间三列分别是三种StyleCLIP方法将潜码编辑到域外文本方向的结果;最后一列是使用本文方法生成的图像。

本文的模型成功地实现了域外更改,这些更改超出了所有StyleCLIP方法的范围。

4.3.2 零样本生成器

第二个对比实验是将本文的零样本训练方法与两种少样本方法进行比较。

-

Ojha 侧重于保持源域的多样性,同时适应目标域的风格;MineGAN 通过引导GAN网络向更符合目标集分布的潜在空间区域来稳定训练;

-

在5个样本的情况下,MineGAN 只是记住训练集,而本文的模型在没有提供任何目标域图像的情况下,保持了高度的多样性。

4.4 消融实验

从图中可以看出,采用自适应层冻结方法生成的图像视觉效果非常好。在某些情况下,可以通过训练潜在映射器来进一步提高质量(例如第一行)。

5. 总结

-

本文提出了一种文本驱动的方法,将生成模型的领域迁移到一个新的领域,只使用文本提示实现域外生成;

-

提出了一种新颖的双生成器训练方法,这些生成器是相互交织的,并且共享一个共同的潜在空间;

-

引入了一种新颖的自适应训练方法,该方法利用CLIP来识别和限制训练,提高了训练稳定性,以应对更剧烈的领域变化。