首篇!无相机参数BEV感知!(北航、地平线)

点击下方卡片,关注“自动驾驶之心”公众号

ADAS巨卷干货,即可获取

点击进入→自动驾驶之心【3D目标检测】技术交流群

后台回复【3D检测综述】获取最新基于点云/BEV/图像的3D检测综述!

摘要

在自动驾驶的高级范例中,从环视图学习BEV表示对于多任务框架至关重要。然而,现有的基于深度估计或camera-driven attention的方法不稳定,无法在有噪声的相机参数下获得transformation,主要有两个挑战,即精确的深度预测和相机标定。在这项工作中,论文提出了一种用于鲁棒BEV表示的完全多相机无标定Transformer(CFT),该Transformer专注于探索隐式映射,而不依赖于相机内外参。为了将更好的特征学习从图像引导到BEV,CFT通过位置感知增强(PA)在BEV中挖掘潜在的3D信息。代替摄像机驱动的逐点或全局Transformer,为了在更有效的区域内进行交互并降低计算成本,论文提出了一种view-aware attention,这也减少了冗余计算并加速了收敛。CFT在nuScenes检测任务排行榜上实现了49.7%的NDS,与其他几何引导方法相比,这是第一个去除相机参数的工作。在没有时间输入和其他模态信息的情况下,CFT以较小的图像输入(1600×640)实现了第二高的性能。由于view-attention的变体,CFT将普通注意力的内存和transformer FLOPs分别减少了约12%和60%,NDS提高了1.0%。此外,它对噪声相机参数的天然鲁棒性使CFT更具竞争力!!

介绍

与昂贵的基于激光雷达的[10,18,3]或多模态方法[42,41,50,49,2,30,12]相比,从多摄像机2D图像中检测3D目标是自动驾驶系统的关键感知技术。最近的方法强调将2D图像特征转换为稀疏实例级[9,37,45]或密集鸟瞰图(BEV)表示[16,22,26],以表征周围环境的3D结构。尽管一些基于深度的检测器[16、17、21、26、51]结合了深度估计来引入这种3D信息,但为了更精确的检测,需要获取额外的深度监督。因此,其他范式[22,45]直接学习基于注意力机制的转换[40]。它们显式地预测query的3D坐标。有了这些坐标,结合相机的内外参,可以对局部图像特征进行采样以进行cross-attention,如图1a所示。然而,由于真实场景中摄像机参数的不准确预测、标定误差或动态变化,所获得的表示并不稳定。推理速度也受到逐点坐标投影和采样的影响。

为了更稳定地学习表示,研究人员[25,52]通过隐式生成相机驱动的3D位置嵌入来间接挖掘不同视图之间的关系。这绕过了位置估计,但注意力计算仍然对相机参数敏感,如图1b所示。事实上,现有的分析[22,26,33]也表明,噪声外参对结果有很大影响。此外,BEV网格的每个位置和图像像素的位置之间的global attention导致了较高的计算成本。因此,考虑到具有显式或隐式相机驱动注意力的上述问题,去除鲁棒BEV表示的几何先验,并在性能、速度和计算成本之间取得良好的平衡非常重要。

论文提出了一种多摄像机无标定Transformer(CFT),在没有任何几何引导的情况下学习BEV表示来实现3D目标检测。图1c简要说明了CFT,它通过隐式增强BEV嵌入中的3D特征,帮助相机参数在图像和BEV之间自由转换。具体而言,CFT提出了一种content-based的位置感知增强(PA)。由于PA能够分别捕获位置和content,即使是隐式无监督学习也可以有效地提取3D位置信息,类似于在PA中添加显式监督的结果。BEV的原始2D坐标编码可以包含更丰富的3D线索,从而获得与图像像素的充分交互。这不仅能够稳定地学习物体的特征以获得正确的感知,而且能够实现更快的推断。

为了节省CFT模型的计算成本,论文进一步提出了一种轻量级的view-aware attention(VA),而不是几何引导的稀疏采样,同时应用于视图内和视图间转换。除了有效地减少FLOPs和内存,view-attention还忽略了冗余计算,这有助于更快地学习注意力。与global attention相比,论文BEV上构建的不同视图选择方案都取得了更好的效果。

本文的主要贡献如下:

论文提出的CFT可以学习鲁棒的BEV表示,用于无需相机参数的多目3D目标检测。这是首篇在精度和速度方面实现了与几何相关方法相当甚至更高性能的工作(45.5%NDS,3.6 FPS vs 44.8%NDS,2.7 FPS);

论文设计PA以获得BEV更丰富的3D信息,这可以从内容嵌入中充分挖掘高度特征,促进图像与BEV之间的关联建立;

VA是为了减少冗余计算而提出的。与global transformation相比,注意力的FLOPs减少了60%∼ 78%,内存开销减少了12%~17%,它促进了有效区域内更好的相互作用;

nuScenes检测任务的实验评估表明,CFT实现了49.7%的NDS(2022年10月5日),与排行榜上没有时序或其他模态输入的最新方法(50.4%的NDS)相比,具有竞争力。特别是,与其他噪声外参模型相比,CFT没有退化。

相关工作

多目3D目标检测从输入的环视视图预测感兴趣目标的3D边界框。受2D检测中典型工作的启发[6,55,38],研究人员结合3D先验,提出了不同的3D目标检测框架,以直接实现稀疏目标级特征提取[45,9,37,11]。在最近的自动驾驶新范例中,BEV空间因其在感知[35,47,56,7,33]、预测[1,14]、多任务学习[46,51,28,5]和下游规划[33]等方面的优势而备受关注。BEVDet和CenterPoint[48]通过在map view上定位目标中心点来实现基于关键点的检测[53]。PETR和BEVFormer利用DETR[6]中的端到端3D检测头,将所有BEV网格视为密集query。为了更好地检测被遮挡和动态目标,还将多帧时间信息引入原始检测架构[15,26,34]。

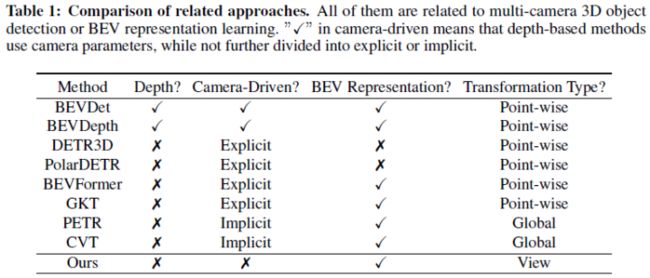

为了从环视视图中学习BEV表示,基于深度的方法[33,36,21,16,43,35]推断图像视图中的深度,并使用内外参将其投影到BEV平面,其中无监督深度估计仍是一大挑战。尽管与其他范式相比,BEVdepth[21]提高了特征提取和下游任务的性能,但额外的监督是一个关键问题,相对来说更难获得。相比之下,受2D目标检测的Transformer框架[55,6]的启发,一些工作如BEVformer[22,17,32,8]强调基于注意力机制直接学习图像和BEV之间的变换关系。具体而言,他们显式地预设高度或监督预测高度,然后通过根据相机内外参对局部图像特征进行采样,对BEV进行逐点注意力。端到端表示学习和较少的计算是它们的优势,但对3D先验的依赖会影响模型的鲁棒性,例如高度误差或相机参数的偏差。此外,坐标变换和采样导致处理效率较低。在没有投影操作的情况下,PETR[25]和CVT[52]将3D信息隐式编码为图像或BEV特征。但精确的相机参数仍然是必要的,这些参数间接地用于引导注意力。此外,引入全局变换增加了计算成本和优化难度。与以前的方法不同,论文提出的CFT不估计深度,并完全移除相机参数。受视觉Transformer[29,24,20]的启发,CFT将位置感知增强中的位置和内容嵌入解耦,并进一步挖掘更丰富的3D信息,从而有效地学习稳定的BEV表示。提出了一种view-attention,以减少计算量并加速转换关系的建立,而不是使用相机引导或冗余global attention的逐点注意力。

对于上述各种相关方法,论文在表1中总结了一些有代表性的方法与CFT之间的主要差异。

方法

整体框架

论文专注于基于注意力的3D目标检测,而不引入时序信息,并提出了一个完全消除相机参数影响的整体架构。多目图像输入,其中表示视图数。每个视图图像被馈送到主干网络和neck,用于提取多尺度特征图。特别是,论文采用了最低比例尺度的特征图用于后续处理,即仅使用单尺度。然后,与BEV嵌入交互,以获得我们的CFT中的BEV表示,如图2所示。CFT主要有两个组件:position-aware enhancement(PA)和view-aware attention(VA),它们分别用于捕获BEV 3D位置信息和实现轻量级注意力。最后,借助于设计的检测头,在BEV空间上输出3D边界框的预测。

Position-Aware Enhancement

为了在没有相机参数的情况下捕获BEV中的3D位置信息,论文从嵌入的普通BEV 2D坐标开始,并进一步更新它,这为每个BEV网格(h,w)分配了唯一的特征编码。首先基于粗略地推断(h,w)的参考高度,并如下执行正弦位置编码[40]:

为了适应不同目标的高度,进一步引入了BEV content embedding,然后,基于学习矩阵M,以细化目标高度,并获得更新的结果。如下所示:

该操作可以提取content中的位置相关信息,并获得,这增强了原始不足的2D坐标嵌入。整个步骤如图2所示。考虑到普通注意力混合了content和position,这对正确学习位置信息没有好处,因此论文在图像和BEV中重构了两个部分:

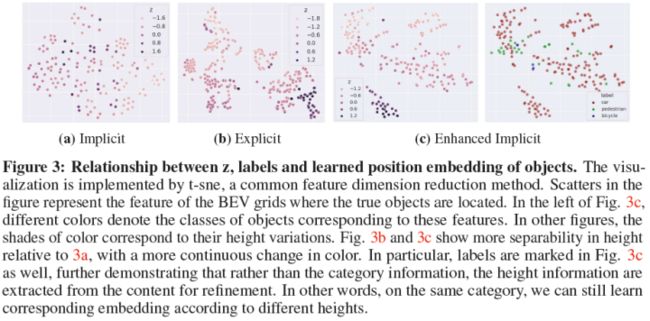

图3展示了通过t-sne的特征可视化[39],其比较了不同设计下的精细高度编码和高度GT之间的关系。具体而言,图3a表示仅使用2D位置信息和普通注意力来学习变换,图3b和3c分别表示在PA中是否存在预测的监督。不管监督如何,论文的PA有助于增强BEV的位置嵌入,使其与高度更相关,其高度特征与简单设计相比表现出更好的可分性。因此,多亏了PA,相机的内外参可以完全消除,仍然可以确保有效地学习3D信息。

View-Aware Attention

在标准的global attention中,和将被展平以便直接计算,不包括通道维度。与这种高成本的计算冗余方法不同,论文提出的视图级注意力变体仅考虑有价值的交互。如图2所示,首先将图像编码重塑为来调节self-attention。因此,对于每个图像,self-attention只涉及同一视图中的像素。然后沿着BEV编码的空间维度划分个窗口。事实上,有多种划分方法,在减少计算量和提高性能方面带来不同的好处。

论文的注意力变体引入了视图先验,而不依赖内外参。除了降低内存成本,它还通过粗略考虑相机范围来消除冗余信息,这有利于更快更好地学习BEV特性。VA对相机参数具有固有的鲁棒性,并比几何引导的注意力更有效地进行推理。

检测头参考CenterPoint[48]构建。

实验

论文在nuScenes [4]上展开实验。论文采用ResNet-101[13]主干,经过FCOS3D[44]预训练,以及FPN[23]颈部,默认情况下为CFT提取图像特征。

主要结果

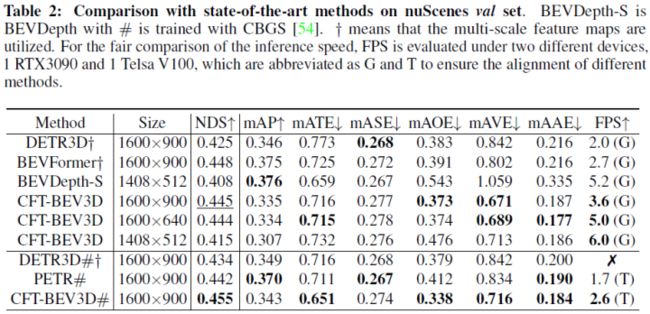

论文将所提出的方法与四种最先进的模型DETR3D、BEVFormer、BEVDepth和PETR进行了比较,如表2所示,其中CFT-BEV3D表示论文用于3D目标检测任务的CFT模型。为了公平比较,输入不同大小的图像视图以对齐其他方法。在相同条件下,CFT-BEV3D在NDS上分别优于DETR3D和PETR 2.1%(或2.0%,无CBGS)和1.3%。在1600×640的较小尺寸下,CFT-BEV3D仍超过DETR3D 1.9%。特别是,即使不使用多尺度特征,CFT仍然可以获得具有竞争力的NDS(−0.3%vs BEVFormer)。与具有额外深度监督的高级方法BEVDepth相比,CFT在相同分辨率1408×512下仍高0.7%NDS。值得注意的是,尽管BEVDeph由于其精确的深度估计而超过了在mAP和mATE上具有更大分辨率的大多数方法,但其他度量相对较低,因此不如我们的CFT-BEV3D。就推理速度而言,CFT-BEV3D在不同的输入尺度上表现出更快的FPS。此外,与其他在噪声外参下性能下降的方法不同,CFT-BEV3D是稳定的,可能远优于其他方法。

表3展示了nuScenes检测任务排行榜上没有时序输入和其他模态信息的方法的比较。所有模型都使用VoVNetV2[19]主干进行训练,并通过DD3D[31]进行预训练。不同的是,CFT-BEV3D利用了更小的(1600×640)分辨率输入,并获得了可比的NDS分数,这是第二好的,比PETR低0.7%。

消融实验

当基于论文设计的PA构建嵌入以增强位置信息时,使用三种策略进行比较:隐式、显式和增强的隐式。详细解释和结果如表4所示。

与学习到的嵌入相比,“显式”PA在NDS上提高了2.0%,其中mAOE和mAP的提高分别为4.5%和1.4%。它表明,附加的3D增强信息有助于每个BEV网格更好地对应于真实位置,这有利于捕获正确的图像特征。它们显示在地图视图中,从而改进了方向和类别的预测。特别是,在NDS上,“增强型隐式”PA与“显式”PA相当,只有mAOE稍差。

BEV Window Division

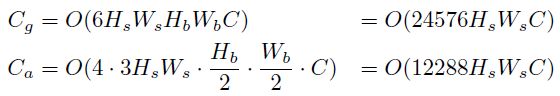

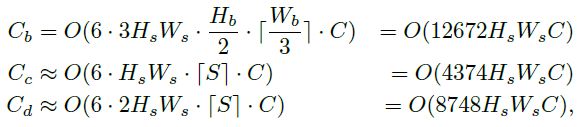

为了在VA中进行cross-attention,BEV需要被划分为多个窗口,并且可以考虑各种划分方法。为了尽可能选择最佳分割方法以平衡性能和计算成本,论文在图4中对4种不同的策略进行了充分的实验。在比较实验结果之前,首先对这些策略进行了理论分析,计算它们与global attention相比带来的计算减少:

实验结果如图5所示,其中包含了不同注意力类型下两个输入图像大小在检测分数、计算量和内存方面的比较。对于1600×640输入,内存和FLOP的改进与理论分析基本一致,其中(a)在FLOP中比(b)稍差,因为它考虑了整个transformer的计算。尽管(c)在降低计算成本方面表现最佳,但NDS得分低于其他方法(−1.3%vs(a)),因为它的表示能力不足,仅使用一个视图。相比之下,(a)和(d)都实现了良好的平衡,其NDS优于global attention约1.0%和0.5%,同时成本也得到了充分的降低。特别是,论文的所有注意力变体都可以在检测中实现与原始注意力相当或更好的性能,这表明VA有效地丢弃了冗余特征,促进了有效区域内的交互,甚至提高了学习BEV表示的能力。

着眼于检测性能,论文最终选择了(a)的划分方法,并以更大的分辨率1600×900进行了实验,这表明与global attention相比,计算成本优化是足够的。

总之,VA作为论文提出的新注意力变体,提升了原始的全局注意力性能,也取代了不稳定的几何制导注意力。它对摄像机参数变化具有鲁棒性,确保了足够的感受野,实现了潜在视点变换的稳定学习。

噪声外参分析

为了分析摄像机参数对BEV表示学习的影响,论文采用了[22]中的外部噪声。将其应用于PETR、BEVFormer和CFT-BEV3D以评估训练模型,如图5中的结果所示。在精确外参条件下,与相同配置的其他模型相比,CFT-BEV 3D的NDS得分略低。然而,它自然不受噪声水平变化的干扰,结果稳定。即使参数有微小的扰动,BEVformer也会下降0.6%− 6.8%NDS和PETR下降4.7%− 7.6%,但论文的方法不易受到这些扰动的影响,并显示出明显的改进。上述相机参数不稳定导致的退化问题和结果说明了无标定模型的重要性,并证实了无需依赖参数指导即可获得具有竞争力的结果,其稳定性能也有助于进一步扩展和应用。

可视化结果如图6所示:

结论

本文提出了一种通过完全无相机标定的视图变换从图像视图学习BEV表示的方法。CFT是第一个无参数的工作,与3D目标检测的最新方法性能相当,这得益于使用增强的3D信息隐式学习映射。此外,论文提出了一种注意力变体,它使模型能够减少内存、计算成本并更好地收敛。与现有其他工作不同,CFT对相机参数噪声具有天然的鲁棒性。在不久的将来,论文将探索将CFT与时序或其他模态相结合。

参考

[1] Multi-Camera Calibration Free BEV Representation for 3D Object Detection

往期回顾

单目BEV!CROMA:跨模态域适应下的单目BEV感知

【自动驾驶之心】全栈技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦目标检测、语义分割、全景分割、实例分割、关键点检测、车道线、目标跟踪、3D目标检测、BEV感知、多传感器融合、SLAM、光流估计、深度估计、轨迹预测、高精地图、规划控制、模型部署落地、自动驾驶仿真测试、硬件配置、AI求职交流等方向;

加入我们:自动驾驶之心技术交流群汇总!

自动驾驶之心【知识星球】

想要了解更多自动驾驶感知(分类、检测、分割、关键点、车道线、3D目标检测、多传感器融合、目标跟踪、光流估计、轨迹预测)、自动驾驶定位建图(SLAM、高精地图)、自动驾驶规划控制、领域技术方案、AI模型部署落地实战、行业动态、岗位发布,欢迎扫描下方二维码,加入自动驾驶之心知识星球(三天内无条件退款),日常分享论文+代码,这里汇聚行业和学术界大佬,前沿技术方向尽在掌握中,期待交流!