多元线性回归&梯度下降法——多元线性回归

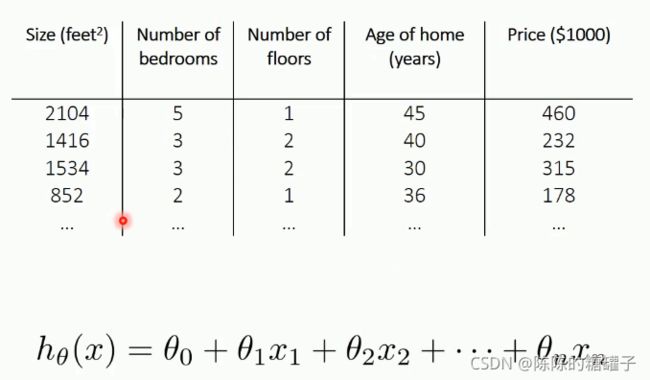

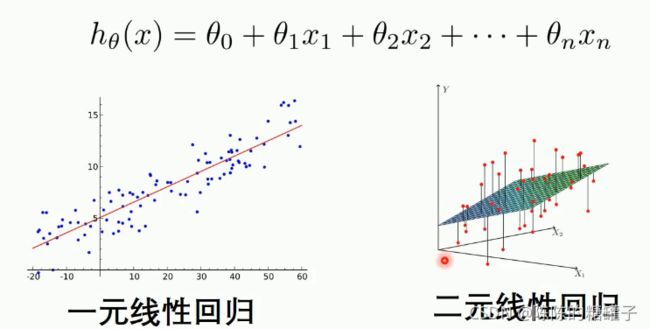

多特征

当Y值的影响因素不是唯一时,采用多元线性回归模型

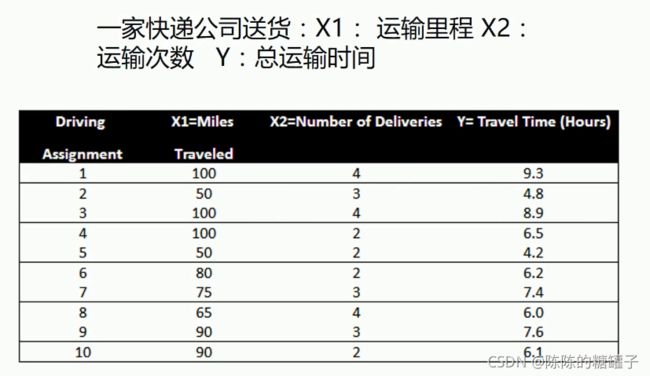

例子

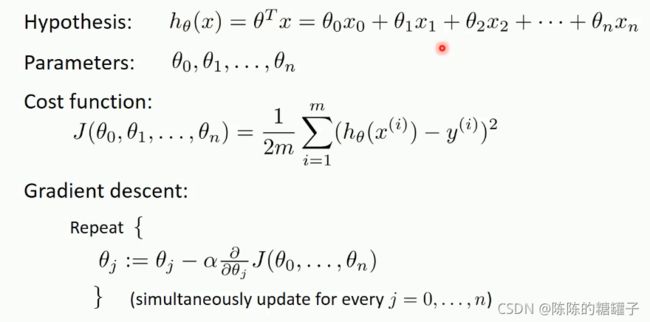

梯度下降法——多元线性回归

import numpy as np

from numpy import genfromtxt

import matplotlib.pyplot as plt

from mpl_toolkits.mplot3d import Axes3D

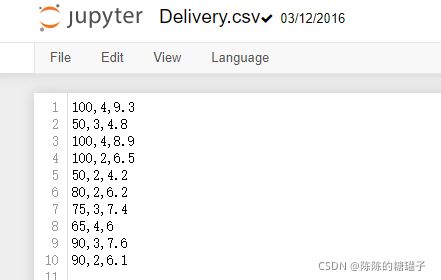

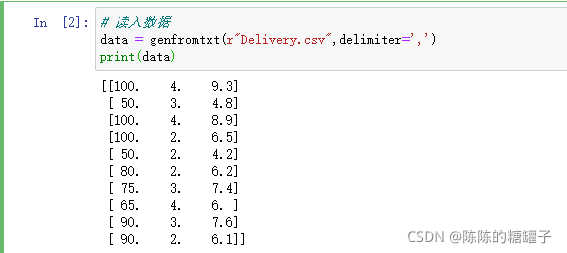

# 读入数据

data = genfromtxt(r"Delivery.csv",delimiter=',')

print(data)

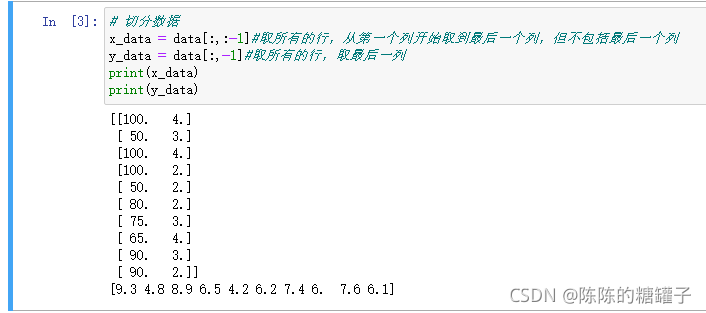

# 切分数据

x_data = data[:,:-1]#取所有的行,从第一个列开始取到最后一个列,但不包括最后一个列

y_data = data[:,-1]#取所有的行,取最后一列

print(x_data)

print(y_data)

# 学习率learning rate

lr = 0.0001

# 参数

theta0 = 0

theta1 = 0

theta2 = 0

# 最大迭代次数

epochs = 1000

# 最小二乘法

def compute_error(theta0, theta1, theta2, x_data, y_data):

totalError = 0

for i in range(0, len(x_data)):

totalError += (y_data[i] - (theta1 * x_data[i,0] + theta2*x_data[i,1] + theta0)) ** 2

return totalError / float(len(x_data))

def gradient_descent_runner(x_data, y_data, theta0, theta1, theta2, lr, epochs):

# 计算总数据量

m = float(len(x_data))

# 循环epochs次

for i in range(epochs):

theta0_grad = 0

theta1_grad = 0

theta2_grad = 0

# 计算梯度的总和再求平均

for j in range(0, len(x_data)):

theta0_grad += (1/m) * ((theta1 * x_data[j,0] + theta2*x_data[j,1] + theta0) - y_data[j])

theta1_grad += (1/m) * x_data[j,0] * ((theta1 * x_data[j,0] + theta2*x_data[j,1] + theta0) - y_data[j])

theta2_grad += (1/m) * x_data[j,1] * ((theta1 * x_data[j,0] + theta2*x_data[j,1] + theta0) - y_data[j])

# 更新b和k

theta0 = theta0 - (lr*theta0_grad)

theta1 = theta1 - (lr*theta1_grad)

theta2 = theta2 - (lr*theta2_grad)

return theta0, theta1, theta2

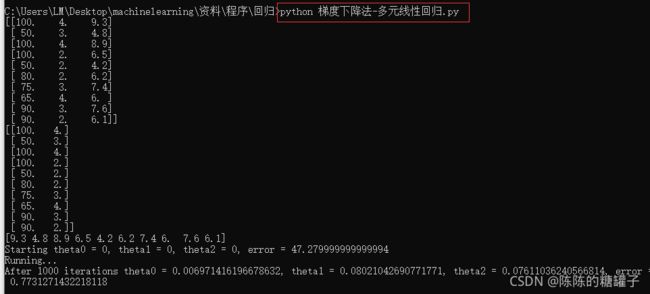

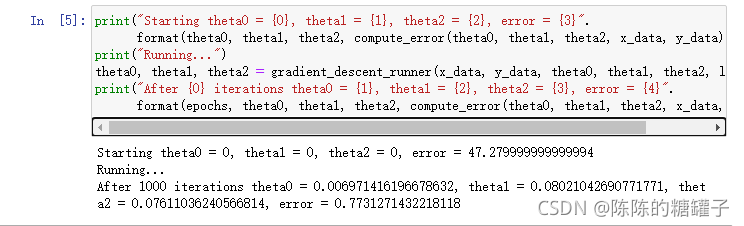

print("Starting theta0 = {0}, theta1 = {1}, theta2 = {2}, error = {3}".

format(theta0, theta1, theta2, compute_error(theta0, theta1, theta2, x_data, y_data)))

print("Running...")

theta0, theta1, theta2 = gradient_descent_runner(x_data, y_data, theta0, theta1, theta2, lr, epochs)

print("After {0} iterations theta0 = {1}, theta1 = {2}, theta2 = {3}, error = {4}".

format(epochs, theta0, theta1, theta2, compute_error(theta0, theta1, theta2, x_data, y_data)))

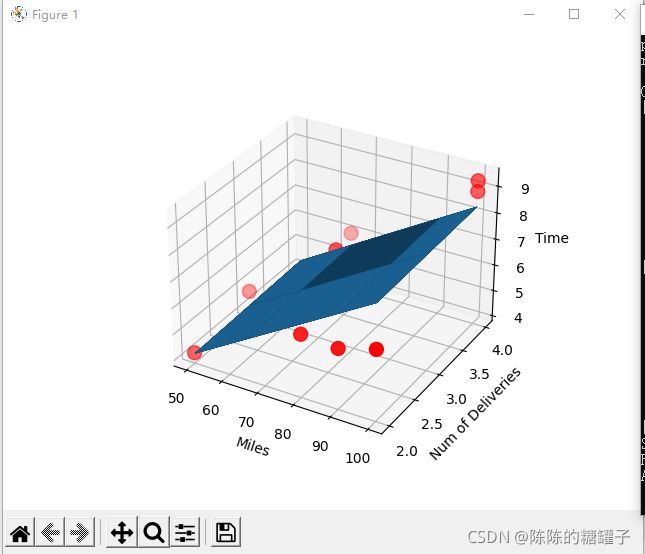

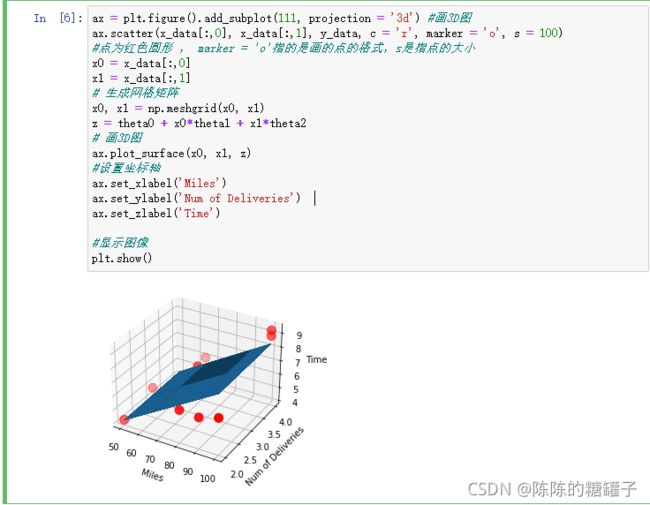

ax = plt.figure().add_subplot(111, projection = '3d') #画3D图

ax.scatter(x_data[:,0], x_data[:,1], y_data, c = 'r', marker = 'o', s = 100)

#点为红色圆形 , marker = 'o'指的是画的点的格式,s是指点的大小

x0 = x_data[:,0]

x1 = x_data[:,1]

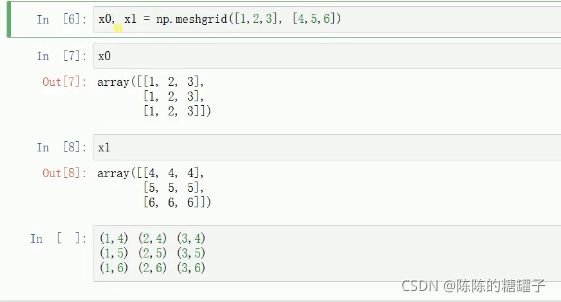

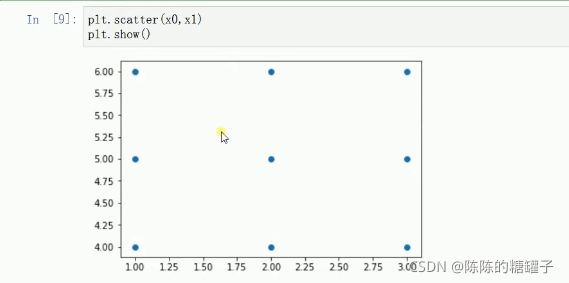

# 生成网格矩阵

x0, x1 = np.meshgrid(x0, x1)

z = theta0 + x0*theta1 + x1*theta2

# 画3D图

ax.plot_surface(x0, x1, z)

#设置坐标轴

ax.set_xlabel('Miles')

ax.set_ylabel('Num of Deliveries')

ax.set_zlabel('Time')

#显示图像

plt.show()

其中x0, x1 = np.meshgrid(x0, x1)的作用便是将x0,x1每个坐标对应形成网格

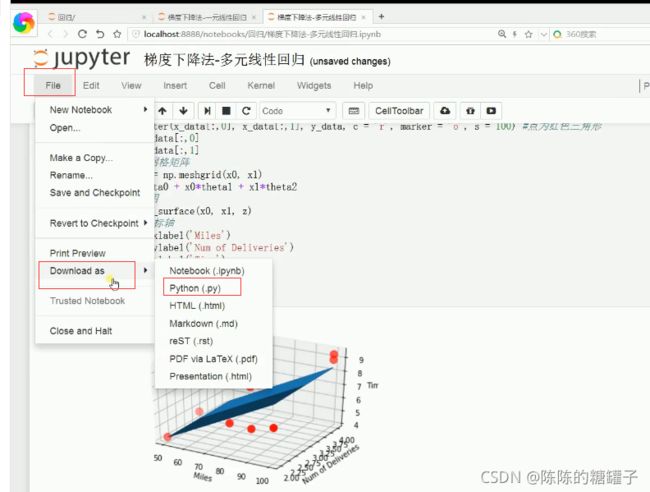

如果想看到比较完整可以转动的图,将代码文件存成.py文件,然后在cmd相应文件内运行