【论文学习】《Adversarial Attacks on GMM i-vector based Speaker Verification Systems》

《Adversarial Attacks on GMM i-vector based Speaker Verification Systems》论文学习

文章目录

- 《Adversarial Attacks on GMM i-vector based Speaker Verification Systems》论文学习

-

- 摘要

- 1 介绍

- 2 自动说话人验证系统

-

- 2.1 高斯混合模型 i-vector提取

- 2.2 x-vector提取

- 2.3 后端概率线性判别分析

- 3 对抗样本生成

-

- 3.1 快速梯度符号法

- 3.2 问题界定

- 4 实验设置

-

- 4.1 ASV模式配置

- 4.2 评价指标

- 4.3 ABX测试

- 5 实验结果

-

- 5.1 ABX测试结果

- 5.2 白盒攻击

- 5.3 黑盒攻击

- 6 结论

摘要

本文研究了基于高斯混合模型(GMM) i-vector的说话人验证系统对对抗攻击的脆弱性,以及GMM i-vector系统对x-vector系统制作的对抗样本的可迁移性。详细地说,我们制定了GMM i-vector系统作为登记和测试语音对的评分函数。然后,我们利用快速梯度符号法(FGSM)来优化测试话语的对抗样本生成。这些对抗性样本用于攻击GMM的 i-vector和 x-vector系统。我们通过等错误率和误接受率的降低来衡量系统的脆弱性。实验结果表明,GMM i-vector系统在对抗攻击下非常脆弱,所构建的对抗样本具有可转移性,并对基于神经网络说话人嵌入的系统(如x-vector系统)构成威胁。

关键词:对抗攻击,说话人验证,GMM i-vector,x-vector

1 介绍

自动说话人验证(ASV)系统的目的是对声明的说话人身份进行确认。经过几十年的发展,说话人验证领域取得了很大的进步,并将该技术应用于许多生物识别认证案例,如电子设备中的语音激活、电子银行认证等。

然而,过去的研究表明,ASV系统容易受到假冒(《A comparison between human perception and a speaker verification system score of a voice imitation》,《Spoofing and countermeasures for speaker verification: A survey》)、重放(《Spoofing and countermeasures for speaker verification: A survey》,《A study on replay attack and anti-spoofing for text-dependent speaker verification》)、语音合成(《Examining vulnerability of voice verification systems to spoofing attacks by means of a TTS system》,《Vulnerability of voice verification systems to spoofing attacks by tts voices based on automatically labeled telephone speech》)和语音转换(《Vulnerability of speaker verification systems against voice conversion spoofing attacks: The case of telephone speech》)等欺骗语音的恶意攻击。在这四种欺骗攻击中,重放攻击、语音合成攻击和语音转换攻击是ASV系统面临的最严重的威胁。创建的欺骗语音听起来可能非常接近目标人的声音。此外,ASV系统也可能被听起来像冒名顶替者的声音欺骗。这将使系统面临其他一些危险情况,例如,在不知情的情况下,被冒充者代替真正的主人控制语音设备。这些威胁可能由对抗攻击造成。

《Intriguing properties of neural networks》,《On adversarial examples for character-level neural machine translation》,《Explaining and harnessing adversarial examples》的研究表明,性能优异的深度神经网络(DNNs)在许多任务中,如人脸识别(《Are imageagnostic universal adversarial perturbations for face recognition difficult to detect?》,《Accessorize to a crime: Real and stealthy attacks on state-of-the-art face recognition》)、图像分类(《Delving into transferable adversarial examples and black-box attacks》,《Synthesizing robust adversarial examples》)、语音识别(《Audio adversarial examples: Targeted attacks on speech-to-text》)等,容易受到简单的对抗攻击。然而,据我们所知,唯一将对抗攻击应用于ASV系统的工作是(《Fooling end-to-end speaker verification with adversarial examples》),它验证了端到端ASV系统对对抗攻击的脆弱性。简单地说,有三种具有代表性的ASV框架:基于i-vector说话人嵌入的系统(《Front-end factor analysis for speaker verification》,《A small footprint i-vector extractor》,《Probabilistic linear discriminant analysis for inferences about identity》,《Analysis of i-vector length normalization in speaker recognition systems》),基于神经网络(NN)说话人嵌入的系统(《Deep neural networks for small footprint textdependent speaker verification》,《X-vectors: Robust DNN embeddings for speaker recognition》)和端到端方法(《End-to-end attention based text-dependent speaker verification》,《End-to-end text-dependent speaker verification》,《Deep neural network-based speaker embeddings for end-to-end speaker verification》)。尽管端到端系统已被证明容易受到对抗攻击,但其他方法的鲁棒性,包括基于GMM i-vector的系统和基于NN说话人嵌入的系统(例如我们实现的x-vector系统),仍有待探索。基于GMM i-vector的系统广泛应用于生物特征认证,研究其对此类攻击的鲁棒性势在必行。

对抗攻击旨在以一种有目的设计的方式干扰系统输入,使系统行为不正确。这些干扰通常是微妙的,以致于人类无法察觉对抗输入和原始输入之间的差异。主要有两种攻击场景:白盒攻击和黑盒攻击。白盒攻击允许攻击者访问系统的完整参数,使系统功能可以直接参与优化输入扰动。黑盒攻击者只能访问系统的输入和输出,而对抗样本通常是由其他替代系统制作的。

对于对抗样本的生成,之前提出了许多算法来解决扰动优化问题,如快速梯度符号法(FGSM)(《Explaining and harnessing adversarial examples》),基本迭代法(BIM)(《Adversarial machine learning at scale》)和DeepFool(《Deepfool: a simple and accurate method to fool deep neural networks》)。在本研究中,我们简单地采用FGSM来验证ASV系统对对抗性攻击的脆弱性。

本文主要研究了GMM i-vector系统对对抗性攻击的脆弱性,以及从i-vector系统到x-vector系统制作的对抗样本的可迁移性。具体来说,我们对GMM的i-vector系统进行白盒攻击和黑盒攻击,对x-vector系统进行黑盒攻击。详细的攻击配置见第3节。本文采用FGSM(《Explaining and harnessing adversarial examples》)进行对抗扰动优化。我们的代码是开源的。

本文的组织结构如下。第二节介绍了实验中采用的ASV系统。对抗攻击配置和FGSM优化算法在第3节中进行了说明。第4节和第5节分别描述了实验设置和结果。最后,第6节对本文进行了总结。

2 自动说话人验证系统

实验工作包括GMM的i-vector系统和x-vector系统。两种系统均由两部分组成:前端用于语音级说话人嵌入提取,后端用于说话人相似度评分。所有实验均采用概率线性判别分析(PLDA)后端。

2.1 高斯混合模型 i-vector提取

GMM i-vector提取器(《Front-end factor analysis for speaker verification》)的示意图如图1所示。它由高斯混合模型-通用背景模型(GMM-UBM)和总变率矩阵( T T T矩阵)组成。考虑到语音 i i i的声学特征,利用GMM-UBM通过Baum-Welch统计量计算提取零阶( N i N_i Ni)和一阶( f ~ i \tilde{f}_i f~i)统计量。将统计信息与 T T T矩阵结合,提取i-vector ω i ωi ωi,如公式1所示:

ω i = L i − 1 T ⊤ ( Σ ( b ) ) − 1 f ~ i (1) \omega_i = L_i^{-1}T^{\top}(Σ^{(b)})^{-1}\tilde{f}_i \tag{1} ωi=Li−1T⊤(Σ(b))−1f~i(1) 式中, L i = I + T ⊤ ( Σ ( b ) ) − 1 N i T L_i = I + T^{\top}(Σ^{(b)})^{-1}N_iT Li=I+T⊤(Σ(b))−1NiT, I I I是单位矩阵, Σ ( b ) Σ^{(b)} Σ(b)是GMM-UBM的协方差矩阵。

2.2 x-vector提取

x-vector提取器(《X-vectors: Robust DNN embeddings for speaker recognition》)利用DNN产生说话人区分嵌入。它由框架级和语句级提取器组成。在帧级,声学特征由几层时延神经网络(TDNN)前馈。在语音层,统计池化层对最后一帧层的输出进行汇总,并计算其均值和标准差。将平均值和标准差串联在一起,通过语音级层和softmax输出层进行传播。在测试阶段,给定语音的声学特征,提取嵌入层输出作为x-vector。

2.3 后端概率线性判别分析

PLDA是一个监督版本的因子分析(《Introduction to factor analysis》)。它通过公式2模型i-vector/x-vector( ω ω ω)

ω = m + Φ β + ϵ r (2) \omega = m+\Phi \beta+\epsilon_r \tag{2} ω=m+Φβ+ϵr(2) 其中 m m m是全局偏置项, Φ \Phi Φ的列提供了特定于说话人子空间的基础, β ∈ N ( 0 , I ) \beta \in N(0, I) β∈N(0,I)是潜在的说话人身份向量。残差项 ϵ r ∈ N ( 0 , Σ ) \epsilon_r \in N(0, Σ) ϵr∈N(0,Σ)具有均值为零的高斯分布和全协方差矩阵 Σ Σ Σ。模型参数 { m , Φ , Σ } \{m, Φ, Σ\} {m,Φ,Σ}在训练集上用期望最大化(EM)算法估计。

在测试阶段,分数 S S S被估计为两个条件概率的对数似然比(公式3)。 ω 1 ω_1 ω1和 ω 2 ω_2 ω2分别是从登记和测试语音中提取的i-vector/x-vector。 H s \mathcal{H}_s Hs是两句话属于同一身份的假设, H d \mathcal{H}_d Hd是相反的假设。

S = l o g P ( ω 1 , ω 2 ∣ H s ) P ( ω 1 , ω 2 ∣ H d ) = l o g P ( ω 1 , ω 2 ∣ H s ) P ( ω 1 ∣ H d ) P ( ω 2 ∣ H d ) (3) \begin{aligned} S &=log \frac {P(ω_1,ω_2|\mathcal{H}_s)} {P(ω_1,ω_2|\mathcal{H}_d)} \\ &=log \frac {P(ω_1,ω_2|\mathcal{H}_s)} {P(ω_1|\mathcal{H}_d)P(ω_2|\mathcal{H}_d)} \\ \tag{3} \end{aligned} S=logP(ω1,ω2∣Hd)P(ω1,ω2∣Hs)=logP(ω1∣Hd)P(ω2∣Hd)P(ω1,ω2∣Hs)(3)

3 对抗样本生成

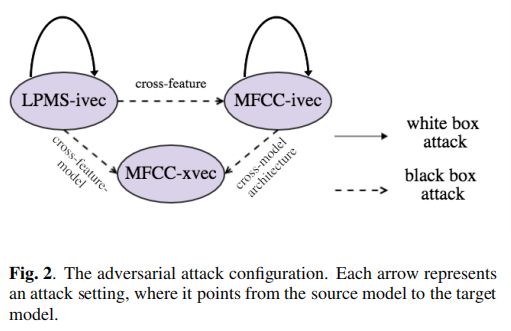

在本研究中,我们从跨特征、跨模型架构和跨特征-模型设置等方面研究了ASV系统在对抗攻击下的脆弱性,包括白盒攻击和黑盒攻击。实验建立了三种ASV模型:基于Mel-frequency倒谱系数(MFCC)的GMM i-vector系统(MFCC-ivec)、基于对数功率幅谱(LPMS)的GMM i-vector系统(LPMS-ivec)和基于MFCC的x-vector系统(MFCC-xvec)。白盒攻击和黑盒互攻设置如图2所示。分别对MFCC-ivec和LPMS-ivec系统进行了两次白盒攻击。三种黑盒攻击设置分别为:LPMS-ivec攻击MFCC-ivec (交叉特征)、MFCC-ivec攻击MFCC-xvec (交叉模型)、LPMS-ivec攻击MFCC-xvec (交叉特征模型)。最后两种设置是研究从GMM i-vector系统到x-vector系统制作的对抗样本的可迁移性。

为了执行上述攻击,对抗样本需要从源模型(即本例中的LPMS-ivec和MFCC-ivec)中精心制作。在这项工作中,我们在声学特征水平,即MFCC或LPMS,生成对抗样本。在交叉特征和交叉特征模型设置的黑盒攻击中,首先将生成的对抗特征(LPMS)倒推回音频,然后从音频中提取目标模型中采用的声学特征进行攻击。在其他情况下,对抗特征可以直接用于攻击。

3.1 快速梯度符号法

在一般情况下,我们将系统函数表示为 f f f,参数是 θ θ θ。给定原始输入 x x x,我们寻找一个对抗扰动 δ x δ_x δx加入 x x x,以产生对抗样本 x ⋆ = x + δ x x^\star= x + δ_x x⋆=x+δx。这种对抗扰动 δ x δ_x δx是通过最大化系统在给定对抗输入 x ⋆ x^\star x⋆和真实值 y y y,如公式4所示:

δ x = a r g m a x ∣ ∣ δ x ∣ ∣ p ≤ ϵ L ( f θ ( x + δ x ) , y ) (4) \delta_x=arg \underset {||\delta_x||_p \le \epsilon} {max} L(f_\theta(x+\delta_x),y) \tag{4} δx=arg∣∣δx∣∣p≤ϵmaxL(fθ(x+δx),y)(4) 偏差由系统预测与真实值之间的损失函数 L L L来度量,通常用于分类任务的交叉熵,或用于回归任务的均方误差。 δ x δ_x δx的 p p p-范数约束保证人类无法区分对抗样本 x ⋆ x^\star x⋆来自原 x x x,上限 ϵ \epsilon ϵ表示扰动程度。需要注意的是,在优化过程中,系统参数 θ θ θ总是固定的,这意味着对抗攻击者只修改输入来攻击系统,而不修改系统参数。

本文采用快速梯度符号法(FGSM)(《Explaining and harnessing adversarial examples》)求解公式4中的优化问题。它将原始输入 x x x向损失函数 L L L求导 x x x的梯度方向扰动,以产生对抗样本。具体地说,具体地说,它专门将公式4中的规范 p p p表示为 ∞ \infty ∞,并给出方程5的解:

δ x = ϵ × s i g n ( ∇ x L ( f θ ( x ) , y ) ) (5) \delta_x=\epsilon \times sign(\nabla_x L(f_\theta(x),y)) \tag{5} δx=ϵ×sign(∇xL(fθ(x),y))(5) 其中函数符号 ( ⋅ ) (·) (⋅)取梯度的符号, ϵ \epsilon ϵ表示扰动程度。

3.2 问题界定

对抗样本由GMM i-vector系统(LPMS-ivec和MFCC-ivec系统)生成。为了将其转化为一个优化问题,我们用两个函数表示GMM的i-vector系统:参数为 θ 1 θ_1 θ1的i-vector提取器f和参数为 θ 2 θ_2 θ2的PLDA评分函数 S S S。规范化步骤,如i-vector规范化,隐式包含在函数中。

每句话的声学特征 i i i表示为矩阵 X i X_i Xi,其中每一列表示每一帧的声学特征,横轴表示时间序列。考虑两句话的声学特性 X i X_i Xi和 X j X_j Xj,推导出对应的i-vector,分别为 ω i = f θ 1 ( X i ) ω_i = f_{θ_1} (X_i) ωi=fθ1(Xi)和 ω j = f θ 1 ( X j ) ω_j = f_{θ_1} (X_j) ωj=fθ1(Xj)。基于这两个i-vector的最终相似度评分(实验中采用的PLDA评分)为 S θ 2 ( f θ 1 ( X i ) , f θ 1 ( X j ) ) S_{θ_2}(f_{θ_1}(X_i), f_{θ_1}(X_j)) Sθ2(fθ1(Xi),fθ1(Xj))。

在ASV测试阶段,每个测试试验由一个注册语音 X i X_i Xi和一个测试语音 X j X_j Xj组成。根据说话人在这两段语音中的身份,可以分为两种试验:目标试验和非目标试验。在目标试验中,注册和测试语音中的说话人身份属于一个人。在非目标试验中,身份属于两个不同的人。为了模拟一个真实的模型攻击,我们保持登记特征 X i X_i Xi和系统参数 { θ 1 , θ 2 } \{θ_1,θ_2\} {θ1,θ2}固定,并修改测试特征 X j X_j Xj以产生对抗样本。对于目标试验,我们搜索扰动 δ X δ_X δX添加到 X j X_j Xj中以最小化相似度得分。对于非目标试验,我们搜索扰动以使分数最大化。这可能会导致ASV系统在目标和非目标试验中做出错误的决定。优化问题公式如式6所示,FGSM给出的解如式7和式8所示。

δ X = a r g m a x ∣ ∣ δ X ∣ ∣ p ≤ ϵ k × S θ 2 ( f θ 1 ( X i ) , f θ 1 ( X j + δ X ) ) (6) \delta_X=arg \underset {||\delta_X||_p \le \epsilon} {max} k \times S_{θ_2}(f_{θ_1}(X_i), f_{θ_1}(X_j+\delta_X)) \tag{6} δX=arg∣∣δX∣∣p≤ϵmaxk×Sθ2(fθ1(Xi),fθ1(Xj+δX))(6) δ X = ϵ × k × s i g n ( ∇ X j S θ 2 ( f θ 1 ( X i ) , f θ 1 ( X j ) ) ) (7) \delta_X=\epsilon \times k \times sign(\nabla_{X_j}S_{θ_2}(f_{θ_1}(X_i), f_{θ_1}(X_j))) \tag{7} δX=ϵ×k×sign(∇XjSθ2(fθ1(Xi),fθ1(Xj)))(7) k = { − 1 , target trial 1 , non-target trial (8) k= \begin{cases} -1, & \text{target trial} \\ 1, & \text{non-target trial} \\ \end{cases} \tag{8} k={−1,1,target trialnon-target trial(8)

4 实验设置

本实验使用的数据集是Voxceleb1(《Voxceleb: a large-scale speaker identification dataset》),它由人类语言的短片段组成。共有1251人说148,642种话语。与《Voxceleb: a large-scale speaker identification dataset》一致,40个说话者的4874句话被保留用于测试,以产生试验和进行对抗性攻击。剩下的语料数据用于训练我们的SV模型。此外,我们在训练x-vector嵌入网络时使用了数据增强(《X-vectors: Robust DNN embeddings for speaker recognition》)。

本实验采用Mel-frequency倒谱系数(MFCCs)和对数功率幅谱(LPMSs)作为声学特征。在提取mfcc时,采用了系数为 0.97 0.97 0.97的预强调法。利用大小为25ms、步长为10ms的"Hamming"提取一帧,最后保留24个倒谱系数。对于LPMSs,采用大小为8ms、步长为4ms的"blackman"窗口。没有应用预强调。

4.1 ASV模式配置

在GMM i-vector系统设置中,只使用了语音活动检测(VAD)对声学特征进行预处理。具有全协方差矩阵的2048混合UBM与具有400维i-vector向量空间的 T T T矩阵协同工作。在PLDA建模之前,对i-vector进行居中和长度归一化。

在x-vector系统中,采用倒谱均值方差归一化(CMVN)和VAD对声学特征进行预处理。i-vector嵌入网络的设置一般与《X-vectors: Robust DNN embeddings for speaker recognition》一致。提取的i-vector使用200维LDA居中并投影,然后在PLDA建模之前对长度进行归一化。

4.2 评价指标

ASV系统的评价指标可以是错误拒绝率(FRR)、错误接受率(FAR)和等错误率(EER)。FRR和FAR分别度量目标试验和非目标试验的分类误差,EER是两种误差率相等的平衡度量。由于实际攻击情况大多与非目标试验相似,因此我们更关心对抗攻击后系统FAR的增加。实际上在目标试验中,除了对抗干扰外,在输入中加入简单的随机噪声也会导致系统无法识别所有者的声音,因此FRR的增加并不能很好地反映ASV系统对对抗攻击的脆弱性。基于以上考虑,我们通过FAR和EER的增加来衡量系统对对抗攻击的脆弱性。

4.3 ABX测试

为了评估对抗音频与原始音频的听觉难以区分性,我们进行了ABX测试(《Standardizing auditory tests》),这是一种强制选择测试,用于识别两种感官刺激选择之间的可检测差异。对抗样本由LPMS-ivec使用 ϵ = 1 \epsilon= 1 ϵ=1的FGSM生成。每个对抗音频都是由扰动的LPMS和相应的原始音频的相位重建。在这个工作中,随机选择50组原始-对抗音频对(A和B)对呈现给听众,从每对中选择一个音频作为音频 X X X。8名听众参加了这个测试,他们被要求从A和B中选择一个音频作为音频 X X X。

5 实验结果

5.1 ABX测试结果

实验结果表明,ABX测试的平均准确率为 51.5 % 51.5\% 51.5%,验证了人类无法区分对抗和对应的原始音频。

5.2 白盒攻击

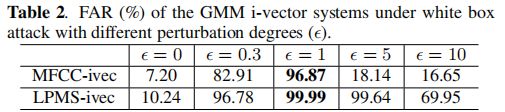

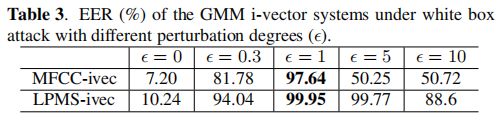

我们对MFCC-ivec和LPMS-ivec系统进行白盒攻击。两个系统在不同摄动程度 ϵ \epsilon ϵ下的FAR如表2所示。具体来说, ϵ = 0 \epsilon=0 ϵ=0的列展示了没有攻击的系统性能。可以观察到,当 ϵ = 1 \epsilon=1 ϵ=1时,两种系统的FARs都显著增加了约 90 % 90\% 90%,而人类仍然无法区分对抗样本和原始样本之间的区别。两种系统的EER性能也可以观察到类似的结果,如表3所示。这证明了GMM i-vector系统容易受到白盒攻击。此外,从表2和表3中 ϵ = 5 , 10 \epsilon=5,10 ϵ=5,10的列中,我们还观察到,持续增加 ϵ \epsilon ϵ超过某个值会降低攻击效率。一种可能的解释是,不断增加的 ϵ \epsilon ϵ使每个扰动超越对抗有效性,而仅仅成为噪音。在非目标试验中,噪声不能降低ASV系统的性能,因此FARs开始下降。但在目标试验中,噪声仍然会降低ASV系统的性能,因此平衡度量EER趋于收敛于 50 % 50\% 50%左右。在黑盒攻击的实验结果中也观察到了这种现象。

5.3 黑盒攻击

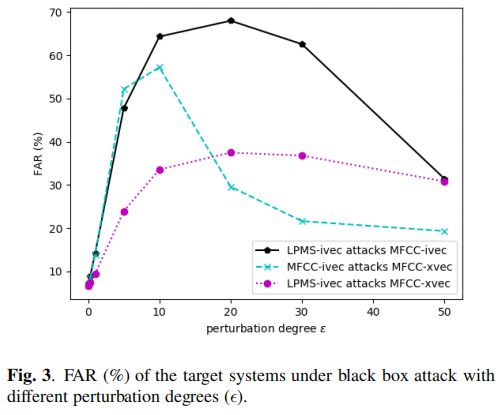

根据第3节的配置,涉及三种黑盒攻击设置,分别是LPMS-ivec攻击MFCC-ivec(跨特征)、MFCC-ivec攻击MFCC-xvec(跨模型架构)和LPMS-ivec攻击MFCC-xvec(跨特征-模型)。这些攻击设置下的FAR波动如图3所示。可以观察到,在所有三种攻击设置中FAR都显著增加。具体来说,在跨功能、跨模型架构和跨功能-模型设置方面,FAR的增幅最大,分别约为 60 % 60\% 60%、 50 % 50\% 50%和 30 % 30\% 30%。最有效的攻击出现在交叉特征设置中,而最不有效的攻击出现在交叉特征模型设置中。这表明,黑盒攻击的有效性可能会受到源和目标系统设置之间的差距的影响。FAR的降低证实了GMM的i-vector和x-vector系统都容易受到黑盒攻击。具体来说,从i-vector系统制作的对抗样本可以转移到x-vector系统。在EER性能中可以观察到类似的结果,如表1所示。x-vector系统易受黑盒攻击的现象,也说明其易受更严重的攻击,即白盒攻击。

此外,我们还发现较大的 ϵ \epsilon ϵ值仍然能够产生有效的攻击,例如跨特征设置中的 20 20 20。在这种情况下,人们可以在欺骗音频中感知到小噪音,但仍然确认说话者身份在原始音频和相应的欺骗音频之间没有变化。

6 结论

在这项工作中,我们研究了GMM的i-vector系统对对抗攻击的脆弱性和从i-vector系统到x-vector系统的对抗迁移性。实验结果表明,GMM i-vector系统易受黑盒和白盒攻击。生成的对抗样本也被证明可以迁移到基于神经网络说话人嵌入的系统,如x-vector系统。进一步的工作将集中在保护ASV系统免受这种对抗性攻击,例如,涉及对抗训练策略来开发ASV系统。

Li X, Zhong J, Wu X, et al. Adversarial attacks on GMM i-vector based speaker verification systems[C]//ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2020: 6579-6583.