- Python 列表

列表是由一系列按特定顺序排列的元素组成。在python中用方括号([])来表示列表并用逗号来分隔其中的元素。例如:bicycles=['trek','cannondale','redline']。访问列表元素时,只需将该元素的索引值或位置告诉Python即可。(索引值由0开始)>>>names=['zhao','qian','sun','li']>>>print(names[0])zhao创建的大

- 《都市不俗人》:之460 各有各法,各马各扎,实践才能出真知;各师各教,各施各技,实际方能得正果

古韵撷趣

上篇说到,曾明来到来凤村山庄建设工地,和承建者曹思汉在工棚里,又做了一次深入的沟通,双方均表现了十足的诚意,和对未来合作的信心。曹思汉听完曾明的简单畅述后,很高兴地说:曾先生,感谢你和赵先生的认可。能认识你们,能承建刘(长河)夏(天青)二老设计的建筑,我曹思汉和我曹家村这般兄弟,何其幸运啊!曾明谦虚地说:我和我兄弟算不的什么,但二老退休后,心有所属,早就不问“世事”,一心只设计自己心仪的建筑,这都

- 假期的变化

杨小芹

假期,实在是一个很美好的字眼。上班之初,看到假期二字,脑海中不禁浮现出:蔚蓝的天空,金黄的沙滩上,插着一把太阳伞,游人躺在沙滩椅上,吹着海风,喝着饮料,好不惬意。这是我想象中的假期,我的假期生活与之相差十万八千里,丝毫不影响我对假期的热爱。放假,我基本上啥也不干,帮二姐姐(二姐家种大棚,一年到头没有闲着的时候)带带孩子,给二姐家帮忙,是假期的主旋律。后来自己有了孩子,就陪着自己的孩子玩耍。基本上不

- 为什么中药能治病?核心原理是什么?

4bf825984a00

一、为什么中药能治病?中医用来治病的药物是中药,而中药大多取自于天然的植物、动物、矿物,其中尤以植物为多,所以在古代,中药也被称为“本草”。相传,中药的发现和运用,都来自起源于神农氏,自古民间有“神农尝百草”的传说。为什么草根树皮能够治疗人的疾病,中药能治病到底是什么原因呢?人得天地之全性,草木得天地之偏性。中医认为,人和万物都得天地一气而生,但人得天地之全性,草木得天地之偏性,人得病就是人体气机

- Linux设备驱动之SPI驱动

关于电机的一切

linux驱动开发arm开发

Linux下SPI驱动分成两部分:主机驱动和设备驱动。主机驱动:主机侧SPI控制器使用structspi_master描述,该结构体中包含了SPI控制器的序号(很多SoC中存在多个SPI控制器),片选数量,SPI信息传输的速率,配置SPI模式的函数指针(4种模式),实现数据传输的函数指针。structspi_master{structdevicedev;structlist_headlist;s1

- 从比特币到DeFi:区块链如何重塑未来社会

L星际节点指挥官

区块链开发dapp公链开发区块链分布式账本零知识证明智能合约web3共识算法

引言:数字时代的信任之问在信息爆炸的数字时代,信任成为稀缺资源。从网络诈骗到数据泄露,从虚假新闻到平台垄断,传统中心化系统的脆弱性暴露无遗。当人们为支付安全焦虑、为隐私泄露愤怒、为信息真实性迷茫时,一种名为“区块链”的技术悄然崛起。它以去中心化的结构、不可篡改的账本和智能合约的自动执行,重新定义了信任的规则。区块链不仅是技术革命,更是对人类社会协作模式的深度重构。一、区块链的创世密码1.应运而生的

- Spring Cloud LoadBalancer 详解

大手你不懂

springJavaJava项目实战springcloudspring后端

在分布式系统快速发展的当下,服务间的调用日益频繁且复杂。如何合理分配请求流量,避免单个服务节点过载,保障系统的稳定性与高效性,成为关键问题。负载均衡技术便是解决这一问题的重要手段。SpringCloudLoadBalancer作为SpringCloud官方推出的负载均衡器,在微服务架构中发挥着至关重要的作用。本文将对其进行详细解析。一、SpringCloudLoadBalancer基本概念Spri

- 2023-03-21

我_4b6f

保定影像之街道(一一四三)2019年1月25日,星期五。农历戊戌年乙丑月壬戌日(狗年)十二月(腊月)二十。河北省保定市:阳光大街。保定市,古称清苑、上谷、保州、保府。因城池似靴,又称靴城。保定与北京相伴而生,保定之名取自“保卫大都、安定天下”之意。阳光大街,南北街道。原名韩村路,因韩村而得名。2003年5月21日,国务院办公厅批准修订后的《保定市城市总体规划(2001至2020年)》,规范道路命名

- 《论语》为政篇之2.3[刑与德]14

蜻蜓之旅

【原文】子曰:“道之以政,齐之以刑,民免而无耻。道之以德,齐之以礼,有耻且格。”【白话】孔子说:“以政令来教导,以刑罚来管束,百姓免于罪过但是不知道羞耻。以德行来教化,以礼制来约束,百姓知道羞耻,还能走上正途。”对百姓进行教育和规范。第一是德与礼,第二是政与刑。德与礼“道之以德”,用德行来引导,百姓看到上位者有德行,自然就跟着走。古代讲德,代表为政者照顾百姓,百姓都喜欢政治领袖有德行。因为这对百姓

- Spring Boot、Spring MVC 和 Spring 有什么区别

spring是⼀个IOC容器,⽤来管理Bean,使⽤依赖注⼊实现控制反转,可以很⽅便的整合各种框架,提供AOP机制弥补OOP的代码重复问题、更⽅便将不同类不同⽅法中的共同处理抽取成切⾯、⾃动注⼊给⽅法执⾏,⽐如⽇志、异常等springmvc是spring对web框架的⼀个解决⽅案,提供了⼀个总的前端控制器Servlet,⽤来接收请求,然后定义了⼀套路由策略(url到handle的映射)及适配执⾏h

- View的加载过程

window加载视图的过程activity的启动过程:App1进程startActivity->AMSstartActivity->AMSsocketzyogte孵化app2进程->app2进程触发activityThreadmain函数->handlerThread,looper,context,contentProviders,Application准备好->launcherActivity在

- 重生之将门毒后|谢景行

89b491201ff0

高山仰止,景行行止。谢景行之于沈妙,到底是怎么样的存在呢?救赎?我觉得有些像。两世情缘,谢景行一直都是运筹帷幄的,唯独看不透沈妙,可谢景行最让我心动之处,也就在于他明知沈妙不一般,却从不深究,给她足够的自由空间,放任他的沈娇娇做自己想做的事,而谢景行则为她铺路,在背后收拾摊子,从不邀功。颠个皇权罢了,你想要,都归你。谢景行有些霸道,却丝毫不油腻,在沈妙面前永远是个少年,意气风发,带着些挑衅意味。十

- postgresql之语法解析 浅析

happytree001

pgpostgresql

一、pg语法简介1.1语法文件结构语法.y文件和词法.l文件结构差不多,也是通过%%分成了三个部分:声明部分、语法规则部分、C代码部分。src/backend/parser/gram.y####声明部分%{C代码头文件,变量声明等(此范围内的内容原样输出到文件中)#include"postgres.h"...%}#变量声明%union{core_YYSTYPEcore_yystype;/*thes

- 2023-05-06

仁德上人

心中没有我我我,换来的就是清净自在安详文/仁德上人真正明心见性的菩萨,在平常生活之中会落实做到,没有事情,不会随便的找事;事情真的要来了,也不会怕事。找事与怕事都是自己心中的我我我在作怪,心中没有了我我我,没有事正好享受安详清净自在,如果该来的事情,就让事情来吧,正好利用事情来磨练自己,考验自己的内心是不是还把事情当事情,是不是为了虚幻的事再产生自我的爱憎取舍之妄心。自心不动我我我的妄心,没有谁能

- RxJava 全解析:从原理到 Android 实战

Monkey-旭

javarxjava响应式编程android

在Android开发中,异步任务处理是绕不开的核心场景——网络请求、数据库操作、文件读写等都需要在后台执行,而结果需回调到主线程更新UI。传统的“Handler+Thread”或AsyncTask不仅代码冗余,还容易陷入“回调地狱”(嵌套回调导致代码可读性差)。RxJava作为一款基于响应式编程思想的异步框架,通过“链式调用”和“操作符”完美解决了这些问题,成为Android开发者的必备工具。本文

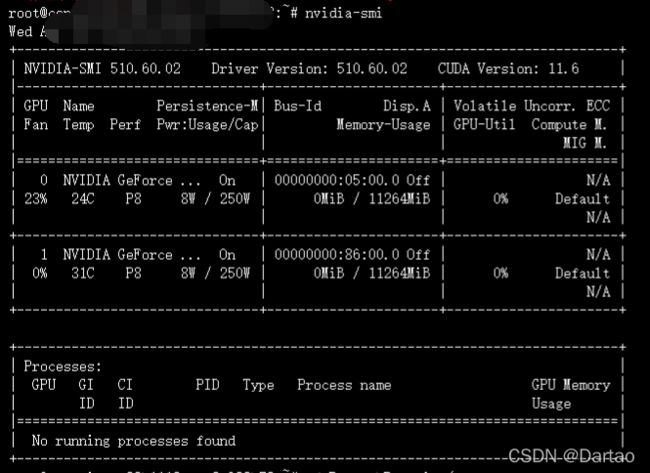

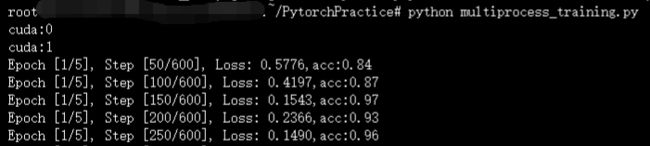

- 深度学习系列----->环境搭建(Ubuntu)

二师兄用飘柔

深度学习历程深度学习ubuntu人工智能pytorchpython

1、前言电脑基础系统硬件情况:系统:ubuntu18.04、显卡:GTX1050Ti;后续的环境搭建都在此基础上进行。此次学习选择Pytorch作为深度学习的框架,选择的原因主要由于PyTorch在研究领域特别受欢迎,较多的论文框架也是基于其开发。2、anaconda+python3安装测试在学习深度学习的过程中会涉及到使用不同版本python包的问题,而anaconda可以便捷获取包且对包能够进

- MySQL分布式架构深度实践:从分库分表到云原生集成

软考和人工智能学堂

PHP和MySQLMySQL经验与技巧wpf

1.分布式MySQL架构全景graphTDA[分布式MySQL体系]-->B[数据分片策略]A-->C[分布式事务处理]A-->D[读写分离扩展]A-->E[高可用架构]A-->F[云原生集成]B-->B1(水平分库分表)B-->B2(垂直分库分表)B-->B3(分片路由策略)B-->B4(全局ID方案)C-->C1(XA协议)C-->C2(TCC模式)C-->C3(SAGA模式)C-->C4(本

- 远程连接之ssh的使用(日志监控)

小朱撕码迹

ssh远程连接linuxubuntuwindows

ssh的简介ssh服务【SecureShell】:SSH为建立在应用层基础上的安全协议。SSH是较可靠,专为远程登录提供服务。解决的问题:对服务器的远程控制,远程操作。ssh服务是安全的、加密、基于S/C(服务端/客户端)的远程连接服务【运行的sshd进程会监听22号端口,提供远程登录的服务,服务的内容:远程操作服务器】OpenSSH是使用SSH协议远程登录的首选连接工具。它对所有流量进行加密,以

- 小豆芽芽吖流水日记 Day24

小豆芽芽吖

肚子饿了~哈哈哈哈哈,室友在讨论吃的,可真的是搞得肚子都饿了!晚上不宜讨论吃的,真的好想吃,但是难受的漱口了,不想再跑那么远漱口了。还有很多作业没写,一周的开始意味着作业的开始了~好多DDL等着自己去完成,现在主要的是自己的详情页做完,然而现在都已经十一点了我还是没有头绪~难死我了。

- 尚玩助手开通升级团长怎么做?升级团长收益更高吗?有何规则门槛

星火执行官

尚玩助手团长招募如何参与?揭秘其背后的优势与开通条件!今年的广告赚钱项目中,尚玩助手无疑是一颗璀璨的明星。其稳定的运营和丰厚的静态收益,赢得了众多用户的喜爱。若你拥有一定的人脉资源,成为尚玩助手的团长将是明智之选。团长的身份不仅能让你的收益水涨船高,更是对你能力的肯定。快来了解团长招募的具体条件和好处,开启你的日进斗金之旅吧!一、尚玩助手APP下载:我们先扫码下载尚玩助手,这边开通团长后续会有政策

- open-falcon的agent部署

chinasl008

运维代码部署二开运维开发

open-falcon的agent部署agent用于采集机器负载监控指标,比如cpu.idle、load.1min、disk.io.util等等,每隔60秒push给Transfer。agent与Transfer建立了长连接,数据发送速度比较快,agent提供了一个http接口/v1/push用于接收用户手工push的一些数据,然后通过长连接迅速转发给Transfer。——————————————

- 分布式之agent

daisylym

人工智能integerclassstringnullimportaction

Agent的简单运用,实现卖旗子代理。这个代码实现的要求如下,这个做了很久了,突然想到,才整理出来贴出来。没法翻译,将就着看吧,看英文多了,其实觉得还不错啦。Thereisabuyerwhowantstobuyaspecificflagfromoneortwoselleragentswhoaretryingtoofferthebest(lowest)price.Youaretomodelthiss

- 先贤格言 | 事亲奉祀,岂可使人为之?

知创快讯

事亲奉祀,岂可使人为之?——(北宋)张载【通俗释义】横渠先生张载说,照顾自己的父母、祭祀自己的祖先必当亲力亲为,岂能让别人来代替?父母和宗族,是中国人根系所在。老人总是教后辈要敬重中华传统,恪守华夏礼仪,心中若没有祖宗父母,心灵则无处依存,必然造成道德虚无、道德崩溃,那就不是礼仪之邦,而是蛮夷了。图片发自App

- 深度学习-常用环境配置

瑶山

AIlinux人工智能windowsCUDAPyTorch

目录Miniconda安装安装NVIDIA显卡驱动安装CUDA和cnDNNCUDAcuDNNPyTorch安装手动下载测试Miniconda安装最新版Miniconda搭建Python环境_miniconda创建python虚拟环境-CSDN博客安装NVIDIA显卡驱动直接进NVIDIA官网:NVIDIAGeForce驱动程序-N卡驱动|NVIDIA在这里有GeForce驱动程序,立即下载,这是下

- 读《愚公移山》的新思考

吉林袁守君

图片发自App晨读《列子·汤问》,再品春秋战国时大作家列御寇先生的传世之作《愚公移山》,忽而闪出几条反向观点,聊算是一孔之见吧。这则寓言故事是讲,太行、王屋两座大山原先是在冀州之南、河阳之北,有个叫愚公的九十多岁老头儿领着一家子人住在山北面,深感出入不方便,于是决定挖掉这两座山,使自家可以直通豫南,达到汉阴。一家子说干就干,邻居一个寡妇的小儿子也来帮忙,他们用锄头刨土,用土筐将土运到很远的渤海边,

- C#实现24种数据校验算法的综合指南及工具包.zip

语嫣凝冰

本文还有配套的精品资源,点击获取简介:在数据通信和网络编程中,数据的完整性和准确性是至关重要的。C#作为一种流行的开发语言,提供了强大的工具来实现各类数据校验算法。本压缩包包含了一个名为“WindowsFormsApp”的C#应用程序,用于展示和实验24种数据校验方法,涵盖从简单到复杂的各种算法。这包括CRC校验、MD5、SHA系列、Adler32、Checksum、ParityBit、LRC、H

- 2023-11-08

实权_1376

不要的东西,再好也是垃圾。心很贵,一定要装最美的东西情绪很贵,一定要接触让你愉快的人。金钱就像水一样,缺水,渴死;贪多,淹死。真话有刺,实话有毒,懒得计较了,要么理解,要么远离。人生就像蒲公英看似自由却身不由己。性格是不治之症,我还是喜欢我自己。香烟到头终是灰,故事到头终是悲以前喜欢一个人,现在喜欢一个人微信,微信,只可微信,不可全信。明知不可为而为之,是我最大的诚意!随薪锁欲,问薪吾愧,相由薪生

- 诸葛亮《将苑》卷1诗解3将弊将志将善将刚骄吝众叛五强八恶

琴诗书画

诸葛亮《将苑》卷1诗解3将弊将志将善将刚骄吝众叛五强八恶题文诗:为将之道,有八弊焉,贪而无厌,妒贤嫉能,信谗好佞,四曰料彼,而不自料,五曰犹豫,而不自决,六曰荒淫,于酒色也,七曰奸诈,而自怯也,八曰狡言,而不以礼.兵者凶器,将者危任,器刚则缺,任重则危.善将者不,恃强怙势,宠之不喜,辱之不惧,见利不贪,见美不淫,以身殉国,壹意而已.为将也有,五善四欲:五善也者,所谓善知,敌之形势,进退之道,国之虚

- python分布式事务_分布式事务系列(2.1)分布式事务的概念

#1系列目录#2X/OpenDTPDTP全称是DistributedTransactionProcess,即分布式事务模型。之前我们接触的事务都是针对单个数据库的操作,如果涉及多个数据库的操作,还想保证原子性,这就需要使用分布式事务了。而X/OpenDTP就是一种分布式事务处理模型。##2.1X/OpenDTP模型X/Open是一个组织,维基百科上这样说明:X/Open是1984年由多个公司联合创

- 深入理解TransmittableThreadLocal:原理、使用与避坑指南

智慧源点

后端java开发语言

一、ThreadLocal与InheritableThreadLocal回顾在介绍TransmittableThreadLocal之前,我们先回顾一下Java中的ThreadLocal和InheritableThreadLocal。1.ThreadLocalThreadLocal提供了线程局部变量,每个线程都可以通过get/set访问自己独立的变量副本。ThreadLocalthreadLocal

- Spring4.1新特性——Spring MVC增强

jinnianshilongnian

spring 4.1

目录

Spring4.1新特性——综述

Spring4.1新特性——Spring核心部分及其他

Spring4.1新特性——Spring缓存框架增强

Spring4.1新特性——异步调用和事件机制的异常处理

Spring4.1新特性——数据库集成测试脚本初始化

Spring4.1新特性——Spring MVC增强

Spring4.1新特性——页面自动化测试框架Spring MVC T

- mysql 性能查询优化

annan211

javasql优化mysql应用服务器

1 时间到底花在哪了?

mysql在执行查询的时候需要执行一系列的子任务,这些子任务包含了整个查询周期最重要的阶段,这其中包含了大量为了

检索数据列到存储引擎的调用以及调用后的数据处理,包括排序、分组等。在完成这些任务的时候,查询需要在不同的地方

花费时间,包括网络、cpu计算、生成统计信息和执行计划、锁等待等。尤其是向底层存储引擎检索数据的调用操作。这些调用需要在内存操

- windows系统配置

cherishLC

windows

删除Hiberfil.sys :使用命令powercfg -h off 关闭休眠功能即可:

http://jingyan.baidu.com/article/f3ad7d0fc0992e09c2345b51.html

类似的还有pagefile.sys

msconfig 配置启动项

shutdown 定时关机

ipconfig 查看网络配置

ipconfig /flushdns

- 人体的排毒时间

Array_06

工作

========================

|| 人体的排毒时间是什么时候?||

========================

转载于:

http://zhidao.baidu.com/link?url=ibaGlicVslAQhVdWWVevU4TMjhiKaNBWCpZ1NS6igCQ78EkNJZFsEjCjl3T5EdXU9SaPg04bh8MbY1bR

- ZooKeeper

cugfy

zookeeper

Zookeeper是一个高性能,分布式的,开源分布式应用协调服务。它提供了简单原始的功能,分布式应用可以基于它实现更高级的服务,比如同步, 配置管理,集群管理,名空间。它被设计为易于编程,使用文件系统目录树作为数据模型。服务端跑在java上,提供java和C的客户端API。 Zookeeper是Google的Chubby一个开源的实现,是高有效和可靠的协同工作系统,Zookeeper能够用来lea

- 网络爬虫的乱码处理

随意而生

爬虫网络

下边简单总结下关于网络爬虫的乱码处理。注意,这里不仅是中文乱码,还包括一些如日文、韩文 、俄文、藏文之类的乱码处理,因为他们的解决方式 是一致的,故在此统一说明。 网络爬虫,有两种选择,一是选择nutch、hetriex,二是自写爬虫,两者在处理乱码时,原理是一致的,但前者处理乱码时,要看懂源码后进行修改才可以,所以要废劲一些;而后者更自由方便,可以在编码处理

- Xcode常用快捷键

张亚雄

xcode

一、总结的常用命令:

隐藏xcode command+h

退出xcode command+q

关闭窗口 command+w

关闭所有窗口 command+option+w

关闭当前

- mongoDB索引操作

adminjun

mongodb索引

一、索引基础: MongoDB的索引几乎与传统的关系型数据库一模一样,这其中也包括一些基本的优化技巧。下面是创建索引的命令: > db.test.ensureIndex({"username":1}) 可以通过下面的名称查看索引是否已经成功建立: &nbs

- 成都软件园实习那些话

aijuans

成都 软件园 实习

无聊之中,翻了一下日志,发现上一篇经历是很久以前的事了,悔过~~

断断续续离开了学校快一年了,习惯了那里一天天的幼稚、成长的环境,到这里有点与世隔绝的感觉。不过还好,那是刚到这里时的想法,现在感觉在这挺好,不管怎么样,最要感谢的还是老师能给这么好的一次催化成长的机会,在这里确实看到了好多好多能想到或想不到的东西。

都说在外面和学校相比最明显的差距就是与人相处比较困难,因为在外面每个人都

- Linux下FTP服务器安装及配置

ayaoxinchao

linuxFTP服务器vsftp

检测是否安装了FTP

[root@localhost ~]# rpm -q vsftpd

如果未安装:package vsftpd is not installed 安装了则显示:vsftpd-2.0.5-28.el5累死的版本信息

安装FTP

运行yum install vsftpd命令,如[root@localhost ~]# yum install vsf

- 使用mongo-java-driver获取文档id和查找文档

BigBird2012

driver

注:本文所有代码都使用的mongo-java-driver实现。

在MongoDB中,一个集合(collection)在概念上就类似我们SQL数据库中的表(Table),这个集合包含了一系列文档(document)。一个DBObject对象表示我们想添加到集合(collection)中的一个文档(document),MongoDB会自动为我们创建的每个文档添加一个id,这个id在

- JSONObject以及json串

bijian1013

jsonJSONObject

一.JAR包简介

要使程序可以运行必须引入JSON-lib包,JSON-lib包同时依赖于以下的JAR包:

1.commons-lang-2.0.jar

2.commons-beanutils-1.7.0.jar

3.commons-collections-3.1.jar

&n

- [Zookeeper学习笔记之三]Zookeeper实例创建和会话建立的异步特性

bit1129

zookeeper

为了说明问题,看个简单的代码,

import org.apache.zookeeper.*;

import java.io.IOException;

import java.util.concurrent.CountDownLatch;

import java.util.concurrent.ThreadLocal

- 【Scala十二】Scala核心六:Trait

bit1129

scala

Traits are a fundamental unit of code reuse in Scala. A trait encapsulates method and field definitions, which can then be reused by mixing them into classes. Unlike class inheritance, in which each c

- weblogic version 10.3破解

ronin47

weblogic

版本:WebLogic Server 10.3

说明:%DOMAIN_HOME%:指WebLogic Server 域(Domain)目录

例如我的做测试的域的根目录 DOMAIN_HOME=D:/Weblogic/Middleware/user_projects/domains/base_domain

1.为了保证操作安全,备份%DOMAIN_HOME%/security/Defa

- 求第n个斐波那契数

BrokenDreams

今天看到群友发的一个问题:写一个小程序打印第n个斐波那契数。

自己试了下,搞了好久。。。基础要加强了。

&nbs

- 读《研磨设计模式》-代码笔记-访问者模式-Visitor

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

import java.util.ArrayList;

import java.util.List;

interface IVisitor {

//第二次分派,Visitor调用Element

void visitConcret

- MatConvNet的excise 3改为网络配置文件形式

cherishLC

matlab

MatConvNet为vlFeat作者写的matlab下的卷积神经网络工具包,可以使用GPU。

主页:

http://www.vlfeat.org/matconvnet/

教程:

http://www.robots.ox.ac.uk/~vgg/practicals/cnn/index.html

注意:需要下载新版的MatConvNet替换掉教程中工具包中的matconvnet:

http

- ZK Timeout再讨论

chenchao051

zookeepertimeouthbase

http://crazyjvm.iteye.com/blog/1693757 文中提到相关超时问题,但是又出现了一个问题,我把min和max都设置成了180000,但是仍然出现了以下的异常信息:

Client session timed out, have not heard from server in 154339ms for sessionid 0x13a3f7732340003

- CASE WHEN 用法介绍

daizj

sqlgroup bycase when

CASE WHEN 用法介绍

1. CASE WHEN 表达式有两种形式

--简单Case函数

CASE sex

WHEN '1' THEN '男'

WHEN '2' THEN '女'

ELSE '其他' END

--Case搜索函数

CASE

WHEN sex = '1' THEN

- PHP技巧汇总:提高PHP性能的53个技巧

dcj3sjt126com

PHP

PHP技巧汇总:提高PHP性能的53个技巧 用单引号代替双引号来包含字符串,这样做会更快一些。因为PHP会在双引号包围的字符串中搜寻变量, 单引号则不会,注意:只有echo能这么做,它是一种可以把多个字符串当作参数的函数译注: PHP手册中说echo是语言结构,不是真正的函数,故把函数加上了双引号)。 1、如果能将类的方法定义成static,就尽量定义成static,它的速度会提升将近4倍

- Yii框架中CGridView的使用方法以及详细示例

dcj3sjt126com

yii

CGridView显示一个数据项的列表中的一个表。

表中的每一行代表一个数据项的数据,和一个列通常代表一个属性的物品(一些列可能对应于复杂的表达式的属性或静态文本)。 CGridView既支持排序和分页的数据项。排序和分页可以在AJAX模式或正常的页面请求。使用CGridView的一个好处是,当用户浏览器禁用JavaScript,排序和分页自动退化普通页面请求和仍然正常运行。

实例代码如下:

- Maven项目打包成可执行Jar文件

dyy_gusi

assembly

Maven项目打包成可执行Jar文件

在使用Maven完成项目以后,如果是需要打包成可执行的Jar文件,我们通过eclipse的导出很麻烦,还得指定入口文件的位置,还得说明依赖的jar包,既然都使用Maven了,很重要的一个目的就是让这些繁琐的操作简单。我们可以通过插件完成这项工作,使用assembly插件。具体使用方式如下:

1、在项目中加入插件的依赖:

<plugin>

- php常见错误

geeksun

PHP

1. kevent() reported that connect() failed (61: Connection refused) while connecting to upstream, client: 127.0.0.1, server: localhost, request: "GET / HTTP/1.1", upstream: "fastc

- 修改linux的用户名

hongtoushizi

linuxchange password

Change Linux Username

更改Linux用户名,需要修改4个系统的文件:

/etc/passwd

/etc/shadow

/etc/group

/etc/gshadow

古老/传统的方法是使用vi去直接修改,但是这有安全隐患(具体可自己搜一下),所以后来改成使用这些命令去代替:

vipw

vipw -s

vigr

vigr -s

具体的操作顺

- 第五章 常用Lua开发库1-redis、mysql、http客户端

jinnianshilongnian

nginxlua

对于开发来说需要有好的生态开发库来辅助我们快速开发,而Lua中也有大多数我们需要的第三方开发库如Redis、Memcached、Mysql、Http客户端、JSON、模板引擎等。

一些常见的Lua库可以在github上搜索,https://github.com/search?utf8=%E2%9C%93&q=lua+resty。

Redis客户端

lua-resty-r

- zkClient 监控机制实现

liyonghui160com

zkClient 监控机制实现

直接使用zk的api实现业务功能比较繁琐。因为要处理session loss,session expire等异常,在发生这些异常后进行重连。又因为ZK的watcher是一次性的,如果要基于wather实现发布/订阅模式,还要自己包装一下,将一次性订阅包装成持久订阅。另外如果要使用抽象级别更高的功能,比如分布式锁,leader选举

- 在Mysql 众多表中查找一个表名或者字段名的 SQL 语句

pda158

mysql

在Mysql 众多表中查找一个表名或者字段名的 SQL 语句:

方法一:SELECT table_name, column_name from information_schema.columns WHERE column_name LIKE 'Name';

方法二:SELECT column_name from information_schema.colum

- 程序员对英语的依赖

Smile.zeng

英语程序猿

1、程序员最基本的技能,至少要能写得出代码,当我们还在为建立类的时候思考用什么单词发牢骚的时候,英语与别人的差距就直接表现出来咯。

2、程序员最起码能认识开发工具里的英语单词,不然怎么知道使用这些开发工具。

3、进阶一点,就是能读懂别人的代码,有利于我们学习人家的思路和技术。

4、写的程序至少能有一定的可读性,至少要人别人能懂吧...

以上一些问题,充分说明了英语对程序猿的重要性。骚年

- Oracle学习笔记(8) 使用PLSQL编写触发器

vipbooks

oraclesql编程活动Access

时间过得真快啊,转眼就到了Oracle学习笔记的最后个章节了,通过前面七章的学习大家应该对Oracle编程有了一定了了解了吧,这东东如果一段时间不用很快就会忘记了,所以我会把自己学习过的东西做好详细的笔记,用到的时候可以随时查找,马上上手!希望这些笔记能对大家有些帮助!

这是第八章的学习笔记,学习完第七章的子程序和包之后