ECCV 2022 | 亚马逊提出GLASS:场景文字识别中的全局到局部注意力

点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

点击进入—> CV 微信技术交流群

转载自:CSIG文档图像分析与识别专委会

论文:https://arxiv.org/abs/2208.03364

代码(已开源):

https://github.com/amazon-research/glass-text-spotting

本文简要介绍ECCV 2022录用论文“GLASS: Global to Local Attention for Scene-Text Spotting”的主要工作。这篇文章针对场景文字端到端识别任务,提出了一个从全局到局部的注意力模块。这个模块结合了全局特征(从共享的主干网络中提取的特征)和局部特征(从原图中裁剪下来的图片,然后再送入一个识别的主干网络提取的特征)融合到一起再进行识别,极大提升了模型的性能。同时文章还提出了一个新的损失函数来提升模型对旋转文本识别的能力。在多个公开数据集上,该论文提出的模型都取得了很好的效果。论文提出的模型也可以用到现在有的框架上。

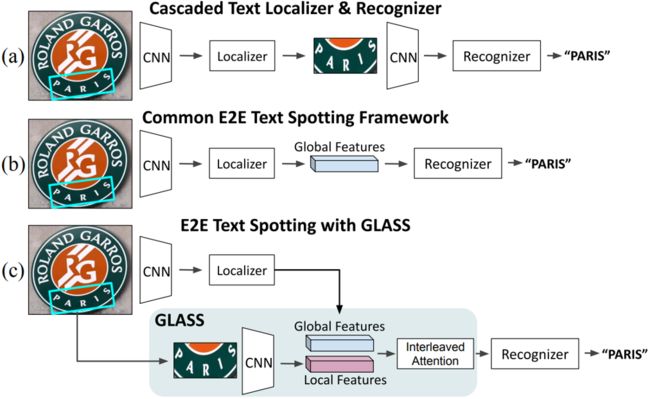

图1. 场景文字端到端识别方法总览。(a)两阶段检测识别。一个独立的文本检测器后面跟着一个独立的识别器。两者是单独训练的。(b) 端到端文字识别。检测与识别协同优化。(c)论文提出的模块同时结合了(a)和(b)的优势。特征图使用交错注意进行融合,提高了对缩放和旋转的鲁棒性,以及整体性能。

一、研究背景

场景文字端到端识别,即在自然场景图片中检测出文本实例并识别出文字的内容,近年来在性能上有了显著的提高。它现在通常用于许多真实的场景中,比如自动驾驶、文档分析和地理定位等。场景文字端到端识别挑战在于,有些单词可能跨越整个图像,而另一些单词,可能就只占据图像很小的一部分,例如,离得很远导致几乎看不到的交通标志。两者的尺度变成非常大,导致了模型性能不佳。论文为了解决文本尺度的变化大,以及文本旋转的问题,提出了一个GLASS模块,在极端尺度变化的情况下增强了模型的性能,并且还设计了一个周期的,针对旋转的损失函数,增强了模型对于任意旋转角度的文本的检测性能。

二、方法原理简述

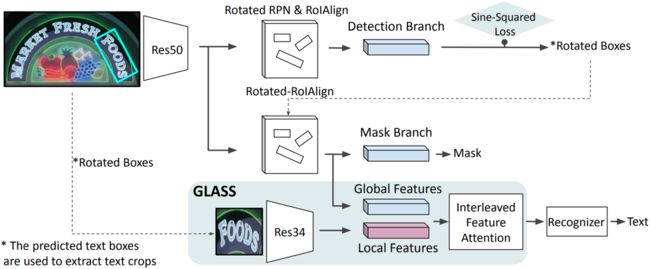

图2. 网络整体框架图。

图片输入到主干网络提取特征,然后输入到检测器中,这个检测器是一个基于Rotated Mask RCNN的检测器,先用一个Rrotated RPN来生成一些旋转的一些Pproposal,然后提取RoI特征,然后对这些旋转的Proposal进行一个精调。得到一个精细的旋转框。然后再用这些旋转框进行Rotated RoIAlign提取RoI特征, 生成Mask。然后就到了识别部分。首先检测部分生成的旋转框从主干网络输出的特征中使用Rotated RoIAlign 提取识别部分的RoI特征这部分Global 的特征,然后再用检测部分生成的旋转框从输入的图片中把旋转文本Crop出来,再送入到一个Res34的主干网络中提取特征,这部分就是Local的特征。最后把这两个特征送入到Interleaved Feature Attention进行融合,然后再送入到识别器中。这里使用的识别器是ASTER。下图是图1中GALSS的详细结构。

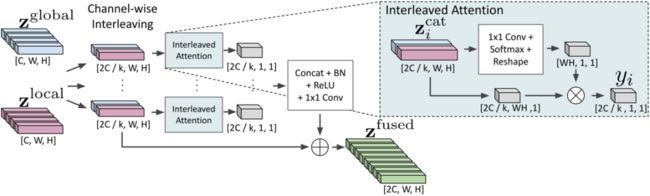

图3. 全局到局部注意特征融合。

图2中的这个 Local特征是从图片裁剪得到的特征,分辨率高。全局特征![]() 是从Backbone采样的特征,其感受野比局部特征

是从Backbone采样的特征,其感受野比局部特征![]() 要大。首先,先把这两个特征在通道上分组,分成K组,然后再拼接起来。然后送入到这个Interleaved Attention中,通过卷积和Softmax得到一个热图,然后乘上原来的特征进行加权求和。总共得到K组这样的特征,然后再把这个特征加回到拼接的特征那里。得到最后的特征

要大。首先,先把这两个特征在通道上分组,分成K组,然后再拼接起来。然后送入到这个Interleaved Attention中,通过卷积和Softmax得到一个热图,然后乘上原来的特征进行加权求和。总共得到K组这样的特征,然后再把这个特征加回到拼接的特征那里。得到最后的特征![]() 。

。![]() 就是送入识别的那个特征。

就是送入识别的那个特征。

![]()

用于端到端监督训练的总损失函数为

![]() 的计算与Mask RCNN中一致,

的计算与Mask RCNN中一致,![]() 的计算与ASTER一致,

的计算与ASTER一致,![]() 的计算如下

的计算如下

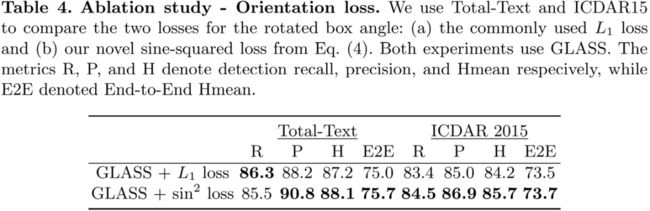

计算角度损失时,使用了文章提的基于正弦函数的Loss来计算。

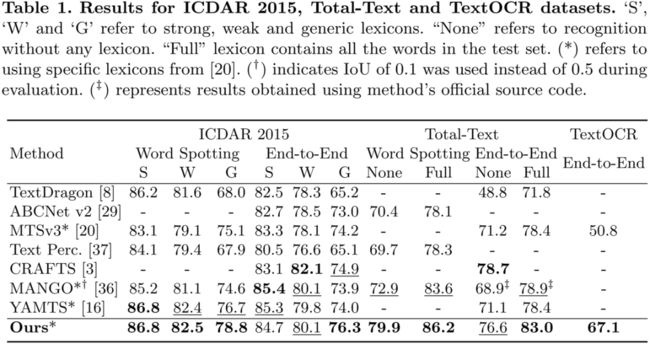

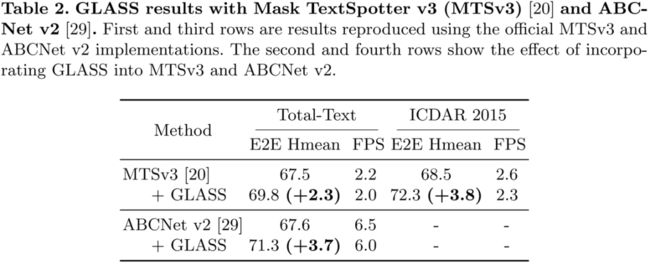

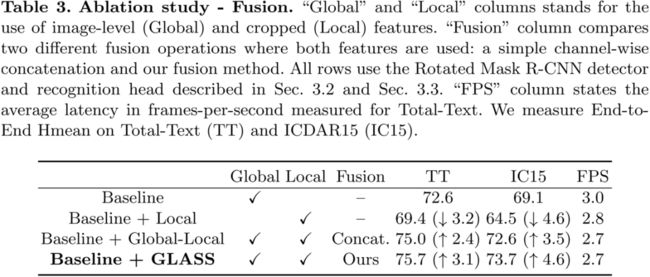

三、主要实验结果及可视化结果

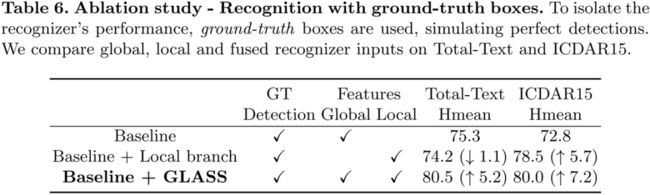

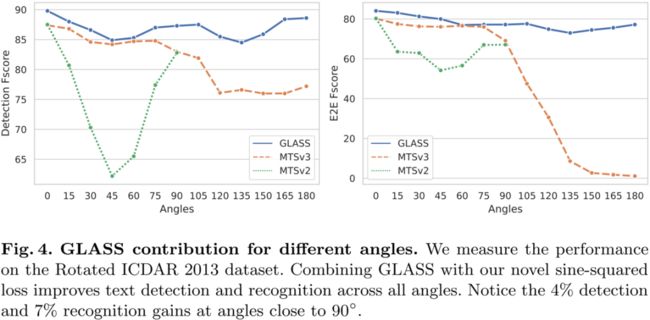

下面是本文的一些实验结果

下面是一些可视化图

四、总结及讨论

本文对现有的场景文字端到端识别提出了两个扩展。首先是提出了一个GLASS模块, 将全局和局部特征结合起来,实现端到端文本识别。另一个是为旋转文本检测提出了一个新的损失函数。在多个数据集上,都证明了本文提出方法的有效性。

参考文献

[1] Ronen R, Tsiper S, Anschel O, et al. GLASS: Global to Local Attention for Scene-Text Spotting[C]. ECCV 2022.

[2] Liao M, Pang G, Huang J, et al. Mask textspotter v3: Segmentation proposal network for robust scene text spotting[C]. ECCV 2020.

[3] Liu Y, Shen C, Jin L, et al. Abcnet v2: Adaptive bezier-curve network for real-time end-to-end text spotting[J]. TPAMI, 2021.

原文作者: Roi Ronen, Shahar Tsiper, Oron Anschel, Inbal Lavi, Amir Markovitz, and R. Manmatha.

撰稿:黄明鑫 编排:高 学

审校:连宙辉 发布:金连文

点击进入—> CV 微信技术交流群

CVPR/ECCV 2022论文和代码下载

后台回复:CVPR2022,即可下载CVPR 2022论文和代码开源的论文合集

后台回复:ECCV2022,即可下载CVPR 2022论文和代码开源的论文合集后台回复:Transformer综述,即可下载最新的3篇Transformer综述PDF

目标检测和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer222,即可添加CVer小助手微信,便可申请加入CVer-目标检测或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer等。

一定要备注:研究方向+地点+学校/公司+昵称(如目标检测或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲扫码或加微信号: CVer222,进交流群

CVer学术交流群(知识星球)来了!想要了解最新最快最好的CV/DL/ML论文速递、优质开源项目、学习教程和实战训练等资料,欢迎扫描下方二维码,加入CVer学术交流群,已汇集数千人!

▲扫码进群

▲点击上方卡片,关注CVer公众号整理不易,请点赞和在看