【论文学习】《Transfer Learning from Speaker Verification to Multispeaker Text-To-Speech Synthesis》

《Transfer Learning from Speaker Verification to Multispeaker Text-To-Speech Synthesis》论文学习

文章目录

- 《Transfer Learning from Speaker Verification to Multispeaker Text-To-Speech Synthesis》论文学习

-

- 摘要

- 1 介绍

- 2 多说话人语音合成模型

-

- 2.1 说话人编码器

- 2.2 合成器

- 2.3 神经声码器

- 2.4 推理和零样本的说话者适应

- 3 实验部分

-

- 3.1 语音自然度

- 3.2 说话人相似度

- 3.3 说话人验证

- 3.4 说话人嵌入空间

- 3.5 训练说话人编码器的数量

- 3.6 虚构的说话人

- 4 结论

摘要

我们描述了一种基于神经网络的文本到语音(TTS)合成系统,该系统能够在不同的说话人的声音中生成语音音频,包括那些在训练期间未见过的说话人。我们的系统由三个独立训练的组件组成:(1)一个说话人编码器网络,在一个说话人验证任务中使用一个独立的数据集,该数据集包含不含数千个说话人的文本的嘈杂语音,从目标说话人的仅几秒参考语音生成一个固定维的嵌入向量;(2)基于Tacotron 2的序列到序列合成网络,以说话人嵌入为条件,从文本生成语音谱图;(3)一种基于自回归WaveNet网络的声码器网络,可将mel谱图转换为时域波形样本。

我们证明,该模型能够将经过鉴别训练的说话人编码器学习到的说话人变异性知识转移到多说话人的TTS任务中,并能够从训练中未见过的说话人合成自然语音。为了获得最佳的泛化性能,我们量化了在一个大而多样的说话人集合上训练说话人编码器的重要性。最后,我们证明了随机采样的说话人嵌入可以在不同于训练中使用的说话人的声音中合成语音,表明该模型学习了高质量的说话人表示。

1 介绍

本工作的目标是建立一个能够以数据高效的方式为各种说话人生成自然语音的TTS系统。我们专门解决了零样本学习设置,其中几秒钟的未转录参考音频从目标发言人的声音合成新的语音,而不更新任何模型参数。这类系统具有可访问性应用程序,例如恢复与失去声音因而无法提供许多新的训练示例的用户自然交流的能力。

它们还可以支持新的应用程序,如跨语言传输语音以实现更自然的语音对语音翻译,或在低资源设置下从文本生成真实的语音。然而,同样重要的是要注意到这种技术可能被滥用,例如未经他人同意就模仿他人的声音。为了解决与(《Artificial Intelligence at Google – Our Principles》)等原则一致的安全问题,我们验证了所提出的模型生成的声音可以很容易地与真实的声音区分开来。

合成自然语音需要对大量高质量的语音文本对进行训练,支持多个说话人通常使用每个说话人(《Deep Voice 2: Multi-speaker neural text-to-speech》)几十分钟的训练数据。为许多说话人记录大量高质量数据是不切实际的。我们的方法是将说话人建模与语音合成分离,方法是独立训练一个说话人识别的嵌入网络,该网络捕获说话人特征的空间,并以第一个网络学习的表示为条件,在更小的数据集上训练高质量的TTS模型。

解耦网络使它们能够在独立的数据上进行训练,从而减少了获得高质量多说话人训练数据的需要。我们在一个说话人验证任务中训练说话人嵌入网络,以确定两个不同的话语是否出自同一说话人之口。与后续的TTS模型不同的是,该网络是针对包含大量混响和背景噪声的未转录语音进行训练的。

我们证明了说话人编码器和合成网络可以在不平衡和不相交的说话人集合上训练,并且仍然具有很好的泛化性。我们在1.2K说话人数据集上训练合成网络,结果表明,在更大的18K说话人数据集上训练编码器可以提高自适应质量,并进一步使从嵌入之前的采样合成完全新颖的说话人成为可能。

人们对TTS模型的端到端训练非常感兴趣,该模型直接从文本-音频对中进行训练,而不依赖于手工制作的中间表示(《Char2Wav: End-to-end speech synthesis》,《Tacotron: Towards end-to-end speech synthesis》)。Tacotron 2(《Natural TTS synthesis by conditioning WaveNet on mel spectrogram predictions》)使用WaveNet(《WaveNet: A generative model for raw audio》)作为声码器,将关注(《Neural machine translation by jointly learning to align and translate》)的编解码器结构生成的谱图进行反相,将Tacotron(《Tacotron: Towards end-to-end speech synthesis》)韵律与WaveNet的音质相结合,获得接近人类语言的自然感。它只支持一个说话人。

Gibiansky等人(《Deep Voice 2: Multi-speaker neural text-to-speech》)引入了Tacotron的多说话人变体,为每个训练说话人学习了低维说话人嵌入。Deep Voice 3(《Deep Voice 3: 2000-speaker neural text-to-speech》)提出了一个完全卷积的编码器-解码器架构,扩大到支持超过2400个来自LibriSpeech(《LibriSpeech: an ASR corpus based on public domain audio books》)的说话人。

这些系统学习一组固定的说话者嵌入,因此只支持在训练中看到的声音的合成。相比之下,VoiceLoop(《VoiceLoop: Voice fitting and synthesis via a phonological loop》)提出了一种基于固定大小的内存缓冲区的新体系结构,可以从训练过程未见过的声音中生成语音。要想取得好成绩,新说话人需要数十分钟的源语音和语音转录。

最近的扩展已经启动了少样本说话人适应,每个说话人(没有文本)只有几秒钟的讲话,就可以用来生成新的讲话在该说话人的声音。(《Neural voice cloning with a few samples》)扩展了Deep Voice 3,将类似VoiceLoop的说话人自适应方法与使用神经网络直接从声谱图预测说话人嵌入的说话人编码方法进行了比较。VoiceLoop的模型参数(包括说话人嵌入)是根据少量自适应数据进行微调的。后一种方法显著提高了数据效率,使用少量的自适应数据获得更高的自然度,仅在一两个话语中。它的计算效率也显著提高,因为它不需要数百次反向传播迭代。

Nachmani等人(《Fitting new speakers based on a short untranscribed sample》)类似地扩展了VoiceLoop,利用目标说话人编码网络来预测说话人嵌入。该网络与使用对比三联体损耗的合成网络联合训练,以确保从同一说话人的话语中预测的嵌入比从不同说话人的话语中计算的嵌入更接近。此外,为了保证合成语音编码与自适应语音具有相似的嵌入特征,还采用了周期一致性损失算法。

一个类似的谱图编码器网络,在没有三连音损失的情况下训练,被证明可以将目标韵律转移到合成语音(《Towards end-to-end prosody transfer for expressive speech synthesis with Tacotron》)。在这篇文章中,我们证明了训练一个类似的编码器来区分说话人会导致可靠的说话人特征转移。

我们的工作与(《Neural voice cloning with a few samples》,《Fitting new speakers based on a short untranscribed sample》)中的说话人编码模型最相似,除了我们使用了一个独立训练的网络,用于在来自数万个说话人的未转录音频的大数据集上进行说话人验证任务,使用的是最先进的通用端到端损失(《Generalized end-to-end loss for speaker verification》)。(《Fitting new speakers based on a short untranscribed sample》)在他们的模型中加入了一个类似的说话者区别表示,然而所有的成分是联合训练的。相比之下,我们探索了从一个预先训练的说话者验证模型迁移学习。

Doddipatla等人(《Speaker adaptation in dnnbased speech synthesis using d-vectors》)使用了类似的迁移学习配置,其中从预先训练的说话者分类器计算出的说话者嵌入被用来调节TTS系统。在本文中,我们利用了一个不依赖中间语言特征的端到端合成网络和一个本质上不同的说话人嵌入网络,它不局限于一个封闭的说话人集合。此外,我们分析了训练集中扬声器的数量对质量的影响,发现零样本传输需要训练数千个扬声器,比(《Speaker adaptation in dnnbased speech synthesis using d-vectors》)中使用的多得多。

2 多说话人语音合成模型

我们的系统由三个独立训练的神经网络组成,如图1所示:

(1)基于(《Generalized end-to-end loss for speaker verification》)的循环说话人编码器,该编码器从语音信号中计算出固定维向量;

(2)基于(《Natural TTS synthesis by conditioning WaveNet on mel spectrogram predictions》)的序列对序列合成器,以说话人嵌入向量为条件,从字母或音素输入序列预测MEL谱图;

(3)自回归WaveNet(《WaveNet: A generative model for raw audio》)声码器,它可以将声谱图转换为时域波形。

2.1 说话人编码器

说话人编码器用于将合成网络置于来自目标说话人的参考语音信号上。对于良好的泛化来说,关键是使用一种能够捕捉不同说话人特征的表征,以及仅使用一个较短的适应信号来识别这些特征的能力,而不依赖于语音内容和背景噪声。在文本无关的说话人验证任务上训练的说话人识别模型可以满足这些要求。

我们遵循(《Generalized end-to-end loss for speaker verification》),它提出了一个高度可扩展和精确的神经网络框架用于说话人验证。该网络将从任意长度的语音计算得到的log-mel谱图帧序列映射到固定维的嵌入向量,称为d-vector(《Deep neural networks for small footprint text-dependent speaker verification》,《End-to-end text-dependent speaker verification》)。该网络经过训练以优化广义端到端说话人验证损失,使来自同一说话人的话语嵌入具有较高的余弦相似度,而来自不同说话人的话语嵌入空间相差很远。训练数据集由被分割为1.6秒的语音音频示例和相关的说话人标识标签组成;不使用文字记录。

输入40通道log-mel谱图被传递到一个网络,该网络由3个LSTM层组成,共768个单元,每个单元后面都有一个256维的投影。最终的嵌入是通过在最终帧对顶层的输出进行L2-normalizing来创建的。在推理过程中,任意长度的话语被分割成800ms的窗口,重叠50%。该网络在每个窗口上独立运行,并对输出进行平均和归一化,形成最终的话语嵌入。

尽管该网络没有直接优化以学习捕捉与合成相关的说话人特征的表示,但我们发现,在说话人识别任务上的训练导致了一个直接适合于将合成网络条件反射到说话人身份的嵌入。

2.2 合成器

我们扩展了Tacotron 2架构(《Natural TTS synthesis by conditioning WaveNet on mel spectrogram predictions》)的重复序列到序列,以支持多个扬声器遵循类似(《Deep Voice 2: Multi-speaker neural text-to-speech》)的方案。目标扬声器的嵌入向量在每个时间步长与合成器编码器输出相连接。与(《Deep Voice 2: Multi-speaker neural text-to-speech》)相比,我们发现,简单地将嵌入信息传递到注意层(如图1所示),会在不同的说话者之间汇聚。

我们比较了该模型的两种变体,一种是使用说话人编码器计算嵌入,另一种是基线,该基线为训练集中的每个说话人优化固定嵌入,本质上学习了一个类似于(《Deep Voice 2: Multi-speaker neural text-to-speech》,《Deep Voice 3: 2000-speaker neural text-to-speech》)的说话人嵌入查找表。

合成器是训练对文本文本和目标音频。在输入时,我们将文本映射到一个音素序列,这可以加快收敛速度,改善生僻词和专有名词的发音。网络在迁移学习配置中进行训练,使用预先训练的说话人编码器(其参数被冻结)从目标音频中提取一个说话人嵌入,即训练时说话人参考信号与目标语音相同。训练期间没有使用明确的说话人标识标签。

目标谱图特征由12.5ms步长计算的50ms窗口计算出来,通过80通道梅尔尺度滤波器组,然后进行日志动态范围压缩。我们通过在预测谱图上增加L2损耗和L1损耗来扩展《Natural TTS synthesis by conditioning WaveNet on mel spectrogram predictions》。在实践中,我们发现这种综合损失对噪声训练数据更有鲁棒性。与《Fitting new speakers based on a short untranscribed sample》相比,我们没有引入基于扬声器嵌入的额外损耗项。

2.3 神经声码器

我们使用逐样自回归WaveNet作为声码器,将合成网络发出的合成的mel谱图转换为时域波形。其结构与Tacotron中描述的相同,由30个扩张卷积层组成。网络并不直接取决于说话人编码器的输出。由合成器网络预测的mel谱图捕获了各种声音的高质量合成所需的所有相关细节,允许多说话人声码器通过简单地训练来自多个说话人的数据来构建。

2.4 推理和零样本的说话者适应

在推理过程中,模型条件使用任意未转录的语音音频,不需要匹配要合成的文本。由于用于合成的说话人特征是从音频中推断出来的,因此它可以以训练集之外的说话人的音频为条件。在实践中,我们发现使用一个几秒长的音频片段就足以合成具有相应说话人特征的新语音,代表了对新说话人的零样本适应。在第3节中,我们评估了这个过程对之前未见过的演讲者的推广效果。

图2显示了推理过程的一个示例,其中显示了使用几个不同的5秒说话人参考话语合成的谱图。合成的男性(上)说话人声谱图与女性(中、下)说话人声谱图相比,基频明显较低,在低频较密集的谐波间隔(水平条纹)和共振峰中可见,在元音中出现的中频峰值可见,比如在0.3秒时的i,最顶端的男性F2在mel通道35,而中间说话者的F2似乎更接近通道40。

类似的差异在咝咝声中也可见,例如,0.4秒的s在男性声音中比在女性声音中含有更多的能量,频率更低。最后,说话人嵌入也在一定程度上捕获了特征说话率,从下面一行的信号持续时间比上面两行长可以看出。右边一栏对应的参考语音的声谱图也可以做类似的观察。

3 实验部分

我们使用两个公共数据集来训练语音合成和声码器网络。VCTK(《CSTR VCTK Corpus: English multi-speaker corpus for CSTR voice cloning toolkit》)包含了来自109位演讲说话人的44个小时的清晰语音,其中大多数人都有英国口音。我们将音频采样到24kHz,调整了开头和结尾的静音(将中间持续时间从3.3秒减少到1.8秒),并将其分成三个子集:训练、验证(包含与训练集相同的说话人)和测试(包含从训练和验证集中取出的11个说话人)。

LibriSpeech(《LibriSpeech: an ASR corpus based on public domain audio books》)由两个干净训练集的联合组成,包含来自1172个说话人的436小时的讲话,采样频率为16khz。大部分的口语都是美式英语,但是由于它来源于有声读物,同一个人说话的语气和风格会有很大的不同。我们将数据重新分割为较短的话语,通过使用ASR模型将音频与文本对齐,并在沉默中分割片段,将中值持续时间从14秒减少到5秒。与原始数据集一样,文本中没有标点符号。说话人数据集在训练、验证和测试集之间是完全不相交的。

LibrisSpeech干净语料库中的许多录音都含有明显的环境噪声和静止的背景噪声。我们使用简单的谱减法(《Suppression of acoustic noise in speech using spectral subtraction》)去噪程序对目标谱图进行预处理,其中语音的背景噪声谱估计为整个信号中每个频带能量的第十百分位。此工艺仅用于合成目标物;原始的噪声语音被传递给说话人编码器。

我们为这两个语料库分别训练了合成和声码网络。在本节中,我们使用经过音素输入训练的合成网络,以控制主观评价中的发音。对于音频相当清晰的VCTK数据集,我们发现在ground truth mel谱图上训练的声码器效果良好。但是对于噪声较大的LibriSpeech,我们发现有必要在合成网络预测的谱图上训练声码器。对声码器训练的目标波形不进行去噪处理。

说话人编码器是在一个专有的语音搜索语料库上训练的,该语料库包含36M个来自美国18K讲英语的人的话语,平均持续时间为3.9秒。此数据集未转录,但包含匿名发言者身份。它从未被用于训练合成网络。

我们主要依赖于基于主观听力测试的众包平均意见评分(MOS)评估。我们所有的MOS评估都符合绝对类别评级量表(《Methods for subjective determination of transmission quality》),评级分数从1到5,以0.5分的增量。我们使用这个框架从两个维度来评估合成语音:它的自然度和与目标说话人真实语音的相似度。

3.1 语音自然度

我们比较了使用VCTK和LibriSpeech训练的合成器和声码器合成语音的自然度。我们构建了一个由100个没有出现在任何训练集中的短语组成的评价集,并为每个模型评估了两组说话人:一组由包含在训练集中的说话人组成(Seen),另一组由那些被扣留的说话人组成(Unseen)。我们在VCTK中使用了11个出现过和未出现过的说话人,在LibriSpeech中使用了10个可见和不可见的说话人。对于每个说话人,我们随机选择一个持续时间约为5秒的话语来计算说话人嵌入。每次评估总共有大约1000个合成话语。每个样本由一个评分者进行评分,并且每个评价都是独立进行的:不同模型的输出不直接进行比较。

结果如表1所示,将提出的模型与使用类似于(《Deep Voice 2: Multi-speaker neural text-to-speech》,《Deep Voice 3: 2000-speaker neural text-to-speech》)的说话人嵌入查找表的基线多说话人模型进行比较,但其他方面与提出的合成器网络具有相同的架构。提出的模型在所有数据集上获得了约4.0的MOS,其中VCTK模型获得的MOS比LibriSpeech模型高出0.2个点。这是LibriSpeech数据集的两个缺点造成的结果:(1)文本中缺少标点符号,这使得模型很难学会自然地停顿;(2)与VCTK相比,背景噪声水平更高,尽管对上述训练目标去噪,但合成器已经学会再现其中的一些噪声。

最重要的是,我们的模型为未见过的说话人生成的音频与为见过的说话人生成的音频几乎一样自然。令人惊讶的是,在LibriSpeech上看不见的演讲者的MOS比看到的演讲者的MOS高0.2个百分点。这是每个说话人随机选择指称话语的结果,指称话语有时包含不均匀和非中性的韵律。在非正式的听力测试中,我们发现合成语音的韵律有时与参考语音的韵律相似,类似于(《Towards end-to-end prosody transfer for expressive speech synthesis with Tacotron》)。这种影响在LibriSpeech上更大,因为它包含更多的韵律。这表明必须采取额外的注意,在合成网络中从韵律中分离说话人的身份,也许可以像(《Towards end-to-end prosody transfer for expressive speech synthesis with Tacotron》,《Style tokens: Unsupervised style modeling, control and transfer in end-to-end speech synthesis》)那样集成一个韵律编码器,或者通过训练来自同一说话人的随机配对参考和目标话语。

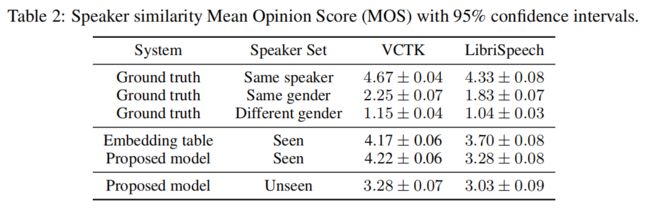

3.2 说话人相似度

为了评估合成语音与目标说话者的匹配程度,我们将每个合成语音与来自同一说话者的随机选择的ground truth语音进行配对。此处不应该判断句子的内容、语法或音频质量;相反,只关注说话者之间的相似之处。

结果如表2所示。VCTK模型的得分往往高于LibriSpeech,这反映了数据集的清洁性质。这在VCTK上更高的地面真实基线中也很明显。对于在VCTK上看到的说话人,所提出的模型的性能与使用嵌入查找表进行说话人条件设置的基线差不多。然而,在LibriSpeech上,所提出的模型获得了比基线更低的相似度MOS,这可能是由于说话人内部变化的更大程度,以及数据集中的背景噪声水平。

在未见过的说话人的情况下,该模型获得了较低的ground truth与合成语音的相似度。在VCTK上,相似度得分为3.28,在评价量表上介于中度相似和非常相似之间。不正式地说,该模型很明显能够转换未见过的说话人概括性的说话特征,清楚地反映出正确的性别,音高,和共振峰范围(如图2)。但在未见过的说话人身上,相似度评分显著降低,这表明一些细微差别,比如与特色韵律相关的差别,已经消失了。

说话人编码器只接受北美口音的训练。因此,口音不匹配限制了我们在VCTK上对说话人相似度的表现,因为评分者指令没有指定如何判断口音,所以如果口音不匹配,评分者可能会认为一对来自不同的说话人。事实上,对评分者评论的检查表明,我们的模型有时会产生与基本事实不同的口音,从而导致较低的分数。然而,一些评价者评论说,尽管口音不同,但音调和音调的变化听起来非常相似。

我们使用VCTK和LibriSpeech训练过的合成器从其他数据集合成说话人,作为对域外说话人的能力的初步评估。我们只改变了合成器和声码器网络的序列集;两种型号都使用了相同的说说话人编码器。如表3所示,该模型能够生成与表1中未见但在域内的说话人相同的自然程度的语音。

然而,LibriSpeech模型合成的VCTK说话人具有明显更高的说话人相似度,而VCTK模型能够合成LibriSpeech说话人。LibriSpeech模型的较好泛化表明,仅在100个说话人上训练合成器不足以实现高质量的说话人转换。

3.3 说话人验证

我们评估了一个有限的说话人验证系统区分合成语音和真实语音的能力,作为一个客观度量合成语音和真实语音之间的相似度的度量。我们训练了一个新的只用评估的说话人编码器,其网络拓扑与第2.1节相同,但使用了来自113K说话人的28M话语的不同训练集。使用不同的评估模型确保指标不仅在特定的说话人嵌入空间有效。

我们记录了21个真实的说话人的声音:11个来自VCTK,10个来自LibriSpeech,并根据记录的说话人集合成波形。在合成器训练期间,看不到所有记录和验证的说话人。通过将每个测试话语与每个记录的说话人配对,估计说话人验证的等错误率。我们为每个说话人合成了100个测试话语,因此每一个评价都进行了21000或23100次试验。

如表4所示,只要将合成器训练在足够大的说话人集上,即在LibriSpeech上,合成的语音通常与ground truth声音最相似。使用两个数据集的参考说话人,LibriSpeech合成器获得相似的5-6%的EER,而在VCTK上训练的结果更差,特别是在域外的LibriSpeech扬声器上。这些结果与表3中的主观评价一致。

为了衡量区分同一个说话人的真实语音和合成语音的难度,我们对一组选用的说话人进行了额外的评估,其中包括10个真实LibriSpeech演讲者的合成版本。在这20个语音识别任务中,我们得到了2.86% 的EER,表明合成语音倾向于接近目标说话人(余弦相似度>0.6,并且如表4所示),它几乎总是更接近于同一说话人的其他合成话语(相似度>0.7)。由此,我们可以得出结论,提出的模型可以生成类似于目标说话人的语音,但不够好到能与真正的说话人混淆。

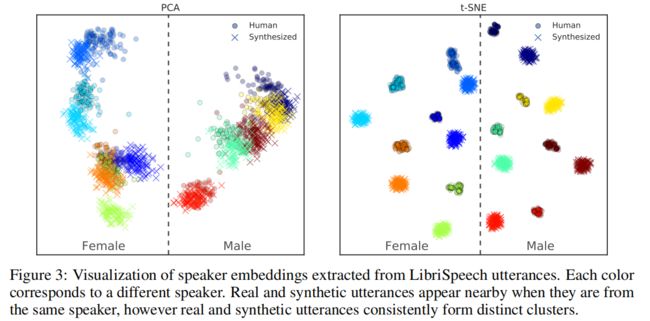

3.4 说话人嵌入空间

将说话人嵌入空间可视化,进一步将3.2节和3.3节中描述的量化结果语境化。如图3所示,不同的说话人在说话人嵌入空间中被很好地分离。主成分分析可视化(左)显示,在嵌入空间中,合成的话语往往与来自同一说话人的真实话语非常接近。然而,合成话语仍然很容易与真实的人类话语区分开来,正如t-SNE可视化(右图)所示,每个合成说话人的话语形成一个不同的簇,与对应说话人的真实话语簇相邻。

在主成分分析(PCA)和t-SNE可视化中,说话者似乎很好地按性别分开,所有女性说话者出现在左边,所有男性说话者出现在右边。这表明说话人编码器已经学会了说话人空间的合理表示。

3.5 训练说话人编码器的数量

很可能,所提出的模型能够很好地概括各种各样的发言者是基于发言者编码器学习的表示质量。因此,我们探讨了说话人编码器训练集对合成质量的影响。我们用了三个额外的训练集:(1)LibriSpeech Other,它包含了来自一组1166个说话人的461小时的语音,这些说话人与干净子集中的说话人不相关联;(2)VoxCeleb(《VoxCeleb: A large-scale speaker identification dataset》);(3)VoxCeleb2(《VoxCeleb2: Deep speaker recognition》)含有1211个说话人说的139k条语音,以及5994个说话人说的1.09M条语音。

表5比较了作为训练说话人编码器的说话人数量的函数,所提出的模型的性能。这衡量了在训练说话人编码器时说话人多样性的重要性。为了避免过拟合,在小数据集(前两行)上训练的说话人编码器使用更小的网络结构(256维的LSTM单元与64维的预测)并输出64维说话人嵌入。

我们首先评估在LibriSpeech Clean和Other集合上训练的说话人编码器,每个集合包含相似数量的说话人。在Clean中,说话人编码器和合成器在相同的数据上进行训练,这一基线类似于(《Neural voice cloning with a few samples》)中的非微调说话人编码器,只是它与(《Fitting new speakers based on a short untranscribed sample》)中的训练具有区别性。这种匹配条件给出了稍好一点的自然度和相似度。随着训练说话人数量的增加,自然度和相似度都有显著提高。客观的EER结果也随着主观评价而改善。

这些结果对多说话人TTS训练具有重要意义。说话人编码器的数据要求比完整的TTS训练少得多,因为不需要文字记录,而且音频质量可能比TTS训练低。我们已经证明,将训练于大量未转录数据的说话者编码器网络与训练于较小的高质量数据集的TTS网络相结合,是有可能合成非常自然的TTS的。

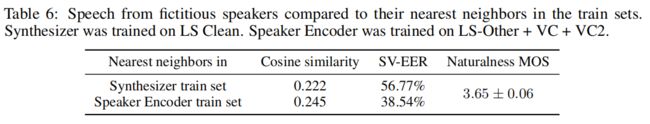

3.6 虚构的说话人

绕过说话人编码器网络并将合成器设置在说话人嵌入空间的随机点上,就会产生来自虚拟说话人的语音,这些虚拟说话人并不存在于合成器或扬声器编码器的训练集或测试集中。这在表6中得到了证明,它比较了由单位超球表面均匀采样点生成的10个这样的说话人与它们在组件网络训练集中最近邻的说话人。SV-EERs 是在记录了10个最近相邻的声音后,使用与3.3节相同的设置计算的。即使这些说话人是完全虚构的,合成器和声码器能够产生的音频,就像见过或未见过的真实说话人一样自然。与最近相邻训练语音的余弦相似度较低,而EER较高,表明它们确实不同于训练说话人。

4 结论

提出了一种基于神经网络的多说话人TTS合成系统。该系统结合了一个独立训练的说话人编码器网络,序列到序列的TTS合成网络和基于Tacotron 2的神经声码器。通过利用鉴别说话人编码器所学习的知识,合成器能够不仅能够为在训练中见过的说话人,而且也能够为从未见过的说话人生成高质量的语音。通过基于说话人验证系统的评价和主观听力测试,我们证明了合成的语音与目标说话人的真实语音相当相似,即使是在这些未见过的说话人身上。

我们进行了实验来分析用于训练不同组件的数据量的影响,发现如果在合成器训练集中有足够的说话人多样性,增加说话人编码器训练数据量可以显著提高说话人转换质量。

迁移学习是实现这些结果的关键。通过分离说话人编码器和合成器的训练,系统显著降低了对多说话人TTS训练数据的要求。它既不需要为合成器训练数据的说话人身份标签,也不需要为说话人编码器训练数据的高质量干净的讲话或文本。此外,与《Fitting new speakers based on a short untranscribed sample》相比,独立训练这些组件显著简化了合成器网络的训练配置,因为它不需要额外的三连音或对比损耗。然而,使用低维向量建模说话人的变化限制了利用大量参考语音的能力。对于超过几秒的参考语音,提高说话人的相似度需要像《Neural voice cloning with a few samples》和最近《* Sample efficient adaptive text-to-speech*》中的模型适应方法。

最后,我们证明该模型能够从与训练集不同的虚构说话人生成真实的说话人,这意味着该模型已经学会利用说话人变化空间的真实表示。

尽管使用了WaveNet声码器(以及它非常高的推理成本),但与《Natural TTS synthesis by conditioning WaveNet on mel spectrogram predictions》的单说话者结果相比,所提出的模型并没有达到人类水平的自然度。这是由于为不同的说话人生成语音的额外困难,每个说话人的数据明显更少,以及使用数据质量较低的数据集。另外一个限制是模型不能转移重音。如果有足够的训练数据,可以通过将合成器设置为独立说话人和重音嵌入来解决这个问题。最后,我们注意到该模型也不能完全将说话人的声音从参考音频的韵律中分离出来,这与《Towards end-to-end prosody transfer for expressive speech synthesis with Tacotron》中观察到的趋势类似。