Conditional Convolutions for Instance Segmentation译文

Conditional Convolutions for Instance Segmentation

本人自己翻译的,翻译的不好请见谅,主要是我在复现这个论文,同时分享出来给大家。

我们提出了一个简单而有效的实例分割框架,称为CondInst(条件卷积引入在实例分割)。效果最好的实例分割方法(例如Mask R-CNN)依靠ROI操作(比如ROIPool或ROIAlign)来获取最终的实例掩码。相反,我们计划从新的角度解决实例分割问题。我们不使用实例方式的ROI作为固定权重网络的输入,而是采用基于实例的动态实例感知网络。CondInst具有两个优点:1)通过全卷积网络解决实例分割,无需进行ROI裁剪和特征对齐。 2)由于动态生成的条件卷积的能力大大提高,因此mask head可以非常紧凑(例如3个卷积层,每个仅具有8个通道),从而导致明显更快inference。我们展示了一种更简单的实例分割方法,该方法可以在准确性和inference速度上都实现更高的性能。在COCO数据集上,我们优于一些最新的方法,包括经过微调的Mask RCNN基线,而无需更长的训练时间。

1、简介

实例分割是计算机视觉中一项基本但具有挑战性的任务,它需要一种算法来预测 per-pixel mask with a category label for each instance of interest in an image.尽管最近提出了一些工作,但实例分割的主要框架仍然是两阶段方法Mask R-CNN [3],它将实例分割转换为两阶段的检测和分割任务。Mask R-CNN第一次使用目标检测器Faster R-CNN来预测每个实例的边界框。然后针对每种实例,从网络的特征图中裁剪出感兴趣区域(ROI)用ROIAlign操作。

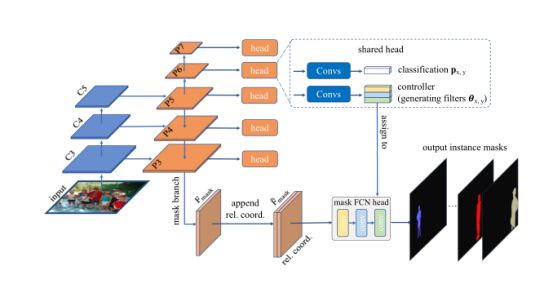

图1. CondInst利用实例感知mask head来预测每个实例的masks。K是要预测的实例数量。mask head中的过滤器随不同实例而变化,这些实例是动态生成的并以目标实例为条件。对于非最后面的卷积。在mask head层中,ReLU被用作激活功能,此处未使用诸如批归一化[1]之类的归一化层。最后一层,使用Sigmoid形来预mask前景的可能性。

为了预测每个实例的最终mask,将密集的全卷积网络(FCN)(即:mask head)应用于这些ROI,以执行前景/背景分割。然而,这种基于ROI的方法可能具有以下缺点。 1)由于ROI通常是与轴对齐的边界框,对于形状不规则的对象,它们可能包含过多的不相关图像内容,包括背景和其他实例。通过使用旋转的ROI可以缓解此问题,但是需要更复杂的管道。 2)为了区分前景实例和背景实例,mask head需要相对较大的感受野来对足够大的上下文信息进行编码。因此,在mask head中需要大量的3×3卷积(例如在mask R-CNN中具有4个256通道的3×3卷积)。这大大增加了Mask head的计算复杂度,从而导致推理时间随实例数的变化而显着变化。3)ROIs通常大小不同。为了在深度学习框架中使用有效的批量计算,通常需要进行大小调整操作以将区域调整为相同大小的patch。例如,Mask R-CNN将所有裁剪区域的大小调整为14×14(使用反卷积将其上采样为28×28),这限制了实例分割的输出分辨率,因为大型实例需要更高的分辨率才能在边界保留细节。

图2.与其他方法的定性比较。我们将提出的CondInst与YOLACT[1]和Mask R-CNN [2]进行了比较。我们的Mask通常质量较高(例如:保留更多细节)。视觉上的场景。

在计算机视觉中,最接近实例分割的任务是语义分割,为此,全卷积网络(FCN)已显示出巨大的成功[6,7]。FCN在许多其他per-pixel(逐像素)预测任务上也表现出出色的性能,这些任务包括从低级图像处理(例如去噪,超分辨率)到中级任务(例如光流估计和轮廓检测)和高级任务(包括最近的 single-shot物体检测[8]),

单眼深度预测[9]和计数[10]。但是,几乎所有的实例分割方法都基于FCNs1并落后于基于最新的ROI方法。为什么通用FCN在实例分割上的表现不令人满意?我们观察到将FCN应用于实例分割的主要困难在于,相似的图像外观可能需要不同的预测,但是FCN在实现这一目标方面遇到了困难。例如,如果在输入图像中有两个外表相似的人A和B,则在预测A的实例mask时,FCN需要将B预测为背景,这可能很难,因为它们看起来相似。因此,ROI操作用于裁剪interest,e.g., A; and filter out B,本质上,实例分割需要两种类型的信息:1)大量的网络参数提供;2)照片信息以区分属于同一类别的多个对象。几乎所有方法都依赖于ROI裁剪,该裁剪精确地编码实例的位置信息。相比之下,CondInst通过使用位置/实例敏感的卷积过滤器以及附加到特征图的相对坐标来利用位置信息。

图3.CondInst的总体架构。 C3,C4和C5是骨干网(例如ResNet50)的功能图。 P3至P7是[8,26]中的FPN功能图。 Fmask是mask分支的输出,而〜Fmask是通过将相对坐标连接到Fmask获得的。分类头部预测目标实例在位置(x,y)的分类概率p px,y,与FCOS中相同。注意分类和转换。参数生成头(在虚线框中)应用于P3···P7。Mask head是实例感知的,其转换滤波器θθx,y是针对每个实例动态生成的,并且被施加到〜Fmask的次数与图像中的实例数目一样多(参见图1)。

因此,我们提倡使用实例感知FCN进行实例mask预测的新解决方案。换句话说,不是使用具有标准的卷积滤波器集的标准ConvNet作为用于预测所有实例的mask head,而是根据要预测的实例调整网络参数。受动态过滤网络[11]和CondConv [12]的启发,对于每个实例,控制器子网(请参见图3)动态生成maskFCN网络参数(以实例的中心区域为条件),然后用于预测此实例的掩码。期望网络参数可以编码该实例的特征,并且仅在该实例的像素上触发,因此绕过了上述困难。这些条件mask head可应用于整个特征图,从而无需进行ROI操作。乍一看,这种想法可能效果不佳,因为某些图像包含多达数十个实例,因此按实例的mask head可能会产生大量的网络参数。但是,我们表明,具有动态生成的filters的非常密集的FCNmask head已经可以胜过以前ROI-based的Mask RCNN,与Mask R-CNN中的mask head相比,每个实例的计算复杂度大大降低。我们将主要贡献总结如下。

- 我们尝试从新的角度解决实例分割。为此,我们提出了CondInst实例分割框架,该框架实现了比现有方法(例如Mask R-CNN)更快的实例分割性能。据我们所知,这是新实例分割框架在准确性和速度上都首次超过最新技术。

- CondInst是全卷积的,并且在许多现有方法中避免了上述resizing operation,因为CondInst不依赖ROI操作。无需调整特征图的大小即可生成具有更精确边缘的高分辨率实例mask。

- 与之前的方法不同,在之前的方法中,一次训练,所有实例的mask head中的fiters都是固定的,我们的mask head中的filter是动态生成的并以实例为条件。由于仅要求滤波器预测一个实例的mask,因此极大地减轻了学习要求,从而减少了fiters的负载。结果,mask head可以非常轻便,从而大大减少了每次inference的时间。与边界框检测器FCOS相比,CondInst仅需要多10%的计算时间,甚至可以处理每个图像的最大实例数(即100个实例)。

- 在近期resorting[2,13]中,即使没有采用更长的训练,CondInst仍可实现最新性能,同时推理速度更快。我们希望CondInst可以成为流行的方法(如Mask R-CNN)用于实例分割任务的强大替代品。

而且,CondInst的灵活设计可以立即应用于全景分割。我们相信,通过最少的重新设计工作,建议的CondInst可用于解决所有以前使用基于ROI的pipeline解决的实例级识别任务。

-

- 相关工作

在这里,我们回顾一些与我们的工作最相关的工作。条件卷积。与传统卷积层不同,传统卷积层具有which have fixed filters once trained,而条件卷积的滤波器则以输入为条件,并由另一个网络(即控制器)动态生成。以前在动态过滤器网络[11]和CondConv [12]中已经探讨了这个想法,主要是为了增加分类网络的容量。在这项工作中,我们将这一思想扩展到解决实例分割这一更具挑战性的任务。

实例分割。迄今为止,实例分割的主要框架仍然是Mask R-CNN。Mask R-CNN首先使用object detector来检测实例的边界框(例如ROI)。通过这些边界框,可以使用ROI操作从特征图中裁剪实例的特征。最后,使用密集的FCN head来获得所需的实例masks。许多具有最佳性能的模型[14-16]都是基于Mask R-CNN构建的。此外,一些工作已经探索将FCN应用于实例分割。Instance FCN [17]可能是第一个全卷积的实例分割方法。 Instance FCN建议使用vanilla FCN预测位置敏感得分图。之后,组装这些得分图以获得所需的实例masks。请注意,Instance FCN在重叠的实例上不能很好地工作。其他人[18–20]尝试首先执行分割,并通过组合同一实例的像素来形成所需的实例mask。据我们所知,到目前为止,在公开COCO基准数据集上,这些方法都无法在准确性和速度上胜过Mask R-CNN。

最近的YOLACT [2]和BlendMask [21]可以看作是Mask RCNN的重新标定,它可以将ROI检测与用于mask预测的特征图。Wang等开发了一种基于FCN的简单实例分割方法,显示了competitive performance[22]。Polar Mask开发了用于实例分割的新的简单mask representation[23],它扩展了边界框检测器FCOS [8]。

最近AdaptIS [24]提出用FiLM [25]解决全景分割问题。这个想法与CondInst有一些相似之处,即有关实例的信息编码在FiLM生成的系数中。由于仅动态生成批归一化系数,因此AdaptIS需要较大的mask head才能获得良好的性能。相反,CondInst直接将它们编码为conv。Mask head的过滤器,因此具有更大的容量。结果,即使使用非常密集的mask head,我们也认为CondInst可以实现实例分割精度,而AdaptIS则无法实现这种精度。

2.使用CondInst进行实例分割

2.1、整体架构

给定输入图像I∈RH×W×3,实例分割的目标是预测图像中每个实例所关注的逐像素mask和类别。实例分割的基本定义为{(Mi,ci)},其中Mi∈{0,1} H×是第i个实例的mask,而ci∈{1,2,...,C}为类别。MS-COCO上的C为80[27]。与语义分割不同,后者仅需要预测一个输入图像的一个mask,而实例分割则需要预测可变数量的mask。取决于图像中实例的数量。在将传统FCN [6]应用于实例分割时,这构成了挑战。在这项工作中,我们的核心思想是对于具有K个实例的图像,将动态生成K个不同的mask head,并且每个mask head将在其filter包含其目标实例的特征。结果,当将mask应用于输入时,它只会在实例的像素上触发,从而产生实例的mask预测。我们在图1中说明该过程。

回想一下,Mask R-CNN使用object detector来预测输入图像中实例的边界框。边界框实际上是Mask R-CNN表示实例的方式。同样,CondInst使用实例感知filter来表示实例。换句话说,CondInst不会将实例概念编码到边界框中,而是将其隐式编码到mask head的参数中,这是一种更加灵活的方法。例如,它可以轻松地表示难以被边界框紧密包围的不规则形状。与以前基于ROI的方法相比,这是CondInst的优势之一。

类似于基于ROI的方法获取边界框的方式,实例感知过filter也可以通过object detector获得。在这项工作中,由于其简单和灵活,我们在受欢迎的对象检测器FCOS [8]上构建了CondInst。同样,在FCOS中消除锚定框也可以节省参数数量和CondInst的计算量。如图3所示,在FCOS [8]之后,我们利用特征金字塔网络(FPN)[26]的特征图{P3,P4,P5,P6,P7},其下采样比率为8,16、32、64和128。如图3所示,在FPN的每个功能级别上,都应用了一些功能层(在虚线框中)来进行实例相关的预测。例如,目标实例的类和该实例的动态生成的过滤器。从这个意义上讲,CondInst可以被视为与Mask R-CNN相同,两者都首先关注图像中的实例,然后预测实例的像素级mask(即实例优先)。

除了detector,外,如图3所示,还有一个mask分支,提供了我们生成的mask head作为输入来预测所需实例mask的特征图。特征图由Fmask∈RHmask×Wmask×Cmask表示。掩码分支连接到FPN级别P3,因此其输出分辨率为输入图像分辨率的1/8。掩码分支在最后一层之前有四个128通道的3×3卷积。此后,为了减少所生成参数的数量,掩码分支的最后一层将通道的数量从128减少到8(即Cmask = 8)。令人惊讶的是,如我们的实验所示,使用Cmask = 8已经可以实现出色的性能,而在此处使用较大的Cmask(例如16)无法提高性能。更积极地,使用Cmask = 2只会使mask AP中的性能降低0.3%。此外,如图3所示,将Fmask与坐标的映射图组合,所述坐标的映射是从Fmask上的所有位置到位置(x,y)(即,生成mask head的filter的位置)的相对坐标。然后,将组合发送到maskhead以预测实例mask。如我们的实验所示,相对坐标为预测实例mask提供了强有力的提示。而且,单个S形被用作mask head的最终输出,因此mask预测是类别不可知的。实例的类别由分类head与控制器并行预测,如图3所示。

原始mask预测的分辨率与Fmask的分辨率相同,即输入图像分辨率的1/8。为了产生高分辨率实例mask,使用双线性上采样将mask预测上采样4,从而得到400×512mask预测(如果输入图像大小为800×1024)。我们将显示,上采样对CondInst在实验中最终实例的分割性能至关重要。请注意,mask的分辨率比mask R-CNN的分辨率高得多(之前仅为28×28)。

2.2、网络输出和训练目标

没翻译...

2.3、损失函数

没翻译...

2.4、推理

给定输入图像,我们将其通过网络前向传播,以获得包括分类置信度p(x,y),中心度得分,预测框t(x,y)和生成的参数θ(x,y)的输出。我们首先按照FCOS中的步骤来获取边界框检测。然后,将阈值为0.6的基于框的NMS用于删除重复的检测,然后将前100个边界框(即实例)用于计算mask。让我们假设在该过程之后保留K个边界框,因此我们有K个生成的过滤器组。Mask head中依次使用了K组滤镜。将这些特定于实例的Mask head以FCN的方式应用于F(x,y)(即,Fmask和Ox,y的组合)以预测实例的Mask。由于Mask head是一个非常紧凑的网络(三个8通道和总共169个参数的1×1卷积),因此计算Mask的开销非常小。例如,即使进行了100次检测(即MS-COCO上每幅图像的最大检测次数),在Mask head上总共只花费了不到5毫秒,这仅增加了基本detector FCOS的约10%的计算时间。相比之下,Mask R-CNN的Mask Head具有四个具有256个通道的3×3卷积,因此具有超过2.3M的参数,并且需要更长的计算时间。

- 实验

我们在大型基准MS-COCO上评估CondInst [27]。按照常规做法[3、8、32],我们的模型使用splittrain2017(115K图像)进行训练,所有消融实验均在splitval2017(5K图像)上进行评估。我们的主要结果报告在test-dev拆分中(20K图像)。

3.1、实施细节

除非另有说明,否则我们将使用以下实现细节。继FCOS [8]之后,ResNet-50 [33]被用作我们的骨干网络,而ImageNet [34]上预训练的权重被用于初始化它。对于新添加的图层,我们按照[8]中的说明对其进行初始化。我们的模型使用8个V100 GPU上的随机梯度下降(SGD)进行了90K迭代训练,初始学习率为0.01,并且有16个图像的小批量。在迭代60K和80K时,学习率分别降低了10倍。权重衰减和动量分别设置为0.0001和0.9。根据Detectron2 [35],调整输入图像的大小以使其在[640,800]中较短,而在训练过程中其较长边小于或等于1333。在训练期间也使用向左翻转数据增强。在测试时,我们不使用任何数据扩充,仅使用较短边的比例尺为800。这项工作的推理时间是在单个V100 GPU上进行测量的,每批GPU具有1张图像。

3.2、面具头的体系结构

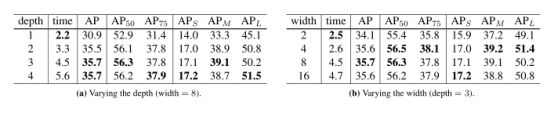

在本节中,我们讨论CondInst中mask head的设计选择。令我们惊讶的是,其性能对mask head的结构不敏感。我们的基线是8个通道的三个1×1卷积的mask head(即width = 8)。如表1(第三行)所示,掩码AP达到35.7%。接下来,我们首先通过改变mask head的深度进行实验。如表1a所示,除了深度为1的mask head外,所有其他mask head(即深度= 2,3和4)都达到类似的性能。

表1:在MS-COCO val2017拆分中,使用mask head的不同体系结构的实例分割结果。“深度”:mask head中的层数。“宽度”:这些层的通道数。“时间”:mask head处理100个实例所花费的毫秒数。

深度为1的mask head的性能较差,因为在这种情况下,mask head实际上是线性映射,其容量过弱。而且,如表1b所示,只要宽度在合理范围内,改变宽度(即,通道数)也不会导致显着的性能变化。我们还注意到,我们的mask head非常轻巧,因为mask head中的filter是动态生成的。如表1所示,我们的基线mask head每100个实例仅花费4.5ms(MS-COCO上的最大实例数),这表明我们的mask head仅给基本detector.增加了少量计算开销。此外,我们的基准mask head.总共只有169个参数。与之形成鲜明对比的是,Mask R-CNN [3]的掩码头具有超过2.3M的参数,并需要约2.5倍的计算时间(每100个实例11.4 ms)。

3.3、Mask Branch的设计选择

我们将进一步研究Mask分支的影响。我们首先更改Cmask,它是mask分支的输出要素贴图(即Fmask)的通道数。如表2所示,只要Cmask处于合理范围内(即2到16),性能就几乎保持不变。Cmask = 8是最佳选择,因此默认情况下,我们在所有其他实验中都使用Cmask = 8。

表2:通过更改MS-COCO val2017拆分中的mask分支输出(即Cmask)的通道数来进行实例分割。如下表所示,如果Cmask处于合理范围内,则性能几乎保持不变,这表明CondInst对设计选择具有鲁棒性。

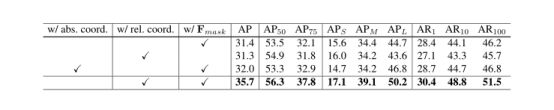

如前所述,在mask head分支的输出Fmask与相对坐标图连接起来之前,作为mask head的输入,这为mask预测提供了有力的提示。如表3(第二行)所示,如果删除了相对坐标,则性能会显着下降(35.7%对31.4%)。性能的显着下降意味着生成的filter不仅对外观提示进行编码,而且还对目标实例的形状进行编码。仅使用相对坐标也可以通过实验证明。如表3(第二行)所示,仅使用相对坐标也可以获得不错的性能(在maskAP中为31.3%)。我们要强调的是,与Mask R-CNN通过边界框对目标实例的形状进行编码不同,CondInst将形状隐式编码到生成的filter中,该filter可以轻松表示任何形状,包括不规则形状,因此具有更多的灵活含义。我们还尝试了绝对坐标,但是不能如表3所示(32.0%)大大提高性能。这表明生成的filter主要携带局部提示,例如形状。最好主要依赖于本地线索,因为我们希望CondInst是 translation invariant。

表3:对MS-COCO val2017分割mask输入的消融研究。如表中所示,在没有相对坐标的情况下,mask AP的性能从35.7%下降到31.4%。使用绝对坐标不能显着提高性能(仅32.0%),这意味着生成的filter主要对局部提示(例如形状)进行编码。此外,如果mask head仅将相对坐标作为输入(在这种情况下,即没有外观特征),CondInst也将获得适度的性能(31.3%)。

3.4、提升mask预测的重要性有多大?

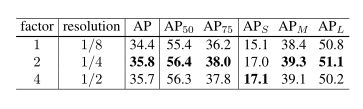

如前所述,原始mask预测被上采样,并且上采样对最终性能非常重要。我们在实验中证实了这一点。如表4所示,在不使用上采样的情况下(表中的第一行),在这种情况下,CondInst可以产生输入图像分辨率为1 8的mask预测,这在mask AP中仅能达到34.4%,因为大多数details(例如,边界)丢失。如果通过系数= 2对mask 预测进行上采样,则mask AP的性能可以显着提高1.4%(从34.4%增至35.8%)。特别是对小物体的改进很大(从15.1%到17.0),这表明上采样可以极大地保留物体的细节。将上采样系数增加到4会使性能稍微变差(mask AP的从35.8%至35.7%),可能是由于MS-COCO的low-quality annotation。我们在所有其他模型中都使用factor = 4,因为它有可能产生高分辨率实例mask。

表4:通过更改用于对mask预测进行上采样的因子,在MS-COCO val2017拆分后的实例分割结果。“分辨率”表示掩模预测与输入图像的分辨率之比。如表中所示,如果不进行上采样(即系数= 1),则性能会显着下降(从掩码AP中的35.8%降至34.4%)。比率2或4几乎获得相同的结果。

3.5、无边界框检测的CondInst

尽管我们仍将边界框检测分支保留在CondInst中,但是如果我们不使用边界框来使用NMS,则从概念上完全消除边界分支是可行的。在这种情况下,所有前景样本(由分类头确定)将用于计算实例mask,而重复的mask将被基于mask的NMS删除。如表5所示,使用基于掩码的NMS,可以获得与基于框的NMS相同的总体性能(35.7%,而mask AP中为35.7%)。

表5:使用不同的NMS算法的实例分割结果。如表所示,基于mask的NMS可以获得与基于盒子的NMS相同的总体性能,这表明CondInst可以完全消除边界框检测。注意,基于ROI的方法(例如Mask R-CNN)无法删除边界框检测。

3.6、与最先进方法的比较

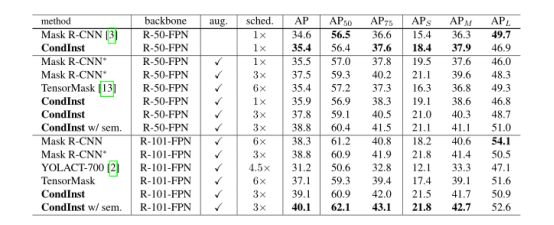

我们将CondInst与MS-COCO test-dev拆分与之前的最新方法进行了比较。如表6所示,在学习速率为1倍(即90K迭代)的情况下,CondInst的性能比原始Mask R-CNN高出0.8%(35.4%对34.6%)。 CondInst还实现了比原始Mask R-CNN更快的速度(单个V100 GPU上每个图像分别为49ms和65ms)。据我们所知,

这是第一次出现新和简单的实例分割方法,在准确性和速度上都优于Mask R-CNN。与Detectron2中精心设计的Mask R-CNN(即表6中的Mask R-CNN *)相比,CondInst还获得了更好的性能(35.9%vs. 35.5%)和标准速度(49ms vs 49ms)。此外,通过更长的训练周期(例如3倍)或更强的backbone(例如ResNet-101),也可以实现持续的改进(ResNet-50 3x分别为37.8%与37.5%和39.1% vs ResNet-101 3x)占38.8%,这表明CondInst本质上优于Mask R-CNN。而且,如表6所示,通过auxiliary语义分割任务,可以将性能从37.8%提高到38.8%(ResNet-50)或从39.1%提高到40.1%(ResNet-101),而无需增加推理时间。为了公平地进行比较,此处的所有推断时间均由我们自己使用官方代码在同一硬件上测量。

表6:与MS-COCO test-dev上的最新方法的比较。“ Mask R-CNN”是原始Mask R-CNN [3],“ Mask R-CNN ∗”是Detectron2中改进的Mask R-CNN [35]。 “增强”:在训练过程中使用多尺度数据增强。 “进度表”:使用的学习率进度表。 “ 1×”表示模型经过90K迭代训练,“ 2×”是180K迭代,依此类推。学习率如[36]中所述改变。“ w / sem”:使用辅助语义分割任务。

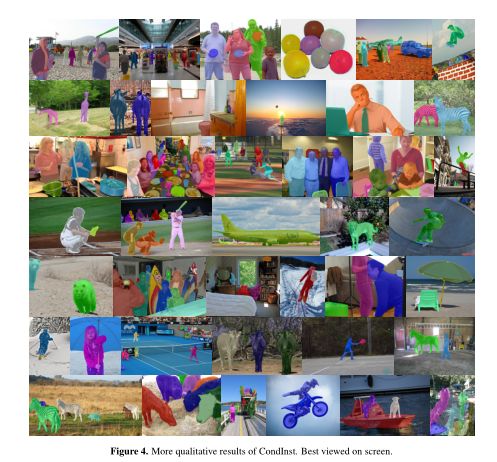

我们还将CondInst与最近提出的实例分割方法进行了比较。仅进行了一半的训练迭代,CondInst就大大超过了Tensor Mask [13](ResNet-50分别为38.8%和35.4%,ResNet-101为39.1%和37.1%)。 CondInst也比Tenso rMask快8倍(在相同GPU上,每个图像分别为49ms和380ms),性能相似(37.8%对37.1%)。而且,CondInst在使用相同的主干网ResNet-101时,在很大程度上优于YOLACT-700 [2](40.1%对31.2%并且都带有auxiliary语义分割任务)。而且,如图2所示,与YOLACT-700和Mask R-CNN相比,CondInst可以保留更多细节并产生更高质量的实例分割结果。图4显示了更多定性结果。

4、结论

我们提出了一个新的,更简单的实例分割框架,名为CondInst。与以前的方法(例如Mask R-CNN)使用固定权重的mask head不同,CondInst在实例上调节mask head并动态生成mask head的过滤器。这不仅降低了mask head的参数和计算复杂度,而且消除了ROI操作,从而实现了更快,更简单的实例分割框架。据我们所知,CondInst是第一个在准确性和速度上都可以胜过Mask R-CNN的框架,而无需更长的训练时间。我们认为,CondInst可以成为Mask R-CNN实例分割的一个强大的新选择。

图4. CondInst的定性结果,最好在屏幕上观看。

References

[1] S. Ioffe and C. Szegedy, “Batch normalization: Accelerating deep network training by reducing internal covariate shift,”arXiv preprint arXiv:1502.03167, 2015.

[2] D. Bolya, C. Zhou, F. Xiao, and Y . J. Lee, “YOLACT: real time instance segmentation,” in Proc. IEEE Int. Conf. Comp.Vis., pp. 9157–9166, 2019.

[3] K. He, G. Gkioxari, P . Dollár, and R. Girshick, “Mask R-CNN,” in Proc. IEEE Int. Conf. Comp. Vis., pp. 2961–2969,2017.

[4] A. Paszke et al., “PyTorch: An imperative style, high performance deep learning library,” in Proc. Advances in Neural Inf. Process. Syst., pp. 8024–8035, 2019.

[5] M. Abadi et al., “TensorFlow: A system for large-scale machine learning,” in USENIX Symp. Operating Systems Design & Implementation (OSDI), pp. 265–283, 2016.

[6] J. Long, E. Shelhamer, and T. Darrell, “Fully convolutional networks for semantic segmentation,” in Proc. IEEE Conf. Comp. Vis. Patt. Recogn., pp. 3431–3440, 2015.

[7] L.-C. Chen, G. Papandreou, I. Kokkinos, K. Murphy, and A. Y uille, “Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs,” IEEE Trans. Pattern Anal. Mach. Intell.,vol. 40, no. 4, pp. 834–848, 2017.

[8] Z. Tian, C. Shen, H. Chen, and T. He, “FCOS: Fully convolutional one-stage object detection,” in Proc. IEEE Int. Conf.Comp. Vis., pp. 9627–9636, 2019.

[9] F. Liu, C. Shen, G. Lin, and I. Reid, “Learning depth from single monocular images using deep convolutional neural fields,” IEEE Trans. Pattern Anal. Mach. Intell., 2016.

[10] L. Boominathan, S. Kruthiventi, and R. V . Babu, “Crowdnet: A deep convolutional network for dense crowd counting,” in Proc. ACM Int. Conf. Multimedia, pp. 640–644, ACM, 2016.

[11] X. Jia, B. De Brabandere, T. Tuytelaars, and L. V . Gool, “Dynamic filter networks,” in Proc. Advances in Neural Inf. Process. Syst., pp. 667–675, 2016.

[12] B. Yang, G. Bender, Q. V . Le, and J. Ngiam, “Condconv:Conditionally parameterized convolutions for efficient inference,” in Proc. Advances in Neural Inf. Process. Syst.,pp. 1305–1316, 2019.

[13] X. Chen, R. Girshick, K. He, and P . Dollár, “Tensormask: A foundation for dense object segmentation,” in Proc. IEEE Int. Conf. Comp. Vis., pp. 2061–2069, 2019.

[14] K. Chen, J. Pang, J. Wang, Y . Xiong, X. Li, S. Sun, W. Feng, Z. Liu, J. Shi, W. Ouyang, et al., “Hybrid task cascade for instance segmentation,” in Proc. IEEE Conf. Comp. Vis. Patt. Recogn., pp. 4974–4983, 2019.

[15] S. Liu, L. Qi, H. Qin, J. Shi, and J. Jia, “Path aggregation network for instance segmentation,” in Proc. IEEE Conf. Comp.Vis. Patt. Recogn., pp. 8759–8768, 2018.

[16] Z. Huang, L. Huang, Y . Gong, C. Huang, and X. Wang,“Mask scoring r-cnn,” in Proc. IEEE Conf. Comp. Vis. Patt.Recogn., pp. 6409–6418, 2019.

[17] J. Dai, K. He, Y . Li, S. Ren, and J. Sun, “Instance-sensitive fully convolutional networks,” in Proc. Eur . Conf. Comp. Vis., pp. 534–549, Springer, 2016.

[18] D. Neven, B. D. Brabandere, M. Proesmans, and L. V . Gool, “Instance segmentation by jointly optimizing spatial embeddings and clustering bandwidth,” in Proc. IEEE Conf. Comp. Vis. Patt. Recogn., pp. 8837–8845, 2019.

[19] A. Newell, Z. Huang, and J. Deng, “Associative embedding: End-to-end learning for joint detection and grouping,” in Proc. Advances in Neural Inf. Process. Syst., pp. 2277–2287,2017.

[20] A. Fathi, Z. Wojna, V . Rathod, P . Wang, H. O. Song,S. Guadarrama, and K. P . Murphy, “Semantic instance segmentation via deep metric learning,” arXiv: Comp. Res.Repository, 2017.

[21] H. Chen, K. Sun, Z. Tian, C. Shen, Y . Huang, and Y . Yan, “Blendmask: Top-down meets bottom-up for instance segmentation,” in Proc. IEEE Conf. Comp. Vis. Patt. Recogn.,2020.

[22] X. Wang, T. Kong, C. Shen, Y . Jiang, and L. Li, “SOLO:Segmenting objects by locations,” arXiv: Comp. Res. Repository, 2019.

[23] E. Xie, P . Sun, X. Song, W. Wang, D. Liang, C. Shen, and P . Luo, “PolarMask: Single shot instance segmentation with polar representation,” in Proc. IEEE Conf. Comp. Vis. Patt. Recogn., 2020.

[24] K. Sofiiuk, O. Barinova, and A. Konushin, “Adaptis: Adaptive instance selection network,” in Proc. IEEE Int. Conf.Comp. Vis., pp. 7355–7363, 2019.

[25] E. Perez, F. Strub, H. De Vries, V . Dumoulin, and A. Courville, “Film: Visual reasoning with a general conditioning layer,” in Proc. AAAI Conf. Artificial Intell., 2018.

[26] T.-Y . Lin, P . Dollár, R. Girshick, K. He, B. Hariharan,and S. Belongie, “Feature pyramid networks for object detection,” in Proc. IEEE Conf. Comp. Vis. Patt. Recogn.,pp. 2117–2125, 2017.

[27] T.-Y . Lin, M. Maire, S. Belongie, J. Hays, P . Perona, D. Ramanan, P . Dollár, and C. L. Zitnick, “Microsoft coco: Common objects in context,” in Proc. Eur . Conf. Comp. Vis.,pp. 740–755, Springer, 2014.

[28] S. Ren, K. He, R. Girshick, and J. Sun, “Faster R-CNN: To wards real-time object detection with region proposal networks,” in Proc. Advances in Neural Inf. Process. Syst.,pp. 91–99, 2015.

[29] K. He, X. Zhang, S. Ren, and J. Sun, “Spatial pyramid pooling in deep convolutional networks for visual recognition,” IEEE Trans. Pattern Anal. Mach. Intell., vol. 37, no. 9,pp. 1904–1916, 2015.

[30] X. Zhou, D. Wang, and P . Krähenbühl, “Objects as points,”arXiv: Comp. Res. Repository, 2019.

[31] F. Milletari, N. Navab, and S.-A. Ahmadi, “V-net: Fully convolutional neural networks for volumetric medical image segmentation,” in Proc. Int. Conf. 3D Vision (3DV), pp. 565–571, IEEE, 2016.

[32] T.-Y . Lin, P . Goyal, R. Girshick, K. He, and P . Dollár, “Focal loss for dense object detection,” in Proc. IEEE Conf. Comp.Vis. Patt. Recogn., pp. 2980–2988, 2017.

[33] K. He, X. Zhang, S. Ren, and J. Sun, “Deep residual learning for image recognition,” in Proceedings of the IEEE conference on computer vision and pattern recognition, pp. 770–778, 2016.

[34] J. Deng, W. Dong, R. Socher, L.-J. Li, K. Li, and L. FeiFei, “Imagenet: A large-scale hierarchical image database,”in Proc. IEEE Conf. Comp. Vis. Patt. Recogn., pp. 248–255,Ieee, 2009.

[35] Y . Wu, A. Kirillov, F. Massa, W.-Y . Lo, and R. Girshick, “Detectron2.” https://github.com/facebookresearch/detectron2, 2019.

[36] K. He, R. Girshick, and P . Dollár, “Rethinking imagenet pretraining,” in Proc. IEEE Int. Conf. Comp. Vis., pp. 4918–4927, 2019.