读书笔记-Coordinated Deep Reinforcement Learners for Traffic Light Control

Coordinated Deep Reinforcement Learners for Traffic Light Control

本文研究了交通灯的学习控制策略。在交通灯控制问题引入了一种新的奖励函数,并提出了将DQN算法 与 传输规划transfer planning相结合的多代理深度强化学习方法。通过使用传输规划,它避免了之前多代理强化学习中存在的问题,并且允许更快和更可扩展的学习。它优于早期关于多代理交通灯控制的工作,但DQN算法可能会发生振荡,需要进行更多的研究以防止DQN不稳定。

背景

将RL应用于交通灯控制的一个难题是选择特征:状态的数量是巨大的,每个状态描述交叉点周围的确切情况。

我们对单交叉DQN方法【15】进行了修改,并研究了奖励函数的有效表达式。

为了提高训练过程的稳定性,我们测试了在交通控制背景下深度学习领域中一些最新技术的效果【22,5,17】。

此外,我们提出了使用这些技术来协调多交叉口的方法。

有两种方法来稳定DQN算法:

第一种是经验重放【10,14】,其中采样数据点

第二种解决方案是 target network freezing【12】,其中Q-value估计被分成两个不同的网络,一个用于估计当前状态的Q(s,a)的值网络value network, 一个计算目标y 的目标网络target network 。

交通灯控制 - 深度强化学习DQN

STATE

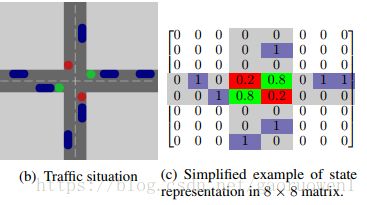

我们使用类似图像image-like的表示来表示交叉口周围的状态,如图b示。

在之前的工作【15】中,由交通灯控制的车道上车辆位置的二元矩阵表示状态,如图c示。

因此,卷积神经网络应该能够识别交通堵塞。

在当前模型中,交通灯颜色的表示使用数字来映射。

交通灯信息将是状态空间的额外层,每个交通灯颜色都具有二进制特征。

但是,这会随着状态空间的增加导致replay memory的内存问题,以及较慢的计算。

ACTION

在每个时间步,代理采取的动作在两种不同的交通灯配置间进行选择。代理选择哪个车道获得绿灯。

TRANSITION

从 s t s_t st 到 s t + 1 s_{t + 1} st+1 的转换由SUMO隐式定义,取决于 a t a_t at和模拟中的汽车。

REWARD

为交通灯控制问题定义反馈信号并不明确

一个好的指标是旨在减少行驶时间。然而,车辆的平均行驶时间在完成其路线之前无法计算,这导致奖励极度延迟的问题。

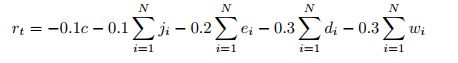

因此,将标准进行不同权重的组合,迭代交叉口周围的车辆。其中i是车辆索引,N是代理控制的车道上的车辆数量:

运输惩罚 penalties for teleports j (表示SUMO中的车祸或拥堵)

紧急停止e(减速度超过 4.5 m / s 2 4.5m/s^2 4.5m/s2)

灯光配置是否已更改 c(布尔变量,以防止闪烁flickering)

车辆的延误 d=1 - (vehivle speed / allowed speed)

车辆的等待时间 w

Learning stability

使用上述状态描述和奖励函数,我们研究了“未调整的DQN算法”的性能。结果显示如下,其显示了在每10,000个时间步后的奖励和平均旅行时间。

这清楚地表明,DQN算法虽然很快就能遇到好的策略,但训练曲线中出现大幅振荡。这种不稳定性可能是灾难性忘却catastrophic forgetting 造成的【11】,这是阻碍神经网络技术不断进步的最大绊脚石,即学习解决新任务会导致系统忘记早期的学习结构。另一方面,Q学习中的函数逼近不能保证收敛。

于是,测试了许多不同的参数设置,并使用了优先级经验重放机制。

除此之外还测试了Double DQN(DDQN)算法在交通问题上的表现。但是DDQN似乎陷入局部最小值。还尝试使用批量标准化Batch Normalization【5】,发现批量标准化会导致分歧divergence。可见还需要更多的研究来解决在这些算法中遇到的问题。

协作深度强化学习

通过利用 transfer planning【13】 和 ** max-plus coordination algorithm**【6】将单代理DQN扩展到多代理,并在不同的流量场景下评估该方法。

方法

为了在多个代理之间进行协调,我们遵循早期的工作【4,6】并将全局Q函数定义为局部问题的线性组合,其中e对应于邻居代理的子集。

![]()

然后,我们使用max-plus协调算法 【6】来优化联合全局动作。

与前面提到的方法【4,6】相反,使用转移计划transfer planning【13】的变体找到函数Qe。

在transfer planning中,我们为一个多代理问题的子问题学习Q函数。如果源问题和其他子问题相似,那么我们可以在较大的多代理问题中为每个子问题重用源问题的Q函数,而不是为每个单独的子问题训练Q函数。换句话说,与早期的工作【4,6】不同,transfer planning不会尝试最小化Q的全局近似误差。

这种transfer planning方法避免了之前多代理强化学习中存在的两个问题。第一个是多个代理同时学习和行动导致环境的不平稳性。通过对源问题进行训练,环境动态在学习过程中不会发生变化。第二个是同时培训许多代理的成本。因为源问题是独立的,所以它们可以独立地(例如顺序地)解决。此外,我们利用源问题的对称性,进一步降低了计算成本。

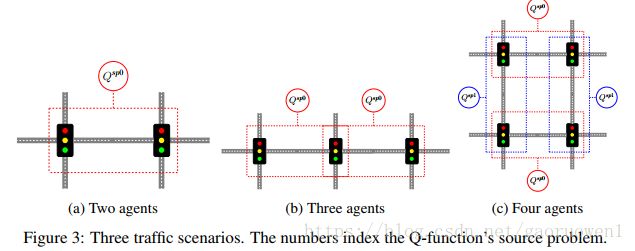

例如,在图3a中的两个代理源问题上训练DQN代理以获得Qsp0,并且使用旋转版本来获得Qsp1,然后使用transfer planning来解决图3b和3c中的多代理问题。

作为对比实验,使用早期算法Wiering 【23】及多代理扩展Kuyer【8】。我们使用Wiering算法来学习双代理方案的策略,然后使用transfer planning和max-plus将他们组合以获得类似于Kuyer的算法。

结果显示DQN方法在大多数情况下优于Wiering / Kuyer方法,但它由于不稳定性有时表现不佳。

[15] Tobias Rijken. DeepLight: Deep reinforcement learning for signalised traffic control, 2015.

[17] Tom Schaul, John Quan, Ioannis Antonoglou, and David Silver. Prioritized experience replay. ICLR 2016, 2016.

[12] Volodymyr Mnih, Koray Kavukcuoglu, David Silver, Andrei A Rusu, Joel Veness, Marc G

Bellemare, Alex Graves, Martin Riedmiller, Andreas K Fidjeland, Georg Ostrovski, et al.

Human-level control through deep reinforcement learning. Nature, 518(7540):529–533, 2015.

[5] Sergey Ioffe and Christian Szegedy. Batch normalization: Accelerating deep network training by reducing internal covariate shift. arXiv preprint arXiv:1502.03167, 2015.

[22] Hado van Hasselt, Arthur Guez, and David Silver. Deep reinforcement learning with double Q-learning. CoRR, abs/1509.06461, 2015.

[4] Carlos Guestrin, Michail Lagoudakis, and Ronald Parr. Coordinated reinforcement learning. In ICML, volume 2, pages 227–234, 2002.

[6] Jelle R Kok and Nikos Vlassis. Using the max-plus algorithm for multiagent decision making in coordination graphs. In Robot Soccer World Cup, pages 1–12. Springer, 2005.

[13] Frans A Oliehoek, Shimon Whiteson, and Matthijs TJ Spaan. Approximate solutions for factored Dec-POMDPs with many agents. In Proceedings of the 2013 international conference on Autonomous agents and multi-agent systems, pages 563–570. International Foundation for Autonomous Agents and Multiagent Systems, 2013.

[23] Marco Wiering et al. Multi-agent reinforcement learning for traffic light control. In ICML, 2000

[8] Lior Kuyer, Shimon Whiteson, Bram Bakker, and Nikos Vlassis. Multiagent reinforcement learning for urban traffic control using coordination graphs. In Joint European Conference on Machine Learning and Knowledge Discovery in Databases, pages 656–671. Springer, 2008.