Jenkins 持续集成十六(基于 K8S 构建 Jenkins 持续集成平台一)

文章目录

- 一、Jenkins 的 Master-Slave 分布式构建

-

- 1. 什么是 Master-Slave 分布式构建

- 2. 如何实现 Master-Slave 分布式构建

-

- 2.1 开启代理程序的 TCP 端口

- 2.2 新建节点

- 2.3 slave1 操作

- 2.4 自由风格项目测试

- 2.5 流水线项目测试

- 二、K8S 实现 Master-Slave 分布式构建方案

-

- 1. 传统 Jenkins 的 Master-Slave 方案的缺陷

- 2. Kubernates 简介

- 3. K8S + Docker + Jenkins 持续集成架构图

- 4. K8S + Docker + Jenkins 持续集成方案好处

- 三、集群环境搭建

-

- 1. 所需虚拟机

- 2. K8S 环境安装

-

- 2.1 修改三台机器的 hostname 及 hosts 文件

- 2.2 关闭防火墙,selinux,swap

- 2.3 设置系统参数,加载 br_netfilter 模块

- 2.4 设置允许路由转发,不对 bridge 的数据进行处理

- 2.5 安装 docker

- 2.6 kube-proxy 开启 ipvs 的前置条件

- 2.7 设置 yum 安装源

- 2.8 安装 K8S(三个节点)

- 2.9 部署 Master 节点

- 2.10 node 节点加入集群

- 2.11 安装 Calico 网络插件(master 节点)

- 2.12 node 节点启动 kubelet

- 3. kubectl 常用命令

一、Jenkins 的 Master-Slave 分布式构建

1. 什么是 Master-Slave 分布式构建

Jenkins 的 Master-Slave 分布式构建,就是通过将构建过程分配到从属 Slave 节点上,从而减轻 Master 节点的压力,而且可以同时构建多个,有点类似负载均衡的概念。

Jenkins 集群不同于 redis 集群(redis 集群是去中心化的,失效一个节点其他的还能用),Jenkins 集群是 master-slave 的形式,Jenkinsmaster 负责中心调度,如果 master 是单节点,其发生故障后集群就失去了功能。所以我们用 K8S 部署 Jenkins 集群,Jenkins 以 Pod 的形式存在,这样 master 就具有了自愈功能。

2. 如何实现 Master-Slave 分布式构建

先不使用 K8S 集群方式,使用裸金属形式集群

2.1 开启代理程序的 TCP 端口

Manage Jenkins -> Configure Global Security

2.2 新建节点

Manage Jenkins -> Manage Nodes -> 新建节点

点击 slave1

下载的 agent.jar 需要上传到 slave1

2.3 slave1 操作

192.168.10.116

[root@c7-6 ~]#mkdir /root/jenkins

[root@c7-6 ~]#yum -y install git &> /dev/null

[root@c7-6 ~]#rz -E

rz waiting to receive.

[root@c7-6 ~]#ll

总用量 1488

-rw-r--r-- 1 root root 1522173 3月 7 15:56 agent.jar

drwxr-xr-x 2 root root 6 3月 7 15:10 jenkins

[root@c7-6 ~]#yum install java-1.8.0-openjdk* -y

......

[root@c7-6 ~]#java -version

......

[root@c7-6 ~]#java -jar agent.jar -jnlpUrl http://192.168.10.30:8888/computer/slave1/jenkins-agent.jnlp -secret 84da3507a13a1c6b65a83fff1352dc14c85579dad83c3feaea4b1fc802039a11 -workDir "/root/jenkins"

......

三月 07, 2022 4:09:01 下午 hudson.remoting.jnlp.Main$CuiListener status

信息: Remote identity confirmed: 12:9d:a7:ef:1b:c6:ea:20:4f:44:c3:e4:84:4a:fb:c0

三月 07, 2022 4:09:01 下午 hudson.remoting.jnlp.Main$CuiListener status

信息: Connected

非阻塞式启动:nohup ... &

2.4 自由风格项目测试

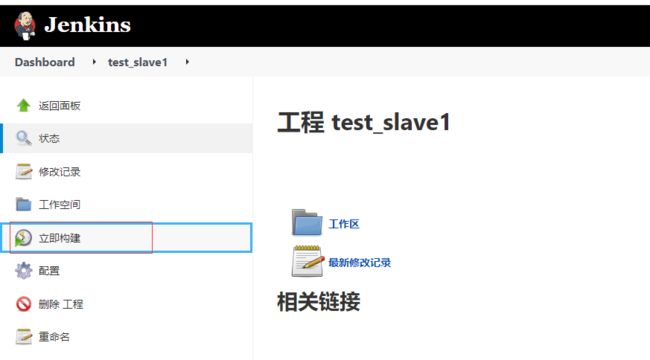

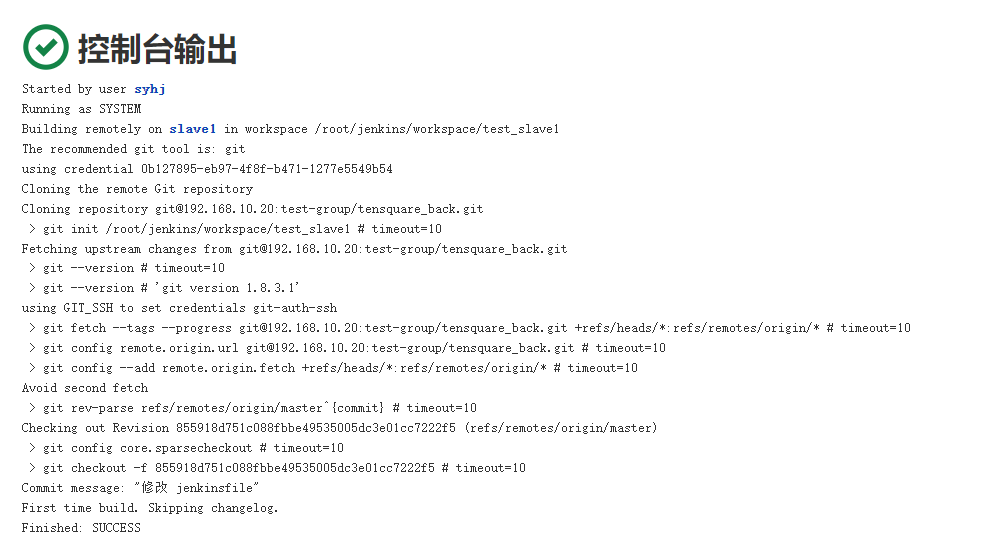

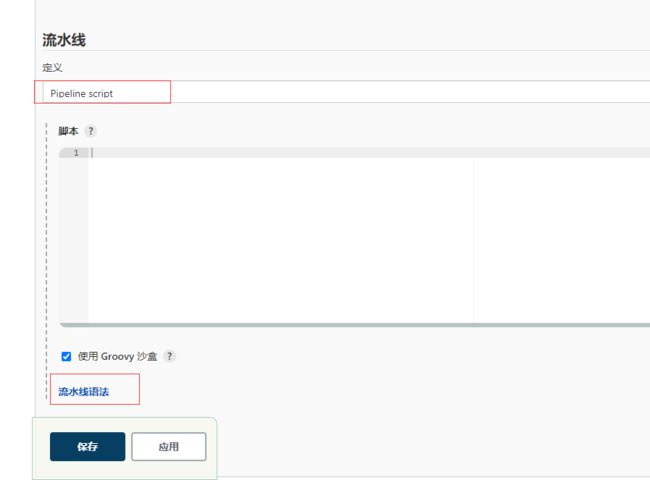

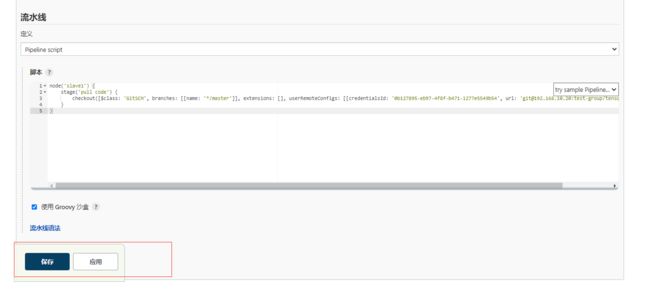

2.5 流水线项目测试

node('slave1') {

stage('pull code') {

checkout([$class: 'GitSCM', branches: [[name: '*/master']], extensions: [], userRemoteConfigs: [[credentialsId: '0b127895-eb97-4f8f-b471-1277e5549b54', url: '[email protected]:test-group/tensquare_back.git']]])

}

}

二、K8S 实现 Master-Slave 分布式构建方案

1. 传统 Jenkins 的 Master-Slave 方案的缺陷

- Master 节点发生单点故障时,整个流程都不可用了。

- 每个 Slave 节点的配置环境不一样,来完成不同语言的编译打包等操作,但是这些差异化的配置导致管理起来非常不方便,维护起来也是比较费劲。

- 资源分配不均衡,有的 Slave 节点要运行的 job 出现排队等待,而有的 Slave 节点处于空闲状态。

- 资源浪费,每台 Slave 节点可能是实体机或者 VM,当 Slave 节点处于空闲状态时,也不会完全释放掉资源。

以上种种问题,我们可以引入 Kubernates 来解决!

2. Kubernates 简介

Kubernetes(k8s)服务介绍

3. K8S + Docker + Jenkins 持续集成架构图

大致工作流程:

手动/自动构建 -> Jenkins 调度 K8S API -> 动态生成 Jenkins Slave pod -> Slave pod 拉取 Git 代码/编译/打包镜像 -> 推送到镜像仓库 Harbor -> Slave 工作完成,Pod 自动销毁 -> 部署到测试或生产 Kubernetes 平台。(完全自动化,无需人工干预)

4. K8S + Docker + Jenkins 持续集成方案好处

服务高可用:当 Jenkins Master 出现故障时,Kubernetes 会自动创建一个新的 Jenkins Master 容器,并且将 Volume 分配给新创建的容器,保证数据不丢失,从而达到集群服务高可用。动态伸缩,合理使用资源:每次运行 Job 时,会自动创建一个 Jenkins Slave,Job 完成后,Slave 自动注销并删除容器,资源自动释放,而且 Kubernetes 会根据每个资源的使用情况,动态分配 Slave 到空闲的节点上创建,降低出现因某节点资源利用率高,还排队等待在该节点的情况。扩展性好:当 Kubernetes 集群的资源严重不足而导致 Job 排队等待时,可以很容易的添加一个 Kubernetes Node 到集群中,从而实现扩展。

三、集群环境搭建

1. 所需虚拟机

| 主机名称 | IP 地址 | 安装的软件 |

|---|---|---|

| 代码托管服务器 | 192.168.10.20 | Gitlab-12.4.2 |

| Docker 仓库服务器 | 192.168.10.40 | Harbor1.9.2 |

| k8s-master | 192.168.10.100 | kube-apiserver、kube-controller-manager、kube- scheduler、docker、etcd、calico,NFS |

| k8s-node1 | 192.168.10.101 | kubelet、kubeproxy、Docker18.06.1-ce |

| k8s-node2 | 192.168.10.102 | kubelet、kubeproxy、Docker18.06.1-ce |

保留 Gitlab 和 harbor 服务器,其他的挂起。

2. K8S 环境安装

2.1 修改三台机器的 hostname 及 hosts 文件

hostname

hostnamectl set-hostname k8s-master && su

hostnamectl set-hostname k8s-node1 && su

hostnamectl set-hostname k8s-node2 && su

/etc/hosts

cat >>/etc/hosts<<EOF

192.168.10.100 k8s-master

192.168.10.101 k8s-node1

192.168.10.102 k8s-node2

EOF

2.2 关闭防火墙,selinux,swap

systemctl stop firewalld && systemctl disable firewalld

setenforce 0

swapoff -a

2.3 设置系统参数,加载 br_netfilter 模块

modprobe br_netfilter

2.4 设置允许路由转发,不对 bridge 的数据进行处理

cat >>/etc/sysctl.d/k8s.conf <<EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

net.ipv4.ip_forward = 1

vm.swappiness = 0

EOF

sysctl -p /etc/sysctl.d/k8s.conf

2.5 安装 docker

wget https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo -O /etc/yum.repos.d/docker-ce.repo

yum -y install epel-release && yum clean all && yum makecache #如果无法安装docker再执行

yum -y install docker-ce-18.06.1.ce-3.el7 #版本可自选,该版本比较稳定

# yum install docker-ce-20.10.7 docker-ce-cli-20.10.7 containerd.io -y

systemctl start docker && systemctl enable docker

mkdir /etc/docker

cat > /etc/docker/daemon.json << EOF

{

"registry-mirrors": ["https://b9pmyelo.mirror.aliyuncs.com"]

}

EOF

systemctl restart docker

2.6 kube-proxy 开启 ipvs 的前置条件

cat > /etc/sysconfig/modules/ipvs.modules <<EOF

#!/bin/bash

modprobe -- ip_vs

modprobe -- ip_vs_rr

modprobe -- ip_vs_wrr

modprobe -- ip_vs_sh

modprobe -- nf_conntrack_ipv4

EOF

chmod 755 /etc/sysconfig/modules/ipvs.modules && bash /etc/sysconfig/modules/ipvs.modules && lsmod | grep -e ip_vs -e nf_conntrack_ipv4

2.7 设置 yum 安装源

cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

2.8 安装 K8S(三个节点)

yum install -y kubelet-1.17.0 kubeadm-1.17.0 kubectl-1.17.0

systemctl enable kubelet

2.9 部署 Master 节点

初始化 kubeadm

kubeadm init \

--kubernetes-version=1.17.0 \

--apiserver-advertise-address=192.168.10.100 \

--image-repository registry.aliyuncs.com/google_containers \

--service-cidr=10.1.0.0/16 \

--pod-network-cidr=10.244.0.0/16

启动 kubelet

systemctl restart kubelet

配置 kubectl 工具

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

2.10 node 节点加入集群

2.11 安装 Calico 网络插件(master 节点)

wget --no-check-certificate https://docs.projectcalico.org/v3.10/getting-started/kubernetes/installation/hosted/kubernetes-datastore/calico-networking/1.7/calico.yaml

sed -i 's/192.168.0.0/10.244.0.0/g' calico.yaml

kubectl apply -f calico.yaml

查看所有 Pod 的状态,确保所有 Pod 都是 Running 状态

kubectl get pod --all-namespaces -o wide

2.12 node 节点启动 kubelet

systemctl start kubelet

3. kubectl 常用命令

kubectl get nodes #查看所有主从节点的状态

kubectl get ns #获取所有 namespace 资源

kubectl get pods -n {$nameSpace} #获取指定 namespace 的 pod

kubectl describe [pod的名称] -n {$nameSpace} #查看某个 pod 的执行过程

kubectl logs --tail=1000 [pod的名称] | less #查看日志

kubectl apply -f xxx.yml #通过配置文件创建一个集群资源对象

kubectl delete -f xxx.yml #通过配置文件删除一个集群资源对象