图像检测:医疗影像分割

医学影像

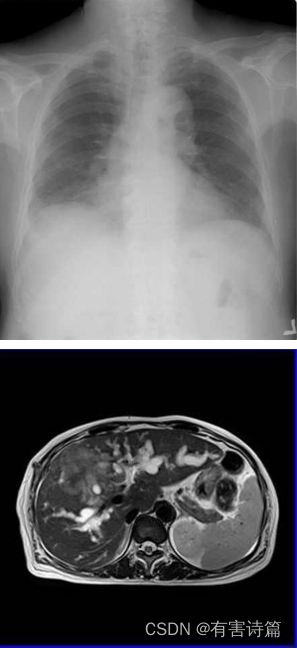

X线设备:是通过测量透过人体的X线来实现人体成像的,即利用人体各组织的密度和厚度不同,X线穿过后的衰减程度不同,来显示身体内部的形态影像。

磁共振成像设备:是通过测量构成人体组织元素的原子核发出的磁共振信号来实现人体成像。MRI可反映人体分子水平的生理、生化等方面的功能特性。

超声成像设备:分为利用超声口波进行探测、超声诊断仪根据其显示方式不同,可分为A型、B型、D型(多普勒成像)、M型等。

医用内镜:是能够直观地观察人体内部器官的形态的设备,相对其他影像设备其诊断准确性更高。最常见的有光导纤维内镜和电子内镜。

计算机断层扫描(CT),根据所采用的射线不同可分为:X射线CT(X-CT)、超声CT. (UCT)以及y射线CT (y-CT)等。

标题磁共振成像技术

常规MRI检查(常规MR成像序列):是指以常规T1WI和T2WI为主的磁共振成像技术,主要显示人体器官或组织的形态结构及其信号强度变化。

超快速成像序列的MRI检查,能够评价器官的功能状态,揭示生物体内的生理学信息,统称为功能磁共振成像,或功能性成像技术。

这些技术中就包括弥散加权成像(DWI)技术。弥散( diffusion)是描述水和其他小分子随机热运动(即布朗运动)的术语,水分子的净移动可通过表观弥散系数(ADC)描述。

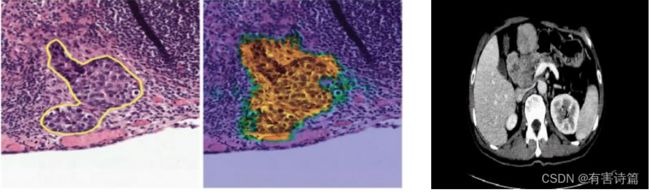

影像分割的目标

对医学、生物影像中的器官、组织或细胞进行分割,即判断出影像中的每一个像素点是否属于器官、组织或细胞。

主流存储方式

DICOM(医学数字成像和通信标准)是Digital Imaging and Communications inMedicine的英文循与。

DICOM被广泛应用于放射医疗,心血管成像以及放射诊疗诊断设备(X射线,CT,核磁共振,超声等)。

DICOM标准的推出与实现,大大简化了医学影像信息交换的实现,推动了远程放射学系统、图像管理与通信系统(PACS)的研究与发展,并且由于DICOM的开放性与互联性,使得与其它医学应用系统(HIS、RIS等)的集成成为可能。

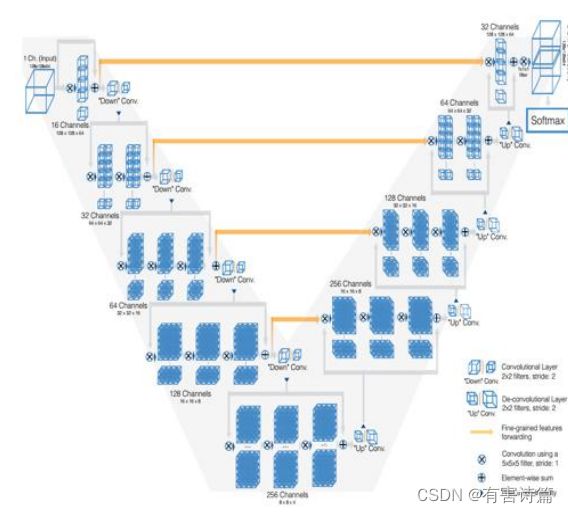

U-Net

曲率驱动的图像降噪

在图像去噪领域,由于高斯低通滤波对图像所有高频成分不加区别地减弱,从而在去噪的同时也使边缘模糊化。自然图像中的物体所形成的等照度线(包括边缘)应该是足够光顺的曲线,即这些等照度线的曲率的绝对值应该足够小.当图像受到噪音污染后,图像的局部灰度值发生随机起伏,导致等照度线的不规则振荡,形成局部曲率很大的等照度线。根据这一原理,可以进行图像去噪。

U-Net详解

U-Net是一种用于生物影像分割的深度学习模型,它是一个全卷积神经网络,输入和输出都是图像,没有全连接层。

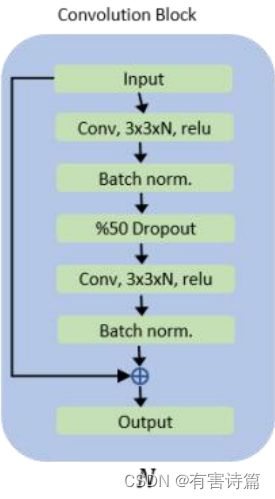

卷积块

目标函数-Dice系数

Dice距离用于度量两个集合的相似性。可用于计算两个字符串的相似度和图形掩码区域的差异。在形式上,Dice系数和Jaccard指数(A交B除以A并B)没多大区别,可以互相之间进行转换。

Dice系数的取值范围为0到1。

用于图像分割的数据增强

原始数据集仅有几十例,远不足以训练7层U-Net这样具有5000w个参数的深层次网络。需要使用数据增强技术。

弹性变形

在原有点阵上,叠加正负向随机距离形成“插值位置”矩阵,然后计算每个插值位置上的灰度,形成新的点阵,可实现图像的扭曲变形。

U-Net 未能解决的问题

- 组织器官的顶层截面和底层截面与中部截面差异过大而不易识别

- 不同扫描影像之间有较大的外观变异而不易识别

- 磁场不均匀性引起的伪影和畸变,导致不易识别

3D U-Net

3维影像数据在生物医学数据分析中广泛存在,但这样的数据与分割标签的注释却很困难。因此,以逐片方式对大量3维影像进行注释是繁琐的而低效的,因为相邻的切片显示几乎相同的信息。3D影像数据的完全标注不是创建丰富训练数据集的有效方法。

3维影像数据在生物医学数据分析中广泛存在,训练一个网络,希望能利用3维影像的标注信息。

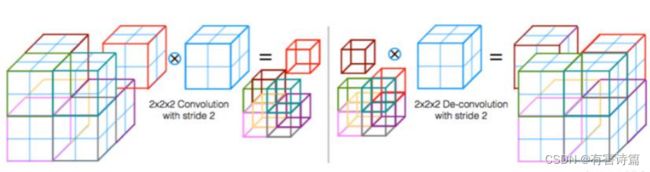

**3D U-NET网络以3D数据作为输入,并用相应的操作来处理数据,包括3D卷积、3D最大池和3D向上卷积层。

假设输入数据的大小为al × a2 × a3,通道数为c,过滤器大小为f,即过滤器维度为f ×f ×f × c,过滤器数量为n。则三维卷积最终的输出为( al -f+1)×( a2- f+1)×( a3 - f+1)×n。

**

包括用于分析整个影像的收缩编码器部分和连续扩展的解码器部分以产生全分辨率分割。与二维的U-Net一样,它具有分析路径和合成路径,该架构总共有19069955个参数。

在分析路径中,每一层包含两个3×3×3个卷积,每一个跟随一个Relu激活函数,然后在每个维度上有2×2×2最大池合并两个步长

在合成路径中,每个层有2×2×2的上卷积组成,每个维度上步长均为2,接着是两个3×3×3个卷积,然后是Relu

在分析路径中从相等分辨率层的shortcut连接提供了合成路径的基本高分辨率特征。

在最后一层中,1×1×1卷积减少了输出通道的数量,标签的数量是3。

V-Net

V-Net是U-Net的另一个3D版本。

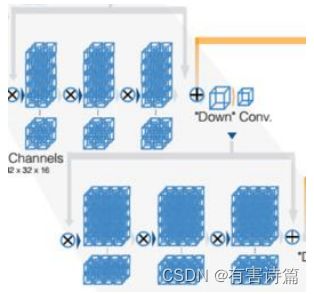

它是基于3D卷积的3D图像分割;基于Dice系数的新型目标函数;改进数据扩展方法;加入残差学习提升收敛。

⊙代表卷积核为555,stride为1的卷积。

每个stage的末尾使用卷积核为222,stride为2的卷积,特征大小缩小一半。⊕代表按元素相加。卷积后的小三角代表"PReLU”,是指增加了参数修正的ReLU。

网络末尾加一个111的卷积,处理成与输入一样大小的数据,然后接一个softmax最

Softmax之后,输出由背景和前景的概率图组成。

具有较高概率(>0.5)的体素属于前景,而不是背景,被认为是组织器官的一部分。

残差学习机制:V-Net学习了U-Net的思想,把缩小端的底层特征送入放大端的相应位置帮助重建高质量图像,并且加速模型收敛。每一个stage中也使用了跃层连接。

可以使用适当步幅(大于1)的3D卷积来减小数据的大小。反之,逆卷积通过将每个输入体素通过内核投影到更大的区域来增大数据的尺寸。

DenseNet

前些年卷积神经网络提高效果的方向:要么深,比如ResNet,解决了网络深时的梯度消失问题;要么宽,比如GoogleNet的Inception。而DenseNet则是从feature入手,通过对feature的极值利用达到更好的效果和更少的参数。

DenseNet的几大优点

- 减轻了梯度消失

- 加强了feature的传递性,更有效地利用了feature

- 一定程度上减少了参数数量

- 强调参数有效性,参数使用率高

- 隐式深层监督,short paths

- 抗过拟合,尤其是训练数据匮乏时

与传统的卷积神经网络不同,在DenseNet中,L层网络会产生L(L+1)/2个连接。简单的说:就是每一层的输入来自前面所有层的输出。

如图:X0是input,H1的输入时X0(input),H2的输入是X0和X1,以此类推。

FC-DenseNet

在下图中,使用Dense block和transition up替换FC上采样的卷积操作。Transition up 使用转置卷积上采样特征图,与跳层传来的特征串联,生成新的dense block的输入。但这样会带来特征图数目的线性增长,为了解决这个问是题,dense block的输入不与它的输出串联。同时引入跳层解决之前dense block特征损失的问题

dense block结构如下图,令第一层输入x有m个特征图第一层输出x有k个特征图,这k个特征图与m个特征图串联,作为第二层的输入,如此重复n次;

第n层的layer层输出后与前面的layer输出合并,共有n×k个特征图。