【图像超分辨率】MSAN:Scene-Adaptive RS Img SR a Multiscale Attention

MSAN:Scene-Adaptive Remote Sensing Image Super-Resolution Using a Multiscale Attention Network

-

- 摘要

- I 介绍

- III. 方法

-

- A. 用于遥感图像超分辨率的MSAN模型的结构

- B. 多尺度激活特征融合块(MAFB)

-

- 1) 多尺度激活模块。

- 2) 注意模块。

- C. 场景适应性框架描述

-

- 1) 转移学习

- 2)重构

摘要

遥感图像超分辨率一直是研究的重点,近年来提出了许多基于深度学习的算法。然而,由于遥感图像的结构往往比自然图像的结构更加复杂,因此遥感图像的超分辨率仍然存在一些困难。首先,很难用同一个模型来描述不同场景的高分辨率(HR)和低分辨率(LR)图像之间的非线性映射。其次,遥感图像中地面物体的尺度范围很广,单尺度卷积很难有效提取各种尺度的特征。为了解决上述问题,我们提出了一个多尺度注意网络(MSAN)来提取遥感图像的多层次特征。MSAN的基本组成部分是多尺度激活特征融合块(MAFB)。此外,还采用了遥感图像的场景适应性超分辨率策略来更准确地描述不同场景的结构特征。在几个数据集上进行的实验证实,所提出的算法在评价指标和视觉结果上都优于其他最先进的算法。

I 介绍

与自然图像相比,遥感图像的结构更为复杂。首先,遥感图像通常具有更大的图像宽度,并包含各种不同的场景,如建筑物、农田、森林和机场。一幅完整的遥感图像可以由许多不同的场景组成,而这些场景的纹理和结构信息又有很大不同,导致不同场景的HR和LR图像之间的映射关系不一致。其次,遥感图像中的地面物体的尺度差别很大。例如,飞机和车辆等物体在遥感图像中只占几个像素,这与自然图像有很大不同。因此,用同一个超分辨率模型很难准确地重建不同场景的图像,而且单尺度卷积不能很好地提取不同尺度的特征。

目前,许多基于深度学习的遥感图像超分辨率框架已经被开发出来[25]-[27]。虽然这些方法可以达到令人满意的效果,但在某种程度上,它们往往忽略了遥感图像的结构信息[28],而且没有考虑不同场景下的潜在视觉信息性。因此,为了从海量遥感图像中提取更多有用的知识,需要开发一种更适合于遥感图像的方法,并能利用遥感图像中不同场景之间的结构信息。在这篇文章中,我们提出了一个新的框架,用不同类别场景的遥感图像训练一个深度神经网络,以获得不同的超分辨率模型,以适应各种场景的遥感图像。还提出了一个多尺度注意网络(MSAN),以表征遥感图像的多层次结构特征。在这篇文章中,我们首次提出了一个多尺度激活模块,然后在后面增加了一个通道注意模块。我们的工作贡献可以总结为三个方面。

-

多尺度激活特征融合块(MAFB)。我们开发了一个新的MAFB作为MSAN的基本组成部分。受文献[29]中宽幅激活策略的启发,在本文中,我们首先提出了一个多尺度激活模块,在整流线性单元(ReLU)激活层之前扩大特征图的数量,在每个MAFB中同时提取多层次的特征。 在融合了不同尺度的特征图后,后面又增加了一个通道注意模块,以进一步自适应地利用多个尺度的特征中的有效信息。

-

场景自适应策略。我们建立了一个超级分辨率模型数据库,通过迁移学习适应遥感图像的不同场景;针对航空图像数据集(AID)30]数据集中包含的30个不同场景的遥感图像,共训练了30个网络模型,该数据集主要用于航空场景分类任务。因此,在这个模型数据库的基础上,经过场景匹配,可以对遥感图像进行场景适应性重建。

-

我们通过对比实验分析了遥感图像中不同场景之间的不相似性。此外,在AID数据集和其他遥感图像数据集(包括吉林一号卫星图像和马萨诸塞州道路和建筑检测数据集)上获得的实验结果都证实了所提方法的满意表现。

本文的其余部分组织如下。第二节介绍了现有的SISR方法。第三节描述了拟议的MSAN的框架和模型的细节。第四节给出了用AID数据集、吉林一号卫星图像和马萨诸塞州道路和建筑检测数据集得到的模拟实验结果,以及讨论。最后,我们在第五节中提出了这项工作的结论。

III. 方法

如第一节所述,由于遥感图像结构复杂,遥感图像超分辨率存在两个主要困难。

首先,对于遥感图像中多样化的场景对象,其高频信息的联合分布模式差异很大,因此,不同场景之间的高低映射关系往往不一致,这样就很难用同一模型重建不同场景的遥感图像。

其次,由于遥感图像中的目标往往具有很宽的尺度,应考虑到图像的局部纹理信息和全局特征分布。因此,与自然图像相比,学习多层次的特征并执行特征表达具有重要意义。

为了解决上述问题,在WDSR架构的基础上,我们首先对其进行了优化,提出了一个新的多尺度激活特征融合RB,称为MAFB。在每个MAFB中,我们将一个多尺度激活模块和一个通道关注模块结合在一起。然后,开发了一个用于遥感图像超分辨率的场景适应性框架。在这一部分,我们将详细描述所提出的MSAN模型和场景自适应策略。

A. 用于遥感图像超分辨率的MSAN模型的结构

如图1所示,包括完整的网络结构和新的RB MAFB,分别如图1(a)和(b)所示。MSAN的整体结构由两部分组成。1) the identity mapping 和 2) the residual body。对于the identity mapping分支,我们利用原始的5×5的卷积层来提取LR特征,并保留上采样层与WDSR的subpixel卷积。

在本文中,我们旨在从LR输入中恢复超分辨率遥感图像,如下所示。

![]()

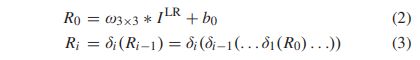

其中F是端到端网络学习的映射,I LR∈RH×W×c代表LR输入,I SR∈Rs H×sW×c代表SR输出,s是比例因子。假设在剩余分支中有N个MAFB,第一个和第i个(i∈[1,N])块的输入可以定义为

其中ω和b分别代表滤波器和偏置,下标代表核大小,δ代表每个MAFB的函数。ω3×3的大小为c×3×3×n,其中c=3代表输入LR图像的RGB通道,n是输出特征图的数量。

B. 多尺度激活特征融合块(MAFB)

MAFB是在多尺度激活模块、特征融合瓶颈层和通道关注模块的基础上发展起来的,如图1(b)所示。

1) 多尺度激活模块。

由于WDSR已经证明,在ReLU激活前扩展特征图有助于提高网络的性能,因此,在本文中,我们首先提出多尺度激活模块。我们通过在每个MAFB的ReLU激活前增加一个多尺度卷积模块,将宽泛的激活策略扩展到多尺度激活,以扩大不同尺度的特征图数量,同时提取不同场景在多个尺度上的类间分集,如图1(b)所示。多尺度卷积滤波器的核大小分别为3×3、5×5和7×7。多尺度卷积模块有能力在不同层次上描述输入LR图像的背景和纹理信息,并能提高网络的表示能力。

由于多尺度卷积操作具有不同大小的感受野,在通过几个RB后可以处理长期的依赖关系。此外,通过三种核大小的组合,可以获得多层次的特征和更大的感受野,从而可以同时捕捉到遥感图像中不同场景的局部和全局分布的联合信息。我们的MAFB中的多尺度卷积模块可以表述为

我们将三个卷积的输出特征图串联起来,然后应用ReLU函数

![]()

其中σ (-) 表示非线性激活函数,M∈RH×W×3n。如果我们假设三个convo lution操作各输出n个特征图,那么在ReLU激活后我们可以得到3×n个特征图。随后,再进行1×1卷积,将之前提取的多尺度特征进行融合。同时,它仍然作为一个瓶颈层,将通道数减少到

![]()

其中M∈RH×W×n。

2) 注意模块。

RCAN架构中的通道关注模块如图2所示。通道关注机制是由RCAN首次引入超分辨率领域的,事实证明它具有自适应利用不同通道间有效信息的能力。就遥感图像而言,LR图像中的高频分量是很有价值的,特别是对于那些充满边缘、纹理和其他细节的场景。为了强化特征表达,使网络关注更多的信息特征,我们在RB中加入了图2所示的注意模块,在1×1卷积后对通道特征进行重新划分,具体操作如下。

![]()

其中Pave(M )∈R1×1×n代表全局平均池操作,W f 1∈R1×1×(n/r)和W f 2∈R1×1×n代表两个全连接层,f (-)表示sigmoid函数。在重新校准操作之后,我们在RB的尾部使用3×3卷积进行空间上的特征提取。考虑到网络的参数预算和计算负担,特征图的数量n被设定为64。

为了提高实验效率,我们用8个RB作为基线,在提出的MSAN和两个比较方法(即EDSR和WDSR)中。此外,利用权重归一化(WN)来提高训练的效率和准确性。地面真实图像和超分辨率图像之间的l1损失函数也被计算出来以训练最终的MSAN。

C. 场景适应性框架描述

考虑到遥感图像中不同场景之间的巨大差异,很难训练一个对所有不同场景都有效的模型。因此,在这篇文章中,我们提出了一个场景适应性的超级分辨率框架。该框架的流程图如图3所示。如图3所示,场景自适应超级分辨率的流程图可以分为两个部分:1)转移学习和2)重建。

1) 转移学习

首先,我们用包含各种场景的遥感图像对基本网络进行预训练以初始化参数。然而,由于不同场景之间纹理信息的明显差异和遥感图像之间的广泛尺度,初始化的模型往往是不同场景的训练数据之间博弈的妥协结果。因此,这种预训练的模型不会对每个单一场景实现最佳的重建结果。为此,为了使初始化的参数能够转移到遥感图像的相应场景领域,我们使用不同场景的遥感图像来微调预训练的基本网络[50]。在得到预训练的基本网络后,利用不同场景的遥感图像对预训练的网络进行微调,得到最终模型。因此,我们可以建立一个数据库,其中包含适应不同场景的遥感图像的超分辨率模型。同时,我们可以利用不同场景的结构信息来探索LR和HR图像之间更精确的非线性映射,以改善重建结果。

2)重构

在重建部分,在获得所有与不同场景微调的模型后,我们可以应用场景自适应的超级分辨率框架。首先,我们可以通过场景分类将遥感图像与对应的类别相匹配。在场景匹配之后,每张遥感图像被输入到在第一个程序中自适应获得的相应的超分辨率模型中,以获得最终的HR输出。