Web中的Bias

目录

- 前言

- 数据偏见对人们的影响

- 衡量偏见

- 活跃偏差或少数人的智慧

- 数据偏见

- 算法偏差和公平性

- 用户交互偏差

-

- 曝光偏差

- 位置偏差

- 社会一致性偏差

- 自我选择偏见

- 偏差的层叠和相互依赖

- 小结

- 偏差的恶性循环

- 总结

- 参考文献

前言

本文参考Ricardo Baeza-Yates 2018年发表在《Communications of the ACM》的论文Bias on the Web,论文旨在提高人们对网络使用和内容中存在的偏见对我们所有人造成的潜在影响的认识。

本文部分内容由论文Bias and Debias in Recommender System: A Survey and Future Directions补充。

希望对推荐排序方向上的探索有所启发,在为满足人们需求的Web系统设计中考虑这一点。

Bias 在一些文献和博客中也称为偏差,但在此处翻译成偏见更合适一些,后文也会使用偏差一词,两者在英文中的意义是等价的。

数据偏见对人们的影响

自古以来,偏见就植根于人类文化和历史之中。而且,由于数字数据的兴起,它现在可以比以往更快地传播并接触更多的人。大数据中的偏见,影响着我们的每一个人,尽管很多时候我们没有意识到它的存在甚至不知道它如何(正面或负面地)影响我们的判断和行为。对于少数群体而言,数据偏见可能影响到生活的方方面面,小到一次搜索的结果、一个个性化广告的展示,大到抵押贷款的审批。这些结果往往都是由算法控制的,而算法就是基于带有偏见的数据训练和优化的。

衡量偏见

解决偏见的第一个挑战是如何定义和衡量它。 从统计学的角度来看,偏见是由不准确的估计或抽样过程引起的系统性偏差。因此,变量的分布可能相对于原始的、可能未知的分布有偏差。此外,文化偏见可以在我们对共同个人信仰的倾向中找到,而认知偏见会影响我们的行为和决策方式。

重要见解:

- 对偏见的任何补救措施都始于认识偏见。

- 网络上的偏见反映了我们内心的偏见,可能以更微妙的方式表现出来

- 在设计真正满足用户需求的基于Web的系统时,我们必须考虑并说明偏见。

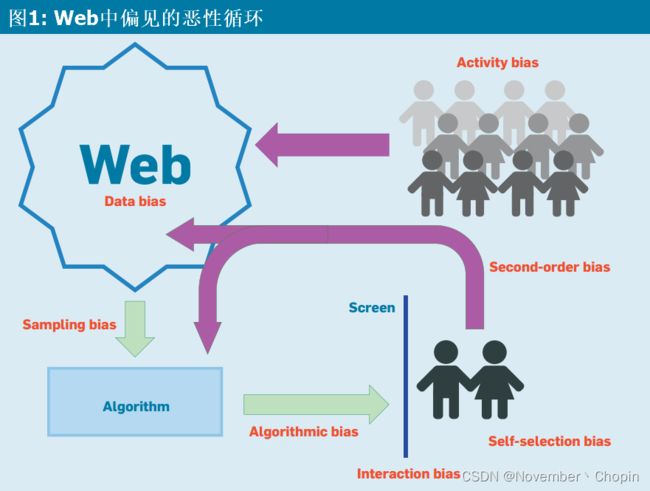

图1显示了偏见(红色)是如何影响网络的发展及其使用的:

- 人们使用网络导致的活跃偏差(Activity bias)和没有互联网接入的人的隐藏偏差。

- 他们产生了网络上的数据偏差(Data bias),这些带有偏见的数据污染了基于这些数据的算法。

- 通过我们与网站的交互,产生了交互偏差、自我选择偏差。

- 内容和使用循环回网络,造成各种类型的二阶偏见。

视频解读地址:CACM June 2018 - Bias on the Web

活跃偏差或少数人的智慧

活跃偏差(Activity Bias)或少数人的智慧(Wisdom of a Few)。

2011年,吴等人[28]关于人们如何在推特上关注其他人的研究发现,0.05%的最受欢迎的人吸引了几乎50%的参与者,也就是说,数据集中一半的推特用户只关注少数精选的名人。沉默的大多数网络用户,他们只看网络而不贡献,这本身就是一种自我选择偏见。[14]

Ricardo Baeza-Yates 和 Saez-Trumper 分析了四个数据集,结果是令人吃惊的:

- 在2009年的Facebook数据集中,7%的活跃用户发布了50%的帖子。

- 在2013年更大的亚马逊评论数据集中,4%的活跃用户撰写了一半的评论。

- 在2011年的一个非常大的数据集中,有1200万活跃的推特用户,2%的用户发表了一半的帖子。

- 英文维基百科一半条目的第一个版本是由0.04%的注册编辑(约2000人)研究和发布的,这表明只有一小部分用户为网络做出了贡献,认为它代表了整个人群的智慧是一种错觉。

只有4%的人自愿写亚马逊数据集中所有评论的一半是没有意义的,也是很奇怪的。因此2015年10月,亚马逊开始了一场反付费虚假评论的企业运动,该运动在2016年继续进行,起诉了近1000名被指控撰写评论的人。

当然,偏差也有有益的一面:

虽然英文维基百科的例子是最有偏见的,但它代表了积极的偏见。英文维基百科开始时的2000人可能引发了雪球效应,帮助维基百科成为今天的巨大百科全书资源。

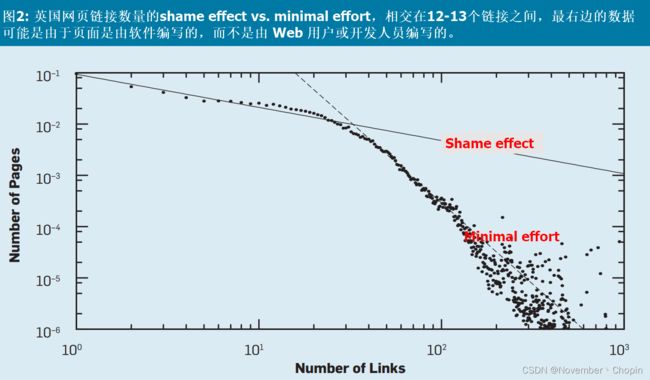

Zipf Law,也称为最小努力原则,即做最少的事来达到目的。认为许多人只做很少,而很少有人做很多,这可能有助于解释很大一部分活动偏见。然而,经济和社会激励也在产生这一结果方面发挥了作用。例如,Zipf Law可以在大多数Web度量中看到(例如每个网站的页数或每个网页的链接数)。图2的x-轴表示英国网页的链接数量,y-轴表示拥有相应链接数的网页的数量。然而,在x轴的开头有一股强大的社会力量,作者称之为“shame effect”,它使斜率不那么负。它还表明,许多人更喜欢付出最少的努力,尽管大多数人也需要感觉他们做了足够多的事情来避免对自己的努力感到羞耻。 这两种影响是人们在网络上活动的共同特征。

数字沙漠(digital desert)。诺贝尔奖获得者Herbert Simon说,“丰富的信息造成了注意力的匮乏。” 因此,活跃偏差在网络上产生了一个“digital desert”,或者说没人见过的网络内容。一个下限来自推特数据,Ricardo Baeza-Yates 和 Saez-Trumper 发现1.1%的推文是由没有追随者的人撰写和发布的。回顾维基百科使用统计数据给了我们一个上限,即2014年5月添加或修改的文章中有31%在6月份从未被访问过。网络上数字沙漠的实际规模可能在1%到31%范围的前一半。

偏差并不总是负面的。 由于活跃偏差,所有级别的Web缓存在保持最常用的内容随时可用方面都非常有效,网站和Internet网络的负载总体上比可能的要低得多。此外,正面的偏差还包括 Inductive Bias。

数据偏见

与人际交往能力一样,数据质量参差不齐,因此在某种程度上预计会有偏差。 在政府、大学和其他处理信息的机构工作的人应该发布质量更高、偏见更少的数据,而社交媒体作为一个整体要大得多、有偏见,而且毫无疑问,平均质量较低。 另一方面,为社交媒体做出贡献的人数可能至少比在信息机构工作的人数多一个数量级。 因此,来自所有人的任何质量的数据都越来越多,包括高质量的数据(无论人们使用什么质量的定义)。 尽管如此,网络上的许多虚假内容似乎比可靠内容传播得更快。

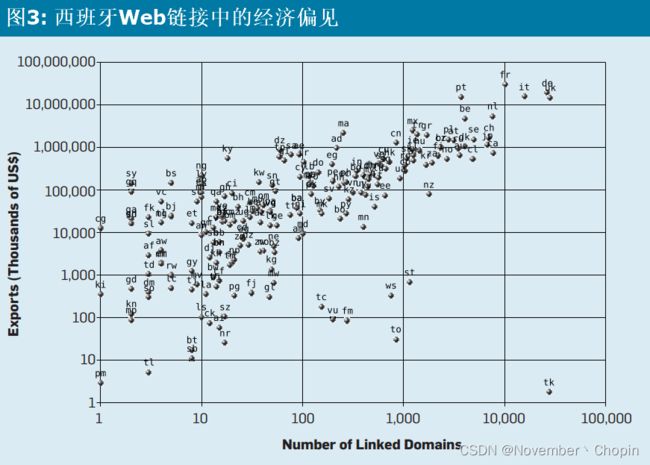

在人们与Web 交互时,看到的第一组偏差是由于他们的人口统计数据造成的。 访问和使用 Internet 与教育、经济和技术偏见以及其他特征相关,从而导致 Web 内容和链接的偏见连锁反应。例如,据估计超过 50% 的最受欢迎的网站是英文的,而世界上以英语为母语的人的比例大约只有 5%。与大城市和旅游景点相关的Web内容也存在地域偏差。Web 偏差的网络效应的另一个例子是Web 本身的链接结构。如图3所示,与西班牙贸易量大的国家,其与西班牙的Web链接数量也很高,这部分国家也是发达国家。

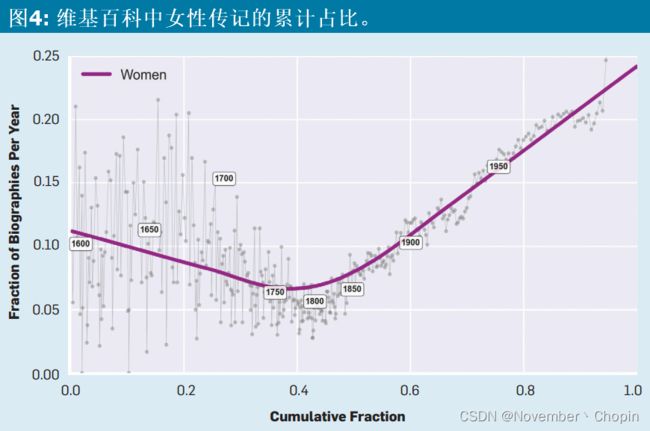

第二组偏差是由于不同类型偏差之间的相互作用。 图4绘制维基百科中女性传记的比例曲线,这一曲线可以通过贯穿人类历史的系统性性别偏见来解释。然而,维基百科的统计数据显示,只有不到12%的维基百科传记类别编辑是女性,在地理类别上达到4%。传记实际上显示出微小的活跃偏差。

数据偏差的第三个来源是网络垃圾邮件。 这部分不再详述。

由于衡量几乎所有偏差都很困难,它对使用机器学习的预测算法的影响同样难以理解。Web数据一开始代表了有偏见的人群样本,基于社交媒体的研究可能会有很大的误差,我们可以肯定这不是均匀分布的。出于同样的原因,此类研究的结果不能外推到其他人群,比如2016年美国总统选举预测。

算法偏差和公平性

算法偏差,是指算法自身的偏差,而不是输入数据导致的算法输出偏差。如果输入数据有偏差,那么算法的输出也可能反应相同的偏差。不过,即使知道并能检测到所有可能的偏差,解释算法如何运行来消除偏差也是很困难的。

In a 2016 research effort that used a corpus of U.S. news to learn she-he analogies through word embeddings, most of the results was reported as biased, as in nurse–surgeon and diva–superstar instead of queen–king.

一项快速的Web搜索显示,美国大约70%有影响力的记者是男性,尽管在美国新闻学院,性别比例是相反的。因此,从新闻文章中学习的算法是从带有明显和系统性性别偏见的文本中学习的。

另一方面,一些Web开发者已经能够限制偏见。消除性别偏见问题可以通过自动考虑性别子空间来解决。关于新闻推荐中的地理偏见,大城市和政治权力中心肯定会产生更多的新闻。如果使用标准推荐算法,公众可能会阅读来自首都的新闻,而不是来自他们居住的地方。考虑到多样性和用户位置,Web设计者在网站不太显眼的位置放置本地新闻。

标签推荐(Tag recommendations)是算法偏差的一个极端例子。用户上传图片并打算对照片添加标签,标签推荐算法会根据协同过滤来推荐人们在其他照片中使用的标签,用户会选择自己认为正确的标签。但当人们使用推荐标签时,他们添加自己的标签的次数会减少,从已知标签中挑选而不添加新标签。 从本质上讲,该算法正在对自己进行长时间的自我毁灭。

用户交互偏差

曝光偏差

曝光偏差(Presentation Bias),也称为Exposure Bias。当用户只接触到特定项目的一部分时,就会发生曝光偏差,因此未观察到的交互并不总是代表负面偏好。最常见的解决方案被称为“探索和利用”(explore and exploit),将用户交易的一部分暴露在新项目中,这些项目随机混合了要探索的热门推荐,利用使用数据来揭示它们的真实相对价值。

这种解决方案的悖论在于,探索可能意味着损失或已知“利用信息”的机会成本。。在某些情况下,甚至会损失收入(例如来自数字广告)和用户体验。然而,学习和发现(新的)好项目的唯一方法是探索。

位置偏差

位置偏差(Position bias)。在很多中西方文化中,我们的阅读习惯是是从上到下、从左到右。这种偏差是先看屏幕左上角,促使该区域吸引更多的目光和点击。“排名偏差”(Ranking bias)是这种偏见的一个重要例子。考虑一个网络搜索引擎,结果页面按从上到下的相关顺序列出。因此,排名靠前的结果将比其他结果吸引更多的点击,因为它既是最相关的,也是排名第一的。为了避免排名偏差,Web开发者需要消除点击分布偏差,以便他们可以使用点击数据来改进和评估排名算法。否则,流行页面会变得更加流行(即rich-get-richer)。

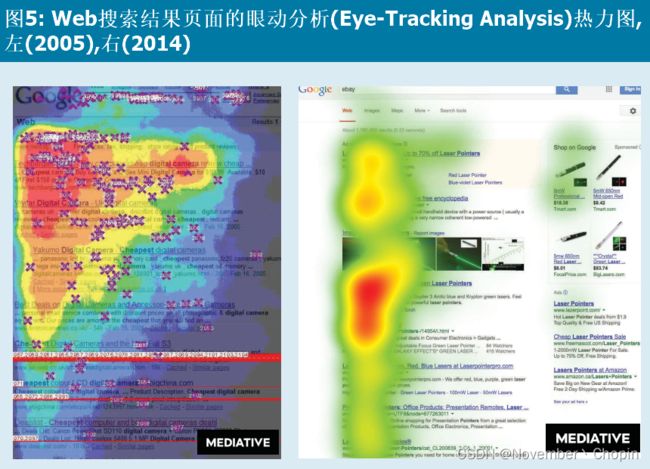

任何用户需要滚动才能看到其他内容的网页都会反映像曝光偏差一样的偏差,图像附近的内容更有可能被点击,因为图像会吸引用户的注意力。图5显示了眼动追踪研究的例子,在引入通用搜索(多种类型的答案)后,非文本内容抵消了结果页面中的位置偏差,还显示了右边的广告栏会吸引额外的注意力。

社会一致性偏差

社会偏见定义了来自他人的内容如何影响我们的判断。考虑一个涉及协同评分的例子:假设我们想给一个低分的项目评分,但发现大多数人已经给它打了高分。我们可能会仅仅认为自己太苛刻就提高分数。这种偏见已经在亚马逊评论数据的背景下得到了探索,通常被称为“社会一致性”或“羊群效应”。

自我选择偏见

用户倾向于选择与他们现有信念一致的答案。

偏差的层叠和相互依赖

让偏见变得更加复杂的是,交互偏见在系统中层叠,Web开发人员很难将它们隔离开来。

小结

交互偏差对于分析用户体验和网站的整体性能至关重要,因为许多Web系统都是通过隐性用户反馈进行优化的。随着这种优化系统越来越多地基于机器学习,它们学会了强化自己的偏差或其他链接系统的偏差,从而产生次优解决方案和/或自证预言(self-fulflling prophecies)。这些系统有时甚至会相互竞争,一个系统的改进可能来自使用不同(反向相关)优化功能的另一个系统的降级。一个经典的例子是改善用户体验和增加变现能力之间的冲突关系(例如广告数量的增加通常会降低用户体验)。

偏差的恶性循环

偏差的恶性循环(Vicious Cycle of Bias),即偏差引起偏差。这一过程造成了二阶偏见的恶性循环,因为一些内容提供商获得了更好的排名,导致更多的点击。也就是说,富人变得更富有。此外,内容的重复只会加剧区分好页面和坏页面的问题。

偏差引起偏差。这一过程造成了二阶偏见的恶性循环,因为一些内容提供商获得了更好的排名,导致更多的点击。也就是说,富人变得更富有。此外,内容的重复只会加剧区分好页面和坏页面的问题。

如果个性化算法只使用我们的交互数据,我们只看到我们想看的内容,从而使内容偏向我们自己的选择偏差,让我们处于一个封闭的世界,对我们可能真正喜欢的新项目封闭。这方面的术语有过滤气泡(The Filter Bubble)、信息茧房(Information Cocoons)、回音室等(Echo Chamber Effect)。这个问题必须通过协同过滤或任务上下文化以及多样性、新奇性、偶然性来解决,甚至在需要时给我们另一面。

总结

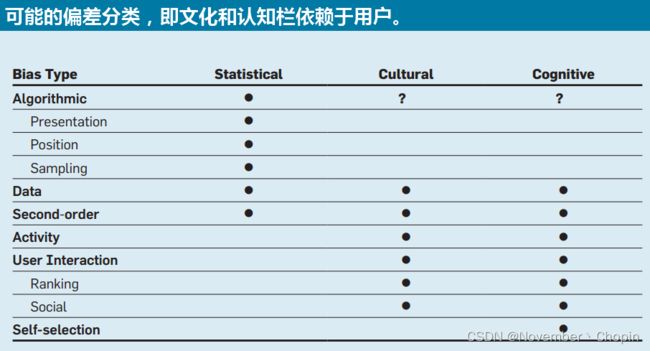

偏差的问题比本文在这里概述的要复杂得多,本文只涵盖了问题的一部分。事实上,这个基础涉及我们所有的个人偏见。这里描述的许多偏见已经超越了Web生态(如移动设备和物联网)。这个表格对之前提到的偏差分成三类:偏差可能会涉及到数据、文化和认知中的一个或多个。

任何试图保持公正的尝试都可能因为我们自己的文化和认知偏见而产生偏见,因此第一步是意识到偏见。只有当Web开发人员知道偏见的存在时,他们才能解决并在可能的情况下修正偏差。否则,我们的未来可能是一个基于偏差认知的虚构世界。

参考文献

[8] Baeza-Yates, R. and Saez-Trumper, D. Wisdom of the crowd or wisdom of a few? An analysis of users’ content generation. In Proceedings of the 26th ACM Conference on Hypertext and Social Media (Guzelyurt, TRNC, Cyprus, Sept. 1–4). ACM Press, New York, 2015, 69–74.

[14] Gong, W., Lim, E.-P., and Zhu, F. Characterizing silent users in social media communities. In Proceedings of the Ninth International AAAI Conference on Web and Social Media (Oxford, U.K., May 26–29). AAAI, Fremont, CA, 2015, 140–149.

[28] Wu, S., Hofman, J.M., Mason, W.A., and Watts, D.J. Who says what to whom on Twitter. In Proceedings of the 20th International Conference on the World Wide Web (Hyderabad, India, Mar. 28–Apr. 1). ACM Press, New York, 2011, 705–714