弱监督视频异常检测|Self-Training Multi-Sequence Learning with Transformer for Weakly Supervised Video Anomaly

Self-Training Multi-Sequence Learning with Transformer for Weakly Supervised Video Anomaly Detection

Li, S., Fang Liu and Licheng Jiao. “Self-Training Multi-Sequence Learning with Transformer for Weakly Supervised Video Anomaly Detection.” AAAI (2022).

Paper:Self-Training Multi-Sequence Learning with Transformer for Weakly Supervised Video Anomaly Detection| Proceedings of the AAAI Conference on Artificial Intelligence

本文的亮点:

- 提出了一种多序列学习(Multi-Sequence Learning MSL)方法,它使用由多个实例组成的序列作为优化单元。基于此,我们提出了一种Multi-Sequence Learning ranking loss,它选择异常分数总和最高的序列.

大多数弱监督VAD都基于多实例学习(MIL)。基于 MIL 的方法将视频视为一个包,其中包含多个实例。每个实例都是一个片段。由异常视频产生的包称为正包,由正常视频产生的包称为负包。由于视频级标签指示视频是否包含异常,因此正包 包含至少一个异常片段,而负包不包含任何异常片段。

因此,基于MIL的方法的重点是正确地选择正包中的异常实例。

使用多实例学习(MIL)的弱监督视频异常检测(VAD)通常基于异常片段的异常分数高于正常片段的异常得分这一事实。多序列同样也是基于这个原理。

但存在 一个问题:在训练初期,由于模型的精度有限,很容易选择错误的异常片段。

本文提出的想法就是 为了缓解这个问题

- 基于多序列学习及其排序损失,我们设计了一个基于 Transformer 的多序列学习网络,并提出在推理阶段使用视频级异常分类概率来抑制片段级异常得分的波动。

- 通过逐渐减少所选序列的长度,我们提出了一种两阶段自训练策略,以逐步细化异常分数,因为VAD需要预测细粒度的异常分数

关于 Self-training 的步骤:

1)带标记数据的训练模型; 2)利用训练后的模型预测未标记数据,生成伪标记; 3)带标记数据和伪标记数据的训练模型; 4)重复2)和3)

Approach

符号和问题陈述

在弱监督的VAD中,训练视频只使用视频级别(Video-level)的标签。包含异常 为 1(正样本), 不包含为 0 (负样本)。

基于MIL 的方法 将一个视频 看为一个 包 ,片段 看为实例。

![]() 表示预测异常分数的函数 ,指的就是整个模型

表示预测异常分数的函数 ,指的就是整个模型

通常,基于MIL的VAD假设异常片段的异常得分高于正常片段。

Sultani, W.; Chen, C.; and Shah, M. 2018. Real-World Anomaly Detection in Surveillance Videos. In CVPR, 6479–6488.

将VAD表示为异常得分回归问题,并提出MIL ranking objective function 和MIL ranking loss

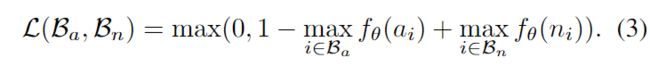

为了在正实例和负实例之间保持较大的差距,给出了a hinge-based ranking loss:

Multi-Sequence Learning

在优化开始时,fθ需要具有一定的预测异常的能力。否则,会选择正常实例作为异常实例。如果fθ错误地预测了正包中的实例,例如,将正常实例预测为异常实例,则随着训练的进行,此错误将得到加强。此外,异常部分通常是多个连续的片段,但基于MIL的方法不考虑这一先验。

提出的 Multi-Sequence Learning 就是为了缓解这个问题。从图2 中可以看出差别

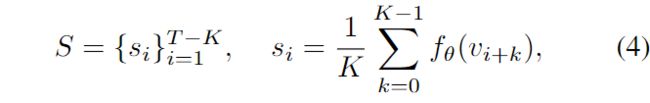

K 表示 选取的连续片段的数量,是一个超参数

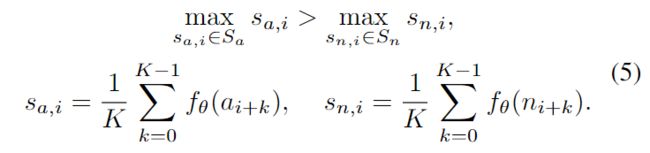

对于的一个序列的异常分数的计算:

其中,Si表示从第 i 个片段开始的 K 个连续片段序列的异常得分平均值。

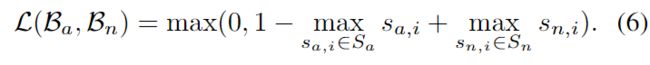

基于上述序列选择方法,我们可以简单地使用MSL ranking objective function :

其中,

其中,![]() 和

和![]() 分别表示异常视频和正常视频中从第 i 个片段开始的K个连续片段的异常得分平均值。

分别表示异常视频和正常视频中从第 i 个片段开始的K个连续片段的异常得分平均值。

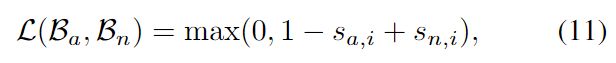

同样地,hinge-based MSL ranking loss:

可以看出,MIL是我们MSL的一个特例。当K=1时,MIL和MSL相等。当K=T时,我们的MSL会将异常视频中的每个片段视为异常(这就是对整个视频 判断是否有异常)。

Transformer-based MSL Network

Convolutional Transformer Encoder

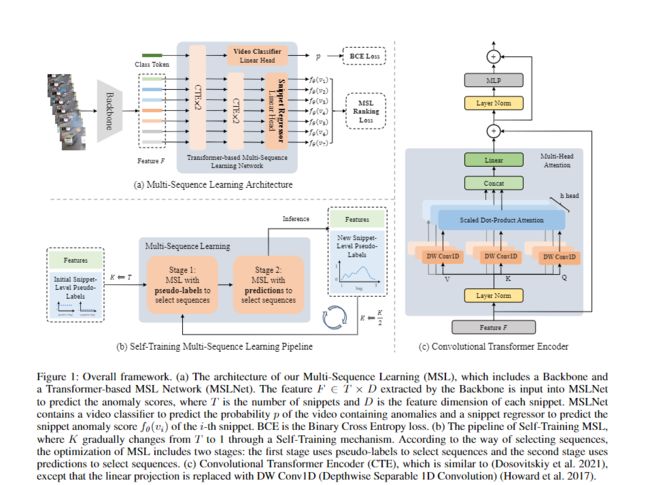

Transformer不擅长学习相邻帧或片段的local representations。受此启发,如图1(c)所示,我们将原始 Transformer 中的linear projection替换为DW Con-v1D(深度可分离1D卷积)。这样,我们的CTE可以继承Transformer和卷积神经网络的优点。

Transformer-based MSL Network

任何动作识别方法都可以用作主干,例如C3D(Tran et al.2015)、I3D(Carreira and Zisserman 2017)和VideoSwin(Liu et al.2021c)。通过主干,特征 F∈T×D 从包含T片段的视频中提取,其中D是每个片段的特征尺寸。我们的MSLNet将使用 F 作为输入来预测异常。

我们的MSLNet包括一个视频分类器(video classifier )和一个片段回归器(snippet regressor)。

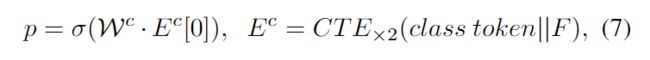

视频分类器用于预测视频是否包含异常。具体来说,视频分类器包含两层CTE和一个线性头,用于预测视频是否包含异常的概率:

其中![]() 是线性头的参数,p是视频包含异常的可能性,class token 用于通过CTE中的聚集特征预测概率 。视频是否包含异常是一个二分类问题,σ选择了sigmoid函数。

是线性头的参数,p是视频包含异常的可能性,class token 用于通过CTE中的聚集特征预测概率 。视频是否包含异常是一个二分类问题,σ选择了sigmoid函数。

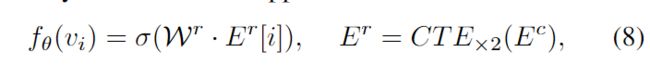

片段回归器用于预测每个片段的异常分数。具体来说,片段回归器包含两层CTE和一个线性头,用于预测每个片段的异常得分:

是第i个片段的异常分数,

是第i个片段的异常分数, 是第i片段的特征,预测异常分数被视为一个回归问题 。

是第i片段的特征,预测异常分数被视为一个回归问题 。

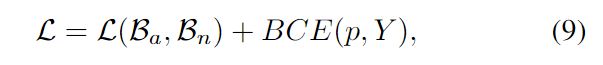

我们将视频分类器和片段回归器的优化视为一个多任务学习问题。优化MSLNet参数的总损失是我们 hinge-based MSL ranking loss和 the classification loss 的总和:

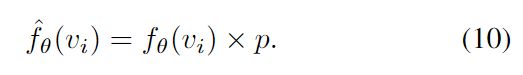

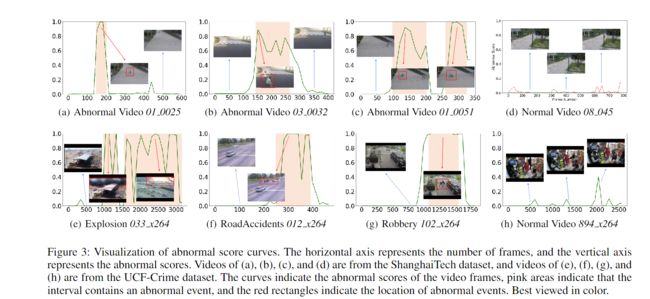

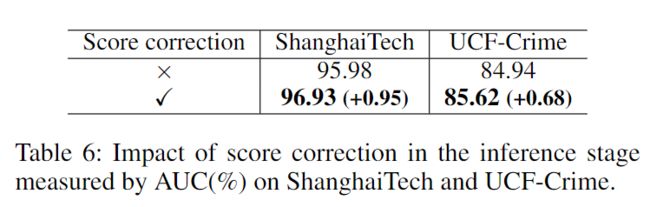

为了减少片段回归器预测的异常分数的波动,我们在推理阶段提出了一种分数修正方法。

具体而言,分数校正方法通过使用视频是否包含异常的概率来校正异常分数:

该方法的直观性在于,当视频分类器预测视频含有较高概率的异常时,保留异常分数,当视频分类器预测视频含有较低概率的异常时,减弱异常评分。

Self-Training MSL

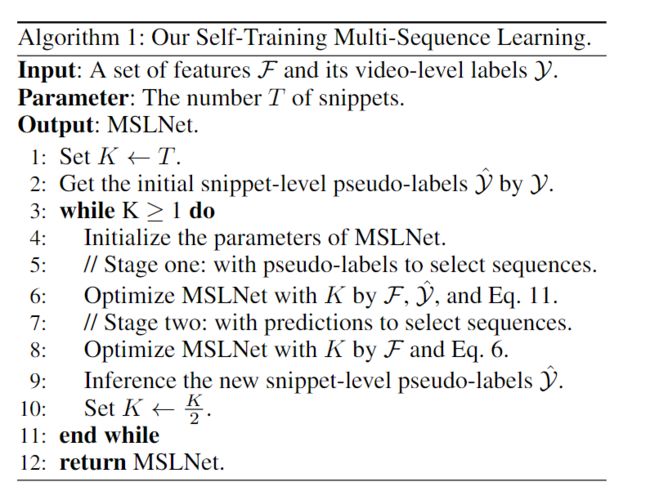

如图1(b)所示,我们提出了一种自我训练机制,以实现从粗到细的训练。MSLNet的训练过程包括两个训练阶段。

在引入我们的自我训练机制之前,我们首先获得了训练视频的伪标签 ˆy 。通过将已知的视频级标签 y 列为弱监督的VAD作为视频片段的异常分数,我们可以立即获得初始的实例级伪标签。也就是说,对于一个异常视频,每个片段的伪标签为1,对于普通视频,每个snippet的伪标签为0

在训练的初始阶段,函数fθ预测异常的能力较差。因此,如果直接通过fθ的预测选择序列,则有可能选择错误的序列。

基于这个动机,我们提出了一个过渡阶段(第一阶段):用伪标签选择序列的MSL。

具体来说,通过 使用每个片段vi的伪标签ˆyi 将预测的异常分数 重新放置在等式4中,我们选择

重新放置在等式4中,我们选择![]() 伪标签平均值最大的序列。基于此序列,我们可以计算

伪标签平均值最大的序列。基于此序列,我们可以计算![]() 和

和![]() ,然后通过 hinge-based MSL ranking loss 优化MSLNet:

,然后通过 hinge-based MSL ranking loss 优化MSLNet:

其中, ![]() 和

和![]() 分别是从异常视频和正常视频中的第i个片段开始的伪标签平均值最大的序列。经过E1 epochs训练后,fθ具有初步预测异常分数的能力。

分别是从异常视频和正常视频中的第i个片段开始的伪标签平均值最大的序列。经过E1 epochs训练后,fθ具有初步预测异常分数的能力。

在第二阶段,MSLNet 使用预测来选择序列进行优化。这个阶段使用 式5和式6 来计算排名损失。在 E2 epochs 训练后,对训练视频的新片段级伪标记 Y 进行了推断。通过将长度 K 减半并重复上述两个阶段,预测的异常值逐渐得到细化。

过渡阶段的作用是在MSL和不同的自我训练回合之间建立联系。通过引入自我训练机制,我们实现了从粗到细的异常分数预测。为了更好地理解,在算法1中展示了的自训练MSL。

Experiments

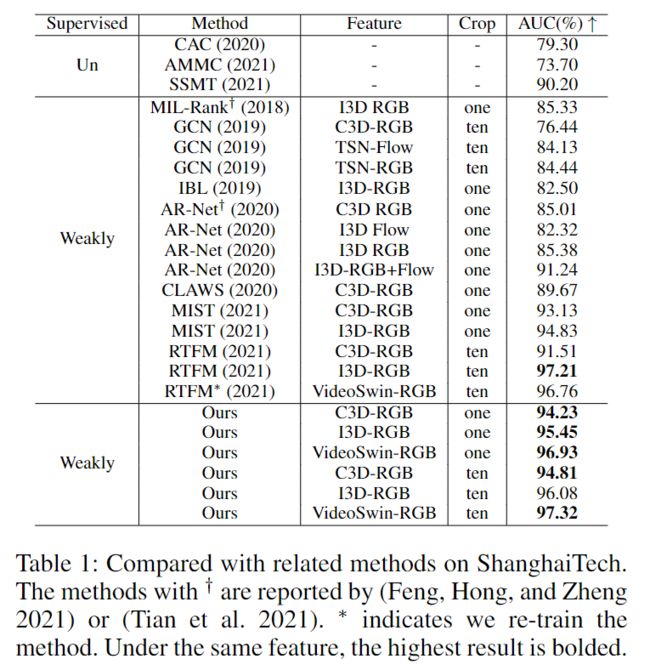

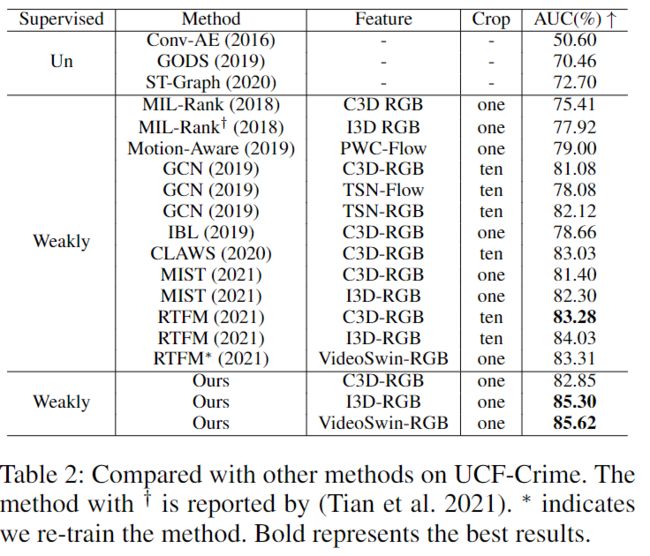

Datasets:ShanghaiTech,UCF-Crime, and XD-Violence datasets

Shanghaitech Vision and Intelligent Perception(SVIP) LAB

CRCV | Center for Research in Computer Vision at the University of Central Florida

XD-Violnce

Evaluation Metrics:

Area Under the Curve (AUC) of the frame-level ROC (Receiver Operating Characteristic) for ShanghaiTech and UCF-Crime.

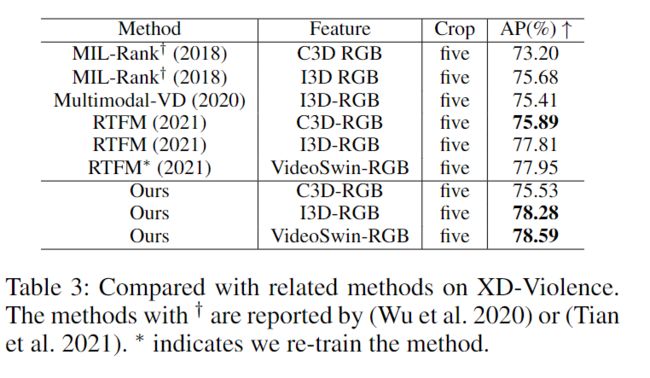

Average Precision (AP) as our metric for XD-Violence.

请注意,AUC和AP的值越大,性能越好

在几个数据集上的效果:

Ablation Analysis

Performance change as K decreases.

Improvement brought by CTE.