标强化学习基本假设之——回报函数假设

考虑以下命题:

“我们所有目标和目的都可以通过最大化接收到的标量信号(也称为奖励)和的期望来实现。”

这是真的?假?一个定义?无法伪造?欢迎大家就该假设发表评论,一两句也行。比如,“是的”,“不是的”。

这是我最喜欢的“零假设”,以至于我有时将其简称为零假设。对这个非常基本的问题所持有的立场是很关键的,这样后面才可以更清晰,明智地谈论很多其他问题。

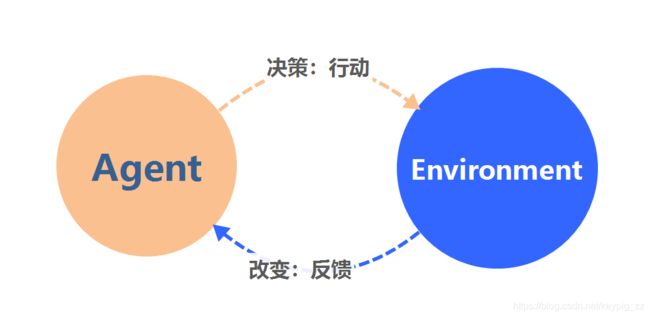

迈克尔·利特曼(Michael Littman)将此称为强化学习假设。这么说是合理的,因为只有对于强化学习而言,这一假设必须被认真对待。虽然马尔可夫决策过程也涉及奖励,但是只在有了强化学习之后,奖励最大化才作为与人类类似的完整智能主体的合理模型被认真提出。

帕特里克,2004年10月25日星期一13:34:14

我认为,特别是从生物学的角度,很难反驳奖励假说。可以看出,大多数生命系统是基于一小部分基本信号(神经反应,免疫激活,化学刺激等)而形成、发展和运行的。也可以说,大多数这些基本信号努力使单个特性(反馈信号)最大化来提高整个系统的生存能力。

我认为有趣的问题在于基本奖励信号的识别。最终的奖励是智能体中有意识的“幸福”或兴奋的水平?还是它内置在系统中的生存价值远远低于认知过程的水平(即分子机制的状态和响应)?细分得足够远,对每个组成部分的奖励仅仅是“我生存了”还是“我没有生存”,而系统旨在使组成部分的总长期生存最大化?

匿名,2004年11月1日星期一11:46:37

对于是否可以仅以生存价值来考虑奖励,我持怀疑态度。考虑一个烈士的例子,他宁愿牺牲牺牲自己的生命而获得的报酬,而不是生活另一天的报酬。恰恰是,恰恰是我们获得的报酬往往与给定状态的生存价值相关(如果没有,则我们将无法谈论这一点)!

大自然的力量不在乎他们的人口如何生存,只在乎他们的生存。我猜想(有机生物中)奖励的概念可能受许多不同的作用力影响,包括认知作用和更简单的基本作用力,所有这些作用都是协同作用的。

Cosmin,2004年12月6日星期一21:13:45

我得出的结论是,您给予代理人的报酬是至关重要的,微妙的事情。除非您将获胜的奖励设置为1,否则将其设置为0(如西洋双陆棋),或者将每一步的奖励设置为-1,将目标的奖励设置为0,那么它会变得非常混乱。会有很多问题出现,例如在学习驾驶汽车的时时刻刻都需要针对燃料,汽车损坏和人身伤害之间进行权衡。我真的很想知道是否有使用复杂奖励的完备的方法。

所以我的问题是:强化学习的每一项成功都基于非常简单的奖励函数吗?如何为复杂的应用程序(例如驾驶汽车)设计奖励功能?(甚至更具挑战性,而且我敢肯定,这是DARPA要做的事情之一,即机器人海军陆战队需要对杀死平民、错过敌人和自损之间进行权衡)。

解决这个问题的一种方法可能是,根据我们对表演的满意程度,在每一次任务结束后按照我们的满意度给特工的表现评分。但这将意味着大量的人工工作-尤其是对于需要大量样本的在线方法,工作量更大。

Vadim Bulitko,2005年1月26日星期三23:47:29

以下是今天与奖励假设有关的问题:

-

Rich表示,指定奖励功能是用户的烦恼,因为奖励函数是问题本身的一部分。RL研究人员的职责是想出一种RL算法,以学习使奖励最大化的策略。

-

在我看来,我们处理的许多(也可能是大多数)“现实生活”任务并不立即涉及任何奖励价值。在以下任何问题中都没有提到标量信号:“从北京到上海”,“找到更好的工作”,“娶一个好妻子”,“幸福”,“购买美食” ”,“安全驾驶”,“赶上下午5点的飞机”,“玩好西洋双陆棋”,“倒置直升机”,“让AIBO快速运行”等。奖励信号是由RL研究人员(例如, Tesauro,Ng,Stone,Velloso等强加上去的。因此,很自然地想知道,要求客户提供一个标量来获得问题的方方面面是是否合理。

-

怎么可能不合理?毕竟,作为RL算法的作者,我们有权随意对问题的提出引入一致的假设,不是吗?好吧,这是一个不合理的问题说明要求的荒唐可笑的例子。您是否想要一种简单且有保证的方法来解决AI中的任何问题?好吧,我将免费提供给您。作为此方法的作者,我将要求解决方案是问题的一部分,并照此提供给算法。然后我的算法只是从输入中取出解决方案,然后将其输出给用户;-)

-

因此,合理地提出可能对问题规范提出哪些要求。我认为我们在这里缺少的是描述AI问题的标准语言。Rich今天问我:“如果不通过奖励函数,我们还能如何描述问题呢?”在上个世纪的后半叶,图灵,教会,冯·诺伊曼(von Neuman)等人提出了类似的问题——如何描述一个通用的计算问题?在那里找到的答案在于用正式语言检查成员资格(所谓的“决策问题”)。递归理论围绕递归集(其成员可以由Turing机器检查)建立一个大型理论,如递归可枚举集(其成员可以由Turing机器以集合K作为预言器检查)等。

-

我们需要另一种语言来表示AI问题吗?还是我们应该认为任何AI智能体都是计算设备,因此AI问题应仅被视为计算问题,并像其他所有其他计算问题一样通过形式语言来形式化?

PS:奖励功能包含多少解决方案?由于无数的奖励函数导致相同的策略,作为RL算法的设计者,我们是否同样对这种奖励函数感到满意?还是我们想要“更好”的奖励功能,例如,可以加快学习速度?例如,吴恩达(Andrew Ng)加入了手工设计的塑形奖励。那我们不是在要求用户帮助我们解决问题吗?

Rich Rich Sutton,2005年5月5日

注意,奖励假设与以下概念不同:以某种方式关注风险,将可能发生的最坏情况减至最少,这是另一个问题。该假设意味着,可以将所有此类情况简化为最大化某种奖励选择的最大累积奖励的期望。因此,该假设可能与存在大量将风险敏感计划视为特例的研究事实相矛盾。先不考虑特殊情况。

Al Paris星期五9月2日12:17:56 2005

我从以金融为重点的工商管理硕士的角度出发。在我看来,您对目标和目的的看法类似于我们在资本配给中的净现值概念。

根据此处使用的净现值方法,我们对要资助的项目(做出的决定)进行排名,根据这些项目将提供未来现金流量(奖励)的最高净现值。如果我们不关心奖励的时间价值,也就是说,更喜欢奖励离现在更近的时间,那么我们将无视决策路径,该路径在时间范围的尽头与开始时堆叠最多的奖励,假设总和奖励的价值是相等的。但是,由于我们希望尽快获得奖励,因此我们更倾向于将奖励堆叠到现在的路径。

这是一个合理的经济学观点,似乎与RL具有共同点。

Rich Sutton 2005年9月27日星期二00:31:43

听起来好像Al Paris在考虑我们常说的折扣奖励的情况,这里有个类似的例子:http://www.cs.ualberta.ca/%7Esutton/book/ebook/node30.html#eq:return,这似乎是经济学中的标准案例。

Cristian Lagos,2005年12月11日星期日

不确定

达,星期六2006年10月28日17:22:13

我可以对这个零假设说“不”,但对“是”也不能充满信心。“已接收标量信号的累加总和的期望值的最大值”——为什么它必须是“标量”?目标可以是多重准则吗?就像我们想要便宜,近景点且安全的酒店一样。我们应该将它们组合成标量吗?如果超级便宜的酒店不安全怎么办?

Balint,Fri Aug 28 06:33:25 2009

任何“目标”或“目的”都必须由我们的行为隐含地表示,而我们的行为是由策略来建模的。因此,我认为从技术上讲,这个问题等同于为任何可能的策略找到奖励函数(也就是说,给定一个策略,找到在同一策略中最优结果的奖励)。当马尔可夫假设成立时,这很可能-只是立即惩罚行为中没有的行为。假设人类思想的变量是完全可以观察到的(包括其记忆),则所有人类行为在具有适当表示形式的情况下都应具有关联的奖励函数。

此技术性言论未提及奖励的解释能力。也许我们可以定义奖励,但是我们无法获得更深入的洞察力,因为它可能变得与行为本身一样复杂。

因此,从技术上讲,答案也许是“是”,但更重要的问题是:在实践中将目标描述为奖励是否总是有益的?可能不会。

现在是2020年了,距离这个帖子建立已经将近16年了,当年的回答里面很多想法在最近今年都有相应的研究发表,Sutton也70多岁了。考虑近期实用的RL,似乎不能太强调端到端——把我们的现实世界扔进去,仅靠一个标量的反馈就能完全学到整个世界的规律?没有必要限定在标量,MDP也不一定是最好的数学框架。