毫米波雷达相机融合综述——MmWave Radar and Vision Fusion for ObjectDetection in Autonomous Driving: A Review

MmWave Radar and Vision Fusion for ObjectDetection in Autonomous Driving: A Review

该论文是北京邮电大学2022年关于毫米波雷达和摄像头融合的一篇综述

摘要:随着自主驾驶的蓬勃发展,复杂场景下的精确目标检测受到广泛关注,以确保自主驾驶的安全。毫米波雷达和视觉融合是实现精确障碍物检测的主流解决方案。本文详细介绍了基于毫米波雷达和视觉融合的障碍物检测方法。首先,我们介绍了自动驾驶目标检测的任务、评估标准和数据集。然后,将毫米波雷达与视觉融合的过程分为传感器部署、传感器标定和传感器融合三个部分,并对这三个部分进行了综合评述。具体来说,我们将融合方法分为数据级、决策级和特征级融合方法。此外,我们还介绍了具有广阔前景的三维目标检测、自主驾驶中的激光雷达与视觉融合以及多模式信息融合。最后,对本文进行了总结。

文章首先点出,两者融合的重点是:

1.时空校准:融合的前提是在同一时间和空间,这意味着需要校准毫米波雷达和视觉信息

2.信息融合:融合不同传感器的传感信息以实现最佳性能的目标检测算法至关重要

重点:

第四章:传感器标定

一般来说,传感器校准包括坐标校准【42】–【48】、雷达点滤波【43】、【45】和误差校准【49】–【51】。

1.坐标标定的目的是将雷达点与图像中的目标进行匹配。对于坐标校准,最常用的方法分为坐标转换方法[45]、[46]、传感器验证方法[42]、[44]、[47]和基于视觉的方法[43]、[52],现将其综述如下 :

1)坐标变换法:坐标变换法通过矩阵运算将同一坐标系下的雷达信息和视觉信息统一起来。在[46]中,根据毫米波雷达和视觉传感器的空间位置坐标,通过坐标变换的方法完成空间标定。针对不同传感器采样率引起的时间不一致性,采用线程同步方法实现了图像帧和毫米波雷达数据的同时采集。参考文献[45]使用基于伪逆的点对齐方法,该方法通过最小二乘法获得坐标变换矩阵。传统的坐标变换无法生成目标的精确位置,给最终结果带来误差。在[53]中,Wang等人提出了一个校准实验,将真实坐标投影到雷达探测图中,无需特殊工具和雷达反射强度,从而减弱了对校准误差的依赖性。

2)传感器验证方法:传感器验证方法利用同一物体上不同传感器的检测信息,将多个传感器相互校准。在【42】中,传感器验证包括两个步骤。首先,雷达生成目标列表,然后根据视觉信息对列表进行验证。在【47】中,经过雷达坐标变换后,首先粗略搜索图像,然后与雷达信息进行比较。比较结果将目标分为两类:匹配目标和非匹配目标。在[44]中,Streubel等人设计了一个融合时隙,以匹配雷达和视觉在同一时隙中检测到的对象。

3)基于视觉的方法:在【52】中,使用运动立体技术来实现雷达目标和图像目标的匹配。在[43]中,Huang等人使用自适应背景减法检测图像中的运动目标,生成候选区域,并通过判断雷达点是否位于候选区域来验证目标。

2.雷达点滤波

雷达点滤波的目的是过滤掉噪声和无用的检测结果,以避免这些雷达点造成的误判。在[45]中,Guo等人提出了一种利用帧内聚类和帧间跟踪信息进行噪声滤波和有效目标提取的方法。在文献[43]中,利用毫米波雷达获得的速度和角速度信息对雷达点进行滤波。然后对无效的雷达点进行过滤,从而减少树木和桥梁等固定目标对毫米波雷达的影响。目前,在自动驾驶领域,研究人员大多使用开源数据集进行训练,他们想要检测的对象一般是车辆或行人。因此,可以使用[43]的方法根据速度和其他信息过滤雷达点,以排除非车辆和非行人物体

3.误差校准

由于传感器或数学计算中的误差,校准的雷达点可能存在误差。一些文章提出了纠正这些错误的方法。在文献[50]中,提出了一种基于交互式网络调整的方法,对投影在视觉图像上的雷达点进行最终校正。作者在[51]中提出了一种改进的扩展Kalmanfilter(EKF)算法,以模拟不同传感器的测量误差。在[49]中,分析和讨论了各种坐标对检测结果的影响,并提出了一种半积分笛卡尔坐标表示方法,将所有信息转换为随宿主车辆移动的坐标系。目前使用开源数据集时,不需要进行错误校准。然而,如果数据集是自制的,则雷达滤波和纠错是必要的技术步骤。

第五章 基于传感器融合的车辆检测

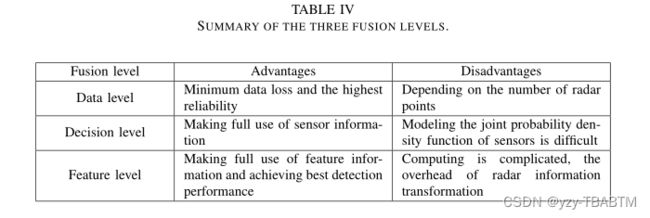

一般来说,毫米波雷达与视觉的融合有三个层次,包括数据层、决策层和特征层。数据级融合是毫米波雷达和摄像机检测到的数据的融合,具有最小的数据丢失和最高的可靠性。决策级融合是毫米波雷达和摄像机检测结果的融合。特征级融合要求提取雷达特征信息,然后将其与图像特征进行融合。表IV提供了三种融合水平的比较。

1.数据级融合

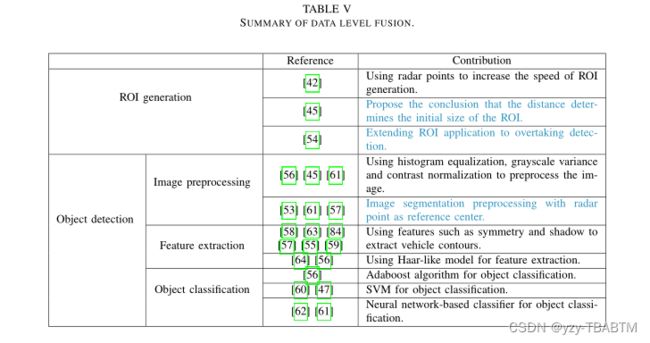

数据级融合是一种成熟的融合方案,目前还不是主流的研究趋势。然而,其融合不同传感器信息的想法仍然值得借鉴。如表V所示,数据级fusionfirst基于雷达点生成感兴趣区域(ROI)[42]、[45]、[54]、[55]。然后根据ROI提取视觉图像的相应区域。最后,使用特征提取器和分类器对这些图像进行目标检测【45】、【47】、【53】、【55】–【61】。12一些文献使用神经网络进行目标检测和分类[61],[62]。对于数据级融合,有效雷达点的数量直接影响最终的检测结果。如果图像的某一部分中没有雷达点,则该部分将被忽略。该方案缩小了目标检测的搜索空间,节省了计算资源,同时也留下了安全隐患。数据级融合过程如图4所示。

2.决策级融合

决策级融合是目前主流的融合方案。过程如表六所示。雷达的优势在于纵向距离,视觉传感器的优势在于水平视野。决策级融合可以兼顾两者的优点,充分利用感知信息。决策级融合滤波算法面临的挑战是建立两种检测信息的联合概率密度函数模型。这是因为两种检测信息的噪声不同。决策级融合主要包括两个步骤:感知信息处理[65]–[69],[71]和决策融合[66],[72]–[78],[84]。决策级融合过程如图5所示。

3.特征级融合

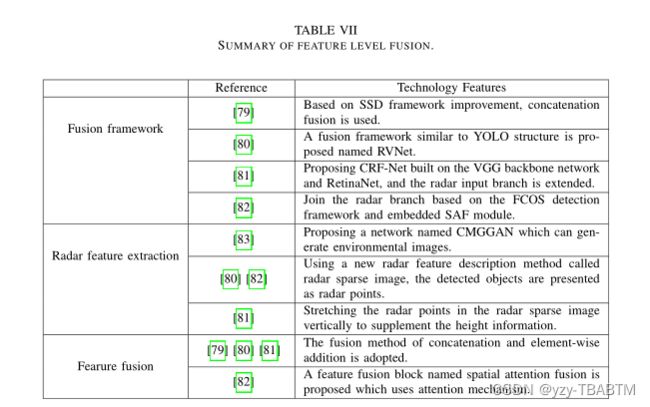

特征级融合是近年来出现的一种新的融合方案。流程如表七所示。在特征级融合方法中使用额外的雷达输入分支是一种常见的方法【79】–【83】。基于CNN的目标检测模型可以有效地学习图像特征信息。通过将雷达检测信息转化为图像形式,检测模型可以同时学习雷达和视觉特征信息,实现特征级融合。

挑战

对于目标检测任务,目前的研究成果已经取得了优异的性能,但这些成果大多是二维目标检测。在真实的自动驾驶场景中,复杂的交通环境通常需要3D目标检测,以更准确地感知环境信息。当前三维目标检测网络的性能远远低于二维检测的水平。因此,提高三维目标检测的精度不仅是自动驾驶领域的一个挑战,也是目标检测任务中的一个重大挑战。毫米波雷达和视觉的融合仍然存在挑战,这是本文的重点。毫米波雷达最大的缺点是雷达特征稀疏。与视觉图像相比,毫米波雷达提供的信息非常少,无法带来显著的性能改善。此外,毫米波雷达和视觉的特征信息是否能够进一步集成,以及它们之间的相关互信息是否已经被挖掘出来还有待研究。因此,毫米波雷达视觉融合仍然面临两大挑战:稀疏的感知信息和更高效的融合方法,这也是多传感器融合领域的两大挑战。

展望——多模态融合

我们在现实世界中看到的物体、听到的声音和闻到的气味都是不同的模态信息。组合同一事物的多模态信息可以帮助AI更好地理解该事物。目前,该领域中比较流行的研究涉及图片、声音、视频和文本的关联,如搜索引擎。因此,无论是毫米波雷达还是激光雷达,其传感信息在不同模式下都是相同的环境信息。雷达传感信息和视觉信息也是不同形态的信息。将雷达视觉融合视为多模态信息融合,可能有更好的解决方案。此外,在自动驾驶领域,数据集提供的毫米波雷达数据是经过后处理的数据。然而,从信息保存的角度来看,后处理雷达数据中包含的信息量必须相对于原始数据丢失。如果将原始雷达检测数据和视觉图像视为两种不同的传感信息进行融合,可以获得更丰富的传感信息。多模态信息融合面临的挑战是如何将不同模态的信息及其携带的噪声完美地结合起来,以及如何挖掘相关信息以帮助理解同一事物。