CVPR2020:Learning Texture Transformer Network for Image Super-Resolution解读

论文信息:

Title:Learning Texture Transformer Network for Image Super-Resolution(用于图像超分辨率的学习纹理transformer网络)

Writers:Fuzhi Yang , Huan Yang, Jianlong Fu, Hongtao Lu , Baining Guo

Conference:cvpr 2020

作者单位:Department of Computer Science and Engineering, MoE Key Lab of Artificial Intelligence, AI Institute, Shanghai Jiao Tong University, Microsoft Research, Beijing, P.R. China

代码链接:添加链接描述

文章链接:添加链接描述

问题动机:

传统的SISR经常导致模糊效果,因为高分辨率(HR)纹理在退化过程中被过度破坏,无法恢复。基于参考的图像超分辨率(RefSR)技术最近取得了进展,它可以从给定的Ref图像中传输HR纹理,以产生视觉上令人愉悦的结果,但效果还是不大令人满意。而现有的基于生成对抗网络(GAN)的图像SR方法可以来缓解上述问题,但由GAN引起的幻觉和伪影进一步对图像SR任务提出了巨大挑战(棋盘效应)。然而它们都忽略了使用注意力机制来从Ref图像中转移高分辨率(HR)纹理,这限制了这些方法在具有挑战性的情况下的应用。

解决思路:

作者提出了一种新的图像超分辨率(TTSR)纹理transformer网络,其中LR和Ref图像分别表示为transformer中的查询(q)和键(k)。TTSR由四个紧密相关的模块组成,这些模块针对图像生成任务进行了优化,包括DNN的可学习纹理提取器、相关性嵌入模块、用于纹理转换的硬注意模块和用于纹理合成的软注意模块。这种设计鼓励对LR和Ref图像进行联合特征学习,其中可以通过注意力发现深层特征对应关系,从而可以传输准确的纹理特征。所提出的纹理transformer可以进一步以跨尺度方式堆叠,这使得能够从不同级别(例如,从1×到4×放大率)恢复纹理(比如参考图是1,需要纹理恢复的是4,这是可行的)。

方法亮点:

1.据作者所知,作者是最早将transformer架构引入图像生成任务的团队之一。更具体地说,作者为图像SR提出了一个具有四个密切相关模块的纹理transformer,它比SOTA方法有了显著的改进。

2.作者为图像生成任务提出了一种新的跨尺度特征集成模块,该模块通过堆叠多个纹理transformer来学习更强大的特征表示。

主要结果:

我们先来关注一下它的纹理transformer的部分

提出的纹理transformer。Q、K和V分别是从上采样LR图像、顺序下/上采样Ref图像和原始Ref图像中提取的纹理特征。h和S表示根据相关性嵌入计算的硬/软注意力图。f是从DNN主干提取的LR特征,并进一步与传输的纹理特征T融合以生成SR输出。而它又由以下几个部分构成:

可学习的纹理提取器(LTE)。在RefSR任务中,参考图像的纹理提取是必不可少的,因为准确和适当的纹理信息将有助于SR图像的生成。我们设计了一个可学习的纹理提取器,其参数将在端到端的训练过程中更新,而不是使用像VGG 那样通过预先训练的分类模型提取的语义特征。这种设计鼓励在LR和Ref图像上进行联合特征学习,从而可以捕获更精确的纹理特征。纹理提取的过程可以表示为:

其中LT E()表示我们的可学习纹理提取器的输出。提取的纹理特征Q(query)、K(key)和V(value)表示transformer内部注意力机制的三个基本元素,并将进一步用于作者的相关性嵌入模块。

相关性嵌入。相关性嵌入旨在通过估计Q和K之间的相似性来嵌入LR和Ref图像之间的相关性。我们将Q和K展开为面片,表示为qi(i∞[1,HLR ×WLR])和kj(j∞[1,HRef × WRef ])。然后,对于Q中的每个面片qi和K中的每个面片kj,我们通过归一化内积计算这两个面片之间的相关性ri,j:

进一步利用相关性得到硬注意图和软注意图。

硬注意。我们提出了一个硬注意模块来转移参考图像的HR纹理特征V。传统的注意力机制对每个查询qi取一个V的加权和。但是,这样的操作可能会造成模糊效果,缺乏传递HR纹理特征的能力。因此,在我们的硬注意模块中,对于每个查询qi,我们只从V中最相关的位置转移特征。

更具体地说,我们首先计算一个硬注意图H,其中第i个元素hi(I∞[1,HLR × WLR])是根据相关性ri,j:

hi值可视为硬索引,表示Ref图像中与LR图像中第I个位置最相关的位置。为了从参考图像中获得转移的HR纹理特征T,我们使用硬注意图作为索引,对展开的V块进行索引选择操作:

![]()

其中ti表示第I个位置的T值,它是从第V个位置中选择的。

因此,我们获得了LR图像的HR特征表示T,它将进一步用于作者的软注意模块。

软-注意。我们提出了一个软注意模块来合成来自DNN中的LR图像的传递的HR纹理特征T和LR特征F的特征。在合成过程中,相关的纹理转移应该被增强,而不太相关的纹理转移应该被消除。为了实现这一点,从ri,j计算软注意图S,以表示T中每个位置的转移纹理特征的置信度:

![]()

其中si表示软注意图S的第I个位置。代替直接将注意图S应用于T,作者首先将HR纹理特征T与LR特征F融合,以利用来自LR图像的更多信息。这种融合的特征进一步元素乘以软注意地图S,并添加回F,以获得纹理transformer的最终输出。此操作可表示为:

![]()

其中Fout表示合成的输出特征。Conv和Concat分别代表一个共解层和连接操作。算子☉表示特征映射之间的元素乘法。

综上所述,纹理transformer能够有效地将参考图像中的相关HR纹理特征转换为LR特征,从而提高了纹理生成的准确性。

接下来我们来看下**跨尺度特征集成(CSFI)**的部分

所提出的跨尺度特征集成模块(CSFI)以跨尺度方式堆叠多个纹理transformer的体系结构)。 RB表示一组剩余块。

作者的纹理transformer可以进一步堆叠在一个跨尺度的方式与跨尺度特征集成模块。 架构如上图所示, 堆叠纹理transformer输出三个分辨率尺度(1×、2×和4×)的合成特征,使不同尺度的纹理特征能够融合到LR图像中。 为了在不同尺度上学习更好的表示,作者提出了一个跨尺度特征集成模块(CS FI),以在不同尺度的特征之间交换信息。 每次将LR特征向上采样到下一个尺度时,都会应用CSFI模块。 对于CSFI模块内的每个尺度,它通过上/下采样接收来自其他尺度的交换特征,然后在信道维度中进行级联操作。 然后,卷积层将特征映射到原始信道数。在这样的设计中,从堆叠纹理transformer传递的纹理特征在每个尺度上交换,从而实现了更强大的特征表示。 这种跨尺度特征集成模块进一步提高了作者的方法的性能。

最后我们再来看下它的损失函数

在作者的方法中有3个损失函数。 总体损失可解释为:

![]()

重建损失。 第一损失为重建损失:

![]()

其中(C,H,W)是HR的大小。作者利用了L1损失,该损失已被证明比L2损失更有利于性能和收敛。

对抗损失。生成性对抗网络被证明能有效地生成清晰且视觉上有利的图像。这里作者采用了WGAN-GP ,它提出用梯度范数的惩罚来代替权重裁剪加粗样式,使得训练更加稳定,性能更好。这种损失可以解释为:

感知损失。 感知损失已被证明对提高视觉质量有用。 感知损失的关键思想是增强预测图像与目标图像在特征空间上的相似性。 这里我们的知觉损失包含两部分

其中第一部分是传统的感知损失,其中φvggi(·)表示VGG19的第i层特征映射,(Ci,Hi,Wi)表示该层特征映射的形状。 ISR是预测的SR图像。 我们的知觉损失的第二部分是转移知觉损失,其中φLTEj(·)表示从所提出的LTE的J层中提取的纹理特征映射,(Cj、Hj、Wj)表示该层的形状。 图2中的T是传输的HR纹理特征。 这种传递知觉损失限制了预测的SR图像与传递的纹理特征T具有相似的纹理特征,这使得作者的方法更有效地传递Ref纹理。

结果对比

消融研究

在这一部分中,作者验证了方法中不同模块的有效性,包括纹理transformer、跨尺度特征集成、对抗性损失和转移感知损失。 此外,作者还讨论了不同参考相似性对TTSR的影响。

纹理transformer。我们的纹理transformer主要包括四个部分:可学习纹理提取器(LTE)、相关性嵌入模块、特征传递的硬注意模块和特征合成的软注意模块。消融结果见表2。我们仅通过移除所有BN层和Ref部分,将SRNTT [41]重新实施为我们的“基础”模型。在基线模型的基础上,我们逐步添加了HA、SA和LTE。没有LTE的型号使用VGG19特性进行相关性嵌入。由此可知,加入HA后,PSNR性能可从26.34提高到26.59,验证了硬注意模块对特征转移的有效性。当涉及SA时,在特征合成过程中,相关纹理特征将被增强,而不太相关的纹理特征将被消除。这进一步提高了性能到26.81。当用推荐的LTE代替VGG时,PSNR最终提高到26.92,证明了联合特征嵌入在LTE中的优越性。

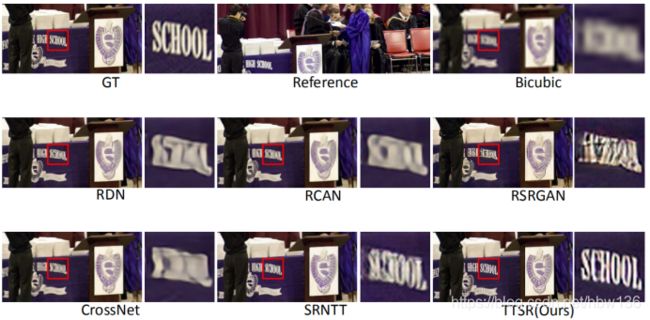

硬注意力,为了进一步验证LTE的有效性,作者使用硬注意力图来传输原始图像。期望更好的特征表示可以从原始图像转移更精确的纹理。上图显示了VGG19在TTSR SRNTT和LTE中传输的原始图像。在这个图中,TTSR可以转移更精确的参考纹理,并产生一个全球有利的结果,这进一步证明了作者的LTE的有效性。

跨尺度特征集成。除了纹理transformer之外,CSFI还可以进一步实现不同分辨率尺度(1×、2×、4×)的纹理恢复。我们进行了表3所示的消融研究。第一行显示了只有TT的模型的性能,而第二行证明了CSFI的有效性,这使PSNR度量增加了0.17。为了验证性能的提高不是由参数大小的增加带来的,我们将“Base+TT”模型的通道数增加到80和96。由此可知,“Base+TT(C80)”几乎没有增长,其参数值与“Base+TT+CSFI”几乎相同。即使作者将参数个数增加到9.10M,得到“Base+TT(C96)”模型,仍然存在性能差距。

这证明了CSFI能够以相对较小的参数大小有效地利用参考纹理信息。

对抗损失。确保感知质量的提高受益于模型设计,而不是对抗损失。作者在“Baserec”、“Base”、TTSR-rec和TTSR之间进行消融,其中TTSR可解释为“Base+TT+CSFI”,而“-rec”表示仅伴有重建损失的训练。上图显示,即使没有感知和对抗损失,TTSR-rec仍然可以利用参考图像并恢复比“Base-rec”更多的细节。在所有损失都在的情况下,TTSR获得了最好的视觉效果。

转移知觉损失。 转移知觉损失限制了预测的SR图像和转移的图像T之间的LTE特征是相似的。 如上图所示,使用这个损失能够以更有效的方式传输纹理,从而获得视觉上令人愉悦的结果。 此外,这一损失还将TTSR的定量指标PSNR和SSIM从25.20/757提高到25.53/765。

不同参考相似度的影响。为了研究LR和Ref图像之间的相关性如何影响TTSR结果,作者在CUFED5测试集上进行了实验,该测试集包含不同相关性水平的参考图像。表4显示了五个相关性级别的结果,其中“L1”至“L4”表示CUFED5测试集提供的参考图像,其中L1是最相关级别,L4是最不相关级别。“LR”表示使用输入图像本身作为参考图像。如下表所示,使用L1作为参考图像的TTSR获得了最佳性能。当使用LR作为参考图像时,TTSR仍然比以前的最先进的RefSR方法表现得更好。

总结

本文提出了一种新的图像超分辨率纹理transformer网络(TTSR),它将HR纹理从Ref传输到LR图像。 该纹理transformer由一个可学习的纹理提取器组成,该提取器学习用于进一步注意计算的联合特征嵌入和两个基于注意的模块,它们从Ref图像中传输HR纹理。 此外,所提出的纹理transformer可以与所提出的CSFI模块交叉叠加,以学习更强大的特征表示。 广泛的实验表明,我们的TTSR在定量和定性评价方面优于最先进的方法。 在未来,我们将进一步将所提出的纹理transformer扩展到一般的图像生成任务。

阅读参考

1·自注意力机制详解

添加链接描述

2·transformer详解(encoder部分是重点(QKV))

添加链接描述