综述|线结构光中心提取算法研究

点击上方“3D视觉工坊”,选择“星标”

干货第一时间送达

摘 要: 线结构光扫描是三维重建领域的关键技术。光条纹中心提取算法是决定线结构光三维重建精度以及光条纹轮廓定位准确性的重要因素。本文详细阐述了光条纹中心提取算法的理论基础及发展历程,将现有算法分为三类,传统光条纹中心提取算法、基于传统光条纹中心提取的改进算法、基于神经网络光条纹中心提取算法,并提出每一类算法的优势与不足。最后,对线结构光中心提取算法的发展提出展望,生产更高质量的线激光器,扩充基于神经网络的光条纹中心线检测模型的训练样本。

关键词:中心提取;线结构光;三维重建;光条纹

1.引言

双目立体视觉技术是三维重建领域的关键技术之一,广泛应用于机器人视觉导航,非接

触性三维测量,工业检测,医学成像,航空测绘,军事应用和全息投影等领域[1]。双目视觉测量原理是两台平行放置的CCD相机观测同一物体,相机分别获取图像并提取两幅图像中的特征点进行立体匹配,使用三角测量法由视差值计算物点的三维空间坐标[2]。立体匹配是双目视觉测量最关键的模块[3],对于表面光滑、图像灰度变化小的物体立体匹配的难度极高[4]。因此引入线结构光扫描技术主动增加图像的纹理特征,利用双目相机采集线结构光条纹[5]如图 1所示。由于设备硬件结构的原因激光器投射出的线结构光光条纹通常具有3~12个像素宽度,需要提取单像素甚至亚像素级的光条纹中心作为双目视觉系统的匹配点[6,7]。因此光条纹中心点的提取是立体视觉测量中的关键问题,目前使用最广泛的中心提取算法是Steger C在二十世纪末提出的基于Hessian矩阵的Steger算法,长期以来国内外研发团队基于Steger算法以及其他传统算法不断做出改进,显著提高了中心提取算法精度。本文对近二十年的光条纹中心提取算法进行综述,将现有算法分为三类,传统光条纹中心提取算法、基于传统光条纹中心提取的改进算法、基于神经网络光条纹中心提取算法,并提出各种算法的优势与不足。

图1 双目系统采集线结构光条纹

Fig.1 Structure light stripe of acquisition line of binocular system

2. 传统光条纹中心提取算法

传统的光条纹中心提取算法有灰度重心法、阈值法、极值法、边缘法、中心法、二值形态学细化法、Steger算法、曲线拟合法、深度约束法。本文根据不同算法的理论基础与特点将其分为四大类,光条纹几何中心提取方法、基于光条纹灰度分布特点提取方法、基于形态学条纹中心提取方法、光条纹亚像素中心提取方法。

2.1 基于光条纹灰度分布特点提取方法

2.1.1 灰度重心法条纹中心提取

投射到平坦物体表面的线结构光条纹截面光强分布近似服从高斯分布[7]。通过灰度重心法可以求出条纹横截面光强分布曲线的高斯中心[8],对光条纹逐行提取高斯中心,将中心点拟合形成光条纹中心线。

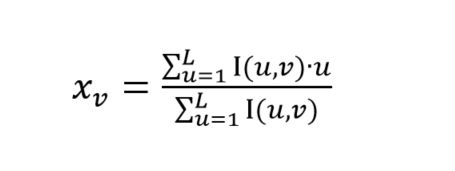

灰度重心法的计算公式如下:

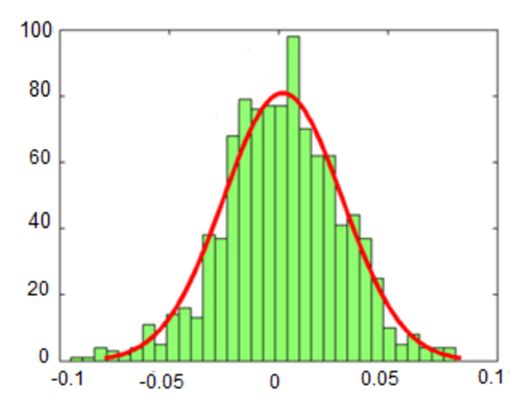

光条纹第v列的灰度重心坐标为p(xv,v),在包含U行,V列的图像中坐标(u,v)处的像素灰度值为I(u,v),其中u=1,2,3,…,U;v=1,2,3…,V。灰度重心法速度快,实时性好,当光条纹投射在形态复杂的物体表面时,光条纹会产生较大形变,此时条纹截面呈现非高斯分布,继续使用灰度重心法会出现中心提取误差,如图 2所示。

图2 中心提取误差直方图[45]

Fig.2 Histogram of center extraction error

2.1.2 极值法提取光条纹中心

极值法的原理是对光条纹横截面的灰度分布函数做梯度运算,将梯度值为零处的像素点作为光条纹中心点,极值法对截面像素呈高斯分布的光条纹适用性较高[9,10],由于是基于灰度值的方法提取中心点,算法易受噪声影响,信噪比较小的图像不采用此方法[11,12]。

2.1.3 曲线拟合法提取光条纹中心

由于条纹截面光强分布呈高斯分布[13],对条纹截面的像素点采用二次抛物线拟合[14]与最小二乘法的高斯曲线拟合[14,15],光条纹每一行截面拟合结果的局部极大值对应的像素点即为条纹中心[16]。

2.1.4 方向模板法提取光条纹中心

方向模板法最初由胡斌[17]提出,是基于灰度重心法的改进算法。线结构光投射到粗糙的物体表面时,光条纹会发生形变与偏移,在一定范围内,可认为光条纹向四个方向发生偏移,水平、垂直、左倾45o、右倾45o。对应上述光条纹发生偏移的四种情况,构建四个方向的模板,分别与条纹截面各行的像素块做卷积,取响应值最大的像素块中心点作为该行的条纹中心。方向模板法能够克服白噪声的影响,并可以在一定程度上修补断线,但受限于有限的模板方向,纹理复杂的物面会使条纹向更多方向发生偏移。

2.1.5 脊线跟踪法提取光条纹中心

将光条纹各行横截面灰度值最大的点连接成条纹脊线,沿脊线切线方向灰度值变换平缓,脊线的法线方向光条纹灰度值逐渐降低。脊线跟踪法对噪声十分敏感[10]。

2.2 光条纹几何中心提取方法

2.2.1 边缘法和中心法提取光条纹中心

提取光条纹的两条边缘如图3(a)所示,并以其中一条边缘作为光条纹中心,边缘法处理速度快,但会给三维重建结果带来很大误差。常用的条纹边缘提取方法有Canny算法[18],Canny算法需要调整高低阈值及高斯滤波器大小。考虑光条纹边缘的连续性也可以采用邻域法提取光条纹边缘[11],提取到的光条纹两个边缘线的列坐标分别为u、v,则中心法得到的光条纹中心的列坐标y=(u+v)/2。如图3(b)所示,中心法提取的光条纹中心点准确性高于边缘法,但由于图像噪点影响,边缘线的提取会出现误差导致中心法的效果不佳。

图3(a) 边缘法[23]

(b) 中心法[23]

Fig.3 (a) arginal method;(b) Central method

2.2.2 阈值法提取光条纹中心

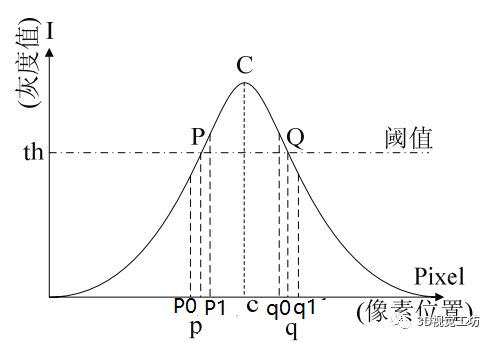

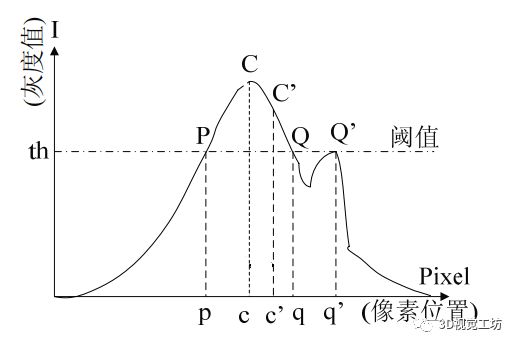

设定阈值T,在光条纹截面上找到最接近阈值的四个点,用这四个点在光条纹截面上的坐标以及灰度值做线性插值,得到光条纹截面上的两个点p,q的坐标,取p,q的中点即为光条纹中心点如图4所示。阈值法可以做到实时提取中心点,但易受到噪声干扰导致线性插值结果出现偏差如图5所示为噪声对阈值法的干扰。

图4阈值法[10]

图5 噪声对阈值法的影响[10]

2.2.3 基于形态学条纹中心提取方法

利用细化法[19]提取光条纹中心骨架,由于光条纹具有一定的宽度,所以需要对光条纹反复进行形态学处理,对光条纹不断地进行腐蚀操作,剥离光条纹边界,同时也要保证剥离边界后的光条纹中心线是单像素宽度的连通线,连通线保持光条纹原有的拓扑结构。由于光照影响,细化法提取的条纹中心线有毛刺出现,使中心线的宽度超过单像素。

2.2.4 光条纹亚像素中心提取方法

Steger算法利用Hessian矩阵对图像求二阶方向导数[20],二阶方向导数绝对值最大的方向就是光条纹的法线方向[10]。

Hessian矩阵的表达式:

h(x,y)为二维高斯函数,f(x,y)表示Hessian矩阵求二阶导数的图像。Hessian矩阵对f(x,y)中像素点(u,v)进行5次二维高斯卷积运算[9,10],得到绝对值最大的特征值对应的特征向量就是该点的法线方向。并在法线方向上对光条纹灰度分布函数二阶泰勒展开,得到一阶过零点即为光条纹中心点。Hessian矩阵对图像求方向导数的过程运算量巨大,无法达到实时的效果[20]。

3. 基于传统光条纹中心提取的改进算法

传统光条纹中心提取算法中最常用的有灰度重心法、方向模板法、Steger法,如表1所示算法均存在一定的缺陷。近年来许多研究人员对传统条纹中心提取算法做出改进。

表1 光条纹中心提取算法的缺陷 Table 1 Defects in the extraction algorithm of light stripe center |

|

算法 |

缺陷 |

灰度重心法 |

要求光条纹横截面呈完整的高斯分布 |

易受环境噪声与传感器引入的误差的影响 |

|

方向模板法 |

受限于有限的模板方向 |

物体表面粗糙度会影响条纹中心提取精度 |

|

Steger算法 |

运算量过大,效率低 |

高斯核选取不恰当会导致图像信息失真 |

|

3.1 灰度重心法的改进

由于高空间相干性,线激光器会产生随机的斑点或颗粒状的图案,光条纹截面会出现宽度不一致的问题如图6所示。张小艳[21]等提出一种自适应二值化处理的方法先确定位光条纹各行截面边界,根据不同的条纹边界宽度利用灰度重心法提取光条纹中心点,提高了中心线提取准确性。

图6 变形的光条纹[27]

刘振[22]等通过条纹中心点间邻域灰度变化较平缓的特点,引入高斯分布互相关系数,自适应地调节互相关模板大小,结合互相关算法与曲线拟合算法精确定位条纹中心点,算法对于高光强背景的情况表现良好。

赵博华[23]等利用形态学方法[12]设定连通域面积阈值,去除噪声并输出具有有效光条信息的二值化模板图像,利用模板与原图像相乘获得无噪声的光条图像,使用灰度重心法提取光条中心线,有效的克服了外部噪声干扰。

粗糙的物体表面会导致光条纹发生不规则的扭曲变形,席剑辉[24]等结合高斯拟合算法与灰度重心算法提出一种快速提取条纹中心线的方法,先利用差影法提取二值化条纹图像,创建模板对图像进行两次卷积处理并采用中值滤波[25]去除噪点,在条纹边缘的局部邻域内计算像素点的梯度从而确定光条法线方向,在法线方向上利用灰度重心法获取光条中心点如图5所示。算法克服了因粗糙的物面造成的光条纹形变问题。

图5 基于骨架的灰度重心法[31]

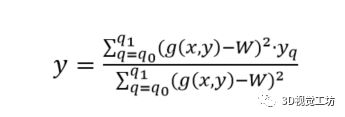

赵彬[26]等提出一种自适应阈值的加权重心法提取光条纹中心。将多通道的BGR图像转换成只有R通道的光条纹图像,实验证明R通道的光条纹像素点灰度分布最接近高斯分布。通过Otsu自适应阈值法获取图像的最佳分割阈值从而将光条纹与背景分离,提高算法运算效率。最后利用加权灰度重心法提取光条中心点,该算法增强了条纹中心点局部邻域像素的权重,更精准的定位中心点坐标。

加权灰度重心法公式:

其中q为光条纹宽度范围,W为自适应阈值法的最佳阈值。g(x,y)为像素灰度值,yi为像素坐标值,y就是光条纹中心坐标。

3.2 方向模板法的改进

李和平[27]等提出一种基于遗传算法的光条纹中心提取算法,首先利用遗传算法[28,29]自动选取颜色阈值从图像中分割出光条纹区域,再通过方向模板法获取光条中心线,采用人机交互的方式填充断裂的中心线。算法增强了抗噪声的能力,实现了断线修补。

针对方向模板法计算量大,运算效率低,光条纹中心提取精度只能达到像素级别等问题。苏小勤[30]等基于方向模板法、中心法、灰度重心法,提出了一种快速提取光条纹中心的算法。首先通过中心法提取光条骨架,利用基于位置的发现判断法求取骨架法线方向,在法线方向上对条纹截面的像素进行灰度加权提取条纹中心。

由于投射面反射率不一致,光条纹会出现粗细不均匀的情况。传统方向模板法四个方向的高斯模板大小是固定的,当局部条纹宽度较小时,中心线会偏离结构光中心。为克服这一问题,王泽浩[31]等提出一种自适应方向模板法,首先利用灰度属性邻域法[32]对图像去噪,根据不同的条纹截面宽度自动调整方向模板大小,对结构光中心线有很好的追随性,提高了中心线提取的准确率。

方向模板法输出光条纹三维数据的图像点列,直接使用这些点拟合条纹中心线,会出现大量毛刺。为了解决以上问题,金俊[33]等结合多帧平均法和方向模板法提出一种基于Bezier曲线拟合的光条中心提取方法。算法使用最大方差阈值分割和灰度领域属性将两幅含有结构光条纹的图像求平均,再与不含光条纹的图像做差,从而获得无噪声的光条图像[17]。利用方向模板法初步提取光条纹中心点,最后使用基于Bezier曲线的最小二乘法将这些点拟合成完整的光条纹中心线。算法提高了中心线提取速度,并修补断点。

不同于直线光条纹中心线提取,针对大曲率的线结构光条纹中心提取问题,辛军强[34]等利用自适应阈值法分割光条纹与图像背景,对分割出的光条纹采用并行细化算法提取单像素骨架,通过方向模板法获取骨架像素点的法线方向,在法线方向上使用灰度重心法获取光条纹中心点如图7所示。算法准确度较高,可以做到实时检测。

图7基于方向模板的灰度重心中心线

3.3 Steger算法的改进

张远[35]等采用FPGA的递归逻辑结构提高Steger算法的运算效率,使条纹中心提取算法的精度不受二维高斯卷积核参数的影响,增加了算法的灵活性。

胡坤[36]等将Steger算法与阈值法结合,利用阈值法分离光条纹与图像背景,提取光条纹ROI减小Hessian矩阵的运算量。并根据高斯函数的可分离性[37],将Hessian矩阵的二维高斯卷积核转换为一维高斯卷积核。该算法提高了Steger算法的运算效率。

Steger算法运算量大,效率低的最主要因素是Hessian矩阵对图像反复进行5次二维高斯卷积运算求取光条纹各像素点的法线方向。蔡怀宇[38]等利用PCA[39]方法对图像梯度向量的协方差矩阵进行特征分解[40],代替Hessian矩阵计算光条纹的法线方向,提高了算法运算效率。

刘剑[41]等,提出一种Hessian矩阵与区域增长算法结合的条纹中心提取算法,先利用Hessian矩阵确定像素点的法向量,在法线方向上对条纹灰度分布函数泰勒展开获得中心点亚像素坐标作为初始种子点,区域增长迭代算法通过Hessian矩阵确定种子点的切线方向,在该方向的8邻域内寻找下一个种子点进行,将所有种子点拟合形成条纹中心线如图7所示。该算法克服了噪声对中心点提取的影响,相比文[20]算法速度提升了40倍,均方差相比灰度重心法降低了2.02 pixel。

图7 条纹中心线效果图

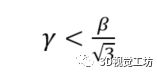

岳龙[42]等针对物体表面反射率差异较大的情况,基于Steger算法提出一种自适应条纹中心提取算法。利用Hessian矩阵计算光条纹的法向方向,在法向方向上根据条纹不同的截面宽度调整高斯函数的均方差参数σ,最后对条纹灰度分布函数泰勒展开获得条纹中心点。该方法自适应地提取曲率变化较大的条纹,一定程度上提高了运算效率。

Hessian矩阵高斯函数的均方差参数γ与条纹宽度β的关系:

程鑫[43]等针对检测对象为黑色胶体的情况,提出一种基于阈值分割的Hessian矩阵定位和高斯曲线拟合的算法。首先对图像采用中值滤波去除噪点,通过阈值法提取光条纹图像的ROI,并对ROI的高频区域进行线性增强提升图像对比度。利用极值法找到条纹截面灰度极大值作为初始条纹中心点。将初始中心点带入Hessian矩阵计算光条纹的法向方向,在法向方向上对条纹灰度分布函数二阶泰勒展开得到条纹中心点坐标。最后采用高斯函数对中心点集进行函数逼近的拟合,获取光条纹精确的中心点坐标[44]。算法鲁棒性高,能够增强投射到特殊物体表面的光条纹稳定性。

4. 基于神经网络光条纹中心提取算法

李玥华[45]等提出一种基于BP神经网络的光条纹中心提取方法。先设定光条截面中心点的灰度阈值为 IT=50,选取图像中每列像素的有效光条截面区域。搭建为三层神经网络,输出层神经元个数为1,输入层个数11、隐层神经元个数设定为3。通过Steger算法对一系列弧形、随机、间断、齿形光条提取光条纹中心点并利用最小二乘法拟合获取光条纹中心线,将以上四种条纹中心线图像作为模型训练样本,训练BP神经网络。训练后的网络模型对各种复杂光条纹中心提取误差均值小于0.02 pixel,算法平均用时仅为文[120]的0.27%,克服了灰度重心法和Steger算法的缺点。

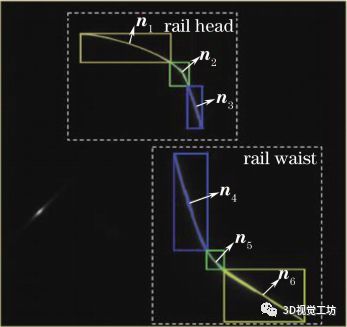

王胜春[46]等提出了一种基于分区域多模板匹配的光条纹中心提取算法。先对图像提取结构光条纹ROI,提高光条纹在图像中的比重。根据光条纹的灰度分布和梯度方向等特征利用ENet神经网络将条纹分割为多个区域如图8所示。传统计算条纹法线的方法是对图像全局进行梯度计算,耗时巨大。针对这一问题该算法首先通过基于梯度直方图统计的区域划分方法,确定每个分割出的光条纹子区域的法线主方向。每个条纹子区域与其对应的方向模板在其法线方向上进行互相关运算[47],初步提取光条纹中心点。以初始中心点为基点,利用灰度重心法沿着该点所在的子区域法线方向提取光条亚像素中心点。该算法采用ENet模型代替传统的SegNet图像分割模型,在保证分割效果情况下,运算速度提升了18倍,浮点计算量减少至传统模型的1/76,参数设置减少至1/80。克服了噪声对光条中心提取的干扰,提升算法的提取精度。

图8 线结构光光条区段划分[46]

5.总结与展望

随着三维重建领域的快速发展,线结构光扫描技术逐渐成熟,结合不同的工业生产需求取得了很多创新性成果。本文综述了线结构光中心提取技术的三个不同发展阶段。先介绍了各种传统的结构光中心提取技术并指明算法缺陷。针对传统算法提取精度差,运算量过大,易受外部环境噪声干扰等缺陷以及不同的应用场景,总结了基于不同传统算法组合的一系列改进算法。除此之外,分析了神经网络结合线结构光中心提取技术的应用及效果。本文对线结构光中心提取技术的发展提出如下展望:

生产更高质量的线激光器,避免出现光条纹截面宽度不一致的现象。光条纹截面灰度分布更接近高斯分布的线结构光和亚微米级的激光器也是提升条纹中心提取技术的精度关键因素。

本文提到的基于神经网络的光条纹中心提取算法可以达到很高的精度。为提高算法鲁棒性使其适应各种应用场景,扩充现有的数据集并添加具有一定噪声的随机光条图像是一种很好的方法。由于深度学习模型的网络结构较为复杂,提升算法速度是需要解决的关键问题。

参考文献

[1] Shuang Y, Baoyuan C, Lei Z, et al. Encoded lightimage active feature matching approach in binocular stereo vision[C]. Internationalforum on strategic technology, 2016: 406-409.

[2] Tong S, Xu XG, Yi C T, et al. A survey of 3D reconstructiontechnology based on vision[J]. Application Research of Computers. 2011, 28(7):411-2417.

佟帅, 徐晓刚, 易成涛, 等. 基于视觉的三维重建技术综述[J]. 计算机应用研究, 2011, 28(7): 411-417.

[3] Lin J Y, Huang C B, L B, et al. Laser line scanning technologybased on binocular stereo vision[J]. Machine Design and ManufacturingEngineering, 2011, (8): 200-202.

林俊义, 黄常标, 刘斌, 等. 一种基于双目立体视觉的激光线扫描技术[J]. 机械设计与制造, 2011, (8): 200-202.

[4] Zhu S P, Qiang X F. A survey of 3D coordinatevision measurement methods for workpiece feature points[J]. Optics andPrecision Engineering, 2000, 8(2): 192-197.

祝世平, 强锡富. 工件特征点三维坐标视觉测量方法综述[J]. 光学精密工程, 2000, 8(2): 192-197.

[5] Jia Z Y, Fan C N, Liu W, et al. Extraction of light stripe centerof middle matching point in binocular vision measurement[J]. Optics andPrecision Engineering, 2016, 24(7): 1582-1591.

贾振元, 樊超楠, 刘巍, 等. 双目视觉测量中等匹配点的光条中心提取[J]. 光学精密工程, 2016, 24(7): 1582-1591.

[6] Yang J H, Yang X R, Cheng S Y, et al. A survey of the centerextraction of light stripe in 3D vision measurement of line structured light[J].Journal ofGuangdong University of Technology, 2014, (1): 74-78.

杨建华, 杨雪荣, 成思源, 等. 线结构光三维视觉测量中光条纹中心提取综述[J]. 广东工业大学学报, 2014, (1): 74-78.

[7] Wu Q Y, Su X Y, Li J Z, et al. A new algorithm forextracting the center of light band of line structured light[J]. Journal of Sichuan University(Natural Science Edition), 2007, 39(4): 151-155.

吴庆阳, 苏显渝, 李景镇, 等. 一种新的线结构光光带中心提取算法[J]. 四川大学学报(工程科学版), 2007, 39(4): 151-155.

[8] PERONA P, MALIK J. Scale-space and edge detection using anisotropicdiffusion[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,1990, 12(7) : 629-639.

[9] Yang W. Research on the method of extracting the center of structuredlight stripe[D]. Harbin: Harbin Institute of Technology, 2009.

杨尉. 结构光光条中心提取方法研究[D]. 黑龙江: 哈尔滨工业大学, 2009.

[10] Xu N. Research on imageprocessing method of line structured light stripe[D]. Harbin: HarbinEngineering University, 2007.

许宁. 线结构光光条图像处理方法研究[D]. 黑龙江: 哈尔滨工程大学, 2007.

[11] Li Y H, Zhou J B, Liu L J.Research progress of line structured light measurement technology[J]. Journalof Hebei University of Science and Technology, 2018, 39(2): 115-124.

李玥华, 周京博, 刘利剑. 线结构光测量技术研究进展[J]. 河北科技大学学报, 2018, 39(2): 115-124.

[12] JIA Q Q, WANG B X, Luo X Z.Extraction of central positions of light stripe in sub-pixel in 3D surfacemeasurement based on light ping method[J]. Optics and PrecisionEngineering. 2010, 18(2): 390-396.

贾倩倩, 王伯雄, 罗秀芝. 光切法形貌测量中光条中心的亚像素提取[J]. 光学精密工程, 2010, 18(02):390-396.

[13] Izquierdo M A, Sanchez M T,Ibanez A, et al. Sub-pixel measurement of 3D surfaces by laserscanning[J]. Sensors and Actuators A-physical, 1999, 76(1): 1-8.

[14] He J J, Zhang G J, Research onthe method of strip image processing in structured light 3D visiondetection[J]. Journal of BeijingUniversity of Aeronautics and Astronautics, 2003, 29(7): 593-597.

贺俊吉, 张广军. 结构光三维视觉检测中光条图像处理方法研究[J]. 北京航空航天大学学报, 2003, 29(7): 593-597.

[15] Lukas J, Fridrich J, Goljan M,et al. Detecting digital image forgeries using sensor pattern noise[C]. conferenceon security steganography and water marking of multimedia contents, 2006.

[16] Cai H Y, Yu Y, Huang Z H, etal. A new method of extracting the center of interference fringes based oncurve fitting[J]. Journal ofOptoelectronics·Laser, 2006, 17(1):115-118.

蔡怀宇, 于毅, 黄战华, 等. 一种基于曲线拟合提取干涉条纹中心点的新方法[J]. 光电子·激光, 2006, 17(1): 115-118.

[17] Hu B, Li D H, Jin G, et al.Detection method of stripe center of structured light based on directiontemplate[J]. Computer Engineering andApplications. 2002, 38(11): 59-60,109.

胡斌, 李德华, 金刚, 等. 基于方向模板的结构光条纹中心检测方法[J]. 计算机工程与应用, 2002, 38(11): 59-60,109.

[18] Li C M, Wang M M, Liu H Y, etal. Research on the accurate algorithm of extracting the center of linestructured light[J]. Machinery& Electronics,2017, 35(6): 29-31.

李春明, 王萌萌, 刘海洋, 等. 精确的线结构光中心提取算法研究[J]. 机械与电子, 2017, 35(6): 29-31.

[19] Jang Y F, Jang K Y, Lin J Y.Accurate sub-pixel extraction method of light stripe center in line structuredlight[J]. Laser & Optoelectronics Progress, 2015, 52(7): 177-183.

江永付, 江开勇, 林俊义. 线结构光光条中心亚像素精确提取方法[J]. 激光与光电子学进展, 2015, 52(7): 177-183.

[20] Steger C. An Unbiased Detectorof Curvilinear Structures[J]. IEEE Transactions on Pattern A nalysis andmachine Intelligence. 1998, 20(2): 113 -125.

[21] Zhang X Y, Wang X Q, Bai F Z, etal. An algorithm for extracting the center of light band based on theimproved gray center of gravity method[J]. Laser & Infrared, 2016, 46(5): 622-626.

张小艳, 王晓强, 白福忠, 等. 基于改进灰度重心法的光带中心提取算法[J]. 激光与红外, 2016, 46(5): 622-626.

[22] Liu Z, Li S, Feng C.Extraction of laser stripe center based on cross correlation algorithm[J]. Chinese Journal of Lasers, 2013, 40(5): 197-202.

刘振, 李声, 冯常. 基于互相关算法的激光条纹中心提取[J]. 中国激光, 2013, 40(5): 197-202.

[23] Zhao B H, Wang B X, Zhang J, etal. The method of extracting the center of light strip on rough metalsurface[J]. Optics and Precision Engineering, 2011, 19(9):2138-2145.

赵博华, 王伯雄, 张金, 等. 粗糙金属表面光条中心提取方法[J]. 光学精密工程, 2011, 19(9):2138-2145.

[24] Xi J H, Bao H, Ren Y. Fastextraction algorithm of normal center of laser stripe[J]. Science andTechnology & Innovation,

2018, (1):41-43.

席剑辉, 包辉, 任艳. 激光条纹法向中心的快速提取算法研究[J]. 科技与创新, 2018, (1): 41-43.

[25] Xing Wang S J, Deng H J, etal. A new filtering algorithm based on extremum and median[J]. Journalof Image and Graphics, 2001, (6): 533-536.

刑藏菊, 王守觉, 邓浩江, 等. 一种基于极值中值的新型滤波算法[J]. 中国图象图形学报, 2001,(6): 533-536.

[26] Zhao B, Ma G J. Research onsubpixel location of the center of linear laser stripe[J]. Electronic DesignEngineering, 2017, 25(24): 184-188, 193.

赵彬, 马国军. 线激光条纹中心亚像素定位研究[J]. 电子设计工程, 2017, 25(24): 184-188,193.

[27] Li H P, Li D H, Zhu Z, etal. Detection method of stripe center of structured light based on geneticalgorithm[J]. Optics and Precision Engineering, 2004, 12(1):82-87.

李和平, 李德华, 朱洲, 等. 基于遗传算法的结构光条纹中心检测方法[J]. 光学精密工程, 2004, 12(1): 82-87.

[28] ZHANG Y J. Image Segmention[M].Beijing: Science Press, 2001.

章毓晋. 图像分割[M]. 北京:科学出版社,2001.

[29] FOGEL D B. An introduction tosimulated evolutionary optimization[J]. IEEE-NN, 1994, 5(1): 3-14.

[30] Su X Q, Xiong X M. A fastalgorithm for extracting the center of line structured light[J]. Journal of Computer Applications. 2016, 36(1): 238-242.

苏小勤, 熊显名. 快速线结构光中心提取算法[J]. 计算机应用, 2016, 36(1): 238-242.

[31] Wang Z H, Zhang Z W. Themethod of extracting the fringe center of the adaptive direction template linestructure light[J]. Laser Journal, 2017, 38(1): 60-64.

王泽浩, 张中炜. 自适应方向模板线结构光条纹中心提取方法[J]. 激光杂志. 2017, 38(1): 60-64.

[32] Fang C. Research onsymmetrical line laser road rutting detection technology[D]. Xian: Chang'anUniversity, 2010.

方翠. 对称式线激光路面车辙检测技术研究[D]. 西安: 长安大学, 2010.

[33] Jin J, Li D H, Li H P. NewMethod for Obtaining the Center of Structured Light Stripe[J]. COMPUTERENGINEERING AND APPLICATIONS, 2006, 42(4): 42-44.

金俊, 李德华, 李和平. 结构光三维获取系统条纹中心线检测[J]. 计算机工程与应用, 2006, 42(4):42-44.

[34] Xin J Q, Wu Y B, Huang J.Research on the method of extracting the center line of high curvature laserstripe[J]. China Computer & Communication, 2018, (2): 39-40,46.

辛军强, 吴远波, 黄劼. 大曲率激光条纹中心线提取方法研究[J]. 信息与电脑, 2018, (2):39-40,46.

[35] Zhang Y, Zhang G J, Jiang J.Design and implementation of FPGA recursive logic structure of Stegeralgorithm[J]. Transducer and MicrosystemTechnologies. 2008, 27(9): 78-81.

张远, 张广军, 江洁. Steger算法的FPGA递归逻辑结构设计与实现[J]. 传感器与微系统, 2008, 27(9):78-81.

[36] Hu K, Zhou F Q. A fastsubpixel extraction method of stripe center line[J]. Electro-Optic Technology Application. 2005(06): 60-63.

胡坤, 周富强. 一种条纹中心线快速亚像素提取方法[J]. 光电技术应用, 2005(06): 60-63.

[37] Jia Y D. Machine Vision[M].Beijing: Science Press, 2000: 34-63.

贾云得. 机器视觉[M]. 北京: 科学出版社, 2000: 34-63.

[38] Cai H Y, Feng Z D, Huang Z H.A method of extracting stripe center of structured light based on principalcomponent analysis[J]. ChineseJournal of Lasers. 2015, 42(3):270-275.

蔡怀宇,冯召东,黄战华. 基于主成分分析的结构光条纹中心提取方法[J]. 中国激光, 2015, 42(3): 270-275.

[39] Pearson K. On lines and planesof closest fit to systems of points in space[J]. Philosophical Magazine,1901, 2(6): 559-572.

[40] Abdi H, Williams L J. Principalcomponent analysis[J]. Wiley Interdisciplinary Reviews: ComputationalStatistics,2010,2(4):433-459.

[41] Liu J, Liu L H. Extraction oflaser stripe center based on Hessian matrix and region growth[J]. Laser & Optoelectronics Progress,2019, 56(2): 105-110.

刘剑, 刘丽华. 基于海森矩阵与区域增长的激光条纹中心提取[J]. 激光与光电子学进展, 2019, 56(2): 105-110.

[42] Yue L, Guo X Q, Yu J. Researchon Self-adptive Extraction Method of Central Points in Complex Light Stripe[J].Science Technology and Engineering, 2016, 16(14): 236-239,244.

岳龙, 郭喜庆, 余锦. 自适应复杂光条纹中心提取方法研究[J]. 科学技术与工程, 2016, 16(14):236-239,244.

[43] Cheng X, Lin H, Li S. Researchon the algorithm of strip center extraction of automobile weld sealantstrip[J]. Journal of Applied Optics, 2019, 40(5): 823-828.

程鑫, 凌鹤, 李硕. 汽车焊缝密封胶条的光条中心提取算法研究[J]. 应用光学, 2019, 40(5): 823-828.

[44] KOKORIAN J,BUJA F, STAUFER U, etal. An optical in-plane displacement measurement technique withsub-nanometer accuracy based on curve-fitting[C]//2014 IEEE 27thInternational Conference on Micro Electro Mechanical Systems (MEMS 2014),January 26-30 2014, San Francisco, CA, USA. 2014: 580-583.

[45] Li Y H, Liu P, Zhou J B, Ren YZ, Jin J Y. Extraction of structured light stripe center based on BP neuralnetwork[J]. Acta

Optica Sinica, 2019, 39(12): 186-194.

李玥华, 刘朋, 周京博, 任有志, 靳江艳. 基于BP神经网络的结构光光条中心提取[J]. 光学学报, 2019, 39(12):186-194.

[46] Wang S C, Han Q, Wang H, etal. Extraction method of laser stripe center of rail profile in drivingenvironment[J]. Acta OpticaSinica, 2019, 39(2): 167-176.

王胜春, 韩强, 王昊, 等. 行车环境下钢轨轮廓激光条纹中心的提取方法[J]. 光学学报, 2019, 39(2): 167-176.

[47] Chen N, Guo Y K, Zhang X Q.Extraction of stripe center of line structured light based on Hessianmatrix[J]. Digital Technology and Application, 2019, 37(3): 126-127.

陈念, 郭阳宽, 张晓青. 基于Hessian矩阵的线结构光光条中心提取[J]. 数字技术与应用, 2019, 37(3): 126-127.

本文仅做学术分享,如有侵权,请联系删文。

下载1

在「3D视觉工坊」公众号后台回复:3D视觉,即可下载 3D视觉相关资料干货,涉及相机标定、三维重建、立体视觉、SLAM、深度学习、点云后处理、多视图几何等方向。

下载2

在「3D视觉工坊」公众号后台回复:3D视觉github资源汇总,即可下载包括结构光、标定源码、缺陷检测源码、深度估计与深度补全源码、点云处理相关源码、立体匹配源码、单目、双目3D检测、基于点云的3D检测、6D姿态估计汇总等。

下载3

在「3D视觉工坊」公众号后台回复:相机标定,即可下载独家相机标定学习课件与视频网址;后台回复:立体匹配,即可下载独家立体匹配学习课件与视频网址。

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的知识点汇总、入门进阶学习路线、最新paper分享、疑问解答四个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近2000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、可答疑解惑、助你高效解决问题