ISP论文整理2

原创声明:本文为是暮涯啊在CSDN创作,认准原创地址https://blog.csdn.net/longshaonihaoa/article/details/124144604 未经允许,请勿转载。

ISP论文整理1 会记录顶会订刊的论文

ISP论文整理2 记录一些workshop或者arxiv等的论文。

7、Deep Camera: A Fully Convolutional Neural Network for Image Signal Processin(ICCVW19)

论文 被引20

说这个传统分阶段ISP会把每个步骤的loss累加并降低最终图像质量。因此用全卷积网络替代缺陷像素校正、去噪、白平衡、曝光校正、去马赛克、颜色变换和伽马编码(defect pixel correction, denoising, white balancing, exposure correction, demosaicing, color transform, and gamma encoding),他说这是第一篇端到端CNN替代ISP流程的论文(啊这),大量实验证明效果比传统的好。

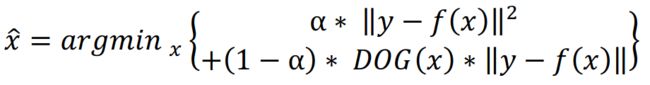

损失函数定义为:

损失函数定义为:

其中前一项为负对数似然项,后一项为负log先验项。其中DOG表示对x的高斯差(difference of Gaussian),这项使用L1对高频边缘信息好。

8、W-Net: Two-stage U-Net with misaligned data for raw-to-RGB mapping(ICCVW2019)

论文 被引9

AIM 2019 raw-to-RGB mapping 挑战赛使用的ZRR数据集具有不对齐的问题,且白平衡增益和色彩校正矩阵(white balance gains and color correction matrix)不可获得,所以任务很难。本文提出一个双阶段Unet和一个新的loss,该loss对对齐影响小,对色彩差异更敏感。在比赛中PSNR和SSIM指标均比第二名高。

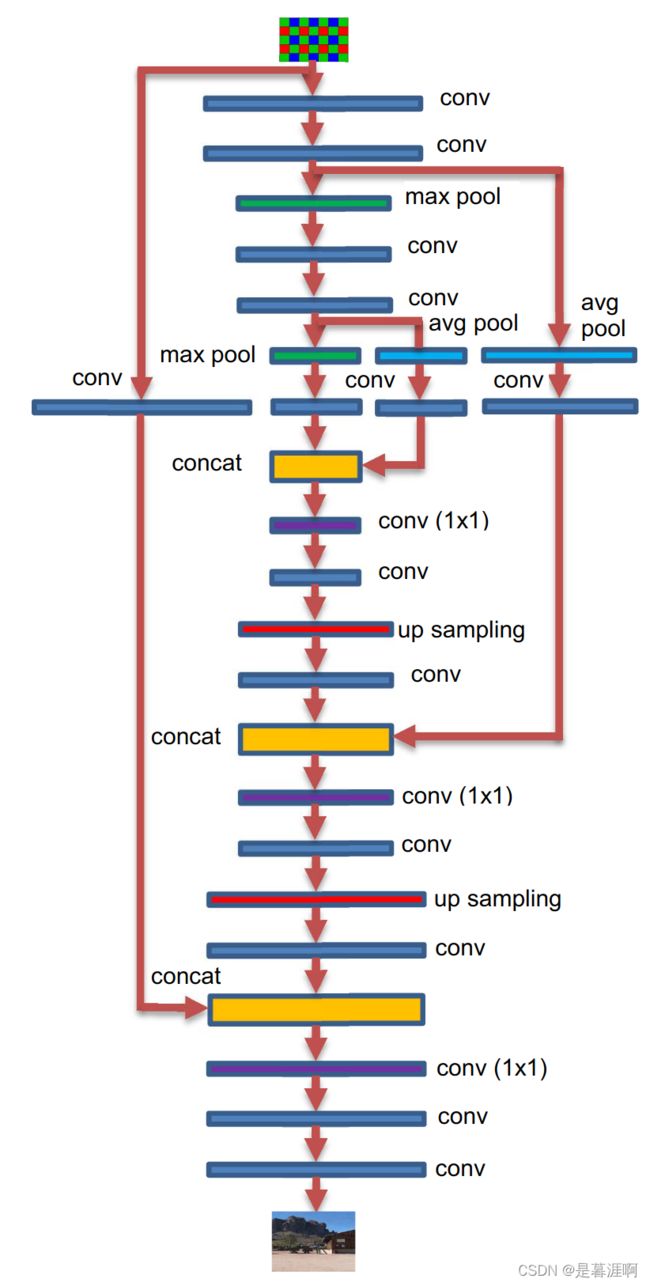

本文和6思路相同(本文先发表)第一个Unet可以获得comparable效果,然后用第二个Unet boost效果。Unet结构如下

上采样过程中对每个concat之后用SE做通道attention。

上采样过程中对每个concat之后用SE做通道attention。

8.1 Loss

作者采用了3个loss。

1)Pixel loss采用L1,由于数据对不对齐,会导致模糊。

2)Feature Loss。也就是Perceptual loss,用L1拉进经过VGG后的特征。

3)Color Loss。计算pred和gt降采后的Cos距离。公式如下

9、Replacing Mobile Camera ISP with a Single Deep Learning Model( PyNET,CVPRW2020)

论文 被引60

数据集、演示、code等官方网址

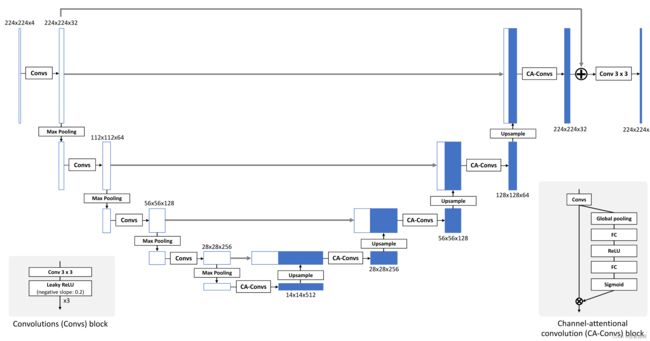

文章说本文可以在不需要任何先验的情况下,证明端到端的网络可以超过即使是最复杂ISP。作者提出金字塔CNN结构来代替所有ISP流程,直接从移动相机传感器获得的 RAW Bayer 数据转换为使用专业高端数码单镜头反光相机(digital single-lens reflex camera,DSLR)拍摄的照片,从而使该解决方案独立于任何特定的移动 ISP 实施。作者还自己提出了新的数据集。

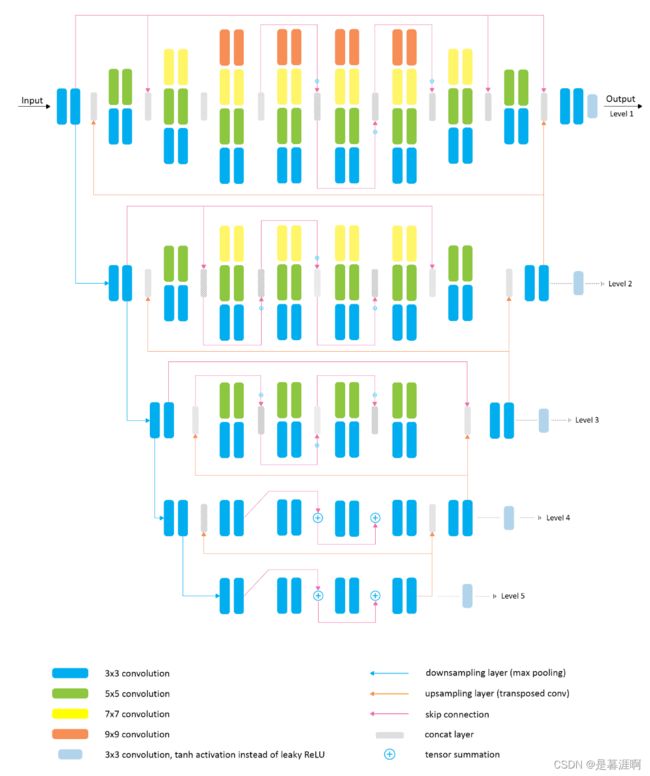

网络作为一个金子塔而非Unet结构,主要是每层都有单独的卷积进行处理。网络本来很简单,但是图画的有点超出常人理解,一般框框都当成feature map,这里当成卷积,所以导致框框之间没有卷积的相连。所以在看的时候横向框框之间如果没有线条,就是卷积得到的。比如level5,跳连相加就是简单的res block。每个灰色的concat层 都迷人是将有连线的和前面的卷积结果进行concat。不同尺度纵向平行代表用不同ks并行处理前面的feature map,然后将结果进行concat。卷积后使用LReLU,level2-5采用IN。

网络作为一个金子塔而非Unet结构,主要是每层都有单独的卷积进行处理。网络本来很简单,但是图画的有点超出常人理解,一般框框都当成feature map,这里当成卷积,所以导致框框之间没有卷积的相连。所以在看的时候横向框框之间如果没有线条,就是卷积得到的。比如level5,跳连相加就是简单的res block。每个灰色的concat层 都迷人是将有连线的和前面的卷积结果进行concat。不同尺度纵向平行代表用不同ks并行处理前面的feature map,然后将结果进行concat。卷积后使用LReLU,level2-5采用IN。

网络训练很神奇啊,按照从level5->level1以此训练,作者认为这样每次更高的层在训练时,前面的输出进行采作为当前的输入,就只用学习丢失的细节,refine之前的结果就好。

LOSS:level4-5学习全局颜色,亮度/gamma 矫正(global color and brightness / gamma correction),使用MSE

level2-3 refine颜色,形状属性,用MSE+Perceptual loss

level1 用于纹理增强,噪声移除,局部颜色处理,用Perceptual loss + 0.75SSIM+0.05MSE

10、AWNet: Attentive Wavelet Network for Image ISP(ECCVW 2020)

论文 被引10

代码

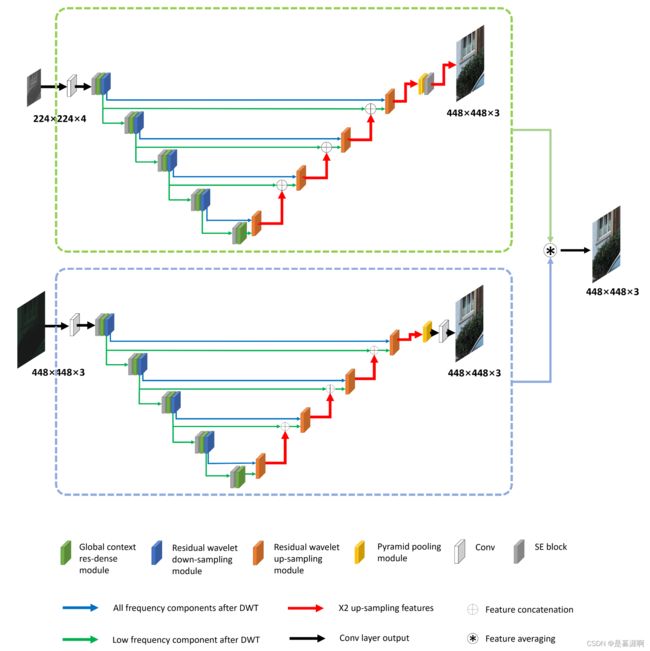

本文利用attention机制和小波变换(wavelet transform),提出了AWNet处理ISP问题。其中小波变换可以从raw中重建有利的细节,获得大的感受野,同时计算成本高效。全局上下文(global context)结构学习non-local的颜色映射,并且能缓解图像不匹配的问题。

前面有提到6,8也是采用两个Unet,不过他们是串行,本文是并行处理。其中上面的网络是将Bayer filter(RGGB)采样转为4个通道作为输入。下面是将raw图经过demosaic操作后获得原尺寸大小的三通道图作为输入。绿色框框具体如下

前面有提到6,8也是采用两个Unet,不过他们是串行,本文是并行处理。其中上面的网络是将Bayer filter(RGGB)采样转为4个通道作为输入。下面是将raw图经过demosaic操作后获得原尺寸大小的三通道图作为输入。绿色框框具体如下

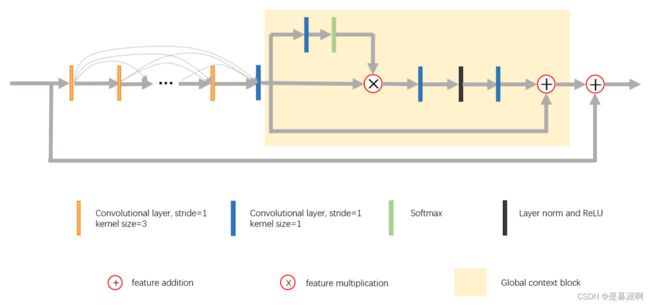

黄框之外是res-dense connect,可以提升颜色重建,黄色框框是global context模块,鼓励网络学习全局颜色映射(global color mapping),不再赘述。下面稍微说说wavelet transform

黄框之外是res-dense connect,可以提升颜色重建,黄色框框是global context模块,鼓励网络学习全局颜色映射(global color mapping),不再赘述。下面稍微说说wavelet transform

这个讲道理还蛮有意思的,因为之前在整理去噪论文时候有看过几个工作采用小波变换。这里DWT/IDWT和Conv相互结合使用。作者说空域和频域结合可以有助于学习丰富的特征。如果我看代码没错的话,上图应该都是画错的,左边RWDB中,X都采用了一个步长为2的卷积,X进入DWT,并将得到的的低频特征与卷积concat,这样concat的对象都是原来尺寸的一半。这也符合常理,毕竟有两个的话每次降采4,连接5层就要最少256的尺寸,比输入还大。RWUB的代码中是没有步长为2的卷积的,这也符合常理,左边上采2倍,右边IDWT也是变为原来尺寸的二倍,这样可以concat。具体可以查看代码。

这个讲道理还蛮有意思的,因为之前在整理去噪论文时候有看过几个工作采用小波变换。这里DWT/IDWT和Conv相互结合使用。作者说空域和频域结合可以有助于学习丰富的特征。如果我看代码没错的话,上图应该都是画错的,左边RWDB中,X都采用了一个步长为2的卷积,X进入DWT,并将得到的的低频特征与卷积concat,这样concat的对象都是原来尺寸的一半。这也符合常理,毕竟有两个的话每次降采4,连接5层就要最少256的尺寸,比输入还大。RWUB的代码中是没有步长为2的卷积的,这也符合常理,左边上采2倍,右边IDWT也是变为原来尺寸的二倍,这样可以concat。具体可以查看代码。

损失函数:Cb loss + Perceptual loss + SSIM loss + Multi-scale loss

这个Multi-scale loss和上个论文9的损失函数一个模子刻出来的。尺度最小的两层,学习全局颜色和色调映射global color and tone mapping,使用Cb loss。中间尺寸的两层保持感知可接受性和全局映射(perform global mapping while remaining the perceptual acceptance)所以用Cb loss+0.25Perceture loss。最高尺寸的,raw一层,demosaic两层,用来恢复图像纹理和颜色映射,因此使用Cb loss+0.25Perceture loss+0.05SSIM loss。最后的Multi-scale loss采用上面每层的和。

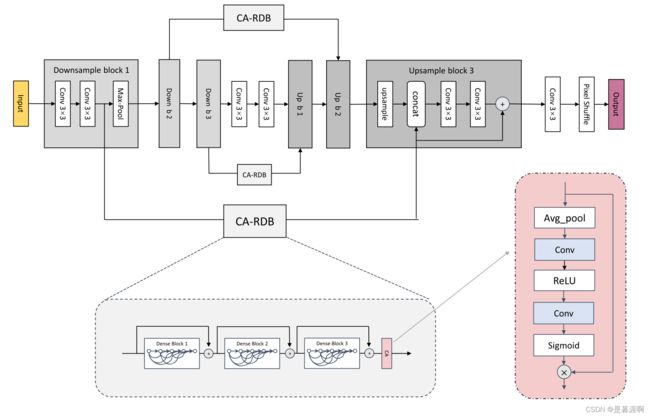

11、EEDNet: Enhanced Encoder-Decoder Network for AutoISP(ECCVW2020)

论文 被引2

文章提出一个关于感受野的假设,大感受野(LRF)对high-level cv中至关重要,但low-level的pixel-to-pixel任务中不重要。(后一句不知道,前一句最近的ConvNext和RepLKNet是这么说的,其实想想也很符合常理)。然后还提出了一个ClipL1 loss,可以同时考虑简单样本和离群样本。依靠LRF理论和ClipL1 loss,作者获得了AIM2020 ISP挑战赛的冠军。(但好像他是在保真度(Fidelity)中的PSNR,SSIM指标最优,但官方在整理时按照感官(Perceptual)的MOS排名,那他就要排到第5了,不过还是很吊的。)

网络结构如下,3层降采,已经连成麻花了,不再讲啦

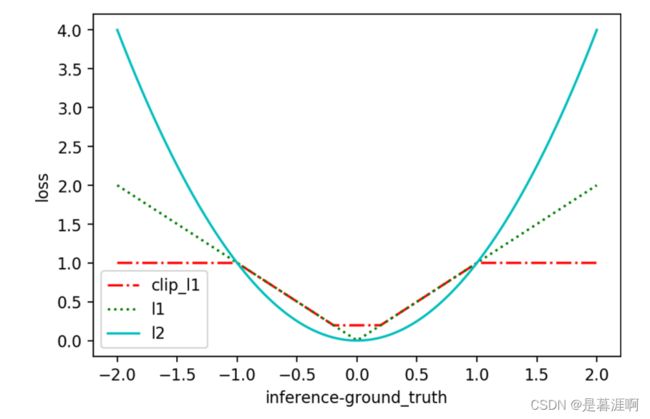

可以看看clipL1 loss,如名字所示,是对L1 loss的大小值进行clip,限定在[Cmin,Cmax]。

作者使用时候设置Cmin=1/255, Cmax=1

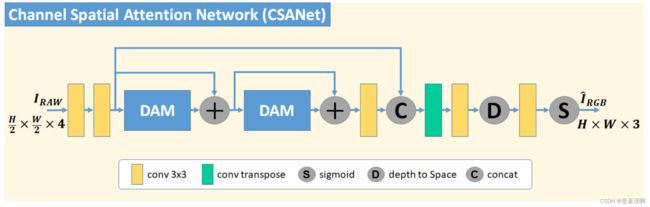

12、CSANet: High Speed Channel Spatial Attention Network for Mobile ISP(CVPRW2021)

论文

传统ISP调整每个处理单元非常复杂,需要图像专家的大量经验和努力。本文提出CSANet兼顾推理速度和PSNR指标。采用时空dual attention。其中空间加权简单的使用了轻量级空洞depth-with卷积取得了好结果( light-weighted dilated depth-wise convolution)。网络结构如下,没啥特别的

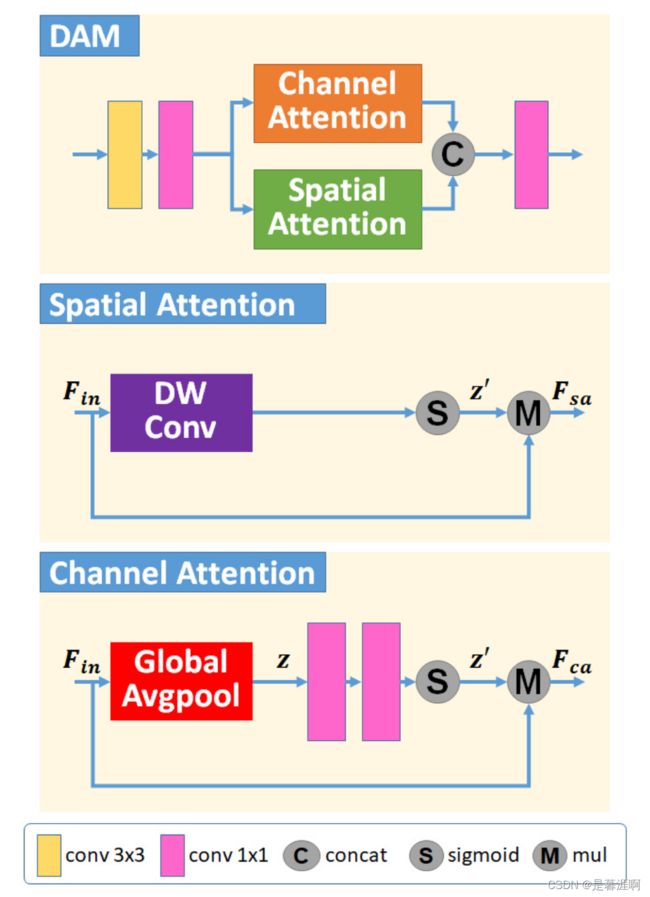

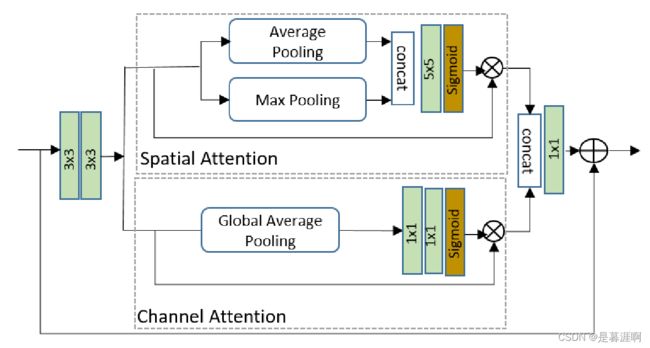

其中DAM如下

其中DAM如下

loss采用Cb loss + 0.001Perceptual loss + 0.1SSIM loss

loss采用Cb loss + 0.001Perceptual loss + 0.1SSIM loss

13、Learning Digital Camera Pipeline for Extreme Low-Light Imaging(Neurocomputing2021)

论文 被引15

也是解决暗光环境下ISP问题的论文,作者设计网络学习曝光良好图像的所需属性,并将它们反映在在极低环境光环境中捕获的图像中,这样low-light图可以获得明显视觉质量提升。作者说提出了一个新loss可以利用像素和感知指标的特征,但好像还是Perceptual loss。作者在SID上的结果比google的Learn to see in the dark(上一篇有讲)效果好。网络结构是单独的Unet,没啥其他了吧

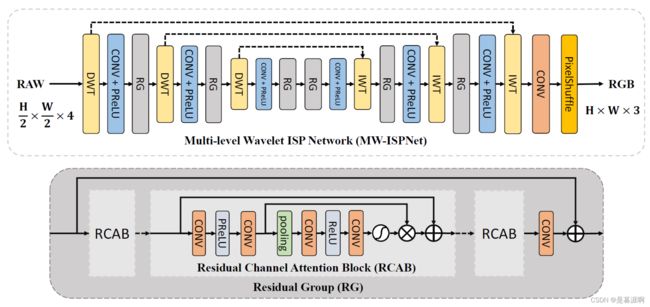

14、AIM 2020 Challenge on Learned Image Signal Processing Pipeline(ECCV2020 workshop)

论文 被引36

AIM 2020 AI ISP的方法总结,前面很多workshop都是参加的这个比赛,第一名是MW-ISPNet,同样采用了和上面论文10(应该是这个比赛的第二名)相同的小波变换和逆变换。但是做法更简单,没有结合卷积在空域操作。模型如下

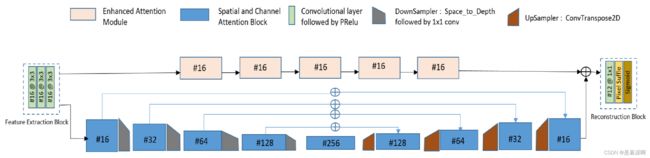

15、Del-Net: A Single-Stage Network for Mobile Camera (未发表)

论文

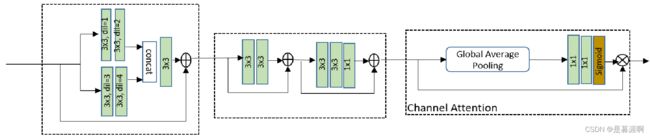

三星的论文,很多地方没有原理讲解。传统ISP对不同亮度条件和噪声等级重建质量有线。现有AI ISP太复杂,乘积累加运算(Multiply Accumulate,MAC)量大。本文提出Del-Net是一个多尺度结构,用空间通道attention学习如颜色等全局特征,一系列轻量残差attention模块用于去噪。与最优网络相比减少了~90%MAC。这个很MAC我很中意,因为我们实际部署确实很重要就是考虑这个,而非参数量。网络结构如下

从网络看主要是通道数设置挺小的,最高才256,其中通道空间attention比较常见,筛选有用特征,丢弃不相关的。但作者没说为什么空间attnetion要把ave和max两种都使用,具体结构如下

从网络看主要是通道数设置挺小的,最高才256,其中通道空间attention比较常见,筛选有用特征,丢弃不相关的。但作者没说为什么空间attnetion要把ave和max两种都使用,具体结构如下

浅粉色的Enhanced Attention model一直作用在原尺寸,先生成特征然后对通道进行attention,结构如下

浅粉色的Enhanced Attention model一直作用在原尺寸,先生成特征然后对通道进行attention,结构如下

loss有个蛮有意思的地方,采用modified loss+SSIM loss+perceptual loss

loss有个蛮有意思的地方,采用modified loss+SSIM loss+perceptual loss

其中这个modified loss=L1+ ǁ log(max(gt, ) − log(max(pred, ))ǁ,其中=0.001。后面这一项怎么说呢?用来抑制离群点?也没有消融实验对照结果。

16、ISP distillation(未发表)

论文

不是做AI ISP的。观点很奇特,他说很多图像其实不是给人看的,而是给机器,比如机器人。但是有需要用ISP把raw图像处理RGB,这不是闲的蛋疼吗?浪费时间计算单元还丢失信息,为啥不直接在raw域进行相关任务呢?但好像直接在raw训练效果下降很多,这咋办呢?所以作者首先拿到raw和对应经过传统ISP处理的RGB图,将RGB经过预训练的CNN得到输出,然后利用知识蒸馏将raw图送到CNN获得输出,这样raw的结果就比直接在raw图上训练的结果很多了(这意思是还是没rgb的效果好?那你之前的假设不就很鸡肋了?)但是节省了ISP的时间和计算量啊。

有错误敬请指出,欢迎多多评论交流,最好能点赞收藏啊