datawhale数据分析3——数据重构

Task03:数据重构

声明:本文主要参考DataWhale开源学习——动手学数据分析,GitHub地址:https://github.com/datawhalechina/hands-on-data-analysis

#准备工作:导入库,导入数据

import numpy as np

import pandas as pd

text = pd.read_csv('xxxx.csv')

text.head()

一.数据的合并

1.1 任务一:将data文件夹里面的所有数据都载入,与之前的原始数据相比,观察他们的之间的关系

text_left_up = pd.read_csv("data/train-left-up.csv")

text_left_down = pd.read_csv("data/train-left-down.csv")

text_right_up = pd.read_csv("data/train-right-up.csv")

text_right_down = pd.read_csv("data/train-right-down.csv")

通过观察可知,以上四个文件是将原来的train.csv文件分隔成了四个(左上,左下,右上,右下)部分。

1.2 任务二:使用concat方法:将数据train-left-up.csv和train-right-up.csv横向合并为一张表,并保存这张表为result_up

list_up = [text_left_up,text_right_up]

result_up = pd.concat(list_up,axis=1)

1.3 任务三:使用concat方法:将train-left-down和train-right-down横向合并为一张表,并保存这张表为result_down。然后将上边的result_up和result_down纵向合并为result。

list_down=[text_left_down,text_right_down]

result_down = pd.concat(list_down,axis=1)

result = pd.concat([result_up,result_down])

1.4 任务四:使用DataFrame自带的方法join方法和append:完成任务二和任务三的任务

resul_up = text_left_up.join(text_right_up)

result_down = text_left_down.join(text_right_down)

result = result_up.append(result_down)

补充注:join默认左右连接,append默认上下连接

1.5 任务五:使用Pandas的merge方法和DataFrame的append方法:完成任务二和任务三的任务

result_up = pd.merge(text_left_up,text_right_up,left_index=True,right_index=True)

result_down = pd.merge(text_left_down,text_right_down,left_index=True,right_index=True)

result = resul_up.append(result_down)

对比merge、join以及concat的方法的不同以及相同。思考一下在任务四和任务五的情况下,为什么都要求使用DataFrame的append方法,如何只要求使用merge或者join可不可以完成任务四和任务五呢?

可参考:https://blog.csdn.net/qq_33624802/article/details/109714536

原因:merge和join都是左右连接,只有append是上下连接,可以把行拼接起来。因此必须用到append方法。

1.6 任务六:完成的数据保存为result.csv

result.to_csv('result.csv')

二.换一种角度看数据

2.1 任务一:将我们的数据变为Series类型的数据

# 将完整的数据加载出来

text = pd.read_csv('result.csv')

text.head()

unit_result=text.stack().head(20)

这个stack函数是干什么的?

参考:https://www.cnblogs.com/bambipai/p/7658311.html

简单来说就是把DataFrame转换成层次化的Series

#将代码保存为unit_result,csv

unit_result.to_csv('unit_result.csv')

三.数据聚合与运算

3.1 任务一:了解groupby机制

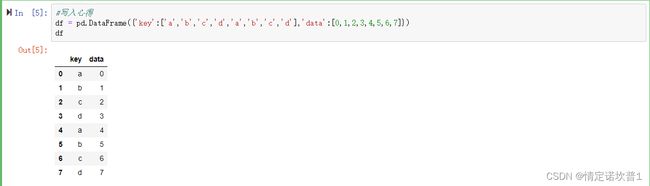

首先定义一个DataFrame

显然,这里一共有4个不同的key,如果我们想查看每个key对应的data的和,首先直观的思想是用for循环遍历

for key in ['a','b','c','d']:

print(key,df[df['key'] == key].sum())

非常的麻烦,groupby函数就是用来解决这个问题的

df.groupby('key').sum()

事实上,把上面的sum改成我们之前学过的describe可以得到所有描述性统计

在了解groupby机制之后,运用这个机制完成一系列的操作,来达到我们的目的。

下面通过几个任务来熟悉groupby机制。

3.2 任务二:计算泰坦尼克号男性与女性的平均票价

df = text['Fare'].groupby(text['Sex'])

means = df.mean()

3.3 任务三:统计泰坦尼克号中男女的存活人数

survived_sex = text['Survived'].groupby(text['Sex']).sum()

survived_sex.head()

3.4 任务四:计算客舱不同等级的存活人数

survived_pclass = text['Survived'].groupby(text['Pclass'])

survived_pclass.sum()

由上,我们可以得出一些例如泰坦尼克号女性平均票价比男性高等有关数据分析的信息。

**从任务二到任务三中,这些运算可以通过agg()函数来同时计算。并且可以使用rename函数修改列名。 **

text.groupby('Sex').agg({'Fare': 'mean', 'Pclass': 'count'}).rename(columns=

{'Fare': 'mean_fare', 'Pclass': 'count_pclass'})

3.5 任务五:统计在不同等级的票中的不同年龄的船票花费的平均值

text.groupby(['Pclass','Age'])['Fare'].mean() #里边Pclass和Age调换就是不同年龄中不同等级票花费平均值

3.6 任务六:将任务二和任务三的数据合并,并保存到sex_fare_survived.csv

采用merge

result = pd.merge(means,survived_sex,on='Sex')

result.to_csv('sex_fare_survived.csv')

3.7 任务七:得出不同年龄的总的存活人数,然后找出存活人数最多的年龄段,最后计算存活人数最高的存活率(存活人数/总人数)

#不同年龄的存活人数

survived_age = text['Survived'].groupby(text['Age']).sum()

#找出最大值的年龄段

survived_age[survived_age.values==survived_age.max()]

#计算总人数

_sum = text['Survived'].sum()

print("sum of person:"+str(_sum))

precetn =survived_age.max()/_sum

print("最大存活率:"+str(precetn))