pytorch生态之:生态简介+torchvision/torchvideo/torchtext+transforms实战

Pytorch学习第六部分:pytorch生态

- Let's go !

- 一、pytorch生态简介

- 二、 torchvision(图像)

-

- 2.1 torchvision简介

- 2.2 torchvision.datasets

- 2.3 torchvision.transforms

- 2.4 torchvision.models

-

- 2.4.1 Classification

- 2.4.2 Semantic Segmentation

- 2.4.3 Video classification

- 2.5 torchvision.io

- 2.6 torchvision.ops

- 2.7 torchvision.utils

- 三、 torchvideo(视频)

-

- 3.1 PyTorchVideo简介与当前发展不足

- 3.2 PyTorchVideo的主要部件和亮点

- 3.3 PyTorchVideo的安装

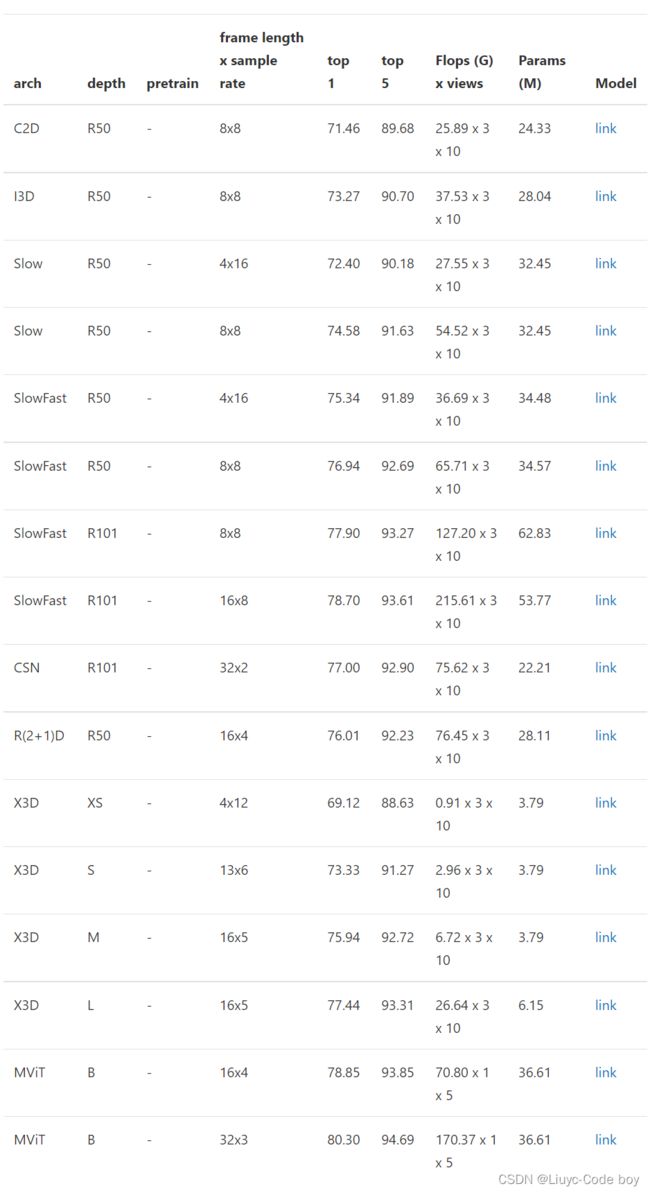

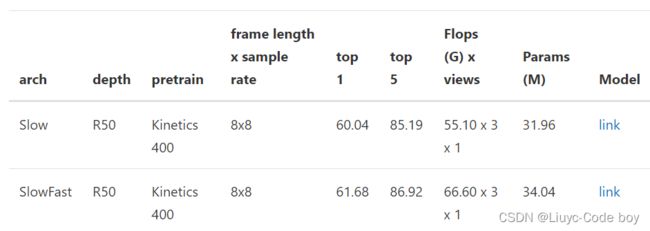

- 3.4 Model zoo 和 benchmark

-

- 3.4.1 Kinetics-400

- 3.4.2 Something-Something V2

- 3.4.3 Charades

- 3.4.4 AVA (V2.2)

- 3.5 使用 PyTorchVideo model zoo

- 四、 torchtext(文本)

-

- 4.1 torchtext简介

- 4.2 torchtext的主要组成部分

- 4.3 torchtext的安装

- 4.4 构建数据集

-

- 4.4.1 Field及其使用

- 4.4.2 词汇表(vocab)

- 4.4.3 数据迭代器

- 4.4.4 使用自带数据集

- 4.5 评测指标(metric)

- 4.6 其他

- 五、 transforms实战

-

- 5.1 图片读取

- 5.2 沿中心处理transforms.CenterCrop(size)

- 5.3 对图片的亮度,对比度,饱和度,色调进行改变transforms.ColorJitter

- 5.4 输出灰度图transforms.Grayscale(num_output_channels)

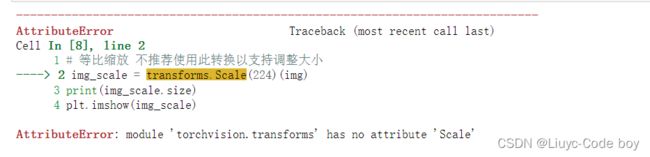

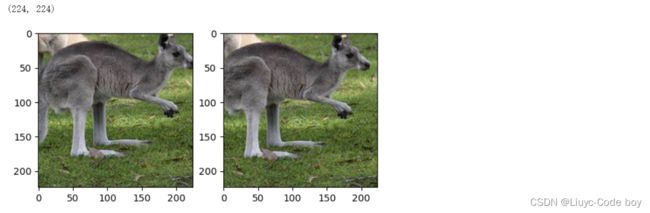

- 5.5 等比缩放transforms.Resize/transforms.Scale

- 5.6 随机裁剪transforms.RandomCrop/transforms.RandomResizedCrop

- 5.7 随机左右旋转transforms.RandomHorizontalFlip

- 5.8 随机垂直旋转transforms.RandomVerticalFlip

- 5.9 对图片进行组合变化 tranforms.Compose()¶

Let’s go !

在前面五节的学习中我们已经学习了pytorch的基础知识、组成模块、模型定义、进阶的模型训练技巧,以及可视化的相关知识,在本次pytorch学习的最后一部分我们将会学习pytorch生态相关的知识。如果你觉得那一部分知识还没有掌握的太透彻可以点击对应的链接跳转复习一下:

- pytorch基础知识之:张量-自动求导-并行计算

- pytorch主要组成模块之:动手完成简单的深度学习模型搭建

- pytorch模型定义之:模型定义三种方式以及U-Net模块搭建笔记

- pytorch进阶训练技巧之:探索如何更优雅地训练PyTorch模型

- pytorch可视化之:可视化网络结构+CNN可视化+TensorBorad使用

一、pytorch生态简介

PyTorch的强大并不仅局限于自身的易用性,更在于开源社区围绕PyTorch所产生的一系列工具包(一般是Python package)和程序,这些优秀的工具包极大地方便了PyTorch在特定领域的使用。比如对于计算机视觉,有TorchVision、TorchVideo等用于图片和视频处理;对于自然语言处理,有torchtext;对于图卷积网络,有PyTorch Geometric ······。这里只是举例,每个领域还有很多优秀的工具包供社区使用。这些工具包共同构成了PyTorch的生态(EcoSystem),核心要义就是make work easier。

PyTorch生态很大程度助力了PyTorch的推广与成功。在特定领域使用PyTorch生态中的工具包,能够极大地降低入门门槛,方便复现已有的工作。比如我们在讨论模型修改时候就用到了torchvision中预定义的resnet结构,而不需要自己重新编写。同时,PyTorch生态有助于社区力量的加入,共同为社区提供更有价值的内容和程序,这也是开源理念所坚持的价值。

二、 torchvision(图像)

PyTorch之所以会在短短的几年时间里发展成为主流的深度学习框架,除去框架本身的优势,还在于PyTorch有着良好的生态圈。在前面的学习和实战中,我们经常会用到torchvision来调用预训练模型,加载数据集,对图片进行数据增强的操作。

2.1 torchvision简介

" The torchvision package consists of popular datasets, model architectures, and common image transformations for computer vision. "

正如引言介绍的一样,我们可以知道torchvision包含了在计算机视觉中常常用到的数据集,模型和图像处理的方式,而具体的torchvision则包括了下面这几部分,带 ***** 的部分是我们经常会使用到的一些库。

2.2 torchvision.datasets

torchvision.datasets主要包含了一些我们在计算机视觉中常见的数据集,在0.10.0版本的torchvision下,有以下的数据集:

| Caltech | CelebA | CIFAR | Cityscapes |

|---|---|---|---|

| EMNIST | FakeData | Fashion-MNIST | Flickr |

| ImageNet | Kinetics-400 | KITTI | KMNIST |

| PhotoTour | Places365 | QMNIST | SBD |

| SEMEION | STL10 | SVHN | UCF101 |

| VOC | WIDERFace |

2.3 torchvision.transforms

我们知道在计算机视觉中处理的数据集有很大一部分是图片类型的,如果获取的数据是格式或者大小不一的图片,则需要进行归一化和大小缩放等操作,这些是常用的数据预处理方法。除此之外,当图片数据有限时,我们还需要通过对现有图片数据进行各种变换,如缩小或放大、水平或垂直翻转等,这些是常见的数据增强方法。而torchvision.transforms中就包含了许多这样的操作。在之前第四章的Fashion-mnist实战中对数据的处理时我们就用到了torchvision.transformer:

from torchvision import transforms

data_transform = transforms.Compose([

transforms.ToPILImage(), # 这一步取决于后续的数据读取方式,如果使用内置数据集则不需要

transforms.Resize(image_size),

transforms.ToTensor()

])

除了上面提到的几种数据增强操作,在torchvision官方文档里提到了更多的操作,具体使用方法也可以参考本节配套的”transforms.ipynb“,在这个notebook中我们给出了常见的transforms的API及其使用方法。

2.4 torchvision.models

为了提高训练效率,减少不必要的重复劳动,PyTorch官方也提供了一些预训练好的模型供我们使用,可以点击这里进行查看现在有哪些预训练模型,下面我们将对如何使用这些模型进行详细介绍。 此处我们以torchvision0.10.0 为例,如果希望获取更多的预训练模型,可以使用使用pretrained-models.pytorch仓库。现有预训练好的模型可以分为以下几类:

2.4.1 Classification

在图像分类里面,PyTorch官方提供了以下模型,并正在不断增多。

| AlexNet | VGG | ResNet | SqueezeNet |

| DenseNet | Inception v3 | GoogLeNet | ShuffleNet v2 |

| MobileNetV2 | MobileNetV3 | ResNext | Wide ResNet |

| MNASNet | EfficientNet | RegNet | 持续更新 |

这些模型是在ImageNet-1k进行预训练好的,我们也可以去查看这些模型在ImageNet-1k的准确率。

2.4.2 Semantic Segmentation

语义分割的预训练模型是在COCO train2017的子集上进行训练的,提供了20个类别,包括background, aeroplane, bicycle, bird, boat, bottle, bus, car, cat, chair, cow, diningtable, dog, horse, motorbike, person, pottedplant, sheep, sofa,train, tvmonitor。

| FCN ResNet50 | FCN ResNet101 | DeepLabV3 ResNet50 | DeepLabV3 ResNet101 |

| LR-ASPP MobileNetV3-Large | DeepLabV3 MobileNetV3-Large | 未完待续 |

我们可以查看预训练的模型的mean IOU和 global pixelwise acc

2.4.3 Video classification

视频分类模型是在 Kinetics-400上进行预训练的

| ResNet 3D 18 | ResNet MC 18 | ResNet (2+1) D |

| 未完待续 |

我们也可以查看这些模型的Clip acc@1,Clip acc@5

2.5 torchvision.io

在torchvision.io提供了视频、图片和文件的 IO 操作的功能,它们包括读取、写入、编解码处理操作。随着torchvision的发展,io也增加了更多底层的高效率的API。在使用torchvision.io的过程中,我们需要注意以下几点:

-

不同版本之间,torchvision.io有着较大变化,因此在使用时,需要查看下我们的torchvision版本是否存在你想使用的方法。

-

除了read_video()等方法,torchvision.io为我们提供了一个细粒度的视频API torchvision.io.VideoReader() ,它具有更高的效率并且更加接近底层处理。在使用时,我们需要先安装ffmpeg然后从源码重新编译torchvision我们才能我们能使用这些方法。

-

在使用Video相关API时,我们最好提前安装好PyAV这个库。

2.6 torchvision.ops

torchvision.ops 为我们提供了许多计算机视觉的特定操作,包括但不仅限于NMS,RoIAlign(MASK R-CNN中应用的一种方法),RoIPool(Fast R-CNN中用到的一种方法)。在合适的时间使用可以大大降低我们的工作量,避免重复的造轮子。

2.7 torchvision.utils

torchvision.utils 为我们提供了一些可视化的方法,可以帮助我们将若干张图片拼接在一起、可视化检测和分割的效果。

总的来说,torchvision的出现帮助我们解决了常见的计算机视觉中一些重复且耗时的工作,并在数据集的获取、数据增强、模型预训练等方面大大降低了我们的工作难度,可以让我们更加快速上手一些计算机视觉任务。

三、 torchvideo(视频)

3.1 PyTorchVideo简介与当前发展不足

近几年来,随着传播媒介和视频平台的发展,视频正在取代图片成为下一代的主流媒体,这也使得有关视频的深度学习模型正在获得越来越多的关注。然而,有关视频的深度学习模型仍然有着许多缺点:

-

计算资源耗费更多,并且没有高质量的model zoo,不能像图片一样进行迁移学习和论文复现。

-

数据集处理较麻烦,但没有一个很好的视频处理工具。

-

随着多模态越来越流行,亟需一个工具来处理其他模态。

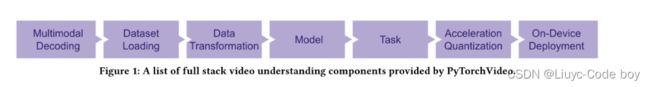

除此之外,还有部署优化等问题,为了解决这些问题,Meta推出了PyTorchVideo深度学习库(包含组件如Figure 1所示)。PyTorchVideo 是一个专注于视频理解工作的深度学习库。PytorchVideo 提供了加速视频理解研究所需的可重用、模块化和高效的组件。PyTorchVideo 是使用PyTorch开发的,支持不同的深度学习视频组件,如视频模型、视频数据集和视频特定转换。

3.2 PyTorchVideo的主要部件和亮点

PytorchVideo 提供了加速视频理解研究所需的模块化和高效的API。它还支持不同的深度学习视频组件,如视频模型、视频数据集和视频特定转换,最重要的是,PytorchVideo也提供了model zoo,使得人们可以使用各种先进的预训练视频模型及其评判基准。PyTorchVideo主要亮点如下:

基于 PyTorch: 使用 PyTorch 构建。使所有 PyTorch 生态系统组件的使用变得容易。

Model Zoo: PyTorchVideo提供了包含I3D、R(2+1)D、SlowFast、X3D、MViT等SOTA模型的高质量model zoo(目前还在快速扩充中,未来会有更多SOTA model),并且PyTorchVideo的model zoo调用与PyTorch Hub做了整合,大大简化模型调用,具体的一些调用方法可以参考下面的【使用 PyTorchVideo model zoo】部分。

1. 数据预处理和常见数据 ,PyTorchVideo支持Kinetics-400, Something-Something V2, Charades, Ava (v2.2), Epic Kitchen, HMDB51, UCF101, Domsev等主流数据集和相应的数据预处理,同时还支持randaug, augmix等数据增强trick。

2. 模块化设计: PyTorchVideo的设计类似于torchvision,也是提供许多模块方便用户调用修改,在PyTorchVideo中具体来说包括data, transforms, layer, model, accelerator等模块,方便用户进行调用和读取。

3. 支持多模态: PyTorchVideo现在对多模态的支持包括了visual和audio,未来会支持更多模态,为多模态模型的发展提供支持。

4. 移动端部署优化: PyTorchVideo支持针对移动端模型的部署优化(使用前述的PyTorchVideo/accelerator模块),模型经过PyTorchVideo优化了最高达7倍的提速,并实现了第一个能实时跑在手机端的X3D模型(实验中可以实时跑在2018年的三星Galaxy S8上,具体请见Android Demo APP)。

3.3 PyTorchVideo的安装

可以直接使用pip安装:

pip install pytorchvideo

注意:

安装的虚拟环境的python版本 >= 3.7

PyTorch >= 1.8.0,安装的torchvision也需要匹配

CUDA >= 10.2

ioPath:具体情况

fvcore版本 >= 0.1.4:具体情况

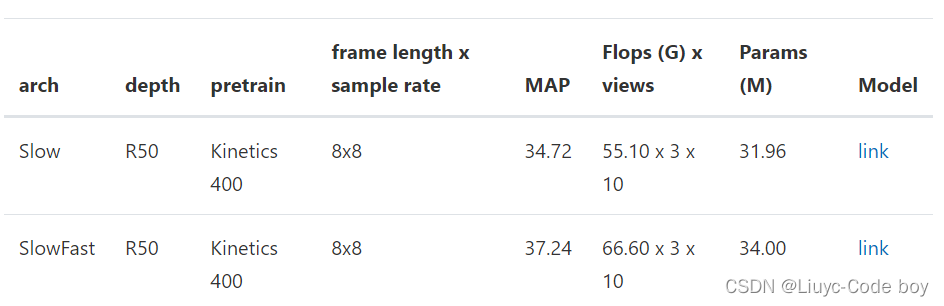

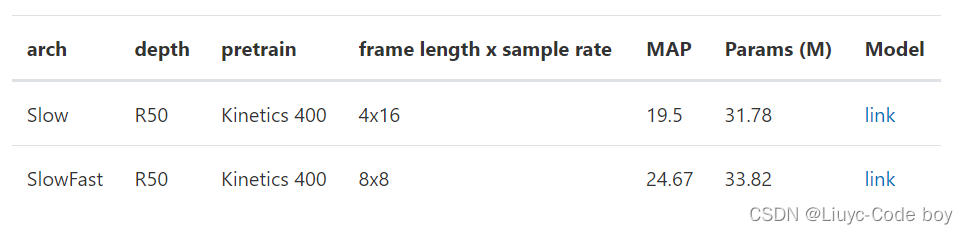

3.4 Model zoo 和 benchmark

在下面这部分,我将简单介绍些PyTorchVideo所提供的Model zoo和benchmark

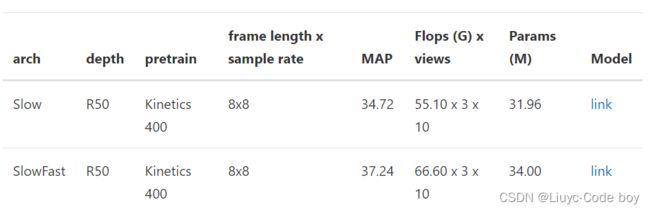

3.4.1 Kinetics-400

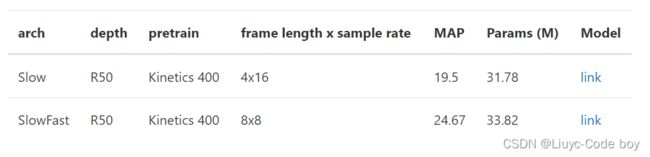

3.4.2 Something-Something V2

3.4.3 Charades

3.4.4 AVA (V2.2)

3.5 使用 PyTorchVideo model zoo

PyTorchVideo提供了三种使用方法,并且给每一种都配备了tutorial

-

TorchHub,这些模型都已经在TorchHub存在。我们可以根据实际情况来选择需不需要使用预训练模型。除此之外,官方也给出了TorchHub使用的 tutorial 。

-

PySlowFast,使用 PySlowFast workflow 去训练或测试PyTorchVideo models/datasets.

-

PyTorch Lightning建立一个工作流进行处理,点击查看官方 tutorial。

如果想查看更多的使用教程,可以点击 这里 进行尝试

总的来说,PyTorchVideo的使用与torchvision的使用方法类似,在有了前面的学习基础上,我们可以很快上手PyTorchVideo,具体的我们可以通过查看官方提供的文档和一些例程来了解使用方法:官方网址

四、 torchtext(文本)

4.1 torchtext简介

本节我们来介绍PyTorch官方用于自然语言处理(NLP)的工具包torchtext。自然语言处理也是深度学习的一大应用场景,近年来随着大规模预训练模型的应用,深度学习在人机对话、机器翻译等领域的取得了非常好的效果,也使得NLP相关的深度学习模型获得了越来越多的关注。

由于NLP和CV在数据预处理中的不同,因此NLP的工具包torchtext和torchvision等CV相关工具包也有一些功能上的差异,如:

-

数据集(dataset)定义方式不同

-

数据预处理工具

-

没有琳琅满目的model zoo

4.2 torchtext的主要组成部分

torchtext可以方便的对文本进行预处理,例如截断补长、构建词表等。torchtext主要包含了以下的主要组成部分:

-

数据处理工具 torchtext.data.functional、torchtext.data.utils

-

数据集 torchtext.data.datasets

-

词表工具 torchtext.vocab

-

评测指标 torchtext.metrics

4.3 torchtext的安装

torchtext可以直接使用pip进行安装:

pip install torchtext

4.4 构建数据集

4.4.1 Field及其使用

Field是torchtext中定义数据类型以及转换为张量的指令。torchtext 认为一个样本是由多个字段(文本字段,标签字段)组成,不同的字段可能会有不同的处理方式,所以才会有 Field 抽象。定义Field对象是为了明确如何处理不同类型的数据,但具体的处理则是在Dataset中完成的。下面我们通过一个例子来简要说明一下Field的使用:

tokenize = lambda x: x.split()

TEXT = data.Field(sequential=True, tokenize=tokenize, lower=True, fix_length=200)

LABEL = data.Field(sequential=False, use_vocab=False)

其中:

sequential设置数据是否是顺序表示的;

tokenize用于设置将字符串标记为顺序实例的函数

lower设置是否将字符串全部转为小写;

fix_length设置此字段所有实例都将填充到一个固定的长度,方便后续处理;

use_vocab设置是否引入Vocab object,如果为False,则需要保证之后输入field中的data都是numerical的

构建Field完成后就可以进一步构建dataset了:

from torchtext import data

def get_dataset(csv_data, text_field, label_field, test=False):

fields = [("id", None), # we won't be needing the id, so we pass in None as the field

("comment_text", text_field), ("toxic", label_field)]

examples = []

if test:

# 如果为测试集,则不加载label

for text in tqdm(csv_data['comment_text']):

examples.append(data.Example.fromlist([None, text, None], fields))

else:

for text, label in tqdm(zip(csv_data['comment_text'], csv_data['toxic'])):

examples.append(data.Example.fromlist([None, text, label], fields))

return examples, fields

这里使用数据csv_data中有"comment_text"和"toxic"两列,分别对应text和label。

train_data = pd.read_csv('train_toxic_comments.csv')

valid_data = pd.read_csv('valid_toxic_comments.csv')

test_data = pd.read_csv("test_toxic_comments.csv")

TEXT = data.Field(sequential=True, tokenize=tokenize, lower=True)

LABEL = data.Field(sequential=False, use_vocab=False)

# 得到构建Dataset所需的examples和fields

train_examples, train_fields = get_dataset(train_data, TEXT, LABEL)

valid_examples, valid_fields = get_dataset(valid_data, TEXT, LABEL)

test_examples, test_fields = get_dataset(test_data, TEXT, None, test=True)

# 构建Dataset数据集

train = data.Dataset(train_examples, train_fields)

valid = data.Dataset(valid_examples, valid_fields)

test = data.Dataset(test_examples, test_fields)

可以看到,定义Field对象完成后,通过get_dataset函数可以读入数据的文本和标签,将二者(examples)连同field一起送到torchtext.data.Dataset类中,即可完成数据集的构建。使用以下命令可以看下读入的数据情况:

# 检查keys是否正确

print(train[0].__dict__.keys())

print(test[0].__dict__.keys())

# 抽查内容是否正确

print(train[0].comment_text)

4.4.2 词汇表(vocab)

在NLP中,将字符串形式的词语(word)转变为数字形式的向量表示(embedding)是非常重要的一步,被称为Word Embedding。这一步的基本思想是收集一个比较大的语料库(尽量与所做的任务相关),在语料库中使用word2vec之类的方法构建词语到向量(或数字)的映射关系,之后将这一映射关系应用于当前的任务,将句子中的词语转为向量表示。

在torchtext中可以使用Field自带的build_vocab函数完成词汇表构建。

TEXT.build_vocab(train)

4.4.3 数据迭代器

其实就是torchtext中的DataLoader,代码如下:

from torchtext.data import Iterator, BucketIterator

# 若只针对训练集构造迭代器

# train_iter = data.BucketIterator(dataset=train, batch_size=8, shuffle=True, sort_within_batch=False, repeat=False)

# 同时对训练集和验证集进行迭代器的构建

train_iter, val_iter = BucketIterator.splits(

(train, valid), # 构建数据集所需的数据集

batch_sizes=(8, 8),

device=-1, # 如果使用gpu,此处将-1更换为GPU的编号

sort_key=lambda x: len(x.comment_text), # the BucketIterator needs to be told what function it should use to group the data.

sort_within_batch=False

)

test_iter = Iterator(test, batch_size=8, device=-1, sort=False, sort_within_batch=False)

torchtext支持只对一个dataset和同时对多个dataset构建数据迭代器。

4.4.4 使用自带数据集

与torchvision类似,torchtext也提供若干常用的数据集方便快速进行算法测试。可以查看官方文档寻找想要使用的数据集。

4.5 评测指标(metric)

NLP中部分任务的评测不是通过准确率等指标完成的,比如机器翻译任务常用BLEU (bilingual evaluation understudy) score来评价预测文本和标签文本之间的相似程度。torchtext中可以直接调用torchtext.data.metrics.bleu_score来快速实现BLEU,下面是一个官方文档中的一个例子:

from torchtext.data.metrics import bleu_score

candidate_corpus = [['My', 'full', 'pytorch', 'test'], ['Another', 'Sentence']]

references_corpus = [[['My', 'full', 'pytorch', 'test'], ['Completely', 'Different']], [['No', 'Match']]]

bleu_score(candidate_corpus, references_corpus)

4.6 其他

值得注意的是,由于NLP常用的网络结构比较固定,torchtext并不像torchvision那样提供一系列常用的网络结构。模型主要通过torch.nn中的模块来实现,比如torch.nn.LSTM、torch.nn.RNN等。

备注:

对于文本研究而言,当下Transformer已经成为了绝对的主流,因此PyTorch生态中的HuggingFace等工具包也受到了越来越广泛的关注。

五、 transforms实战

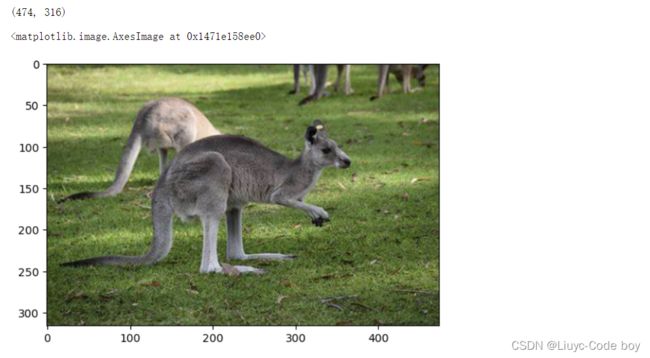

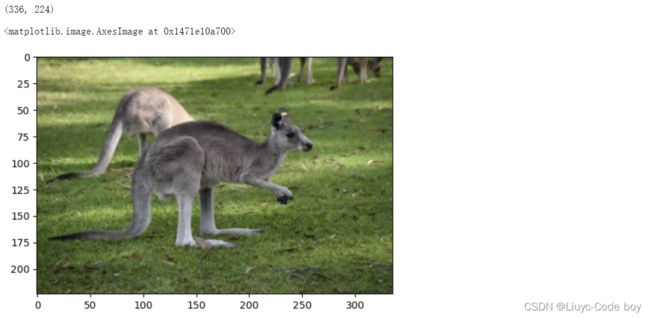

5.1 图片读取

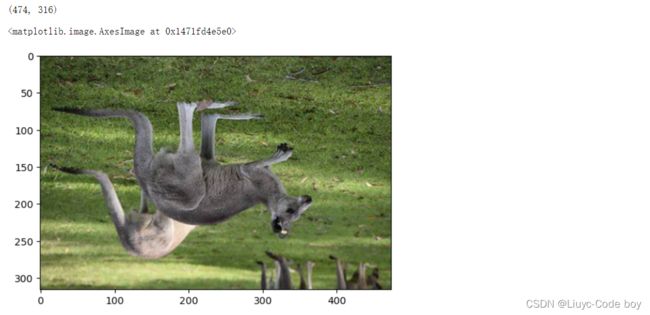

首先从当前文件夹中使用plt读取一张图片。

代码如下:

from PIL import Image

from torchvision import transforms

import matplotlib.pyplot as plt

%matplotlib inline

# 加载原始图片

img = Image.open("./daishu.jpg")

print(img.size)

plt.imshow(img)

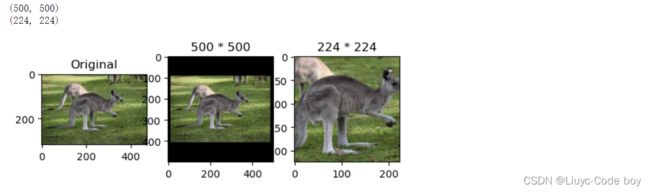

5.2 沿中心处理transforms.CenterCrop(size)

包括:对给定图片进行沿中心切割对图片沿中心放大切割、超出图片大小的部分填0、对图片沿中心缩小切割,超出期望大小的部分剔除。

代码如下:

# 对给定图片进行沿中心切割

# 对图片沿中心放大切割,超出图片大小的部分填0

img_centercrop1 = transforms.CenterCrop((500,500))(img)

print(img_centercrop1.size)

# 对图片沿中心缩小切割,超出期望大小的部分剔除

img_centercrop2 = transforms.CenterCrop((224,224))(img)

print(img_centercrop2.size)

plt.subplot(1,3,1),plt.imshow(img),plt.title("Original")

plt.subplot(1,3,2),plt.imshow(img_centercrop1),plt.title("500 * 500")

plt.subplot(1,3,3),plt.imshow(img_centercrop2),plt.title("224 * 224")

plt.show()

5.3 对图片的亮度,对比度,饱和度,色调进行改变transforms.ColorJitter

代码如下:

# 对图片的亮度,对比度,饱和度,色调进行改变

img_CJ = transforms.ColorJitter(brightness=1,contrast=0.5,saturation=0.5,hue=0.5)(img)

print(img_CJ.size)

plt.imshow(img_CJ)

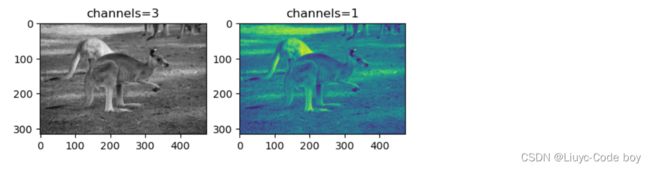

5.4 输出灰度图transforms.Grayscale(num_output_channels)

代码如下:

img_grey_c3 = transforms.Grayscale(num_output_channels=3)(img)

img_grey_c1 = transforms.Grayscale(num_output_channels=1)(img)

plt.subplot(1,2,1),plt.imshow(img_grey_c3),plt.title("channels=3")

plt.subplot(1,2,2),plt.imshow(img_grey_c1),plt.title("channels=1")

plt.show()

5.5 等比缩放transforms.Resize/transforms.Scale

transforms.Resize代码如下:

# 等比缩放

img_resize = transforms.Resize(224)(img)

print(img_resize.size)

plt.imshow(img_resize)

结果展示:

transforms.Scale代码如下:

不推荐

# 等比缩放 不推荐使用此转换以支持调整大小

img_scale = transforms.Scale(224)(img)

print(img_scale.size)

plt.imshow(img_scale)

结果展示:

原因:新版的python已经删除了Scale,用Resize代替了。

5.6 随机裁剪transforms.RandomCrop/transforms.RandomResizedCrop

transforms.RandomCrop代码如下:

# 随机裁剪成指定大小

# 设立随机种子

import torch

torch.manual_seed(31)

# 随机裁剪

img_randowm_crop1 = transforms.RandomCrop(224)(img)

img_randowm_crop2 = transforms.RandomCrop(224)(img)

print(img_randowm_crop1.size)

plt.subplot(1,2,1),plt.imshow(img_randowm_crop1)

plt.subplot(1,2,2),plt.imshow(img_randowm_crop2)

plt.show()

结果展示:

transforms.RandomResizedCrop代码如下:

# 随机裁剪成指定大小

img_random_resizecrop = transforms.RandomResizedCrop(224,scale=(0.5,0.5))(img)

print(img_random_resizecrop.size)

plt.imshow(img_random_resizecrop)

5.7 随机左右旋转transforms.RandomHorizontalFlip

注意:可能不转

代码如下:

# 随机左右旋转

# 设立随机种子,可能不旋转

import torch

torch.manual_seed(31)

img_random_H = transforms.RandomHorizontalFlip()(img)

print(img_random_H.size)

plt.imshow(img_random_H)

5.8 随机垂直旋转transforms.RandomVerticalFlip

代码如下:

# 随机垂直方向旋转

img_random_V = transforms.RandomVerticalFlip()(img)

print(img_random_V.size)

plt.imshow(img_random_V)

5.9 对图片进行组合变化 tranforms.Compose()¶

代码如下:

# 对一张图片的操作可能是多种的,我们使用transforms.Compose()将他们组装起来

transformer = transforms.Compose([

transforms.Resize(256),

transforms.transforms.RandomResizedCrop((224), scale = (0.5,1.0)),

transforms.RandomVerticalFlip(),

])

img_transform = transformer(img)

plt.imshow(img_transform)