AAAI-2020-SiamFC++:Towards Robust and Accurate Visual Tracking with Target Estimation Guidelines阅读笔记

论文代码地址:https://github.com/MegviiDetection/video_analyst

AAAI 2020论文未开源

一、 写作动机

以往的方法提出了多种目标状态估计方法,但很少考虑到视觉跟踪问题本身的特殊性。

跟踪问题可以被视为分类任务和估计任务的组合。第一个任务是通过分类提供一个鲁棒的目标粗定位。第二个任务是估计一个准确的目标状态,通常用一个边界框表示。虽然现代跟踪器已经取得了显著的进步,但令人惊讶的是,它们用于第二个任务(即目标状态估计)的方法有很大的不同。基于这一点,以前的方法大致可以分为三类:

第一类,包括判别式相关滤波器(DCF)和SiamFC采用的多尺度测试,多尺度测试不仅不准确而且低效。另外,先前假设的目标比例/比率在相邻帧中以固定的速率变化,在现实中通常并不成立;

第二类,ATOM通过梯度迭代细化多个初始边界盒来提升对目标包围框的估计,结果在精度上有显著提高。然而,这种目标估计方法不仅带来了沉重的计算负担,而且还带来了许多额外的超参数(如初始盒的数量、初始盒的分布),需要仔细的调优;

第三类,SiamRPN跟踪器族,它们通过引入区域建议网络(RPN),实现精确高效的目标状态估计。然而,预定义的锚设置不仅引入模糊的相似度评分,严重阻碍了鲁棒性,而且还需要访问数据分布的先验信息,这显然违背了通用目标跟踪的精神。

基于上述,提出了一套高性能通用目标跟踪器设计指南。

二、 主要贡献

① 通过识别跟踪的独特特性,设计了一套实用的目标状态估计指南,用于现代跟踪器的设计。

② 设计了一个简单但强大的SiamFC++跟踪器应用提出的指导方针。大量的实验和全面的分析证明了提出的指导方针的有效性。

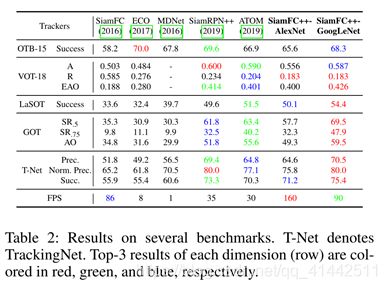

③ 该方法在五个具有挑战性的基准上达到了最先进的结果。据所知,提出的SiamFC++是第一个在大规模TrackingNet数据集上获得75.4 AUC分数的跟踪器,同时运行速度超过90 FPS。

三、 主要内容

目标追踪器设计指南:

G1: decomposition of classification and state estimation

跟踪器应该执行两个子任务:分类和状态估计。

如果没有强大的分类器,跟踪器无法从背景或干扰物中区分目标,这严重阻碍了其鲁棒性。如果没有准确的估计结果,跟踪器的精度从根本上受到限制。多尺度测试方法在很大程度上忽视了后一项任务,存在效率低、准确率低的问题。

G2: non-ambiguous scoring

无歧义评分。

分类得分应该直接表示目标存在的置信度,在“视野”内,即对应像素的子窗口内,而不是锚盒等预定义设置。作为一个反例,目标和锚点之间的匹配(例如:基于RPN分支的锚点)很容易产生假阳性结果,导致跟踪失败。

G3: prior knowledge-free

无先验知识。

跟踪方法应该不受尺度/比率分布等先验知识的约束,这是泛型目标跟踪精神提出的。现有方法普遍依赖于数据分布的先验知识,影响了其泛化能力。

G4: estimation quality assessment

估计质量评估。

如以往研究所示,直接使用分类置信度进行包围框选择将导致性能下降。应该使用独立于分类的评估质量分数,就像之前许多关于目标检测和跟踪的研究一样。第二分支(例如ATOM和DiMP惊人的准确性很大程度上来自于这条指南。而其他人仍然忽略了它,为进一步提高估计精度留下了空间。

现代跟踪器根据其目标状态估计方式大致可分为三个分支:

① 采用多尺度检验估计目标尺度。具体方法是将搜索patch重新缩放成多个尺度,并装配一小批尺度图像,在当前帧中选取分类得分最高的尺度作为预测目标尺度。

② 过序列分类和估计来跟踪目标。对分类得到的粗糙目标初始位置进行迭代细化,实现精确的盒估计。

③ 在孪生网络之后附加一个区域建议网络,实现以前未见的准确性。

SiamFC++框架由一个用于特征提取的孪生子网络和一个用于分类和回归的区域提议子网络组成。绿色的部分是传统SiamFC分支,红色部分是质量评估分支,蓝色部分是回归分支。

按文中提出的四条目标追踪器设计指南分别对追踪器做了以下操作:

[Following G1]

在互相关操作后设计了分类和回归,执行分类和状态估计两个子任务。

分类子任务中,以ψcls为输入,将对应的图像块分类为正或负patch。

具体来说, (x, y) 位置在特征图ψcls上,如果其对应的位置是![]()

在输入图像落入地面真值边界框,则被认为是一个正样本,否则,就是负样本。此处s为步幅(本文s = 8)。

匹配公式:

![]()

★——互相关操作

Ф(·)——用于共同特征提取的孪生主干

Ψi(·)——特定任务层,Ψcls和Ψreg相同大小

I——Cls分类®回归

回归子任务中,以ψreg为输入,再输出一个额外的偏移回归量来精确预测边界盒位置。对于特征图ψreg上各正样本位置(x, y)的回归目标,最后一层预测其与相应位置 ![]()

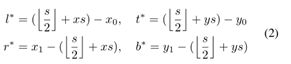

到地面真值包围盒的四条边的距离,并记为一个四维向量t∗= (l∗,t∗,r∗,b∗)。因此,位置(x, y)的回归目标位置公式为

其中(x0, y0)和(x1, y1)表示与点(x, y)相关的地面真值边界框B*的左上角和右下角。

[Following G2]

SiamFC++直接对对应的图像patch进行分类,并在该位置回归目标包围盒,换句话说,SiamFC++直接将位置视为训练样本。在逐像素预测方式中,在最终特征地图上的每个像素只做一个预测。因此,很明显,每个分类得分直接给出了目标在对应像素子窗口上的可信度,这个评分的设计是没有歧义的。

[Following G3]

由于SiamFC++对位置进行分类和回归,因此它没有预定义的锚框,因此没有关于目标数据分布(例如规模/比例)的先验知识,这符合G3。

[Following G4]

分类置信度与定位精度没有很好的相关性。据分析,子窗口中心周围的输入像素对对应输出特征像素的重要性大于其他像素。因此假设目标中心周围的特征像素比其他特征像素具有更好的估计质量。

假设输出估计先验空间得分(PSS):

![]()

PSS不是质量评估的唯一选择。作为一种变体,还可以预测被预测盒子和ground-truth box之间的IoU得分:

![]()

B是预测的边界框,B∗是其对应的地面真值边界框。

推理过程中,使用PSS与相应的预测分类分数相乘来计算用于最终框选择的分数。这样,远离物体中心的边界框就会被严重地降低权重。从而提高了跟踪精度。

其中1{·}是一个指示函数,如果约定的条件保持,则取1;如果不保持,则取0。Lcls表示分类结果的焦损失。Lquality表示质量评估的二进制交叉熵(BCE)损失。Lreg表示包围盒结果的IoU-Loss。如果(x, y)作为正样本赋给c * x,y,若为负样本则赋值为0。

四、 实验结果

改善跟踪性能的关键组件可以按降序列出如下:回归分支(0.094),数据源多样性(0.063/0.010),主干(0.026),头部结构(0.020)。

五、 总结

本文通过分析视觉跟踪任务的特点和以往跟踪器的缺陷,提出了一套跟踪器设计中目标状态估计的指导原则。根据这些指导方针,提出了SiamFC++方法, 并展示了基于这些指导方针的跟踪器在5个具有挑战性的基准上达到了最先进的性能,同时仍然以90帧/秒的速度运行。