技术干货 | PatchmatchNet:对learning-based稠密重建算法新的思考

01

前言

自MVSNet[1]提出以来,稠密重建(Multi-view Stereo, MVS)领域的learning-based方法基于正平扫(front-to-parallel)+可微单应性形变(differentiable homography)构建多视图对的cost volume,之后利用3D CNN进行正则的技术路线似乎已经根深蒂固。后续的R-MVSNet[2]对于cost volume在深度维度的正则方式进行创新,采用Conv-GRU逐层处理大幅减少了显存占用;CasMVSNet[3]首次提出coarse-to-fine的结构范式优化了显存占用和计算效率;Vis-MVSNet[4]和CVP-MVSNet[5]分别从多视图对cost volume的聚合方式以及coars-to-fine后续阶段的深度假设范围进行了深入思考。虽然在这个过程中,近景MVS数据集DTU和中近景MVS数据集Tanks & Temples也不断被新的learning-based方法霸榜,但是没有一篇文章能够跳出MVSNet构建的算法框架去思考learning-based方法未来可能的发展方向。

随着CVPR2021会议的召开,multi-view stereo领域的一篇oral文章《PatchmatchNet: Learned Multi-View Patchmatch Stereo》(论文链接:https://arxiv.org/abs/2012.01411)给出了一种新的可能性——基于patch match的思路去做learning-based稠密重建算法。

02

Learning-based Patchmatch

文章提出的可学习Patchmatch方法接近了传统Patchmatch方法的思想,主要分为以下三个步骤:

1. 初始化:生成随机深度假设

2. 传播:像素之间互相传播深度假设

3. 评估:计算匹配cost并生成深度预测结果

其中深度初始化阶段并没有太多创新,依旧是在全局深度范围或者基于上个阶段或者上个迭代的的深度预测结果构建深度假设,这里就不做过多介绍。文章的主要亮点在于传播和评估两个步骤的设计,下面逐一进行介绍。

03

Adaptive Propagation

传播(propagation)可以认为是patchmatch方法中的核心步骤,其目的是为了获取待预测像素周围的深度信息,利用局部视野构建下个迭代步骤的深度选择范围。理论上只要位于同一表面的像素中有一个像素其深度初始化或者预测得接近真实值,那么整个表面的像素都可以通过传播效应,迭代优化最终获得正确的深度预测。

作者实现传播的思想也非常巧妙,借鉴了经典的可形变卷积(deformable convolution)[6]思路,通过将主视图的特征输入到一个2D CNN去预测每个像素的空间相关邻居的偏移量(2D offsets)

这里 为上个迭代步骤的深度预测结果, 代表传播窗口的大小,限定了每个像素在下个迭代的深度假设延展范围。

图1 Adative Propagation

作者可视化了训练完成之后的网络所预测的offset,图1-b为固定传播的深度假设传播范围,图1-c是施加了offset之后的深度假设传播范围,可以发现offset倾向于分布在位于同一平面的像素上。

04

Adaptive Evaluation

作者定义的评估阶段流程相对复杂,包含了可微单应性形变、cost volume计算、自适应空间cost聚合(adaptive spatial cost aggregation)以及深度回归。这里其余的步骤并没有太多创新,因此只重点介绍下核心步骤自适应空间cost聚合。

05

Adaptive Spatial Cost Aggregation

传统MVS算法通常在一个空间窗口上对cost信息进行聚合,这样做可以提升匹配的鲁棒性同时起到隐式平滑的作用。这个步骤在之前的learning-based方法中主要是通过3D CNN对cost volume进行正则来完成的。而在本文中,作者抛弃了繁重的3D CNN,手动对cost volume中的每个体素进行邻居信息聚合。作者采取的方式同Adaptive Propagation步骤类似,同样用了一个2D CNN来预测主视图特征每个像素位点上的offset。得到offset之后,对于cost volume在深度维度的每个cost map进行spatial cost aggregation,具体公式如下:

采用上述空间cost信息聚合的方式,一定程度上等价于对cost volume用3D CNN进行正则,训练完成之后offset的分布如下:

图2 Adaptive Spatial Cost Aggregation

06

Pipeline

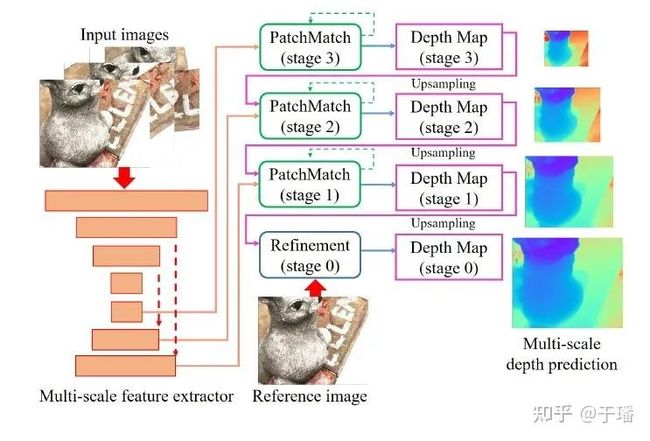

图3 Patchmatch流程

整个learning-based patchmatch的步骤如图3所示,这里展示的是一次patchmatch迭代的流程。单次迭代预测的深度图并不理想,需要通过迭代优化的方式将深度图进行refine。完整的pipeline如图4所示:

图4 PatchmatchNet算法流水线

整个网络的结构基于coarse-to-fine的范式,输入的主视图+辅助视图组首先经过一个多尺度的特征提取器生成三个尺度的特征。之后在每个尺度的特征图上分别进行patchmatch迭代优化生成当前尺度的深度图,上采样之后作为下个尺度patchmatch的初始深度图。分辨率最高的尺度上生成深度预测结果之后,还会上采样并经过refine步骤得到最终的预测结果。

07

实验结果

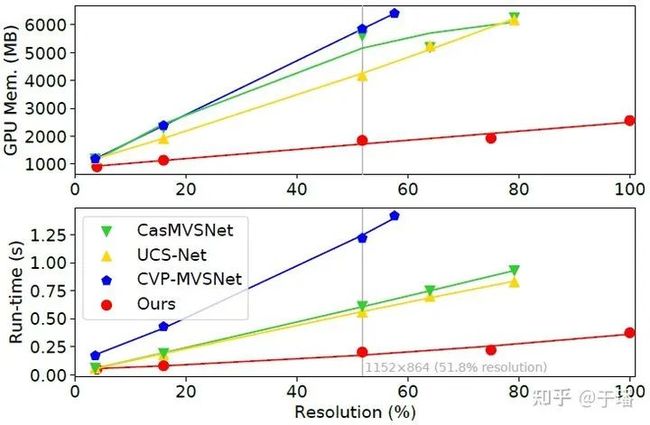

从DTU测试集的结果上看,PatchmatchNet虽然网络结构和计算步骤简单,依旧能够达到SOTA的精度水平。同时,由于网络结构轻量,计算步骤简单,PatchmatchNet的速度和显存占用表现在现有SOTA方法中是最优的。

图5 PatchmatchNet同SOTA方法的显存占用与速度对比

08

思考与总结

PatchmatchNet的出现为已经固化的learning-based类MVS方法注入了新鲜血液,虽然没有彻底颠覆之前的算法流水线,但其通过引入patchmatch方法的思想,同时以极简的网络结构,较快的推理速度和非常少的显存占用达到了同SOTA方法不相上下的精度水准。