EMNLP 2019 LXMERT: Learning Cross-Modality Encoder Representations from Transformers

动机

视觉语言推理要求对视觉内容、语言语义以及跨模态的对齐和关系进行理解。过去已有大量的工作,分别开发具有更好的表示方法的骨干模型,用于语言和语音的单一模态。对于现有的视觉内容,人们已经开发了几个骨干模型,并在大型视觉数据集上显示了它们的有效性。开拓性工作还通过在不同任务上微调这些预训练的(特别是在ImageNet上)骨干模型来显示它们的泛化性。在语言理解方面,去年,本论文在构建具有大规模语境化语言模型预训练的通用背骨模型方面取得了强劲进展,这将各种任务的性能提高到了显著水平。尽管有这些影响较大的单模态研究,但针对视觉和语言模态对的大规模预训练和微调研究还很不发达。

方法

简介

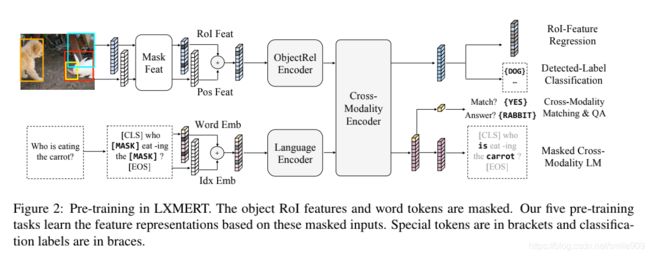

视觉与语言推理需要对视觉概念、语言本身以及最重要的是对这两种形式之间的联系和关系的理解。因此,本论文首次提出了一个预训练好的视觉和语言跨模态框架,并在多个数据集上展示了其强大的性能。本论文将此框架命名为“LXMERT:((Learning Cross-Modality Encoder representations from Transformers))学习Transformers的跨模态编码器表示”(读作“LEKSMERT”)。这个框架是在最近的BERT式的创新之后修改的,同时进一步适应于有用的跨模态场景。本论文的新的跨模态模型专注于学习视觉和语言的交互作用,特别是对于单个图像及其描述性句子的表征。它由三个Transformer编码器组成:一个目标关系编码器,一个语言编码器,和一个跨模态编码器。为了更好地学习视觉和语言之间的跨模态对齐,本论文接下来用五个不同的代表性任务对模型进行预训练:(1)masked的跨模态语言建模,(2)通过ROI特征回归的masked目标预测,(3)通过检测标签分类的masked目标预测,(4)跨模态匹配;(5)图像答疑。与单模态预训练(如BERT中的maskedLM)不同,这种多模态预训练允许本论文的模型从同一模态中的可见元素或从另一模态中的对齐元素推断masked特征。这样,它有助于建立模态内关系和跨模态关系。

模型架构

本论文的模型接受两个输入:一个图像和它的相关句子(例如,一个caption或一个问题)。每个图像被表示为一系列的物体,每个句子被表示为一系列的单词。通过仔细设计和组合这些自注意力层和交叉注意力层,本论文的模型能够从输入中生成语言表征、图像表征和跨模态表征。

嵌入

输入嵌入。LXMERT的输入嵌入层将输入(图像和句子)分为两个特征序列:词级句子嵌入和目标级图像嵌入。这些嵌入特征将由后几个编码层进一步处理。

单词级句子嵌入。首先,使用在Devlin et al.中使用相同的WordPiece tokenizer将句子拆分为多个单词。然后,通过嵌入子层将每个单词及其索引(单词在句子中的绝对位置)投影到向量上,并添加到索引感知的单词嵌入中。

目标级图像嵌入。代替使用卷积神经网络输出的特征映射,本论文遵循Anderson等人的方法。将被检测物体的特征作为图像的嵌入。具体地说,目标检测器检测多个目标。每个目标由其位置特征(即,边界框坐标)和其2048维感兴趣区域(RoI)特征表示。而不是直接使用RoI特征而不考虑其在Anderson等人的位置。本论文通过添加2个全连接层的输出来学习位置感知嵌入。除了在视觉推理中提供空间信息外,位置信息的包含对于本论文的masked目标预训练任务也是必要的。由于图像嵌入层和后续的注意层对其输入的绝对分值是不可知的,因此不指定目标的顺序。

编码器

编码器。包括语言编码器、目标关系编码器和跨模态编码器,主要基于两种注意力层:自注意力层和交叉注意力层。

单模态编码器。在嵌入层之后,首先应用两个transformer编码器,即语言编码器和对象关系编码器,它们中的每一个都只专注于一个单一的模态(即语言或视觉)。在单模态编码器中,每层都包含一个自注意力(“Self”)子层和一个前馈(“FF”)子层,其中前馈子层进一步由两个完全连接的子层组成.。分别在语言编码器和目标关系编码器中采用NL层和NR层,在每个子层之后添加一个残差连接和层归一化。

跨模态编码器。跨模态编码器中的每个跨模态层均由两个自注意力子层,一个双向交叉注意力子层和两个前馈子层组成。在编码器实现中,将这些跨模态层叠加Nx层(即,使用第k层的输出作为第(k + 1)层的输入)。在第k层内部,首先应用了双向交叉注意力子层,该子层包含两个单向交叉注意力子层:一个从语言到视觉,一个从视觉到语言。查询和上下文向量 是(k-1)层的输出(即语言特征和视觉特征)。

交叉注意力子层用于交换信息和对齐两种模态之间的实体,以学习联合的跨模态表示。为了进一步建立内部连接,然后将自注意力子层(“self”)应用于交叉注意力子层的输出。

最后,第k层输出由第k层交叉关注子层的输出顶部的前馈子层(FF)产生。 还在每个子层后添加了残差连接和层归一化,类似于单模态编码器。

输出表示

LXMERT跨模态模型有三个输出,分别用于语言、视觉和交叉模态。语言和视觉输出特征序列由跨模态编码器产生的;对于跨模态输出,在句子词之前附加了一个特殊的标记[CLS],并且该特殊标记在语言特征序列中的对应特征向量被用作跨模态输出。

预训练策略

为了更好地理解视觉和语言之间的联系,在一个大的聚合数据集上采用不同的模态预训练任务对模型进行预训练。

预训练任务

-

语言任务——Masked跨模态LM

任务设置与BERT几乎相同:单词被概率为0.15的随机masked,模型被要求预测这些masked。除了在BERT中,从语言模态中的非masked词预测masked词,LXMERT具有跨模态模型体系结构,可以从视觉模态中预测masked词,从而解决模糊性问题。如上图2所示。很难从其语言上下文中确定masked词“胡萝卜”,但如果考虑视觉信息,则单词选择是明确的。因此,它有助于建立从视觉模态到语言模态的联系,将这项任务称为masked跨模态LM。 -

视觉任务——masked目标预测

如上图2的顶部分支所示。通过概率为0.15的随机masked物体(即用零填充ROI特征)来预先训练视觉的一面,并要求模型预测这些masked目标的结构。与语言任务(即masked跨模态LM)相似,模型可以从可见目标或语言模态推断masked目标。从视觉方面推断目标有助于学习目标关系,从语言方面推断有助于学习跨模态对齐。因此,执行两个子任务:1)RoI-Feature Regression:用L2损失回归对象ROI特征,

2)Detected-Label Classification:学习具有交叉熵损失的masked对象的标签。

在“Detected-Label Classification”的子任务中,虽然大多数预训练图像都有目标级注释,但在不同的数据集中,注释目标的ground truth标签是不一致的(例如,标签类别的数目不同)。因为这些原因,采用Faster RCNN把检测到的标签输出。 -

跨模态任务

如上图2中最右边部分所示。为了学习一个强大的跨模态表示,本论文用两个明确需要语言模态和视觉模态的任务对LXMERT模型进行了预训练。语言模态和视觉模态的任务分别为:

1)Cross-Modality Matching:对于每个句子,按照0.5的概率,用一个不匹配的句子替换它。然后,训练一个分类器来预测图像和句子是否相互匹配。这个任务是如BERT一样进行“下一句预测”。

2)Image Question Answering (QA):为了扩大预训练的数据集,预训练数据中大约1/3的句子是关于图像的问题。当图像和问题匹配时,要求模型预测这些图像相关问题的答案。实验表明,用这种图像QA进行预训练可以得到更好的跨模态表示。

实验

实验中,本论文首先在两个流行的视觉问答数据集VQA和GQA上评估LXMERT。本论文的模型在所有问题类别(如二进制、数字、开放式)上都优于以往的工作,并且在总体准确性方面达到了最先进的结果。此外,为了展示本论文预训练模型的泛化能力,本论文在一个具有挑战性的视觉描述任务–自然语言用于真实的视觉推理(NLVR2)上对LXMERT进行了微调,在该任务中,本论文不使用其数据集中的自然图像进行本论文的预训练,而是对这些具有挑战性的真实世界图像进行微调和评估。在此基础上,系统的精度提高了22%,相对误差降低了48%,绝对误差提高了30%,相对误差降低了34%。最后,本论文进行了几个分析和消融研究,通过移除它们或与它们的替代选项进行比较来证明本论文的模型组件和不同的预训练任务的有效性,及其对本论文的结果有显著的贡献。特别地,本论文用几种方法对现有的BERT模型及其各种不同的方法进行了比较,结果表明了它们在视觉和语言任务中的不足之处,从总体上证明了本论文提出的新的跨模态预训练框架的必要性。本论文还针对不同的语言、目标关系和跨模态编码器提出了几种注意力可视化方法。

小结

提出了LXMERT框架来学习这些视觉和语言的联系。在LXMERT中,本论文建立了一个由三个编码器组成的大型Transformer模型:目标关系编码器、语言编码器和跨模态编码器。其次,为了使模型具有视觉和语言语义的融合能力,本论文利用大量的图像和句子对对模型进行了预训练,通过五个不同的预训练任务:masked语言建模、masked对象预测(特征回归和标签分类)、跨模态匹配和图像答疑。这些任务有助于学习情态内和跨情态关系。在对预先训练的参数进行微调后,本论文的模型在两个视觉问答数据集(即VQA和GQA)上都取得了最新的结果。