VD-BERT:用BERT搭建统一的视觉对话模型

![]()

论文标题:

VD-BERT: A Unified Vision and Dialog Transformer with BERT

论文作者:

Yue Wang, Shafiq Joty, Michael R. Lyu, Irwin King, Caiming Xiong, Steven C.H. Hoi

论文链接:

https://arxiv.org/abs/2004.13278

视觉对话(Visual Dialog)指的是给定一张图、它的标题和问题,我们需要给出这个问题的答案,在VD中,对话往往有多轮,而后面的问题会和前面的对话相关。

本文提出统一的视觉对话VD-BERT模型,联合编码视觉信息和文本信息,既适用于判别式方法,也适用于生成式方法。VD-BERT在视觉对话数据集VisDial实现了单个模型和集成模型上的最佳效果。

视觉对话

人类感知世界是“多模态”的而非“单模态”,学习知识也是在多模态的条件下进行的。

在所有的感知模态中,视觉和文本(语言),是其中最为重要的两类,而文本又是人类所独有的能力。

通过将视觉感知到的内容转换为文本信息,是我们了解世界的重要途径。视觉对话任务就是在模拟这个过程。

给定一副图片(或视频等视觉内容)和一个问题,我们可以根据图片内容去回答这个问题。

之后,我们还可以连续问若干问题,每个问题都有回答,如此根据图片和之前的对话进行下一轮对话,就是视觉对话,而找到每个问题的答案,就是视觉对话的目标。

这可以形式化为:

其中是视觉信息,是视觉信息的说明(如标题),是第轮的问题,是第轮的回答。

有两种方法可以找到,一是“判别式”——从给定的一些回答候选中选一个,二是“生成式”——直接生成回答。

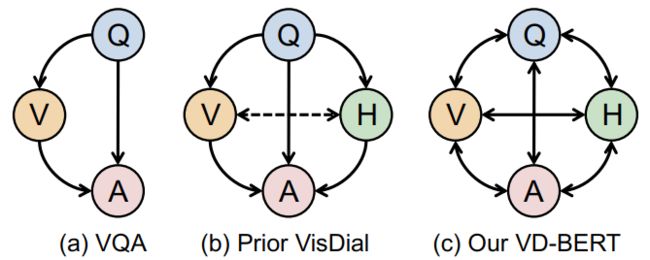

从上式可以看到,视觉对话实际上有四个部分:视觉信息V,对话历史H,当前问题Q和当前回答A。

过去对视觉对话的研究大都采用注意力的方法,让回答A去关注Q,V和H。然而,这种方法不能直接让V和H之间建立联系,从而可能忽略过去的对话内容。

基于此,本文提出VD-BERT,用BERT去建模多个部分的联系,任意两个部分之间就可以通过自注意力完成交互,从而不丢失历史对话信息,如下图所示:

和BERT一样,本文使用MLM和NSP两个训练任务去训练VD-BERT,然后再通过Rank的方法微调VD-BERT,从而可以使用一个模型同时完成判别式和生成式两种生成方法。

总的来说,本文贡献如下:

使用预训练的BERT作为视觉对话模型,并通过MLM和NSP的训练得到一个统一模型;

在VisDial数据集上实现了单个模型和集成模型二者的最优结果;

可以同时应用在判别式和生成式两种生成方法上。

VD-BERT

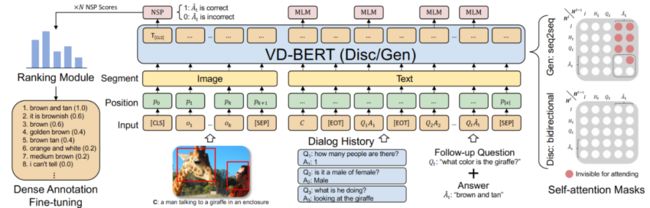

VD-BERT的结构和流程十分简单。下图是VD-BERT的模型结构:

模型流程分为几步:得到视觉表征,得到文本表征,模型训练,模型微调。

视觉表征

本文使用Faster R-CNN得到36个对象视觉表征,用于编码图片的视觉信息,记为。这些特征将作为BERT的输入的一部分。

文本表征

为了编码文本信息并让其和视觉信息充分结合,本文按照BERT,把历史对话以[EOT]为分隔符拼接起来,作为VD-BERT的文本部分,从而得到,其中是一个候选回答。

模型训练

在得到视觉输入和文本输入后,把这两个再拼接起来作为VD-BERT整个的输入,得到。注意到,我们使用了预训练的BERT去初始化VD-BERT,让它得到一些文本的先验知识。

为了训练VD-BERT,本文提出两个,也是BERT所提出的训练任务:MLM和NSP。MLM和BERT一致,随机掩码文本部分15%的词,让模型去预测它。

NSP有所不同,VD-BERT所做的是,让模型的[CLS]去预测当前的候选回答是不是真正的回答,即输出一个0-1之间的概率。

对于判别式方法,只需要从候选回答集中采样一些回答,然后再用NSP去预测是否正确即可;对于生成式方法,只需要一步一步预测即可,类似自回归模型。

模型微调

除了一个回答是否是正确答案之外(0或1),VisDial v1.0还为每个候选答案给出了相关性得分,用于评判每个答案和正确答案之间的语义相关性,得分范围为0-1之间。于是,VD-BERT就可以使用NSP在此基础上进一步微调,而在推理的时候,只需要选择得分最大的那个答案即可。

实验

本文在视觉对话数据集VisDial v0.9和VisDial v1.0上实验,使用BERT-base作为VD-BERT骨干,使用Recall@K、MRR、Mean Rank和NDCG作为测评指标,其他实验细节详见原文。

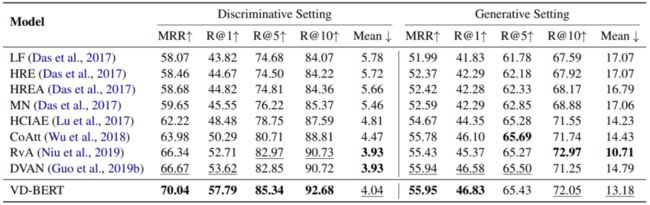

下表是在VisDial v1.0上的结果,可以看到,VD-BERT在几乎所有指标上都超越了之前的模型。

特别注意到,微调的VD-BERT(*)只在NDCG上表现更好,而在其他指标上表现更差,这是因为NDCG衡量的回答的相关度,微调可以提高其表现,但是反而降低了在其他指标上的效果。

下表是在VisDial v0.9上的结果,可以看到,无论是判别式方法还是生成式方法,VD-BERT都能取得一致更好的效果。

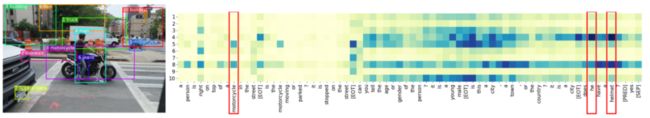

下面来看看视觉信息和文本信息的交互情况。从下图可以看到,文本和图片中的对象是对应的。motorcycle关注了5和8(都是motorcycle),而he关注了4(人),helmet关注了4和8。

小结

本文提出VD-BERT,使用预训练的BERT作为统一的视觉对话模型,通过MLM和NSP的训练,VD-BERT能够很好建模视觉信息和文本信息及其之间的相互联系。

VD-BERT简单有效,不需要任何模型结构设计,也不需要多余的损失函数优化,更不需要额外的标注数据,就能实现SOTA表现。

多模态是近些年发展很快的一个领域,因为和人类获取信息的过程更接近,多模态能够更大地推动CV和NLP在现实的应用和落地。更好、更快的多模态模型是未来的一个持续性研究方向。

????

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

![]()

![]()