β-VAE:学习具有约束框架的基本视觉概念

β-VAE: LEARNING BASIC VISUAL CONCEPTS WITH A CONSTRAINED VARIATIONAL FRAMEWORK

-

- 摘要(Abstract)

- 1. 引言(INTRODUCTION)

- 2. β-VAE衍生框架( β-VAE FRAMEWORK DERIVATION)

- 3. 分离度(DISENTANGLEMENT METRIC)

- 4. 实验(Abstract)

-

- 4.1.定性基准(QUALITATIVE BENCHMARKS)

- 4.1.量化基准(QUANTITATIVE BENCHMARKS)

- 5.结论(CONCLUSION)

原文作者:Irina Higgins, Loic Matthey, Arka Pal, Christopher Burgess, Xavier Glorot, Matthew Botvinick, Shakir Mohamed, Alexander Lerchner

翻译者:Wendy

摘要(Abstract)

在无监督学习的世界上独立的数据生成因素的可解释的 因式分解表示形式是人工智能发展的重要先驱。该人工智能能够像人类一样学习和推理。我们引入最新的一种学习框架β-VAE,可以以完全无监督的方式自动从原始图像中发现可解释的因式分解潜在表示图像。我们的方法是修改可变自动编码器(VAE)框架。我们介绍了一个可调整的超参数β,该参数可平衡潜在通道容量和独立性约束以及重构精度。我们证明具有适当调整的β>1的β-VAE在性能上优于VAE(β=1),以及在各种数据集上进行解缠因子学习和最新无监督学习 (InfoGAN) 和半监督(DC-IGN)方法的应用(名人,脸,椅子)。此外我们设计了一种协议来定量比较不同模型学习的解缠程度,并表明我们的方法在数量上也明显优于所有基准。与InfoGAN不同,β-VAE训练稳定,对数据的假设很少,仅依赖于调整单个超参数β,可以通过使用弱标记数据的超参数搜索,或通过启发式直观检查的纯无标签数据直接对其进行优化。

1. 引言(INTRODUCTION)

对于给定的机器学习方法,学习任务的难度可能会根据数据表示的选择而不同。具有非常适合特定任务和数据域的表示形式可以显著提高所选模型的学习成功率和鲁棒性。已经提出,学习数据中生成因子的解缠结果表示对许多任务和领域都可能有用。纠缠的表示可以定义为单个潜在单位对单个生成因子的变化敏感,而相对于其他因子变化相对不变的表示。例如,在3D对象的数据集上训练的模型可能会学习对单个独立数据生成因素,(例如对象身份,位置,比例,照明,颜色等)敏感的独立潜在单元,从而充当逆向图像模型。在一个纠缠的表示中,关于一个因素的知识可以推广到其他因素的新颖配置中。根据 Lake等人在他们仍然挣扎但是人类擅长的情况下,解缠的表示法可以提高最先进的AI方法的性能。这样的场景包括那些需要知识转移的场景,其中通过将学习的表示重用于许多任务来实现更快的学习;零脉冲推理,其中通过重新组合先前学习的因素来进行新的数据推理;或新颖性检测。

在AI研究中,无监督学习后验分布上的解缠分布在潜在生成因子上是一个重大挑战。之前的大多数尝试都需要先验知识数据生成因子的数量和/或性质。如(Hinton et al., 2011; Rippel & Adams, 2013; Reed et al., 2014; Zhu et al., 2014; Yang et al., 2015; Goroshin et al., 2015; Kulkarni et al., 2015; Cheung et al., 2015; Whitney et al., 2016; Karaletsos et al., 2016)。在现实世界中,这并非总是可行的,在这种情况下,新初始化的学习者可能会接触到复杂的数据,其中不存在关于生成因子的先验知识,并且几乎没有发现这些因子的监督。直到最近完全无监督的分解因子学习方法还没有很好的扩展。

最近,已经开发出一种可扩展的无监督学习方法来解决纠缠因素学习问题,称为 InfoGAN 。 InfoGAN 扩展了生成对抗网络(GAN) 框架,以额外的最大化生成噪声变量的子集与识别网络输出之间的互信息。据研究,它能够发现数据生成因子的至少一个子集,并且能够学习这些因子的解开表示。但是 InfoGAN 对GAN框架的依赖是以训练不稳定和减少样本多样性为代价。此外, InfoGAN需要一些数据的先验知识,因为它的性能对先验分布的选择和正规化噪声变量的数量比较敏感。 InfoGAN还缺少一个原则上的推理网络(尽管可以将识别网络看作一个推理网络)。当在迁移学习或零推断的场景中使用无监督模型时,从感觉输入推断后潜在分布的能力非常重要。因此,尽管InfoGAN 是朝着正确方向迈出的重要一步,但我们认为有必要进行进一步改进,以实现使用无监督学习的原理性方法,从而在Lake 等人描述的算法中开发出更多类似于人的学习和推理方法。

最后目前尚无用于量化学习解缠程度的通用方法。因此,无法定量比较不同模式或优化单个模型的超参数时实现的解缠程度。

在本文中,我们尝试解决这些问题。我们提出了 β-VAE,这是一种用于因子分解学习的深层无监督生成方法,可以自动发现无标签数据中变异的独立潜在因子。我们的方法基于可变自动编码器(Variational Auto-Encoder (VAE))框架,带来了可扩展性和训练稳定性。尽管最初的VAE工作已显示在诸如FreyFaces或MNIST的简单数据集上实现有限的解缠性能,但解缠性能并不能扩展到更复杂的数据集,促使开发更精细的基于半监督的基于AVE的学习方法来学习纠缠因子。

我们建议使用单个超参数β扩展原始VAE框架,该超参数β调制应用于模型的学习约束。这对潜在信息通道的容量增加了限制,并控制了对学习系统上独立的潜在因素的重视。其中β=1对应于原始的VAE框架。当β > 1时,模型被推动以学习数据更有效的潜在表示,如果数据至少包含一些独立的潜在变化因素,则可以将其解开。我们的研究表明,与原始的VAE框架相比,这种简单的修改使β-VAE显著提高了学习的潜在表示中的解缠度。此外,β-VAE 与无监督因子(InfoGAN)和半监督(DC-IGN)相比可以获得最佳的解缠性能。使用定性评估在许多基准数据集上学习,例如CelebA、椅子和脸部。最后为了帮助量化差异,我们开发了一种新的解缠测量的度量方法,并显示在此测量值上,β-VAE 明显优于我们所有的基线。

我们的主要贡献如下:1)我们提出了β-VAE,一种新的无监督学习方法,用于学习独立的视觉数据生成因子的解缠表示;2)我们提出了一种协议,以定量比较不同模型学习的解缠程度;3)从定性和定量两个方面证明了,与各种复杂数据集上的各种基准算法相比较,我们的β-VAE方法可实现最好的解缠性能。

2. β-VAE衍生框架( β-VAE FRAMEWORK DERIVATION)

令 D = {X,V,W}为由图像x ∈ RN和两组实验的真实数据生因子组成的集合,条件独立因子 v ∈RK,其中 logp(v|x) =Σk logp(vk|x)和条件因子w ∈ RH。我们假设图像x是由真实世界模拟器使用相应的真实实验数据生成因子生成的:p(x|v,w) = Sim(v,w)。我们想要建立一个无监督的深度生成模型,该模型仅使用来自x的样本就可以学习数据x和一组生成潜在因子z (z ∈ RM, 其中M ≥ K) 的联合分布,从而z可以生成观测数据x,即p(x|z) ≈ p(x|v,w) = Sim(v,w)。因此,一个合适的目标是在潜在因子z整个分布范围内,使观察到的数据x的边际(对数)似然性最大化:

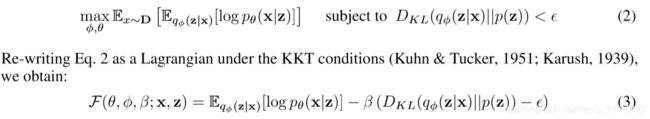

给定一个观测值x,通过概率分布qφ(z|x)推断潜在因子z的后验设置。我们的目标是确保推断的潜在因子后验概率qφ(z|x) 以非纠缠的方式捕获生成因子v。条件相关的数据生成因子w可以纠缠在不用于表示v的z的单独子集中。为了鼓励推论qφ(z|x)的这种解缠性质,我们尝试通过对其施加约束,将其与p(z)预先匹配,既可以控制潜在信息瓶颈的能力,又可以体现上述统计独立的愿望。我们将先验设置为各向同性的单位高斯分布(p(z) = N(0,I)),则可以实现此目的,从而得出等式2中的约束优化问题。其中ε表示所施加约束的强度。条件约束问题2通过在KKT条件下,引入拉格朗日乘数法,变为等式3的无条件约束问题:

其中KKT乘数β是正则化系数,它约束了潜在信息通道z的容量,并且由于高斯先验分布p(z)的各向同性性质,对学习后验施加隐式的独立压力。由于根据补充松弛KKT条件, β,ε ≥ 0 ,重新编写等式3,以得出β-VAE公式,这是Jordan等人描述的可变自由能目标函数,但增加了β系数:

![]()

β的变化会改变训练过程中施加的学习压力的程度,从而鼓励不同的学习表现形式。β-VAE,其中,β=1对应于原始的VAE公式。我们假设为了学习条件独立的数据生成因子v的纠缠表示,重要的是设置β > 1,从而对潜在的瓶颈施加比 Kingma & Welling 最初的VAE公式更强的约束。这些约束限制了z的容量,再加上使模型中训练数据x的对数似然性最大化的压力,应该会鼓励模型学习最有效的数据表示形式。由于数据x是使用至少一些条件独立的真实实验因子v生成的,并且β-VAE目标函数的DKL项鼓励qφ(z|x)中的条件独立,因此我们假设较高的β值应该有利于学习解缠v的表示。但是来自高β值得额外压力可能会在学习得潜在表示的重建精度和解缠质量之间造成折衷。当在信息保存(重建成本作为正则化)与潜在通道容量限制(β > 1)之间找到适当的平衡时,就会出现纠缠的表示。由于高频细节在经过受限的潜在瓶颈时会丢失,因此后者可能导致重建效果较差。因此,在学习模型下数据的 对数似然度 是评估β-VAE中解缠的不良表示。取而代之的是,我们提出了一种 定量度量,可以直接测量潜在表示中学习的纠缠程度。

由于我们提出的超参数β直接影响学习的解缠程度,因此我们想估计用于直接学习解缠的潜在表示的最佳β。但是,不可能这样做。这是因为最优 β 值将取决于等式2中的ε值。不同的数据集和不同的模型架构将需要不同的ε最佳值。但是,当优化公式中的β时。如图4所示,我们也在间接地优化ε以实现最佳解缠度(详细信息请参见附录A.7节),尽管我们无法直接学习β的最优值,但可以使用我们建议的解缠度度量对其进行估计(参见第3节)或通过目测启发式。

3. 分离度(DISENTANGLEMENT METRIC)

能够量化由不同模型实现的解缠程度非常重要。但是为此设计度量标准并不容易。我们首先定义我们期望解缠的表示所具有的属性。然后,描述了我们提出的方案,用于量化学习中此类属性的存在。

如上所述,我们 假设数据时通过使用多个数据生成因子的真实实验模拟过程中生成的,其中一些是条件独立的,并且我们还假定他们是可解释的。例如,模拟器可能会采样与对象形状、颜色和大小相对应的独立因素,以生成一个小苹果的图像。由于具有独立性,因此模拟器还可以生成小红苹果或大绿苹果。表示与这些生成因子无关的数据表示,即将其编码为单独的潜在像,即使使用非常简单的线性分类器也可以实现可靠的分类(因此提供了可解释性)。例如,当其他数据生成因素(例如大小或颜色)发生变化时,学习依赖对象形状的决策边界的分类器也会表现出色。

请注意,根据我们的需求,由独立潜在像组成的表示不一定会纠缠。通过学习将数据投影到独立基础上 的多种方法(例如PCA或者ICA)可以轻松实现独立性。通过这种方法学习的表示形式通常与数据生成因素不一致,因此可能缺乏可解释性。因此,在推断的潜在数之间进行简单的互相关计算就不能作为解缠度量。

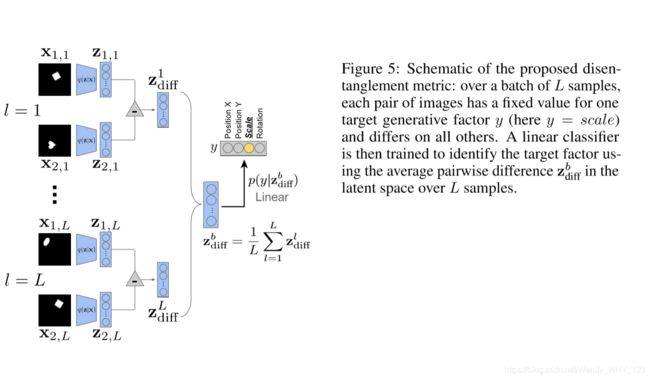

因此,我们提出的解缠度量 可以测量推断潜伏的独立性和可解释性(由于使用了简单的分类器) 。为了应用我们提出的度量方法,我们对通过固定一个数据生成因子的值而对其他所有数据随机采样而生成的许多图像进行推断。如果推断表示的独立性和可解释性属性成立,则推论潜在因素的差异将与固定性因素相对应。我们 使用低容量线性分类器来识别此因素,并将精度值报告为最终的解缠度度量值。与目标因子对应的潜在差异较小,将是该分类器的工作更轻松,从而指导该指标下的得分更高。有关完整过程的表示,请参见图5:

更正式的讲,从数据集D = {X,V,W}开始,如第二节所述。假设包含实验真实因素 (v,w)的均匀分布,图2中的图像数据点是使用实验真实模拟器过程x ∼ Sim(v,w)获得的。

我们还假设至少在某些情况下,给我们提供了标记以标识独立数据生成因子v ∈ V 的子集。

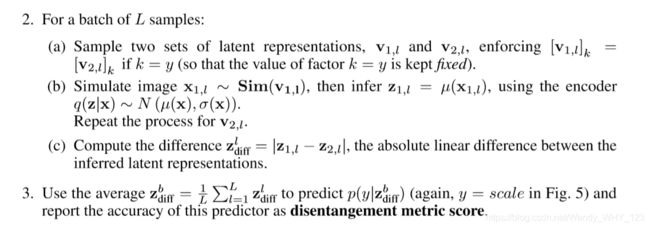

然后,我们构造一批B向量z_diff^b,作为输入线性分类器,如下:

- 选择一个因子y〜Unif [1 … K](例如图5中的y =比例)。

- 对于一批L样本:

分类器的目标是预测对于给定的zbdiff固定的生成因子的索引y。该分类器在多个批次中的准确性被用作我们的解缠度指标得分。我们选择具有低VC维度的线性分类器,以确保它本身不具有执行非线性解缠的能力。我们采用两个推断的潜在向量的差值,以减少分类器输入的方差,并减少对输入x的条件依赖性。这可以在均值上确保 更多细节步骤看附录A.4的等式5。

更多细节步骤看附录A.4的等式5。

4. 实验(Abstract)

在本节中,我们首先定型的证明了我们提出的β-VAE 框架不断发现更多潜在因素,并以一种更简单的方式解决基于各种基准的纠缠因子的学习的解决方案。(无论是原始的VAE算法、无监督学习的InfoGAN算法和半监督的DC-IGN算法)。然后,我们使用拟提出的新解缠度量标准,量化和表征我们的β-VAE框架与各种基准之间的解缠因子学习的差异。

4.1.定性基准(QUALITATIVE BENCHMARKS)

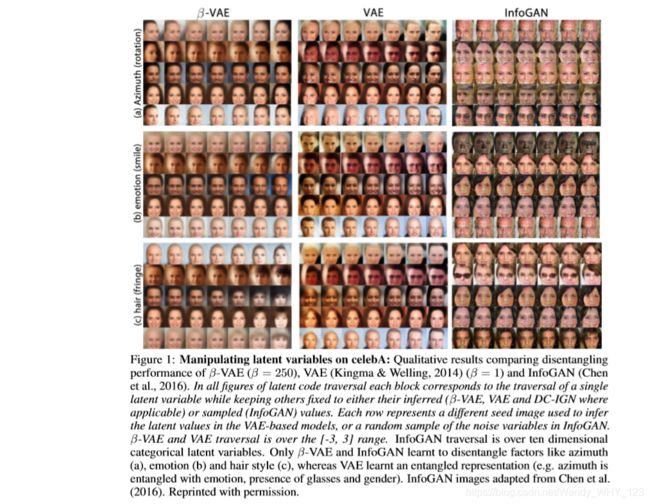

我们在各种常用来评估模型解缠性能的数据集上训练了β-VAE(有关结构的详细信息,参见表1),这些数据集是celebA (Liu et al., 2015), chairs (Aubry et al., 2014) and faces (Paysan et al., 2009)。图1-3提供了 β-VAE, VAE (β = 1) , InfoGAN和 DC-IGN 的实验结果。

可以看出,在所有的数据集中,β-VAE能够自动发现并学会解开半监督DC-IGN 所学习的所有因素:方位角(Fig. 3a, Fig. 2a)、照明度和高程 (Fig. 3b,c)。它通常比DC-IGN (e.g. Fig. 3a)或InfoGAN (e.g. Fig. 2a, Fig. 1a-c or Fig. 3a)更具说服力。此外,与DC-IGN不同的是,β-VAE是完全无监督学习,因此可以了解DC-IGN 无法通过设计学习的额外的未标记数据生成因素,例如椅子宽度或腿部样式(Fig. 2b,c)。无监督 InfoGAN 的学习方法与β-VAE具有相同的性能,并且两个框架倾向于发现重叠但不一定相同的数据生成因子集。例如,β-VAE 和 InfoGAN都学习到了椅子的宽度,但是DC-IGN没有(Fig. 2b)。只有β-VAE 学习了椅子腿的样式 (Fig. 2c)。有趣的是,注意到β-VAE如何让能够产生一个带有办公椅底座的扶手椅,尽管这样的扶手椅在数据集中不存在(或者可能、现实的)。此外只有β-VAE 能够通过单一模型发现所有三个变化因素(椅子方位角、宽度和椅腿样式),而InfoGAN学会了将其连续的潜在变量分配给方位角和宽度。 InfoGAN有时会发现 β-VAE无法精确解开的因素,例如明星数据中太阳镜的存在。但是,β-VAE 确实发现了许多其他因素,例如肤色,图像饱和度和年龄、性别,这在InfoGAN论文中b并未提到(Fig. 4)。此外,与 InfoGAN 相比,β-VAE潜在趋势倾向于在更宽泛的因子值上学习平滑的连续变换(例如,Figs. 1-3a所示在更宽泛的角度内旋转)。

总体而言,与InfoGAN 和DC-IGN相比, β-VAE倾向于持续稳健的发现更多潜在因素,并能更清晰地了解这些因素。即使在诸如celebA这样具有挑战性的数据集上也是如此。此外,与InfoGAN 和DC-IGN不同,β-VAE 不需要有关数据的设计决策或假设 ,并且训练非常稳定。

与未修改的VAE 基础模型相比,β-VAE 始终学习到更多的非纠缠的潜在表示。例如,在学习椅子时,VAE 将椅子的宽度与腿的样式纠缠在一起 (Fig. 2b)。当学习celebA时,VAE将 方位角与情感和性别纠缠在一起(Fig. 1a)。带有发型,肤色和身份的情感(Fig. 1b);而VAE条纹潜伏也编码秃发和头部尺寸。尽管VAE在人脸数据集上表现相当好,但仍难以学习方位的清晰表示 (Fig. 3a)。但是,这表明存在一个连续的纠缠性能,并且可以通过更改β-VAE框架内的β值来遍历。然而β值越大,通常会导致更好的解缠性能,但可能会以重建的结果为代价,并丢失某些因素表示,尤其是那些仅与像素空间的微小变化相对应的因素。

4.1.量化基准(QUANTITATIVE BENCHMARKS)

为了定量比较β-VAE在各种基线下的解缠性能,我们创建了一个合成数据集,该数据集由737,280个二进制二维形状(心形、椭圆形和正方形)组成,该形状由形状的笛卡尔积和在矢量中定义的四个独立的生成因子vk生成图形:位置X(32个值),位置Y(32个值),比例尺度(6个值),旋转角度(0到2π中取40个值)。为了确保对象的平滑转换,为给定64×64的像素图像分辨率,选择每个因子vk的每两个后续值以确保像素空间的最小差异。选择该数据是因为除了五个独立的数据生成因素(身份,X位置,Y位置,比例尺度和旋转角度)外,它不包含任何混杂因素。这使我们了解了用于以客观方式比较不同模型的解缠性能的基本事实。

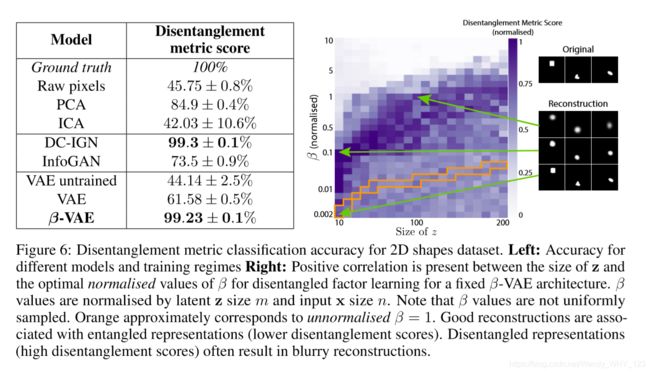

我们使用拟议的解缠度量标准(参见第3节)来定量比较 β-VAE 自适应发现和学习上述2D形状合成数据集的数据生成因子与许多基准的解缠关系的能力。(有关模型体系结构的详细信息,参见附录表1 )。图6(左)中的表格显示了5000个测试样本的解缠指标的分类精度。可以看出,β-VAE (β = 4) 明显优于所有基准算法,例如未经训练的原始的VAE(β = 1) 方法,其结构与β-VAE 相同,数据的前十个PCA和ICA组件(有关详细信息,参阅附录A.3节),或直接使用原始像素时, β-VAE也比InfoGAN更好。值得注意的是,β-VAE的性能与DC-IGN是相同的,尽管DC-IGN是半监督学习,而β-VAE是完全无监督学习的。此外,β-VAE的分类精度与用于数据生成的实验真实向量相似,因此表明它能够学习很好的数据生成因子的解缠表示。

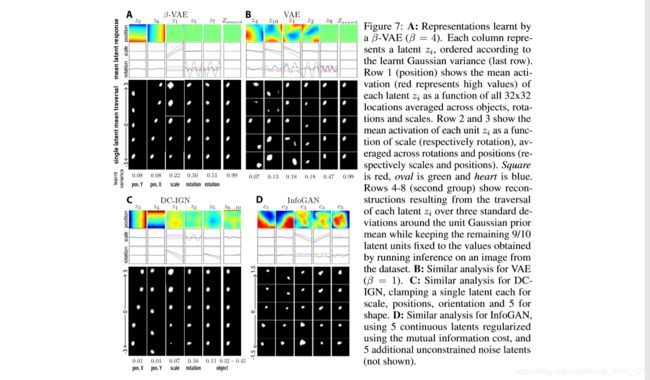

我们还定性地测试了β-VAE, VAE, InfoGAN 和 DC-IGN 在2D形状的合成数据集中学习的表示形式。图7A证明,经过训练后, β = 4的 β-VAE可以很好地(虽然不是完美的)解开数据生成因子的表示,并且其解码器学会了充当渲染引擎。它的性能与DC-IGN (Fig. 7C)相比,不同之处在于DC-IGN需要一定的先验知识,了解数据生成因子的数量,而β-VAE能够以完全无监督的方式发现它们。β-VAE的 信息量最大的潜在神经元 zm与单位高斯先验概率 (p(z) = N(0,I))的KL散度最高,而信息不充分的潜伏的KL散度接近于零。 Fig. 7A展示了每个潜在zm对独立数据生成因子的选择性:![]() 其中zµ m 是潜在单位 zm 的学习高斯平均值。遍历每个潜在zm对结果重构的影响如 Fig. 7A的底部五行所示。潜在z6和z2学会了分别编码对象的X和Y坐标;z1潜在单元学会了对比例尺度进行编码;z5和z7学会了对象的旋转角度编码。每个旋转潜在区域中的振荡频率对应于相应对象的旋转对称性(心形为2π ,椭圆为π,正方形为π /2)。此外,两个旋转潜在像似乎编码cos和sin旋转坐标,而位置潜像于笛卡尔轴对齐。尽管不能保证与人类的直观看法一致,但根据经验,我们发现它非常普遍。Fig. 7B 证明,在适当的学习压力下,为经修改的VAE基础模型(β = 1)无法像β-VAE一样解开数据中的生成因子。取而代之的是,每个潜在z(除z9外,z9都学会了旋转)编码至少两个数据生成因子。InfoGAN还实现了一定程度的解缠(参见图7D),尤其是在位置因素方面。但是,尽管我们尽了最大的努力来训练 InfoGAN,但在其他因素(例如旋转、缩放和形状)上却无法达到同样的解缠度。我们还发现,在训练过程中 其在数据集中生成不同形状的能力不准确且不稳定,这可能是由于所展示的 GAN框架的局限性所致,该框架可能难以了解完整的数据分布,而通常会学习一部分数据模式。

其中zµ m 是潜在单位 zm 的学习高斯平均值。遍历每个潜在zm对结果重构的影响如 Fig. 7A的底部五行所示。潜在z6和z2学会了分别编码对象的X和Y坐标;z1潜在单元学会了对比例尺度进行编码;z5和z7学会了对象的旋转角度编码。每个旋转潜在区域中的振荡频率对应于相应对象的旋转对称性(心形为2π ,椭圆为π,正方形为π /2)。此外,两个旋转潜在像似乎编码cos和sin旋转坐标,而位置潜像于笛卡尔轴对齐。尽管不能保证与人类的直观看法一致,但根据经验,我们发现它非常普遍。Fig. 7B 证明,在适当的学习压力下,为经修改的VAE基础模型(β = 1)无法像β-VAE一样解开数据中的生成因子。取而代之的是,每个潜在z(除z9外,z9都学会了旋转)编码至少两个数据生成因子。InfoGAN还实现了一定程度的解缠(参见图7D),尤其是在位置因素方面。但是,尽管我们尽了最大的努力来训练 InfoGAN,但在其他因素(例如旋转、缩放和形状)上却无法达到同样的解缠度。我们还发现,在训练过程中 其在数据集中生成不同形状的能力不准确且不稳定,这可能是由于所展示的 GAN框架的局限性所致,该框架可能难以了解完整的数据分布,而通常会学习一部分数据模式。

理解超参数β的影响

我们假设约束优化对于使深层无监督学习模型能够独立数据生成因子的解缠表示很重要(第2节)。在 β-VAE框架中,这相当于调整β系数。 观察β的一种方法是作为混合系数(关于推导,请参见A.6节),以平衡训练过程中方程4中VAE下界公式的重构和先验匹配分量的梯度幅度。在这种情况下,有意义的是通过潜在z大小m和输入x大小n标准化β,以便在不同的潜在层大小和不同的数据集之间比较其不同的值(βnorm=βM/N)。我们发现,***较大的潜在z层大小m需要较高的约束压力(较高的β值)***,请参见图6(右)。 此外,对于给定的m,β的关系以倒U曲线为特征。当β太低或太高时,由于z潜在瓶颈中的容量过多或过小,模型都会学习到纠缠的潜在表示。 我们发现,一般而言,β> 1是实现良好解缠结所必需的。但是,如果β太大,并且潜在通道的最终容量低于数据生成因子的数量,则必须纠缠学习的表示(因为真实数据生成因子的低秩投影会将它们压缩)仍然可以很好地捕获完整数据分布的非析因方法)。我们还注意到,VAE重建质量不能很好地表明学习的纠缠程度。良好的纠缠表示由于潜在信息通道z的容量受限而经常导致模糊的重建,而纠缠表示常常导致最清晰的重建。因此,我们建议当使用β-VAE作为无监督特征学习者时,人们不一定要争取完美的重建-尽管通常可以找到正确的β-VAE体系结构和β的正确值,以使其具有良好解开的潜在表示和良好的 重建。

我们提出了一种原则上选择带有至少弱标签信息的数据集的β的方法。 如果标签信息至少存在一小部分独立的数据生成因子变化,则可以应用第 3节中描述的解缠度度量。可以估计超参数扫描期间各种β选择的学习解缠水平。当这样的标记信息不可用时,可以通过目视检查每个单个潜伏单元zm的遍历对像素空间中生成的图像(x | z)有什么影响来找到β的最佳值(如图7所示)。 第4-8行)。 对于2D形状数据集,我们发现通过视觉检查确定的β最优值与通过解缠度度量确定的最优值紧密匹配。

5.结论(CONCLUSION)

在本文中,我们将标准的VAE框架重新设计为 具有强大潜在容量约束和独立先验压力的约束优化问题。通过用可调节此类压力强度的β系数增加下界公式,并因此提高模型所体现的定性性质,我们达到了研究结果的状态,以学习数据生成因子的分解表示。已经表明,我们提出的β-VAE框架在性能和数量上均明显优于原始VAE方法,以及无监督的最新技术 InfoGAN和半监督 DC-IGN的方法来解开因子学习。此外,我们已经证明,β-VAE能够一致而稳健地发现数据中更多的变异因素,并且它学习的表示形式涵盖了更广泛的因子值范围,并且比其他基准测试更清晰地进行了纠缠,而这一切都是完全无监督的。与InfoGAN和DC-IGN不同,我们的方法不依赖于任何有关数据生成因子的数量或性质的先验知识。我们的初步研究表明,β-VAE框架的性能可能取决于训练数据集中数据生成因子的采样密度(更多信息,请参见附录A.8)。似乎具有更密集的采样数据生成因子会导致更好的解纠缠β-VAE性能,但是我们将这种效果的更原则性研究留给以后的工作。

β-VAE相对于不同的体系结构,优化参数和数据集具有鲁棒性,因此需要很少的设计决策。我们的方法依赖于单个超参数β的优化,如果弱标记数据可用于计算我们新提出的解缠结度量,则可以直接通过超参数搜索找到。可替代地,可以在纯粹无监督的情况下通过启发式估计最佳β。 以完全无监督的方式学习独立数据生成因子的可解释因子分解表示,这是人工智能发展的重要先驱,该人工智能以与人类相同的方式理解世界。我们相信,将我们的方法用作监督或强化学习的无监督预训练阶段,将对诸如迁移或快速学习之类的场景产生显着改善。