采用双注意力机制的Deeplabv3+算法的遥感影像语义分割(论文)

摘要

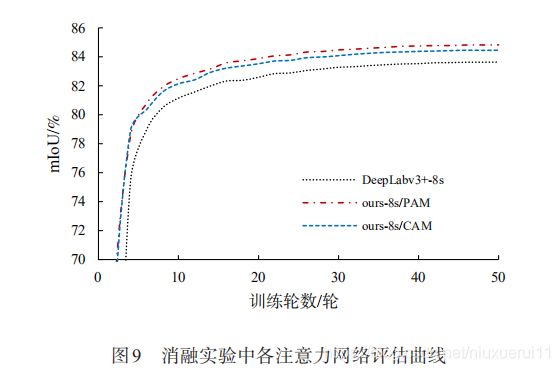

针对 DeepLabv3+网络在遥感影像上呈现出拟合速度慢,边缘目标分割不精确,大尺度目标分割类内不一致、存在孔洞等缺陷,提出在该网络中引入双注意力机制模块 (Dual Attention Mechanism Module,DAMM),设计并实现了将DAMM结构与ASPP (Atous Spatial Pyramid Pooling) 层串联或并联的2种不同连接方式网络模型 ,串联连接方式中先将特征图送入 DAMM 后,再经过 ASPP结构;并联连接方式中将双注意力机制层与 ASPP层并行连接,网络并行处理主干网提取特征图,再融合两层处理特征信息。将改进的 2种方法通过 INRIA Aerial Image 高分辨率遥感影像数据集验 证,结果表明,串联或并联方式 2 种网络都能有效改善Deeplabv3+的不足,并联方式网络性能更好,其对原网络缺陷改善效果更明显,并在测试数据集上 mIoU达到85.44%,比 Deeplabv3+提高了 1.8%,而串联方式网络提高了 1.12%。并联结构网络更符合本文需求,其形成了一种对DeepLabv3+网络上述问题进行统一改善的方案。

改进的DeepLabv3+算法

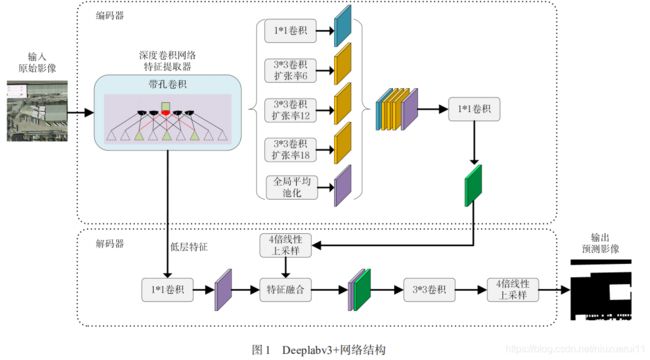

Deeplabv3+在deeplabv3的基础上添加了编码-解码结构,使得其成为现如今最为流行的一种分割网络,其结构如下图所示。 可以看到网络由编码器和解码器两部分组成, 编码器为深度扩张卷积神经网络和ASPP层, 解码器融合底层特征进行特征图恢复。

首先: DeepLabv3+ 在深度扩张卷积神经网络中加入了扩张卷积,在保证减少下采样操作和不增加网络参数的情况下增加了网络感受野, 使得特征图尽可能的不丢失目标边界特征信息, 从而提升分割精度。

其次:针对图像中不同的目标尺寸大小不同,DeepLabv3+ 网络接用了SSP-Net网络中的空间金字塔池化层,来达到对多尺度目标分割的能力。 ASPP将输入特征图进行1x1 卷积, 扩张率 为6,12,18的3x3卷积以及全局平均池化操作后, 最终ASPP完成对多尺度目标的特征提取和区分,很好的实现多尺度目标分割。

最后,DeepLabv3+网络为充分提取图像中目标物体的高层特征信息,对输入图像进行必要的下采样操作,为弥补下采样操作中丢失的边界信息,DeepLabv3+采用编码-解码结构,在特征图恢复过程中融合低层特征,恢复目标部分边界信息,特征图恢复采用线性插值方法,最终提高了网络分割的精度。

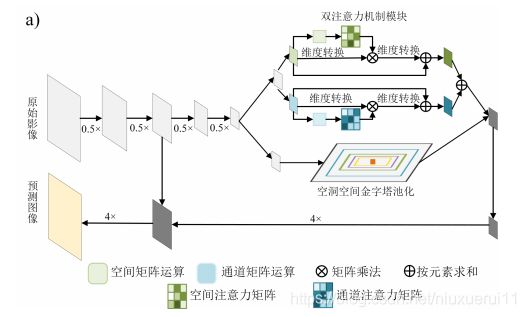

将自注意力机制引入语义分割任务中, 并设计了网络模型DANet,证明了自注意力机制在语义分割任务中同样使用,DANet网络模型包括两大部分, 位置注意力机制和通道注意力机制。

位置注意力模块: 能够模拟出丰富的全局特征上下文信息, 从而使得不同位置同特征进行增强

。提高语义分割能力, 位置注意力模块结构图如下图所示:

通过主干网络可以得到局部特征 A ∈ RC × H × W矩阵,将特征A通过卷积操作得到矩阵B、C和D,其中{B,C,D} ∈ RC × H × W。接着将矩阵B改变形状成B′ ∈ RC × N,N = H × W,同时将矩阵 B′ 转置为 BT,接着C改变为C′ 形状后与BT做矩阵乘法,最后使用softmax层计算出位置注意力S ∈ RN × N。

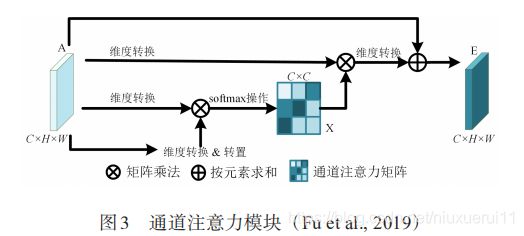

通道注意力模块:

语义分割模型提取的不同通道的高层语义特征图是某个特定类型的预测, 且不同类型的语义之间具有特定的联系。

与位置注意力模块不同,通道注意力模块直 接 通 过 A ∈ RC × H × W 计 算 出 通 道 注 意 力 图X ∈ RC × C, 首 先 将 特 征 矩 阵 A 形 状 改 变 成 A´ ∈ RC × N,N = H × W后将 A´与 A´的转置矩阵做矩阵乘法并通过softmax层得到X

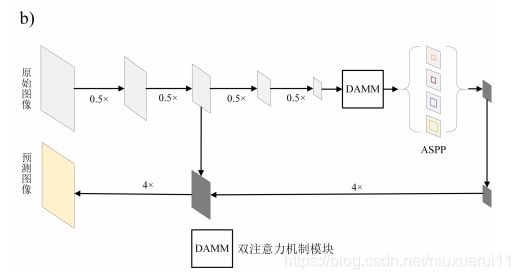

本文提出2种基于双注意力机制的Deeplabv3+模型以弥补上述不足,最后将 2 种网络结构进行实验对比,2种改进后的DeepLabv3+网络结构如图4所示。图为 DAMM 与 ASPP并联情况,使用主干网络先对图像进行特征提取,然后将模型分为2条支路网络分别对主干网提取的特征图进行处理,再将2条分路特征图融合。图中上支路是双注意力机制模块,由通道注意力模块和位置注意力模块组成,这 2个模块在双注意力模块中并行操作。

具体为:首 先,将骨干网提取所得特征图进行扩张率为 2 的 3×3卷积操作,然后将其分别送入通道注意力模块和位置注意力模块中处理,并将处理特征图进行加操作。其中通道注意力模块利用不同通道的相关类别特征间的关联性进行不同类别特征强化,提升分类精度,位置注意力模块通过模拟出不同局部特征间的联系,可相互促进不同局部特征间的分类精度。图中下支路使用DeepLabv3+中ASPP操作,先将特征图送入ASPP处理,再将ASPP处理特征图与双注意力模块处理特征图融合,最终将融合特征图降维至256通道数。网络解码模块沿用DeepLabv3+解码模块操作,最终得出图像分割图。

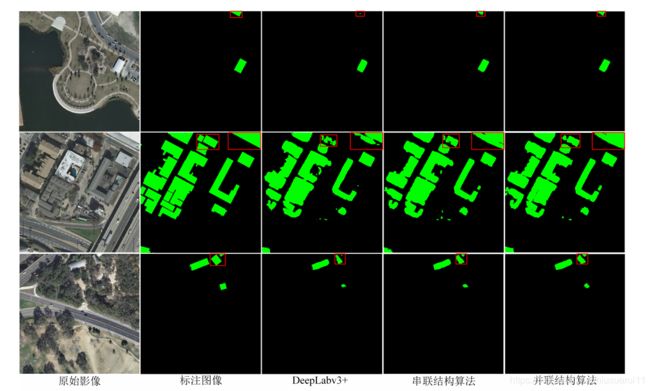

提出的两种网络与DeepLabv3+模型在边缘目标分割中效果

通过添加双注意力机制,能够有效模拟出图像位置间的长期上下文依赖信息,将不同局部特征信息连贯起来,注意力模块可利用不同通道的类内关联性使分割目标类内一致。

由于 DeepLabv3+网络较深,在训练时存在不稳定及训练较缓慢等现象,而双注意力机制可有效改善此问题。

DAMM 有效地改善了DeepLabv3+网络收敛慢的缺点。同时,改进后的网络保留DeepLabv3+的强大拟合能力,对 Deep‐Labv3+网络的性能有所提升。

结论与讨论

采用双注意力机制的Deeplabv3+深度语义分割网络对高分辨率遥感影像进行房屋分割,讨论了

DAMM结构与ASPP层在网络中不同连接方式对网络性能的影响,

得出如下结论:

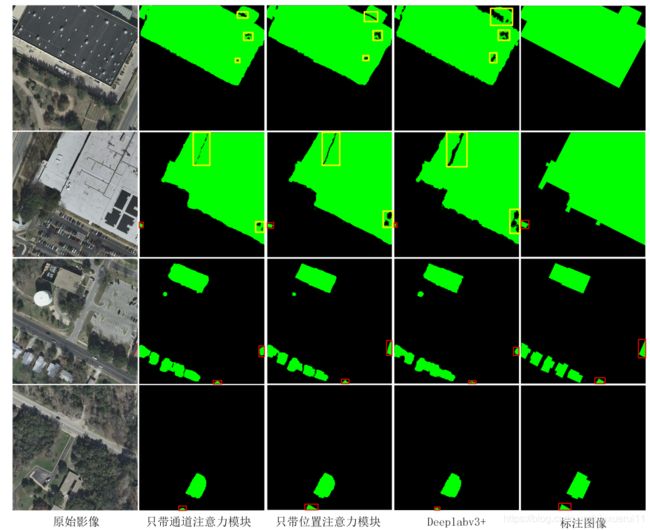

1)无论DAMM与ASPP并联还是串联,都缓解了DeepLabv3+ 收敛速度慢,消融实验证明注意力机制改善了训练过程中拟合缓慢现象。

2)在处理同一类型的目标中DAMM能够使得大尺度目标分割更为完善,能有效去除大尺度目标分割的孔洞现象。

3)DAMM结构利用通道和位置像素间的特征信息相互增强,使改进网络能够有效推断出边缘特征被破坏目标位置,并能更为精准地分割边缘目标,有效改善Dee‐plabv3+中边缘目标分割不准确的缺陷。

注:红色框中为边缘目标识别对比;黄色框中为大尺度目标孔洞现象对比;前面2行为不同注意力模块对大尺度目标语义分割情况。