[GNN论文阅读]DeepGCNs: Can GCNs Go as Deep as CNNs?

一、主要工作

基本思路和解决的任务:

CNN可以深卷而获得较好的性能,然不能表示非欧氏空间的数据。

GCN可以表非欧氏空间的图,然因梯度消失(过平滑,节点特征趋于一致)不能深卷(彼时<=4)。

此文提出一种多达56层的深卷GCN。

利用残差网络ResNet、密集连接DenseNet、空洞卷积

We adapt concepts that were successful in training deep CNNs, mainly residual connections, dense connections, and dilated convolutions. We show how we can incorporate these layers into a graph framework, and present an extensive analysis of the effect of these additions to the accuracy and stability of deep GCNs.

在点云模型语义分割上实验,证明性能明显提升。

+3.7% mIoU over state-of-the-art

二、研究动机

深卷GCN,获得较好性能:in computer vision, natural

language processing, and data mining。

三、创新点

利用深卷CNN中提出的思路。

四、具体思路

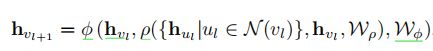

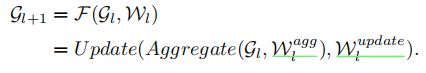

ρ为节点聚合函数, φ是顶点特征更新函数

![]()

这里ρ为一个最大池,φ为多层感知机:有批量归一化,ReLU作为激活函数。

此MLP将hvl与ρ()的聚合特征concate起来形成它的输入。

max-pooling:

对图的不重复区域应用同一个规则(取该区域最大点做输出)得到其对应的值作为该区域的特征。起到了减少下一层输入大小->降维、减少计算量和参数个数的作用;增大感受野(透过输出的一个点看到区域的所有点)。

因其定义方式,它具有一定的平移旋转放缩不变形(只要没弄出区域)。

此文在每层特征空间用Dilated k-NN funcntion增加感受野。

最近的工作[34,42,38]表明,动态图卷积,其中图结构允许在每一层改变比起固定不变,可以学习更好的图形表示。 当考虑更深的GCNs,动态变化的邻居有助于缓解过度平滑问题,并有有效的更大的接受场。

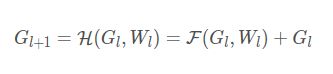

2.使用残差连接

https://www.cnblogs.com/xiaoboge/p/10539884.html

博客园 我的明天不是梦 的文章

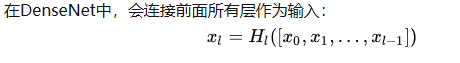

3. 使用dense连接

H代表是非线性转化函数(non-liear transformation),它是一个组合操作,其可能包括一系列的BN(Batch Normalization),ReLU,Pooling及Conv操作。注意这里 l层与 l+1 层之间可能实际上包含多个卷积层。![[GNN论文阅读]DeepGCNs: Can GCNs Go as Deep as CNNs?_第2张图片](http://img.e-com-net.com/image/info8/852aced7694545e58d63aceb211c9246.jpg)

DenseBlock+Transition的DenseNet网络:

DenseBlock是含多层的模块,Transition是通过pooling达到降小图,层数不变大小变,其包括一个1x1的卷积和2x2的AvgPooling,结构为BN+ReLU+1x1 Conv+2x2 AvgPooling。

DenseBlock内部可以采用bottleneck层来减少计算量,主要是原有的结构中增加1x1 Conv,即BN+ReLU+1x1 Conv+BN+ReLU+3x3 Conv,称为DenseNet-B结构。

https://zhuanlan.zhihu.com/p/37189203

知乎 小小将 的文章

版权声明:本文为博主yyl424525原创文章,遵循 CC 4.0 BY 版权协议,转载请附上原文出处链接和本声明。

本文链接:https://blog.csdn.net/yyl424525/article/details/99464457

4. Dilated Aggregation

普通情形

Dilation enlarges the receptive fifield without loss of resolution.(因为原图的所有信息无浪费吧——不降低解析度)

Dilated Aggregation是在一个大的范围里规则得跳点来和卷积核卷积。e.g.对3x3卷积核, dilated=2(点间间隔)的空洞卷积,就是在 3+1+1+1+1 =7,7x7的区域上挑9个点卷积(三个点有4个空儿:(3-1)+2,每个空儿大小是2-1=1)空洞位置权重视为0,在被又一个Dilated Aggregation的时候,人家说不定不在空洞位置,视作0的就是别人了。

卷积核mxm

dilated=n 感受野大小为[m+(m+1)x(n-1)]x[m+(m+1)x(n-1)]

TODO:我怎么发现不同的文章了感受野大小定义不同?!

p.s.padding是个补0操作

p.s.普通卷积stride>1提高感受野卷积的两个点之间间隔为stride-1 ,卷积核mxm感受野大小:m+(m-1)x(stride-1)(未考证)

与前同理

版权声明:本文为博主jiachen0212原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

本文链接:https://blog.csdn.net/jiachen0212/article/details/78548667

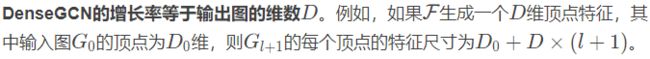

此文Dilated k-NN

对于Dilated k-NN,d as the dilation rate的输入图G=(V,E),Dilated k-NN通过跳过每d个邻域来返回k×d邻域内的k个最近邻类比于Dilated卷积抽出的点。

![[GNN论文阅读]DeepGCNs: Can GCNs Go as Deep as CNNs?_第4张图片](http://img.e-com-net.com/image/info8/51d0d486e49c4ce494da97dbecd7cd81.jpg)

此方法相当于将卷积中心点 和 自定义的邻居节点集 中的每 一个点连成一条边。 然后,按照本博文第一个公式中所示,进行GCN步骤中的 Aggregate 和 Update 函数。

在最后的实验部分作者又说了一遍:动态增加边进行GCN在Backbone Block.

知乎 https://zhuanlan.zhihu.com/p/97375480

此文用Dilated k-NN to find dilated neighbors after every GCN layer and construct a Dilated Graph.

我们在当前层的特征空间中使用l2距离。

五、理论分析

嗯?见以上。不求甚解。

六、实验效果

在大规模点云分割的任务上进行大量试验。

实验指标:overall accuracy (OA);mean intersection over union (mIoU) across all classes thorough ablation on area 5

28层骨干用了残差图连接和随机图空洞卷积on area 6。

与做的好的其他方法比较:shallow DGCNN baseline [42] and other state-of-the-art methods。

在 S3DIS semantic segmentationtask 上:Backbone Block输入点云有4096点通过连续GCN层聚合邻居信息提取特征,学得有4096顶点的图表示。

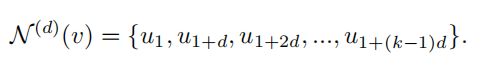

实验保持Fusion Block 和 MLP相同,变化Backbone Block得到PlainGCN,ResGCN,DenseGCN。

1.PlainGCN:堆叠28层边卷积,使用动态k-NN,类于DGCNN.无跳过连接。

2.ResGCN:1添加了动态Dilated k-NN 和残差图连接,这些连接不会增加参数。(因为只是改变了输入值,规模不变吗)

3.DenseGCN:1添加了动态Dilated k-NN 和密集图连接

2、3中dilation rate schedule同

Fusion Block :fuse the global and multi-scale local features,卷积+池化

它以每个GCN层的GCN骨干块中提取的顶点特征作为输入,并将这些特征concatenates起来,然后通过1×1卷积层,然后是maxpooling

后一层将整个图的顶点特征聚合成一个单一的全局特征向量再concatenate它与以前所有GCN层的每个顶点的特征( 整体和局部信息的融合)。

MLP为三层,these layers are 1×1 convolutions. 啥?

具体实现

Tensorflow

Adam optimizer 在相同的初始学习率0.001和学习率时间表。

每层用Batch Normalization, dropout以0.3的率在第二层MLP中用。

dilated k-NN with a random uniform sampling probability e = 0.2 for GCNs with dilations

为了分离出所提出的深度GCN体系结构的效果,我们不使用任何数据增强或后处理技术。 We train our models end-to-end from scrach.

实验结果

p.s.width:滤波器数->中间出来的特征层数吧

纵轴表示我们研究谁的影响

![[GNN论文阅读]DeepGCNs: Can GCNs Go as Deep as CNNs?_第6张图片](http://img.e-com-net.com/image/info8/326f1b54bfe4481680681b1e82d2df66.jpg)

此文实现了

ResGCN-56 8 最近邻

ResGCN-28 16 最近邻

ResGCN-151 3 最近邻 for 80 epochs

他们效果都挺好

学习列表:

论文 :DeepGCNs: Can GCNs Go as Deep as CNNs?残差连接:https://www.cnblogs.com/xiaoboge/p/10539884.html

博客园 我的明天不是梦 的文章

dense连接:

https://zhuanlan.zhihu.com/p/37189203

知乎 小小将 的文章

版权声明:本文为博主yyl424525原创文章,遵循 CC 4.0 BY 版权协议,转载请附上原文出处链接和本声明。ps://blog.csdn.net/yyl424525/article/details/99464457

空洞卷积:

版权声明:本文为博主jiachen0212原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

tps://blog.csdn.net/jiachen0212/article/details/78548667

![[GNN论文阅读]DeepGCNs: Can GCNs Go as Deep as CNNs?_第1张图片](http://img.e-com-net.com/image/info8/1fb524d6c76a4a11bfc1f5d3dad42899.png)

![[GNN论文阅读]DeepGCNs: Can GCNs Go as Deep as CNNs?_第3张图片](http://img.e-com-net.com/image/info8/dffda0a4593548b5aa7be9d101698001.jpg)

![[GNN论文阅读]DeepGCNs: Can GCNs Go as Deep as CNNs?_第5张图片](http://img.e-com-net.com/image/info8/77ce7c609a524ca7bd3903e00117bb7f.jpg)