- 高通 QCS8550 大模型性能深度解析:从算力基准到场景实测的全维度 Benchmark

伊利丹~怒风

Qualcomm人工智能AI编程pythonarm自然语言处理

前言在人工智能技术狂飙突进的时代,大模型正以前所未有的速度重塑各行业生态,从智能客服到多模态交互,从边缘推理到端侧部署,其应用场景不断拓展。而这一切革新的背后,离不开底层硬件的强力支撑。高通QCS8550作为面向下一代智能设备的旗舰级计算平台,凭借高达48TOPS的AI算力与先进的第七代高通AI引擎,在大模型性能表现上极具竞争力。其异构多核架构不仅能高效处理复杂的神经网络计算,还通过软硬件协同优化

- 卷积神经网络(Convolutional Neural Network, CNN)

不想秃头的程序

神经网络语音识别人工智能深度学习网络卷积神经网络

卷积神经网络(ConvolutionalNeuralNetwork,CNN)是一种专门用于处理图像、视频等网格数据的深度学习模型。它通过卷积层自动提取数据的特征,并利用空间共享权重和池化层减少参数量和计算复杂度,成为计算机视觉领域的核心技术。以下是CNN的详细介绍:一、核心思想CNN的核心目标是从图像中自动学习层次化特征,并通过空间共享权重和平移不变性减少参数量和计算成本。其关键组件包括:卷积层(

- ResNet(Residual Network)

不想秃头的程序

神经网络语音识别人工智能深度学习网络残差网络神经网络

ResNet(ResidualNetwork)是深度学习中一种经典的卷积神经网络(CNN)架构,由微软研究院的KaimingHe等人在2015年提出。它通过引入残差连接(SkipConnection)解决了深度神经网络中的梯度消失问题,使得网络可以训练极深的模型(如上百层),并在图像分类、目标检测、语义分割等任务中取得了突破性成果。以下是ResNet的详细介绍:一、核心思想ResNet的核心创新是

- P25:LSTM实现糖尿病探索与预测

?Agony

lstm人工智能rnn

本文为365天深度学习训练营中的学习记录博客原作者:K同学啊一、相关技术1.LSTM基本概念LSTM(长短期记忆网络)是RNN(循环神经网络)的一种变体,它通过引入特殊的结构来解决传统RNN中的梯度消失和梯度爆炸问题,特别适合处理序列数据。结构组成:遗忘门:决定丢弃哪些信息,通过sigmoid函数输出0-1之间的值,表示保留或遗忘的程度。输入门:决定更新哪些信息,同样通过sigmoid函数控制更新

- Python训练营打卡——DAY16(2025.5.5)

cosine2025

Python训练营打卡python开发语言机器学习

目录一、NumPy数组基础笔记1.理解数组的维度(Dimensions)2.NumPy数组与深度学习Tensor的关系3.一维数组(1DArray)4.二维数组(2DArray)5.数组的创建5.1数组的简单创建5.2数组的随机化创建5.3数组的遍历5.4数组的运算6.数组的索引6.1一维数组索引6.2二维数组索引6.3三维数组索引二、SHAP值的深入理解三、总结1.NumPy数组基础总结2.SH

- 【重构推荐系统】国产大模型驱动的电商个性化推荐完整实战:架构设计、推理优化与在线部署闭环

观熵

国产大模型部署实战全流程指南重构人工智能Agent智能体落地方案

个人简介作者简介:全栈研发,具备端到端系统落地能力,专注大模型的压缩部署、多模态理解与Agent架构设计。热爱“结构”与“秩序”,相信复杂系统背后总有简洁可控的可能。我叫观熵。不是在控熵,就是在观测熵的流动个人主页:观熵个人邮箱:

[email protected]座右铭:愿科技之光,不止照亮智能,也照亮人心!专栏导航观熵系列专栏导航:AI前沿探索:从大模型进化、多模态交互、AIGC内容生成,到

- Python爬虫实战:全方位爬取知乎学习板块问答数据

Python爬虫项目

2025年爬虫实战项目python爬虫学习开发语言scrapy游戏

1.项目背景与爬取目标知乎是中国最大的知识问答社区,聚集了大量高质量的学习资源和经验分享。爬取知乎“学习”板块的问答数据,可以为学习资料整理、舆情分析、推荐系统开发等提供数据支持。本项目目标:爬取“学习”话题下的热门问答列表抓取每个问答的标题、作者、回答内容、点赞数、评论数等详细信息实现动态加载内容的抓取,包含图片和富文本避免被反爬机制限制,保证数据采集稳定结合数据分析,为后续应用打基础2.知乎“

- 【机器学习&深度学习】反向传播机制

目录一、一句话定义二、类比理解三、为什重要?四、用生活例子解释:神经网络=烹饪机器人4.1第一步:尝一口(前向传播)4.2第二步:倒着推原因(反向传播)五、换成人工智能流程说一遍六、图示类比:找山顶(最优参数)七、总结一句人话八、PyTorch代码示例:亲眼看到每一层的梯度九、梯度=损失函数对参数的偏导数十、类比总结反向传播(Backpropagation)是神经网络中训练过程的核心机制,它就像“

- 人脸识别算法赋能园区无人超市安防升级

智驱力人工智能

算法人工智能边缘计算人脸识别智慧园区智慧工地智慧煤矿

人脸识别算法赋能园区无人超市安防升级正文在园区无人超市的运营管理中,传统安防手段依赖人工巡检或基础监控设备,存在响应滞后、误报率高、环境适应性差等问题。本文从技术背景、实现路径、功能优势及应用场景四个维度,阐述如何通过人脸识别检测、人员入侵算法及疲劳检测算法的协同应用,构建高效、精准的智能安防体系。一、技术背景:视觉分析算法的核心支撑人脸识别算法基于深度学习的卷积神经网络(CNN)模型,通过提取面

- Web3前沿科技:开启数字资产交易新征程

AI天才研究院

AI大模型企业级应用开发实战AgenticAI实战AI人工智能与大数据web3科技ai

Web3前沿科技:开启数字资产交易新征程关键词:Web3、数字资产交易、区块链、智能合约、去中心化金融摘要:本文聚焦于Web3前沿科技在数字资产交易领域的应用与发展。详细阐述了Web3的核心概念、相关技术原理,包括区块链、智能合约等。通过具体的算法原理和Python代码示例,深入剖析了数字资产交易在Web3环境下的运行机制。同时,结合实际项目案例,讲解了开发环境搭建、代码实现与解读。探讨了Web3

- 掌握Web3开发:从入门到精通

夲奋亻Jay

Web3web3

掌握Web3开发是一个涉及多个步骤和学习阶段的过程。以下是一些关键的步骤和开发案例,以及它们在搜索结果中的索引编号:了解区块链基础:学习区块链的基本概念,如去中心化、加密技术、共识机制等[1]。学习智能合约:学习智能合约的工作原理和它们在区块链上的应用,特别是以太坊平台上的智能合约[1]。掌握Web3.js或Ethers.js:学习如何使用这些JavaScript库与智能合约交互、发送交易和监听事

- Web3解读:解锁去中心化网络的潜力

清 晨

反侦测指纹浏览器社交媒体web3去中心化区块链tiktokfacebookinstagramClonBrowser

随着互联网技术的飞速发展,我们正在进入一个新的时代——Web3。Web3不仅仅是一个技术概念,它代表了一种全新的网络架构和价值交换方式。本文将深入探讨Web3的核心理念,以及它如何解锁去中心化网络的潜力。什么是Web3?Web3是一个基于区块链技术的去中心化网络,它旨在提供一个更加开放、透明和安全的互联网环境。与传统的Web2相比,Web3强调用户对数据的控制权,以及数据的不可篡改性。在Web3中

- 【Python深度学习】零基础掌握Pytorch Pooling layers nn.MaxPool方法

Mr数据杨

Python深度学习python深度学习pytorch

在深度学习的世界中,MaxPooling是一种关键的操作,用于降低数据的维度并保留重要特征。这就像是从一堆照片中挑选出最能代表某个场景的那张。PyTorch提供了多种MaxPooling层,包括nn.MaxPool1d、nn.MaxPool2d和nn.MaxPool3d,它们分别适用于不同维度的数据处理。如果处理的是声音信号(一维数据),就会用到nn.MaxPool1d。而处理图像(二维数据)时,

- 误差的回响:反向传播算法与神经网络的惊天逆转

田园Coder

人工智能科普人工智能科普

当专家系统在20世纪80年代初期大放异彩,成为人工智能实用化的耀眼明星时,另一股曾经被宣判“死刑”的力量——连接主义(神经网络)——正在寒冬的冻土下悄然涌动,孕育着一场惊天动地的复苏。马文·明斯基和西摩·帕尔特在1969年《感知机》专著中那精准而冷酷的理论批判,如同沉重的封印,将多层神经网络的研究禁锢了近二十年。他们指出的核心死结——缺乏有效算法来训练具有隐藏层的网络——仿佛一道无法逾越的天堑。单

- 阅读笔记(2) 单层网络:回归

a2507283885

笔记

阅读笔记(2)单层网络:回归该笔记是DataWhale组队学习计划(共度AI新圣经:深度学习基础与概念)的Task02以下内容为个人理解,可能存在不准确或疏漏之处,请以教材为主。1.从泛函视角来看线性回归还记得线性代数里学过的“基”这个概念吗?一组基向量是一组线性无关的向量,它们通过线性组合可以张成一个向量空间。也就是说,这个空间里的任意一个向量,都可以表示成这组基的线性组合。函数其实也可以看作是

- 【深度学习解惑】如果用RNN实现情感分析或文本分类,你会如何设计数据输入?

云博士的AI课堂

大模型技术开发与实践哈佛博后带你玩转机器学习深度学习深度学习rnn分类人工智能机器学习神经网络

以下是用RNN实现情感分析/文本分类时数据输入设计的完整技术方案:1.引言与背景介绍情感分析/文本分类是NLP的核心任务,目标是将文本映射到预定义类别(如正面/负面情感)。RNN因其处理序列数据的天然优势成为主流方案。核心挑战在于如何将非结构化的文本数据转换为适合RNN处理的数值化序列输入。2.原理解释文本到向量的转换流程:原始文本分词建立词汇表词索引映射词嵌入层序列向量关键数学表示:词嵌入表示:

- MATLAB实现WOA-BP鲸鱼优化算法优化BP神经网络多输入单输出回归预测(含模型描述及示例代码)

nantangyuxi

MATLAB含模型描述及示例代码算法matlab神经网络大数据人工智能深度学习机器学习

目录MATLAB实现WOA-BP鲸鱼优化算法优化BP神经网络多输入单输出回归预测(多指标,多图)1项目背景介绍...1项目目标与意义...2项目挑战...3项目特点与创新...5<

- End-To-End 之于推荐-kuaishou OneRec 笔记

ASKED_2019

RecSys笔记

核心思想OneRec提出了一种统一的生成式推荐系统架构,打破了传统“召回-粗排-精排”级联式推荐流程,使用单一生成模型同时完成召回与排序任务。该系统由快手团队研发,并成功部署于短视频主场景。OnlineA/BTest表现:模型总观看时长平均观看时长OneRec-1B+IPA+1.68%+6.56%一Input处理Userpositiveactionsequence,将短视频的多模态表征,通过量化的

- 量子机器学习前沿:量子神经网络与混合量子-经典算法

软考和人工智能学堂

人工智能#深度学习Python开发经验量子计算

1.量子计算基础1.1量子比特与量子门importnumpyasnpfromqiskitimportQuantumCircuit,Aer,executefromqiskit.visualizationimportplot_histogram#单量子比特操作演示defsingle_qubit_demo():qc=QuantumCircuit(1)qc.h(0)#Hadamard门创建叠加态qc.rz

- Pytorch模型安卓部署

python&java

pytorch人工智能python

Pytorch是一种流行的深度学习框架,用于算法开发,而Android是一种广泛应用的操作系统,多应用于移动设备当中。目前多数的研究都是在于算法上,个人觉得把算法落地是一件很有意思的事情,因此本人准备分享一些模型落地的文章(后续可能分享微信小程序部署,PyQt部署以及exe打包,ncnn部署,tensorRT部署,MNN部署)。本篇文章主要分享Pytorch的Android端部署。看这篇文章的读者

- 人工智能-基础篇-5-建模方式(判别式模型和生成式模型)

机器学习包括了多种建模方式,其中判别式建模(DiscriminativeModel)和生成式建模是最常见的两种。这两种建模方式都可以通过深度学习技术来实现,并用于创建不同类型的模型。简单来说:想要创建一个模型,依赖需求需要合适的建模方式来创建这个模型。通常建模方式主要分为两大类。一类是判别式模型,针对输入数据给出特定的输出。如:判断一张图片是猫还是狗,直接学习“猫”和“狗”的特征差异(如耳朵形状、

- PyTorch教程:LSTM语言模型的动态量化技术解析

怀灏其Prudent

PyTorch教程:LSTM语言模型的动态量化技术解析tutorialsPyTorchtutorials.项目地址:https://gitcode.com/gh_mirrors/tuto/tutorials前言在深度学习模型部署过程中,模型大小和推理速度是两个至关重要的考量因素。PyTorch提供的动态量化技术能够在不显著影响模型准确率的前提下,有效减小模型体积并提升推理速度。本文将深入解析如何对

- 【机器学习】数学基础——张量(傻瓜篇)

一叶千舟

深度学习【理论】机器学习人工智能

目录前言一、张量的定义1.标量(0维张量)2.向量(1维张量)3.矩阵(2维张量)4.高阶张量(≥3维张量)二、张量的数学表示2.1张量表示法示例三、张量的运算3.1常见张量运算四、张量在深度学习中的应用4.1PyTorch示例:张量在神经网络中的运用五、总结:张量的多维世界延伸阅读前言在机器学习、深度学习以及物理学中,张量是一个至关重要的概念。无论是在人工智能领域的神经网络中,还是在高等数学、物

- 后端开发实习生简历迭代的5个版本,希望能帮你找到实习

今天不coding

简历实习后端Java大厂暑期实习

后端开发实习生简历迭代的5个版本,希望能帮你找到实习1.0研究生开学时写的第一份简历,主要是对本科做的项目的一些总结。本科主要是以深度学习的项目为主+比赛,开发的技术学的比较少,后端的项目也没有做过。但是凭此找到了一份算法的实习。当时研一还是想走算法工程师的。后面觉得自己不适合,就放弃了。2.0经历过几个月的算法实习和论文折磨之后,决定走后端开发岗了,选择Java为主语言,在B站大学做了一个项目,

- 【机器学习实战】Datawhale夏令营2:深度学习回顾

城主_全栈开发

机器学习机器学习深度学习人工智能

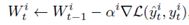

#DataWhale夏令营#ai夏令营文章目录1.深度学习的定义1.1深度学习&图神经网络1.2机器学习和深度学习的关系2.深度学习的训练流程2.1数学基础2.1.1梯度下降法基本原理数学表达步骤学习率α梯度下降的变体2.1.2神经网络与矩阵网络结构表示前向传播激活函数反向传播批处理卷积操作参数更新优化算法正则化初始化2.2激活函数Sigmoid函数:Tanh函数:ReLU函数(Rectified

- 深度学习详解:通过案例了解机器学习基础

beist

深度学习机器学习人工智能

引言机器学习(MachineLearning,ML)和深度学习(DeepLearning,DL)是现代人工智能领域中的两个重要概念。通过让机器具备学习的能力,机器可以从数据中自动找到函数,并应用于各种任务,如语音识别、图像识别和游戏对战等。在这篇笔记中,我们将通过一个简单的案例,逐步了解机器学习的基础知识。1.1机器学习案例学习1.1.1回归问题与分类问题在机器学习中,根据所要解决的问题类型,任务

- 大模型量化

需要重新演唱

大模型量化

大模型量化是一种优化技术,旨在减少深度学习模型的内存占用和提高推理速度,同时尽量保持模型的精度。量化通过将模型中的浮点数权重和激活值转换为较低精度的表示形式来实现这一目标。以下是关于大模型量化的详细知识:目录1.量化基础1.1量化定义1.2量化优势1.3量化挑战2.量化方法2.1量化类型2.2量化粒度2.3量化算法3.量化实践3.1量化流程3.2量化工具4.量化案例4.1BERT量化4.2GPT-

- RNN笔记

sjtu_哈基坤

LLM随笔rnn笔记人工智能

来源见此处概述RNN(RecurrentNeuralNetwork)RNN之所以称为循环神经网络,是因为一个序列的当前的输出与前面的输出也有关.具体表现是网络会对前面的信息进行记忆并且应用于当前输出的计算中.即隐藏层之间的节点也是有连接的.并且隐藏层的输入不仅包括输入层的输出还包括上一时刻隐藏层的输出.理论上RNN能对任何长度的序列进行处理,但是在实践中,为了降低复杂性,往往假设当前状态只与前面几

- 从0开始学习计算机视觉--Day04--线性分类

Chef_Chen

学习计算机视觉分类

从宏观来看,卷积网络可以看做是由一个个不同的神经网络组件组合而成,就像积木一样通过不同类型的组件搭建形成,其中线性分类器是一个很重要的组件,在很多卷积网络中都有用到,所以了解清楚它的工作原理对我们后续的学习会有很大的帮助。线性分类器是参数模型中最简单,最基础的例子,下面我们用输入图片输出图片分类的模型的例子来更进一步地了解它。首先,我们输入一张图片到模型中,输入后我们就会得到f(x,W),x指的是

- 如何设计和训练大模型(神经网络):从入门到精通!

“学习一门技术,先找一套工具和理论研究下去;千万不要反复横跳,什么都想学”大模型作为未来重要的发展方向,很多人想学习大模型技术,但又苦于无从下手;而本公众号前前后后也写过一些怎么学习大模型技术的方法论;但大部分都是从应用的角度作为切入点。但是,有一个问题就是,如果你是一个技术从业者,想学习和设计一款属于自己的大模型,应该怎么做?设计一个自己的大模型大模型作为一门快速发展的新型技术,其理论与实现也是

- 项目中 枚举与注解的结合使用

飞翔的马甲

javaenumannotation

前言:版本兼容,一直是迭代开发头疼的事,最近新版本加上了支持新题型,如果新创建一份问卷包含了新题型,那旧版本客户端就不支持,如果新创建的问卷不包含新题型,那么新旧客户端都支持。这里面我们通过给问卷类型枚举增加自定义注解的方式完成。顺便巩固下枚举与注解。

一、枚举

1.在创建枚举类的时候,该类已继承java.lang.Enum类,所以自定义枚举类无法继承别的类,但可以实现接口。

- 【Scala十七】Scala核心十一:下划线_的用法

bit1129

scala

下划线_在Scala中广泛应用,_的基本含义是作为占位符使用。_在使用时是出问题非常多的地方,本文将不断完善_的使用场景以及所表达的含义

1. 在高阶函数中使用

scala> val list = List(-3,8,7,9)

list: List[Int] = List(-3, 8, 7, 9)

scala> list.filter(_ > 7)

r

- web缓存基础:术语、http报头和缓存策略

dalan_123

Web

对于很多人来说,去访问某一个站点,若是该站点能够提供智能化的内容缓存来提高用户体验,那么最终该站点的访问者将络绎不绝。缓存或者对之前的请求临时存储,是http协议实现中最核心的内容分发策略之一。分发路径中的组件均可以缓存内容来加速后续的请求,这是受控于对该内容所声明的缓存策略。接下来将讨web内容缓存策略的基本概念,具体包括如如何选择缓存策略以保证互联网范围内的缓存能够正确处理的您的内容,并谈论下

- crontab 问题

周凡杨

linuxcrontabunix

一: 0481-079 Reached a symbol that is not expected.

背景:

*/5 * * * * /usr/IBMIHS/rsync.sh

- 让tomcat支持2级域名共享session

g21121

session

tomcat默认情况下是不支持2级域名共享session的,所有有些情况下登陆后从主域名跳转到子域名会发生链接session不相同的情况,但是只需修改几处配置就可以了。

打开tomcat下conf下context.xml文件

找到Context标签,修改为如下内容

如果你的域名是www.test.com

<Context sessionCookiePath="/path&q

- web报表工具FineReport常用函数的用法总结(数学和三角函数)

老A不折腾

Webfinereport总结

ABS

ABS(number):返回指定数字的绝对值。绝对值是指没有正负符号的数值。

Number:需要求出绝对值的任意实数。

示例:

ABS(-1.5)等于1.5。

ABS(0)等于0。

ABS(2.5)等于2.5。

ACOS

ACOS(number):返回指定数值的反余弦值。反余弦值为一个角度,返回角度以弧度形式表示。

Number:需要返回角

- linux 启动java进程 sh文件

墙头上一根草

linuxshelljar

#!/bin/bash

#初始化服务器的进程PId变量

user_pid=0;

robot_pid=0;

loadlort_pid=0;

gateway_pid=0;

#########

#检查相关服务器是否启动成功

#说明:

#使用JDK自带的JPS命令及grep命令组合,准确查找pid

#jps 加 l 参数,表示显示java的完整包路径

#使用awk,分割出pid

- 我的spring学习笔记5-如何使用ApplicationContext替换BeanFactory

aijuans

Spring 3 系列

如何使用ApplicationContext替换BeanFactory?

package onlyfun.caterpillar.device;

import org.springframework.beans.factory.BeanFactory;

import org.springframework.beans.factory.xml.XmlBeanFactory;

import

- Linux 内存使用方法详细解析

annan211

linux内存Linux内存解析

来源 http://blog.jobbole.com/45748/

我是一名程序员,那么我在这里以一个程序员的角度来讲解Linux内存的使用。

一提到内存管理,我们头脑中闪出的两个概念,就是虚拟内存,与物理内存。这两个概念主要来自于linux内核的支持。

Linux在内存管理上份为两级,一级是线性区,类似于00c73000-00c88000,对应于虚拟内存,它实际上不占用

- 数据库的单表查询常用命令及使用方法(-)

百合不是茶

oracle函数单表查询

创建数据库;

--建表

create table bloguser(username varchar2(20),userage number(10),usersex char(2));

创建bloguser表,里面有三个字段

&nbs

- 多线程基础知识

bijian1013

java多线程threadjava多线程

一.进程和线程

进程就是一个在内存中独立运行的程序,有自己的地址空间。如正在运行的写字板程序就是一个进程。

“多任务”:指操作系统能同时运行多个进程(程序)。如WINDOWS系统可以同时运行写字板程序、画图程序、WORD、Eclipse等。

线程:是进程内部单一的一个顺序控制流。

线程和进程

a. 每个进程都有独立的

- fastjson简单使用实例

bijian1013

fastjson

一.简介

阿里巴巴fastjson是一个Java语言编写的高性能功能完善的JSON库。它采用一种“假定有序快速匹配”的算法,把JSON Parse的性能提升到极致,是目前Java语言中最快的JSON库;包括“序列化”和“反序列化”两部分,它具备如下特征:

- 【RPC框架Burlap】Spring集成Burlap

bit1129

spring

Burlap和Hessian同属于codehaus的RPC调用框架,但是Burlap已经几年不更新,所以Spring在4.0里已经将Burlap的支持置为Deprecated,所以在选择RPC框架时,不应该考虑Burlap了。

这篇文章还是记录下Burlap的用法吧,主要是复制粘贴了Hessian与Spring集成一文,【RPC框架Hessian四】Hessian与Spring集成

- 【Mahout一】基于Mahout 命令参数含义

bit1129

Mahout

1. mahout seqdirectory

$ mahout seqdirectory

--input (-i) input Path to job input directory(原始文本文件).

--output (-o) output The directory pathna

- linux使用flock文件锁解决脚本重复执行问题

ronin47

linux lock 重复执行

linux的crontab命令,可以定时执行操作,最小周期是每分钟执行一次。关于crontab实现每秒执行可参考我之前的文章《linux crontab 实现每秒执行》现在有个问题,如果设定了任务每分钟执行一次,但有可能一分钟内任务并没有执行完成,这时系统会再执行任务。导致两个相同的任务在执行。

例如:

<?

//

test

.php

- java-74-数组中有一个数字出现的次数超过了数组长度的一半,找出这个数字

bylijinnan

java

public class OcuppyMoreThanHalf {

/**

* Q74 数组中有一个数字出现的次数超过了数组长度的一半,找出这个数字

* two solutions:

* 1.O(n)

* see <beauty of coding>--每次删除两个不同的数字,不改变数组的特性

* 2.O(nlogn)

* 排序。中间

- linux 系统相关命令

candiio

linux

系统参数

cat /proc/cpuinfo cpu相关参数

cat /proc/meminfo 内存相关参数

cat /proc/loadavg 负载情况

性能参数

1)top

M:按内存使用排序

P:按CPU占用排序

1:显示各CPU的使用情况

k:kill进程

o:更多排序规则

回车:刷新数据

2)ulimit

ulimit -a:显示本用户的系统限制参

- [经营与资产]保持独立性和稳定性对于软件开发的重要意义

comsci

软件开发

一个软件的架构从诞生到成熟,中间要经过很多次的修正和改造

如果在这个过程中,外界的其它行业的资本不断的介入这种软件架构的升级过程中

那么软件开发者原有的设计思想和开发路线

- 在CentOS5.5上编译OpenJDK6

Cwind

linuxOpenJDK

几番周折终于在自己的CentOS5.5上编译成功了OpenJDK6,将编译过程和遇到的问题作一简要记录,备查。

0. OpenJDK介绍

OpenJDK是Sun(现Oracle)公司发布的基于GPL许可的Java平台的实现。其优点:

1、它的核心代码与同时期Sun(-> Oracle)的产品版基本上是一样的,血统纯正,不用担心性能问题,也基本上没什么兼容性问题;(代码上最主要的差异是

- java乱码问题

dashuaifu

java乱码问题js中文乱码

swfupload上传文件参数值为中文传递到后台接收中文乱码 在js中用setPostParams({"tag" : encodeURI( document.getElementByIdx_x("filetag").value,"utf-8")});

然后在servlet中String t

- cygwin很多命令显示command not found的解决办法

dcj3sjt126com

cygwin

cygwin很多命令显示command not found的解决办法

修改cygwin.BAT文件如下

@echo off

D:

set CYGWIN=tty notitle glob

set PATH=%PATH%;d:\cygwin\bin;d:\cygwin\sbin;d:\cygwin\usr\bin;d:\cygwin\usr\sbin;d:\cygwin\us

- [介绍]从 Yii 1.1 升级

dcj3sjt126com

PHPyii2

2.0 版框架是完全重写的,在 1.1 和 2.0 两个版本之间存在相当多差异。因此从 1.1 版升级并不像小版本间的跨越那么简单,通过本指南你将会了解两个版本间主要的不同之处。

如果你之前没有用过 Yii 1.1,可以跳过本章,直接从"入门篇"开始读起。

请注意,Yii 2.0 引入了很多本章并没有涉及到的新功能。强烈建议你通读整部权威指南来了解所有新特性。这样有可能会发

- Linux SSH免登录配置总结

eksliang

ssh-keygenLinux SSH免登录认证Linux SSH互信

转载请出自出处:http://eksliang.iteye.com/blog/2187265 一、原理

我们使用ssh-keygen在ServerA上生成私钥跟公钥,将生成的公钥拷贝到远程机器ServerB上后,就可以使用ssh命令无需密码登录到另外一台机器ServerB上。

生成公钥与私钥有两种加密方式,第一种是

- 手势滑动销毁Activity

gundumw100

android

老是效仿ios,做android的真悲催!

有需求:需要手势滑动销毁一个Activity

怎么办尼?自己写?

不用~,网上先问一下百度。

结果:

http://blog.csdn.net/xiaanming/article/details/20934541

首先将你需要的Activity继承SwipeBackActivity,它会在你的布局根目录新增一层SwipeBackLay

- JavaScript变换表格边框颜色

ini

JavaScripthtmlWebhtml5css

效果查看:http://hovertree.com/texiao/js/2.htm代码如下,保存到HTML文件也可以查看效果:

<html>

<head>

<meta charset="utf-8">

<title>表格边框变换颜色代码-何问起</title>

</head>

<body&

- Kafka Rest : Confluent

kane_xie

kafkaRESTconfluent

最近拿到一个kafka rest的需求,但kafka暂时还没有提供rest api(应该是有在开发中,毕竟rest这么火),上网搜了一下,找到一个Confluent Platform,本文简单介绍一下安装。

这里插一句,给大家推荐一个九尾搜索,原名叫谷粉SOSO,不想fanqiang谷歌的可以用这个。以前在外企用谷歌用习惯了,出来之后用度娘搜技术问题,那匹配度简直感人。

环境声明:Ubu

- Calender不是单例

men4661273

单例Calender

在我们使用Calender的时候,使用过Calendar.getInstance()来获取一个日期类的对象,这种方式跟单例的获取方式一样,那么它到底是不是单例呢,如果是单例的话,一个对象修改内容之后,另外一个线程中的数据不久乱套了吗?从试验以及源码中可以得出,Calendar不是单例。

测试:

Calendar c1 =

- 线程内存和主内存之间联系

qifeifei

java thread

1, java多线程共享主内存中变量的时候,一共会经过几个阶段,

lock:将主内存中的变量锁定,为一个线程所独占。

unclock:将lock加的锁定解除,此时其它的线程可以有机会访问此变量。

read:将主内存中的变量值读到工作内存当中。

load:将read读取的值保存到工作内存中的变量副本中。

- schedule和scheduleAtFixedRate

tangqi609567707

javatimerschedule

原文地址:http://blog.csdn.net/weidan1121/article/details/527307

import java.util.Timer;import java.util.TimerTask;import java.util.Date;

/** * @author vincent */public class TimerTest {

- erlang 部署

wudixiaotie

erlang

1.如果在启动节点的时候报这个错 :

{"init terminating in do_boot",{'cannot load',elf_format,get_files}}

则需要在reltool.config中加入

{app, hipe, [{incl_cond, exclude}]},

2.当generate时,遇到:

ERROR