【论文阅读】WWW21 Graph Topic Neural Network for Document Representation

文章目录

- Background

-

- Motivation

- Idea

- Challenges

- Related Paper

- Model

-

- Graph Construction

- Bipartite Graph Message Passing(BGMP)

-

- Intra-domain message propagation(IAMP)

- Inter-domain message passing

- Final hidden representation

- generative story

- Learning

Background

Motivation

- DNN(RNN,CNN,GNN)已经在捕获单词和文档语义上获得了显著成功,但是这些方法的resulting representation解释性很差。

- 统计主题建模已经可以挖掘document的潜在语义结构,生成可解释的主题

- 主题结构可以提供关于document的语义视图

Idea

具有连接的文档应该具有相似的主题。

Challenges

除了41和29,在GNN中集成主题结构的研究还很少。

- 41提出DHTG,使用probabilistic deep topic model来学习主题,在集成了topic node的document-word图上,执行GNN进行document embedding。

- 29提出了GraphSTONE,先挖掘latent topic struture,再将其与GNN结合进行document embedding。

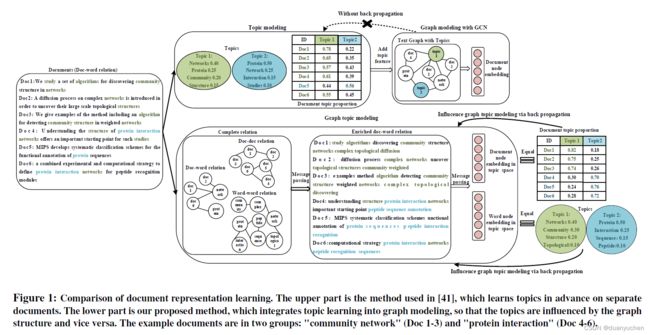

但是这两种方法,latent topics都是提前在document set中提取的,并没有考虑document-word链接和document链接的深层次信息传播。

这样提取到的主题,可能是次优的。

GTNN是inductive的,可以处理训练集中未出现的文档,而其他的一些方法要求测试集的文档再训练时就已经包含在graph中。

为了解决“其他方法为在数据中假设潜在的主体结构,限制了resulting representation的有效性,且不利于interpret”的问题,Wang et al. [41] proposed DHTG to integrate the topic model into the graph construction. It first extracts hierarchical topics to describe the document contents using probabilistic deep topic model. These topics are added into the document-word network, on which GCN is applied to generate node representations. Long et al. [29] proposed GraphSTONE to incorporate the topic model into graph embedding. It first mines the latent topic structure on the graph, and then incorporate the mined topic features with graph neural network for node embedding.

Related Paper

[41]Zhengjue Wang, Chaojie Wang, Hao Zhang, Zhibin Duan, Mingyuan Zhou, and Bo Chen. 2020. Learning Dynamic Hierarchical Topic Graph with Graph Convolutional Network for Document Classification. AISTATS

[29]Qingqing Long, Yilun Jin, Guojie Song, Yi Li, and Wei Lin. 2020. Graph Structural-topic Neural Network. In SIGKDD. 1065–1073.

[27]Ngo Van Linh, Tran Xuan Bach, and Khoat Than. 2020. Graph Convolutional Topic Model for Data Streams. arXiv (2020), arXiv–2003.

[46]Liang Yang, Fan Wu, Junhua Gu, Chuan Wang, Xiaochun Cao, Di Jin, and Yuanfang Guo. 2020. Graph Attention Topic Modeling Network. In WWW. 144–154.

[49]Qile Zhu, Zheng Feng, and Xiaolin Li. 2018. GraphBTM: Graph enhanced autoencoded variational inference for biterm topic model. In EMNLP. 4663–4672.

Model

- 如果独立抽取doc1-3和doc4-6的主题,会发现topic1和topic2混淆了。doc4和doc2很相似,这是因为一些词在不同的document中是shared(directly connected),这样不准确的topic features将会进一步对document node embedding引入噪声。

- 如果我们知道document1-3相连,document4-6相连,就可以将一个document中的信息传递到另外一个document中。同样,通过word之间的联系,一个word的信息也可以传播到与她相关联的word中。

- 这样非直接相连的关系能够增强document description,得到更加清晰连贯的topic

- topic modeling与graph(topic)modeling能够同时动态优化。

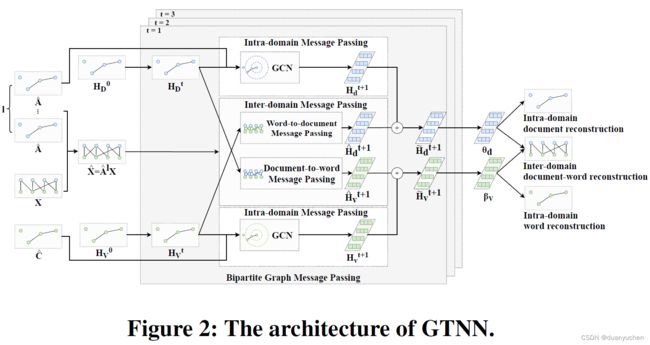

- 提出了GTNN模型,提出了在doc-doc、doc-word、word-word二部图上进行消息传递的BGMP方法,可以捕捉到间接关系并且学习到隐藏表示。

模型的目标是统一主题和图建模,从而在一个潜在的主题空间中提取可解释的低维文档和单词表示

Graph Construction

word-word:两个word的point-wise mutual information(PMI)(正数)

doc-word:word j在document i中的TF-IDF值

Bipartite Graph Message Passing(BGMP)

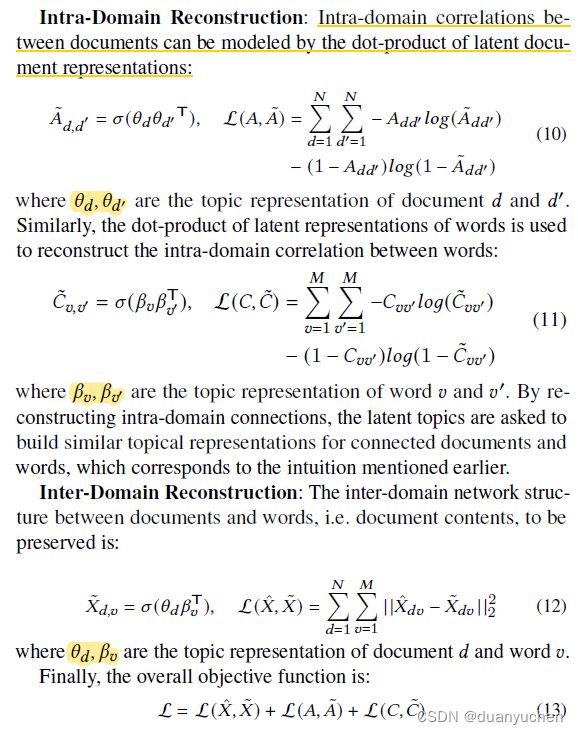

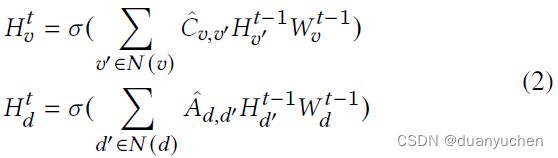

Intra-domain message propagation(IAMP)

在相同性质节点中传播,即文档之间和单词之间,

document和word的隐藏表示:

Inter-domain message passing

探索间接的doc-word、doc-doc、word-word关系

t层的document d和word v的表示分别由t-1层的word-to-doc message passing(WDMP)和doc-to-word message passing(DWMP)来得到的:

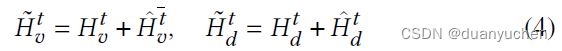

Final hidden representation

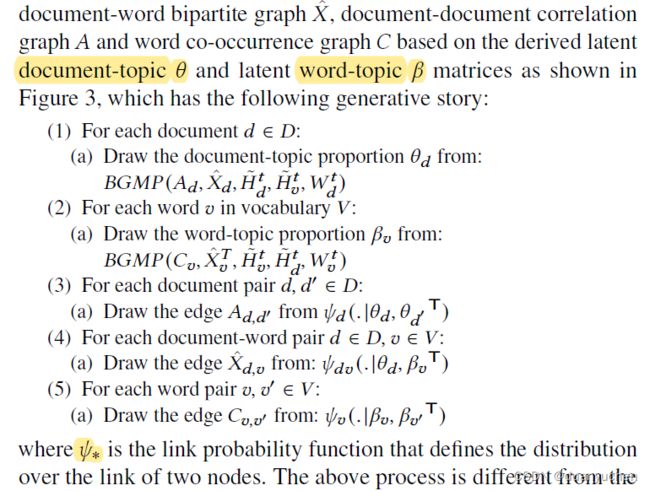

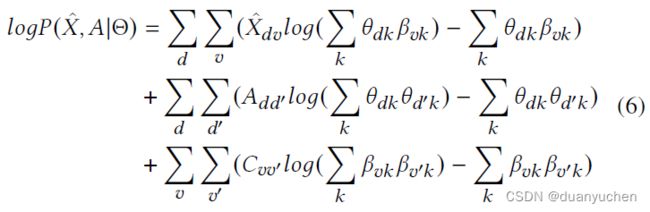

generative story

上述过程可看做基于BGMP的关系主题建模推理。下面进行证明:

与传统关系主题模型类似,假设doc-wod graph X ^ \hat{X} X^,document network A A A和word network C C C都是由Poisson prior distribution生成的。

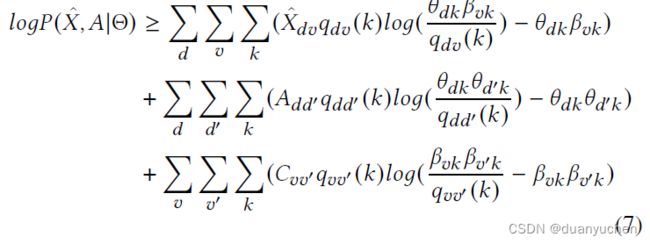

公式6利用杰森不等式可以进一步改写为:

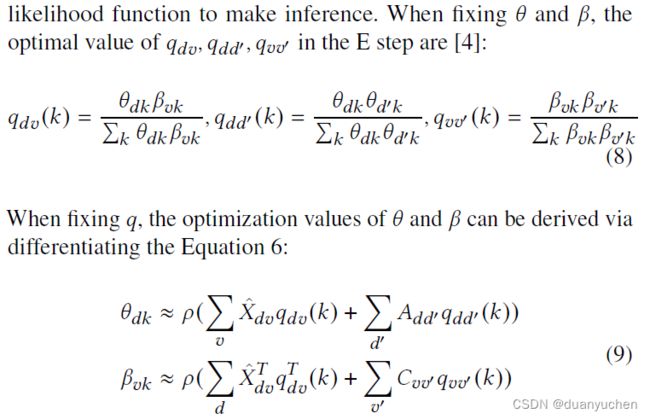

使用EM算法可以用来最大化上述的对数似然函数来进行推理。

可以看到公式9的推断,迭代等价于公式4的BGMP信息传播公式

通过这种比较,GTNN模型可以解释为GCN和BGMP对基于泊松分布的关系主题模型进行的半平摊推理。