16个车辆信息检测数据集收集汇总(简介及链接)

16个车辆信息检测数据集收集汇总(简介及链接)

目录

1. UA-DETRAC

2. BDD100K 自动驾驶数据集

3. 综合汽车(CompCars)数据集

4. Stanford Cars Dataset

5. OpenData V11.0-车辆重识别数据集 VRID

6. N-CARS数据集

7. MIT DriveSeg Dataset

8. KITT

9. CityScapes

10. Comma.ai 's Driving Dataset

11. Udacity 's Driving Dataset

12. D²-City

背景

数据集介绍

评估任务

13. ApolloScape

14. nuScenes

15. 牛津Robotcar数据集

16. Vehicle Image Database

附:交通标志数据集

1. UA-DETRAC

http://detrac-db.rit.albany.edu/

UA-DETRAC是一个具有挑战性的现实世界多目标检测和多目标跟踪基准。数据集由 Cannon EOS 550D摄像头在中国北京和天津24个不同地点拍摄的10个小时的视频组成。视频以每秒25帧的速度录制,分辨率为960540像素。在UA-DETRAC数据集中,有超过14万帧和8250辆车被人工标注,总共标记了121万物体的边界盒。我们还对目标检测和多目标跟踪方面的最新方法进行基准测试,以及本网站中详细介绍的评估指标。

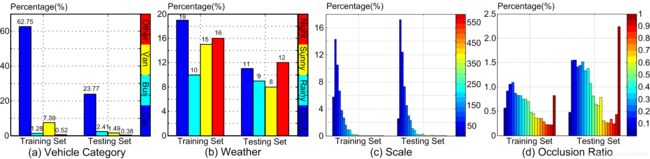

车辆分为四类,即轿车、公共汽车、厢式货车和其他车辆。

天气情况分为四类,即多云、夜间、晴天和雨天。

标注的车辆的尺度定义为其像素面积的平方根。将车辆分为三种规模:小型(0-50像素)、中型(50-150像素)和大型(大于150像素)。遮挡比我们使用车辆包围框被遮挡的比例来定义遮挡的程度。

遮挡程度分为三类: 无遮挡、部分遮挡和重遮挡。具体来说,定义了部分遮挡(如果车辆遮挡率在1%-50%之间)和重遮挡(如果遮挡率大于50%)。

截尾率表示车辆部件在帧外的程度,用于训练样本的选择。

效果图:

2. BDD100K 自动驾驶数据集

https://bdd-data.berkeley.edu/

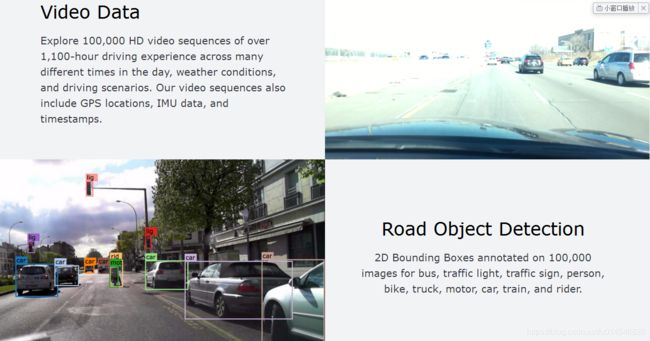

视频数据: 超过1,100小时的100000个高清视频序列在一天中许多不同的时间,天气条件,和驾驶场景驾驶经验。视频序列还包括GPS位置、IMU数据和时间戳。

道路目标检测:2D边框框注释了100,000张图片,用于公交、交通灯、交通标志、人、自行车、卡车、摩托车、小汽车、火车和骑手。

实例分割:超过10,000张具有像素级和丰富实例级注释的不同图像。

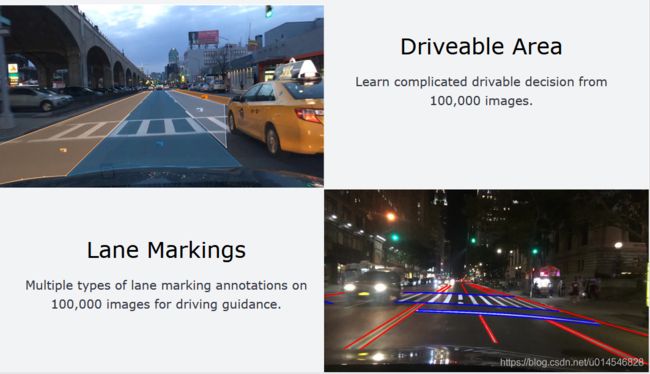

引擎区域:从10万张图片中学习复杂的可驾驶决策。

车道标记:10万张图片上多类型的车道标注,用于引导驾驶。

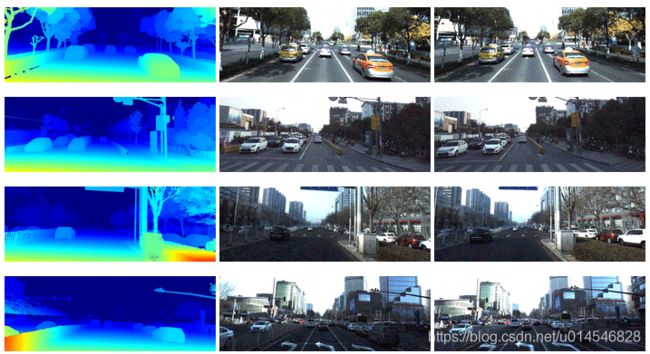

如图:

3. 综合汽车(CompCars)数据集

http://mmlab.ie.cuhk.edu.hk/datasets/comp_cars/index.html

该数据集在 CVPR 2015论文中给出,Linjie Yang, Ping Luo, Chen Change Loy, Xiaoou Tang. A Large-Scale Car Dataset for Fine-Grained Categorization and Verification, In Computer Vision and Pattern Recognition (CVPR), 2015. PDF。

综合汽车(CompCars)数据集包含来自两种场景的数据,包括来自web-nature和监视-nature的图像。

web-nature数据包含163辆汽车和1,716个汽车模型。总共有136,726张图像捕捉整个汽车,27,618张图像捕捉汽车部件。完整的汽车图像被标记为边界框和视点。每个车型都有五个属性,包括最大速度、排水量、车门数量、座椅数量和车型。

监视-自然数据包含了5万张前视图捕捉到的汽车图像。

该数据集已经为以下计算机视觉任务做好了准备:细粒度分类、属性预测、汽车模型验证。

本文中介绍的这些任务的训练/测试子集都包含在数据集中。研究人员也欢迎使用它来完成其他任务,如图像排序、多任务学习和3D重建。

4. Stanford Cars Dataset

http://ai.stanford.edu/~jkrause/cars/car_dataset.html

Cars数据集包含196类汽车的16,185张图像。将数据分成8144张训练图像和8041张测试图像,大致对每个类进行50-50的分割。级别通常按制造、型号、年份划分,例如2012年特斯拉Model S或2012年宝马M3 coupe。

3D Object Representations for Fine-Grained Categorization

Jonathan Krause, Michael Stark, Jia Deng, Li Fei-Fei

4th IEEE Workshop on 3D Representation and Recognition, at ICCV 2013 (3dRR-13). Sydney, Australia. Dec. 8, 2013.

[pdf] [BibTex] [slides]

5. OpenData V11.0-车辆重识别数据集 VRID

http://www.openits.cn/opendata4/748.jhtml

数据集说明:

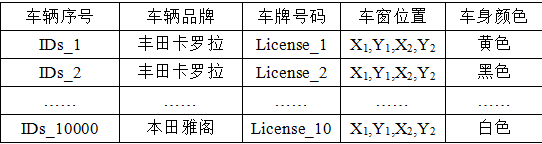

开放的车辆重识别的数据来自某城市卡口车辆图像,由326个高清摄像头拍摄,时间覆盖日间14天,分辨率从400×424到990×1134不等。数据集中包含最常见的10种车辆款式,共10000张图像,如表1所列。为了模拟同款车辆对车辆重识别的影响,每个车辆款式里各有100个不同的车辆ID,即100个不同的车辆。在同一车辆款式里的100个车辆ID,它们的外观近乎相同,差异大部分只在于车窗部分的个性化标识,如年检标志等。此外,每个车辆ID包含有10张图像,这10张图像拍摄于不同的道路卡口,光照、尺度以及姿态均不尽相同,相应的同一车辆也可能会具有不同的外观。

车辆重识别数据集的车辆字段属性如表2所示,其中车辆品牌表示车辆品牌信息,车牌号码用于数据库里同一车辆的关联,车窗位置代表图像里的车窗所在区域的坐标,车身颜色表示的是图像里的车辆颜色信息。这些信息使得数据库不仅能用于车辆重识别研究,也可用于车辆品牌精细识别,车辆颜色识别等研究。

数据集里10种车辆款式

数据库属性示意表

6. N-CARS数据集

https://www.prophesee.ai/dataset-n-cars/

N-CARS数据集是一个用于汽车分类的大型基于事件的真实世界数据集。

它由12,336个汽车样本和11,693个非汽车样本(背景)组成。这些数据是通过安装在一辆汽车挡风玻璃后的ATIS摄像机记录下来的。这些数据是从不同的驾驶过程中提取的。数据集被分割为7940个car和7482个背景训练样本,4396个 car 和4211个背景测试样本。每个示例持续100毫秒。

7. MIT DriveSeg Dataset

https://agelab.mit.edu/driveseg

到目前为止,提供给研究社区的自动驾驶数据主要由静态的、单一的图像组成,这些图像可以通过使用边界框来识别和跟踪道路内和周围的常见物体,比如自行车、行人或交通灯。相比之下,DriveSeg包含了更精确的、像素级的这些常见道路物体的表示,但通过连续视频驾驶场景的镜头。这种类型的全场景分割可以特别有助于识别更多的无定形物体,如道路建设和植被,它们并不总是有这样明确和统一的形状。数据集由两部分组成:

DriveSeg(手动)

一种面向前帧逐帧像素级语义标记数据集,该数据集是从一辆在连续日光下通过拥挤的城市街道行驶的移动车辆中捕获的。

- 技术摘要

视频数据: 2分47秒(5000帧)1080P (1920x1080) 30帧/秒

类定义(12):车辆、行人、道路、人行道、自行车、摩托车、建筑、地形(水平植被)、植被(垂直植被)、杆子、交通灯和交通标志

8. KITT

· 数据集链接:http://www.cvlibs.net/datasets/kitti/

· 论文链接: http://www.webmail.cvlibs.net/publications/Geiger2012CVPR.pdf

精确的地面真相由Velodyne激光扫描仪和GPS定位系统提供。我们的数据集是通过在中型城市卡尔斯鲁厄(Karlsruhe)、乡村地区和高速公路上行驶来获取的。每张图像可看到多达15辆汽车和30个行人。除了以原始格式提供所有数据外,我们还为每个任务提取基准。对于我们的每一个基准,我们也提供了一个评估指标和这个评估网站。初步实验表明,在现有基准中排名靠前的方法,如Middlebury方法,在脱离实验室进入现实世界后,表现低于平均水平。我们的目标是减少这种偏见,并通过向社会提供具有新困难的现实基准来补充现有基准。

9. CityScapes

· 数据集链接:https://www.cityscapes-dataset.com/

· 论文链接:https://arxiv.org/pdf/1604.01685.pdf

提供了一个新的大规模数据集,其中包含了50个不同城市的街道场景中记录的不同的立体视频序列,有5000帧的高质量像素级注释,还有更大的一组2万帧的弱注释。因此,该数据集比以前类似的尝试要大一个数量级。有关注释类的详细资料及注释示例可在此网页查阅。Cityscapes数据集旨在评估用于语义城市场景理解的主要任务的视觉算法的性能:像素级、实例级和全光学语义标记;支持旨在开发大量(弱)注释数据的研究,例如用于训练深度神经网络。

10. Comma.ai 's Driving Dataset

· 数据集链接:https://github.com/commaai/research

· 论文链接:https://arxiv.org/pdf/1608.01230.pdf

目的是低成本的自动驾驶方案,目前是通过手机改装来做自动驾驶,开源的数据包含7小时15分钟分为11段的公路行驶的行车记录仪视频数据,每帧像素为160x320。主要应用方向:图像识别;

11. Udacity 's Driving Dataset

· 数据集链接:https://github.com/udacity/self-driving-car/tree/master/datasets

· 论文链接:未找到

Udacity的自动驾驶数据集,使用Point Grey研究型摄像机拍摄的1920x1200分辨率的图片,采集到的数据分为两个数据集:第一个包括在白天情况下在加利福尼亚州山景城和邻近城市采集的数据,数据集包含9,423帧中超过65,000个标注对象,标注方式结合了机器和人工。标签为:汽车、卡车、行人;第二个数据集与前者大体上相似,除了增加交通信号灯的标注内容,数据集数量上也增加到15,000帧,标注方式完全采用人工。数据集内容除了有车辆拍摄的图像,还包含车辆本身的属性和参数信息,例如经纬度、制动器、油门、转向度、转速。主要应用方向:目标检测,自动驾驶;

12. D²-City

· 数据集链接:https://outreach.didichuxing.com/d2city/

背景

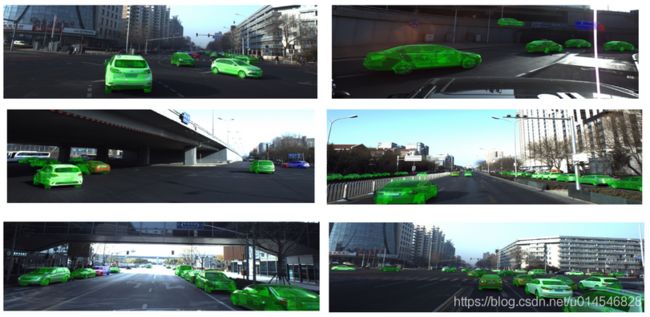

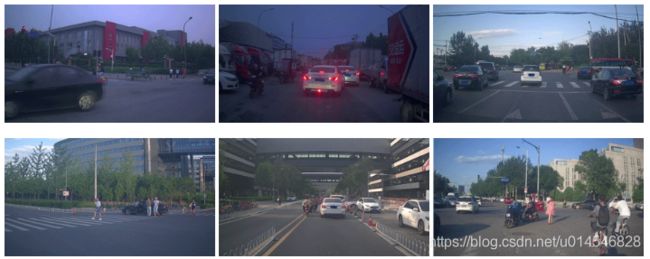

D²-City 是一个大规模行车视频数据集,提供了超过一万段行车记录仪记录的前视视频数据。所有视频均以高清(720P)或超高清(1080P)分辨率录制。我们为其中的约一千段视频提供了包括目标框位置、目标类别和追踪ID信息的逐帧标注,涵盖了共12类行车和道路相关的目标类别。我们为一部分其余的视频提供了关键帧的框标注。

和现有类似数据集相比,D²-City 的数据采集自中国多个城市,涵盖了不同的天气、道路、交通状况,尤其是极复杂和多样性的交通场景。我们希望通过该数据集能够鼓励和帮助自动驾驶相关领域研究取得新进展。

数据集介绍

D²-City 数据集采集自运行在中国五个城市的滴滴运营车辆。所提供的原始数据均存储为帧率25fps、时长30秒的短视频。后续我们将会提供对该数据集的训练、验证和测试集的划分与统计。

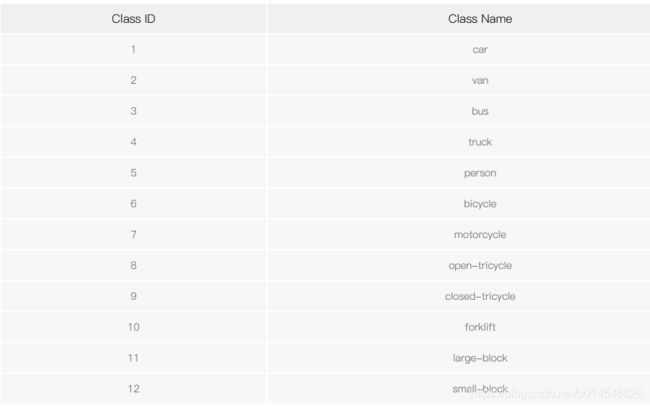

我们为其中约一千段视频提供了12类目标的边界框和追踪ID标注信息,对其他的视频,我们提供关键帧的框标注。类别信息详见下表。

评估任务

基于本数据集,我们将提供一项评估任务(和BDD合作)作为NeurIPS 2019 ML4AD挑战赛的赛事。任务和评估的详情请参见竞赛网站相关页面。

赛事:D²-City & BDD100K 目标检测迁移学习挑战赛 在目标检测迁移学习挑战赛中,参赛者需要利用采集自美国的BDD100K数据,训练目标检测模型用于采集自中国的D²-City数据。数据集中可能包含稀有或有挑战性的状况下采集的数据,如光线不足、雨雾天气、道路拥堵等,参赛者需要提供在各状况下准确的目标检测结果。

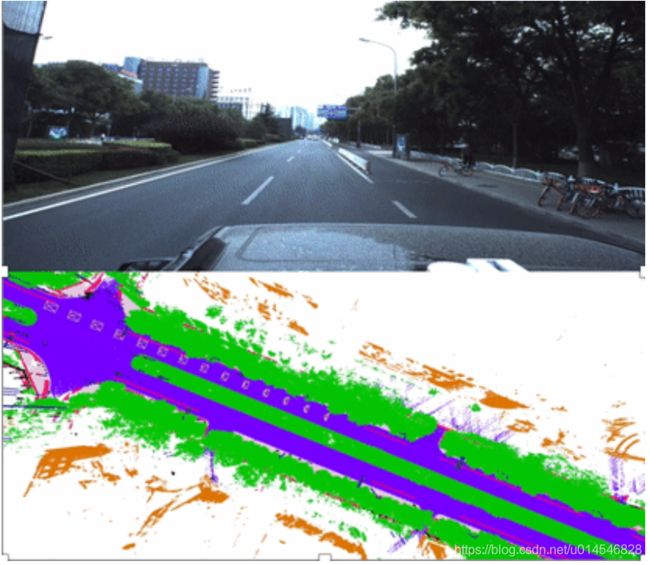

13. ApolloScape

· 数据集链接:http://apolloscape.auto/inpainting.html

关于ApolloScape数据集

轨迹数据集,三维感知激光雷达目标检测和跟踪数据集,包括约100K图像帧,80k激光雷达点云和1000km城市交通轨迹。数据集由不同的条件和交通密度,其中包括许多具有挑战性的场景,车辆,自行车,和行人之间移动。

数据集包括以下几个方面的研究:

Scene Parsing

3D Car Instance

Lane Segmentation

Self Localization

Trajectory

Stereo

Inpainting

14. nuScenes

· 数据集链接:https://www.nuscenes.org/

nuScenes数据集是一个具有3d对象标注的大规模自主驾驶数据集。它特点:

完整的传感器套件(1 x激光雷达、5 x雷达、6 x相机,IMU, GPS)

1000 scenes of 20s each

1400000相机图像

390000激光雷达扫描

两个不同的城市:波士顿和新加坡

左派和右手交通详细的地图信息

1.4M 3D 边界盒手工注释等,23个对象类

属性可见性、活动和姿势

新: 1.1B 激光雷达点手工注释为32类

新: 探索nuScenes在SiaSearch免费使用非商业用途

15. 牛津Robotcar数据集

https://robotcar-dataset.robots.ox.ac.uk/

牛津机器人车数据集包含了超过100次在英国牛津的同一路线的重复,采集时间超过一年。数据集捕捉了天气、交通和行人的许多不同组合,以及建筑和道路工程等长期变化。

16. Vehicle Image Database

http://www.gti.ssr.upm.es/data/Vehicle_database.html?spm=5176.100239.0.0.XGJd1k

图像处理组目前正在研究基于视觉的车辆分类任务。为了评估我们的方法,我们创建了一个新的图像数据库,这些图像是从我们的视频序列中提取的(通过安装在车辆上的向前看的摄像机获取)。该数据库包括3425张从不同角度拍摄的车辆尾部图像,以及3900张从不包含车辆的道路序列中提取的图像。选择图像是为了最大化vehicle类的代表性,这涉及到自然的高可变性。在我们看来,影响车辆后部外观的一个重要特征是车辆相对于摄像机的位置。因此,数据库根据姿态将图像划分为四个不同的区域:镜头前的中/近距离,左侧的中/近距离,右侧的近/中距离,以及远距离。此外,为了使分类器在假设生成阶段对偏移量具有更强的鲁棒性,我们提取的图像不能很好地贴合车辆的轮廓。相反,一些图像松散地包含了车辆(一些背景也包含在图像中),而其他图像只包含部分车辆。对同一运载工具的多个实例分别给出了不同的边界假设。这些图像的分辨率为64x64,是从马德里、布鲁塞尔和都灵的高速公路上记录的360x256像素序列中裁剪出来的。

附:交通标志数据集

1)KUL Belgium Traffic Sign Dataset,比利时的一个交通标志数据集。

2)German Traffic Sign,德国交通标注数据集。

3)STSD,超过20 000张带有20%标签的图像,包含3488个交通标志。

4)LISA,超过6610帧上的7855条标注。

5)Tsinghua-Tencent 100K ,腾讯和清华合作的数据集,100000张图片,包含30000个交通标志实例。