BERT源码解读,详细写记录从零实现BERT模型

目录

1、参数设置

2、数据预处理

3、预训练任务的数据构建部分(非常重要)

mask部分

(***)为什么在max_pred - 实际mask掉的单词数量上补0

4、模型整体架构

损失函数

1、参数设置

if __name__ == '__main__':

# BERT Parameters

maxlen = 30 # 句子的最大长度 cover住95% 不要看平均数 或者99% 直接取最大可以吗?当然也可以,看你自己

batch_size = 6 # 每一组有多少个句子一起送进去模型

max_pred = 5 # max tokens of prediction

n_layers = 6 # number of Encoder of Encoder Layer

n_heads = 12 # number of heads in Multi-Head Attention

d_model = 768 # Embedding Size

d_ff = 3072 # 4*d_model, FeedForward dimension

d_k = d_v = 64 # dimension of K(=Q), V

n_segments = 2

max-pred一个句子中最大可以预测多少个token,控制每个句子最多有多少个单词被masked

因为如果一个句子mask掉3个单词,一个句子mask掉7个单词,就没法组成矩阵。

有的程序没有这个参数,那就是把这个句子中所有的单词全部输入到计算损失的函数中,也就是每个batch都填充过了,全都补齐到一个长度了。

计算损失的时候那些没被maks的单词不去计算就可以了

n-layer由多少个encoder进行堆叠,一般base有12个,large有24个

n_head多少个头

d_ff 前馈神经网络的维度

d_k,d_v 是Q,K维度的大小,两个必须维度一致

n_segment 是二分类任务中,区分多少不同句子

2、数据预处理

text = (

'Hello, how are you? I am Romeo.\n'

'Hello, Romeo My name is Juliet. Nice to meet you.\n'

'Nice meet you too. How are you today?\n'

'Great. My baseball team won the competition.\n'

'Oh Congratulations, Juliet\n'

'Thanks you Romeo'

)

sentences = re.sub("[.,!?\\-]", '', text.lower()).split('\n') # filter '.', ',', '?', '!'

word_list = list(set(" ".join(sentences).split()))

word_dict = {'[PAD]': 0, '[CLS]': 1, '[SEP]': 2, '[MASK]': 3}

for i, w in enumerate(word_list):

word_dict[w] = i + 4

number_dict = {i: w for i, w in enumerate(word_dict)}

vocab_size = len(word_dict)

token_list = list()

for sentence in sentences:

arr = [word_dict[s] for s in sentence.split()]

token_list.append(arr)192行去除原始文本中一些没有用的字符

在定义word list时,0123分别代表特殊字符PAD CLS SEP MASK

文本中的字符从3以后依次取(196行)

把文本转化成数字,便于被计算机处理。

3、预训练任务的数据构建部分(非常重要)

mask部分

# MASK LM

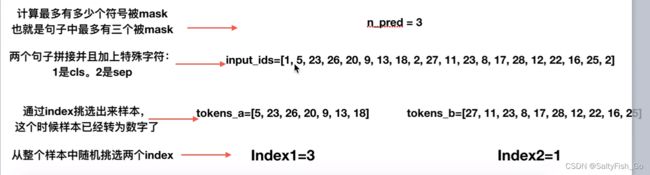

n_pred = min(max_pred, max(1, int(round(len(input_ids) * 0.15)))) # n_pred=3;整个句子的15%的字符可以被mask掉,这里取和max_pred中的最小值,确保每次计算损失的时候没有那么多字符以及信息充足,有15%做控制就够了;其实可以不用加这个,单个句子少了,就要加上足够的训练样本

cand_maked_pos = [i for i, token in enumerate(input_ids)

if token != word_dict['[CLS]'] and token != word_dict['[SEP]']] ## cand_maked_pos=[1, 2, 3, 4, 5, 6, 7, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18];整个句子input_ids中可以被mask的符号必须是非cls和sep符号的,要不然没意义

shuffle(cand_maked_pos)## 打乱顺序:cand_maked_pos=[6, 5, 17, 3, 1, 13, 16, 10, 12, 2, 9, 7, 11, 18, 4, 14, 15] 其实取mask对应的位置有很多方法,这里只是一种使用shuffle的方式

masked_tokens, masked_pos = [], []

for pos in cand_maked_pos[:n_pred]:## 取其中的三个;masked_pos=[6, 5, 17] 注意这里对应的是position信息;masked_tokens=[13, 9, 16] 注意这里是被mask的元素之前对应的原始单字数字;

masked_pos.append(pos)

masked_tokens.append(input_ids[pos])

if random() < 0.8: # 80%

input_ids[pos] = word_dict['[MASK]'] # make mask

elif random() < 0.5: # 10%

index = randint(0, vocab_size - 1) # random index in vocabulary

input_ids[pos] = word_dict[number_dict[index]] # replace

取max_pred和实际mask的单词个数的最小值(超出截取)

cand_maked_pos = [i for i, token in enumerate(input_ids)

if token != word_dict['[CLS]'] and token != word_dict['[SEP]']]## cand_maked_pos=[1, 2, 3, 4, 5, 6, 7, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18];整个句子input_ids中可以被mask的符号必须是非cls和sep符号的,要不然没意义

将cls和sep在数据中去除,不计入数量的计算,不然没有意义。

masked_tokens, masked_pos = [], []

for pos in cand_maked_pos[:n_pred]:## 取其中的三个;masked_pos=[6, 5, 17] 注意这里对应的是position信息;masked_tokens=[13, 9, 16] 注意这里是被mask的元素之前对应的原始单字数字;

masked_pos.append(pos)

masked_tokens.append(input_ids[pos])

取前三个mask字符,并记录mask的字符token和它的位置信息position

现在的tokens=[6,5,17]是指的shuffle之后的tokens的pos(真实标签), mask之后的是预测出来的tokens=[13,9,16],这是mask预测出来的元素之前对应的单字数字。

现在的tokens=[6,5,17]是指的shuffle之后的tokens的pos(真实标签), mask之后的是预测出来的tokens=[13,9,16],这是mask预测出来的元素之前对应的单字数字。

(***)为什么在max_pred - 实际mask掉的单词数量上补0

原因如下:

在计算loss的时候,ignore_index=0,忽略真实标签为0的哪些样本, 补零可以让其他没有被mask的元素不参与计算

4、模型整体架构

和transformer架构基本相同,就是把encoder拎出来

BERT模型整体架构

class BERT(nn.Module):

def __init__(self):

super(BERT, self).__init__()

self.embedding = Embedding() ## 词向量层,构建词表矩阵

self.layers = nn.ModuleList([EncoderLayer() for _ in range(n_layers)]) ## 把N个encoder堆叠起来,具体encoder实现一会看

self.fc = nn.Linear(d_model, d_model) ## 前馈神经网络-cls

self.activ1 = nn.Tanh() ## 激活函数-cls

self.linear = nn.Linear(d_model, d_model)#-mlm

self.activ2 = gelu ## 激活函数--mlm

self.norm = nn.LayerNorm(d_model)

self.classifier = nn.Linear(d_model, 2)## cls 这是一个分类层,维度是从d_model到2,对应我们架构图中就是这种:

# decoder is shared with embedding layer

embed_weight = self.embedding.tok_embed.weight

n_vocab, n_dim = embed_weight.size()

self.decoder = nn.Linear(n_dim, n_vocab, bias=False)

self.decoder.weight = embed_weight

self.decoder_bias = nn.Parameter(torch.zeros(n_vocab))

def forward(self, input_ids, segment_ids, masked_pos):

output = self.embedding(input_ids, segment_ids)## 生成input_ids对应的embdding;和segment_ids对应的embedding

enc_self_attn_mask = get_attn_pad_mask(input_ids, input_ids)

for layer in self.layers:

output, enc_self_attn = layer(output, enc_self_attn_mask)

# output : [batch_size, len, d_model], attn : [batch_size, n_heads, d_mode, d_model]

# it will be decided by first token(CLS)

h_pooled = self.activ1(self.fc(output[:, 0])) # [batch_size, d_model]

logits_clsf = self.classifier(h_pooled) # [batch_size, 2]

masked_pos = masked_pos[:, :, None].expand(-1, -1, output.size(-1)) # [batch_size, max_pred, d_model] 其中一个 masked_pos= [6, 5, 17,0,0]

# get masked position from final output of transformer.

h_masked = torch.gather(output, 1, masked_pos) # masking position [batch_size, max_pred, d_model]

h_masked = self.norm(self.activ2(self.linear(h_masked)))

logits_lm = self.decoder(h_masked) + self.decoder_bias # [batch_size, max_pred, n_vocab]

return logits_lm, logits_clsf需要注意的是:

masked_pos = masked_pos[:, :, None].expand(-1, -1, output.size(-1)) # [batch_size, max_pred, d_model] 其中一个 masked_pos= [6, 5, 17,0,0]

# get masked position from final output of transformer.

h_masked = torch.gather(output, 1, masked_pos) # masking position [batch_size, max_pred, d_model]

h_masked = self.norm(self.activ2(self.linear(h_masked)))

logits_lm = self.decoder(h_masked) + self.decoder_bias # [batch_size, max_pred, n_vocab]mask_pos是得到一个句子中哪些单词被mask掉了,例子中就是6,5,17,0,0

然后取出来给h_masked,过一个Linear,激活函数,过layernorm

最后解码到词表大小

损失函数

model = BERT()

criterion = nn.CrossEntropyLoss(ignore_index=0)

optimizer = optim.Adam(model.parameters(), lr=0.001)

for epoch in range(100):

optimizer.zero_grad()

logits_lm, logits_clsf = model(input_ids, segment_ids, masked_pos)## logits_lm 【6,5,29】 bs*max_pred*voca logits_clsf:[6*2]

loss_lm = criterion(logits_lm.transpose(1, 2), masked_tokens) # for masked LM ;masked_tokens [6,5]

loss_lm = (loss_lm.float()).mean()

loss_clsf = criterion(logits_clsf, isNext) # for sentence classification

loss = loss_lm + loss_clsf

if (epoch + 1) % 10 == 0:

print('Epoch:', '%04d' % (epoch + 1), 'cost =', '{:.6f}'.format(loss))

loss.backward()

optimizer.step()criterion = nn.CrossEntropyLoss(ignore_index=0)保证没有被masked的词汇没有被计算损失

loss_lm这里计算的损失是把15%的masked的单词都计算了损失(不只是80%真正mask,也包括10%随机替换的和10%没有替换的)

BERT代码(源码)从零解读【Pytorch-手把手教你从零实现一个BERT源码模型】_哔哩哔哩_bilibili

讲解视频如上,记录是为自己更好的学习的笔记和方便后面复习。