Hadoop 和 Spark 知识点整理汇总

文章目录

- 前言

- 一、LINUX 系统常用命令汇总

- 二、Hadoop 常用命令汇总

- 三、Hadoop 基本概念

-

- 1. Hadoop 特性

- 2. Hadoop 架构

-

- 2.1 Hadoop 集群

- 2.2 HDFS

- 2.3. YARN

- 四、Hadoop HDFS命令

-

- 1. HDFS 命令通用格式

- 2. 创建与查看 HDFS 目录

- 3. HDFS 与本地计算机之间的文件复制

- 4. 复制与删除 HDFS文件

- 5. 在Hadoop HDFS Web 用户界面浏览 HDFS

- 五、Hadoop MapReduce

-

- 1. MapReduce 介绍

- 2. MapReduce 原理

- 3. MapReduce 集群上的实现

- 4. 不止一个MapReduce:作业链

- 六、Hadoop Streaming

-

- 1. Hadoop Streaming 介绍

- 2. Hadoop Streaming 工作原理

- 3. Hadoop Streaming 执行

- 4. Python 的 MapReduce 框架

- 5. MapReduce 高级工具

- 七、Spark 内存计算

-

- 1. 为什么需要 Spark?

- 2. Spark 基础

-

- Spark 栈

- RDD

- 使用RDD编程

- 3. Spark 执行机制

- 4. 基于 PySpark 的交互性 Spark

- 5. Spark 应用程序模版

- 6. 总结

- 八、分布式分析和模式

-

- 1. 前言

- 2. 键计算

-

- 复合键

- 键空间模式

- pair 与 stripe

- 3. 设计模式

-

- 概要

- 索引

- 过滤

- 4.迈向最后一英里分析

-

- 模型拟合

- 模型验证

- 九、数据挖掘和数据仓储

-

- 1. Hive 结构化数据查询

-

- Hive命令行接口(CLI)

- Hive查询语言

- Hive数据分析

- 2. HBase

-

- NoSQL与列式数据库

- HBase实时分析

- 十、数据采集

-

- 1. 使用Sqoop导入关系数据

-

- 从MySQL导入HDFS

- 从MySQL导入Hive

- 从MySQL导入HBase

- 2. 使用Flume获取流式数据

-

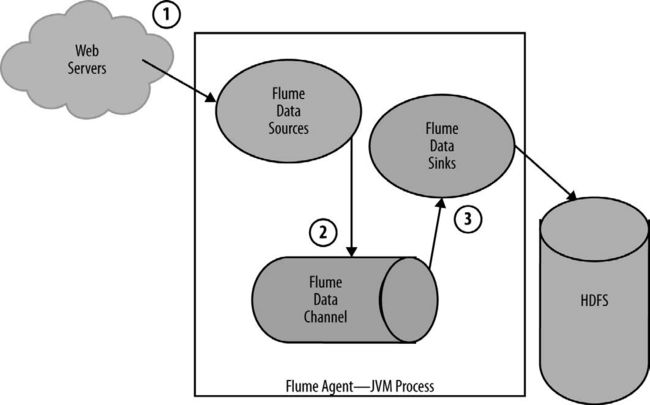

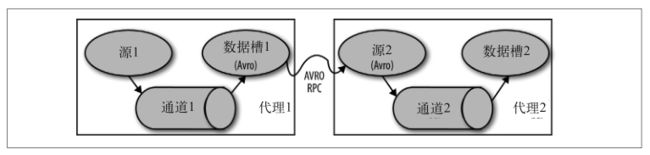

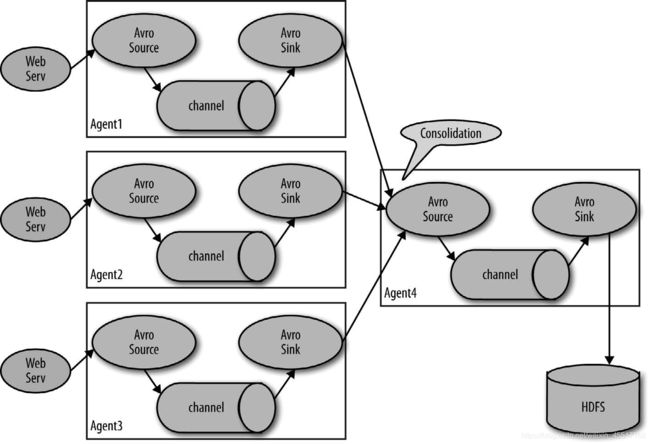

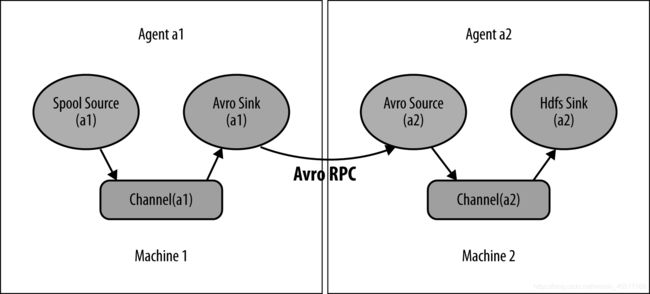

- Flume数据流

- 使用Flume获取产品印象数据

- 十一、使用高级API进行分析

-

- 1. Pig

-

- Pig Latin

- 数据类型

- 关系运算符

- 用户定义函数

- 2. Spark高级API

-

- Spark SQL

- DataFrame

- 3. 总结

- 十二、机器学习

-

- 1. 使用Spark进行可扩展的机器学习

- 2. 协同过滤

- 3. 分类

- 3. 聚类

- 十三、总结:分布式数据科学实战

-

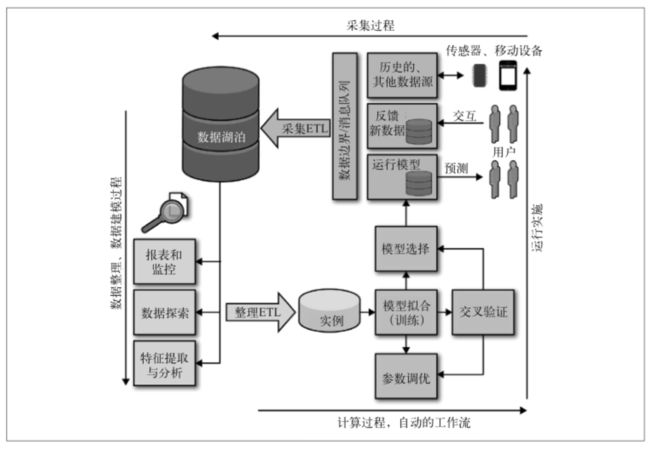

- 1. 数据产品生命周期

-

- 数据湖泊

- 数据采集

- 计算数据存储

- 2. 机器学习生命周期

- 3. 总结

前言

2020年9月至11月,我通过一本理论书简单地学习了 Hadoop 和 Spark 的基本知识,大体上了解了 Hadoop 和 Spark 的一些底层工作机制、基本原理和实用工具等。之后,我又根据另一本实践书学习了 Hadoop 和 Spark 中像是伪分布式环境搭建、集群部署等实践性内容,跑了几个 demo。

但是,随着转而去学其他的知识,关于 Hadoop 和 Spark 的相关内容逐渐被我遗忘。因此,为了避免这两部分内容被我彻底抛弃,同时为了将来找工作时能够回忆起相关知识点,我打算用这篇博客来记录我所学习到的 Hadoop 和 Spark 的重要知识点。

一、LINUX 系统常用命令汇总

这一部分将学习过程中常见的 LINUX 系统命令行命令进行汇总。

| 命令 | 含义 |

|---|---|

| cd <路径> | 切换到目标路径 |

| chomd <权限> <文件> | 控制文件的权限 +:增加权限;-:取消权限 r 读 w 写 x 执行 |

| cp < src > < dst > | 复制文件 |

| echo <内容> | 输出内容到标准输出 |

| ll <目录名称> | 列出来指定目录下的详细结果,包括时间、是否可读写等信息 |

| ls <目录名称> | 列出来指定目录下的简略结果,只列出文件名或者目录名 |

| mkdir <目录名称> | 创建目录 |

| mv < src > < dst > | 移动(剪切)文件 |

| rm <文件名称> | 删除文件 |

| sudo <命令> | 对命令赋予管理员权限 |

| 竖杠 | pipe管道 |

二、Hadoop 常用命令汇总

这一部分将学习过程中常见的 Hadoop 操作系统常见命令进行汇总。

| 命令 | 含义 |

|---|---|

| hadoop fs -命令 | HDFS命令的通用格式 |

| hadoop fs -help | 查看 fs 命令下可用的命令 |

| hadoop fs -mkdir <目录名称> | 创建 HDFS 目录 |

| hadoop fs -mkdir -p <多级目录名称> | 创建 HDFS 多级目录 |

| hadoop fs -ls <目录名称> | 列出指定 HDFS 目录下的文件 如果未指定目录名称,则显示 “/user/登录用户” 下的目录 |

| hadoop fs –chmod/-chgrp/-chown <8进制数> <文件或目录名称> | 更改分布式文件系统上文件的其他用户、组和所有者的 rwx 权限 |

| hadoop fs -copyFromLocal < src > < dst > hadoop fs -put < src > < dst > |

复制本地(local)文件到 HDFS |

| hadoop fs -moveFromLocal < src > < dst > | 剪切本地(local)文件到 HDFS |

| hadoop fs -cat <文件名称> | 读取HDFS目录下的文件内容 |

| hadoop fs –tail <文件名称> | 仅检查文件的最后 1000 字节 |

| hadoop fs -copyToLocal < src > < dst > hadoop fs -get < src > < dst > |

将 HDFS 上的文件复制到本地(local) |

| hadoop fs -moveToLocal < src > < dst > | 将 HDFS 上的文件剪切到本地(local) |

| hadoop fs -cp < src > < dst > | 复制 HDFS 文件到 HDFS 另一文件 |

| hadoop fs -mv < src > < dst > | 移动(剪切) HDFS 文件到 HDFS 另一文件 |

| hadoop fs -rm <文件名称> | 删除 HDFS 文件 |

| hadoop fs -rm -R <目录名称> | 删除 HDFS 目录 |

三、Hadoop 基本概念

1. Hadoop 特性

| 特性 | 含义 |

|---|---|

| 容错性 | 如果一个组件失败,不应导致整个系统出现故障,系统应能降级到较低性能状态。 如果失败的组件恢复了,它应该能够重新加入系统。 |

| 可恢复性 | 发生故障时,不应丢失数据。 |

| 一致性 | 一个作业或任务的失败不应该影响最终的结果。 |

| 可扩展性 | 负载的增加(更多的数据或更多的计算)导致性能下降,而不是出现故障; 资源的增加应使容量按比例增加。 |

2. Hadoop 架构

Hadoop 由两个主要组件组成:HDFS 和 YARN,它们实现了分布式存储和分布式计算。HDFS(Hadoop Distributed File System)是 Hadoop 的分布式文件系统,负责管理存储在集群中磁盘上的数据;YARN(Yet Another Resource Negotiator) 则是集群资源管理器,将计算资源(worker 节点上的处理能力和内存)分配给希望执行分布式计算的应用程序。架构栈如下图所示。

2.1 Hadoop 集群

Hadoop 是一个以协调方式运行的机器集群,然而,Hadoop 其实是运行在集群上的软件的名称,即 HDFS 和 YARN,它们由在一组计算机上运行的 6 种后台服务组成。

所谓集群,就是运行 HDFS 和 YARN 的一组计算机,每台计算机被称为一个节点。集群可以有一个节点,也可以有成千上万个节点,但是所有集群都是水平扩展的,这意味着在添加更多节点时,集群以线性方式提升容量和性能。Hadoop 中的节点主要分为两类:

| 节点类型 | 功能 |

|---|---|

| master 节点 | 这些节点为 Hadoop 的 worker 节点提供协调服务,通常是用户访问集群的入口点。 没有master 节点,协调就不复存在,也就不可能进行分布式存储或计算。 |

| worker 节点 | worker 节点运行的服务从 master 节点接受任务——存储或检索数据、运行特定应用程序。 worker 节点通过并行分析运行分布式计算。 |

HDFS 和 YARN 都有多个 master 服务,负责协调运行在各个 worker 节点上的 worker 服务。worker 节点实现 HDFS 和 YARN 的 worker 服务。HDFS 的 master 服务和 worker 服务如下所示:

| HDFS 服务名称 | 功能 |

|---|---|

| NameNode(master 服务) | 用于存储文件系统的目录树、文件元数据和集群中每个文件的位置。 如果客户端想访问 HDFS,必须先通过从 NameNode 请求信息来查找相应的存储节点。 |

| Secondary NameNode(master 服务) | 代表 NameNode 执行内务任务并记录检查点。 虽然它叫这个名字,但它并不是 NameNode 的备份。 |

| DataNode(worker 服务) | 用于存储和管理本地磁盘上的 HDFS 块,将各个数据存储的健康状况和状态报告给 NameNode。 |

从宏观上看,当从 HDFS 访问数据时,客户端应用程序必须先向 NameNode 发出请求,以在磁盘上定位数据。NameNode 将回复一个存储数据的 DataNode 列表,客户端必须直接从 DataNode 请求每个数据块。注意,NameNode 不存储数据,也不将数据从 DataNode 传递到客户端,而是像交警指挥交通一般,将客户端指向正确的 DataNode。请注意,在较大的集群中,NameNode 和 Secondary NameNode 将驻留在不同的计算机上,从而避免竞争资源。

和 HDFS 类似,YARN 也有两个 master 服务和一个 worker 服务,如下所示:

| YARN 服务名称 | 功能 |

|---|---|

| ResourceManager (master 服务) |

为应用程序分配和监视可用的集群资源(如内存和处理器核心这样的物理资源),处理集群上作业的调度。 |

| ApplicationMaster (master 服务) |

根据 ResourceManager 的调度,协调在集群上运行的特定应用程序。 |

| NodeManager (worker 服务) |

在单个节点上运行和管理处理任务,报告任务运行时的健康状况和状态。 |

与 HDFS 的工作方式类似,如果客户端希望执行作业,就必须先向 ResourceManager 请求资源,ResourceManager 会分配一个应用程序专用的 ApplicationMaster,它在作业的执行过程中会一直存在。ApplicationMaster 跟踪作业的执行,ResourceManager 则跟踪节点的状态,每个 NodeManager 创建容器并在其中执行任务。

2.2 HDFS

HDFS 被设计用于存储非常大的文件,使用流访问数据,有一些注意事项:

- 与占用相同容量的数以亿计的小文件相比,HDFS 更适合处理数量适中但非常大的文件;

- HDFS 采用 WORM 模式,即写一次读多次(write once, read many),它不允许随机写入或追加到文件;

- HDFS 针对文件的大型流式读取进行了优化,不采用随机读取或随机选择。

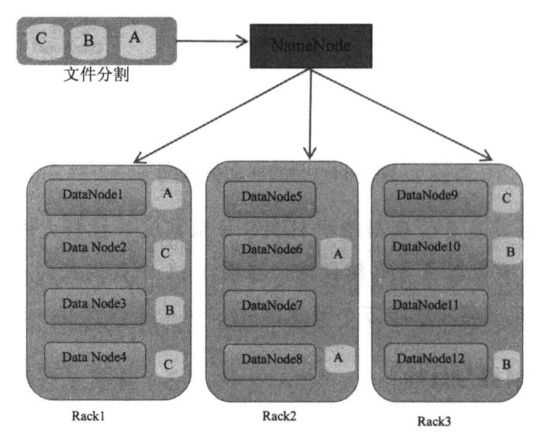

①文件块

HDFS 文件分为多个块,块大小是可以在 HDFS 中读取或写入的最小数据量,小于块大小的文件不占用实际文件系统上一个完整块的空间。为了实现最佳性能,Hadoop 更喜欢分解成小块的大文件,能将许多较小的文件合并成一个大文件就很好。

块将跨 DataNode 复制。默认情况下,块将复制三份,但也可在运行时配置。因此,每个块都将分布在三台计算机和三块磁盘上。即使两个节点都发生了故障,数据也不会丢失。请注意,这意味着集群中的潜在数据存储容量仅为可用磁盘空间的三分之一。

②数据管理

主 NameNode 记录组成文件的块和这些块所在的位置。NameNode 与 DataNode(集群中实际保存块的进程)进行通信。与每个文件相关联的元数据被存储在 NameNode 的 master 节点的内存中,以便进行快速查找。如果 NameNode 停止或发生故障,整个集群都将无法访问。

Secondary NameNode 不是 NameNode 的备份,而是代表 NameNode 执行内务任务。

当客户端应用程序想要读取文件时,它首先从 NameNode 请求元数据,以定位组成文件的块以及存储块的 DataNode 的位置。然后,应用程序直接与 DataNode 通信以读取数据。因此,NameNode 仅仅扮演着日志或查找表的角色,而不是同时读取的瓶颈。

2.3. YARN

YARN 将工作负载管理与资源管理分离,以便多个应用程序可以共享一个集中的公共资源管理服务。通过在 YARN 中提供通用的作业和资源管理能力,Hadoop 不再是一个仅仅专注于 MapReduce 的框架,而成为了一个完整、多应用程序的大数据操作系统。

YARN 的架构图如下图所示,从图中我们可以看出:

- 在 Client 客户端,用户向 ResourceManager 请求执行运算(或执行任务)。

- 在 NameNode 会有 ResourceManager 统筹管理运算的请求。

- 在其他的 DataNode 会有 NodeManager 负责运行,以及监督每一个任务,并且向 ResourceManager 汇报状态。

四、Hadoop HDFS命令

1. HDFS 命令通用格式

利用终端 HDFS 命令对 HDFS 进行操作的示意图如下图所示。

HDFS 通用的命令格式如下:

hadoop fs -命令

用户可以进行所有常规的文件系统操作,例如创建目录,移动、删除和复制文件,列出目录内容,修改集群上文件的权限。要查看 fs 命令下可用的命令,键入:

hadoop fs -help

2. 创建与查看 HDFS 目录

①创建目录

在“终端”程序中输入下列命令,创建HDFS目录:

hadoop fs -mkdir <目录名称>

如果我们要一次性创建多级目录,除了利用上述命令一级一级创建以外,还可以加入参数“-p”:

hadoop fs -mkdir -p <多级目录名称>

②查看目录

在“终端”程序中输入下列命令,查看之前创建的 HDFS 目录

hadoop fs -ls

假设当前登录的用户是 hduser,那么上述命令会显示 “/user/hduser” 下的目录。我们也可以列出指定 HDFS 目录下的文件:

hadoop fs -ls <目录名称>

注意:

- linux 系统中有 ll 和 ls 命令都可以用来查看目录下的内容,但是 HDFS 只有 -ls 命令,没有 -ll 命令一说。

- hadoop fs -ls 命令只能查看一级目录,但是我们可以在该命令上加上 -R 参数(R 代表 recursive(递归))来一次查看所有子目录。

- hadoop fs -ls / 用来查看HDFS根目录

- 可以使用模糊查询,例如 “hadoop fs -ls *.tsv” 来列出目录下文件名相匹配的相关文件

假设显示结果如下图所示:

![]()

上述结果中,第 1 列显示文件的权限模式,第 2 列是文件的副本数(默认情况下,副本数为 3)。请注意,目录不会被复制,因此本例中的此列是短横线( - )。其后依次是用户、组、以字节为单位的文件大小(目录为零)、最后一次修改的日期和时间,以及文件名。

③HDFS 文件权限

权限分三种类型:读(r)、写(w)和执行(x)。这些权限定义了所有者、组和任何其他系统用户的访问级别。对于目录来说,执行权限允许访问目录的内容,但是 HDFS 上文件的执行权限被忽略了。在 HDFS 中,读写权限指定谁可以访问数据,以及谁可以追加文件内容。

每个模式有 10 个槽位。第 1 个槽位是 d ,表示“是目录,否则是文件( - )”。接下来的槽位每 3 个为一组,分别表示所有者、组和其他用户的 rwx 权限。有几个 HDFS 的 shell 命令能管理文件和目录的权限,即我们熟悉的 chmod 、chgrp 和 chown 命令。例如:

hadoop fs –chmod 664 shakespeare.txt

上述 chmod 命令将 shakespeare.txt 的权限更改为 -rw-rw-r-- 。664 是为权限三元组设置的标志的八进制表示。6 的二进制数为 110,这意味着设置了读和写的标志,但没有设置执行标志;完全允许是 7,即二进制数 111;只读是 4,即二进制数 100。 chgrp 和 chown 命令分别更改分布式文件系统上文件的组和所有者。

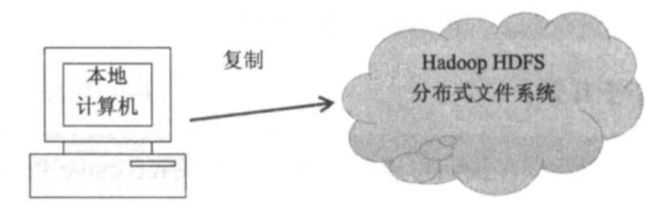

3. HDFS 与本地计算机之间的文件复制

① 从本地计算机复制文件到HDFS

使用下列两个命令均能实现复制本地(local)文件到 HDFS:

hadoop fs -copyFromLocal <从哪复制src> <复制到哪里dst>

hadoop fs -put <从哪复制src> <复制到哪里dst>

整个过程为:copyFromLocal 命令在当前工作目录中搜索要复制的文件,从 NameNode 请求有关该路径的信息,然后直接与 DataNode 通信以传送文件,将其复制到 HDFS 上的目标路径。

注意:

- 复制但不删除本地副本,与复制相对的剪切功能 moveFromLocal 会将本地副本删除。

- 在本地计算机以及远程 HDFS 系统上,都必须考虑相对路径和绝对路径。如果未指定存放位置,那么将直接复制在 “user/当前登录用户/” 目录下。

- < dst >可以仅指定目录,也可以在复制时顺便对文件重命名。

- 使用 copyFromLocal 命令时,如果文件已经存在,系统会回复“File exists”不会复制。但是可以加入 -f(force)选项强制复制并覆盖文件。

- 允许一次复制多个本地文件至HDFS目录,< src >包含多个用空格隔开的文件即可。

- 允许从本地计算机复制整个目录到 HDFS 目录。

- 一定要注意后面加不加 “/”,决定了是复制到当前目录还是当前目录下的同名目录。

put 命令与 copyFromLocal 命令的区别主要有两个:

- 如果文件已经存在,使用 put 命令时系统不会显示文件已经存在,而会直接覆盖;

- put 命令可以接受stdin(标准输入),例如:

- echo abc | hadoop fs -put - /user/hduser/test/echoin.txt

- ls /usr/local/hadoop | hadoop fs -put -/user/duser/test/hadooplist.txt

②读取文件内容

如需读取文件的内容,可使用 cat 命令:

hadoop fs –cat <文件名称>

上述命令会一次列出所有文件内容,如果文件太大,可以加上“| more”或者“| less”,将输出通过管道传递给 more 或者 less 以查看远程文件的内容,命令如下:

hadoop fs –cat <文件名称> | less(或者 | more)

注意:

- more 和 less 均为对文件或其它输出进行分页显示的工具:使用 more 时没有办法向前面翻,只能往后面看;但如果使用了 less,就可以往前往后翻看文件。

还可以使用 tail 命令仅检查文件的最后 1000 字节:

hadoop fs –tail <文件名称>

注意:

- 没有类似 hadoop fs -head 的命令可以用来检查文件的前 1000 字节。不过,可以使用 hadoop fs -cat 并通过管道将文件内容传输到本地 shell 的 head 命令。这种做法很高效,因为 head 命令在读取整个文件之前就终止了远程流。但是以这种方式使用 shell 的 tail 会降低效率,因为在计算输出之前,所有数据都必须从远程文件系统流式传输到本地文件系统。相反, hadoop fs -tail 命令在远程文件中寻址到正确位置,仅通过网络返回所需的数据。

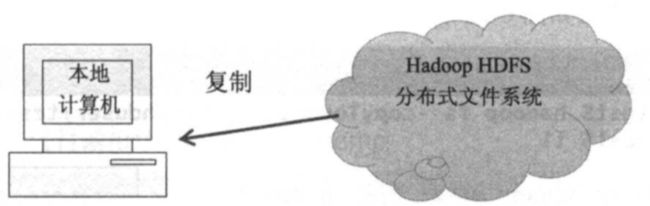

③将 HDFS上的文件复制到本地计算机

使用下列两个命令均能实现复制 HDFS上的文件到本地计算机:

hadoop fs -copyToLocal <从 hdfs 的哪复制src> <复制到本地的哪dst>

hadoop fs -get <从 hdfs 的哪复制src> <复制到本地的哪dst>

注意:

- dst 可以省略,表示将文件或者目录直接复制到当前目录下.

- 复制但不删除 hdfs 副本,与复制相对的剪切功能 moveToLocal 会将该文件从分布式文件系统中删除。

- get merge 命令复制符合给定模式或指定目录下的所有文件,并将其合并成

本机的单个文件。 - 如果远程系统上的文件较大,可以在管道传输的时候使用压缩工具,原始文件与 压缩后的文件相同,例如:

- hadoop fs –get shakespeare.txt ./shakespeare.from-remote.txt

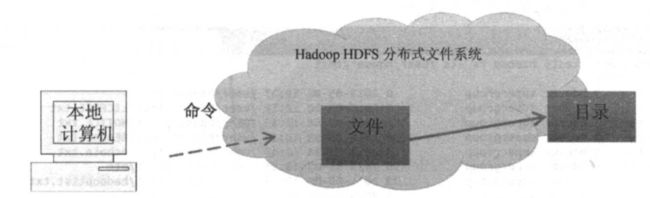

4. 复制与删除 HDFS文件

复制HDFS文件,指的是在 HDFS 中复制文件或目录到另一个 HDFS 目录。命令如下:

hadoop fs -cp < src > < dst >

同样,有复制命令就有剪切命令:

hadoop fs -mv < src > < dst >

删除 HDFS 文件的命令如下:

hadoop fs -rm <文件名称>

删除 HDFS 目录及其包含的所有文件的命令如下:

hadoop fs -rm -R <目录名称>

5. 在Hadoop HDFS Web 用户界面浏览 HDFS

我们可以在 Hadoop HDFS web用户界面来浏览 HDFS 目录或文件,网址是——http://master:50070

ResourceManager 也提供了一个 Web 接口来查看作业的状态及日志文件。可以通过托管 ResourceManager 服务的机器的 8088 端口访问 ResourceManager 的 Web UI,此 Web UI 显示所有当前正在运行的作业,以及集群中 NodeManager 的状态。

五、Hadoop MapReduce

1. MapReduce 介绍

当提到 MapReduce 时,通常指的是分布式编程模型。MapReduce 是一个简单但功能强大的计算框架,专门用于在集中管理的机器集群上进行容错的分布式计算。简单来说,Map 就是分配工作,Reduce就是将工作结果汇总整理。

- Map 将任务分割成更小任务,由每台服务器分别运行。

- Reduce将所有服务器的运算结果汇总整理,返回最后的结果。

通过 MapReduce 方式,可以在上千台机器上并行处理巨量的数据,大大减少数据处理的时间。

2. MapReduce 原理

负责分发任务和聚合结果的两类函数分别被称为 map 和 reduce 。这些函数运算的输入和输出数据不是简单的列表或值的集合,MapReduce 其实是利用键值对来协调计算。Python 中 map 和 reduce 函数的伪代码如下所示:

def map(key, value):

# 执行处理

return (intermed_key, intermed_value)

def reduce(intermed_key, values):

# 执行处理

return (key, output)

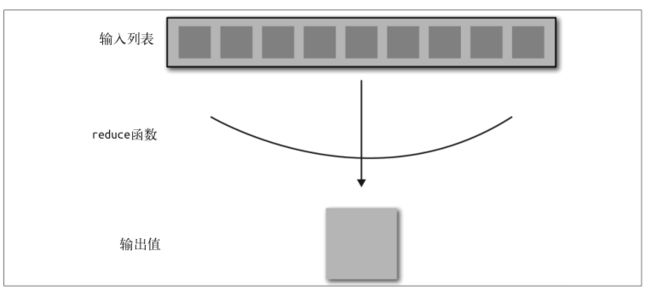

map 函数以一系列键值对作为输入,然后在每个键值对上进行单独运算。在对输入数据执行了一些分析或变换之后, map 函数输出零个或多个键值对,在以上伪代码中表示为单个元组。整个过程将 map 函数应用于输入列表以创建新的输出列表,如下图所示:

通常来讲,map 操作将进行核心分析或处理,因为这个函数能查看数据集中的每个元素。因此我们能在 map 中实现过滤器:测试每个键值对,确定它是否属于最终数据集;如果是则发出,否则就忽略。在 map 阶段之后,所有发出的键值对将按照键来分组,然后根据键被用于各个 reduce 函数的输入。如下图所示,reduce 函数以一个键和一个值列表作为输入,通常通过聚合操作在整个值列表上进行运算,输出零个或多个键值对。

如伪代码所示, reduce 函数是一个有两个参数的函数:一个键(在伪代码中是 intermed_key),以及与之相关联的迭代器或值列表(values)。reducer 对值列表执行最终处理,通常是组合或聚合,然后输出零个或多个键值对。reducer 旨在聚合从 map 阶段输出的大量值,以便将大量数据转换为更小、更易于管理的概要数据。

3. MapReduce 集群上的实现

因为 mapper 对任意列表的每个元素应用相同的函数,所以非常适合被分发到集群的节点上。每个节点获得一个 mapper 操作的副本,并且将 mapper 应用于存储在本地 HDFS 数据节点的数据块中的键值对上。

reducer 需要根据键获取 mapper 的输出作为输入,因此 reducer 的计算也可以被分发出去。每个 reducer 都应该能看到某个独一无二的键的所有值。为了满足该要求,需要 shuffle 和 sort 操作来协调 map 和 reduce 阶段,使 reducer 的输入按键分组并排序。shuffle 和 sort 将 map 阶段的键空间分区,以便将特定键空间分配给特定 reducer。总体来说,MapReduce 的阶段如下图所示。

对上图各阶段的解释如下:

- HDFS 的本地数据以键值对的形式被加载到一个映射过程。

- mapper 输出零个或多个键值对,将计算所得的值映射到一个特定的键上。

- 基于键对这些键值对进行 sort 和 shuffle 操作,然后将它们传递给 reducer,使 reducer 获得键的所有值。

- reducer 输出零个或多个最终的键值对,即输出(归约 map 的结果)。

在拥有几个节点的集群上,MapReduce 流水线的数据流细节如下图所示:

4. 不止一个MapReduce:作业链

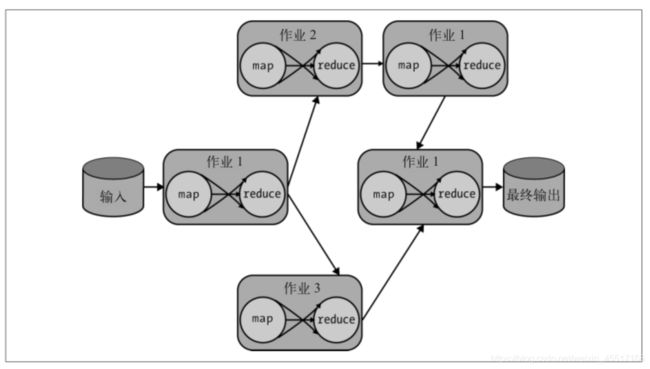

复杂的算法或应用程序实际上是通过被称为“作业链”的过程,使用多个 MapReduce 作业执行单个计算来构建的,其中下游 MapReduce 作业的输入是最近的上游作业的输出作业链。如下图所示,通过创建流经中间 MapReduce 作业系统的数据流,可以创建一个分析步骤的流水线,引导我们得到最终结果。

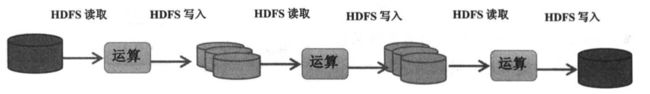

如下图所示, Hadoop MapReduce在运算时需要将中间产生的数据存储在硬盘中。然而,磁盘I/O往往是性能的瓶颈,因此会有读写数据延迟的问题。

六、Hadoop Streaming

1. Hadoop Streaming 介绍

Hadoop Streaming 是一个实用程序,Streaming 作业像普通 Hadoop 作业一样,通过作业客户端传递到集群。但除了可以指定输入和输出的 HDFS 路径的参数外,它还可以指定 mapper 和 reducer 的可执行程序。然后,作业作为普通 MapReduce 作业运行,依然由 ResourceManager 和 MRAppMaster 管理和监控,直到作业完成。

为了执行 MapReduce 作业,Streaming 利用标准 Unix 流进行输入和输出,因此得名 Streaming。mapper 和 reducer 的输入都是从 stdin 读取的。Hadoop 要求由 Python 编写的 mapper 和 reducer 将它们输出的键值对写到 stdout 中。下图演示了 MapReduce 中的这个过程。

- Hadoop Streaming 中的“流”指的是标准的 Unix 流 stdin 、 stdout 和 stderr(标准错误流)。

- 使用 Python 的 Hadoop 开发人员不一定能够通过 Hadoop Streaming 技术访问完整的 MapReduce API(partitioner、输入和输出格式等功能必须用 Java 编写)。

2. Hadoop Streaming 工作原理

当 Streaming 执行作业时,一般经历以下几步:

- 每个 mapper 任务将在自己的进程内启动提供的可执行文件;

- 将输入数据转换为文本行并将其输送到外部进程的 stdin 的同时,从 stdout 收集输出。输入数据的转换通常是直接将值序列化,因为数据是从 HDFS 读取的,其中每行都是一个新值。mapper 要求输出是键或值格式的字符串,其中键和值通过某个分隔符分隔,默认为制表符( \t )。如果没有分隔符,mapper 就认为输出只有键,值为 null 。可以通过向 Hadoop Streaming 作业传递参数来定制分隔符。

- 对 mapper 的输出进行 shuffle 和 sort (确保每个相同的键都发送给同一个 reducer);

- reducer 启动可执行文件。mapper 输出的键值字符串通过 stdin 传输到 reducer 作为输入,reducer 的输入和 mapper 的输出相互匹配,并保证按键分组。reducer 发送到 stdout 的输出的格式应该与 mapper 的键、分隔符和值的格式相同。

因此,为了使用 Python 编写 Hadoop 作业,需要创建两个 Python 文件:mapper.py 和 reducer.py。只需要在这两个文件中导入 sys 模块,就可以访问 stdin 和 stdout 。代码本身需要以字符串的形式处理输入、解析和转换每个数字或复杂的数据类型,我们也需要将输出序列化为字符串。

注意:

- reducer 更复杂一些,因为针对每行输入,我们都要记录正在处理哪个键,只有看到一个新键时,才能发射一个完整的和。这是因为与本地 API 不同,单个数据值会在 shuffle 和 sort 期间聚合到流进程中,而不是暴露为一个列表或迭代器。请记住,每个 reducer 任务都可以看到同一个键的所有值,但也可以看到多个键。

- reducer 不接收累积值,而是接收从 mapper 输出的、经过排序的逐行输入。

- 每个 Python 文件都应以 “#!/usr/bin/env python” 开头,从而提示 shell 应该使用 Python,而不是 bash 来解释代码。

3. Hadoop Streaming 执行

①使用 Linux 管道模拟 Hadoop MapReduce 流水线

因为 Streaming 使用 Unix 标准管道,所以可以使用 Linux 管道和 sort 命令模拟 Hadoop MapReduce 流水线。具体执行步骤如下:

- 在终端中使用 chmod 命令以确保 mapper.py 和 reducer.py 是可执行的。

- 使用 cat 命令输出文件的内容,通过管道将输出从 stdout 传输到 mapper.py 的 stdin,再传输到 sort ,然后到 reducer.py,最后将结果打印到屏幕上。

Unix 管道是一种测试 Hadoop Streaming 的 mapper 和 reducer 的方法,既简单又有效,还能有效说明集群是如何使用 mapper 和 reducer 代码的。这种方法非常适合在编写脚本时进行快速测试,因为不用等待 Hadoop Streaming 作业完成,也不需要解析 Java 调用过程(traceback)。

②在 Hadoop 集群上执行 Streaming 作业

为了将代码部署到集群,需要将 Hadoop Streaming JAR 提交给作业客户端,并传入自定义的操作符参数。Hadoop Streaming 作业的位置取决于 Hadoop 集群的设置。这样就可以按照如下所示的方法在集群上执行 Streaming 作业:

$ hadoop jar $HADOOP_HOME/share/hadoop/tools/lib/hadoop-streaming-*.jar(Hadoop Streaming 作业的位置) \

-input <输入文件> \

-output <输出文件名称> \

-mapper mapper.py \

-reducer reducer.py \

-file mapper.py \

-file reducer.py

注意:

- 这里使用了 -file 选项,它让 Streaming 作业往集群上发送脚本(否则程序无法在节点上找到这些脚本)。执行此命令将在 Hadoop 集群上启动该作业。mapper.py 脚本和 reducer.py 脚本将在处理之前被发送到集群中的每个节点,并应用于流水线的每个阶段。

- 如果有需要与作业一起发送的其他文件,可以使用 -file 选项将它们与作业打包在一起。代码中使用的任何第三方依赖也应与作业一起被提交,通常打包在 Python ZIP 文件中。对于较大的依赖文件或者需要使用 Cython 编译的依赖,则需要在作业启动之前在每个节点的系统路径中安装相应依赖。

4. Python 的 MapReduce 框架

Hadoop Streaming 稍微高级一点的用法是利用标准错误流( stderr )更新 Hadoop 状态以及 Hadoop 计数器。这种技术本质上是让 Streaming 作业访问 Reporter 对象——MapReduce Java API 的一部分,用于跟踪作业的全局状态。通过将特殊格式的字符串写入 stderr ,mapper 和 reducer 可以更新全局作业状态,以报告进度并表明它们是活动的。对于需要大量时间的作业,确保框架不会认为任务已超时至关重要。

计数器在整个 MapReduce 框架或应用程序范围内进行全局聚合,以键值对的形式保存数值。计数器可以通过满足结合律的运算来累加,这本质上就增加了计数器的值。Hadoop 实现了多个计数器,能对处理的记录和字节数进行计数,自定义计数器也能更轻松地跟踪作业中的指标数据或提供副计算的相关渠道。

举例来说,要实现要使用 Reporter 的 Counter 和 Status 功能的话,可以在 Mapper 和 Reducer 类添加如下方法:

def status(self, message):

sys.stderr.write("reporter:status:{}\n".format(message))

def counter(self, counter, amount=1, group="ApplicationCounter"):

sys.stderr.write(

"reporter:counter:{},{},{}\n".format(group, counter, amount)

)

counter 方法允许 map 和 reduce 函数更新任意命名计数器的计数。根据需要,更新的值可为任意值(默认为递增 1)。可以将计数器的组设置为任意名称,通常默认为应用程序的名称。与之类似, status 方法允许 MapReduce 应用程序向框架发送任意消息,并使它们在日志或 Web 用户界面中可见。

全局范围中有一个能改进由 Python 编写的 Streaming 应用程序的工具:作业配置变量(job configuration variable,简称“JobConf 变量”)。Hadoop Streaming 应用程序自动将作业的配置变量添加到环境中,用下划线( _ )替换圆点( . )来重命名配置变量。例如,如果要访问作业中 mapper 的数量,可以请求 “mapred.map.tasks” 配置变量。要在 Python 代码中访问作业配置变量,可添加以下函数:

import os

def get_job_conf(name):

name = name.replace(".", "_").upper()

return os.environ.get(name)

很明显,使用一个微型、可重用的框架对 Hadoop Streaming 的 Python 开发大有帮助。该框架应该有一个用于处理 mapper 和 reducer 的 Streaming 细节的基类,以及应该在自定义MapReduce Streaming 作业中扩展的抽象基类 Mapper 和 Reducer 。想想下面的框架:

import os

import sys

from itertools import groupby

from operator import itemgetter

SEPARATOR = "\t"

class Streaming(object):

@staticmethod #返回函数的静态方法,允许不实例化调用该方法

def get_job_conf(name):

name = name.replace(".", "_").upper()

return os.environ.get(name)

def __init__(self, infile=sys.stdin, separator=SEPARATOR):

self.infile = infile

self.sep = separator

def status(self, message):

sys.stderr.write("reporter:status:{}\n".format(message))

def counter(self, counter, amount=1, group="Python Streaming"):

msg = "reporter:counter:{},{},{}\n".format(group, counter, amount)

sys.stderr.write(msg)

def emit(self, key, value):

sys.stdout.write("{}{}{}\n".format(key, self.sep, value))

def read(self):

for line in self.infile:

yield line.rstrip() # rstrip() 删除 string 字符串末尾的指定字符(默认为空格)

def __iter__(self):

for line in self.read():

yield line

class Mapper(Streaming):

def map(self):

raise NotImplementedError("Mappers must implement a map method")

class Reducer(Streaming):

def reduce(self):

raise NotImplementedError("Reducers must implement a reduce method")

def __iter__(self):

generator = (line.split(self.sep, 1) for line in self.read())

for item in groupby(generator, itemgetter(0)):

yield item

在编写传递给 Hadoop Streaming 的 mapper 和 reducer 时,只需在 Streaming 作业中引入这个文件,并从该框架中导入合适的类。在扩展类后,只需在代码中实现 map 函数或reduce 函数即可。

5. MapReduce 高级工具

这一节从概念层面去介绍一些在 MapReduce 算法和优化中发挥重要作用的工具

(实际上,这些工具很难在没有 Java API 的情况下实现),我们将讨论 combiner(主要的 MapReduce 优化技术)、partitioner(确保在 reduce 步骤中不出现瓶颈的技术)和作业链(用于组合更大的算法和数据流的技术)。

① combiner

mapper 会产生大量的中间数据,这些中间数据必须通过网络传输,进行 shuffle、sort 和 reduce。由于网络是物理资源,大量数据的传输可能会导致作业延迟和内存瓶颈(比如 reducer 要保存到内存中的数据太多)。

combiner 是解决这个问题的主要机制,而且它本质上也是与 mapper 输出相关联的中间 reducer。在将数据转发到合适的 reducer 之前,combiner 通过执行一个 mapper 局部的 reduce 来减少网络流量。

每个 mapper 都为 reducer 带来额外的工作,即每个 mapper 都会产生重复的键。combiner 预先计算每个键的和,减少生成的键值对的数量,从而减少网络流量。此外,因为存在较少的重复键,所以 shuffle 操作和 sort 操作也变得更快。

只要运算满足交换律和结合律,combiner 和 reducer 就是相同的——这很常见,但也不总是这样。只要 combiner 的输入输出数据类型和 mapper 的输出数据类型一样,则 combiner 可以执行任意的局部聚合(partial reduction)。因此,combiner 的运算与 reducer 不同时,算法常常同时使用 mapper、reducer 和 combiner 实现。要在 Hadoop Streaming 中指定 combiner,可以使用 -combiner 选项,与指定 mapper 和 reducer 类似:

$ hadoop jar $HADOOP_HOME/share/hadoop/tools/lib/hadoop-streaming-*.jar(Hadoop Streaming 作业的位置) \

-input <输入文件> \

-output <输出文件名称> \

-mapper mapper.py \

-combiner combiner.py \

-reducer reducer.py \

-file mapper.py \

-file reducer.py \

-file combiner.py

如果 combiner 与 reducer 匹配,则只需将 reducer.py 文件指定为 combiner 即可,无须添加额外的 combiner 文件。

② partitioner

partitioner 通过划分键空间来控制如何将键及其值发送到每个 reducer,默认使用的 HashPartitioner 通常就能满足需求。它通过计算键的散列值并将键分配给由 reducer 数量确定的键空间,来将键均匀地分配给每个 reducer。给定均匀分布的键空间后,每个 reducer 将获得相对平均的工作负载。

一旦键的分布不平均,比如大量的值与一个键相关联,其他键几乎没有关联的值,在这种情况下,大部分 reducer 的工作量不饱满,并行 reduce 的大多数好处也就无从体现。

一个自定义的 partitioner 可以根据散列之外的其他语义结构(通常是特定于领域的)划分键空间,从而缓解这个问题。最后,因为每个 reducer 都将输出写入自己的 part- 文件*,使用自定义 partitioner 还能支持更清晰的数据组织,让你根据分区条件将分段输出写入每个文件。

③ 作业链

大多数复杂的算法不能使用简单的 map 和 reduce 描述。因此,为了实现更复杂的分析,需要一种被称为作业链的技术。如果可以将复杂的算法分解成几个较小的 MapReduce 任务,那么将这些任务链接在一起就可以产生完整的输出。

作业链是许多小作业的组合,通过将一个或多个作业的输出发送给另一个作业作为

输入,从而实现完整的计算。为了实现这样的算法,开发人员必须考虑每一步计算怎样 reduce 出中间值——不仅仅是 mapper 和 reducer 之间的中间值,还包括作业之间的中间值。

如上图所示,许多作业都被认为是线性作业链。线性依赖性意味着每个 MapReduce 作业仅依赖于前一个作业。然而,这是一种简化的作业链形式,更普遍的作业链表示为作业依赖于一个或多个先前作业的数据流。可以用有向无环图(directed acyclic graph,DAG)来表述复杂作业,它描述数据如何从输入源通过每个作业(有向部分)流向下一个作业,最后作为最终输出(如下图所示)。

在考虑作业链和作业依赖时,注意可能会有仅有 map 的作业。仅有 map 的作业分两种:不需要聚合的作业,以及积极避免 shuffle 阶段和 sort 阶段的作业——要么为了保持数据的顺序,要么为了优化作业的执行。要执行仅有 map 的作业,只需将 reducer 的数目设置为 0 即可。有了 HadoopStreaming,就可以使用 -numReduceTasks 标志指定 reducer 的数目。通过使用 identity mapper,也可以实现仅有 reduce 的作业,“仅有 map”的作业可以使用 identity reducer 实现排序。

七、Spark 内存计算

1. 为什么需要 Spark?

MapReduce 的批处理模型不太适合常见的工作流,包括针对单个数据集的迭代、交互和按需计算。为了实现协调性和容错性,MapReduce 模型需要将中间数据写回 HDFS。不幸的是,将数据从其存储位置移动到计算位置所需要的 I/O 在任何计算系统中都是最大的时间成本。因此,MapReduce 在具有极高的安全性和弹性的同时,运行任务的速度也不可避免会慢一些。

关于**弹性(Flexible)**的解释:

- 传统的关系数据库存储数据时必须有数据表结构 schema(各个数据对象的集合),然而 Hadoop 存储的数据是非结构化(schema-less)的,也就是说可以存储各种形式、不同数据源的数据。

更糟的是,几乎所有应用程序都必须在多个步骤中将多个 MapReduce 作业链接在一起,从而创建面向最终所需结果的数据流。这导致不为用户所需的大量中间数据被写入 HDFS,从而产生额外的磁盘开销。

为了解决这些问题,Hadoop 采用了更通用的资源管理框架进行计算,这便是 YARN。 YARN 为 Hadoop 应用程序提供了更通用的资源访问。因此,专用工具不再需要分解为一系列 MapReduce 作业,可以变得更复杂。

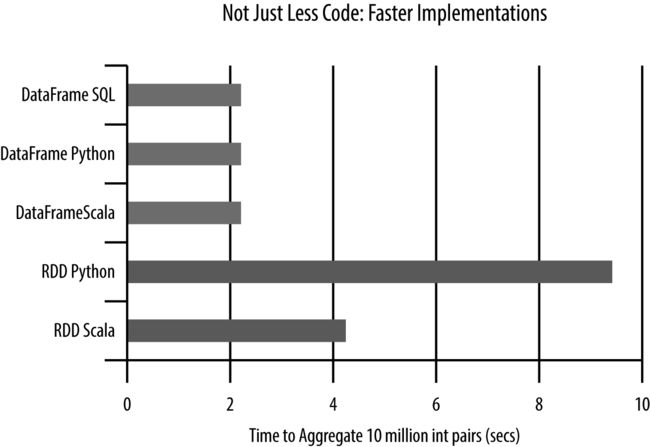

Spark 是应运而生的第一个快速、通用的分布式计算范式,Spark 主要通过名为弹性分布式数据集(resilient distributed dataset,RDD)的新数据模型实现高速运行。该数据模型在计算时存储在内存中,从而避免了昂贵的中间磁盘写操作。它还利用了 DAG (有向无环图)执行引擎优化计算,特别是迭代计算,这对于优化算法和机器学习等数据理论任务来说至关重要。在速度方面的优势使得 Spark 能以交互方式进行访问,使用户成为计算任务的一部分,并支持以前不可能实现的大数据集探索,让数据科学家能更轻松地使用集群。

2. Spark 基础

Spark 主要通过在集群节点的内存中缓存计算所需的数据来实现高速运行。在内存中进行集群计算使 Spark 可以运行迭代算法,因为程序可以为数据创建检查点并引用回它,避免从磁盘重新加载。此外,它支持极快速的交互式查询和流式数据分析。因为 Spark 与 YARN 兼容,所以它可以在现有的 Hadoop 集群上运行并访问任何 Hadoop 数据源,包括 HDFS、S3、HBase 和 Cassandra。

还有一点很重要,Spark 的设计从根本上支持大数据应用程序和数据科学任务。Spark API 不仅支持 map 和 reduce ,还提供了许多强大的分布式抽象。这些抽象同样与函数式编程相关,包括 sample、filter、join 和 collect 等。

先来看看 MapReduce 在迭代算法方面的局限性。例如,为了使用 MapReduce 编程实现有监督学习算法,目标函数的参数必须映射到数据集中的每个实例,并计算和规约误差。在 reduce 阶段结束之后,参数将被更新并馈送到下一个 MapReduce 作业。然而,每个作业都必须从磁盘读取数据,并将误差写回磁盘,这将导致明显的 I/O 延迟。

相反,Spark 在应用程序运行期间将尽可能多的数据集保存在内存中,从而防止在迭代之间重新加载数据。因此,Spark 程序员不是简单地指定 map 步骤和 reduce 步骤,而是在执行某个需要协调的动作(如规约或写入磁盘)之前,指定一系列将应用于输入数据的数据流转换。因为数据流可以通过 DAG 来描述,所以 Spark 的执行引擎提前知道了如何在集群上分发计算并管理计算的细节。

Spark 的通用性意味着可以用它构建更高级的工具,用于实现类 SQL 的计算、图形处理和机器学习算法,乃至交互式 notebook 和数据框——这些都是为数据科学家所熟知的工具,但是是在集群环境中实现的。来了解一下它有哪些工具:

Spark 栈

Spark 是一种通用的分布式计算抽象,可以在独立模式下运行。但是 Spark 只专注于计算而不关心数据存储,因此通常在实现了数据仓储和集群管理工具的集群中运行。当使用 Hadoop 构建 Spark 时,它使用 YARN 通过 ResourceManager 来分配和管理集群资源,如处理器和内存。正因如此,Spark 可以访问所有 Hadoop 数据源,例如 HDFS、HBase、Hive,等等。

Spark 通过 Spark Core 模块将其主要的编程抽象暴露给开发人员。此模块包含基本功能和常规功能,包括定义 RDD 的 API。Spark 构建于这个核心之上,为各种数据科学任务实现与 Hadoop 交互的专用库,如下图所示。

注意:

- 组件库未集成到通用计算框架中,所以 Spark Core 模块非常灵活,允许开发人员以不同的方法轻松解决类似的用例

- Spark 是一个计算框架,旨在利用集群管理平台(如 YARN)和分布式数据存储(如 HDFS)

Spark 主要包含如下组件:

- Spark SQL

这个库提供了更常规、更结构化的数据处理抽象——DataFrame。DataFrame 本质上是组织成列数据的分布式集合,概念上类似于关系数据库中的表。 - Spark Streaming

对无界数据流实现实时处理和操作。Spark Streaming 使程序能够像处理一般的 RDD 一样处理实时数据。 - MLlib

一个常用的机器学习算法库,使用 RDD 上的 Spark 操作实现。该库包含可扩展的学习算法(例如分类、回归等),这些算法需要进行大型数据集的迭代运算。 - GraphX

算法和工具集合,用于操作图形、执行并行图形的操作和计算。GraphX 扩展了 RDD API,囊括了操作图形、创建子图和访问路径中所有顶点的操作。

RDD

我们将 Hadoop 描述为一个分布式计算框架,涉及两个主要问题:如何在集群中分发数据,以及如何分发计算。分布式数据存储问题涉及数据的高可用性(将数据放在它被处理的地方)、可恢复性和持久性。分布式计算意在通过将大型计算或任务分解成更小的独立计算来提高计算的性能(速度),这些计算可以同时(并行)运行,然后聚合得到最终结果。因为每个并行计算在集群中单独的节点或计算机上运行,所以分布式计算框架需要为整个计算提供一致性、正确性和容错保证。

Spark 不处理分布式数据存储,而是依靠 Hadoop 提供此功能,因此通过一个被称为弹性分布式数据集的框架专注于提供可靠的分布式计算。RDD 本质上是一种编程抽象,表示跨机器分区的对象的只读集合。RDD 可以根据转换过程(lineage)重建(因此是容错的),通过并行操作访问,从分布式存储读取和写入,以及高速缓存在 worker 节点的内存中以快速重用——这一点最为重要。

这种内存缓存功能使速度大幅提高,并提供了机器学习所需的迭代计算以及以用户为中心的交互式分析。RDD 使用函数式编程结构体进行操作,函数式编程结构体包括 map 和 reduce ,并在其基础上进行扩展。程序员通过从输入源加载数据,或转换现有集合来创建新的 RDD。RDD转换过程(lineage)主要由应用于 RDD 转换的历史定义,并且因为 RDD 的对象集合是不可变的(不能直接修改),所以转换可以重新应用于部分或整个集合,以便从故障中恢复。因此,Spark API 本质上是创建、转换和导出 RDD 操作的集合。

Spark 中的故障恢复与 MapReduce 的区别很大。在 MapReduce 中,数据在每个临时处理步骤之间是作为文件写入磁盘的。因此,进程在 map、shuffle 和 sort、reduce 之间拉取数据。如果一个进程失败,那么另一个进程就开始拉取数据。在 Spark 中,对象集合存储在内存中。通过保留 RDD 部分的早期检查点或缓存版本,

RDD 转换过程(lineage)可用于重建部分或全部集合。

因此,基本编程模型描述了如何通过编程操作创建和修改 RDD。有两种类型的操作可以应用于 RDD,分别是转换和动作。将转换操作应用于现有 RDD 可以创建新的 RDD,例如对 RDD 应用过滤操作可以生成包含过滤出来的值的较小 RDD。然而,动作才会真正将结果返回给 Spark 驱动程序,协调或聚合 RDD 中的所有分区。在这个模型中, map 是一种转换操作,因为一个函数被传递给存储在 RDD 中的每个对象,并且该函数的输出映射到一个新的 RDD;而像 reduce 这样的聚合是一个动作操作,因为 reduce 需要(根据键)对 RDD 进行重新分区,并计算和返回某个聚合值,如和或平均值。Spark 中大多数动作的设计初衷都只是为了输出——返回单个值或小的值列表,或者将数据写回分布式存储。

Spark 的另一个好处是,它会“延迟”应用转换操作,即向集群提交作业以执行作业之前,检查完整的转换序列和一个动作。这种延迟执行机制带来了明显的存储和计算优化,因为它允许 Spark 建立数据转换过程(lineage)并评估完整的转换链,以便只计算结果所需的数据。例如,如果对 RDD 运行 first() 动作,Spark 将不会读取整个数据集,并只返回第一个匹配行。

使用RDD编程

Spark 应用程序的代码被写在驱动程序(driver program)中,提交时在驱动程序所在机器上被延迟评估。一旦遇到动作,驱动程序代码就被分发到集群上,由 worker 节点在各自的 RDD 分区上执行该代码。然后结果被发送回驱动程序以进行聚合或汇编。

如下图所示,驱动程序通过将来自 Hadoop 数据源的数据集并行化,创建一个或多个 RDD,应用操作来转换 RDD,然后对经过转换的 RDD 调用某个动作以检索输出。“并行化”是一种行为,它将数据集分区,并将数据的每个部分发送到将对其执行计算的节点。

Spark 编程的典型数据流序列如下所示:

- 通过访问存储在磁盘上的数据、并行化某个集合、转换现有 RDD 或缓存来定义一个或多个 RDD。缓存是 Spark 的一个基本过程,即在节点内存中存储 RDD,用于在计算过程中快速访问。

- 通过将闭包(这里指不依赖于外部变量或数据的函数)传递到 RDD 的每个元素,来对 RDD 执行操作。

- 对生成的 RDD 使用聚合动作(例如计数、收集、保存等)。动作将启动集群上的计算,因为在计算聚合之前无法进行任何计算。

当 Spark 在 worker 节点上运行闭包时,闭包中使用的所有变量都将被复制到该节点,但在该闭包的局部范围内维护。如果需要外部数据,Spark 提供了两种类型的共享变量——广播变量和累加器,所有的 worker 节点都可以通过受限方式与它们交互。广播变量被分发给所有 worker 节点,但是只读的,并且通常作为查找表或禁用词列表使用。累加器是一个变量,worker 节点可以“累加”(满足结合律)它,通常用作计数器。这些数据结构类似于 MapReduce 中的分布式缓存和计数器,并且发挥着类似的作用。

3. Spark 执行机制

对 Spark 的执行机制进行简要说明。Spark 应用程序本质上是独立运行的进程的集合,由驱动程序中的 SparkContext 进行协调。该上下文将与某个分配系统资源的集群管理器(例如 YARN)连接。集群中的每个 worker 节点都由一个 executor 管理,executor 又由 SparkContext 管理。executor 管理每台机器上的计算、存储和缓存。驱动程序、YARN 和 worker 节点的交互如下图所示。

但要注意,应用程序代码从驱动程序发送到 executor,executor 指定上下文和要运行的各种任务。executor 与驱动程序来回通信以进行数据的共享或交互。驱动程序是 Spark 作业的关键参与者,因此它们应该和集群待在同一个网络上。这不同于 Hadoop 代码——你可以从任何地方将作业提交到 ResourceManager ,并由 ResourceManager 负责作业在集群上的执行。

可以通过两种模式将 Spark 应用程序提交到 Hadoop 集群,分别是 yarn-client 和 yarn-cluster 。在 yarn-client 模式下,驱动程序在客户端进程内运行。如上所述, ApplicationMaster 仅管理作业的进度并请求资源。然而在 yarn-cluster 模式下,驱动程序在 ApplicationMaster 进程内部运行,因此释放了客户端进程,像传统的 MapReduce 作业一样运行。如果程序员想获取即时结果或想以交互模式运行,可以使用 yarn-client 模式;而对于时间运行长或不需要用户干预的作业,使用 yarn-cluster 模式更为合适。

4. 基于 PySpark 的交互性 Spark

Spark 中的交互式 shell 叫 pyspark 。这种交互方式类似于在 Python 解释器中与本地 Python 代码交互、在命令行中编写命令并接收 stdout 的输出。这种类型的交互还支持交互式 notebook,在 Spark 环境中设置 iPython 或 Jupyter notebook 也非常容易。

在 pyspark 中使用 RDD 是启用 Spark 最简单的方法。为了运行交互式 shell,需要定位 pyspark 命令,该命令位于 Spark 库的 bin 目录。和 $HADOOP_HOME 类似,你也应该配置一个 $SPARK_HOME 。Spark 无须配置即可运行,因此只需下载适用于系统的 Spark 就足够了。将 $SPARK_HOME 替换为下载路径(或设置你的环境)就可以运行交互式 shell,如下所示:

hostname $ $SPARK_HOME/bin/pyspark

PySpark 使用本地 Spark 配置自动创建了一个 SparkContext 。它通过 sc 变量将自己暴露给终端。为了检查到目前为止的转换过程(lineage),可以使用toDebugString 方法来查看 PipelinedRDD 是如何转换的。

请注意,在 MapReduce 作业中,由于 map 和 reduce 之间有 shuffle 阶段和 sort 阶段,所以键会被排序。但因为所有 executor 都可以相互通信,所以 Spark 进行 reduce 时不会对重新分区排序。因此,前面的输出不会按照字母顺序排列。不过,由于用 reduceByKey 算子聚合了相应 RDD,所以即使没有排序,仍然能保证每个键在所有 part 文件中仅出现一次。如果需要排序,可以使用 sort 算子确保所有键在写入磁盘之前都已被排序。

5. Spark 应用程序模版

使用 Python 编写 Spark 应用程序与在交互式控制台中使用 Spark 很像,因为 API 是相同的。但是你不需要在交互式 shell 中输入命令,而是需要创建一个完整的、可执行的驱动程序并将其提交到集群。这涉及一些在 pyspark 中自动处理的内务任务,包括获取 SparkContext 的访问,这是由 shell 自动加载的。

因此,许多 Spark 程序都是简单的 Python 脚本。它包含一些数据(共享变量),定义用于转换 RDD 的闭包,并描述 RDD 转换和聚合的分步执行计划。使用 Python 编写 Spark 应用程序的基本模板如下所示:

''' Spark应用程序,使用spark-submit执行'''

# 导入

from pyspark import SparkConf, SparkContext

# 共享变量和数据

APP_NAME = "My Spark Application"

# 闭包函数

# 主要功能

def main(sc):

"""

这里描述RDD转换和动作

"""

pass

if __name__ == "__main__":

# 配置Spark

conf = SparkConf().setAppName(APP_NAME)

conf = conf.setMaster("local[*]")

sc = SparkContext(conf=conf)

# 执行主要功能

main(sc)

此模板展示了 Python 语言的 Spark 应用程序自上而下的结构:

- import 让各种 Python 库以及 Spark 组件(例如 GraphX 和 SparkSQL)可用于分析

- 为了调试和日志记录,共享数据和变量被指定为模块常量,包括在 Web UI 中使用的应用程序名称

- 为了便于调试,可以让驱动程序包含特定于作业的闭包或自定义算子,这些闭包或自定义算子也可以导入到其他 Spark 作业中

- 最后, main 方法定义转换和聚合 RDD 的分析方法,该 main 方法作为驱动程序运行

这里使用了 ifmain 语句,其中 Spark 配置和 SparkContext 被定义并传递给 main 函数。通过 ifmain 可以轻松地将驱动程序代码导入到其他 Spark 上下文,无须创建新的上下文或配置、执行作业。具体来说,Spark 程序员通常会将代码从应用程序导入到 iPython、Jupyter notebook 或 pyspark 交互式 shell 中,以便在对较大的数据集运行作业之前进行分析。

驱动程序定义了 Spark 执行过程的方方面面,例如程序员可以在代码中使用 sc.stop() 或 sys.exit(0) 停止或退出程序。这样的控制也可以扩展到执行环境——在这个模板中,Spark 集群的配置 local[*] 通过 setMaster 方法硬编码到 SparkConf 中,这告诉 Spark 在本地机器上运行尽可能多的进程(多进程,但不是分布式计算)。虽然你可以在命令行使用 spark-submit 来指定 Spark 执行的位置,但是驱动程序通常基于使用 os.environ 的环境变量来进行选择。因此,在开发 Spark 作业时,作业可以在本地运行;但是在生产环境中,作业在集群的较大数据集上运行。编写 Spark 应用程序肯定与编写 MapReduce 应用程序不同,因为转换和动作提供了灵活性,以及更灵活的编程环境。

注意:

- 与 Hadoop Streaming 一样,任何不属于 Python 标准库的第三方 Python 依赖都必须预先安装在集群中的每个节点上,或随作业一起提供。

- 与 Hadoop Streaming 不同的是,Spark 有两个上下文(即驱动程序上下文和 executor 上下文),这允许一些重量级库(特别是可视化库)可以只安装在驱动程序机器上——只要它们不被在集群上运行的 Spark 运算使用的闭包使用就可以。如果想要预防错误,可以使用 try/except 块包裹 import 语句来捕获 ImportError 。

6. 总结

Spark 不解决分布式存储问题(通常 Spark 从 HDFS 获取其数据,当与 YARN 结合时,Spark 用于增强(不是替换)现有的 Hadoop 集群),但它为分布式计算提供了丰富的函数式编程 API。这种框架建立在弹性分布式数据集(RDD)的理念上。RDD 是一种编程抽象,表示分区的对象集合,允许对它们执行分布式操作。RDD 是容错的(弹性部分),还可以存储在 worker 节点的内存中,以便快速重用。内存存储提供更快、更容易表达的迭代算法,还支持实时交互式分析。

八、分布式分析和模式

1. 前言

MapReduce 和 Spark 让开发人员和数据科学家能轻松进行数据并行运算。在这类运算中,数据被分发到多个处理节点同时计算,然后通过 reduce 产生最终输出。而 YARN 提供了简单的任务并行性,通过为每个任务分配自由计算资源,支持集群同时执行多个不同的操作。然而,大多数并行运算都比较简单。这也带来了一个问题:数据科学家如何进行大规模高级数据分析?

单个运算只对数据进行多个微小的处理,而要想得到更有意义的结果,必须将这些运算组成一个被称为数据流的分步序列。如果两个运算可以同时进行,则数据流可以分叉(fork)和合并(merge),支持任务和数据并行,但是必须保证序列的数据从输入数据源串行馈送到最终输出。因此,数据流被描述为有向无环图(DAG)。如果一种算法、分析或精心设计的计算可以表示为 DAG,则它可以在 Hadoop 上并行化。

但是,许多算法都不能轻易转换为 DAG,即不适合这种类型的并行化。不能被描述为有向数据流的算法有:在整个计算过程中维持或更新单个数据结构的算法(需要一些共享内存),或者依赖中间步骤计算结果的算法 (需要中间进程间通信)。引入循环的算法,特别是循环次数不限的迭代算法,也不容易描述为 DAG。

有一些工具和技术可以满足 MapReduce 和 Spark 中循环性、共享内存或进程间通信的需求。但是要利用这些工具,必须将算法重写为分布式形式。比起重写算法,更常采用的是一种技术要求更低但同样有效的方法:设计一种数据流,将输入域分解为适合单个机器内存的较小输出,对输出运行串行算法, 然后使用另一个数据流在集群上验证该分析。

正是因为这种方法被广泛采用,Hadoop 才被普遍认为是一个释放大数据集潜力的预处理器——它通过每个操作将数据集规约(reduce)成越来越容易管理的块。一种常见做法是,使用 MapReduce 或 Spark 将数据分解到一个可以载入 128GB 内存的计算空间中。这个规则通常被称为“最后一英里”(last-mile)计算,因为它将数据从极大的空间移动到足够近的地方(即最后一英里),从而能够进行准确的分析或特定于应用程序的计算。

2. 键计算

要理解数据流实际是如何工作的,第一步就是理解键值对和并行计算之间的关系。在 MapReduce 中,所有数据在 map 阶段和 reduce 阶段都被构造为键值对。关键需求主要与 reduce 有关,因为聚合是按键分组的,并行 reduce 需要对键空间进行分区,使每一个 reducer 任务都能收到一个键的所有值。如果没有用于分组的键,你就可以按单一的键进行 reduce,强制对所有映射值进行 reduce。然而在这种情况下,reduce 阶段无法从并行中受益。

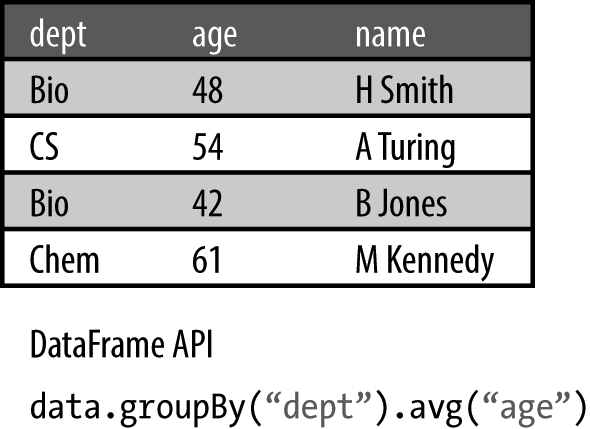

键虽然经常被忽略(特别是在 mapper 中,键仅仅是文档标识符),但是它能让计算在数据集上同时进行。因此,数据流表达了一组值与另一组值之间的关系。MapReduce 和 Spark 计算采用了并行执行分组操作,如下图所示的按键分组的平均值计算。

此外,键可以保存在数据流的一个阶段中已经被 reduce 的信息,还能自动并行下一步计算所需的结果。这是通过复合键完成的,复合键的存在表明了键不一定是简单的、原始的值。事实上,键对于这些类型的计算非常有用,尽管它们在使用 Spark 的计算中不是必需品(RDD 可以是简单值的集合),但大多数 Spark 应用程序需要它们来进行分析,主要是使用 groupByKey 、 aggregateByKey 、sortByKey 和 reduceByKey 动作来收集和 reduce。

复合键

键不一定是简单的原始数据类型,如整型或字符串;相反,它们可以是复合类型或复杂类型,只要是可散列(hashable)且可比较(comparable)的即可。可比较的类型必须至少能暴露某种用于判断相等的机制(用于 shuffle)和某种排序方法(用于 sort)。一般通过将某种类型映射到一个数值(例如,将月份映射到整数 1~12),或通过词汇顺序来完成比较。Python 中的可散列类型是任意一种不可变类型,最典型的就是由不可变类型组成的元组。

用作复杂键的复合键支持在键空间的多个面上进行计算,这是复合键最常见的用例。另一个常见用例是将特定键的信息传播到下游计算,例如依赖于 reduce 或每个键的聚合值的计算。通过将 reducer 的计算与键(特别是类似计数或浮点数的值)相关联,这些信息能与键一起被维护,以用于更复杂的计算。

使用复合键(和复杂的值)的最后一步是理解复合数据的序列化和反序列化。序列化是指将内存中的对象转换成字节流,使其可以被写入磁盘或通过网络传输(反序列化是指相反的过程)。序列化过程必不可少,特别是在 MapReduce 中,因为键和值在 map 阶段和 reduce 阶段之间被写入磁盘(通常作为字符串写入)。然而,理解 Spark 中的序列化也非常重要——Spark 的中间作业要对数据进行预处理,供后续计算使用。

在 Spark 中,Python API 默认使用 pickle 模块进行序列化,这意味着你使用的任何数据结构都必须是可以 pickle 的。使用 MapReduce Streaming 时,必须将键和值序列化为字符串,并以指定的字符分隔,默认情况下为制表符( \t )。那么有没有更高效的办法,能将复合键(和值)序列化为字符串呢?

通常会简单地使用内置的 str 函数对不可变类型(例如元组)进行序列化,将该元组转换为可以轻松 pickle 或流式传输的字符串。然后问题转向反序列化——通过 Python 标准库中的 ast (抽象语法树)模块,使用 literal_eval 函数评估元组字符串得到 Python 元组类型,如下所示:

import ast

def map(key, val):

# 解析复合键,它是一个元组

key = ast.literal_eval(key)

# 以字符串写新的键

return (str(key), val)

随着键和值越来越复杂,你也得考虑使用其他序列化数据结构,尤其是那种更紧凑的、能减少网络流量或能转换为字符串值以确保安全性的数据结构。例如,结构化数据的常见表示形式是 Base64 编码的 JSON 字符串,因为它很紧凑,仅使用 ASCII 字符,并且很容易用标准库进行序列化和反序列化,如下所示:

import json

import base64

def serialize(data):

"""

返回数据(键或值)的Base64编码的JSON表示

"""

return base64.b64encode(json.dumps(data))

def deserialize(data):

"""

解码Base64编码的JSON数据

"""

return json.loads(base64.b64decode(data))

使用复杂的序列化表示时要小心,通常需要权衡序列化的计算复杂度与它所需的空间。许多类型的并行算法更适合使用元组字符串或制表符分隔格式,实现起来更快、更简单,如果能管理好键在计算中的传递过程更能事半功倍。

键空间模式

键也是计算的主要部分。因此,除了数据之外,键也必须被管理。本节将探讨影响键空间的几种模式,特别是爆炸(explode)、过滤、变换和恒等(identity)模式。这些常见模式通过键和值之间的关联关系来构造更大的模式并完成算法。

① 键空间变换

最常见的基于键的运算是输入键的域的变换,在 map 和 reduce 中均可进行。在 map 期间变换键空间会导致数据在聚合期间重新分区(划分),而在 reduce 期间变换键空间可用于重组输出(或后续计算的输入)。最常见的变换函数是直接赋值、复合、分割和键值换位。

直接赋值丢弃了输入的键(通常被完全忽略),从输入值或别的来源(例如随机的键)构造新键。思考一下从文本、CSV 或 JSON 加载原始或半结构化数据的情况。在这种情况下,输入键是行或文档 ID,通常因为某些特定于数据的值而被丢弃。

复合及其相反运算分割管理复合键。复合构建复合键,或向复合键添加新的元素,能增加键关系的面;分割拆分复合键,而只使用其中一小部分。通常,值也能被复合和分割,复合键从拆分值接收新的数据(反之亦然),以确保没有数据丢失。此外,也可以通过复合或分割,丢弃不需要的数据或删除无关的信息。

键值换位交换键和值,是一种常见模式,特别是在链式的 MapReduce 作业或依赖于中间聚合(特别是 groupby )的 Spark 操作中。例如,为了通过值而不是键对数据集进行排序,必须先在 map 中将键和值换位,执行 sortByKey 或者利用 MapReduce 中的 shuffle 和 sort,然后在 reduce 或另一个 map 中重新换位。

② 爆炸 mapper

爆炸 mapper 针对单个输入键生成多个中间键值对。一般来说,这是通过结合键移位(keyshift)和将值拆分为多个部分来实现的。正如单词计数示例,它根据空格拆分行,将输入 mapper 中的单个行号 / 行对输出为几个新的键值对,即单词 /1。通过将值按组成部分划分并且重新将键分配给它们,爆炸 mapper 还可以生成许多中间对。

在这种情况下,我们经常会碰到一个名为 flatMap 的操作函数,该函数一般的功能和 map 函数相同,但是比 map 函数多了一个扁平化的过程,而且传入的函数在处理完后返回值必须是 list 或者 sequence(该函数产生一个序列而不是单个项,然后该序列被链接成单个集合(而不是列表的 RDD))。在 MapReduce 和 Hadoop Streaming 中不存在这样的限制,一个 map 函数可以发射任意数量的对(或者根本不发送)。

③ 过滤器 mapper

过滤通常对限制 reduce 阶段执行的计算量至关重要,特别是在大数据环境中。它还可将同一数据流的计算划分为两条路径,这是专为超大数据集设计的一种大型算法,是面向数据的分支方法。mapper 什么也不发射也完全没问题。因此,用于过滤器 mapper 的逻辑是仅在满足条件时才发射。

④ 恒等模式

MapReduce 中的最后一个常用键空间模式(一般不用于 Spark 中)是恒等(identity)函数。它只是一个传递,能使恒等 mapper 或者恒等 reducer 返回与输入相同的值(就好像在恒等函数 f(x) = x 中一样)。恒等 mapper 通常用于在数据流中执行多个 reduce。当在 MapReduce 中使用恒等 reducer 时,该作业等同于在键空间上进行排序。恒等 mapper 和恒等 reducer 的简单实现如下所示:

class IdentityMapper(Mapper):

def map(self):

for key, value in self:

self.emit(key, value)

class IdentityReducer(Reducer):

def reduce(self):

for key, values in self:

for value in values:

self.emit(key, value)

因为 MapReduce 使用了最优的 shuffle 和 sort,因而恒等 reducer 通常更常见一些。不过恒等 mapper 也非常重要,特别是在链式 MapReduce 作业中,一个 reducer 的输出必须立即被第二个 reducer 再次 reduce。事实上,正是因为 MapReduce 的操作是分阶段的,所以才需要恒等 reducer。在 Spark 中,因为 RDD 被延迟评估,所以不需要恒等闭包。

pair 与 stripe

数据科学家习惯用表示为向量、矩阵或数据框的数据。线性代数计算往往针对单核机器进行了优化,而机器学习中的算法使用低级数据结构(如 numpy 库中的多维数组)来实现。这些结构虽然紧凑,但因为数据的量级实在太大,所以无法在大数据环境中使用。相反,矩阵通常有两种表示方式:pair 和 stripe。

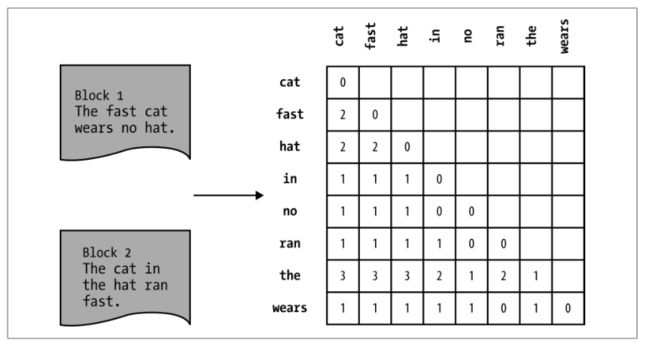

pair 和 stripe 都是基于键的计算。为了理解这一点,试着为基于文本的语料库建立单词共现矩阵。如下图所示的单词共现矩阵是大小为 N×N 的矩阵,其中 N 是语料库的词汇量(单词的种数)。每个单元 W i,j 包含词 w i 和词 w j 同时出现在句子、段落、文档或其他固定长度窗口中的次数。这个矩阵很稀疏,特别是采用了积极的停用词过滤之后,因为大多数单词通常仅与非常少的其他词共现。

pair 方法将矩阵中的每个单元映射到特定值,其中词对是复合键 i,j 。因此,reducer 对每个单元的值进行处理,以产生最终的单元挨单元的矩阵。这是一种合理的方法,它产生的输出中的每个 W i,j 被单独计算并存储。使用求和 reducer,mapper 如下所示:

from itertools import combinations

class WordPairsMapper(Mapper):

def map(self):

for docid, document in self:

tokens = list(self.tokenize(document))

for pair in combinations(sorted(tokens), 2):

self.emit(pair, 1)

这个方法的重中之重是使用内置的 sorted 函数对令牌进行字典排序。在对称矩阵中,必须为词对排序,否则键 (b,a) 和 (a,b) 不会 reduce 在一起。请注意,itertools 库中的 combinations 函数保持其输入列表的排序。输入如下所示:

"See Spot run, run Spot, run!"

单词共现矩阵的词对聚合结果如下所示:

(run, run), 3

(run, see), 3

(run, spot), 6

(see, spot), 2

(spot, spot), 1

虽然 pair 方法易于理解和实现,但是它产生了许多中间对。这些中间对必须在网络上传输,这一过程在 MapReduce 的 shuffle 阶段和 sort 阶段,以及 groupByKey 操作将值 shuffle 到 RDD 各分区的期间均有发生。此外,pair 方法不太适用于需要整行(或列)数据的计算。

stripe 方法最初被设想为一种减少中间对的数量和网络通信的优化手段,从而让作业运行得更快。不过它很快也成为一种重要的工具,应用于许多需要针对一个元素执行快速计算(例如相对频率或其他统计运算)的算法中。stripe 方法没有使用词对,而是在 mapper 中为每个条目构造关联数组(Python 字典),并作为值发射:

from collections import Counter

class WordStripeMapper(Mapper):

def map(self):

for docid, document in self:

tokens = list(self.tokenize(document))

for i, term in enumerate(tokens):

# 为每个条目创建新的stripe

stripe = Counter()

for j, token in enumerate(tokens):

# 不计算该条目与本身的共现

if i != j:

stripe[token] += 1

# 发射条目和stripe

self.emit(term, stripe)

class StripeSumReducer(Reducer):

def reduce(self):

for key, values in self:

stripe = Counter()

# 将所有计数器相加

for value in values:

for token, count in value.iteritems():

# 为每一个令牌分别累加stripe

stripe[token] += count

self.emit(key, stripe)

现在的输出更紧凑:

run, ((run, 3), (see, 3), (spot, 6))

see, ((spot, 2), )

spot, ((spot, 1), )

stripe 方法不仅在其表示上更紧凑,而且也生成更少、更简单的中间键,从而优化了数据的 sort、shuffle 等方面。然而,stripe 对象更庞大,在处理时间和序列化方面的开销都更大,特别是当 stripe 非常大时。stripe 的大小有上限,尤其当共现矩阵非常密集时,可能需要大量的内存来记录一个条目的数据。

大多数大数据计算都靠基于键的计算来提供和维护数据集之间的关系,以确保数据能合理分布在不同的 mapper 和 reducer 上。在 Spark 和 MapReduce 上执行大规模计算需要我们换个角度思考标准计算的传统方法,因为数据的规模实在太大。

3. 设计模式

设计模式是指针对特定编程挑战的通用、可重用解决方案。设计模式通常不限定语言,不仅指模式的实现细节,更指设计或构造策略。我们可以探索函数式设计模式,用于解决 MapReduce 和 Spark 中的并行计算问题。这些模式展示了可用于更复杂或特定于领域的角色的通用策略和原则。事实上,我们已经在用于计算单词共现的 pair 和 stripe 模式中看过一个例子。pair 和 stripe 都可以应用于更一般的计算。

MapReduce 作业有 23 种常见的设计模式,大致分为如下几类:

- 概要

根据聚合、分组、统计度量、索引或数据的其他高级视图,提供大型数据集的摘要视图。 - 过滤

基于一组固定的条件创建数据的子集或样本,并且不以任何方式修改原始数据。 - 数据组织

将记录重组为有意义的模式,不一定使用分组。此任务适合作为后续计算的第一步。 - 连接

从不同来源将相关数据收集到一个统一的整体。 - 元模式

为复杂或优化过的计算实现作业链和作业合并。这类模式是与其他模式相关联的模式。 - 输入和输出

使用数据处理模式对输入源的数据进行转换,以输出到一个不同的输出源。输入源和输出源可以位于 HDFS,也可以是其他数据源。

这些技术通常将输入数据分解或转换成用于最后一英里计算的较小数据源。

概要

概要尝试用尽可能简单的方法描述尽可能多的关于数据集的信息。描述性统计数据试图通过测量观测数据的集中趋势(平均值、中值)、分散情况(标准差)、分布

形状(偏度)或变量之间的依赖关系(相关性)来概括观察数据之间的关系。

基于键的计算对数据进行分组(另一种形式的概要),聚合某个通常能描述键的值,然后概要计算就进入了下一步。在很多情况下,概要只是更大的概括和预测的第一步,例如作为语言模型的单词共现的计算,或描述概率分布的频率分析。

从原理上讲,MapReduce 和 Spark 是应用一系列的概要,将具体的数据形式(每个单独的记录)转换为更一般的形式。大体来说,我们最熟悉的概要具备以下操作特征:

- 聚合(集合到单个值,如平均值、总和或最大值)

- 索引(将值映射到值集合的函数映射)

- 分组(将集合选择或划分成多个集合)

通过之前讨论的基于键的技术可以轻松实现分组,我们接下来将探索聚合和索引的模式。具体来说,我们将探索数据集的并行统计描述;然后,将探索两种索引技术:倒排索引和通过词频 - 逆文档频率(term frequency-inverse document frequency,TF-IDF)的文档概要。

①聚合

MapReduce 和 Spark 上下文中的聚合函数拥有两个输入值并生成一个输出值,它也满足交换律和结合律,因此可以并行计算。交换律表明顺序对二元运算没有影响,例如对给定的运算 ✣ 来说, a ✣ b = b ✣ a ;结合律表示无论输入如何分组,计算都是相同的,即( a ✣ b)✣ c = a ✣ ( b ✣ c )。

聚合一般是对一个集合应用操作以创建较小集合(聚集在一起),而 reduce 通常被认为是将集合 reduce 为单个值的操作。聚合也可以被认为是一系列更小的 reduce 组成的应用程序。在这种情况下,为什么结合性和交换性是实现并行不可或缺的条件也就显而易见了:给定一个 reduce a ✣ b ✣ c ✣ d ,由于网络或其他物理约束导致 shuffle 的结果不确定,这意味着顺序不能有影响。结合性允许一个进程计算 a ✣ b ,另一个进程计算 c ✣ d ,其中一个进程发送它们的结果以执行最终的 ✣ 操作。

标准数据集描述量有平均值、中值、众值、最小值、最大值、总和。其中,总和、最小值和最大值都容易实现,因为它们都满足结合律和交换律;但平均值、中值和众值不是。对中值和众值来说,通常需要先进行某种排序,而由于涉及除法,分组计算平均值会产生精度损失,在执行这些类型的分析时应格外小心。我们将使用一个 MapReduce 作业来描述整个数据集,而不是单独讨论这些计算。

②统计概要

现在,可以通过两个关键概念来分析处理数据集。首先,使用键作为关系来定义有意义的数据子集;其次,使用多种方法,包括作业链、键空间管理或 pair、stripe 等机制,同时实现多个计算。通过将实例按键分组并描述属性,可以简化大型数据集并对其执行概要分析。

我们将在一个批次中一次性运行所有的 6 个作业,包括计算总数、总和、平均值、标准差和范围(最小值和最大值),而不是为每个描述性指标单独实现一个 MapReduce 作业(代价高昂)。这时的基本策略是,为所有按键进行的计算映射一个计数器值的集合。然后,reducer 将每个操作分别应用于值集合中的每个项目,使用每个项目来计算最终输出(例如平均值取决于总数和总和)。这样的 mapper 的基本结构如下所示:

class StatsMapper(Mapper):

def map(self):

for key, value in self:

try:

value = float(value)

self.emit(key, (1, value, value ** 2))

except ValueError:

# 无法解析,忽略

pass

在这种情况下,直接进行 reduce 的三种操作是计算总数、总和和平方和。因此,该 mapper 针对每个键发射一次,1 用于计数,值用于求和,值的平方用于平方和。reducer 使用总数及总和来计算平均值,使用值计算范围,使用总数、总和以及平方和计算标准差,如下所示:

from ast import literal_eval as make_tuple

class StatsReducer(Reducer):

def reduce(self):

for key, values in self:

# 解析mapper发送过来的值

values = make_tuple(values)

count = 0

delay = 0.0

square = 0.0

minimum = None

maximum = None

for value in values:

count += value[0]

delay += value[1]

square += value[2]

if minimum is None or value[1] < minimum:

minimum = value[1]

if maximum is None or value[1] > maximum:

maximum = value[1]

mean = delay / float(count)

stddev = math.sqrt((square-(delay**2)/count)/count-1)

self.emit(key, (count, mean, stddev, minimum, maximum))

MapReduce 中的 reducer 可以访问与单个键相关联的所有值的可迭代对象,而在 Spark 中,必须对这个计算稍作修改。Spark 中的 reduce 不能应用以集合作为输入的操作,因而你必须每一次将操作应用于输入中的一对元素。又因为第一次应用的结果是第二次应用的第一个输入,所以操作必须满足结合律和交换律。例如,对于给定输入 [5, 2, 7] ,你不能简单地将 sum 应用于集合,而要这样使用 add : add(add(5, 2), 7) 。因此,必须为 mapper 输出的值添加最小值和最大值计数器,以分别记录 reduce 过程中的最小值和最大值,如下所示:

def counters(item):

"""

将键值对解析为键和概要计数器

计数器格式: (count, total, square, minimum, maximum)

"""

key, value = item # 分解item元组

try:

value = float(value)

self.emit(key, (1, value, value ** 2, value, value))

except ValueError:

# 无法解析,忽略

pass

def aggregation(first, second):

"""

对两个(key, counter)执行概要聚合

"""

count1, total1, squares1, min1, max1 = first

count2, total2, squares2, min2, max2 = second

minimum = min((min1, min2))

maximum = max((max1, max2))

count = count1 + count2

total = total1 + total2

squares = squares1 + squares2

return (count, total, squares, minimum, maximum)

def summary(aggregate):

"""

根据聚合结果,计算概要统计

"""

(key, (count, total, square, minimum, maximum)) = aggregate

mean = total / float(count)

stddev = math.sqrt((square-(total**2)/count)/count-1)

return (key, (count, mean, stddev, minimum, maximum))

def main(sc):

"""

Spark应用程序的主要分析过程

"""

# 给定一个键值对数据集,映射到counters

dataset = dataset.map(counters)

# 根据键执行概要聚合

dataset = dataset.reduceByKey(aggregation)

dataset = dataset.map(summary)

# 将结果写入磁盘

dataset.saveAsTextFile("dataset-summary")

reduceByKey 函数的规则使得 Spark 作业中的数据流不太一样。我们无法通过迭代跟踪最小值和最大值,而只能在计算结果中标注出最后看到的最小值和最大值,并在继续 reduce 时传播它们。因此,我们不能在聚合期间简单地执行最终计算,而是需要另一个 map 在聚合后的 RDD(小得多)上完成概要计算。

索引

与基于聚合的概要技术不同,索引采用多对多的方法。聚合将多个记录收集到单个记录中,而索引将多个记录与一个或多个索引相关联。在数据库中,索引是用于快速查找的专用数据结构,通常是二叉树(binary-tree,B-Tree)。在 Hadoop/Spark 中,索引也能发挥类似的功能,但是它们不会被维护和更新,而通常会成为需要快速查找的下游计算的第一步。

文本索引在 Hadoop 算法“万神殿”中地位特殊,这是由于 Hadoop 最初被用于创建搜索应用程序。我们将介绍两种类型的基于文本的索引:常见的倒排索引以及词频 - 逆文档频率(TF-IDF)。

①倒排索引

倒排索引是从索引项到文档集合中的位置的映射(与从文档到索引项映射的前向索引相反)。在全文搜索中,索引项是搜索项,通常是去除了停用词的词或数字。大多数搜索引擎还采用了某种词干提取 stemming)和 词 形 还 原(lemmatization): 具 有 相 同 含 义 的 多 个 词 被 分 类 到 单 个 词 类( 例 如 “running”“ran”“runs” 由单个词语 “run” 索引)。

最常见的倒排索引用例是搜索:它让搜索算法能快速检索出要排列和返回的文档子集,而免于扫描每个文档。例如,要想查询“running bear”,可以用索引查找包含搜索项“running”和包含搜索项“bear”的文档的交集。然后采用简单的排名系统来返回搜索项紧挨着,而不是相距很远的文档。

来考虑某个预处理后的文本,其中文档 ID 和行号作为键,行文本作为值。我们将这种预处理方式用于莎士比亚戏剧全集。具体来说,我们要创建一个人物关联索引。因此,不能将人物映射到已有的行,而是要针对人物和起始行进行概要分析,以便看出人物的出场顺序。语料库中的每一行表示如下:

hamlet@15261 HAMLET O, that this too too solid flesh would melt

hamlet@15261 Thaw and resolve itself into a dew!

行的第一部分是“戏剧名 @ 行号”标识符,然后是一个 TAB 字符( \t )、人物的名字、第二个 TAB 字符和剧本中的一行文本。如果相同的人物连续说了多行,则用两个 TAB 字符将标识符与文本分开。为了创建一个人物的倒排索引,我们将使用一个恒等 reducer 和下面的 mapper:

class CharacterIndexMapper(Mapper):

def map(self):

for row in self:

row = row.split("\t") # 使用制表符拆分

if not len(row) >= 3: continue # 确保数据格式

if row[1] != "":

# 如果存在人物,发射名字和docid/lineno

self.emit(row[1], row[0])

这个莎士比亚人物索引示例说明了索引的几个关键点:

- 首先,索引项可以是任意的(这里是人物名称);

- 其次,这种算法虽然非常简单,但它高度依赖于输入数据的结构(例如,我们知道要搜索 TAB 分片以找到人物名称);

- 最后,这个示例还使用了我们之前看到的一些 map 和 reduce 模式——恒等 reducer。

- 人物索引作业的输出是人物名称的列表,每个人名对应该人物每次开始说话的行的列表,这可以当作查找表或作为其他类型分析的输入使用。

② TF-IDF

词频 - 逆文档频率(TF-IDF)可能是目前最常用的基于文本的概要形式,它是一种指标,定义词条(单词)和作为较大语料库一部分的文档之间的关系。具体来说,它给出该词在其他文档中的相对频率,从而试着定义该词对于特定文档的重要性。

词频 tf i,j 是给定词条 i 在文档 j 中出现的次数,通常用于衡量该词与该文档的相关性。以一份关于美国政治的文件为例:一方面,我们可能会说像“民主”(democracy)或“选举”(election)这样的词语比“鲁米那”(luminal)这样的词语出现得更频繁,因此它们与文档的整体论述更相关;另一方面,词频本身将过度强调常见的词语,如“说”(speaking)——在给定组合语料库中,该词会出现于科学和政治类文档中。因此,词条 i 的文档频率 df i ,即该词条在多少文档中出现过,用于弥补词频的片面性。也就是说,包含词条的文档数与文档总数 N 的比例的倒数的对数与词频相乘。TF-IDF 分数高,则给定词经常在目标文档中出现,但不常在语料库的其他位置出现。文档 j 中的词条 i 的 TF-IDF 如下所示:

这种方法最初用于文档的主题建模,这是一种试图将主题相同的文档相互关联的聚类形式。不难看出,若文档共享高 TF-IDF 值的词,它们则可能彼此相关,因为这些词条不常出现在语料库的其余部分。

在索引中加入该算法,原因和加入简单的倒排索引类似:它创建了通常用于下游计算和机器学习的数据结构。此外,这个更复杂的示例突出了“使用作业链实现单个算法”这一内容。考虑到这一点,让我们来看看 TF-IDF 的 MapReduce 实现。我们的策略是使用键空间模式在三个作业中传播所需的数据:第一个作业使用简单的单词计数来计算每个文档的词频,该单词计数还维护该词的文档 ID;第二个作业计算该词一共出现在多少文档中;最后一个作业使用前两个作业传播到最后的信息计算 TF-IDF。第一个作业如下所示:

class TermFrequencyMapper(Mapper):

def __init__(self, *args, **kwargs):

"""

初始化分词器和停用词

"""

super(TermFrequencyMapper, self).__init__(*args, **kwargs)

self.stopwords = set()

self.tokenizer = re.compile(r'\W+')

# 从文本文件读取停用词

with open('stopwords.txt') as stopwords:

for line in stopwords:

self.stopwords.add(line.strip())

def tokenize(self, text):

"""

对一行文本进行分词和规范化(只产生非数字、标点和空字符串的非停用词)

"""

for word in re.split(self.tokenizer, text):

if word and word not in self.stopwords and word.isalpha():

yield word

def map(self):

for docid, line in self:

# 对每一行分词,并发射每个(word, docid)

for word in self.tokenize(line):

self.emit((word, docid), 1)

class SumReducer(Reducer):

def reduce(self):

for key, values in self:

total = sum(int(count) for count in values)

self.emit(key, total)

为了计算文档中的词,不能简单地使用空格分割行,而是要使用正则表达式对文本进行分词。我们还从 stopwords.txt 文件中读取了停用词列表,该文件需要包含在作业中。因此,我们的分词方法简单地使用正则表达式进行拆分,并过滤掉停用词、数字和标点符号。更高级的分词器也可以提取词干,或者实现归一化(例如全部变为小写)。第一个作业发射 (term, docid) 为键、频率为值的元组。第二个作业由一个 mapper 和一个 reducer 组成,如下所示:

class DocumentTermsMapper(Mapper):

def map(self):

for line in self:

key, tf = line.split(self.sep) # 将每一行拆分成键值对

word, docid = make_tuple(key) # 解析元组字符串

self.emit(word, (docid, tf, 1)) # 发射词和带计数器的数据

class DocumentTermsReducer(Reducer):

def reduce(self):

for word, values in self:

# 将values加载到内存,进行多次处理和解析

values = [make_tuple(value) for value in values]

# 第一次处理:计算词条的文档频率

terms = sum(int(item[2]) for item in values)

# 第二次处理:为与docid关联的每一个word发射一个值

for docid, tf, num in values:

self.emit((word, docid), (int(tf), terms))

此作业的 mapper 又是一个计数 mapper,用于求词条的文档频率的和;它还改变了键空间,维护针对该文档的词频并将文档 ID 添加到值中。这样,我们可以按词 reduce,其中每个值都对应一个文档。因此,reducer 需要遍历数据两次:一次求和,另一次执行每个文档的键空间更改。为了做到这一点,必须将元组 (docid, tf, count) 缓存在内存中,使用列表推导从生成器加载数据。如果许多文档都包含该词(如“the”这样的高频词),这个计算也许不能在内存中进行。也正因如此,停用词列表对 TF-IDF 的计算才如此重要。其他解决方法包括:将中间数据临时存储到磁盘;再实现一个中间 MapReduce 作业,一个作业用于求词条的文档频率的和,另一个用于改变键空间。

第三个作业如下所示:

class TFIDFMapper(Mapper):

def __init__(self, *args, **kwargs):

self.N = kwargs.pop("documents") # 语料库中的文档数量

super(TFIDFMapper, self).__init__(*args, **kwargs)

def map(self):

for line in self:

key, val = map(make_tuple, line.split(self.sep))

tf, n = (int(x) for x in val)

if n > 0:

idf = math.log(self.N/n)

self.emit(key, idf*tf)

最后一个作业是一个只有 map 的作业,因为我们已经有了计算用的键——由上一个

reducer 发射的 (word, docid) 对。使用恒等 reducer 就完全能够搞定。我们简单地将行解析为 int 的元组,并且只要频率大于零,就计算 TF-IDF。请注意,需要一条额外的信息——语料库中的文档数量,它在这个过程中没有参与计算。

这个任务虽然看似很复杂,但是将执行过程设想为数据流就能好很多:随着计算结果片段的产生,它们被添加到数据流中。键 / 值选择由计算中的下一步骤激发。而且最重要的是,这个计算仅仅遍历了一次原始输入,所以它支持作业的线性依赖。TF-IDF 计算的 Spark 实现也需要这种数据流思维模式,如下所示:

def tokenize(document, stopwords=None):

"""

分词并返回(docid, word)和一个计数

"""

def line_tokenizer(lines):

"""

逐行分词的内部生成器

"""

for line in lines:

for word in re.split(tokenizer, line):

if word and word not in stopwords.value and word.isalpha():

yield word

docid, lines = document

return [((docid, word), 1) for word in line_tokenizer(lines)]

def term_frequency(v1, v2):

"""

拆分复杂的值,计算词频

"""

docid, tf, count1 = v1

_docid, _tf, count2 = v2

return (docid, tf, count1 + count2)

def tfidf(args):

"""

给定((word, docid), (tf, n))参数,计算TF-IDF

请注意,必须提前定义N_DOCS,它是语料库中的文档数(n是word的文档频率)

"""

(key, (tf, n)) = args

if n > 0:

idf = math.log(N_DOCS/n)

return (key, idf*tf)

def main(sc):

"""

Spark应用程序的主要分析过程

"""

# 从数据集加载停用词

with open('stopwords.txt', 'r') as words:

stopwords = frozenset([

word.strip() for word in words.read().split("\n")

]) # frozenset()创建一个元素不变的集合

# 将停用词广播到集群

stopwords = sc.broadcast(stopwords)

# 第一阶段: 分词并计算文档频率

# 请注意: 假设有一个包含(docid, text)对的语料库corpus

docfreq = corpus.flatMap(partial(tokenize, stopwords=stopwords))

docfreq = docfreq.reduceByKey(add)

# 第二阶段: 计算词频,然后执行键空间更改

trmfreq = docfreq.map(lambda (key, tf): (key[1], (key[0], tf, 1)))

trmfreq = trmfreq.reduceByKey(term_frequency)

trmfreq = trmfreq.map(

lambda (word, (docid, tf, n)): ((word, docid), (tf, n))

)

# 第三阶段:为每个(word,document)对计算TF-IDF

tfidfs = trmfreq.map(tfidf)

Spark 作业同样从磁盘加载停用词,然后将其广播到集群的剩余部分。然后,就可以对默认参数为停用词广播值的 tokenize 偏函数应用 flatMap 操作。最后,将 Spark 实现的 term_frequency 和 tfidif 函数映射到每个文档。请注意,因为 reduceByKey 被调用了两次,并且需要在 tfidfs RDD 上应用某个最后的动作,所以此 Spark 作业同样具有三个数据流,和 MapReduce 作业一样。

我在看这段程序时对函数 term_frequency 产生了疑惑,因为我认为如果函数参数 v1 和 v2 的位置不同,那么产生的结果也会不同。后来觉得,因为 Spark 的聚合函数是支持交换律的,因此是不应该出现这种情况的。所以个人认为调用该函数后应该产生了两组值。因此,在调用 reduceByKey 后,对于同一 key(word),应该为每一组 docid, tf 产生一个相应的值。

过滤

过滤是粗粒度地减少下游计算数据的主要方法之一。与聚合通过宏观概览分组来缩小输入空间不同,过滤意在通过去除不需要的记录来缩小计算空间。因为 mapper 非常适合执行过滤,所以许多过滤任务常使用只有 map 的作业(不需要 reducer)。

另外一些过滤任务使用 reducer,收集具有代表性的数据集或根据值进行过滤。这种过滤包括查找最大的 n 个值或最小的 n 个值、去重或子选择。分析中非常常见的过滤任务是抽样:创建一个较小的、具有代表性的数据集,该数据集相对于较大的数据集分布良好(取决于你期望实现的分布类型)。开发中使用面向数据的子样本验证机器学习算法(例如交叉验证)或者进行其他统计计算。

我们通常可以将过滤实现为一个函数,它接受一条记录作为输入。如果评估返回 true,则发射记录,否则丢弃记录。我们将探讨无序的最大 / 最小 n 个元素、抽样技术,以及经布隆过滤器提高性能后的高级过滤。

① top n 记录

top n 记录(以及相反的 bottom n 记录)方法是一个基数比较过滤器,它需要一个 mapper 和一个 reducer。其基本原理是让每个 mapper 产生其 top n 个项目,然后 reducer 将从 mapper 产生的项目中同样选择 top n 个项目。如果 n 相对较小(至少与数据集的其余部分相比),单个 reducer 应该能够轻松处理该计算,因为每个 mapper 最多产生 n 条记录:

import bisect

class TopNMapper(Mapper):

def __init__(self, n, *args, **kwargs):

self.n = n

super(TopNMapper, self).__init__(*args, **kwargs)

def map(self):

items = []

for value in self:

# 维护有序的items列表(将值value按照顺序插入升序数组items中)

bisect.insort(items, value)

for item in items[-self.n:]:

# 从mapper发射前n个值

self.emit(None, item)

class TopNReducer(object):

def __init__(self, n, *args, **kwargs):

self.n = n

super(TopNReducer, self).__init__(*args, **kwargs)

def reduce(self):

items = []

for _, values in self:

for value in values:

bisect.insort(items, value)

for item in items[-self.n:]:

# 从reducer发射前n个值

self.emit(None, item)

这里的 mapper 和 reducer 都使用了 bisect 模块将值按升序插入列表。为了获得最大的 n 个值,使用了负索引的切片,从而选择有序列表中的最后 n 个值。要得到最小的 n 个值,可以简单地分片取出列表中的前 n 个值。使用 None 作为键可确保仅使用单个 reducer。

注意:

- Spark 拥有丰富的 RDD API,你可以使用 top 和 takeOrdered 动作,而不必自己实现;

- 对于 Spark 和 MapReduce,为了能进行排序,需要记录是可比较的;

- 这种方法最大的好处是不需要对整个数据集进行完整的排序;相反,每个 mapper 对它们自己的数据子集进行排序, 而 reducer 仅看到 mapper 数量 n 倍的数据。

②简单随机抽样

简单随机抽样是数据集的子集,数据集的每条记录属于该子集的可能性相同。在这种情况下,评估函数不关心记录的内容或结构,而是利用某种随机数生成器来评估是否发射记录。但问题来了,如何确保每个元素被选中的可能性相同呢?

如果需要的样本不是必须大小为 n ,而是包含百分之多少的记录就好,第一种方法是简单地使用随机数生成器来产生数字,并将其与期望的阈值大小进行比较。随机数生成器可用值的范围与阈值将共同决定大约发射百分之多少的记录。一般来说,随机数生成器返回的值在 0~1,因此与百分比的直接比较将产生预期的结果!例如,如果想要从数据集中采样20%,可以写如下的 mapper:

import random

class PercentSampleMapper(Mapper):

def __init__(self, *args, **kwargs):

self.percentage = kwargs.pop("percentage")

super(PercentSampleMapper, self).__init__(*args, **kwargs)

def map(self):

for _, val in self:

if random.random() < self.percentage:

self.emit(None, val)

if __name__ == '__main__':

mapper = PercentSampleMapper(sys.stdin, percentage=0.20)

mapper.map()

此作业将返回原始数据集的 20%左右,因为每条记录产生的随机数小于 0.2 的可能性相同,所以随机数小于 0.2 发生的可能性只大约为调用次数的 20%。如果这个作业运行时只有 mapper 而没有 reducer,许多小文件将被写入到磁盘,文件的数量与mapper 的数量相同。使用一个恒等 reducer 将确保这些值都被收集到单个文件中。

然而,如果想要一个大小精确为 n 的样本呢?为了确保每种方法机会均等,必须进行 n 次随机选择,每次选择一个元素,而不进行替换,以确保每条记录被选中的机会均等。一种方法是打乱记录,选择 0~ N - 1 的一个随机数,其中 N 是记录数,并发射在该索引处的记录。然后再次打乱,选择 0~ N - 2 的随机数, 依此类推。

一般来说,当你在 mapper 中使用任何概率分布时,你都必须小心,因为不能保证 mapper 在多次运行中看到相同的数据,也不能保证每个 mapper 获得相同数量的数据,更不能保证映射过程保持一个特定的顺序。这些不确定性会导致一些 mapper 预期的可能性过高或过低。对此(正确)的反应应该是将工作移动到一个 reducer 或聚合上进行,但这样做的话,在集群上多进程执行的优势可能会不复存在!要谨记,同一算法的串行和并行实现往往可能迥然不同!

为了并行化打乱(shuffle)方法,我们可以想象将一幅扑克牌平均发给了四位玩家。如果想要抽取 4 张牌,并且让每张牌被选中的可能性相等,可以简单地让每位玩家洗他们各自手中的牌,然后每个人给你发 4 张牌;然后,你从这 16 张牌中选择前 4 张。但如果你把牌从空中掷给每位玩家,而不是平均发给他们,则每位玩家得到的牌数可能不均等,但这种方法仍然能确保每张牌被选中的可能性相等。这时问题就变成了:该如何使用 Hadoop 来打乱记录,以便获得更好的性能?

答案是在 mapper 中为每个记录分配一个 0~1 的随机浮点数。随后,mapper 会发射前 n 个记录。同样,reducer 也只会发射它从 mapper 接收的前 n 个记录。虽然此机制仍然只允许单个 reducer,但是该 reducer 获取的是数据的有限子集(例如 mapper 数量的 n 倍),子集应该能够放入 reducer 的内存中。因为每行拥有 n 个最大随机数之一的概率相等,所以能获得一个随机样本:

import random, heapq

class SampleMapper(Mapper):

def __init__(self, n, *args, **kwargs):

self.n = n

super(SampleMapper, self).__init__(*args, **kwargs)

def map(self):

# 将堆初始化成一个包含n个0的列表

heap = [0 for x in range(self.n)]

for value in self:

# 维护一个堆,只包含最大的n个值

heapq.heappushpop(heap, (random.random(), value))

for item in heap:

# 发射抽样数据

self.emit(None, item)

class SampleReducer(Mapper):

def __init__(self, n, *args, **kwargs):

self.n = n

super(SampleReducer, self).__init__(*args, **kwargs)

def reduce(self):

# 将堆初始化为一个包含n个0的列表

heap = [0 for x in range(self.n)]

for _, values in self:

for value in values:

heapq.heappushpop(heap, make_tuple(value))

for item in heap:

# 发射抽样数据

self.emit(None, item[1])

我们本可以像使用 top n 记录方法时一样使用 bisect 模块,但是为了获取多样性,我们使用堆数据结构在内存中维持一个只有 n 个最大随机值的列表。这进一步减小了 mapper 和 reducer 的内存需求(对 reducer 尤为明显),使每次只有 n 个值保存在内存中。我们的 mapper(reducer 也类似)初始化了一个长度 n 值为零的列表。 heapq.heappushpop 函数将新值压入到堆中,然后弹出最小值(而且还比顺序调用 heapq.push 和 heapq.pop 快得多)。

③ 布隆过滤

布隆过滤器可以简单解释如下:

- BloomFilter 是一个通过多哈希函数映射到一张表的数据结构,能够快速地判断一个元素在一个集合内是否存在,具有很好的空间和时间效率。

它的原理如下: - BloomFilter 会开辟一个 m 位的位数组,开始所有数据全部置 0 。当一个元素过来时,能过多个哈希函数(h1,h2,h3…)计算不同的在哈希值,并通过哈希值找到对应的bitArray下标处,将里面的值 0 置为 1 。

- 注意,多个哈希函数计算出来的值必须 [0,m) 之中。

- 当判断对应值是否在集合中时,同样通过哈希函数求值,再去寻找数组的下标,如果所有下标都为1时,元素存在。当然也存在错误率。

布隆过滤器是一种高效的概率型数据结构,用于执行集合成员资格测试。布隆过滤器必须进行预先计算以收集“热值”(排除集的成员)——需要过滤的值。布隆过滤器的好处在于,它很紧凑(方便将大集合传输到集群上的每个 mapper),并且能快速测试成员资格。但是,布隆过滤器可能会误判(false positive);换句话说,它会把不属于集合的元素判断为属于集合。不过,它能保证不会排除任何属于集合的元素——没有漏报(false negative)。

因此,表达式 x in bloom 就意味着“ x 可能在集合中”或“ x 绝对不在集合中”。这也决定了布隆过滤器的构造,因为你要在过滤器集合的大小、数据中可能有多少元素,以及 mapper 和 reducer 的内存容量之间进行权衡。通过权衡,你能采用不同程度的模糊性。在构造大多数布隆过滤器时,可以设置误判的概率阈值,这会使布隆过滤器增大或缩小。

使用布隆过滤器的第一步是构建它。布隆过滤器对输入数据应用几个散列函数,然后根据散列值设置位数组中的位。一旦构建了位数组,就可以将散列函数应用于测试数据并查看相关位是否为 1,从而测试成员资格。根据一定的规则将不同的值映射到构造布隆过滤器的 reducer,可以并行化位数组的构造过程。

在这个例子中,我们将使用第三方库 pybloomfiltermmap ,可以通过 pip 安装。虽然 Python 有很多第三方布隆过滤器库,但这个库提供了创建可配置过滤器的最好的 API。来思考一个例子:基于推文是否包含词条和用户名白名单中的标签(#)或者 @ 回复,决定是否包含推文。为了创建布隆过滤器,从磁盘加载数据,并将布隆过滤器保存到一个 mmap 文件,如下所示:

from pybloomfilter import BloomFilter

bloom = BloomFilter(1000000, 0.1, 'twitter.bloom')

for prefix, path in (('#', 'hashtags.txt'), ('@', 'handles.txt')):

with open(path, 'r') as f:

for word in f:

bloom.add(prefix + word.strip())

本示例创建了一个有 100 万元素、错误率为 0.1 的布隆过滤器。它在底层使用这些参数来选择最优数 k (所需散列函数的数量),以保证给定容量下的错误阈值。性能和空间也存在折中——容量越小且错误率越低,需要的散列函数就越多,计算也就越慢;容量越大,布隆过滤器就必须越大。从磁盘文件读取标签和 Twitter 句柄(并给它们加上适当的前缀)后,布隆过滤器将被写入磁盘上一个名为 twitter.bloom 的文件中。

在 Spark 中使用它:

ELEMS = re.compile(r'[#@][\w\d]+')

def tweet_filter(tweet, bloom=None):

for elem in ELEMS.findall(tweet['text']):

if elem in bloom.value:

return True

# 从磁盘加载布隆过滤器,进行并行化

bloom = sc.broadcast(BloomFilter.open('twitter.bloom'))

# 从磁盘加载JSON推文,进行解析

tweets = sc.textFile('tweets').map(json.loads)

tweets = tweets.filter(partial(tweet_filter, bloom=bloom))

我们的推文过滤器是使用 functools.partial 函数创建的,该函数创建了一个拥有布隆过滤器广播变量的闭包,而布隆过滤器是从驱动程序所处主机的磁盘加载的。 tweet_filter 函数使用一个正则表达式提取所有标签和 @ 回复,然后检查它们是否在布隆过滤器中;如果是,则返回 True ,从而保留 RDD 中与白名单匹配的所有元素。

布隆过滤器可能是常用于 Hadoop 分析的最复杂的数据结构。此处提到是为了表明性能和正确性的结合将如何影响分布式计算。作为实践大数据的数据科学家,你会发现随机方法能助力及时计算,这是进一步分析所需要的。

4.迈向最后一英里分析

以上,我们研究了许多数据分析模式,从键计算到聚合、过滤的常规模式。这里面有一个宏观主题:将数据从较大的输入分解为较小的、更易于管理的输入。使用我们讨论过的工具,本节将讨论端到端预测模型的计算策略。

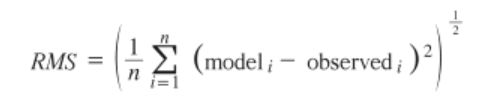

许多机器学习技术在底层使用广义线性模型(generalized linear model,GLM)来估计给定输入数据和误差分布的响应值(response variable)。最常用的 GLM 是线性回归(还有逻辑回归和泊松回归),为模拟因变量 Y 和一个或多个自变量 X 之间的连续关系建模。该关系由一组系数和一个误差项表示如下:

系数 β 的计算是将模型拟合到现有数据的主要目标。这通常通过一个优化算法来完成——根据给定的某个数据集的 X 和 Y 的观察值,该算法能找到一组最小化错误量的系数。请注意,线性回归可以被认为是一种有监督机器学习方法,因为“正确”答案(拟合模型的 X 和 Y 变量)是预先已知的。

普通最小二乘法和随机梯度下降这样的优化算法是迭代的;也就是说,它们要多次遍历数据。在大数据环境中,每次优化迭代都多次读取完整数据集可能会非常耗时,在按需分析或开发中尤其明显。Spark 在 MLlib 中提供的分布式机器学习算法和内存计算让情况稍有好转。但如果碰上极大的数据集或极小的时间窗口,即使是 Spark 也需要花费很长时间;如果 Spark 没有你想要实现的模型或分布式算法,那么分析方法的选择范围将因分布式编程的诸多困难而受限。

通用的解决方案是:将输入数据集转换为更小的数据集,让它可以在内存中被处理,从而达到分解问题的目的。一旦数据集被缩小成内存计算,它就可以使用标准技术进行分析,然后在整个数据集中验证。对于线性回归,我们可以对数据集进行简单随机抽样,对样本执行特征提取,构建线性模型,然后通过计算整个数据集的均方误差来验证模型。

模型拟合

考虑一个具体的例子:我们有一个新闻报道或博文的数据集,现在要预测接下来的 24 小时内的评论数量。针对网络爬取的原始 HTML 页面,数据流应如下所示:

- 解析 HTML 页面获取元数据,并将主文本与评论分开。

- 创建一个从时间戳到博文评论 / 评论者的索引。

- 使用该索引为模型创建实例,实例是一篇博文以及 24 小时滑动窗口内的评论。

- 将实例与主文本数据(评论和博文)连接起来。

- 提取每个实例的特征(例如,前 24 小时的评论数、博文长度、从窗口到发布时间之间的时间、bag of words 特征、星期几,等等)。

- 对实例特征取样。

- 使用 Scikit-Learn 或 Statsmodels 在内存中构建一个线性模型。

- 计算整个数据集的实例特征的均方误差或者决定系数。

该数据流表明,许多预处理作业仅需要运行一次或几次(例如,特征提取需要在整个特征分析生命周期中反复运行)。然而,模型抽样和验证过程可以例行运行。一旦启动并运行这个模型,它甚至可以在线运行,当新的信息被馈送到数据流水线中时,该模型重新进行拟合和验证。

此时,假设我们已经成功得到一个具有所有特征的数据集。使用前面介绍过的抽样技术,可以获取更小的数据集,将其保存到磁盘,并使用 Scikit-Learn 构建一个线性模型:

import pickle

import numpy as np

from sklearn import linear_model

# 从磁盘的制表符分割文件加载数据

data = np.loadtxt('sample.txt')

# 目标是第一列(键),X是值

y = data[:,0]

X = data[:,1:]

# 实例化并拟合线性模型

clf = linear_model.Ridge(alpha=1.0, fit_intercept=True)

clf.fit(X, y)

# 将模型作为pickle写入磁盘

with open('clf.pickle', 'wb') as f:

pickle.dump(clf, f)

这段代码使用 np.loadtxt 函数从磁盘加载样本数据,在这个例子中是包含实例的制表符分隔文件,第一列是目标值,其余列是特征。这种类型的输出与 Spark 和 MapReduce 将键值对写入磁盘时的格式吻合,但是你必须将集群中的数据收集到单个文件,并确保文件格式正确。然后,数据被拟合到岭回归,这是一种使用正则化来防止过拟合的线性回归模型。

模型验证

为了在集群中评估这个模型的效果,我们有两个选择。第一种,将 Scikit-Learn 线性模型属性 clf.coef_ (系数)和 clf.intercept_ (错误项)写入磁盘,然后将这些参数加载到我们的 MapReduce 或 Spark 作业中,并自行计算误差。然而,这需要为每个模型实现一个预测函数。第二种,使用 pickle 模块将模型转储到磁盘,然后将其加载到集群中的每个节点供预测使用。现在就来编写 Scikit-Learn 模型误差估计模板。

要想验证模型,就必须计算整个数据集的均方误差(mean square error,MSE)。误差被定义为实际值和预测值之间的差值 y - ŷ。为了确保没有负值(这将减少误差),我们将计算平方误差的均值。为此,只需要一个计算平均值的 reducer 和一个加载模型并计算均方误差的 mapper 即可:

import pickle

class MSEMapper(Mapper):

def __init__(self, model, *args, **kwargs):

super(MSEMapper, self).__init__(*args, **kwargs)

# 从磁盘加载模型

with open(model, 'rb') as f:

self.clf = pickle.load(f)

def map(self):

for row in self:

# 解析行内浮点数值

row = map(float, row)

y = row[0]

X = row[1:]

yhat = self.clf.predict(x)

self.emit(_, (y-yhat) ** 2)

可以在 Spark 中使用一个累加器来求平方误差之和,并将模型广播到集群上,如下所示:

def cost(row, clf=None):

"""

计算给定行的平方误差

"""

return (row[0] - clf.predict(row[1:])) ** 2

def main(sc):

"""

Spark应用程序的主要分析过程

"""

# 从pickle文件加载模型

with open('clf.pickle', 'rb') as f:

clf = sc.broadcast(model.load(f))

# 创建累加器,求平方误差的和

sum_square_error = sc.accumulator(0)

# 加载和解析博客数据

blogs = sc.textFile("blogData").map(float)

# 映射cost函数,累加平方误差

error = blogs.map(partial(cost, clf=clf))

error.foreach(lambda cost: sum_square_error.add(cost))

# 计算平均平方误差并打印

print sum_square_error.value / error.count()

使用 pickle 模块来序列化 Scikit-Learn 模型是使用极大数据集进行机器学习的好开始。工作流通常是将经过序列化的模型存储在数据库 blob 字段中,然后根据需要在集群中进行加载和验证。更高级的大数据和扩展需要像 Mahout 和 Spark 的 MLlib 这样的机器学习库。无论采用哪种方式,抽样、训练、验证策略都是行之有效的分析方法。

九、数据挖掘和数据仓储

这一章我们将讨论数据挖掘和数据仓储,并就关系型和列式数据存储及查询分别介绍 Hive 和 HBase。

作为数据分析师,我们通常更愿意专注于能获取有意义见解的数据挖掘任务,或者对经过整理(curated)、清洗和分段(staging)的数据应用预测建模方法。然而,在大多数传统企业的数据环境中,在进行任何有意义的数据分析之前,都需要投入大量的工程和技术资源来收集这些数据,并将其组织到统一的数据仓库中。

因此,企业数据仓库(enterprise data warehouse,EDW)已经成为大多数企业处理和分析大规模数据的关键。然而,由于绝大多数 EDW 使用某种形式的关系数据库管理系统(RDBMS)作为主要的存储工具和查询引擎,因此在开展新的数据分析项目时,将在前期模式设计和 ETL(数据仓库技术,ETL 是英文 Extract-Transform-Load 的缩写,用来描述将数据从来源端经过抽取(extract)、转换(transform)、加载(load)至目的端的过程)操作上花费大量精力。据估计,ETL 将占数据仓储成本、风险和实施时间的 70%~80%。 这种开销导致即使是最一般的数据分析原型设计或探索性分析也成本高昂。

当我们需要存储和分析的数据的数据类型急剧增加时——这些数据可以是非结构化的或半结构化的——RDBMS 就暴露了另一个局限性:数据的速度和多样性常常需要“即时”地演进模式,这要被传统的 DW 支持是件非常困难的事。

正是出于这些原因,Hadoop 成为了数据仓储和数据挖掘领域最具革命性的技术。它将存储与处理分离,使公司能够将其原始数据存储在 HDFS 中,而不需要通过 ETL 将数据整合到一个统一的数据模型中。此外,通过使用 YARN 的通用处理层,我们能够从多个角度直接访问和查询原始数据,还能根据特定用例使用不同的方法(SQL、NoSQL)。因此,Hadoop 不仅支持探索性分析和数据挖掘原型设计,还为数据和分析的新类型打开了大门。

1. Hive 结构化数据查询

Apache Hive 是一个建立在 Hadoop 之上的“数据仓储”框架。Hive 为数据分析人员提供了熟悉的、基于 SQL 的 Hadoop 接口,使他们能为 HDFS 中的数据添加结构化模式,并能使用 SQL 查询访问和分析该数据。Hive 使熟练使用 SQL 的开发人员能发挥 Hadoop 的可扩展性和弹性,而不需要他们学习 Java 或原生的 MapReduce API。

Hive 提供了自己的 SQL 方言,被称为 Hive 查询语言(Hive Query Language,HQL)。HQL 支持许多常用的 SQL 语句,包括数据定义语句(DDL,例如 CREATE DATABASE/SCHEMA/TABLE )、数据操作语句(DML,例如 INSERT、UPDATE 和 LOAD )和数据检索查询 (例如 SELECT )。Hive 还支持集成用户定义函数,这些函数可以由 Java 或 Hadoop Streaming 支持的任何语言编写,扩展了 HQL 的内置功能。

Hive 命令和 HQL 查询被编译成执行计划或一系列 HDFS 操作和 / 或 MapReduce 作业,然后在 Hadoop 集群上执行。因此,Hive 继承了 HDFS 和 MapReduce 的某些限制,无法提供传统数据库管理系统应有的关键联机事务处理(online transaction processing,OLTP)功

能。具体来说,因为 HDFS 是写一次,读多次(WORM)文件系统,并且不提供就地文件更新,因此 Hive 执行起行级插入、更新或删除不是非常高效。事实上,这些行级更新最近才被 Hive 的 0.14.0 版本支持。

此外,为了满足在集群上生成和启动编译的 MapReduce 作业所需的开销,Hive 查询需要更长的延迟;在传统 RDBMS 上几秒就能完成的小型查询在 Hive 中可能需要几分钟才能完成。好在 Hive 提供了所有基于 Hadoop 的应用程序都应有的高可扩展性和高吞吐量。因此,它

非常适用于联机分析处理(online analytical processing,OLAP)的批处理任务,处理 TB级甚至 PB 级的超大数据集。

Hive命令行接口(CLI)

Hive 的安装包里有一个方便的命令行接口(command-line interface,CLI),我们将使用它与 Hive 交互,并运行 HQL 语句。从 $HIVE_HOME 启动 Hive CLI:

~$ cd $HIVE_HOME

/srv/hive$ bin/hive

这将启动 CLI 并引导启动 logger(如果配置了)和 Hive 历史记录文件,并最终显示 Hive CLI 提示:

hive>

使用以下命令可以随时退出 Hive CLI:

hive> exit;

通过传递文件名选项 -f 和要执行的脚本的路径,Hive 也可以直接从命令行以非交互模式运行:

~$ hive -f ~/hadoop-fundamentals/hive/init.hql

~$ hive -f ~/hadoop-fundamentals/hive/top_50_players_by_homeruns.hql >>

~/homeruns.tsv

此外,带引号的查询字符串选项 -e 让你能从命令行运行内联命令:

~$ hive -e 'SHOW DATABASES;'

可以使用 -H 标志查看 CLI 的 Hive 选项的完整列表:

~$ hive -H

| usage: hive | |

|---|---|

| -d,–define |

Variable substitution to apply to hive commands. e.g. -d A=B or --define A=B |

| –database < databasename > | Specify the database to use |

| -e < quoted-query-string > | SQL from command line |

| -f < filename > | SQL from files |

| -H,–help | Print help information |

| -h < hostname > | connecting to Hive Server on remote host |

| –hiveconf < property=value > | Use value for given property |

| –hivevar < key=value > | Variable substitution to apply to hive commands. e.g. --hivevar A=B |

| -i < filename > | Initialization SQL file |

| -p < port > | connecting to Hive Server on port number |

| -S,–silent | Silent mode in interactive shell |

| -v,–verbose | Verbose mode (echo executed SQL to the console) |

非交互模式为运行已存脚本提供了方便,但是 CLI 使我们能够在 Hive 中轻松地调试和迭代查询。

Hive查询语言

在本节中,我们将通过编写 HQL 语句,创建 Hive 数据库、将 HDFS 中的数据加载到数据库,以及查询数据进行分析。

①创建数据库

在 Hive 中创建数据库与在基于 SQL 的 RDBMS 中创建数据库非常相似,使用 CREATE DATABASE 或 CREATE SCHEMA 语句:

hive> CREATE DATABASE log_data;

当 Hive 创建新数据库时,模式定义数据存储在 Hive Metastore 中。如果 Metastore 中已经有该数据库,Hive 将抛出错误。我们可以通过使用 IF NOT EXISTS 来检查数据库是否存在:

hive> CREATE DATABASE IF NOT EXISTS log_data;

然后运行 SHOW DATABASES 来验证数据库是否已被创建。Hive 将返回在 Metastore 中找到的所有数据库,以及默认的 Hive 数据库:

hive> SHOW DATABASES;

OK

default

log_data

Time taken: 0.085 seconds, Fetched: 2 row(s)

此外,可以使用 USE 命令设置工作数据库:

hive> USE log_data;

这样就可以在 Hive 中创建一个数据库。可以通过在数据库中创建表定义,描述数据的结构。

②创建表

Hive 提供了一个类似 SQL 的 CREATE TABLE 语句,最简单的形式由一个表名和一个列定义构成:

CREATE TABLE apache_log (

host STRING,

identity STRING,

user STRING,

time STRING,

request STRING,

status STRING,

size STRING,

referer STRING,

agent STRING

);

但是由于 Hive 数据存储在文件系统,通常在 HDFS 或本地文件系统中,所以 CREATE TABLE 命令还使用可选子句指定行格式,使用 ROW FORMAT 子句告诉 Hive 如何读取文件中的每一行并映射到我们的列。例如,可以指明数据位于由制表符分隔字段的文件中:

hive> CREATE TABLE shakespeare (

lineno STRING,

linetext STRING

)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY '\t';

Apache 访问日志的每行根据通用日志格式进行结构化。好在 Hive 为我们提供了一种方法,能将正则表达式应用于已知格式的记录,从而将每行反序列化或解析为各个组成字段。我们将使用 Hive 的 serializer-deserializer 行格式选项 SERDE 和 RegexSerDe 库来指定反序列化,并将字段映射到表列的正则表达式。需要手动将 lib 文件夹中的 hive-serde JAR 添加到当前 hive 会话,以便使用 RegexSerDe 包:

hive> ADD JAR /srv/hive/lib/hive-serde-0.13.1.jar;

现在删除之前创建的 apache_log 表,并使用自定义序列化器重新创建它:

hive> DROP TABLE apache_log;

hive> CREATE TABLE apache_log (

host STRING,

identity STRING,

user STRING,

time STRING,

request STRING,

status STRING,

size STRING,

referer STRING,

agent STRING

)

ROW FORMAT SERDE 'org.apache.hadoop.hive.serde2.RegexSerDe'

WITH SERDEPROPERTIES ("input.regex" = "([^ ]*) ([^ ]*) ([^ ]*) (-|\\[[^\\]]*\\])([^ \"]*|\"[^\"]*\") (-|[0-9]*) (-|[0-9]*)(?: ([^ \"]*|\".*\") ([^ \"]*|\".*\"))?", "output.format.string" = "%1$s %2$s %3$s %4$s %5$s %6$s %7$s %8$s %9$s")

STORED AS TEXTFILE;

创建之后就可以使用 DESCRIBE 来验证表定义:

hive> DESCRIBE apache_log;

OK

host string from deserializer

identity string from deserializer

user string from deserializer

time string from deserializer

request string from deserializer

status string from deserializer

size string from deserializer

referrer string from deserializer

agent string from deserializer

Time taken: 0.553 seconds, Fetched: 9 row(s)

请注意,在这个表中,所有列都使用 Hive 原始数据类型 string 定义。Hive 支持 SQL 用户熟悉的许多其他原始数据类型,下表列举了这些原始数据类型:

| 类型 | 描述 | 举例 |

|---|---|---|

| TINYINT | 8 位带符号整数,从 -128 到 127 | 127 |

| SMALLINT | 16 位带符号整数,从 -32768 到 32767 | 32767 |

| INT | 32 位带符号整数 | 2147483647 |

| BIGINT | 64 位带符号整数 | 9223372036854775807 |

| FLOAT | 32 位单精度浮点数 | 1.99 |

| DOUBLE | 64 位双精度浮点数 | 3.14159265359 |

| BOOLEAN | true 或 false | true |

| STRING | 最大 2GB 的字符串 | hello world |

| TIMESTAMP | 纳秒级时间戳 | 1400561325 |

除原始数据类型之外,Hive 还支持可以存储值集合的复杂数据类型,下表列举了这些类型:

| 类型 | 描述 | 举例 |

|---|---|---|

| ARRAY | 有序集合,数组中元素的类型必须相同 | recipients ARRAY < email:STRING > |

| MAP | 无序键值对集合,键必须是原始数据类型,但值可以是任意类型 | files MAP < filename:STRING,size:INT > |

| STRUCT | 任意类型元素集合 | address STRUCT < street:STRING,city:STRING,state: STRING,zip:INT > |

关系数据库通常不支持集合类型,而是将相关集合存储在单独的表中,以维持第一范式(一言以蔽之,第一范式的数据表必须是二维数据表),最小化数据重复和数据不一致的风险。然而,在像 Hive 这样的通过顺序扫描磁盘来处理大量非结构化数据的大数据系统中,读取嵌入集合能大大提高检索性能。

③加载数据

创建表和定义模式之后,就可以将数据加载到 Hive 了。请注意 Hive 和传统 RDBMS 在强化模式(schema enforcement)上有一个重要区别:Hive 不会对数据执行任何证明它是否符合表模式的验证,也不会在将数据加载到表中时执行任何转换。

传统的关系数据库通过拒绝写入不符合模式定义的数据,强制执行写时模式(schema on write);而 Hive 对查询只强制执行读时模式(schema on read)。在读取数据文件时,如果文件结构与定义的模式不匹配,Hive 通常会为缺失的或类型不匹配的字段返回 null 值,并尝试从错误中恢复。读时模式初始加载的速度非常快,因为数据不以数据库的内部格式读取、解析和序列化到磁盘。加载操作纯粹是将数据文件移动到 Hive 表中对应位置的复制 / 移动操作。

Hive 中的数据加载通过 LOAD DATA 命令批量完成,也可以使用 INSERT 命令插入另一个查询的结果完成。首先,将 Apache 日志数据文件复制到 HDFS,然后将其加载到之前创建的表中:

~$ hadoop fs –mkdir statistics

~$ hadoop fs –mkdir statistics/log_data

~$ hadoop fs –copyFromLocal ~/hadoop-fundamentals/data/log_data/apache.log statistics/log_data/

可以使用 tail 命令验证 apache.log 是否成功上传到了 HDFS:

~$ hadoop fs –tail statistics/log_data/apache.log

一旦文件上传到了 HDFS,就返回 Hive CLI 并使用 log_data 数据库:

~$ $HIVE_HOME/bin/hive

hive> use log_data;

OK

Time taken: 0.221 seconds

使用 LOAD DATA 命令,并指定日志文件的 HDFS 路径,将内容写入到 apache_log 表中:

hive> LOAD DATA INPATH 'statistics/log-data/apache.log' OVERWRITE INTO TABLE apache_log;

Loading data to table log_data.apache_log

rmr: DEPRECATED: Please use 'rm -r' instead.

Deleted hdfs://localhost:9000/user/hive/warehouse/log_data.db/apache_log

Table log_data.apache_log stats: [numFiles=1, numRows=0, totalSize=52276758, rawDataSize=0]

OK

Time taken: 0.902 seconds

LOAD DATA 是 Hive 的批量加载命令。 INPATH 携带一个指向默认文件系统(本例中为 HDFS)中的路径的参数。我们还可以使用 LOCAL INPATH 来指定本地文件系统上的路径。Hive 将文件移动到仓库位置。如果使用 OVERWRITE 关键字,则目标表中的所有已有数据将被删除并由数据文件输入替换;否则,新数据将被添加到表中。

数据复制并加载后,Hive 输出了一些关于加载数据的统计信息;虽然报告的 num_rows 为 0,但你可以通过运行 SELECT COUNT 来验证实际行数(省略输出):

hive> SELECT COUNT(1) FROM apache_log;

Total MapReduce jobs = 1 # 执行了一个 MapReduce 作业来执行聚合

Launching Job 1 out of 1

...

OK

726739

Time taken: 34.666 seconds, Fetched: 1 row(s)

可以看到,这个 Hive 查询运行时,实际上执行了一个 MapReduce 作业来执行聚合。在 MapReduce 作业执行后,你可以看到 apache_log 表目前有 726739 行。

Hive数据分析

我们已经定义了一个模式并将数据加载到了 Hive 中,现在就可以对 Hive 数据库运行 HQL 查询,从而对数据进行实际的数据分析了。我们将编写和运行 HQL 查询,根据先前导入的 Apache 访问日志数据,确定远程流量访问的高峰月份。

①分组

我们已经将一份 Apache 访问日志文件加载到了名为 apache_log 的 Hive 表中,其中包含 Apache Common Log 格式的 Web 日志数据:

127.0.0.1 - frank [10/Oct/2000:13:55:36 -0700] "GET /apache_pb.gif HTTP/1.0" 2002326

考虑一个计算每个自然月访问数的 MapReduce 程序。尽管这是一个非常简单的分组计数问题,但是要实现这个 MapReduce 程序仍然需要耗费不少的精力——除了要编写 mapper 、reducer 和配置作业的 main 函数之外,还要编译和创建 JAR 文件。但有了 Hive 的话,这

个问题将与运行 SQL 的 GROUP BY 查询一样简单直观:

hive> SELECT

month,

count(1) AS count

FROM (SELECT split(time, '/')[1] AS month FROM apache_log) l

GROUP BY month

ORDER BY count DESC;

OK

Mar 99717

Sep 89083

Feb 72088

Aug 66058

Apr 64984

May 63753

Jul 54920

Jun 53682

Oct 45892

Jan 43635

Nov 41235

Dec 29789

NULL 1903

Time taken: 84.77 seconds, Fetched: 13 row(s)

Hive 查询和 MapReduce 程序都要对输入进行分词,并提取月份令牌作为聚合字段。不仅如此,Hive 还提供了简洁自然的查询接口来执行分组;又因为数据被结构化为 Hive 表,所以我们可以轻松地在其他任何字段上执行其他即时查询:

hive> SELECT host, count(1) AS count

FROM apache_log

GROUP BY host

ORDER BY count;

除了计数之外,Hive 还支持其他聚合函数来计算数字列的总和、平均值、最小值、最大值以及方差、标准差和协方差等统计聚合。使用这些内置聚合函数时,可以通过将以下属性设置为 true 来提高聚合查询的性能:

hive> SET hive.map.aggr = true;

这种设置告诉 Hive 在 map 阶段执行“顶层”(top-level)聚合,这与执行 GROUP BY 后再进行聚合不同。但请注意,此设置将需要更多内存。Hive 还提供了轻松存储计算结果的捷径。你可以创建新的表来存储这些查询返回的结果,以便进行记录保存和分析:

hive> CREATE TABLE

remote_hits_by_month

AS

SELECT

month,

count(1) AS count

FROM (

SELECT split(time, '/')[1] AS month

FROM apache_log

WHERE host == 'remote'

) l

GROUP BY month

ORDER BY count DESC;

CREATE TABLE AS SELECT (CTAS)操作非常有用,它能从现有 Hive 表过滤和聚合,从而派生并构建新表。

②聚合和连接

当在单个结构化的数据集中查询和聚合数据时,Hive 能提供一些便利。但在多个数据集之上执行更复杂的聚合时,Hive 才能真正物尽其用。我们曾开发过一个 MapReduce 程序,根据交通研究与创新技术管理局(RITA)收集的航班数据分析美国航空公司的准点情况。我们曾将该准点数据集进行了归一化,让单个数据文件包含所有必需的数据;但事实上,从 RITA 网站下载的数据包括航空公司和飞机的代码,它们必须分别参照单独的查找数据集。

ontime_flights.tsv 中的准点航班数据的每一行都包含一个表示航空公司代码(如 19805)的整数值和一个表示飞机代码(如“AA”)的字符串值。航空公司代码可以与 airlines.tsv 文件中相应的代码进行连接,该文件每行包含代码和相应的描述:

19805 American Airlines Inc.: AA

同理,飞机代码可以与 carriers.tsv 中对应的代码进行连接,该文件包含代码、相应的航空公司名称和生效日期:

AA American Airlines Inc. (1960 - )

要在 MapReduce 程序中实现这些连接,需要在 map 端加载查找表到内存中进行连接,或者在 reduce 端连接。这两种方法都需要耗费大量精力编写配置作业的 MapReduce 代码;但是通过 Hive,则可以简单地将这些附加的查找数据集加载到单独的表中,并在 SQL 查询中执行连接。

假设我们已经将数据文件上传到了 HDFS 或本地文件系统。首先,为航班数据创建一个新的数据库:

hive> CREATE DATABASE flight_data;

OK

Time taken: 0.741 seconds

然后,为准点数据和查找表定义模式并加载数据(出于可读性考虑,省略输出和添加换行):

hive> CREATE TABLE flights (

flight_date DATE,

airline_code INT,

carrier_code STRING,

origin STRING,

dest STRING,

depart_time INT,

depart_delta INT,

depart_delay INT,

arrive_time INT,

arrive_delta INT,

arrive_delay INT,

is_cancelled BOOLEAN,

cancellation_code STRING,

distance INT,

carrier_delay INT,

weather_delay INT,

nas_delay INT,

security_delay INT,

late_aircraft_delay INT

)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY '\t'

STORED AS TEXTFILE;

hive> CREATE TABLE airlines (

code INT,

description STRING

)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY '\t'

STORED AS TEXTFILE;

hive> CREATE TABLE carriers (

code STRING,

description STRING

)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY '\t'

STORED AS TEXTFILE;

hive> CREATE TABLE cancellation_reasons (

code STRING,

description STRING

)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY '\t'

STORED AS TEXTFILE;

hive> LOAD DATA LOCAL INPATH '${env:HOME}/hadoop-fundamentals/data/flight_data/ontime_flights.tsv'

OVERWRITE INTO TABLE flights;

hive> LOAD DATA LOCAL INPATH '${env:HOME}/hadoop-fundamentals/data/flight_data/airlines.tsv'

OVERWRITE INTO TABLE airlines;

hive> LOAD DATA LOCAL INPATH '${env:HOME}/hadoop-fundamentals/data/flight_data/carriers.tsv'

OVERWRITE INTO TABLE carriers;

hive> LOAD DATA LOCAL INPATH '${env:HOME}/hadoop-fundamentals/data/flight_data/cancellation_reasons.tsv'

OVERWRITE INTO TABLE cancellation_reasons;

要获取航空公司及其各自的平均起飞延误时间列表,只需要基于航空公司代码对航班和航空公司执行 SQL JOIN ,然后使用聚合函数 AVG() 计算按航空公司描述分组的平均 depart_delay:

hive> SELECT

a.description,

AVG(f.depart_delay)

FROM airlines a

JOIN flights f ON a.code = f.airline_code

GROUP BY a.description;

AirTran Airways Corporation: FL 8.035840978593273

Alaska Airlines Inc.: AS 4.746143501305276

American Airlines Inc.: AA 10.085038790027395

American Eagle Airlines Inc.: MQ 11.048787878787879

Delta Air Lines Inc.: DL 8.149843785719728

ExpressJet Airlines Inc.: EV 15.762459814292642

Frontier Airlines Inc.: F9 12.319591084296967

Hawaiian Airlines Inc.: HA 2.872051586628203

JetBlue Airways: B6 12.090553084509766

SkyWest Airlines Inc.: OO 10.086447897294379

Southwest Airlines Co.: WN 14.722817981677437

US Airways Inc.: US 7.363223345079652

United Air Lines Inc.: UA 11.124291343587137

Virgin America: VX 9.98681228106326

Time taken: 22.786 seconds, Fetched: 14 row(s)

如你所见,与在 MapReduce 中执行连接相比,在 Hive 中执行连接可以显著减少编码工作量。更重要的是,我们定义的结构化 Hive 数据模式使我们能够轻松添加或更改查询。让我们来修改查询,返回按飞机分组的平均起飞延误时间:

hive> SELECT

c.description,

AVG(f.depart_delay)

FROM carriers c

JOIN flights f ON c.code = f.carrier_code

GROUP BY c.description;

Aces Airlines (1992 - 2003) 9.98681228106326

AirTran Airways Corporation (1994 - ) 8.035840978593273

Alaska Airlines Inc. (1960 - ) 4.746143501305276

American Airlines Inc. (1960 - ) 10.085038790027395

American Eagle Airlines Inc. (1998 - ) 11.048787878787879

Atlantic Southeast Airlines (1993 - 2011) 15.762459814292642

Delta Air Lines Inc. (1960 - ) 8.149843785719728

ExpressJet Airlines Inc. (2012 - ) 15.762459814292642

Frontier Airlines Inc. (1960 - 1986) 8.035840978593273

Frontier Airlines Inc. (1994 - ) 12.319591084296967

Hawaiian Airlines Inc. (1960 - ) 2.872051586628203

JetBlue Airways (2000 - ) 12.090553084509766

Simmons Airlines (1991 - 1998) 11.048787878787879

SkyWest Airlines Inc. (2003 - ) 10.086447897294379

Southwest Airlines Co. (1979 - ) 14.722817981677437

US Airways Inc. (1997 - ) 7.363223345079652

USAir (1988 - 1997) 7.363223345079652

United Air Lines Inc. (1960 - ) 11.124291343587137

Virgin America (2007 - ) 9.98681228106326

Time taken: 22.76 seconds, Fetched: 19 row(s)

Hive 可能比较适用于这些使用场景:使用的数据集的格式是结构化的、基于表格的;要进行的计算是面向批处理的 OLAP 查询,而不是实时的、面向行的 OLTP 事务。

2. HBase

使用 Hive 可以对存储在 HDFS 中的大型结构化数据集执行基于 SQL 的分析。虽然 Hive 在 Hadoop 中提供了一个熟悉的数据操作范式,但它并不会改变存储和处理模式,而是仍然以批处理方式使用 HDFS 和 MapReduce。

由于 HDFS 被设计为写一次、读多次(WORM)的文件系统,因此它针对顺序读取进行了优化,处理起需要对数据进行频繁或快速的行级更新的用例效率低下。这种数据访问模式通常被称为“随机访问”,需要采用这种实时、低延迟读 / 写访问的应用程序也越来越多。对于需要对数据进行随机、实时读 / 写访问的用例,需要在标准的 MapReduce 和 Hive 之外寻找数据持久层和处理层技术。

对许多数据分析应用程序来说,使用传统的关系方法建模还存在挑战。像 Facebook 的实时分析应用程序 “Insights for Websites” 平台(每秒跟踪超过 20 万个事件)和 StumbleUpon 的实时推荐系统,它们需要同时记录来自许多数据源的大量数据事件。这些类型的实时应用程序需要记录大量基于时间的事件,这些事件往往有许多种可能的结构。数据可能以某个特定值为键(如用户),但值通常表示为任意元数据的集。以“Like”和“Share”两个事件为例,它们需要不同的列值,如下表所示:

| 事件ID | 事件时间戳 | 事件类型 | 用户ID | 文章ID | 评论 | 接收用户ID |

|---|---|---|---|---|---|---|

| 1 | 1370139285 | Like | jjones | 521 | ||

| 2 | 1370139285 | Share | smith | 237 | This is hilarious! | 342 |

| 3 | 1370139285 | Share | emiller | 963 | Great article |

这些类型的数据应用程序有存储稀疏数据的需求。在关系模型中,行是稀疏的,但列不是;也就是说,在将新行插入表后,数据库将为每个列分配存储空间,不管该字段是否有值。然而,在数据被表示为任意字段或稀疏列的集合的应用程序中,每行可能只使用可用列的一部分,这让标准关系模式既浪费资源又别扭。

NoSQL与列式数据库

如今,许多现代应用程序都面临着规模和敏捷的挑战,NoSQL 数据库也因此应运而生。NoSQL 是一个广泛的概念,通常指非关系数据库,涵盖广泛的数据存储模型,包括图形数据库、文档数据库、键 / 值数据存储和列族数据库。

HBase 被归类为列族或列式数据库,模型建立在 Google 的 BigTable 架构之上。这种架构让 HBase 具有如下特性:

- 随机(行级)读 / 写访问;

- 强大的一致性;

- “无模式”或灵活的数据建模。

HBase 处理数据建模的方式引入了无模式的特点,它与关系数据库处理数据建模的方式非常不同。HBase 将数据组织到包含行的表中。在表中,行由唯一的行键标识,行键没有数据类型,而是作为字节数组被存储和处理。行键与关系数据库中主键的概念类似,都被自动编入索引。在 HBase 中,表行按照行键进行排序;因为行键是字节数组,所以字符串、long 的二进制表示,乃至序列化的数据结构等几乎一切都可以作为行键。HBase 将其数据存储为键值对,所有表查找都是通过表的行键或存储记录数据的唯一标识符执行的。

一行中的数据被分组成列族,它们由相关列组成。可以画出一个 HBase 表,让它包含给定人口的人口普查数据,其中每行代表一个人,通过唯一的 ID 行键进行访问;每行包含个人数据和人口信息的列族,个人数据的列族包含姓名列和地址列,人口信息的列族包含出生日期列和性别列。该示例如下图所示:

数据仓库和分析数据库的聚合都是在大量数据上进行的,这些数据可能是稀疏的,即不是所有列值都存在,因而按列存储数据比按行存储的优势更明显。尽管列族非常灵活,但列族在实践中并不完全是无模式的。在可以开始将数据插入特定行和列之前,列族就已经被定义了,因为它们会影响 HBase 存储数据的物理格局。然而,可以根据需要确定和创建组成行的实际列。事实上,每行可以包含不同的列。下图展示了一个有两行的 HBASE 表,第一个行键使用了三列族,第二个行键仅使用一列。