PS:因为没有找到实际应用的场景,所以两个示例直接采用了官网的示例。以后遇到实际的应用场景了,再替换成实际的例子。

1.算法简介

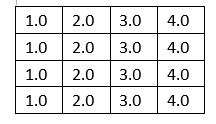

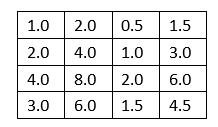

双聚类简单来说就是在数据矩阵A中寻找一个满足条件矩阵B1的子矩阵A1,而B1是条件矩阵B的一个子矩阵.

2.算法常用的计算模型

目前定义双聚类算法有四种比较广泛的方式:(括号中为sklearn官网的说法)

2.1等值模型(常数值,常量行或常量列)

2.2加法模型(低方差的子矩阵)

2.3乘法模型(异常高或低的值)

2.4信息共演模型(相关的行或列)

3.两种特殊的双聚类结果(sklearn官网有算法的)

3.1对角线结构

3.2棋盘格结构

4.双聚类的两种算法

双聚类的算法有很多种,这里只介绍sklearn官网提供的两种算法,也就是上述两种特殊结构的算法。

4.1光谱联合聚类(Spectral Co-Clustering)

说明:因为我们不自己动手写算法,所以这里的公式就略过了。

4.1.1 算法作用

该算法找到的值高于相应的其他行和列中的值。每行和每列只属于一个双聚类,因此重新排列行和列中的这些高值,使这些分区沿着对角线连续显示。

4.1.1 主要计算过程

1)按照数学公式对矩阵进行预处理

2)对处理后的矩阵进行行和列的划分,之后按照另外一个数学公式生产一个新的矩阵Z

3)对矩阵Z的每行使用k-means算法

4.1.2 sklearn中的函数

1) sklearn.cluster.bicluster. SpectralCoclustering

2)主要参数(详细参数)

n_clusters :聚类中心的数目,默认是3

svd_method:计算singular vectors的算法,‘randomized’(默认) 或 ‘arpack’.

n_svd_vecs :计算singular vectors值时使用的向量数目

n_jobs :计算时采用的线程或进程数量

3)主要属性

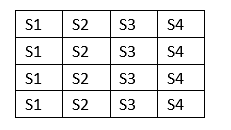

rows_ :二维数组,表示聚类的结果。其中的值都是True或False。如果rows_[i,r]为True,表示聚类i包含行r

columns_:二维数组,表示聚类的结果。

row_labels_ :每行的聚类标签列表

column_labels_ :每列的聚类标签列表

4)官网示例

import numpy as np from matplotlib import pyplot as plt from sklearn.datasets import make_biclusters from sklearn.datasets import samples_generator as sg from sklearn.cluster.bicluster import SpectralCoclustering from sklearn.metrics import consensus_score data, rows, columns = make_biclusters( shape=(300, 300), n_clusters=5, noise=5, shuffle=False, random_state=0) plt.matshow(data, cmap=plt.cm.Blues) plt.title("Original dataset") data, row_idx, col_idx = sg._shuffle(data, random_state=0) plt.matshow(data, cmap=plt.cm.Blues) plt.title("Shuffled dataset") model = SpectralCoclustering(n_clusters=5, random_state=0) model.fit(data) print(model.rows_[0]) print("*******************************************") print(model.rows_[1]) score = consensus_score(model.biclusters_, (rows[:, row_idx], columns[:, col_idx])) print("consensus score: {:.3f}".format(score)) fit_data = data[np.argsort(model.row_labels_)] fit_data = fit_data[:, np.argsort(model.column_labels_)] plt.matshow(fit_data, cmap=plt.cm.Blues) plt.title("After biclustering; rearranged to show biclusters") plt.show()

下面三个图依次表示:原始数据、打乱后的数据、聚类后的效果图

4.2光谱双聚类(Spectral Biclustering)

4.2.1 算法作用

该算法假定输入的数据矩阵具有隐藏的棋盘结构,因此可以对其中的行和列进行划分,使得行簇和列簇的笛卡尔积中的任何双聚类的条目近似恒定。例如,如果有两个行分区和三个列分区,则每行将属于三个双聚集,而每列将属于两个双聚集。

该算法对矩阵的行和列进行划分,使相应的blockwise-constant棋盘格矩阵能够很好地逼近原始矩阵。

4.2.2 主要计算过程

1)对矩阵进行归一化

2)计算前几个singular vectors 值(奇异向量?总感觉这么翻译很别扭)

3)根据这些singular vectors值进行排序,使其可以更好的通过piecewise-constant向量进行近似表示

4) 使用一维k均值找到每个向量的近似值,并使用欧几里德距离进行评分

5) 选择最佳左右singular vectors的一些子集

6) 将数据投影到这个singular vectors的最佳子集并聚集

4.2.3 sklearn中的函数

1) sklearn.cluster.bicluster.SpectralBiclustering

2)主要参数(详细参数)

n_clusters :单个数值或元组,棋盘结构中的行和列聚集的数量

method:把singular vectors值归一化并转换成biclusters的方法。默认值是‘bistochastic’。

3)主要属性

rows_ :二维数组,表示聚类的结果。其中的值都是True或False。如果rows_[i,r]为True,表示聚类i包含行r

columns_:二维数组,表示聚类的结果。

row_labels_ :每行的分区标签列表

column_labels_ :每列的分区标签列表

4)官网示例

import numpy as np from matplotlib import pyplot as plt from sklearn.datasets import make_checkerboard from sklearn.datasets import samples_generator as sg from sklearn.cluster.bicluster import SpectralBiclustering from sklearn.metrics import consensus_score n_clusters = (4, 3) data, rows, columns = make_checkerboard( shape=(300, 300), n_clusters=n_clusters, noise=10, shuffle=False, random_state=0) plt.matshow(data, cmap=plt.cm.Blues) plt.title("Original dataset") data, row_idx, col_idx = sg._shuffle(data, random_state=0) plt.matshow(data, cmap=plt.cm.Blues) plt.title("Shuffled dataset") model = SpectralBiclustering(n_clusters=n_clusters, method='log', random_state=0) model.fit(data) score = consensus_score(model.biclusters_, (rows[:, row_idx], columns[:, col_idx])) print("consensus score: {:.1f}".format(score)) fit_data = data[np.argsort(model.row_labels_)] fit_data = fit_data[:, np.argsort(model.column_labels_)] plt.matshow(fit_data, cmap=plt.cm.Blues) plt.title("After biclustering; rearranged to show biclusters") plt.matshow(np.outer(np.sort(model.row_labels_) + 1, np.sort(model.column_labels_) + 1), cmap=plt.cm.Blues) plt.title("Checkerboard structure of rearranged data") plt.show()

下面四个图依次表示:原始数据、打乱后的数据、进行双聚类重排后的数据、按棋盘结构排列的数据