【论文笔记_对比学习_2021】CONTRASTIVE LEARNING WITH HARD NEGATIVE SAMPLES

摘要

如何才能为对比性学习提供好的负面例子?我们认为,就像度量学习一样,表征的对比性学习得益于硬性负面样本(即难以与锚点区分的点)。使用硬阴性样本的关键挑战是,对比性方法必须保持无监督状态,这使得采用现有的使用真实相似性信息的阴性采样策略变得不可行。作为回应,我们开发了一个新的无监督抽样方法系列,用于选择用户可以控制硬度的困难负样本。这种抽样的一个限制性案例导致了对每个类的紧密聚类,并将不同的类尽可能地推开的表现。所提出的方法改善了多种模式下的下游性能,只需要几行额外的代码来实现,并且没有引入计算开销。

1.介绍

由于他们在经验上的成功,对比学习方法(Chopra等人,2005;Hadsell等人,2006)已经成为学习表征的最流行的自我监督方法之一(Oord等人,2018;田等,2019;陈等,2020a)。在计算机视觉中,对于对象检测和分割任务,无监督的对比学习方法甚至优于有监督的预训练(Misra & Maaten,2020;何等,2020)。

对比学习依赖于两个关键因素:相似(正)(x,x+)和不相似(负)(x,x-)数据点对的概念。训练目标,通常是噪声对比估计(Gutmann & Hyvä rinen,2010年),指导学习到的表示f将正对映射到附近的位置,将负对映射到较远的位置;还考虑了其他目标(Chen等人,2020a)。相关方法的成功依赖于正对和负对信息的设计,由于没有监督,它们不能利用真实的相似性信息。

许多研究致力于解决积极配对的抽样策略,并已成为多视角和对比学习的最新进展的关键驱动力(Blum & Mitchell,1998;徐等,2013;巴赫曼等人,2019;陈等,2020a田等,2020)。对于图像数据,正采样策略通常应用保留语义内容的变换,例如抖动、随机裁剪、分离颜色通道等。(陈等,2020ac;田等,2019)。这种变换在从原始像素数据中学习控制策略方面也是有效的(Srinivas等人,2020)。还提出了针对句子、音频和视频数据的积极采样技术(Logeswaran & Lee,2018;Oord等人,2018;Purushwalkam & Gupta,2020;Sermanet等人,2018)。

令人惊讶的是,在对比学习中,否定配对的选择很少受到关注。通常,给定一个“锚”点x,一个“负”x只是从训练数据中统一采样,而不管它对学习的表示有多有用。在监督和度量学习设置中,“硬”(真负)例子可以帮助指导学习方法更快地纠正其错误(Schroff等人,2015;宋等,2016)。对于表征学习来说,信息性的反面例子直观上是那些映射在附近但应该相距很远的对。这一思想被成功地应用于度量学习中,在度量学习中,不同点的真实对是可用的,这与无监督的对比学习相反。

有了这个动机,我们解决了为对比表征学习选择信息性否定的挑战。作为回应,我们提出了一个解决方案,它构建了一个可调的采样分布,该分布优先选择当前表示非常相似的负对。这种解决方案面临两个挑战:(1)我们无法获得任何真实的相似性或不相似性信息;(2)对于这种可调分布,我们需要一种有效的采样策略。我们克服了(1)建立在积极的无标签学习的想法上(Elkan & Noto,2008;杜普莱西等人,2014年),以及(2)通过设计一个有效的,易于实施的重要性采样技术,不招致任何计算开销。

我们的理论分析表明,作为调谐参数的函数,我们的新方法的最佳表示将相似的输入放置在紧密的簇中,同时将簇尽可能地分开。从经验上看,我们的硬负采样策略提高了图像、图形和文本数据的下游任务性能,支持了这一点,事实上,我们的负样本提供了更多的信息。

总之,我们做出了以下贡献:

1.我们提出了一个简单的困难负对分布用于对比表征学习,并推导了一个实用的零计算开销的重要性抽样策略,该策略考虑了真实相异信息的缺乏;

2.我们从理论上分析了困难负样本和最优表示,表明它们获得了理想的推广性质;

3.我们根据经验观察到,所提出的采样方法提高了图像、图形和文本数据上的下游任务性能。

1.1相关工作

对比表征学习。人们提出了许多视觉表征对比学习的框架,包括SimCLR (Chen et al .,2020ab),使用迷你批次中其他项目的增强视图作为负面样本,以及(何等人,2020;Chen等人,2020c),其使用旧阴性表示的动量更新记忆库,以使得能够使用非常大批量的阴性样本。大多数对比方法是无监督的,但是存在一些使用标签信息的方法(Sylvain等人,2020;科斯拉等人,2020年)。许多作品研究了正对的作用,例如,提出对图像应用大的扰动陈等人(2020ac),或者主张除了最终预测任务的相关信息之外,最小化正对中的互信息(田等人,2020)。除了视觉数据,对比方法还被用于句子嵌入(Logeswaran & Lee,2018年),顺序数据(Oord等人,2018年;海纳夫等,2020),图(孙等,2020;哈萨尼&哈萨马迪,2020;李等人,2019年)和节点表示学习(V elickovic等人,2019年),以及从原始图像中学习表示以进行非策略控制(Srinivas等人,2020年)。负对的作用研究得很少。Chuang等人(2020)提出了一种“去偏置”的方法,即校正并非所有的否定对都是真否定的事实。它通过采用正的无标签学习的观点来做到这一点,并利用了真正的负分布的分解。Kalantidis等(2020)考虑应用Mixup(张等,2018)生成潜在空间的硬底片,Jin等(2018)利用视频特定的时间结构生成底片用于物体检测。

深度度量学习中的负挖掘。与对比表征学习文献相反,负面样本的选择策略已经在(深度)度量学习中进行了彻底的研究(Schroff等人,2015;宋等,2016;哈伍德等人,2017;吴等,2017;葛,2018;Suh等人,2019)。这些工作中的大多数观察到,使用当前嵌入难以辨别的负样本是有帮助的。Schroff等人(2015)对此进行了限定,观察到一些例子太硬,并建议选择“半硬”阴性样本。负样本在度量学习中的重要性是众所周知的,在度量学习中(部分)真实相异度信息是可用的,这提出了对比学习中的负样本问题,这是本文的主题。

2.对比学习设置

我们从对比表征学习的设置和概念开始。我们希望学习一个嵌入f:X→sd-1/t,它将观测值X映射到半径为1/t的Rd中的超球面sd-1/t上的一个点,其中t是“温度”标度超参数。根据Arora等人(2019)的设置,我们假设一组表示语义内容的离散潜在类C,因此相似的对(x,x+)具有相同的潜在类。

对于c ∈ C的ρ©在潜类上的分布,我们定义了联合分布px,c(x,c) = p(x|c)ρ(c ),其边际p(x)我们简称为p,并假设supp§ = X,为简单起见,我们假设ρ© = τ +是一致的,并假设τ-= 1-τ+是另一个类的概率。由于类先验τ+在实践中是未知的,因此它必须被视为超参数,或者被估计(克里斯托费尔等人,2016;Jain等人,2016)。

设h : X → C是将类别标签分配给输入的真实潜在假设。我们写x~x’来表示标签等价关系h(x) = h(x’)。我们用p+x (x’) = p(x’|h(x’) = h(x))表示与x具有相同标号的点上的分布,用p-x(x’)= p(x’ | h(x’)≠ h(x))表示与x具有不同标号的点上的分布。当上下文清楚时,我们去掉下标x。按照通常的约定,我们重载’波浪线’并且也写x波浪线p来表示从p采样的点。

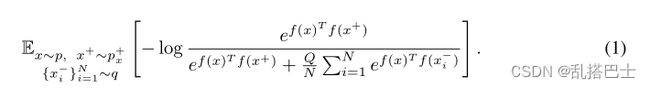

对于每个数据点x波浪线p,用于学习表示式f的噪声对比估计(NCE)目标(Gutmann & Hyvä rinen,2010年)使用正例x+和负例{ Xi -} N~i = 1~,正例x+具有与x相同的标签,负例{ Xi- } N i = 1具有(假定)不同的标签,h(Xi)≠ h(x ),从q:

为了分析的目的,引入了加权参数Q。当N是有限的时,我们取Q = N,产生对比宾语的通常形式。负样本分布q经常被选择为边际分布p,或者在实践中,它的经验近似(田等,2019;陈等,2020ac;何等,2020;陈等,2020cOord等人,2018;海纳夫等人,2020年)。在本文中,我们问:是否有更好的方法来选择q?

3.困难负样本采样

在这一节中,我们将描述硬负采样的方法。我们首先问什么是好的负样本?为了回答这个问题,我们采用以下两个指导原则:

原则1。q应只对标签不同于锚x的“真负”Xi-进行采样。

原则2.最有用的负样本是当前的嵌入表示认为与锚最相似的样本。

简而言之,具有与锚不同的标签,但是嵌入在附近的负样本可能是最有用的,并且在训练期间提供重要的梯度信息。在度量学习中,可以获得真正的否定对,自动实现第一个原则。在无监督的对比学习中没有监督,所以坚持原则1是不可能的。在本文中,我们提出了一种方法,该方法大致支持原则1,同时将这一思想与“硬度”这一关键的附加概念成分(封装在原则2中)相结合。我们的方法中的“硬度”水平可以被平滑地调整,允许用户选择硬度,该硬度在来自硬否定的改进的学习信号和由于错误否定的校正而导致的损害之间进行最佳权衡,该损害仅仅是近似的。这一点很重要,因为最难的点是那些最接近锚的点,并且被认为具有相同标签的高倾向。因此,对于较硬的样品,近似法不能消除所有假阴性的损害变得更大,从而产生折衷。作为我们的方法的一个特例,当硬度水平完全下调时,我们获得(Chuang等人,2020)中提出的方法,该方法仅(近似地)支持原则1,而不支持原则2。最后,在原则1和2之外,我们希望设计一种有效的采样方法,在训练期间不增加额外的计算开销。

3.1提议的硬采样方法

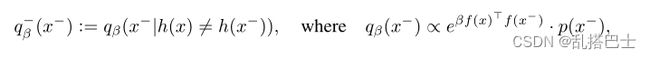

我们的第一个目标是在X上设计一个分布q,它可以依赖于嵌入f和锚X。根据上述原则,我们从q中抽取一批负值{ Xi -} N i =1。我们建议对分布qβ-进行负采样,定义如下:

对于β ≥ 0。注意,qβ-和qβ都依赖于x,但我们从符号中取消了相关性。qβ中的指数项是具有平均方向f(x)和“浓度参数”β的非标准化von Mises–Fisher分布(马迪亚和尤普,2000)。qβ有两个关键部分,对应于每个原则:1)以事件{ h(x)≠h(}为条件,保证(x,x-)对应于不同的潜在类别(原则1);2)浓度参数β项控制qβ对与锚点x具有大内积(相似性)的点x进行加权的程度(原则2)。因为f位于半径为1/t的超球面的表面上,所以我们有||f(x)-f(x’)||2 = 2/t2-2f(x)Tf(x‘),所以偏好具有大内积的点等价于偏好具有小平方欧几里得距离的点。

虽然我们设计的qβ-具有所有所需的元件,但不清楚如何有效地从中采样。为了找到一种实用的方法,请注意,我们可以通过采用PU学习的观点来重写这种分布(Elkan & Noto,2008;杜等,2014;庄等,2020)。也就是说,通过以事件{ h(x)= h(}为条件,我们可以将qβ(x-)分解为:

![]() 。重新排列公式2,得出公式

。重新排列公式2,得出公式![]() 对于负采样分布qβ-,根据两个易于处理的分布,因为我们有来自p的样本,并且可以使用一组语义保持变换来近似来自p+的样本,这在对比学习方法中是典型的。

对于负采样分布qβ-,根据两个易于处理的分布,因为我们有来自p的样本,并且可以使用一组语义保持变换来近似来自p+的样本,这在对比学习方法中是典型的。

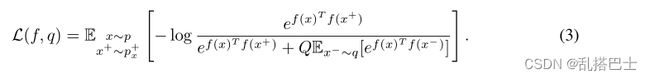

利用抑制采样,可以从qβ和(近似)qβ+产生样本。然而,拒绝抽样涉及算法的复杂性,因为抽样批次的程序必须修改。为了避免这种情况,我们采用重要性抽样方法。为了获得这一点,首先注意固定数量Q并在目标(1)中取极限N → ∞,得到:

…推理

强调我们提出的方法的实现的简单性是很重要的。因为我们建议重新加权目标而不是修改采样过程,所以只需要两行额外的代码来实现我们的方法,而没有额外的计算开销。附录d中的图13给出了该目标的PyTorch式伪代码。

4.硬负采样分析

4.1硬采样在边际和最坏情况负值之间插值

直观地说,我们提出的负样本分布qβ中的浓度参数β控制着负样本的“硬度”水平。如前所述,Chuang等人(2020)的去偏置方法可以恢复为一种特殊情况:取β = 0以获得分布q0-。这种情况相当于对从p采样的负批次中的一些样本将具有与锚相同的标签的事实进行校正。但是大β承认什么解释呢?具体来说,分布qβ在极限β → ∞时收敛到什么程度,如果有的话?我们证明,在极限qβ近似于下面零总和的两人对策的内部解。

…

4.2最坏负样本下超球面上的最优嵌入

一个最优对比嵌入(L的全局极小值)具有什么期望的性质使表示可推广?为了研究这个问题,我们首先分析了当负样本来自敌对的最坏情况分布时,最优嵌入f *在超球面上的分布。我们考虑目标(1)的不同极限观点,即负样本数N → ∞。根据Wang & Isola (2020)的公式,我们在(1)中取Q = N,并减去log N。这既不改变极小值集,也不改变损失面的几何形状。取负样本的数量N → ∞产生极限目标,

…

5.实证结果

接下来,我们根据经验评估我们的硬负采样方法,并将其作为对图像、图形和文本数据的最新对比方法的修改。对于所有实验,β被视为超参数(参见图2中的消融,了解如何选择β)。还必须确定M和τ +的值。对于所有实验,我们固定M = 1,因为取M > 1将增加向前-向后传递的输入数量。附录中的引理11给出了选择M = 1的理论依据。选择类先验τ +可以通过两种方式完成:从数据中估计(克里斯托费尔等人,2016;Jain等人,2016),或者将其视为超参数。第一种选择要求在对比训练之前拥有标记数据。

…

6.近距离观察硬采样

…

7.结论

我们论证了硬否定在无监督对比表征学习中的价值,并介绍了一种简单的硬否定采样方法。我们的工作连接了两条主线:对比学习和度量学习中的负挖掘。这样做需要克服一个明显的障碍:度量学习中的负挖掘使用成对相似性信息作为核心组件,而对比学习是无监督的。我们的方法有几个很好的方面:具有理想的理论性质,实现非常简单,只需要修改几行代码,不改变数据采样管道的任何内容,引入零额外计算开销,以及以有原则的方式处理假负样本。