【论文翻译】一种基于注意的异构结构学习图神经网络

一种基于注意的异构结构学习图神经网络

摘要

本文主要研究异构信息网络(HIN)的图表示学习,其中各种类型的顶点通过各种关系连接。现有的方法大多是通过元路径修正齐次图嵌入模型,以学习HIN的低维向量空间。本文提出了一种新的异构图结构注意神经网络(HetSANN)来直接编码HIN的结构信息,而不需要元路径,从而获得更多的信息表示。该方法不需要领域专家来设计元路径方案,并且可以自动处理异构信息。具体来说,我们用以下两种方法隐式地表示异构信息:1)通过低维实体空间中的投影来模拟异构顶点之间的转换;2)然后,利用投影的方法,对不同顶点之间的变换进行建模,利用注意机制,将图神经网络应用于投影邻域多关系信息的聚集。同时,我们还提出了三种改进方法,即:在HIN中的成对关系共享产品注意,循环一致性损失,以保持异构实体空间之间的转换,以及充分利用信息的多任务学习。在三个公共数据集上进行的实验表明,与最新的解决方案相比,我们提出的模型取得了显著和一致的改进。

1简介

图嵌入追求图的信息化数值表示,这有利于图的分类、链接预测和实体对齐等应用。现有的大多数方法都是在齐次图上进行图嵌入,其中所有的节点和关系(即连接或边)都是同一类型的。例如,DeepWalk(Perozzi、Al-Rfou和Skiena 2014)在低维向量空间中最小化节点与其相邻节点之间的距离,以保留齐次图的结构信息。然而,现实世界中的数据往往呈现为一个异构图,它将不同方面的信息结合在一起。

图1:异构图和元路径的玩具示例。(a) 一个不同的学术图表。(b) 以前基于元路径的方法。

异构信息网络(HIN)。HIN(亦称异构图)由两种以上的节点或边组成。图1a示出了HIN的玩具示例,包括三种类型的节点(作者、论文和会议)和六种类型的边(引用/引用、写入/写入和发布/发布)。请注意,这里我们将HIN中顶点之间的关系视为有向边,并为HIN中的有向关系(例如write)设置反向关系(例如write)。与齐次图相比,HIN面临两大挑战:

- C1:如何对多种类型节点的实体空间进行建模?在齐次图中,所有节点都嵌入到同一个低维实体空间中。相反,HIN中的各种类型的节点自然地在不同的空间中建模。然而,一个顶点可以连接到多种类型的节点,例如,一篇论文是作者写的,它将由学术会议发表。在不同类型的实体空间中,顶点之间的交互方式的设计势在必行。

- C2:如何保留节点之间不同关系的语义?对于HIN,不同的节点对和同一节点对之间存在着多种关系。在学术图表的情况下,一个作者可以引用另一个作者,同时他们也可以是一些论文的合著者。不同的关系表示顶点的不同语义内容。因此,具有不同顶点关系的相邻顶点的特征决定了学习的低维表示空间的性能。

HIN嵌入的大多数当代研究集中于通过元路径使HIN适应同构表示学习算法(Shi et al.2016)。如图1b所示,可以基于所设计的元路径方案APCPA和齐次图的表示学习算法来生成作者之间的链接,例如,在metapath2vec(Dong、Chawla和Swami 2017)或GNN(Gori、Monfardini,和Scarselli 2005)中使用的(Wang et al.2019),实现到生成的图中。有关基于元路径的方法的更多详细信息,请参见第4节。

尽管基于元路径的异构图嵌入方法取得了成功,但这些解决方案采用手工制作的元路径方案来寻找同质节点邻居,这使得它们面临两个主要问题:1)元路径方案依赖于专家,很难用手穷尽地枚举和选择有价值的元路径方案;2) 在生成基于元路径的节点对的过程中,元路径传递的信息(如异构节点或边缘的特征)会丢失,甚至会导致嵌入性能下降。

在本文中,我们抛开元路径,提出了一种新的方法来学习HIN中同时保留结构和语义信息的低维向量空间。具体来说,我们利用图神经网络(GNN)来处理HIN的结构信息,并利用任务导向的目标函数(本文中的节点分类损失)来训练模型。为了解决上述HIN的挑战,我们设计了一个专用的类型感知注意层来代替传统GNN中的卷积层。对于每个类型感知的注意层,定义了一个变换操作,将不同实体空间中的顶点投影到同一个低维目标空间,以实现异构节点(C1)之间的交互,并采用聚焦于不同类型边缘的注意策略来聚合相邻顶点不同的语义(C2)。此外,我们开发了两种类型感知注意层的注意评分函数,包括concat产品和voicesharing产品1。为了更好地模拟异构节点之间的交互,我们进一步对转换操作引入了限制。最后,我们在我们提出的模型中执行多任务学习,这通常有利于表示的鲁棒性。综上所述,本文的主要贡献如下:

- 提出了异构图结构注意神经网络(HetSANN)。与以前的基于元路径的解决方案不同,HetSANN直接利用并探索异构图中的结构,以实现更多信息的表示。

- 我们提出了HetSANN的三个扩展:(E1)通过多任务学习增强信息共享的程度。(E2)考虑有向边和反向边之间的成对关系(语音共享积)。(E3)对转换操作引入约束以保持循环一致。

- 我们在三个异构图数据集上使用节点分类任务对所提出的HetSANN进行了评估。实验结果表明,与现有的各种技术相比,HetSANN具有优越性。此外,本文还对三种延长方式进行了HetSANN实验研究,结果表明,三种延长方式均能改善和HetSANN的原始性能。

2 异构图结构注意神经网络(HetSANN)

异质图G=(V,E)由一组顶点V和一组边E组成,有一组节点类型A,每个顶点v∈V属于其中一种节点类型,用![]() 表示,式中

表示,式中![]() 是从V到A的映射函数。我们表示从顶点i∈V到j∈V的边e∈E,其关系类型r为三元组e=(i,j,r),其中r∈r和r是关系类型的集合。对于正则方向上的有向边e=(i,j,r),我们把它的反边看作

是从V到A的映射函数。我们表示从顶点i∈V到j∈V的边e∈E,其关系类型r为三元组e=(i,j,r),其中r∈r和r是关系类型的集合。对于正则方向上的有向边e=(i,j,r),我们把它的反边看作![]() =(j,i,

=(j,i,![]() ),其中

),其中![]() ∈R不同于r。对于顶点j,其相邻节点的连接集被定义为

∈R不同于r。对于顶点j,其相邻节点的连接集被定义为![]() 。

。

本文旨在学习异构图中每个顶点i的低维表示![]() ,其中

,其中![]() 是节点类型

是节点类型![]() 的嵌入空间的维数,并将其应用于下游节点分类任务。注意,当顶点i链接到j时,各种关系类型可以同时发生,这将是异构图嵌入的一个挑战。为了解决这些问题,我们提出了一种任务导向的异构图嵌入方法HetSANN。如图2所示,HetSANN框架的关键组件是类型感知注意层,如下所示。

的嵌入空间的维数,并将其应用于下游节点分类任务。注意,当顶点i链接到j时,各种关系类型可以同时发生,这将是异构图嵌入的一个挑战。为了解决这些问题,我们提出了一种任务导向的异构图嵌入方法HetSANN。如图2所示,HetSANN框架的关键组件是类型感知注意层,如下所示。

2.1类型感知注意层(TAL)

TAL主要作为GNNs的一个自适应层,对局部图邻域进行卷积运算。在执行嵌入程序之前,我们用![]() 的自循环关系将每个顶点i连接到自身。对于每个节点i∈V,我们得到了冷启动状态

的自循环关系将每个顶点i连接到自身。对于每个节点i∈V,我们得到了冷启动状态![]() ∈

∈![]() 。冷启动状态可以是节点的属性特征,也可以是没有属性的节点的虚拟特征(零向量/独热向量)。

。冷启动状态可以是节点的属性特征,也可以是没有属性的节点的虚拟特征(零向量/独热向量)。

每个TAL都采用了多头注意机制(Vaswani et al.2017),这已经证明有助于稳定注意机制的学习过程,丰富模型能力(Velickovic et al.2018)。图3示出了TAL的每个头部的数据流。考虑在第l层中表示为![]() 的顶点j∈V。第(l+1)个TAL中的注意头m通过以下两个操作输出相应的隐藏状态

的顶点j∈V。第(l+1)个TAL中的注意头m通过以下两个操作输出相应的隐藏状态![]() :变换操作和顶点j在度分布中的邻域聚合。

:变换操作和顶点j在度分布中的邻域聚合。

变换运算(C1) 首先应用线性变换![]() 到顶点j的每个相邻顶点i:

到顶点j的每个相邻顶点i:

![]()

其中![]() 是从

是从![]() 型空间中先前的隐态到l+1层第m个头中

型空间中先前的隐态到l+1层第m个头中![]() 型节点的隐态的投影。也就是说,我们将顶点j的相邻节点变换为节点类型

型节点的隐态的投影。也就是说,我们将顶点j的相邻节点变换为节点类型![]() 相同的低维向量空间,用于邻域聚合。

相同的低维向量空间,用于邻域聚合。

邻域聚合(C2) 为了保留节点间不同类型关系的语义,我们利用 |R| 注意评分函数来匹配不同的关系模式,即![]() 。对于顶点j,计算每个连接边e=(i,j,r)∈

。对于顶点j,计算每个连接边e=(i,j,r)∈![]() 的注意系数,其形式如下:

的注意系数,其形式如下:

其中σ是LeakyReLU(·)实现的激活函数(Maas、Hannun和Ng 2013)。注意系数![]() 表示边缘e对目标顶点j的重要性。原则上,注意评分函数可以是不同的形式来捕捉不同的链接类型。为了简单起见,我们对所有的连接类型都采用相同形式的注意机制,但参数不同。注意力评分函数的一种自然形式是concat产品,在GAT(Velickovic et al.2018)中采用,定义如下:

表示边缘e对目标顶点j的重要性。原则上,注意评分函数可以是不同的形式来捕捉不同的链接类型。为了简单起见,我们对所有的连接类型都采用相同形式的注意机制,但参数不同。注意力评分函数的一种自然形式是concat产品,在GAT(Velickovic et al.2018)中采用,定义如下:

![]()

其中 || 表示级联操作,![]() 是同一边缘类型 r 共享的可训练注意参数。与HAN(Wang et al.2019)采用基于元路径方案的分层注意机制不同,我们将注意机制直接用于原始异构链路。因此,将softmax应用于顶点 j 的邻域连接上,以规范化注意系数:

是同一边缘类型 r 共享的可训练注意参数。与HAN(Wang et al.2019)采用基于元路径方案的分层注意机制不同,我们将注意机制直接用于原始异构链路。因此,将softmax应用于顶点 j 的邻域连接上,以规范化注意系数:

现在我们得到了目标节点 j 的同一低维空间中相邻节点的隐藏状态,以及与顶点 j 相关联的每个链接的权重。然后顶点 j 的邻域聚合可以执行为:

在我们提出的模型中,边的节点对和边的关系类型一起被用来识别边。当顶点 i 以多种关系连接到 j 时,隐藏状态![]() , i 以相应的权重

, i 以相应的权重![]() 传播到顶点 j 多次。

传播到顶点 j 多次。

当M个注意头执行等式(5)的过程时,我们连接注意头的低维向量,并输出类型感知注意层 l+1中每个节点的表示:

其中![]() 。HetSANN的聚合是在原始链路上进行的,而不是基于元路径生成的链路。也就是说,对于基于元路径的链接,顶点 i 可以传播到GNN的一层中的顶点 j ,而对于原始链接,则需要更多的层。因此,在HetSANN中使用了更深层的模型来捕获高阶邻近信息。为了便于培训,我们采用了残余机制,这是(He等人,2016年)首次提出的,我们将公式(6)修改如下:

。HetSANN的聚合是在原始链路上进行的,而不是基于元路径生成的链路。也就是说,对于基于元路径的链接,顶点 i 可以传播到GNN的一层中的顶点 j ,而对于原始链接,则需要更多的层。因此,在HetSANN中使用了更深层的模型来捕获高阶邻近信息。为了便于培训,我们采用了残余机制,这是(He等人,2016年)首次提出的,我们将公式(6)修改如下:

2.2模型训练和三个扩展

最后一个类型感知注意层输出异构图中每个顶点的低维表示,即![]() 。为了优化对目标任务的表示,如本文中的节点分类,我们将节点的表示集成到一个节点分类器中(用softmax函数的全连接层实现)来推断分类标签。在标记数据的指导下,我们最小化了交叉熵损失:

。为了优化对目标任务的表示,如本文中的节点分类,我们将节点的表示集成到一个节点分类器中(用softmax函数的全连接层实现)来推断分类标签。在标记数据的指导下,我们最小化了交叉熵损失:

式中,Vp是属于节点类型 p 的标记顶点集。![]() 和

和![]() 分别是顶点 i 的基本真值和预测类标签。

分别是顶点 i 的基本真值和预测类标签。

E1:多任务学习 我们可以进一步为不同类型的节点使用多个节点分类器。所有类型感知注意层的参数由多个分类器共享和训练。通过合并所有分类器的多任务学习大大降低了过度拟合的风险,并有利于表示的鲁棒性(Baxter 1997)。

E2:声音共享积 concat产品评分函数将有向边(例如write)和反向边(例如write)视为独立的关系类型。直观地说,当顶点j以“写”关系链接到顶点i时,顶点i将以“写”关系链接到顶点j。为了建立有向边和反向边之间的两两关系,我们在两两边类型 r 和![]() 之间共享注意机制的参数,其中

之间共享注意机制的参数,其中![]() 是r类型的边的反向边的类型。从技术上讲,我们强制

是r类型的边的反向边的类型。从技术上讲,我们强制![]() ,并调整注意评分函数

,并调整注意评分函数![]() 如下(称为声音共享积):

如下(称为声音共享积):

E3:循环一致性损失 自然语言处理中,“回译与协调”一直是验证和提高翻译性能的常用技巧(Brislin 1970)。回到等式(1)中异构节点之间的转换操作,我们有一个从节点类型![]() 到

到![]() 的转换和另一个从

的转换和另一个从![]() 到

到![]() 的转换。特别地,对每种类型的节点应用自变换,即

的转换。特别地,对每种类型的节点应用自变换,即![]() →

→![]() 。

。![]() 和

和![]() 之间的变换操作在图4a中示出,这是直观的,顶点应该在循环之后返回到起始位置。因此,我们对转换操作引入一个循环一致性限制:

之间的变换操作在图4a中示出,这是直观的,顶点应该在循环之后返回到起始位置。因此,我们对转换操作引入一个循环一致性限制:

其中,![]() 是

是![]() 的倒数。然而,矩阵求逆是一个非常耗时的问题。为了降低计算复杂度,我们采用一个可训练矩阵

的倒数。然而,矩阵求逆是一个非常耗时的问题。为了降低计算复杂度,我们采用一个可训练矩阵![]() 来代替矩阵

来代替矩阵![]() 的逆矩阵,并将其约束如下:

的逆矩阵,并将其约束如下:

其中 I 是单位矩阵。这些约束集成为循环一致性损失(如图4b所示):

其中β1和β2是加权因子。因此,我们模型的目标函数如下:![]()

图4:转换操作的图示。(a) 节点类型![]() 和

和![]() 之间的转换有两种形式,即

之间的转换有两种形式,即![]() →

→![]() 和

和![]() →

→![]() 。(b) 循环一致性损失。

。(b) 循环一致性损失。

3实验

比较模型 比较模型列表包括:

1) 我们建议的模型2的变体:我们将HetSANN表示为建议的普通版本,即在第2.2节中没有前面提到的三个扩展。三个后缀“.M”、“.R”和“.V”分别表示优化参数的多任务学习、关系注意机制中的语音共享积和保持顶点间变换的循环一致性损失。HetSANN.M.R.V是指我们提出的模型的完整版本。

所有的变型都采用3层HetSANN,每个TAL由8个注意头组成。每个注意头的输出维度与8一致。通过Adam解算器(Kingma和Ba 2015)优化参数,IMDB的学习率为0.001,其他数据集的学习率为0.005。将正则化权重0.0005应用于所有可训练参数。在隐藏层之间植入0.6的退出率(Srivastava et al.2014),以稳定我们的模型训练程序。对于后缀为“.V”的HetSANN变量,权重系数![]() ,

,![]() 。

。

2) 基线模型:我们将代码在网站上公开的最新基线进行比较,包括DeepWalk(Perozzi、Al-Rfou和Skiena 2014)、metapath2vec(Dong、Chawla和Swami 2017)、HERec(Shi等人2018)、HAN(Wang等人2019)、GCN(Kipf和Welling 2017)、R-GCN(Schlichtkrull等人2018)和GAT(Velickovic)等人,2018年)。第4节介绍了所有的基线模型,其具体实现如下。

通过忽略节点和连接的类型,将同构图嵌入方法(DeepWalk、GCN和GAT)转化为异构图嵌入学习模型。R-GCN通过将所有节点视为同一类型的节点,但区分图中不同类型的关系来实现。在实验中,我们遵循了文献中推荐的大多数参数设置,并调整了一些参数以适应数据集。具体来说,我们将metapath2vec、HERec和DeepWalk的行走长度分别设置为50和100次行走/节点,并利用它们学习到的嵌入来训练2层MLP(Rumelhart和Mcclelland 1988)分类器。对于基于图神经网络的方法,GCN、R-GCN和GAT的层数设置为3。在基于注意的模型的每一层中,我们使用8个注意头,即HAN和GAT。为了进行比较,我们为每个数据集设计了一些元路径方案,并评估了metapath2vec和HAN的所有元路径方案,并报告了最佳性能。

所有的网络都是从无到有的训练,直到融合。所有模型的嵌入维数都一致设置为64。除特殊说明外,所有数据集的模型设置都相同。

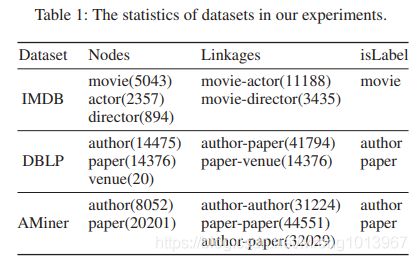

数据集 我们从IMDB网站收集了一个电影图,并分别从DBLP(Ji等人2010)和AMiner(Tang等人2008)数据集构建了两个学术网络。表1列出了这三个数据集的统计信息,它们都是一个异构图,由两种以上的节点或边组成。

- IMDB IMDB记录电影的演员和导演。这些电影按类型分为三类:动作片、喜剧片或戏剧片。通过词袋的方式,利用电影情节的关键词作为电影顶点的属性特征。对于基于元路径的模型,我们设置了两种元路径方案,即MAM和MDM。

- DBLP 在学术网络中,作者在场馆发表论文。我们构建的DBLP数据集由来自四个不同研究领域的20个地点组成:数据库、数据挖掘、机器学习和信息检索。每一篇论文都按照论文发表地的研究领域进行标注,每一篇论文都有一袋关键词。根据作者发表论文的研究领域,对每一位作者进行标注,并将该作者发表论文的字包归纳为作者的特征。再次,我们将PAP和PVP、APA和APVPA分别作为论文分类任务和作者分类任务中基于元路径模型的元路径方案。

- AMiner 我们抛弃了AMiner学术网络中的场馆节点,提出了一项更艰巨的分类任务。除了论文与作者之间的发表关系外,还介绍了论文之间的引用关系和作者之间的协作关系。与DBLP相似,AMiner中的每一篇论文都有一袋关键词,论文和作者被划分为四个研究领域:数据库、数据挖掘、自然语言处理和计算机视觉。每个作者的属性特征都有五个指标,表示作者的学术权威。同样,PAP和PAAP以及APA和APPA被设置为元路径方案。

评价指标 将整个标注数据集按0.8:0.1:0.1的比例随机划分为训练集、验证集和测试集。并从验证集中选取最优模型,然后在测试集上用微观F1和宏观F1进行评价。对于每个模型,我们报告了10个重复过程的平均性能。

3.1消融研究

在本节中,我们采用香草HetSANN及其变体,包括HetSANN.M、HetSANN.M.R和我们的完整方法HetSANN.M.R.V来进行消融研究。为了实现多任务学习,我们在主作者分类任务中引入了论文分类作为辅助任务。对于只包含单一类型标记节点的IMDB数据集,不能进行多任务学习(后缀为“.M”)。测试结果如表2下半部分所示:(1)HetSANN.M在作者和论文分类任务上都优于HetSANN。对于DBLP数据集,HetSANN.M在作者分类任务上仍有一定的改进,但与只针对一个任务训练的HetSANN相比,HetSANN.M在论文分类性能上稍显逊色。我们相信,引入的多任务学习指导我们的模型找到了一个能够捕获所有任务的最佳表示,即使有时它涉及到一个任务的准确性损失,以换取总体性能的提高(Baxter 1997);(2)受益于用语音共享产品替代concat产品,与HetSANN.M.R相比,HetSANN.M.R提高了所有数据集的分类性能;(3)HetSANN.M.R.V在作者和电影分类任务中取得了我们模型变体的最佳性能。然而,从HetSANN.M.R.V和HetSANN.M.R.V的比较可以看出,HetSANN.M.R.V的增益是相对受限的。一个明显的原因是用循环一致性损失中的可训练矩阵替换逆矩阵的解析表达式[式(12)],这将留待以后的工作。

3.2比较结果

表2还显示了我们的模型与其他基线的比较结果。显然,我们的模型在除DBLP上的纸张分类外的所有数据集的分类任务上都优于其他模型。请注意,我们根据论文发表地的研究领域为论文贴上标签。在DBLP中,连接到论文的场馆节点使HAN能够通过元路径方案PVP建立在同一场馆发表论文的邻域,从而在DBLP上获得理想的论文分类性能。没有AMiner中的地点顶点,HAN很难通过PAP和PAAP方案获取论文的类别信息,导致AMiner中作者分类结果最差。与需要设计好元路径解的方法不同,无元路径方法具有明显的性能增益和鲁棒性。通过进一步区分多种类型的节点和链接,我们的模型优于其他基线,我们的完整方法HetSANN.M.R.V在三个数据集上分别将微观F1和宏观F1分别比最具竞争力的模型GAT提高了3%∼13%和3%∼19%。

图5详细说明了主要任务(电影和作者分类)和辅助任务(论文分类)在三个数据集上的比较结果,在{0.2,0.4,0.6,0.8}中改变训练比率的值。一直以来,我们有HetSANN.M.R.V>HetSANN>分类的微观F1得分基线。此外,HetSANN和HetSANN.M.R.V仍然以弱监督的方式保持优势。

3.3参数敏感性研究

最后,我们在IMDB上测试了HetSANN.R.V的参数敏感性,结果如图6所示。左图显示了当其他参数固定时,类型感知注意层的数量L的影响。当L>5时,HetSANN.R.V的性能下降。观察结果与(Li,Han,Wu 2018)中的分析一致,即图卷积是对邻域特征进行拉普拉斯平滑的一种形式,当一个GNN中包含多个卷积层时,会导致节点特征不可区分,节点分类性能较差。剩下的两个图集中在循环阻力损失的加权因子![]() 和

和![]() 上。固定

上。固定![]() ,当

,当![]() 增加到

增加到![]() 时,图6b中的线增加,当我们设置较大的

时,图6b中的线增加,当我们设置较大的![]() 时,线减少,这可能会抑制主任务(即节点分类)的学习。图6c依次改变

时,线减少,这可能会抑制主任务(即节点分类)的学习。图6c依次改变![]() 和固定

和固定![]() ,当

,当![]() 时,直线趋于稳定,表明模型已尽最大努力达到等式(11)中逆矩阵的解。

时,直线趋于稳定,表明模型已尽最大努力达到等式(11)中逆矩阵的解。

4相关工作

4.1异构图表示学习

HIN嵌入的现有工作倾向于利用元路径来调整异构图,以应用同构图嵌入方法,例如(Perozzi,Al Rfou,and Skinena 2014;Tang et Al.2015;Wang,Cui,and Zhu 2016)。metapath2vec(Dong、Chawla和Swami 2017)设计元路径来引导异构图中的随机游动,然后遵循skip-gram模型来学习顶点的潜在空间表示。受metapath2vec的启发,HERec(Shi et al.2018)提出融合不同元路径方案中学习到的不同表示。metapath2vec和HERec都是由独立于下游任务的链接导向目标函数训练的。为了获得特定任务的最佳嵌入,(Chen和Sun 2017)结合作者识别任务指导和链接指导目标来学习异构图嵌入。HAN(Wang et al.2019)对GNN引入了两级层次注意,其中节点级注意捕获由一个元路径方案生成的相邻节点之间的关系,语义级注意为图中的每个节点聚合多个元路径方案。总之,这些方法都依赖于专家的设计,带来了不可避免的信息损失。

4.2图形神经网络(GNNs)

最近,图形神经网络(GNNs)(Gori、Monfardini和Scarselli 2005;Hamilton、Ying和Leskovec 2017;Kipf和Welling 2017;Battaglia等人2018)的研究越来越多。GNNs通过空间滤波器产生节点嵌入,空间滤波器将每个节点卷积到图的邻域上。卷积运算使GNNs能够逐层传播图的结构信息,使图的嵌入方法从链接引导学习中解放出来。在注意机制蓬勃发展的推动下,GAT(Velickovic et al.2018)将注意策略引入GNN框架。对于知识库的关系学习,R-GCN(Schlichtkrull et al.2018)为一个图中的所有节点建立了多个关系空间,不能捕捉到各种类型节点的相对重要性。RSHN(Zhu et al.2019)专注于通过粗线图挖掘边缘类型的语义交互,并将其纳入H-GNN模型。

5结论

提出了一种基于异构图结构信息的无元路径嵌入方法。我们为HetSANN设计了一个类型感知的注意层,它通过连接不同类型的相邻节点和关联链接来嵌入异构图的每个顶点。基于语音共享产品、循环一致性损失和多任务学习三个扩展,提出了模型的几种变体。在三个流行数据集上的综合实验表明,该方法在HIN嵌入和节点分类方面优于现有的方法。在HetSANN框架下,HIN的表示学习不需要依赖元路径来处理异构结构信息,因此在以后的工作中将考虑顶点的异构属性。