【论文阅读】Representation Learning with Multiple Lipschitz-constrained Alignments on Partially-labeled

标题长度受限,完整的该论文标题为:

论文标题:Representation Learning with Multiple Lipschitz-constrained Alignments on Partially-labeled Cross-domain Data;

作者:Songlei Jian, Liang Hu, Longbing Cao, Kai Lu;

College of Computer, National University of Defense Technology, China;

Advanced Analytics Institute, University of Technology Sydney, Australia;

发表期刊:AAAI 2020;

论文下载地址:https://jiansonglei.github.io/files/20AAAI_MULAN.pdf

摘要:

跨域的表示学习(cross-domain representation learning)在许多任务中都有重要的作用,比如域适应(domain adaptation, DA)和迁移学习(transfer learning)。然而现存的跨域表示学习方法多关注于构建一个源域(source domain)和目标域(target domain)的共享空间,忽略了源域中的无标签数据,这样的话跨域数据的分布和结构异质性(structure heterogeneities)不能被有效提取。

为了解决这个问题,本文提出了一个新的跨域表示学习方法:对部分标记(partially-labeled)的跨域数据采用多层利普希茨限制(Lipschitz-constrained )的对齐方法(MULAN)。MULAN构建了两个表示空间:一个公共表示空间用来合并来自源域的知识;一个互补表示空间,通过 Lipschitz-constrained表示变换,用目标域数据的局部拓扑信息补充公共空间中的表示。

MULAN 利用源域和目标域中的无标签和有标签数据通过 Lipschitz-constrained的对抗性分布对齐来解决分布异质性问题,并通过基于集群假设的类对齐来解决结构异质性,同时通过自对齐保持目标局部拓扑信息的互补表示。进一步,MULAN 使用了自定义的学习过程和一个迭代的参数更新过程。 MULAN 在部分标记的半监督域适应和小样本域适应方面表现出卓越的性能,并且比 state-of-the-art 的视觉域适应模型高出 12.1%。

本文动机及现存方法的不足:

- 由于跨域数据的数据分布异质性和结构异质性,跨域表示学习仍然很难。

- 因为目标域或者源域有限的标签数据,源域和目标域的联系就很有限,要学习跨域的补充信息也很难。

- 现有半监督或者无监督的域适应方法实际上仍然在训练中使用了源域的所有标签,而MULAN在源域和目标域都只使用部分标签,这样显然更符合实际情况。

- 经典的跨域表示学习通常将目标域的数据对齐源域数据,然后将其特征映射到一个公共特征空间中,这样也许会损失目标域的局部拓扑结构以及其数据分布信息。而MULAN构建了两个表示空间,一个公共表示空间用来拟合源域的数据,一个互补空间用来拟合目标域的数据结构然后补充到公共表示空间中。

本文主要贡献:

- 提出了一个新的跨域表示学习方法MULAN,针对现有方法只学习一个公共表示空间的不足,构建了两个表示空间用于学习源域和目标域的数据特征;

- MULAN只需要使用源域和目标域的部分有标签数据即可构建模型;

- 提出了一个自定义的参数学习过程,能够将训练过程中的多步对齐联合起来学习。

- 与域适应的现有SOTA部分标记的半监督方法以及few-shot方法在VisDA数据集上进行实验对比,MULAN性能更好。

本文方法及模型:

如下图1所示,是MULAN的整体过程。

具体步骤为:

1. 先通过映射函数 f_s 和 f_t 将源域数据 X_s 和目标域数据 X_t 映射到各自的特征空间 H_s 和 H_t 中,得到源域数据的特征表示 h_s 和目标域数据的特征表示 h_t ,公式如下:

![]()

![]()

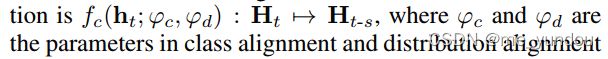

2. 由于源域和目标域数据分布的不一致性,其各自特征空间中的数据特征表示 h_s 和 h_t 不能直接进行对比操作,因此作者将目标域空间 H_t 的特征表示映射到公共表示空间(common representation space)H_{t-s} 中,映射的过程中使用类对齐(class alignment)和分布对齐(distribution alignment)两种约束,以保证目标域数据的局部拓扑结构能够完整映射到公共表示空间中去。

作者限制 f_c 和 f_d 函数满足一阶利普希茨(1-Lipschitz),那么根据三角不等式,![]() 也满足一阶利普希茨限制,根据利普希茨连续性(Lipschitz continuity)的定义和性质(见文中Definition 1,可自行百度),公式(1)中 f 函数具有有界一阶导数,这意味着在变换过程中保持局部结构。即:将目标域特征映射到公开表示空间的过程中,保证了目标域数据的局部结构特征的不变性。

也满足一阶利普希茨限制,根据利普希茨连续性(Lipschitz continuity)的定义和性质(见文中Definition 1,可自行百度),公式(1)中 f 函数具有有界一阶导数,这意味着在变换过程中保持局部结构。即:将目标域特征映射到公开表示空间的过程中,保证了目标域数据的局部结构特征的不变性。

3. 实际的实现中,本文使用具有谱归一化的多层感知器 (SNMLPs) 来实现 1-Lipschitz 函数 [1] 。

4. 接下来本文将公共表示空间(common representation space)中学到的目标域有关knowledge映射到补充表示空间(complementary representation space)中,如下面示意:

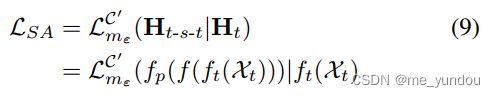

为了在上述映射中保留 H_{t-s} 中学习到的目标域数据的拓扑结构(第3步中学习到的),函数 f_p 也是一个满足一阶利普希茨约束的函数。同时为了保持目标域数据间的差异性,每一个映射后的特征 h_{t-s-t} 都应当能够一对一识别出自己对应的 h_t 数据,也就是作者提出的自对齐(self alignment)限制。如公式(9),作者使用 最大边界类分离(max-margin class separation, MMCS)来确保同一个数据的 h_t 和 h_{t-s-t} 特征表示尽可能接近,而与其他数据的特征表示尽可能远。

作者在公示(9)中设置了margin=1e-3来避免过拟合问题。

过程细节说明:

1. 类对齐(class alignment)

即使源域和目标域中数据的信息很少,比如类别标签信息,但是它们对于跨域的学习仍然是非常重要的,尤其是当跨域的数据分布差异很大时。

聚类假设(cluster assumption)经常被用于解释半监督学习 (SSL) 的成功,它假设输入分布可以划分为由低密度区域分隔开来的簇,其中同一簇中的数据样本共享相同的标签。

根据聚类假设,源域和目标域的少量有标签数据样本就可以用来对齐其余无标签数据,以辅助跨域的学习。本文使用最大边界类分离(max-margin class separation, MMCS)的loss来增大不同类别的数据表示之间的距离,使边界更清晰。

通用的MMCS loss形式如下面公式(3),A和B分别表示不同域。d()计算输入两者的欧氏距离,[x]_0 代表 max(0, x)。![]() 是一个指示函数,只有当a和b_i属于同一个类别且a和b_j属于不同类别时,该指示函数的值才为1,其他情况下该指示函数的值都是0.

是一个指示函数,只有当a和b_i属于同一个类别且a和b_j属于不同类别时,该指示函数的值才为1,其他情况下该指示函数的值都是0.

最小化上述MMCS loss能够将输入数据依照不同类别分割成不同的簇,簇间距离最小是m。

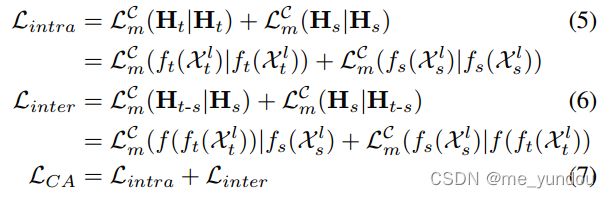

本文设计的类对齐(class alignment)loss L_{CA} 包含一个域内MMCS loss L_{intra} 和一个域间MMCS loss L_{inter},具体公式如下:

通过最小化 L_{intra} 能够保持源域和目标域各自的数据依靠部分有标记数据进行正确地聚类(相当于帮助无标签数据获取一个弱标签的过程)。通过最小化 L_{inter} 且借助于一阶利普希茨约束就能在特征空间 H_{t-s} 中对齐 H_s 的数据局部拓扑结构,传递簇结构,实现跨域传递类别信息。

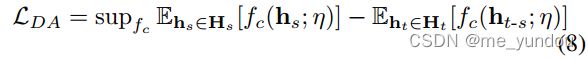

2. 分布对齐(distribution alignment)

如果想要利用上源域里的无标签数据,一个直接的想法就是对于源域和目标域的数据分布。但是在没有标签的情况下直接对齐分布可能会将不同域的不同类别对齐,而没有正确对齐同类。

因此,本文在对齐分布的同时对齐类,两者相辅相成,如公式(1)中的 f_d 和 f_c ,模型训练的时候他俩迭代地一个固定一个训练,这样就行了。

为了找到最优的 f_d,本文使用对抗学习最小化一个 Wasserstein distance ,如下面公式(8)。其中一阶利普希茨函数 f_c 使用 SNMLP实现,作为标准。

训练过程:

MULAN方法的总loss如下面公式(12),其中 L_{CA} 是类对齐class alignment的loss,L_{DA} 是分布对齐distribution alignment的loss, L_{SA} 是自对齐self alignment的loss:

作者通过迭代训练的方法来更新这两个loss,具体算法伪代码见文中Algorithm 1. 关键步骤是:先固定 L_{DA} 的参数来重定义聚类假设,然后固定 L_{CA} 和 L_{SA} 的参数来对齐跨域的数据分布。

实验:

数据集:传统的DA数据集,比如MNIST,USPS 和 SVHN被证明在几乎所有模型上都被高估了,得到了非常高的准确率。因此本文采用了最新的VisDA Challenge数据集 [2] 来做实验。这个数据集里面有152,397张合成的图像,55,388张来自MSCOCO的真实图像。

对比方法:Source-only(i.e., classifier trained only on source domain without adaptation) ,ADA ,DANN ,DIRT-T ,TADT ,CCSA;

实验设置:对比方法的参数同其各自论文;本文模型的参数设置在文中各处分别说明了,详见论文原文,图像处理使用在ImageNet上预训练的ResNet50模型;

消融实验:MULAN_{Com} 只包含公共表示空间,没有互补表示空间。

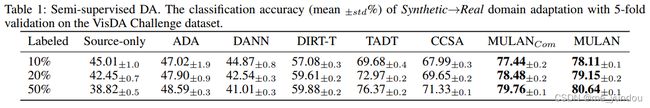

图像分类结果:如下表1,左列代表不同百分比的有标签数据。 半监督的方法CCSA, TADT普遍好于无监督方法ADA, DANN, DIRT-T,尤其是随着有标签数据的增多,分类准确性更好。MULAN好于所有方法。

可视化:下图2将1200个图像样例进行了可视化,可以看出原始的图像特征(直接从ResNet50中拿到)(b)类别边界并不明显,而且源域和目标域有明显的数据分布差距。而MULAN(g)将类别区分地很好,且不同域的同类数据也对齐了。

少样本域适应(few-shot DA):结果见表2。该实验中源域中有50%有标签数据,而目标域中有标签数据只有5,10,20个。实验中使用两种分类器,一种是用源域的有标签数据进行训练的,另一种是用目标域的有标签数据进行训练的。

结论及展望:

本文提出了MULAN来解决部分标签的域适应表示学习的问题。

关于MULAN后续可以有几个扩展:可以扩展为多域学习问题(multi-domain learning),通过灵活地在模型上添加更多的对齐限制;可以扩展为多模态学习问题(multi-modal learning)通过更改原始的特征学习部分。

参考文献:

[1] Miyato, T.; Kataoka, T.; Koyama, M.; and Yoshida, Y. 2018. Spectral normalization for generative adversarial networks. ICLR.

[2] Peng, X.; Usman, B.; Kaushik, N.; Hoffman, J.; Wang, D.; and Saenko, K. 2017. Visda: The visual domain adaptation challenge. arXiv preprint arXiv:1710.06924.

个人理解及问题:

1. 部分有标记的数据Partially-labeled data,是哪部分数据有标记,如何选取这些数据?随机采样的吗?如果有标记的数据所占类别少而同类数量多(不能覆盖所有的类别),是否会影响最后模型性能?如果这些有标记的数据是每一类都有,那么对实验结果来说肯定是有助的。可是这样的假设也有点强了。