PyTorch学习笔记(7)--神经网络:池化层

PyTorch学习笔记(7)–神经网络:池化层

本博文是PyTorch的学习笔记,第7次内容记录,主要介绍神经网络池化层的基本使用。

目录

- PyTorch学习笔记(7)--神经网络:池化层

- 1.池化操作

-

- 1.1什么是池化操作

- 1.2池化操作的类型

- 1.3池化操作的步骤

- 2.池化层

-

- 2.1池化层相关参数

- 2.2最大池化应用实例1--处理矩阵

- 2.3最大池化应用实例2--处理图片

- 2.4池化层input和output尺寸信息

- 3.学习小结

1.池化操作

1.1什么是池化操作

池化操作(Pooling)是CNN中非常常见的一种操作,Pooling层是模仿人的视觉系统对数据进行降维,池化操作通常也叫做子采样(Subsampling)或降采样(Downsampling),在构建卷积神经网络时,往往会用在卷积层之后,通过池化来降低卷积层输出的特征维度,有效减少网络参数的同时还可以防止过拟合现象。

可以简单的理解池化操作的作用:将一个尺寸较大的图像通过池化操作转换成尺寸较小的图像,但是这个操作过程中尽量保留原始图像的特征。关于池化的介绍可以参照这个博文:池化操作。

通过池化操作可以达到如下的效果:

1. 抑制噪声,降低信息冗余

2. 提升模型的尺度不变性、旋转不变形

3. 降低模型计算量

4. 防止过拟合

1.2池化操作的类型

池化操作类型较多,在PyTorch官网中有关于池化操作类型的介绍,参照pyTorch官网,常用的池化操作包括:最大池化、平均池化、随机池化、中值池化等。最常用的是最大池化和平均池化,本文以最大池化介绍神经网络的池化层。

1.3池化操作的步骤

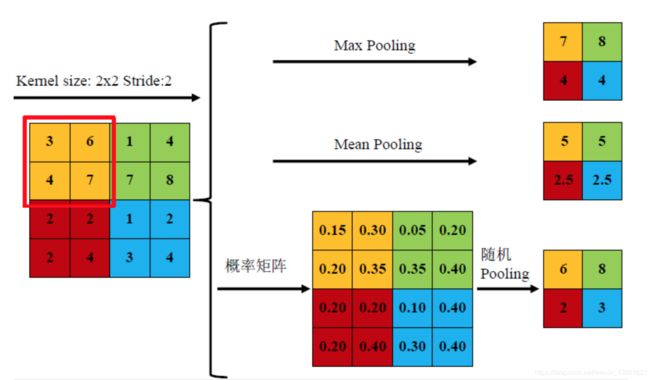

以最大池化操作为例,下图展示了池化操作的基本过程:

在池化操作中也和卷积操作类似,有kernel_size这个参数,在卷积层中叫卷积核,在池化层中叫池化核,上图中池化核大小设置为2,也就是kernel_size=2,同时将步长stride=2。最大池化就是取池化核所覆盖区域中最大的值作为输出值,以上图中左上角黄色区域的为例,3、6、4、7四个数字中最大的为7,因此执行最大池化操作之后,得到的输出结果为7。

2.池化层

2.1池化层相关参数

在PyTorch官网中,详细介绍了池化操作的函数:torch.nn.MaxPool2d(kernel_size, stride=None, padding=0, dilation=1, return_indices=False, ceil_mode=False),在该函数中可以看出执行池化操作有kernel_size、 stride=None、 padding=0、 dilation=1、 return_indices=False、 ceil_mode=False共6个参数需要设置。对这6个参数的说明如下:

- kernel_size:池化核的大小,类型为int 或者元组,当池化是方形的时候,只需要一个整数边长即可,池化不是方形,要输入一个元组表示 高和宽【必选】(例如:设置kernel_size=3时,会自动生成一个3×3的池化核)。

- stride:步长的大小,与卷积层不同,池化层步长大小默认为kernel_size的大小。 【可选】

- padding:在输入图像外围增加一圈0。【可选】

- dilation:控制窗口中元素步幅的参数,较少使用。【可选】

- return_indices:如果为True,将返回最大索引以及输出。适用于torch.nn.maxUnpol2D以后版本,较少使用。【可选】

- ceil_mode:如果为True,将使用ceil而不是floor来计算输出形状,较少使用,关于ceil和floor可以参考下述博文:ceilfloorround三个取整函数【可选】

2.2最大池化应用实例1–处理矩阵

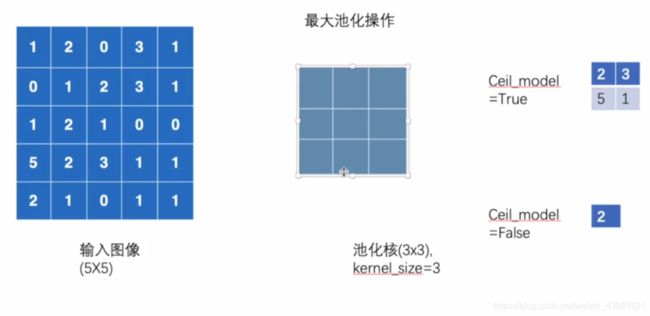

现以池化矩阵的操作为例,介绍池化操作的具体代码实现。现在有图所示的矩阵,同时设置kernel_size=3,验证计算结果是否正确。

- 当ceil_mode=True时,使用ceil输出结果。具体代码和输出结果如下:

# coding :UTF-8

# 文件功能: 代码实现神经网络--池化层功能

# 开发人员: dpp

# 开发时间: 2021/8/17 4:53 下午

# 文件名称: nn_maxpool.py

# 开发工具: PyCharm

import torch

from torch import nn

from torch.nn import MaxPool2d

input = torch.tensor([[1, 2, 0, 3, 1],

[0, 1, 2, 3, 1],

[1, 2, 1, 0, 0],

[5, 2, 3, 1, 1],

[2, 1, 0, 1, 1]], dtype=torch.float32)

input = torch.reshape(input, (-1, 1, 5, 5))

print(input.shape)

class Test(nn.Module):

def __init__(self):

super(Test, self).__init__()

self.maxpool1 = MaxPool2d(kernel_size=3, ceil_mode=True)

def forward(self, input):

output = self.maxpool1(input)

return output

test = Test()

output = test(input)

print(output)

输出结果为:

torch.Size([1, 1, 5, 5])

tensor([[[[2., 3.],

[5., 1.]]]])

- 当ceil_mode=False时,使用floor输出结果。具体代码和输出结果如下:

# coding :UTF-8

# 文件功能: 代码实现神经网络--池化层功能

# 开发人员: dpp

# 开发时间: 2021/8/17 4:53 下午

# 文件名称: nn_maxpool.py

# 开发工具: PyCharm

import torch

from torch import nn

from torch.nn import MaxPool2d

input = torch.tensor([[1, 2, 0, 3, 1],

[0, 1, 2, 3, 1],

[1, 2, 1, 0, 0],

[5, 2, 3, 1, 1],

[2, 1, 0, 1, 1]], dtype=torch.float32)

input = torch.reshape(input, (-1, 1, 5, 5))

print(input.shape)

class Test(nn.Module):

def __init__(self):

super(Test, self).__init__()

self.maxpool1 = MaxPool2d(kernel_size=3, ceil_mode=False)

def forward(self, input):

output = self.maxpool1(input)

return output

test = Test()

output = test(input)

print(output)

输出结果为:

torch.Size([1, 1, 5, 5])

tensor([[[[2.]]]])

2.3最大池化应用实例2–处理图片

以最大池化操作处理二维照片为例,数据集仍选择CIFAR10,代码如下:

# coding :UTF-8

# 文件功能: 代码实现神经网络--池化层功能

# 开发人员: dpp

# 开发时间: 2021/8/17 4:53 下午

# 文件名称: nn_maxpool.py

# 开发工具: PyCharm

import torch

import torchvision

from torch import nn

from torch.nn import MaxPool2d

from torch.utils.data import DataLoader

from torch.utils.tensorboard import SummaryWriter

dataset = torchvision.datasets.CIFAR10("CIFAR10", train=False, download=True,

transform=torchvision.transforms.ToTensor())

dataloader = DataLoader(dataset, batch_size=64)

class Test(nn.Module):

def __init__(self):

super(Test, self).__init__()

self.maxpool1 = MaxPool2d(kernel_size=3, ceil_mode=False)

def forward(self, input):

output = self.maxpool1(input)

return output

test = Test()

step = 0

writer = SummaryWriter("logs")

for data in dataloader:

imgs, targets = data

writer.add_images("input", imgs, step)

output = test(imgs)

writer.add_images("output", output, step)

step = step + 1

writer.close()

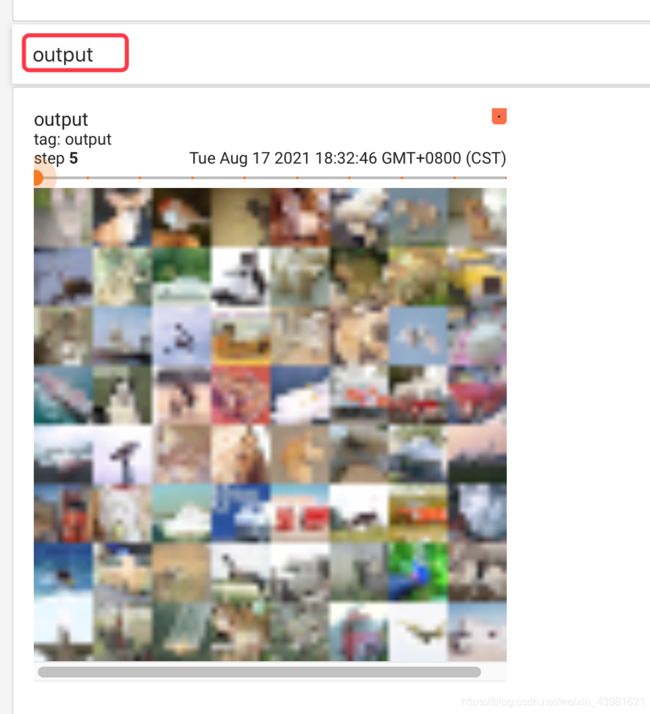

借助Tensorboard,看到如下的输入和输出结果:

通过对比输入图像和输出图像可知,输出图像比输入图像模糊,有点像加了马赛克的感觉,但是仍然保留了图像的基本特征。

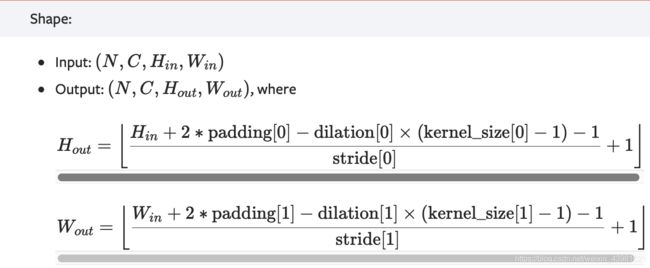

2.4池化层input和output尺寸信息

在input和output中,要重点关注尺寸信息,对于输入和输出的尺寸信息计算关系如下所示,更多细节可参照PyTorch官网信息PyTorch官网。

3.学习小结

在本文中总结了神经网络的池化层的基本使用方法,并通过构建一个类Test介绍二维的最大池化MaxPool2d的具体使用方法,在下一篇博文,将开始介绍神经网络的非线性激活层。