CVPR-2020-SiamBAN:Siamese Box Adaptive Network for Visual Tracking阅读笔记

论文地址:https://arxiv.org/pdf/2003.06761.pdf

论文代码:https://github.com/hqucv/siamban

一、 动机:

现有的追踪器大多依赖于多尺度测试和预定义的锚框来对目标进行精确地位,但这样就需要先验知识和一系列设计候选盒子的超参数,所以为了解决这个问题设计了更加灵活通用的SiamBAN。该算法将视觉跟踪问题视为一个并行分类和回归问题,直接对目标进行分类,并在统一的FCN中回归其边界框。并且,神经科学家已经表明,生物视觉初级视觉皮层可以快速有效地从复杂环境中提取观察物体的轮廓或边界。也就是说,人类可以在没有候选框的情况下识别物体的位置和边界。

二、 主要贡献

① 设计了一个候选框自适应孪生网络,可以使用深度卷积神经网络对标注良好的数据集进行端到端离线训练。

② SiamBAN中的无先验盒设计避免了与候选盒相关的超参数,使该跟踪器更加灵活和通用。

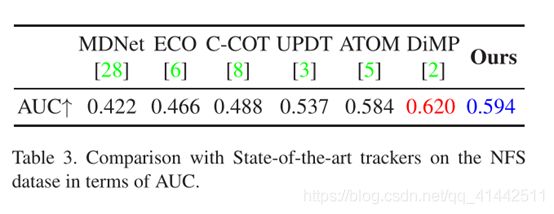

③ SiamBAN不仅实现了最先进的结果,而且在跟踪基准VOT2018,VOT2019,OTB100,NFS,UAV123,和LaSOT上实现了40帧每秒的运行速度。

三、 主要内容

网络框架:

SiamBAN由一个Siamese网络骨干网和多个盒式自适应头组成。Siamese网络主干负责计算模板补丁和搜索补丁的卷积特征映射。盒式自适应头包括分类模块和回归模块。分类模块对相关层的每一点进行前景-背景分类,回归模块对相应位置进行bounding box预测。

Siamese Network Backbone

SiamBAN采用ResNet-50作为骨干网,并去掉了最后两个卷积块的降采样操作。使用扩张卷积,在模型中采用不同的扩张率。conv4、conv5网络的步长都设为1,conv4、conv5模块的扩张率分别设为了2和4。最终输出的三个特征图尺寸是一样的。

为什么使用conv3、conv4、conv5?

消融研究中对conv3、conv4、conv5三层提取的特征进行聚合后,跟踪器取得的效果最好。

为什么要去掉两个卷积块的降采样操作?

Siamese网络的跟踪器需要详细的空间信息来执行密集的预测。为了解决这个问题,去掉了最后两个卷积块的降采样操作。

为什么使用扩张卷积?

为了改善感受野。扩张卷积可以在不改变特征图尺寸的同时增大感受野。

如上图所示,(a)是我们常见的卷积核,可以看成d=1的扩张卷积,核的尺寸为3,感受野为3;(b)是d=2的扩张卷积,核的尺寸上升为5=2*(3-1)+1,如果与(a)叠加使用的话感受野则为7;(c)是d=4的扩张卷积,核的尺寸上升为9=4*(k-1)+1,若与(a)(b)叠加则感受野区域为15;经过dilation rate放大后,fliter大小上升为:d*(k-1)+1。扩张卷积的输入和输出特征图的尺寸关系如下:

![]()

kernel size = k, dilation rate = d, input size = W1, output size = W2, stride=s, padding=p;

以上内容引用于https://www.cnblogs.com/zf-blog/p/12101300.html

Box Adaptive Head部分

Box Adaptive Head由分类模块和回归模块组成。这两个模块从模块分支和搜索分支接受[ϕ(z)]cls、 [ϕ(z)]reg、[ϕ(x)]cls、[ϕ(x)]reg特性到相应模块。然后,分类模块输出两个通道进行前景背景分类,回归模块输出四个通道进行包围盒预测。每个模块使用一个深度相关层来组合特性图:

[ϕ(z)]cls或[ϕ(z)]reg作为卷积核,分类特征图Pclsw×h×2和回归特征图Pregw×h×4可以映射到搜索patch上。比如:特征图上的(i,j)位置在搜索patch上的相应位置为

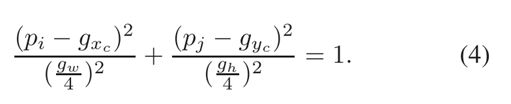

[⌊wim/2⌋ + (i −⌊w/2⌋)×s, ⌊him/2⌋+(j−⌊h/2⌋)×s]即为(pi,pj)。wim him分别代表输入patch的宽和高,s是网络总步长。(i,j)是特征图上接受域的中心位置。对于基于锚点的追踪器来说,跟踪器将位置(pi, pj)作为锚点盒的中心,回归位置(pi, pj),宽度和高度。也就是说,对于位置(i, j),回归可以调整其所有的偏移值,但是分类仍然在原来的位置进行,这可能导致分类和回归不一致。因此,SiamBAN不调整位置(pi, pj),只计算其对边界框的偏移值。(此处还没有理解好,参考一篇博客:https://www.bilibili.com/read/cv7541809/,或者说通过回归预测了一个新的点,已经不是原来的点了)此外,由于回归目标是正实数,所以回归模块的最后一层应用exp(x)将任何实数映射到(0,+∞)。

Multi-level Prediction部分

采用多盒自适应头利用多层次特征进行预测。每个检测头得到的分类图和回归图自适应融合:

Ground-truth and Loss部分

如果位置(pi, pj)位于椭圆E2内,则为其赋正样本,如果位于椭圆E1外,则为其赋负样本,如果位于椭圆E2和E1之间,则作为缓冲,忽略模棱两可的样本。虽然负样本远少于基于锚点的跟踪器(SiamRPN++、SiamRPN),但负样本仍然远多于正样本。因此,从一个图像对中最多收集16个正样本和48个负样本用带正标签的位置(pi, pj)对包围盒进行回归,回归目标(pi,pj)到四个边界框的距离可表述为:

最终预测框左上角和右下角坐标(px1,py1)(px2,py2):

在预测框生成后,我们利用余弦窗和缩放变化惩罚平滑目标的运动和改变(添加余弦窗来抑制大位移,然后添加惩罚来抑制尺寸和比例的大变化),然后选择得分最好的预测框,通过与前一帧状态的线性插值更新其大小。

四、 实验结果

五、 总结

本文利用完全卷积网络的表达能力,提出了一个简单而有效的视觉跟踪框架SiamBAN,它不需要多尺度搜索模式和预先定义的候选框。SiamBAN直接对对象进行分类,并在统一的网络中回归边界框。因此,视觉跟踪问题成为一个分类回归问题。在6个视觉跟踪基准上的大量实验表明,SiamBAN达到了最先进的性能,以40帧每秒的速度运行,证实了它的有效性和效率。