《机器学习(周志华)》Chapter7 贝叶斯分类 课后习题答案

7.1 试使用极大似然法估算西瓜数据集3.0中前3个属性的类条件概率.

即求属性为X={色泽, 根蒂, 敲声},c={是, 否},的类条件概率P(x|c)

根据西瓜书P149.极大似然法,同理假设P(x|c)具有确定的形式并且被参数向量θc唯一确定。

根据公式可得题目转化为求:

$$LL(\mathop \theta \nolimits_C ) = \sum\limits_{x \in \mathop D\nolimits_c } {\log P(x|\mathop \theta \nolimits_c )} $$

$$\mathop {\mathop \theta \nolimits_c }\limits^ \wedge = \mathop {\arg \max }\limits_{\mathop \theta \nolimits_c } LL(\mathop \theta \nolimits_c )$$

而书中对连续属性情况下假设概率密度函数服从正太分布,而题目是离散属性,离散属性的极大似然估计可参考以下网址:

https://baike.baidu.com/item/%E6%9E%81%E5%A4%A7%E4%BC%BC%E7%84%B6%E4%BC%B0%E8%AE%A1/3350286#reference-[2]-185250-wrap

https://zhidao.baidu.com/question/568276383.html?qbl=relate_question_0&word=%C0%EB%C9%A2%CB%E6%BB%FA%B1%E4%C1%BF%B5%C4%BC%AB%B4%F3%CB%C6%C8%BB%B9%C0%BC%C6

若存在未知参数θc,则可使用最大似然函数求导等于零解出,但题目中可以求出各属性的概率分布,三个属性很明显相互独立则可用联合概率公式求出题目答案:

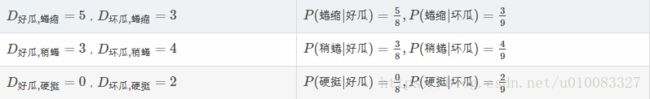

好瓜:

色泽:

根蒂:

敲声:

7.2 试证明:条件独立性假设不成立时,朴素贝叶斯分类器仍有可能产生最优贝叶斯分类器。

7.3 试编程实现拉普拉斯修正的朴素贝叶斯分类器,并以西瓜数据集3.0为训练集,对p.151 “测1”样本进行判别。

查看完整代码及数据集

7.4 实践中使用式(7.15)决定分类类别时,若数据维度非常高,则概率连乘$\prod\nolimits_{i = 1}^{\rm{d}} {P(\mathop x\nolimits_i |c)} $的结果通常会非常接近于0从而导致下溢。试述防止下溢的可能方案。

从最大似然估计那节我们可以看到取对数可以防止下溢,则$$\log P(c) + \sum\limits_{i = 1}^d {\log P(\mathop x\nolimits_i |c)} $$

7.5 试证明:二分类任务中两类数据满足高斯分布并且方差相同时,线性判别分析产生贝叶斯最优分类器。

7.6 编程实现AODE分类器,并以西瓜数据集3.0为训练集,对p.151的“测1”样本进行判别。

查看完整代码及数据集

7.7 给定d个二值属性的二分类任务,假设对于任何先验概率项的估计至少需要30个样例,则在朴素贝叶斯分类器(7.15)中估算先验概率项P(c)需30X2=60个样例。试估计在AODE式(7.23)中估算先验概率项P(c,xi)所需的样例数(分别考虑最好和最坏情形)

P(c,xi)所需要的样例数(分别考虑最好和最坏情形)

。

7.9 以西瓜数据集2.0为例,基于BIC准则构建一个贝叶斯网。

7.10 以西瓜数据集2.0中属性“脐部”为隐变量,试基于EM算法构建一个贝叶斯网。

参考网址:

https://blog.csdn.net/victoriaw/article/details/78257488