大数据基础之Hadoop安装、部署及配置过程

一、基础环境的安装与配置

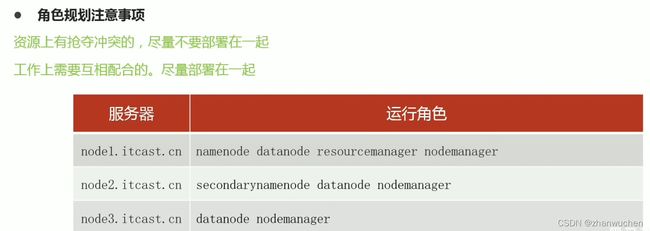

1.集群的规划:

主要包括NameNode、ResourceManager、NodeManager、SecondaryNameNode、DataNode这些角色与机器的划分,如下图

2.主机名修改

vim /etc/hostname分别修改为:node1.itcast.cn、node2.itcast.cn、node3.itcast.cn

3.hosts映射

vim /etc/hosts

192.168.88.151 node1.itcast.cn node1

192.168.88.152 node2.itcast.cn node2

192.168.88.153 node3.itcast.cn node34.防火墙关闭

firewall-cmd --state #查看防火墙状态

systemctl stop firewalld.service #停止firewalld服务

systemctl disable firewalld.service #开机禁用firewalld服务5.ssh免密登录:只需要在node1配置

#node1生成公钥私钥 (一路回车)

ssh-keygen

#node1配置免密登录到node1 node2 node3

ssh-copy-id node1

ssh-copy-id node2

ssh-copy-id node36.集群时间同步(三台机器一起)

yum -y install ntpdate

ntpdate ntp5.aliyun.com7.创建统一工作目录

mkdir -p /export/server/ #软件安装路径

mkdir -p /export/data/ #数据存储路径

mkdir -p /export/software #安装包存放路径8.安装JDK1.8(三台机器)

三台机器同时上传 jdk-8u241-linux-x64.tar.gz到/export/server/目录下

cd /export/server/

tar zxvf jdk-8u241-linux-x64.tar.gz配置环境变量:

vim /etc/profile

#使用vim快捷键 G o:直接在最后一行下方进行编辑

export JAVA_HOME=/export/server/jdk1.8.0_241

export PATH=$PATH:$JAVA_HOME/bin

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

#shift+zz快捷保存退出

#使用scp命令复制配置文件

scp -r /etc/profile root@node2:/etc

scp -r /etc/profile root@node3:/etc

#重新加载环境变量文件

source /etc/profile

#检查jdk版本验证是否安装成功

java -version二、Hadoop的安装

1.在node1上传、解压hadoop安装包

本次使用的版本是:hadoop-3.3.0-Centos7-64-with-snappy.tar.gz

cd /export/server

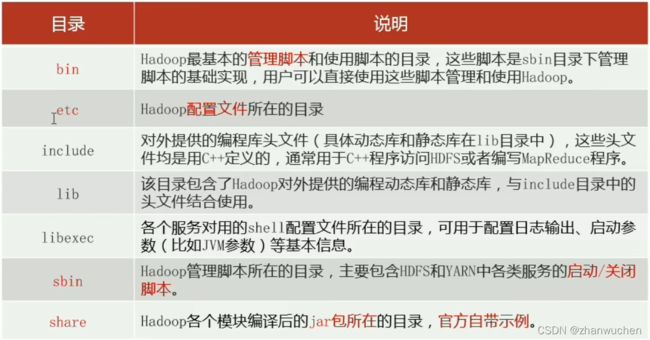

tar zxvf hadoop-3.3.0-Centos7-64-with-snappy.tar.gz2.查看Hadoop安装包目录结构:

三、修改Hadoop配置文件

主要修改内容包括:

1.修改hadoop-env.sh配置文件:

cd etc/hadoop/

vi hadoop-env.sh

#文件最后添加G o快捷键

export JAVA_HOME=/export/server/jdk1.8.0_241

export HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root 2.配置core-site.xml文件:

fs.defaultFS

hdfs://node1:8020

hadoop.tmp.dir

/export/data/hadoop-3.3.0

hadoop.http.staticuser.user

root

hadoop.proxyuser.root.hosts

*

hadoop.proxyuser.root.groups

*

fs.trash.interval

1440

3.配置hdfs-site.xml文件:

dfs.namenode.secondary.http-address

node2:9868

4.配置mapred-site.xml文件:

mapreduce.framework.name

yarn

mapreduce.jobhistory.address

node1:10020

mapreduce.jobhistory.webapp.address

node1:19888

yarn.app.mapreduce.am.env

HADOOP_MAPRED_HOME=${HADOOP_HOME}

mapreduce.map.env

HADOOP_MAPRED_HOME=${HADOOP_HOME}

mapreduce.reduce.env

HADOOP_MAPRED_HOME=${HADOOP_HOME}

5.配置yarn-site.xml文件:

yarn.resourcemanager.hostname

node1

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.nodemanager.pmem-check-enabled

false

yarn.nodemanager.vmem-check-enabled

false

yarn.log-aggregation-enable

true

yarn.log.server.url

http://node1:19888/jobhistory/logs

yarn.log-aggregation.retain-seconds

604800

6.配置workers

vi workers

#dd删除原有信息,输入以下从节点信息,快捷键i进入编辑

node1.itcast.cn

node2.itcast.cn

node3.itcast.cn7.同步Hadoop安装包至node2及node3

cd /export/server

# $PWD代表当前路径

scp -r hadoop-3.3.0/ root@node2:$PWD

scp -r hadoop-3.3.0/ root@node3:$PWD8.将Hadoop添加到环境变量(3台机器)

vim /etc/profile

#使用快捷键G o编辑

export HADOOP_HOME=/export/server/hadoop-3.3.0

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

#shit+zz退出,scp到另外两台机器

scp /etc/profile root@node2:/etc

scp /etc/profile root@node3:/etc

#在统一发送命令行中,重新加载配置文件

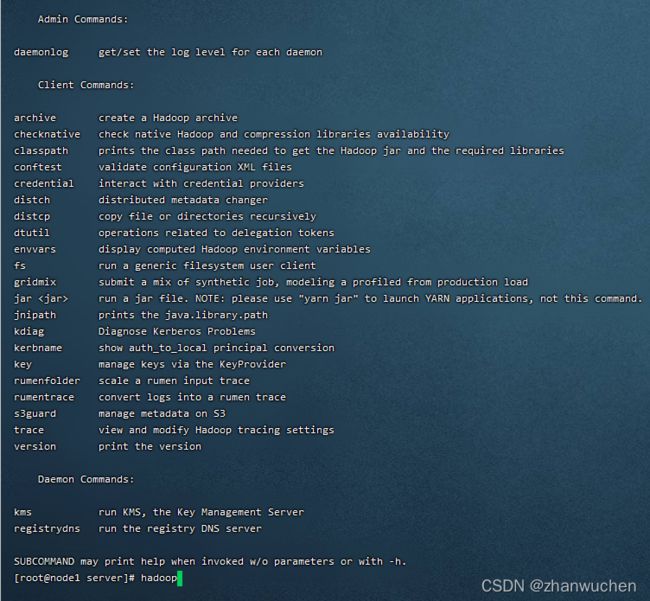

source /etc/profile9.验证Hadoop是否正常安装

#在统一发送命令行输入hadoop

hadoop三台机器都出现以上信息,表示hadoop已经在三台机器上面都成功安装。