深度学习笔记 —— 转置卷积

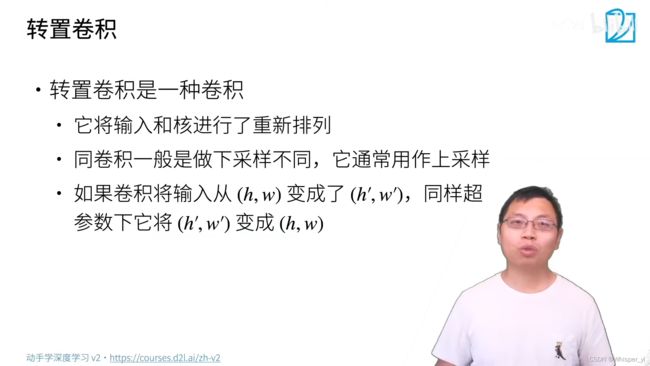

语义分割要做像素级别的预测,但是卷积不断地减小高宽,所以需要另外一种卷积把小的高宽变大。

转置卷积:输入中的单个元素与kernel按元素做乘法但不相加,然后按元素写回到原始的地方。

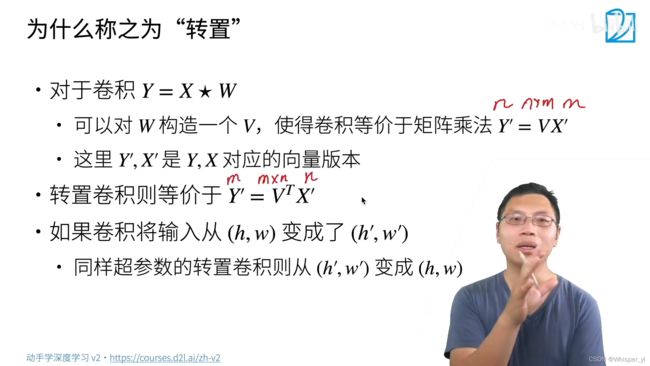

再谈转置卷积:

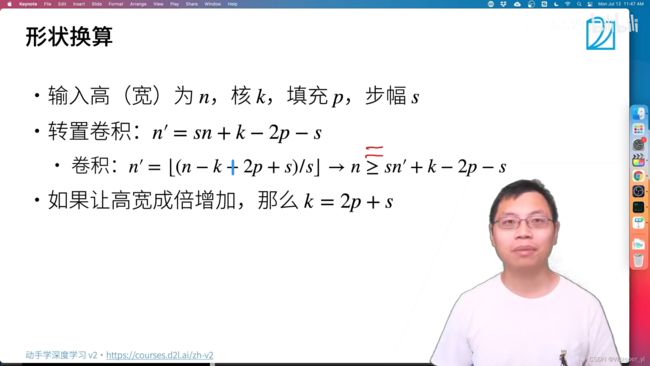

换算成卷积之后,卷积是正常卷积,也就是填充为0,步幅为1,与前面填充和步幅是无关的。

换算成卷积之后,卷积是正常卷积,也就是填充为0,步幅为1,与前面填充和步幅是无关的。

如果要做逆变换需要能推出来:n >= sn' + k - 2p - s(刚好整除的情况下取等号)

转置卷积是形状上做逆运算,但元素值不是。转置卷积本质上还是一种卷积。

import torch

from torch import nn

from d2l import torch as d2l

# 实现基本的转置卷积运算

def trans_conv(X, K):

h, w = K.shape

Y = torch.zeros((X.shape[0] + h - 1, X.shape[1] + w - 1))

for i in range(X.shape[0]):

for j in range(X.shape[1]):

Y[i: i + h, j: j + w] += X[i, j] * K

return Y

# 验证上述实现输出

X = torch.tensor([[0.0, 1.0], [2.0, 3.0]])

K = torch.tensor([[0.0, 1.0], [2.0, 3.0]])

print(trans_conv(X, K))

# 使用高级API获得相同的结果

X, K = X.reshape(1, 1, 2, 2), K.reshape(1, 1, 2, 2)

tconv = nn.ConvTranspose2d(1, 1, kernel_size=2, bias=False)

tconv.weight.data = K

print(tconv(X))

# 填充、步幅和多通道

# 填充在输出上面

tconv = nn.ConvTranspose2d(1, 1, kernel_size=2, padding=1, bias=False)

tconv.weight.data = K

print(tconv(X))

tconv = nn.ConvTranspose2d(1, 1, kernel_size=2, stride=2, bias=False)

tconv.weight.data = K

print(tconv(X))

X = torch.rand(size=(1, 10, 16, 16))

conv = nn.Conv2d(1, 1, kernel_size=5, padding=2, stride=3)

tconv = nn.ConvTranspose2d(1, 1, kernel_size=5, padding=2, stride=3)

print(tconv(conv(X)).shape == X.shape)

# 与矩阵变换的联系

X = torch.arange(9.0).reshape(3, 3)

K = torch.tensor([[1.0, 2.0], [3.0, 4.0]])

Y = d2l.corr2d(X, K)

print(Y)

def kernel2matrix(K):

k, W = torch.zeros(5), torch.zeros((4, 9))

k[:2], k[3:5] = K[0, :], K[1, :]

W[0, :5], W[1, 1:6], W[2, 3:8], W[3, 4:] = k, k, k, k

return W

W = kernel2matrix(K)

print(W)

print(Y == torch.matmul(W, X.reshape(-1)).reshape(2, 2))

Z = trans_conv(Y, K)

print(Z == torch.matmul(W.T, Y.reshape(-1)).reshape(3, 3))