- Python 学习 第五册 深度学习 第1章 什么是深度学习

weixin_38135241

python学习深度学习人工智能

----用教授的方式学习。目录1.1人工智能、机器学习与深度学习1.1.1人工智能1.1.2机器学习1.1.3从数据中学习表示1.1.4深度学习之“深度”1.1.5用三张图理解深度学习的工作原理1.2深度学习之前:机器学习简史1.2.1概率建模1.2.2核方法1.2.3决策树、随机森林与梯度提升机1.2.4深度学习有何不同什么是深度学习?1.1人工智能、机器学习与深度学习三者关系:1.1.1人工智

- 深度学习:让机器学会“思考”的魔法

AI极客Jayden

AI深度学习

文章目录引言:从“鹦鹉学舌”到“举一反三”一、深度学习是什么?1.定义:机器的“大脑”2.核心思想:从数据中“悟”出规律二、深度学习的“大脑”结构:神经网络1.神经元:深度学习的基本单元2.神经网络:多层“神经元”的组合3.深度:为什么需要多层?三、深度学习如何“学习”?1.训练过程:从“笨拙”到“熟练”2.损失函数:衡量“错误”的尺子3.反向传播:从错误中“反思”四、深度学习的“超能力”1.图像

- 目标检测YOLO实战应用案例100讲-基于深度学习的无人机目标检测算法轻量化研究(中)

林聪木

目标检测YOLO深度学习

目录基于改进YOLOv5的无人机图像实时目标检测4.1引言4.2基于改进YOLOv5的目标检测模型结构4.3消融实验及结果分析4.4算法迁移验证实验基于Jetson-Xavier的模型优化部署5.1引言5.2基于人在回路的目标检测模型裁剪5.3嵌入式实时目标检测交互软件基于深度学习的无人机目标检测算法轻量化研究知识拓展基于YOLOv8/YOLOv7/YOLOv6/YOLOv5的无人机目标检测1.数

- 2025年第二届机器学习与神经网络国际学术会议(MLNN 2025)

分享学术科研与论文的禁小默

机器学习神经网络人工智能

重要信息官网:www.icmlnn.org时间:2025年4月22-24日地点:中国-重庆简介2025年第二届机器学习与神经网络国际学术会议(MLNN2025)围绕学习系统与神经网络的核心理论、关键技术和应用展开讨论,涵盖深度学习、计算机视觉、自然语言处理、强化学习等多个子领域,通过特邀报告、主题演讲、海报展示等形式,展示相关领域的最新研究成果和技术创新。征稿主题神经网络机器学习深度学习算法及应用

- 深度学习--概率

fantasy_arch

深度学习人工智能

1基本概率论1.1假设我们掷骰子,想知道1而不是看到另一个数字的概率,如果骰子是公司,那么所有6个结果(1..6),都有相同的可能发生,因此,我们可以说1发生的概率为1/6.然而现实生活中,对于我们从工厂收到的真实骰子,我们需要检查它是否有瑕疵,唯一的办法就是多投掷骰子,对于每个骰子观察到的[1.2...6]的概率随着投掷次数的增加,越来越接近1/6.导入必要的包%matplotlibinline

- YOLOv8 改进:添加 AKConv(任意采样形状和任意数目参数的卷积)

鱼弦

人工智能时代YOLO

YOLOv8改进:添加AKConv(任意采样形状和任意数目参数的卷积)引言在目标检测领域中,YOLO(YouOnlyLookOnce)系列因其速度和效率而受到广泛关注。为了进一步优化模型性能,可以引入创新的卷积操作,例如AKConv,即“任意采样形状和任意数目参数的卷积”。这种卷积能够灵活地调整采样策略,以更好地适应输入特征。技术背景传统卷积运算在采样位置和参数数量上具有固定性,这限制了其对复杂几

- Open3D 点云DBSCAN聚类算法

MelaCandy

算法聚类numpy计算机视觉图像处理3d

目录一、DBSCAN基本原理二、代码实现2.1关键函数2.2完整代码三、实现效果3.1原始点云3.2聚类后点云Open3D点云算法汇总及实战案例汇总的目录地址:Open3D点云算法与点云深度学习案例汇总(长期更新)-CSDN博客一、DBSCAN基本原理DBSCAN(Density-BasedSpatialClusteringofApplicationswithNoise)是一种基于密度的聚类算法,

- 目标检测领域总结:从传统方法到 Transformer 时代的革新

DoYangTan

目标检测系列目标检测transformer人工智能

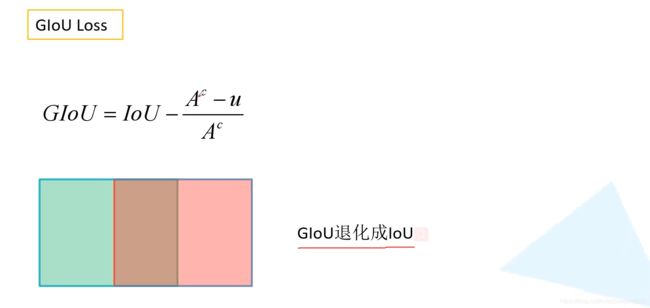

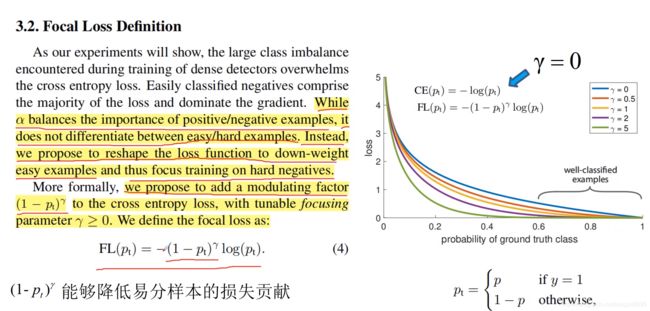

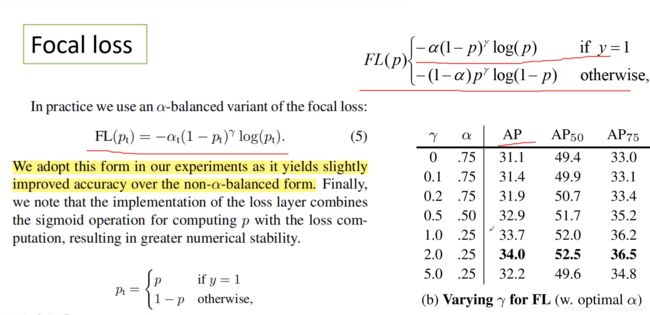

目标检测领域总结:从传统方法到Transformer时代的革新目标检测是计算机视觉领域的一个核心任务,它的目标是从输入图像中识别并定位出目标物体。随着深度学习的兴起,目标检测方法已经取得了显著的进展。从最早的传统方法到现如今基于Transformer的先进算法,目标检测的发展经历了多个重要的阶段。本文将详细总结目标检测领域的演进,涵盖传统方法、两阶段检测方法、单阶段检测方法和基于Transform

- 2024MathorCup数学建模之——MathorCup奖杯”获得者经验思路分享

美赛数学建模

数学建模

一、经验分享1.工具选择:顺手即可。Matlab和Python都是比较主流的选择,二者的应用场合各有不同。Python在数据分析、深度学习方面的优势愈发明显,而Matlab更适合进行物理仿真和数值计算。不过随着Python社区不断发展,其功能也愈发全面与强大,因此我们比较推荐学有余力的情况下可以更早接触Python。2.模型算法:多多益善。不一定要精通所有的算法,但是手上至少要准备一些常用的算法(

- AI人工智能软件开发方案:开启智能时代的创新钥匙

广州硅基技术官方

人工智能

一、引言:AI浪潮下的软件开发新机遇近年来,人工智能(AI)技术的迅猛发展如同一股汹涌澎湃的浪潮,席卷了全球各个领域。从最初的概念提出到如今的广泛应用,AI历经了漫长的发展历程,终于迎来了属于它的黄金时代。回首过去,AI的发展并非一帆风顺,早期由于计算能力和算法的限制,经历了多次起伏。但随着大数据、云计算、机器学习、深度学习等技术的不断突破,AI迎来了爆发式增长。如今,AI已经深入到人们生活和工作

- YOLOV8多模态(可见光+红外光,基于Ultralytics官方代码实现)

@M_J_Y@

目标检测YOLO计算机视觉目标检测python

YOLOV8多模态(可见光+红外光,基于Ultralytics官方代码实现)各位读者麻烦给个star或者fork,求求了。YOLOV8双分支模型架构图YOLOV8多模态目标检测前言:环境配置要求1.数据集DroneVehicle数据集(可见光+热红外)2.数据集文件格式(labeles:YOLO格式)3.权重文件下载4.配置模型yaml文件和数据集yaml文件5.训练6.测试7.打印模型信息8.o

- 深度学习框架PyTorch——从入门到精通(6.2)自动微分机制

Fansv587

深度学习pytorch人工智能经验分享python机器学习

本节自动微分机制是上一节自动微分的扩展内容自动微分是如何记录运算历史的保存张量非可微函数的梯度在本地设置禁用梯度计算设置requires_grad梯度模式(GradModes)默认模式(梯度模式)无梯度模式推理模式评估模式(`nn.Module.eval()`)自动求导中的原地操作原地操作的正确性检查多线程自动求导CPU上的并发不确定性计算图保留自动求导节点的线程安全性C++钩子函数不存在线程安全

- Pytorch深度学习教程_9_nn模块构建神经网络

tRNA做科研

深度学习保姆教程深度学习pytorch神经网络

欢迎来到《深度学习保姆教程》系列的第九篇!在前面的几篇中,我们已经介绍了Python、numpy及pytorch的基本使用,进行了梯度及神经网络的实践并学习了激活函数和激活函数,在上一个教程中我们学习了优化算法。今天,我们将开始使用pytorch构建我们自己的神经网络。欢迎订阅专栏进行系统学习:深度学习保姆教程_tRNA做科研的博客-CSDN博客目录1.理解nn模块:(1)使用nn.Sequent

- Radiance Fields from VGGSfM和Mast3r:两种先进3D重建方法的比较与分析

2401_87458718

3d

VGGSfM和Mast3r:3D场景重建的新方向在计算机视觉和3D重建领域,如何从2D图像重建3D场景一直是一个充满挑战的研究课题。近年来,随着深度学习技术的发展,一些新的方法被提出并取得了显著的进展。本文将重点介绍两种最新的基于深度学习的3D重建方法:VGGSfM和Mast3r,并通过GaussianSplatting技术对它们的性能进行全面比较和分析。VGGSfM:基于视觉几何的深度结构运动恢

- 基于 PyTorch 的 MNIST 手写数字分类模型

欣然~

pytorch分类人工智能

一、概述本代码使用PyTorch框架构建了一个简单的神经网络模型,用于解决MNIST手写数字分类任务。代码主要包括数据的加载与预处理、神经网络模型的构建、损失函数和优化器的定义、模型的训练、评估以及最终模型的保存等步骤。二、依赖库torch:PyTorch深度学习框架的核心库,提供了张量操作、自动求导等功能。torch.nn:PyTorch的神经网络模块,包含了各种神经网络层、损失函数等。torc

- 高效快速教你DeepSeek如何进行本地部署并且可视化对话

大富大贵7

程序员知识储备1程序员知识储备2程序员知识储备3经验分享

科技文章:高效快速教你DeepSeek如何进行本地部署并且可视化对话摘要:随着自然语言处理(NLP)技术的进步,DeepSeek作为一款基于深度学习的语义搜索技术,广泛应用于文本理解、对话系统及信息检索等多个领域。本文将探讨如何高效快速地在本地部署DeepSeek,并结合可视化工具实现对话过程的监控与分析。通过详尽的步骤、案例分析与代码示例,帮助开发者更好地理解和应用DeepSeek技术。同时,本

- Python基于深度学习的动物图片识别技术的研究与实现

Java老徐

Python毕业设计python深度学习开发语言深度学习的动物图片识别技术Python动物图片识别技术

博主介绍:✌程序员徐师兄、7年大厂程序员经历。全网粉丝12w+、csdn博客专家、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java技术领域和毕业项目实战✌文末获取源码联系精彩专栏推荐订阅不然下次找不到哟2022-2024年最全的计算机软件毕业设计选题大全:1000个热门选题推荐✅Java项目精品实战案例《100套》Java微信小程序项目实战《100套》感兴趣的可以先收藏起来,还有大家

- 【深度学习与大模型基础】第7章-特征分解与奇异值分解

lynn-66

深度学习与大模型基础算法机器学习人工智能

一、特征分解特征分解(EigenDecomposition)是线性代数中的一种重要方法,广泛应用于计算机行业的多个领域,如机器学习、图像处理和数据分析等。特征分解将一个方阵分解为特征值和特征向量的形式,帮助我们理解矩阵的结构和性质。1.特征分解的定义对于一个n×n的方阵A,如果存在一个非零向量v和一个标量λ,使得:则称λ为矩阵A的特征值,v为对应的特征向量。特征分解将矩阵A分解为:其中:Q是由特征

- 【论文阅读】实时全能分割模型

万里守约

论文阅读论文阅读图像分割图像处理计算机视觉

文章目录导言1、论文简介2、论文主要方法3、论文针对的问题4、论文创新点总结导言在最近的计算机视觉领域,针对实时多任务分割的需求日益增长,特别是在交互式分割、全景分割和视频实例分割等多种应用场景中。为了解决这些挑战,本文介绍了一种新方法——RMP-SAM(Real-TimeMulti-PurposeSegmentAnything),旨在实现实时的多功能分割。RMP-SAM结合了动态卷积与高效的模型

- 震惊! “深度学习”都在学习什么

扉间798

深度学习学习人工智能

常见的机器学习分类算法俗话说三个臭皮匠胜过诸葛亮这里面集成学习就是将单一的算法弱弱结合算法融合用投票给特征值加权重AdaBoost集成学习算法通过迭代训练一系列弱分类器,给予分类错误样本更高权重,使得后续弱分类器更关注这些样本,然后将这些弱分类器线性组合成强分类器,提高整体分类性能。(一)投票机制投票是一种直观且常用的算法融合策略。在多分类问题中,假设有多个分类器对同一数据进行分类判断。每个分类器

- 深度学习 | pytorch + torchvision + python 版本对应及环境安装

zfgfdgbhs

深度学习pythonpytorch

目录一、版本对应二、安装命令(pip)1.版本(1)v2.5.1~v2.0.0(2)v1.13.1~v1.11.0(3)v1.10.1~v1.7.02.安装全过程(1)选择版本(2)安装结果参考文章一、版本对应下表来自pytorch的github官方文档:pytorch/vision:Datasets,TransformsandModelsspecifictoComputerVisionpytor

- 一文讲清楚深度学习和机器学习

平凡而伟大.

机器学习人工智能深度学习机器学习人工智能

目录1.定义机器学习(MachineLearning,ML)深度学习(DeepLearning,DL)2.工作原理机器学习深度学习3.应用场景机器学习深度学习4.主要区别5.为什么选择深度学习?6.总结深度学习和机器学习是人工智能(AI)领域中两个密切相关但有所区别的概念。要清楚地解释它们之间的关系,我们可以从定义、工作原理、应用场景以及两者的主要区别等方面进行探讨。1.定义机器学习(Machin

- DeepSeek:智能搜索与分析的新纪元

XRC2231

学习

在人工智能浪潮席卷全球的今天,DeepSeek如同一颗璀璨的新星,以其独特的魅力和强大的功能,在AI领域脱颖而出。DeepSeek,这一基于深度学习和数据挖掘技术的智能搜索与分析系统,不仅重新定义了搜索引擎的边界,更以其卓越的性能和广泛的应用场景,为全球用户带来了前所未有的智能体验。本文将从DeepSeek的定义、特点、应用场景、优势等方面进行全面而深入的介绍,带您领略这一新兴技术的独特魅力。一、

- 大模型学习终极指南:从新手到专家的必经之路,全网最详尽解析,你敢挑战吗?

大模型入门教程

学习人工智能AI大模型大模型学习大模型教程AI大模型

随着人工智能技术的飞速发展,大模型(Large-ScaleModels)已经成为推动自然语言处理(NLP)、计算机视觉(CV)等领域进步的关键因素。本文将为您详细介绍从零开始学习大模型直至成为专家的全过程,包括所需掌握的知识点、学习资源以及实践建议等。无论您是初学者还是有一定基础的专业人士,都能从中获得有价值的指导。一、基础知识准备在开始学习大模型之前,需要先掌握一些基础知识,这些知识将为后续的学

- AI模型技术演进与行业应用图谱

智能计算研究中心

其他

内容概要当前AI模型技术正经历从基础架构到行业落地的系统性革新。主流深度学习框架如TensorFlow和PyTorch持续优化动态计算图与分布式训练能力,而MXNet凭借高效的异构计算支持在边缘场景崭露头角。与此同时,模型压缩技术通过量化和知识蒸馏将参数量降低60%-80%,联邦学习则通过加密梯度交换实现多机构数据协同训练。在应用层面,医疗诊断模型通过迁移学习在CT影像分类任务中达到98.2%的准

- AI大模型训练教程

Small踢倒coffee_氕氘氚

python自学经验分享笔记

1.引言随着人工智能技术的快速发展,大模型(如GPT-3、BERT等)在自然语言处理、计算机视觉等领域取得了显著的成果。训练一个大模型需要大量的计算资源、数据和专业知识。本教程将带你了解如何从零开始训练一个AI大模型。2.准备工作2.1硬件要求GPU:推荐使用NVIDIA的高性能GPU,如A100、V100等。内存:至少64GBRAM。存储:SSD存储,至少1TB。#2.2软件环境操作系统:Lin

- 使用Jupyter Notebook进行深度学习编程 - 深度学习教程

shandianfk_com

ChatGPTAIjupyter深度学习ide

大家好,今天我们要聊聊如何使用JupyterNotebook进行深度学习编程。深度学习是人工智能领域中的一项重要技术,通过模仿人脑神经网络的方式进行学习和分析。JupyterNotebook作为一个强大的工具,可以帮助我们轻松地进行深度学习编程,尤其适合初学者和研究人员。本文将带领大家一步步了解如何在JupyterNotebook中开展深度学习项目。一、什么是JupyterNotebook?Jup

- Opencv之计算机视觉一

闭月之泪舞

计算机视觉计算机视觉opencvpython

一、环境准备使用opencv库来实现简单的计算机视觉。需要安装两个库:opencv-python和opencv-contrib-python,版本可以自行选择,注意不同版本的opencv中的某些函数名和用法可能不同pipinstallopencv-python==3.4.18.65-ihttps://pypi.tuna.tsinghua.edu.cn/simplepipinstallopencv-

- 计算机视觉总结

Trank-Lw

计算机视觉深度学习人工智能

以下是针对上述问题的详细解答,并结合代码示例进行说明:1.改进YOLOv5人脸检测模块,复杂光照场景准确率从98.2%提升至99.5%优化具体过程:光照补偿:在数据预处理阶段,采用自适应光照补偿算法,对图像进行实时增强,以减少光照变化对人脸检测的影响。数据增强:在训练数据中增加复杂光照场景下的样本,如强光、弱光、背光等,通过数据增强提高模型对不同光照条件的适应性。模型调整:对YOLOv5模型的网络

- 深度学习 Deep Learning 第8章 深度学习优化

odoo中国

AI编程人工智能深度学习人工智能优化

深度学习第8章深度学习的优化章节概述本章深入探讨了深度学习中的优化技术,旨在解决模型训练过程中面临的各种挑战。优化是深度学习的核心环节,直接关系到模型的训练效率和最终性能。本章首先介绍了优化在深度学习中的特殊性,然后详细讨论了多种优化算法,包括随机梯度下降(SGD)、动量法、Nesterov动量法、AdaGrad、RMSProp和Adam等。此外,还探讨了参数初始化策略、自适应学习率方法以及二阶优

- eclipse maven

IXHONG

eclipse

eclipse中使用maven插件的时候,运行run as maven build的时候报错

-Dmaven.multiModuleProjectDirectory system propery is not set. Check $M2_HOME environment variable and mvn script match.

可以设一个环境变量M2_HOME指

- timer cancel方法的一个小实例

alleni123

多线程timer

package com.lj.timer;

import java.util.Date;

import java.util.Timer;

import java.util.TimerTask;

public class MyTimer extends TimerTask

{

private int a;

private Timer timer;

pub

- MySQL数据库在Linux下的安装

ducklsl

mysql

1.建好一个专门放置MySQL的目录

/mysql/db数据库目录

/mysql/data数据库数据文件目录

2.配置用户,添加专门的MySQL管理用户

>groupadd mysql ----添加用户组

>useradd -g mysql mysql ----在mysql用户组中添加一个mysql用户

3.配置,生成并安装MySQL

>cmake -D

- spring------>>cvc-elt.1: Cannot find the declaration of element

Array_06

springbean

将--------

<?xml version="1.0" encoding="UTF-8"?>

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi="http://www.w3

- maven发布第三方jar的一些问题

cugfy

maven

maven中发布 第三方jar到nexus仓库使用的是 deploy:deploy-file命令

有许多参数,具体可查看

http://maven.apache.org/plugins/maven-deploy-plugin/deploy-file-mojo.html

以下是一个例子:

mvn deploy:deploy-file -DgroupId=xpp3

- MYSQL下载及安装

357029540

mysql

好久没有去安装过MYSQL,今天自己在安装完MYSQL过后用navicat for mysql去厕测试链接的时候出现了10061的问题,因为的的MYSQL是最新版本为5.6.24,所以下载的文件夹里没有my.ini文件,所以在网上找了很多方法还是没有找到怎么解决问题,最后看到了一篇百度经验里有这个的介绍,按照其步骤也完成了安装,在这里给大家分享下这个链接的地址

- ios TableView cell的布局

张亚雄

tableview

cell.imageView.image = [UIImage imageNamed:[imageArray objectAtIndex:[indexPath row]]];

CGSize itemSize = CGSizeMake(60, 50);

&nbs

- Java编码转义

adminjun

java编码转义

import java.io.UnsupportedEncodingException;

/**

* 转换字符串的编码

*/

public class ChangeCharset {

/** 7位ASCII字符,也叫作ISO646-US、Unicode字符集的基本拉丁块 */

public static final Strin

- Tomcat 配置和spring

aijuans

spring

简介

Tomcat启动时,先找系统变量CATALINA_BASE,如果没有,则找CATALINA_HOME。然后找这个变量所指的目录下的conf文件夹,从中读取配置文件。最重要的配置文件:server.xml 。要配置tomcat,基本上了解server.xml,context.xml和web.xml。

Server.xml -- tomcat主

- Java打印当前目录下的所有子目录和文件

ayaoxinchao

递归File

其实这个没啥技术含量,大湿们不要操笑哦,只是做一个简单的记录,简单用了一下递归算法。

import java.io.File;

/**

* @author Perlin

* @date 2014-6-30

*/

public class PrintDirectory {

public static void printDirectory(File f

- linux安装mysql出现libs报冲突解决

BigBird2012

linux

linux安装mysql出现libs报冲突解决

安装mysql出现

file /usr/share/mysql/ukrainian/errmsg.sys from install of MySQL-server-5.5.33-1.linux2.6.i386 conflicts with file from package mysql-libs-5.1.61-4.el6.i686

- jedis连接池使用实例

bijian1013

redisjedis连接池jedis

实例代码:

package com.bijian.study;

import java.util.ArrayList;

import java.util.List;

import redis.clients.jedis.Jedis;

import redis.clients.jedis.JedisPool;

import redis.clients.jedis.JedisPoo

- 关于朋友

bingyingao

朋友兴趣爱好维持

成为朋友的必要条件:

志相同,道不合,可以成为朋友。譬如马云、周星驰一个是商人,一个是影星,可谓道不同,但都很有梦想,都要在各自领域里做到最好,当他们遇到一起,互相欣赏,可以畅谈两个小时。

志不同,道相合,也可以成为朋友。譬如有时候看到两个一个成绩很好每次考试争做第一,一个成绩很差的同学是好朋友。他们志向不相同,但他

- 【Spark七十九】Spark RDD API一

bit1129

spark

aggregate

package spark.examples.rddapi

import org.apache.spark.{SparkConf, SparkContext}

//测试RDD的aggregate方法

object AggregateTest {

def main(args: Array[String]) {

val conf = new Spar

- ktap 0.1 released

bookjovi

kerneltracing

Dear,

I'm pleased to announce that ktap release v0.1, this is the first official

release of ktap project, it is expected that this release is not fully

functional or very stable and we welcome bu

- 能保存Properties文件注释的Properties工具类

BrokenDreams

properties

今天遇到一个小需求:由于java.util.Properties读取属性文件时会忽略注释,当写回去的时候,注释都没了。恰好一个项目中的配置文件会在部署后被某个Java程序修改一下,但修改了之后注释全没了,可能会给以后的参数调整带来困难。所以要解决这个问题。

&nb

- 读《研磨设计模式》-代码笔记-外观模式-Facade

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

/*

* 百度百科的定义:

* Facade(外观)模式为子系统中的各类(或结构与方法)提供一个简明一致的界面,

* 隐藏子系统的复杂性,使子系统更加容易使用。他是为子系统中的一组接口所提供的一个一致的界面

*

* 可简单地

- After Effects教程收集

cherishLC

After Effects

1、中文入门

http://study.163.com/course/courseMain.htm?courseId=730009

2、videocopilot英文入门教程(中文字幕)

http://www.youku.com/playlist_show/id_17893193.html

英文原址:

http://www.videocopilot.net/basic/

素

- Linux Apache 安装过程

crabdave

apache

Linux Apache 安装过程

下载新版本:

apr-1.4.2.tar.gz(下载网站:http://apr.apache.org/download.cgi)

apr-util-1.3.9.tar.gz(下载网站:http://apr.apache.org/download.cgi)

httpd-2.2.15.tar.gz(下载网站:http://httpd.apac

- Shell学习 之 变量赋值和引用

daizj

shell变量引用赋值

本文转自:http://www.cnblogs.com/papam/articles/1548679.html

Shell编程中,使用变量无需事先声明,同时变量名的命名须遵循如下规则:

首个字符必须为字母(a-z,A-Z)

中间不能有空格,可以使用下划线(_)

不能使用标点符号

不能使用bash里的关键字(可用help命令查看保留关键字)

需要给变量赋值时,可以这么写:

- Java SE 第一讲(Java SE入门、JDK的下载与安装、第一个Java程序、Java程序的编译与执行)

dcj3sjt126com

javajdk

Java SE 第一讲:

Java SE:Java Standard Edition

Java ME: Java Mobile Edition

Java EE:Java Enterprise Edition

Java是由Sun公司推出的(今年初被Oracle公司收购)。

收购价格:74亿美金

J2SE、J2ME、J2EE

JDK:Java Development

- YII给用户登录加上验证码

dcj3sjt126com

yii

1、在SiteController中添加如下代码:

/**

* Declares class-based actions.

*/

public function actions() {

return array(

// captcha action renders the CAPTCHA image displ

- Lucene使用说明

dyy_gusi

Lucenesearch分词器

Lucene使用说明

1、lucene简介

1.1、什么是lucene

Lucene是一个全文搜索框架,而不是应用产品。因此它并不像baidu或者googleDesktop那种拿来就能用,它只是提供了一种工具让你能实现这些产品和功能。

1.2、lucene能做什么

要回答这个问题,先要了解lucene的本质。实际

- 学习编程并不难,做到以下几点即可!

gcq511120594

数据结构编程算法

不论你是想自己设计游戏,还是开发iPhone或安卓手机上的应用,还是仅仅为了娱乐,学习编程语言都是一条必经之路。编程语言种类繁多,用途各 异,然而一旦掌握其中之一,其他的也就迎刃而解。作为初学者,你可能要先从Java或HTML开始学,一旦掌握了一门编程语言,你就发挥无穷的想象,开发 各种神奇的软件啦。

1、确定目标

学习编程语言既充满乐趣,又充满挑战。有些花费多年时间学习一门编程语言的大学生到

- Java面试十问之三:Java与C++内存回收机制的差别

HNUlanwei

javaC++finalize()堆栈内存回收

大家知道, Java 除了那 8 种基本类型以外,其他都是对象类型(又称为引用类型)的数据。 JVM 会把程序创建的对象存放在堆空间中,那什么又是堆空间呢?其实,堆( Heap)是一个运行时的数据存储区,从它可以分配大小各异的空间。一般,运行时的数据存储区有堆( Heap)和堆栈( Stack),所以要先看它们里面可以分配哪些类型的对象实体,然后才知道如何均衡使用这两种存储区。一般来说,栈中存放的

- 第二章 Nginx+Lua开发入门

jinnianshilongnian

nginxlua

Nginx入门

本文目的是学习Nginx+Lua开发,对于Nginx基本知识可以参考如下文章:

nginx启动、关闭、重启

http://www.cnblogs.com/derekchen/archive/2011/02/17/1957209.html

agentzh 的 Nginx 教程

http://openresty.org/download/agentzh-nginx-tutor

- MongoDB windows安装 基本命令

liyonghui160com

windows安装

安装目录:

D:\MongoDB\

新建目录

D:\MongoDB\data\db

4.启动进城:

cd D:\MongoDB\bin

mongod -dbpath D:\MongoDB\data\db

&n

- Linux下通过源码编译安装程序

pda158

linux

一、程序的组成部分 Linux下程序大都是由以下几部分组成: 二进制文件:也就是可以运行的程序文件 库文件:就是通常我们见到的lib目录下的文件 配置文件:这个不必多说,都知道 帮助文档:通常是我们在linux下用man命令查看的命令的文档

二、linux下程序的存放目录 linux程序的存放目录大致有三个地方: /etc, /b

- WEB开发编程的职业生涯4个阶段

shw3588

编程Web工作生活

觉得自己什么都会

2007年从学校毕业,凭借自己原创的ASP毕业设计,以为自己很厉害似的,信心满满去东莞找工作,找面试成功率确实很高,只是工资不高,但依旧无法磨灭那过分的自信,那时候什么考勤系统、什么OA系统、什么ERP,什么都觉得有信心,这样的生涯大概持续了约一年。

根本不是自己想的那样

2008年开始接触很多工作相关的东西,发现太多东西自己根本不会,都需要去学,不管是asp还是js,

- 遭遇jsonp同域下变作post请求的坑

vb2005xu

jsonp同域post

今天迁移一个站点时遇到一个坑爹问题,同一个jsonp接口在跨域时都能调用成功,但是在同域下调用虽然成功,但是数据却有问题. 此处贴出我的后端代码片段

$mi_id = htmlspecialchars(trim($_GET['mi_id ']));

$mi_cv = htmlspecialchars(trim($_GET['mi_cv ']));

贴出我前端代码片段:

$.aj